- জানুয়ারী 20, 2014

- ভ্যাসিলিস ভ্রাইনিওটিস

- . 5 মন্তব্য

টেক্সট শ্রেণীবিভাগে, বৈশিষ্ট্য নির্বাচন হল প্রশিক্ষণ সেটের শর্তাবলীর একটি নির্দিষ্ট উপসেট নির্বাচন করার এবং শ্রেণীবিভাগ অ্যালগরিদমে শুধুমাত্র সেগুলি ব্যবহার করার প্রক্রিয়া। বৈশিষ্ট্য নির্বাচন প্রক্রিয়া ক্লাসিফায়ার প্রশিক্ষণের আগে সঞ্চালিত হয়.

আপডেট: Datumbox মেশিন লার্নিং ফ্রেমওয়ার্ক এখন ওপেন সোর্স এবং বিনামূল্যে ডাউনলোড. জাভাতে চি-স্কয়ার এবং পারস্পরিক তথ্য বৈশিষ্ট্য নির্বাচন পদ্ধতির বাস্তবায়ন দেখতে com.datumbox.framework.machinelearning.featureselection প্যাকেজটি দেখুন।

বৈশিষ্ট্য নির্বাচন অ্যালগরিদমগুলি ব্যবহার করার জন্য প্রধান সুবিধাগুলি হল যে এটি আমাদের ডেটার মাত্রা হ্রাস করে, এটি প্রশিক্ষণকে দ্রুততর করে এবং এটি শোরগোলযুক্ত বৈশিষ্ট্যগুলি সরিয়ে নির্ভুলতা উন্নত করতে পারে৷ ফলস্বরূপ বৈশিষ্ট্য নির্বাচন আমাদের ওভারফিটিং এড়াতে সাহায্য করতে পারে।

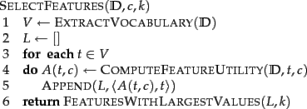

k সেরা বৈশিষ্ট্যগুলি নির্বাচন করার জন্য মৌলিক নির্বাচন অ্যালগরিদম নীচে উপস্থাপন করা হয়েছে (ম্যানিং এট আল, 2008):

পরবর্তী বিভাগে আমরা দুটি ভিন্ন বৈশিষ্ট্য নির্বাচন অ্যালগরিদম উপস্থাপন করি: পারস্পরিক তথ্য এবং চি স্কোয়ার।

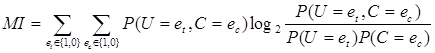

পারস্পরিক তথ্য

সবচেয়ে সাধারণ বৈশিষ্ট্য নির্বাচন পদ্ধতিগুলির মধ্যে একটি হল ক্লাস c-এ টি শব্দের পারস্পরিক তথ্য (ম্যানিং এট আল, 2008) এটি পরিমাপ করে যে কতটা তথ্য একটি নির্দিষ্ট শব্দের উপস্থিতি বা অনুপস্থিতি গ-তে সঠিক শ্রেণিবিন্যাসের সিদ্ধান্ত নিতে অবদান রাখে। পারস্পরিক তথ্য নিম্নলিখিত সূত্র ব্যবহার করে গণনা করা যেতে পারে:

[1]

[1]

আমাদের গণনায়, যেহেতু আমরা সম্ভাব্যতার সর্বাধিক সম্ভাবনা অনুমান ব্যবহার করি আমরা নিম্নলিখিত সমীকরণটি ব্যবহার করতে পারি:

![]() [2]

[2]

যেখানে N হল নথির মোট সংখ্যা, Ntcনথির গণনা হল যেগুলির মান রয়েছে et (নথিতে t শব্দের সংঘটন; এটি 1 বা 0 মান নেয়) এবং ec(c ক্লাসে নথির সংঘটন; এটি 1 বা 0 মান নেয়) যা দুটি সাবস্ক্রিপ্ট দ্বারা নির্দেশিত, ![]() এবং

এবং ![]() . পরিশেষে আমাদের অবশ্যই লক্ষ্য রাখতে হবে যে সমস্ত পূর্বোক্ত ভেরিয়েবল অ-নেতিবাচক মান গ্রহণ করে।

. পরিশেষে আমাদের অবশ্যই লক্ষ্য রাখতে হবে যে সমস্ত পূর্বোক্ত ভেরিয়েবল অ-নেতিবাচক মান গ্রহণ করে।

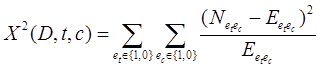

চি স্কোয়ার

আরেকটি সাধারণ বৈশিষ্ট্য নির্বাচন পদ্ধতি হল চি স্কোয়ার. এক্স2 পরীক্ষাটি পরিসংখ্যানে ব্যবহৃত হয়, অন্যান্য জিনিসগুলির মধ্যে, দুটি ঘটনার স্বাধীনতা পরীক্ষা করতে। আরও বিশেষভাবে বৈশিষ্ট্য নির্বাচনে আমরা এটি ব্যবহার করি একটি নির্দিষ্ট শব্দের সংঘটন এবং একটি নির্দিষ্ট শ্রেণীর সংঘটন স্বাধীন কিনা তা পরীক্ষা করতে। এইভাবে আমরা প্রতিটি পদের জন্য নিম্নলিখিত পরিমাণ অনুমান করি এবং আমরা তাদের স্কোর দ্বারা তাদের র্যাঙ্ক করি:

[3]

[3]

এক্সে উচ্চ স্কোর2 নির্দেশ করে যে শূন্য অনুমান (এইচ0স্বাধীনতার ) প্রত্যাখ্যান করা উচিত এবং এইভাবে শব্দ এবং শ্রেণির ঘটনা নির্ভরশীল। যদি তারা নির্ভরশীল হয় তবে আমরা পাঠ্য শ্রেণিবিন্যাসের জন্য বৈশিষ্ট্যটি নির্বাচন করি।

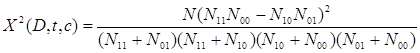

উপরের সূত্রটি নিম্নরূপ পুনর্লিখন করা যেতে পারে:

[4]

[4]

যদি আমরা চি স্কোয়ার পদ্ধতি ব্যবহার করি, তাহলে আমাদের শুধুমাত্র একটি পূর্বনির্ধারিত সংখ্যক বৈশিষ্ট্য নির্বাচন করা উচিত যাতে কুঠার রয়েছে2 পরীক্ষার স্কোর 10.83 এর চেয়ে বড় যা 0.001 স্তরে পরিসংখ্যানগত তাত্পর্য নির্দেশ করে।

শেষ কিন্তু অন্তত আমাদের মনে রাখা উচিত যে পরিসংখ্যানগত দিক থেকে চি স্কোয়ার বৈশিষ্ট্য নির্বাচন ভুল, এক ডিগ্রি স্বাধীনতার কারণে এবং ইয়েটস সংশোধন পরিবর্তে ব্যবহার করা উচিত (যা পরিসংখ্যানগত তাত্পর্য পৌঁছানো কঠিন করে তুলবে)। সুতরাং আমাদের আশা করা উচিত যে মোট নির্বাচিত বৈশিষ্ট্যগুলির মধ্যে, তাদের একটি ছোট অংশ ক্লাস থেকে স্বাধীন)। এইভাবে আমাদের আশা করা উচিত যে মোট নির্বাচিত বৈশিষ্ট্যগুলির মধ্যে, তাদের একটি ছোট অংশ ক্লাস থেকে স্বাধীন। তবুও হিসাবে ম্যানিং এট আল (2008) দেখিয়েছে, এই গোলমাল বৈশিষ্ট্যগুলি আমাদের শ্রেণীবদ্ধকারীর সামগ্রিক নির্ভুলতাকে গুরুত্বের সাথে প্রভাবিত করে না।

শোরগোল/বিরল বৈশিষ্ট্য অপসারণ

আরেকটি কৌশল যা আমাদের অতিরিক্ত ফিটিং এড়াতে, মেমরির খরচ কমাতে এবং গতি উন্নত করতে সাহায্য করতে পারে, তা হল শব্দভাণ্ডার থেকে সমস্ত বিরল পদ অপসারণ করা। উদাহরণ স্বরূপ যে কেউ সমস্ত শ্রেণীতে শুধুমাত্র একবার ঘটে যাওয়া সমস্ত পদগুলিকে বাদ দিতে পারে৷ এই পদগুলি সরানো একটি উল্লেখযোগ্য ফ্যাক্টর দ্বারা মেমরি ব্যবহার কমাতে পারে এবং বিশ্লেষণের গতি উন্নত করতে পারে। অবশেষে আমাদের উচিত নয় যে এই কৌশলটি উপরের বৈশিষ্ট্য নির্বাচন অ্যালগরিদমের সাথে একত্রে ব্যবহার করা যেতে পারে।

আপনি নিবন্ধটি পছন্দ করেছেন? টুইটারে শেয়ার করার জন্য একটি মিনিট সময় নিন। 🙂

- AI

- ai শিল্প

- এআই আর্ট জেনারেটর

- আইআই রোবট

- কৃত্রিম বুদ্ধিমত্তা

- কৃত্রিম বুদ্ধিমত্তা সার্টিফিকেশন

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তা সফ্টওয়্যার

- blockchain

- ব্লকচেইন সম্মেলন এআই

- coingenius

- কথোপকথন কৃত্রিম বুদ্ধিমত্তা

- ক্রিপ্টো সম্মেলন এআই

- ডাল-ই

- ডেটাবক্স

- গভীর জ্ঞানার্জন

- গুগল আই

- মেশিন লার্নিং

- মেশিন লার্নিং এবং পরিসংখ্যান

- Plato

- প্লেটো এআই

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটো গেম

- প্লেটোডাটা

- প্লেটোগেমিং

- স্কেল ai

- বাক্য গঠন

- zephyrnet