Dette er et gæsteindlæg af AK Roy fra Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) DL2q-instanser, drevet af Qualcomm AI 100 Standard-acceleratorer, kan bruges til omkostningseffektivt at implementere deep learning (DL)-arbejdsbelastninger i skyen. De kan også bruges til at udvikle og validere ydeevne og nøjagtighed af DL-arbejdsbelastninger, der vil blive implementeret på Qualcomm-enheder. DL2q-instanser er de første instanser, der bringer Qualcomms kunstige intelligente (AI) teknologi til skyen.

Med otte Qualcomm AI 100 Standard-acceleratorer og 128 GiB total acceleratorhukommelse kan kunder også bruge DL2q-instanser til at køre populære generative AI-applikationer, såsom indholdsgenerering, tekstresumé og virtuelle assistenter, såvel som klassiske AI-applikationer til naturlig sprogbehandling og computersyn. Derudover har Qualcomm AI 100-acceleratorer den samme AI-teknologi, der bruges på tværs af smartphones, autonom kørsel, personlige computere og udvidede reality-headsets, så DL2q-instanser kan bruges til at udvikle og validere disse AI-arbejdsbelastninger før implementering.

Nye DL2q-instanshøjdepunkter

Hver DL2q-instans inkorporerer otte Qualcomm Cloud AI100-acceleratorer med en samlet ydeevne på over 2.8 PetaOps af Int8-inferens ydeevne og 1.4 PetaFlops af FP16-inferens ydeevne. Forekomsten har i alt 112 AI-kerner, acceleratorhukommelseskapacitet på 128 GB og hukommelsesbåndbredde på 1.1 TB pr. sekund.

Hver DL2q-instans har 96 vCPU'er, en systemhukommelseskapacitet på 768 GB og understøtter en netværksbåndbredde på 100 Gbps samt Amazon Elastic Block Store (Amazon EBS) lagring på 19 Gbps.

| Forekomstnavn | vCPU'er | Cloud AI100 acceleratorer | Accelerator hukommelse | Acceleratorhukommelse BW (aggregeret) | Forekomsthukommelse | Forekomst netværk | Storage (Amazon EBS) båndbredde |

| DL2q.24xlarge | 96 | 8 | 128 DK | 1.088 TB / s | 768 DK | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 accelerator innovation

Cloud AI100 acceleratoren system-on-chip (SoC) er en specialbygget, skalerbar multi-core arkitektur, der understøtter en bred vifte af deep-learning use-cases, der spænder fra datacenteret til kanten. SoC'en anvender skalar-, vektor- og tensorcomputerkerner med en brancheførende on-die SRAM-kapacitet på 126 MB. Kernerne er forbundet med et netværk-på-chip (NoC) mesh med høj båndbredde og lav latens.

AI100 acceleratoren understøtter et bredt og omfattende udvalg af modeller og use-cases. Tabellen nedenfor fremhæver rækkevidden af modelstøtten.

| Model kategori | Antal modeller | Eksempler |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-kode MOE |

| Generativ AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generativ AI – billede | 3 | Stabil diffusion v1.5 og v2.1, OpenAI CLIP |

| CV – Billedklassificering | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Objektdetektion | 23 | YOLO v2, v3, v4, v5 og v7, SSD-ResNet, RetinaNet |

| CV – Andet | 15 | LPRNet, Super-opløsning/SRGAN, ByteTrack |

| Bilnetværk* | 53 | Perception og LIDAR-, fodgænger-, vognbane- og trafiklysregistrering |

| I alt | > 300 â € < | â € < |

* De fleste bilnetværk er sammensatte netværk, der består af en sammensmeltning af individuelle netværk.

Den store on-die SRAM på DL2q-acceleratoren muliggør effektiv implementering af avancerede ydeevneteknikker såsom MX6 mikro-eksponent-præcision til lagring af vægte og MX9 mikro-eksponent-præcision til accelerator-til-accelerator-kommunikation. Mikroeksponentteknologien er beskrevet i følgende Open Compute Project (OCP) branchemeddelelse: AMD, Arm, Intel, Meta, Microsoft, NVIDIA og Qualcomm standardiserer næste generations smalle præcisionsdataformater til AI » Open Compute Project.

Forekomstbrugeren kan bruge følgende strategi til at maksimere ydeevnen pr. omkostning:

- Gem vægte ved hjælp af MX6-mikroeksponentpræcisionen i DDR-hukommelsen på acceleratoren. Brug af MX6-præcisionen maksimerer udnyttelsen af den tilgængelige hukommelseskapacitet og hukommelsesbåndbredden for at levere klassens bedste gennemløb og latens.

- Beregn i FP16 for at levere den krævede use case-nøjagtighed, mens du bruger den overlegne on-chip SRAM og ekstra TOP'er på kortet, til at implementere højtydende lav-latency MX6 til FP16 kerner.

- Brug en optimeret batchstrategi og en højere batchstørrelse ved at bruge den store on-chip SRAM til rådighed for at maksimere genbrugen af vægte, samtidig med at aktiveringerne på chip bevares til det maksimale muligt.

DL2q AI stak og værktøjskæde

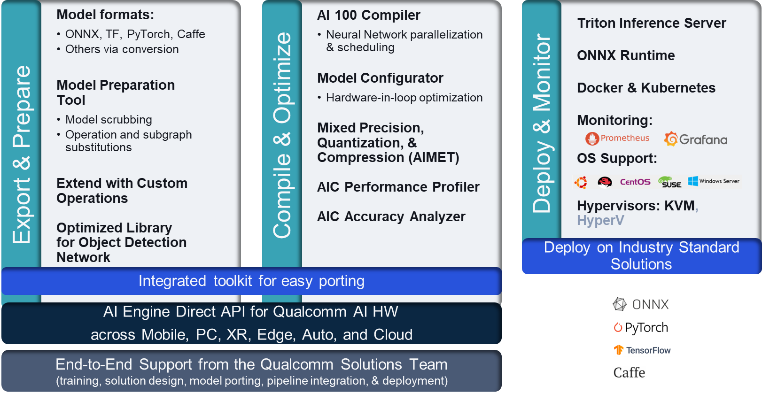

DL2q-instansen er ledsaget af Qualcomm AI-stakken, der leverer en ensartet udvikleroplevelse på tværs af Qualcomm AI i skyen og andre Qualcomm-produkter. Den samme Qualcomm AI stack og base AI-teknologi kører på DL2q-instanserne og Qualcomm edge-enheder, hvilket giver kunderne en ensartet udvikleroplevelse med en samlet API på tværs af deres cloud-, bil-, personlige computer-, udvidede virkeligheds- og smartphone-udviklingsmiljøer.

Værktøjskæden gør det muligt for instansbrugeren hurtigt at ombord på en tidligere trænet model, kompilere og optimere modellen til instanskapaciteterne og efterfølgende implementere de kompilerede modeller til produktionsinferensbrugssager i tre trin vist i den følgende figur.

For at lære mere om justering af en models ydeevne, se Cloud AI 100 Key Performance Parameters Dokumentation.

Kom godt i gang med DL2q-instanser

I dette eksempel kompilerer og implementerer du en foruddannet BERT model fra Knusende ansigt på en EC2 DL2q-instans ved hjælp af en forudbygget tilgængelig DL2q AMI, i fire trin.

Du kan bruge enten en præ-bygget Qualcomm DLAMI på instansen eller start med en Amazon Linux2 AMI og byg din egen DL2q AMI med Cloud AI 100 Platform og Apps SDK tilgængelig i denne Amazon Simple Storage Service (Amazon S3) spand: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

De følgende trin bruger den præbyggede DL2q AMI, Qualcomm Base AL2 DLAMI.

Brug SSH til at få adgang til din DL2q-instans med Qualcomm Base AL2 DLAMI AMI, og følg trin 1 til 4.

Trin 1. Konfigurer miljøet og installer de nødvendige pakker

- Installer Python 3.8.

- Konfigurer det virtuelle Python 3.8-miljø.

- Aktiver det virtuelle Python 3.8-miljø.

- Installer de nødvendige pakker, vist i krav.txt-dokument tilgængelig på Qualcomm's offentlige Github-websted.

- Importer de nødvendige biblioteker.

Trin 2. Importer modellen

- Importer og tokenize modellen.

- Definer et eksempelinput og udtræk

inputIds,attentionMask. - Konverter modellen til ONNX, som derefter kan overføres til compileren.

- Du vil køre modellen i FP16-præcision. Så du skal kontrollere, om modellen indeholder konstanter ud over FP16-området. Send modellen til

fix_onnx_fp16funktion til at generere den nye ONNX-fil med de nødvendige rettelser.

Trin 3. Kompiler modellen

qaic-exec kompileringsværktøj til kommandolinjegrænseflade (CLI) bruges til at kompilere modellen. Inputtet til denne compiler er ONNX-filen genereret i trin 2. Compileren producerer en binær fil (kaldet QPC, For Qualcomm program container) i stien defineret af -aic-binary-dir argument.

I kompileringskommandoen nedenfor bruger du fire AI-beregningskerner og en batchstørrelse på én til at kompilere modellen.

QPC'en genereres i bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc mappe.

Trin 4. Kør modellen

Konfigurer en session for at køre inferensen på en Cloud AI100 Qualcomm-accelerator i DL2q-instansen.

Qualcomm qaic Python-biblioteket er et sæt API'er, der understøtter at køre inferens på Cloud AI100-acceleratoren.

- Brug Session API-kaldet til at oprette en forekomst af session. Session API-kaldet er indgangspunktet for at bruge det qaic Python-bibliotek.

- Omstrukturer dataene fra outputbuffer med

output_shape,output_type. - Afkod det producerede output.

Her er output for inputsætningen "Hunden [MASK] på måtten."

Det er det. Med blot et par trin kompilerede og kørte du en PyTorch-model på en Amazon EC2 DL2q-instans. For at lære mere om onboarding og kompilering af modeller på DL2q-instansen, se Cloud AI100 tutorial dokumentation.

For at lære mere om, hvilke DL-modelarkitekturer der passer godt til AWS DL2q-instanser og den aktuelle modelunderstøttelsesmatrix, se Qualcomm Cloud AI100 dokumentation.

Fås nu

Du kan lancere DL2q-forekomster i dag i AWS-regionerne i USA vest (Oregon) og Europa (Frankfurt) som On-demand, Reserveretog Spot-forekomstereller som en del af en Opsparingsplan. Som sædvanligt med Amazon EC2 betaler du kun for det, du bruger. For mere information, se Amazon EC2-priser.

DL2q-instanser kan implementeres ved hjælp af AWS Deep Learning AMI'er (DLAMI), og containerbilleder er tilgængelige via administrerede tjenester som f.eks Amazon SageMaker, Amazon Elastic Kubernetes Service (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)og AWS ParallelCluster.

For at lære mere, besøg Amazon EC2 DL2q forekomst side, og send feedback til AWS re:Post til EC2 eller gennem dine sædvanlige AWS-supportkontakter.

Om forfatterne

AK Roy er direktør for Product Management hos Qualcomm, for Cloud og Datacenter AI-produkter og -løsninger. Han har over 20 års erfaring inden for produktstrategi og udvikling, med det nuværende fokus på klassens bedste ydeevne og ydeevne/$ end-to-end-løsninger til AI-inferens i skyen, til den brede vifte af use-cases, herunder GenAI, LLM'er, Auto og Hybrid AI.

AK Roy er direktør for Product Management hos Qualcomm, for Cloud og Datacenter AI-produkter og -løsninger. Han har over 20 års erfaring inden for produktstrategi og udvikling, med det nuværende fokus på klassens bedste ydeevne og ydeevne/$ end-to-end-løsninger til AI-inferens i skyen, til den brede vifte af use-cases, herunder GenAI, LLM'er, Auto og Hybrid AI.

Jianying Lang er Principal Solutions Architect hos AWS Worldwide Specialist Organisation (WWSO). Hun har over 15 års erhvervserfaring inden for HPC og AI-området. Hos AWS fokuserer hun på at hjælpe kunder med at implementere, optimere og skalere deres AI/ML-arbejdsbelastninger på accelererede computerforekomster. Hun brænder for at kombinere teknikkerne inden for HPC og AI områder. Jianying har en ph.d.-grad i Computational Physics fra University of Colorado i Boulder.

Jianying Lang er Principal Solutions Architect hos AWS Worldwide Specialist Organisation (WWSO). Hun har over 15 års erhvervserfaring inden for HPC og AI-området. Hos AWS fokuserer hun på at hjælpe kunder med at implementere, optimere og skalere deres AI/ML-arbejdsbelastninger på accelererede computerforekomster. Hun brænder for at kombinere teknikkerne inden for HPC og AI områder. Jianying har en ph.d.-grad i Computational Physics fra University of Colorado i Boulder.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :har

- :er

- $OP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 år

- 15 %

- 17

- 19

- 20

- 20 år

- 22

- 23

- 7

- 75

- 8

- 84

- a

- Om

- over

- accelereret

- accelerator

- acceleratorer

- adgang

- ledsaget

- nøjagtighed

- tværs

- aktiveringer

- Derudover

- fremskreden

- aggregat

- AI

- AI / ML

- Alle

- også

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- ,

- Fondsbørsmeddelelse

- enhver

- api

- API'er

- applikationer

- apps

- arkitektur

- ER

- argument

- ARM

- kunstig

- AS

- assistenter

- At

- auto

- automotive

- autonom

- til rådighed

- AWS

- AKSER

- båndbredde

- bund

- BE

- før

- jf. nedenstående

- Beyond

- BIN

- Bloker

- Bloom

- bringe

- bred

- buffer

- bygge

- by

- ringe

- kaldet

- CAN

- kapaciteter

- Kapacitet

- kort

- tilfælde

- kontrollere

- Classic

- Cloud

- Colorado

- kombinerer

- Kommunikation

- omfattende

- beregningsmæssige

- Compute

- computer

- Computer Vision

- computere

- computing

- konsekvent

- Bestående

- kontakter

- Container

- indeholder

- indhold

- Indholdsgenerering

- skabe

- Nuværende

- Kunder

- data

- Datacenter

- dyb

- dyb læring

- definerede

- Degree

- levere

- leverer

- indsætte

- indsat

- implementering

- beskrevet

- udvikle

- Udvikler

- Udvikling

- enhed

- Enheder

- Broadcasting

- Direktør

- dokumentation

- Dog

- kørsel

- dynamisk

- Edge

- effektiv

- enten

- beskæftiger

- muliggør

- ende til ende

- indrejse

- Miljø

- miljøer

- Europa

- eksempel

- erfaring

- udvidet virkelighed

- ekstrakt

- falsk

- Feature

- tilbagemeldinger

- få

- felt

- Fields

- Figur

- File (Felt)

- Fornavn

- passer

- Fokus

- fokuserer

- følger

- efter

- Til

- fundet

- fire

- Frankfurt

- fra

- funktion

- fusion

- generelt

- generere

- genereret

- generation

- generative

- Generativ AI

- GitHub

- given

- godt

- Gæst

- gæst Indlæg

- he

- headsets

- hjælpe

- link.

- Høj ydeevne

- højere

- højdepunkter

- besidder

- HPC

- HTML

- HTTPS

- Hybrid

- i

- IDX

- if

- billede

- billeder

- gennemføre

- implementering

- importere

- in

- Herunder

- inkorporerer

- individuel

- industrien

- brancheførende

- oplysninger

- indgang

- installere

- instans

- Intel

- Intelligent

- sammenkoblet

- grænseflade

- IT

- jpg

- lige

- Nøgle

- Lane

- Sprog

- stor

- Latency

- lancere

- LÆR

- læring

- biblioteker

- Bibliotek

- lys

- Line (linje)

- belastninger

- lykkedes

- ledelse

- maske

- Matrix

- max

- Maksimer

- Maksimerer

- maksimal

- Hukommelse

- mesh

- Meta

- microsoft

- minut

- model

- modeller

- modificeret

- mere

- mest

- navn

- smal

- Natural

- Natural Language Processing

- nødvendig

- Behov

- netværk

- netværk

- net

- Ny

- næste generation

- nu

- bedøvet

- Nvidia

- objekt

- of

- on

- Ombord

- onboarding

- ONE

- kun

- åbent

- OpenAI

- Optimer

- optimeret

- or

- Oregon

- organisation

- OS

- Andet

- ud

- output

- udgange

- i løbet af

- egen

- pakker

- side

- del

- passerer

- Bestået

- lidenskabelige

- sti

- Betal

- per

- ydeevne

- personale

- phd

- Fysik

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- Populær

- mulig

- Indlæg

- strøm

- Precision

- tidligere

- Main

- forarbejdning

- produceret

- producerer

- Produkt

- produktstyring

- produktion

- Produkter

- Program

- projekt

- giver

- leverer

- offentlige

- Python

- pytorch

- Qualcomm

- hurtigt

- rækkevidde

- RE

- Læsning

- Reality

- regioner

- påkrævet

- Krav

- tilbageholdende

- afkast

- genbruge

- roy

- Kør

- kører

- løber

- samme

- Gem

- besparelse

- skalerbar

- Scale

- SDK

- Anden

- se

- send

- dømme

- Sequence

- tjeneste

- Tjenester

- Session

- sæt

- hun

- vist

- Simpelt

- forenkle

- websted

- Størrelse

- smartphone

- smartphones

- So

- Løsninger

- spænding

- specialist

- stable

- standard

- starte

- påbegyndt

- Trin

- Steps

- opbevaring

- butik

- lagring

- Strategi

- Efterfølgende

- sådan

- overlegen

- support

- Støtte

- Understøtter

- SYS

- systemet

- bord

- teknikker

- Teknologier

- tekst

- at

- deres

- derefter

- Disse

- de

- denne

- tre

- Gennem

- kapacitet

- thru

- til

- i dag

- tokenisere

- værktøj

- Toppe

- fakkel

- I alt

- Trafik

- uddannet

- transformers

- sand

- tuning

- tutorial

- forenet

- universitet

- us

- brug

- brug tilfælde

- brugssager

- anvendte

- Bruger

- ved brug af

- sædvanlig

- v1

- VALIDATE

- værdi

- Virtual

- vision

- Besøg

- we

- web

- webservices

- GODT

- Vest

- Hvad

- som

- mens

- bred

- Bred rækkevidde

- vilje

- med

- ord

- arbejder

- verdensplan

- år

- Du

- Din

- zephyrnet