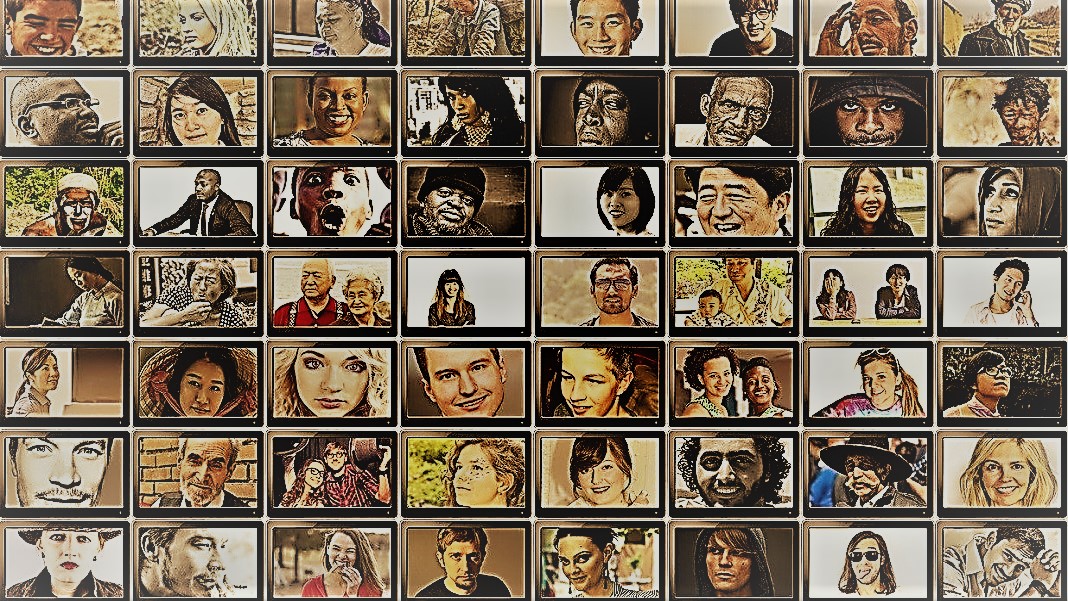

Jeg er stor fan af Anthony Bourdains rejseshow Dele ukendt. I hver episode besøger kokken fjerntliggende landsbyer over hele kloden og dokumenterer regionale stammers liv, mad og kultur med et åbent hjerte og sind.

Showet giver et indblik i menneskehedens forbløffende mangfoldighed. Samfundsforskere har et lignende mål – at forstå forskellige menneskers, gruppers og kulturers adfærd – men bruger en række forskellige metoder i kontrollerede situationer. For begge er stjernerne i disse sysler emnerne: mennesker.

Men hvad nu hvis du erstattede mennesker med AI-chatbots?

Ideen lyder absurd. Men takket være fremkomsten af ChatGPT og andre store sprogmodeller (LLM'er), flirter samfundsforskere med ideen om at bruge disse værktøjer til hurtigt at konstruere forskellige grupper af "simulerede mennesker" og køre eksperimenter for at undersøge deres adfærd og værdier som en proxy til deres biologiske modstykker.

Hvis du forestiller dig digitalt genskabte menneskelige sind, er det ikke det. Ideen er at udnytte ChatGPTs ekspertise til at efterligne menneskelige reaktioner. Fordi modellerne skraber enorme mængder af onlinedata – blogs, Youtube-kommentarer, fanfiction, bøger – fanger de let relationer mellem ord på flere sprog. Disse sofistikerede algoritmer kan også afkode nuancerede aspekter af sproget, såsom ironi, sarkasme, metaforer og følelsesmæssige toner, et kritisk aspekt af menneskelig kommunikation i enhver kultur. Disse styrker sætter LLM'er op til at efterligne flere syntetiske personligheder med en bred vifte af overbevisninger.

Endnu en bonus? Sammenlignet med menneskelige deltagere bliver ChatGPT og andre LLM'er ikke trætte, hvilket giver videnskabsmænd mulighed for at indsamle data og teste teorier om menneskelig adfærd med hidtil uset hastighed.

Idéen, selvom den er kontroversiel, har allerede støtte. En nylig artikel Gennemgang af det begyndende felt fandt ud af, at i visse omhyggeligt designede scenarier, var ChatGPTs svar korreleret med dem fra omkring 95 procent af de menneskelige deltagere.

AI "kunne ændre spillet for samfundsvidenskabelig forskning," sagde Dr. Igor Grossman ved University of Waterloo, som sammen med sine kolleger for nylig skrev en artikel om et fremsyn i Videnskab. Nøglen til brug Homo silicus i forskning? Omhyggelig bias management og datafidelity, sagde teamet.

Undersøgelse af det menneskelige samfundssind

Hvad er samfundsvidenskab egentlig?

Kort sagt, det er at studere, hvordan mennesker – enten som individer eller som en gruppe – opfører sig under forskellige omstændigheder, hvordan de interagerer med hinanden og udvikler sig som en kultur. Det er en paraply af akademisk forfølgelse med flere grene: økonomi, statskundskab, antropologi og psykologi.

Disciplinen behandler en bred vifte af emner, der er fremtrædende i den aktuelle tidsånd. Hvilken indflydelse har sociale medier på mental sundhed? Hvad er den nuværende offentlige holdning til klimaændringer, efterhånden som alvorlige vejrepisoder stiger? Hvordan værdsætter forskellige kulturer kommunikationsmetoder – og hvad udløser misforståelser?

Et samfundsvidenskabeligt studie starter med et spørgsmål og en hypotese. En af mine favoritter: tolererer kulturer kropslugt anderledes? (Det siger du ikke, emnet er blevet undersøgt en del, og ja, der er forskel!)

Forskere bruger derefter en række forskellige metoder, såsom spørgeskemaer, adfærdstest, observation og modellering til at teste deres ideer. Undersøgelser er et særligt populært værktøj, fordi spørgsmålene kan udformes stringent og undersøges og nemt nå ud til en bred vifte af mennesker, når de distribueres online. Forskere analyserer derefter skriftlige svar og drager indsigt i menneskelig adfærd. Med andre ord er en deltagers sprogbrug afgørende for disse undersøgelser.

Så hvordan passer ChatGPT ind?

'Homo Silicus'

For Grossman repræsenterer LLM'erne bag chatbots som ChatGPT eller Google's Bard en hidtil uset mulighed for at redesigne samfundsvidenskabelige eksperimenter.

Fordi de er trænet på massive datasæt, kan LLM'er "repræsentere en bred vifte af menneskelige erfaringer og perspektiver," sagde forfatterne. Fordi modellerne "roamer" frit uden grænser på tværs af internettet - ligesom folk, der ofte rejser internationalt - kan de adoptere og vise en bredere vifte af svar sammenlignet med rekrutterede menneskelige forsøgspersoner.

ChatGPT bliver heller ikke påvirket af andre medlemmer af en undersøgelse eller bliver træt, hvilket potentielt gør det muligt for det at generere mindre partiske svar. Disse egenskaber kan være særligt nyttige i "højrisikoprojekter" - for eksempel ved at efterligne reaktionerne fra mennesker, der lever i lande i krig eller under vanskelige regimer gennem opslag på sociale medier. Til gengæld kunne svarene informere om interventioner fra den virkelige verden.

På samme måde kunne LLM'er, der er uddannet i kulturelle varme emner såsom kønsidentitet eller misinformation, reproducere forskellige teoretiske eller ideologiske tankegange til at informere om politikker. I stedet for omhyggeligt at spørge hundredtusindvis af menneskelige deltagere, kan AI hurtigt generere svar baseret på online diskurs.

Bortset fra potentielle anvendelser i det virkelige liv, kan LLM'er også fungere som digitale emner, der interagerer med menneskelige deltagere i samfundsvidenskabelige eksperimenter, lidt ligesom nonplayer-karakterer (NPC) i videospil. For eksempel kunne LLM adoptere forskellige "personligheder" og interagere med menneskelige frivillige over hele kloden online ved at bruge tekst ved at stille dem det samme spørgsmål. Fordi algoritmer ikke sover, kan den køre 24/7. De resulterende data kan så hjælpe videnskabsmænd med at udforske, hvordan forskellige kulturer vurderer lignende information, og hvordan meninger - og misinformation - spredes.

Baby Steps

Ideen om at bruge chatbots i stedet for mennesker i undersøgelser er endnu ikke mainstream.

Men der er tidlige beviser for, at det kunne virke. EN fortryksundersøgelse udgivet i denne måned fra Georgia Tech, Microsoft Research og Olin College fandt ud af, at en LLM replikerede menneskelige reaktioner i adskillige klassiske psykologiske eksperimenter, herunder de berygtede Milgram chok eksperimenter.

Alligevel er et kritisk spørgsmål tilbage: hvor godt kan disse modeller virkelig fange et menneskes reaktion?

Der er flere snublesten.

Først er kvaliteten af algoritmen og træningsdataene. Det meste onlineindhold er domineret af kun en håndfuld sprog. En LLM trænet på disse data kunne nemt efterligne følelsen, perspektivet eller endda moralsk dømmekraft hos mennesker, der bruger disse sprog - til gengæld arver bias fra træningsdataene.

"Denne bias reproduktion er en stor bekymring, fordi den kan forstærke de meget forskelle, samfundsforskere stræber efter at afdække i deres forskning," sagde Grossman.

Nogle forskere bekymrer sig også om, at LLM'er er retfærdige opstødende hvad de får at vide. Det er modsætningen til et samfundsvidenskabeligt studie, hvor hovedpointen er at fange menneskeheden i al dens mangfoldige og komplekse skønhed. På den anden side er ChatGPT og lignende modeller kendt for at "hallucinere,” gør oplysninger, der lyder plausible, men er falske.

For nu er "store sprogmodeller afhængige af 'skygger' af menneskelige oplevelser," sagde Grossman. Fordi disse AI-systemer stort set er sorte bokse, er det svært at forstå, hvordan eller hvorfor de genererer bestemte reaktioner - en smule bekymrende, når man bruger dem som menneskelige proxyer i adfærdseksperimenter.

På trods af begrænsninger tillader "LLM'er samfundsforskere at bryde fra traditionelle forskningsmetoder og gribe deres arbejde an på innovative måder," sagde forfatterne. Som et første skridt kunne Homo silicus hjælpe med at brainstorme og hurtigt teste hypoteser, hvor lovende hypoteser bliver yderligere valideret i menneskelige populationer.

Men for at samfundsvidenskaberne virkelig kan byde AI velkommen, skal der være gennemsigtighed, retfærdighed og lige adgang til disse kraftfulde systemer. LLM'er er vanskelige og dyre at træne, med nyere modeller i stigende grad lukket bag heftige betalingsmure.

"Vi skal sikre, at socialvidenskabelige LLM'er, ligesom alle videnskabelige modeller, er open source, hvilket betyder, at deres algoritmer og ideelt set data er tilgængelige for alle til at granske, teste og ændre," sagde undersøgelsesforfatter Dr. Dawn Parker ved University of Waterloo. "Kun ved at opretholde gennemsigtighed og replikerbarhed kan vi sikre, at AI-støttet samfundsvidenskabelig forskning virkelig bidrager til vores forståelse af menneskelig erfaring."

Billede Credit: Gerd Altmann / Pixabay

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :har

- :er

- :ikke

- $OP

- 23

- a

- Om

- akademisk

- adgang

- tværs

- Lov

- vedtage

- advent

- AI

- algoritme

- algoritmer

- Alle

- tillade

- tillade

- allerede

- også

- beløb

- an

- analysere

- ,

- Anthony

- tilgang

- ER

- arizona

- Array

- artikel

- AS

- udseende

- aspekter

- At

- forfatter

- forfattere

- til rådighed

- baseret

- BE

- Skønhed

- fordi

- været

- adfærd

- bag

- være

- overbevisninger

- mellem

- skævhed

- forudindtaget

- Bit

- Sort

- Blocks

- krop

- Bonus

- grænser

- både

- kasser

- brainstorm

- grene

- Pause

- men

- by

- CAN

- fange

- forsigtig

- vis

- lave om

- tegn

- chatbots

- ChatGPT

- omstændigheder

- Klima

- Klima forandring

- kolleger

- indsamler

- Kollegium

- kommentarer

- Kommunikation

- sammenlignet

- komplekse

- Bekymring

- konstruere

- indhold

- bidrager

- kontrolleret

- kontroversielle

- kunne

- lande

- kredit

- kritisk

- kritisk aspekt

- kulturelle

- Medarbejder kultur

- Nuværende

- data

- datasæt

- konstrueret

- udvikle

- forskellige

- svært

- digital

- digitalt

- Skærm

- distribueret

- forskelligartede

- Mangfoldighed

- do

- gør

- Er ikke

- Dont

- dr

- tegne

- hver

- Tidligt

- nemt

- Økonomi

- enorm

- sikre

- episode

- lige

- især

- evaluere

- Endog

- Hver

- præcist nok

- eksempel

- dyrt

- erfaring

- Oplevelser

- eksperimenter

- ekspertise

- udforske

- fairness

- falsk

- ventilator

- Fiktion

- troskab

- felt

- Fornavn

- passer

- fødevarer

- Til

- fundet

- fra

- yderligere

- spil

- Spil

- Køn

- generere

- Georgien

- få

- glimt

- kloden

- Googles

- Gruppens

- hånd

- håndfuld

- Have

- Helse

- Hjerte

- hjælpe

- HOT

- Hvordan

- HTML

- http

- HTTPS

- kæmpe

- menneskelig

- Menneskelig erfaring

- Menneskelighed

- Mennesker

- Hundreder

- idé

- ideelt

- ideer

- Identity

- if

- KIMOs Succeshistorier

- in

- I andre

- Herunder

- Forøg

- stigende

- enkeltpersoner

- berygtede

- påvirket

- informere

- oplysninger

- innovativ

- indsigt

- interagere

- ind

- ironi

- IT

- ITS

- jpg

- lige

- Nøgle

- kendt

- Sprog

- Sprog

- stor

- vid udstrækning

- mindre

- ligesom

- begrænsninger

- Lives

- levende

- LLM

- Main

- Mainstream

- Vedligeholdelse

- større

- Making

- ledelse

- massive

- Kan..

- betyder

- Medier

- Medlemmer

- mentale

- Mental sundhed

- metoder

- microsoft

- tankerne

- sind

- misinformation

- modellering

- modeller

- ændre

- Måned

- moralsk

- mest

- flere

- skal

- my

- spirende

- Behov

- ingen

- nu

- talrige

- of

- tit

- on

- ONE

- dem

- online

- åbent

- open source

- Opportunity

- or

- Andet

- vores

- deltagere

- Mennesker

- procent

- Personligheder

- perspektiv

- perspektiver

- plato

- Platon Data Intelligence

- PlatoData

- plausibel

- Punkt

- politikker

- politisk

- Populær

- populationer

- Indlæg

- potentielt

- vigtigste

- sonde

- fremtrædende

- lovende

- bevis

- giver

- proxy

- Psykologi

- offentlige

- udøvelse

- kvalitet

- spørgsmål

- Spørgsmål

- rækkevidde

- hurtigt

- hellere

- nå

- virkelige verden

- virkelig

- nylige

- for nylig

- redesign

- regimer

- regional

- Relationer

- frigivet

- stole

- resterne

- fjern

- udskiftes

- replikerbarhed

- replikeres

- repræsentere

- reproduktion

- forskning

- svar

- reaktioner

- resulterer

- groft

- Kør

- Said

- samme

- scenarier

- Skoler

- Videnskab

- VIDENSKABER

- videnskabelig

- forskere

- stemningen

- sæt

- flere

- svær

- Vis

- lignende

- ganske enkelt

- situationer

- søvn

- Social

- sociale medier

- Indlæg på sociale medier

- samfundsmæssigt

- noget

- sofistikeret

- hastighed

- Stjerner

- starter

- Trin

- styrker

- stræbe

- undersøgelser

- Studere

- studere

- snublende

- sådan

- support

- syntetisk

- Systemer

- Taklinger

- Tryk på

- hold

- tech

- prøve

- tests

- end

- Tak

- at

- deres

- Them

- derefter

- teoretisk

- Der.

- Disse

- de

- denne

- dem

- selvom?

- tænkte

- tusinder

- Gennem

- træt

- til

- værktøj

- værktøjer

- Emner

- mod

- traditionelle

- Tog

- uddannet

- Kurser

- Gennemsigtighed

- rejse

- bekymrende

- virkelig

- TUR

- paraply

- afdække

- under

- forstå

- forståelse

- universitet

- uden fortilfælde

- brug

- bruger

- ved brug af

- valideret

- værdi

- Værdier

- række

- Vast

- meget

- undersøgt

- video

- videospil

- Besøg

- frivillige

- krig

- måder

- we

- Vejr

- velkommen

- GODT

- Hvad

- hvornår

- som

- WHO

- hvorfor

- bred

- Bred rækkevidde

- bredere

- Wikipedia

- vilje

- med

- uden

- ord

- Arbejde

- virker

- bekymre sig

- skriftlig

- Ja

- endnu

- Du

- youtube

- tidsånden

- zephyrnet