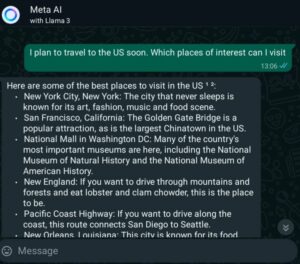

En af de største risici med den øgede brug af AI-chatbots som ChatGPT er fremkomsten af nye trusler mod brugerdata. Men nogle virksomheder begynder at bygge decentraliserede AI-systemer, som de håber vil gøre lækage af personlige data vanskeligere.

AI-startup Elna er en sådan enhed. Det Indien-baserede firma giver folk mulighed for at skabe tilpassede AI chatbots på blockchain og samtidig forblive "decentral, transparent" og gratis at bruge.

Læs også: Vil decentraliseret digitalt ID bremse AI-trusler i Web3 og Metaverse?

Sikkerhed på blockchain

"Elna prioriterer brugerdatabeskyttelse gennem brugen af Internet Computer Protocol (ICP)-beholdere [eller smarte kontrakter], som er decentrale containere, der styres direkte af brugerens tegnebog," fortalte Elnas medstifter og administrerende direktør Arun PM MetaNews.

"Denne ramme sikrer fuldstændig ejerskab, gennemsigtighed og kontrol over data fra brugeren," sagde han.

ICP er et blockchain-netværk - den samme slags teknologi, der understøtter Bitcoin – der sigter mod at forbedre effektiviteten og hastigheden til decentraliseret datalagring.

En stor bekymring med centraliserede og lukkede AI-platforme såsom OpenAI (som tilsyneladende begyndte livet som en non-profit med det formål at bygge open source-modeller) eller Google, er persondatas sårbarhed. I et sådant set-up opbevares data typisk på virksomhedens servere, ofte med begrænset kontrol fra den enkelte.

Arum PM siger, at brugen af smarte kontrakter inden for kunstig intelligens løser dette problem ved at hjælpe med at beskytte privatlivets fred og brugerdata, såsom handelsinformation og chathistorik, via decentral lagring. På den måde har folk kontrol over deres egen information, tilføjer han.

Arun siger, at Elna ikke "gemmer eller bruger" brugerdata. Han slår fast, at modellen "i sagens natur stemmer overens med EU's skrappe General Data Protection Regulation (GDPR) og andre globale love om privatlivets fred. I stedet gemmer brugerne deres egne data ved hjælp af smarte kontraktbaserede tegnebøger.

"Ved at udnytte blockchain-teknologien sikrer Elna, at integriteten og privatlivets fred for brugerdata opretholdes," fortæller Arun os og tilføjer, at platformen kun indsamler de data, den skal bruge for at fungere optimalt.

"Vi vedtager bedste praksis inden for dataminimering og tilbyder brugerne værktøjerne til at administrere deres data effektivt," sagde han.

Hvad er Elna AI?

Lanceret i august 2023, Elna beskriver sig selv som en "fællesskabsdrevet decentraliseret AI-agentoprettelsesplatform." I modsætning til andre AI-chatbots, hvor operatørerne vælger træningsdataene, kan brugere af Elna uploade deres egne data til netværket og træne AI-modeller, der fokuserer på emner og applikationer, der interesserer dem.

Når det er gjort, implementerer Elna derefter din kunstige intelligens-assistent eller AI-agent på ICP-blockchainen, hvor brugere løbende kan udvide deres AI's viden ved at tilføje nye data.

Elna er drevet af det firmaet kalder "kanister smarte kontrakter” som er ansvarlige for træning af AI-modeller og implementering. Det bruger også noget kendt som en "vektordatabase" til lagring af information i kæden.

Folk bruger deres tegnebøger til at logge ind på systemet, og til styring bruger de ELNA-tokenet, mens Elixir er et værktøjstoken, begge bygget på Internet Computer Protocol.

ChatGPT-datalækker

Big Tech har ikke tidligere kunnet sikre brugerdata. Centraliserede enheder, som Facebook, har bevist, at de spiller hurtigt og løst med brugerdata. Det sociale medienetværk lækkede personlige e-mails, telefonnumre, beskeder, billeder og videoer.

Data i sig selv er blevet et produkt, der kan sælges, og med mere end 24 milliarder besøg på top 50 AI-værktøjer sidste år, iflg. Forfatterkammerat, har risikoen aldrig været højere. At levere unikke datasæt, som indsamlet af kunstig intelligens-virksomheder, giver en meget lukrativ satsning, når disse data falder i de forkerte hænder.

Faktisk, i marts 2023, en fejl, der udsat tusindvis af chattitler, den første besked om nye samtaler og betalingsoplysninger fra ChatGPT Plus-brugere kom frem. OpenAI undskyldte for lækagen, men det er blevet undersøgt for, hvordan det beskytter brugerdata.

Som MetaNews tidligere rapporterede, var ChatGPT midlertidigt forbudt i Italien af netop denne grund. Regulatorer var bekymrede over brud på privatlivets fred som defineret under GDPR.

Forskere fra University of North Carolina fandt også, at centraliserede store sprogmodeller såsom ChatGPT eller Googles Gemini løbende lække følsomme data, inklusive økonomiske poster, selv efter at det er blevet slettet af chatbot-skaberne.

Decentraliseret AI: Reimagining the wheel

Mens data, der er lagret på blockchain, er umulige at manipulere med, er decentraliserede AI-platforme som Elna ikke uden deres egne udfordringer, selv med løftet om en fremtid, hvor brugerne kontrollerer deres data.

"Den primære udfordring i decentraliseret AI er manglen på en grundlæggende infrastruktur og rammer, der eksisterer i web2, hvilket nødvendiggør en reimagining af hjulet for AI i web3," sagde Elna CEO Arun PM.

Han mener også, at eksisterende globale reguleringsrammer "ikke er fuldt udstyret til at løse de unikke udfordringer og privatlivsproblemer, som centraliserede AI-systemer udgør." Arun sagde, at tilsynsmyndigheder ofte halter bagefter vigtige fremskridt inden for teknologi, hvilket gør det sværere for dem at gennemføre rettidig data- og privatlivsbeskyttelseslovgivning.

Men hvad sker der i tilfælde af, at Elnas decentraliserede AI-model lider af et sikkerhedsbrud, der fører til tab af brugerdata? Er det overhovedet muligt? Arun PM sagde, at et sådant brud kun kunne forekomme på det brugeroprettede chabot-niveau, ikke på Elnas infrastruktur.

"Den decentraliserede karakter af platformen giver mulighed for præcis sporing og tildeling af ansvar," uddybede han. "Denne model sikrer, at ansvarlighed opretholdes, med evnen til at identificere og adressere brud affektivt."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://metanews.com/decentralized-ai-offers-new-hope-for-user-data-security/

- :har

- :er

- :ikke

- :hvor

- 2023

- 24

- 400

- 50

- 600

- 7

- 9

- 900

- a

- evne

- Om

- Ifølge

- ansvarlighed

- tilføje

- adresse

- Tilføjer

- vedtage

- fremskridt

- Efter

- Agent

- AI

- AI modeller

- AI-systemer

- sigter

- målsætninger

- tillader

- også

- ,

- applikationer

- ER

- kunstig

- kunstig intelligens

- Kunstig intelligens virksomheder

- AS

- Assistant

- At

- AUGUST

- avatar

- BE

- bliver

- været

- begyndte

- bag

- mener

- BEDSTE

- bedste praksis

- Største

- Billion

- blockchain

- Blockchain netværk

- både

- brud

- brud

- Bug

- bygge

- bygget

- men

- by

- Opkald

- kom

- CAN

- dåser

- Carolina

- centraliseret

- Direktør

- udfordre

- udfordringer

- chatte

- chatbot

- chatbots

- ChatGPT

- Vælg

- lukket

- Medstifter

- Kom

- Virksomheder

- selskab

- fuldføre

- computer

- Bekymring

- pågældende

- Bekymringer

- Beholdere

- kontinuerligt

- kontrakter

- kontrol

- kontrolleret

- samtaler

- kunne

- skabe

- oprettet

- skabelse

- skabere

- kantsten

- tilpassede

- data

- databeskyttelse

- datasikkerhed

- datasæt

- data opbevaring

- decentral

- definerede

- implementering

- udruller

- detaljeret

- Dfinity

- svært

- digital

- Digital ID

- direkte

- gør

- færdig

- effekt

- effektivt

- effektivitet

- emails

- fremkomsten

- sikrer

- enheder

- enhed

- udstyret

- Endog

- begivenhed

- eksisterende

- eksisterer

- Udvid

- mislykkedes

- Falls

- FAST

- finansielle

- Firm

- Fornavn

- fast

- Fokus

- Til

- fundet

- grundlæggende

- Framework

- rammer

- Gratis

- fra

- fuldt ud

- fremtiden

- GDPR

- Gemini

- Generelt

- generelle data

- Generel databeskyttelsesforordning

- gif

- Global

- Googles

- regeringsførelse

- hænder

- sker

- hårdere

- Have

- he

- hjælpe

- Høj

- højere

- historie

- håber

- Hvordan

- HTTPS

- ICP

- ID

- identificere

- umuligt

- Forbedre

- in

- Herunder

- øget

- individuel

- oplysninger

- Infrastruktur

- i stedet

- integritet

- Intelligens

- interesse

- Internet

- Internet-computer

- ind

- IT

- Italiensk vin

- selv

- holdt

- Nøgle

- Venlig

- viden

- kendt

- Mangel

- Sprog

- stor

- Efternavn

- Sidste år

- Love

- Leads

- lække

- Lækager

- Niveau

- løftestang

- Livet

- lys

- ligesom

- Limited

- log

- off

- lukrative

- opretholdes

- større

- lave

- maerker

- administrere

- Marts

- Medier

- besked

- beskeder

- MetaNews

- metaverse

- minimering

- model

- modeller

- mere

- Natur

- nødvendiggør

- behov

- netværk

- aldrig

- Ny

- non-profit

- Nord

- nord carolina

- numre

- forekomme

- of

- tilbyde

- Tilbud

- tit

- on

- On-Chain

- ONE

- kun

- på

- open source

- OpenAI

- betjene

- Operatører

- or

- Andet

- i løbet af

- egen

- ejerskab

- forbi

- betaling

- Mennesker

- personale

- Personlig data

- telefon

- Billeder

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- plus

- pm

- stillet

- mulig

- strøm

- praksis

- brug

- tidligere

- primære

- prioriterer

- Beskyttelse af personlige oplysninger

- Problem

- Produkt

- løfte

- beskyttelse

- beskytter

- protokol

- gennemprøvet

- leverer

- Læs

- grund

- optegnelser

- Regulering

- Regulators

- lovgivningsmæssige

- forestille sig igen

- forblive

- rapporteret

- ansvar

- ansvarlige

- Risiko

- risici

- værne

- Said

- samme

- siger

- kontrol

- sikker

- sikkerhed

- følsom

- Servere

- sæt

- Smart

- Smarte kontrakter

- Social

- sociale medier

- Sociale medier netværk

- solgt

- nogle

- noget

- Kilde

- hastighed

- Starter

- opstart

- Stater

- opbevaring

- butik

- opbevaret

- lagring

- sådan

- lider

- systemet

- Systemer

- tech

- Teknologier

- fortæller

- end

- at

- deres

- Them

- derefter

- de

- denne

- tusinder

- trusler

- Gennem

- tid

- rettidig

- titler

- til

- token

- fortalt

- værktøjer

- top

- Emner

- hård

- Sporing

- Trading

- Tog

- Kurser

- Gennemsigtighed

- typisk

- under

- understøtter

- enestående

- universitet

- I modsætning til

- us

- brug

- Bruger

- brugere

- ved brug af

- nytte

- Utility Token

- udnytter

- venture

- meget

- via

- Videoer

- Besøg

- tegnebog

- Punge

- var

- Vej..

- Web2

- Web3

- web3 og metaverse

- var

- Hvad

- Hjul

- hvornår

- som

- mens

- vilje

- med

- uden

- Forkert

- forkerte hænder

- år

- Din

- zephyrnet