DeepMind har gjort det igen.

Efter at have løst en grundlæggende udfordring i biologi-forudsige proteinstruktur-og udrede matematikken i knudeteorien, det tager sigte på en grundlæggende computerproces, der er indlejret i tusindvis af hverdagsapplikationer. Fra parsing af billeder til modelleringsvejr eller endda undersøge de indre funktioner i kunstige neurale netværk, AI kunne teoretisk fremskynde beregninger på tværs af en række felter, øge effektiviteten og samtidig reducere energiforbrug og omkostninger.

Men mere imponerende er det hvordan de gjorde det. Den rekordstore algoritme, døbt AlphaTensor, er en spinoff af Alpha Zero, som berømt satte menneskelige spillere i skak og Go.

"Algorithmer er blevet brugt i hele verdens civilisationer til at udføre grundlæggende operationer i tusinder af år," skrev medforfattere Drs. Matej Balog og Alhussein Fawzi hos DeepMind. "Men det er meget udfordrende at opdage algoritmer."

AlphaTensor baner et spor til en ny verden, hvor AI designer programmer, der udkonkurrerer alt, hvad mennesker ingeniører, og samtidig forbedrer sin egen maskin-"hjerne".

"Dette arbejde skubber ind på ukendt territorium ved at bruge AI til et optimeringsproblem, som folk har arbejdet på i årtier ... de løsninger, det finder, kan udvikles med det samme for at forbedre beregningsmæssige køretider," sagde Dr. Federico Levi, seniorredaktør på Natur, Hvilket offentliggjort Studiet.

Indtast matrixmultiplikationen

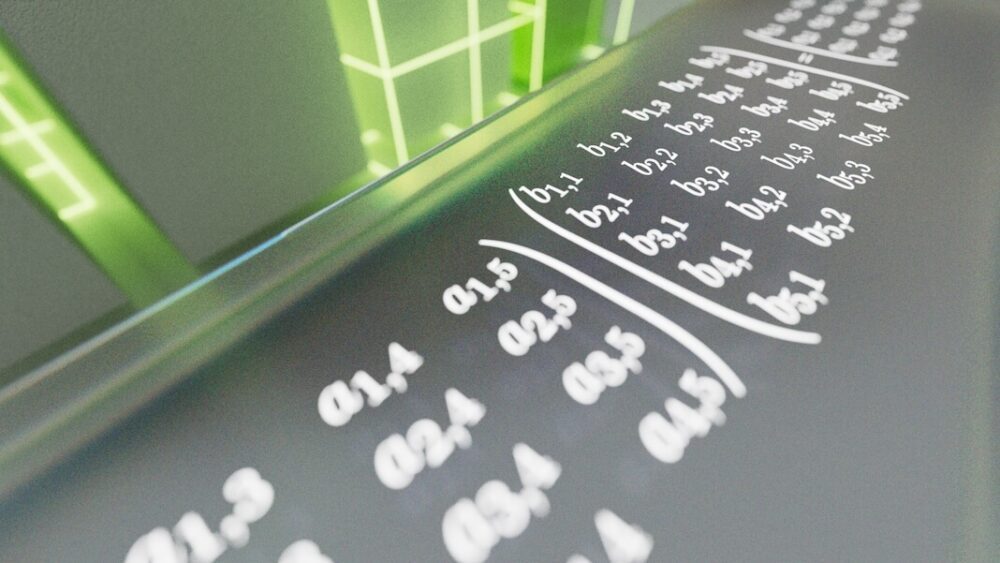

Problemet AlphaTensor står over for er matrixmultiplikation. Hvis du pludselig ser for dig rækker og kolonner med grønne tal, der ruller ned på skærmen, er du ikke alene. Groft sagt er en matrix sådan set - et gitter af tal, der digitalt repræsenterer data efter eget valg. Det kan være pixels i et billede, frekvenserne af et lydklip eller udseendet og handlingerne af karakterer i videospil.

Matrixmultiplikation tager to gitter af tal og multiplicerer den ene med den anden. Det er en beregning, der ofte undervises i i gymnasiet, men som også er afgørende for computersystemer. Her ganges rækker af tal i én matrix med kolonner i en anden. Resultaterne genererer et resultat - for eksempel en kommando til at zoome ind eller vippe din visning af en videospilscene. Selvom disse beregninger fungerer under motorhjelmen, er enhver, der bruger en telefon eller computer, afhængig af deres resultater hver eneste dag.

Du kan se, hvordan problemet kan blive ekstremt svært, ekstremt hurtigt. At multiplicere store matricer er utroligt energi- og tidskrævende. Hvert talpar skal ganges individuelt for at konstruere en ny matrix. Efterhånden som matricerne vokser, bliver problemet hurtigt uholdbart - endnu mere end at forudsige de bedste skak- eller Go-træk. Nogle eksperter vurderer, at der er flere måder at løse matrixmultiplikation end antallet af atomer i universet.

Tilbage i 1969 viste Volker Strassen, en tysk matematiker, at der er måder at skære hjørner på ved at skære en runde to-til-to matrixmultiplikation fra i alt otte til syv. Det lyder måske ikke imponerende, men Strassens metode viste, at det er muligt at slå langvarige standarder for operationer - det vil sige algoritmer - til matrixmultiplikation. Hans tilgang, Strassen-algoritmen, har regeret som den mest effektive tilgang i over 50 år.

Men hvad nu hvis der er endnu mere effektive metoder? "Ingen kender den bedste algoritme til at løse det," Dr. François Le Gall ved Nagoya Universitet i Japan, som ikke var involveret i arbejdet, fortalt MIT Technology Review. "Det er et af de største åbne problemer inden for datalogi."

AI Chasing Algoritmer

Hvis den menneskelige intuition vakler, hvorfor så ikke bruge et mekanisk sind?

I den nye undersøgelse forvandlede DeepMind-teamet matrixmultiplikation til et spil. I lighed med sin forgænger AlphaZero bruger AlphaTensor deep reinforcement learning, en maskinlæringsmetode inspireret af den måde, biologiske hjerner lærer på. Her interagerer en AI-agent (ofte et kunstigt neuralt netværk) med sit miljø for at løse et flertrinsproblem. Hvis det lykkes, tjener det en "belønning" - det vil sige, at AI'ens netværksparametre opdateres, så det er mere sandsynligt, at det lykkes igen i fremtiden.

Det er som at lære at vende en pandekage. Masser vil i starten falde på gulvet, men i sidste ende vil dine neurale netværk lære arm- og håndbevægelserne til et perfekt flip.

Træningspladsen for AlphaTensor er en slags 3D-brætspil. Det er i bund og grund et puslespil for én spiller, der nogenlunde ligner Sudoku. AI'en skal multiplicere gitter af tal i de færrest mulige trin, mens den vælger fra et utal af tilladte træk - over en billion af dem.

Disse tilladte bevægelser blev omhyggeligt designet i AlphaTensor. På en pressebriefing forklarede medforfatter Dr. Hussain Fawzi: "At formulere rummet for algoritmisk opdagelse er meget indviklet ... endnu sværere er, hvordan kan vi navigere i dette rum."

Med andre ord, når vi står over for en forbløffende række af muligheder, hvordan kan vi så indsnævre dem for at forbedre vores chancer for at finde nålen i høstakken? Og hvordan kan vi bedst planlægge for at komme til nålen uden at grave gennem hele høstakken?

Et trick, som holdet har indarbejdet i AlphaTensor, er en metode kaldet træsøgning. I stedet for, metaforisk talt, tilfældigt at grave gennem høstakken, sonderer AI her "veje", der kunne føre til et bedre resultat. Den mellemliggende læring hjælper derefter AI med at planlægge sit næste træk for at øge chancerne for succes. Holdet viste også algoritmeeksempler af vellykkede spil, som at lære et barn åbningstræk af skak. Endelig, når AI opdagede værdifulde træk, tillod holdet det at omorganisere disse operationer for mere skræddersyet læring i søgen efter et bedre resultat.

Bryder ny jord

AlphaTensor spillede godt. I en række tests udfordrede holdet AI til at finde de mest effektive løsninger til matricer op til fem gange fem – det vil sige med fem tal hver i en række eller kolonne.

Algoritmen genopdagede hurtigt Strassens originale hack, men overgik derefter alle løsninger, der tidligere var udtænkt af det menneskelige sind. Ved at teste AI med forskellige størrelser af matricer fandt AlphaTensor mere effektive løsninger til over 70. "Faktisk opdager AlphaTensor typisk tusindvis af algoritmer for hver størrelse af matrix," sagde teamet. "Det er sindssygt."

I et tilfælde, multiplicerede en fem gange fem matrix med en fire gange fem, reducerede AI den tidligere rekord på 80 individuelle multiplikationer til kun 76. Den skinnede også på større matricer, hvilket reducerede antallet af beregninger, der var nødvendige for to elleve gange elleve matricer fra 919 til 896.

Proof-of-concept i hånden, holdet vendte sig til praktisk brug. Computerchips er ofte designet til at optimere forskellige beregninger - GPU'er til grafik, for eksempel eller AI-chips til maskinlæring– og at matche en algoritme med den bedst egnede hardware øger effektiviteten.

Her brugte teamet AlphaTensor til at finde algoritmer til to populære chips inden for maskinlæring: NVIDIA V100 GPU og Google TPU. Alt i alt øgede de AI-udviklede algoritmer beregningshastigheden med op til 20 procent.

Det er svært at sige, om AI også kan fremskynde smartphones, bærbare computere eller andre dagligdagsenheder. Men "denne udvikling ville være meget spændende, hvis den kan bruges i praksis," sagde MIT's Dr. Virginia Williams. "Et boost i ydeevnen ville forbedre mange applikationer."

Sindet af en AI

På trods af, at AlphaTensor har slået den seneste menneskelige rekord for matrixmultiplikation, kan DeepMind-teamet endnu ikke forklare hvorfor.

"Det har fået denne fantastiske intuition ved at spille disse spil," sagde DeepMind-forsker og medforfatter Dr. Pushmeet Kohli ved en pressebriefing.

Udvikling af algoritmer behøver heller ikke at være menneske mod maskiner.

Selvom AlphaTensor er et springbræt i retning af hurtigere algoritmer, kunne der findes endnu hurtigere algoritmer. "Fordi den er nødt til at begrænse sin søgning til algoritmer af en bestemt form, kan den gå glip af andre typer algoritmer, der kan være mere effektive," skrev Balog og Fawzi.

Måske ville en endnu mere spændende vej kombinere menneskelig og maskinel intuition. "Det ville være rart at finde ud af, om denne nye metode faktisk optager alle de tidligere, eller om du kan kombinere dem og få noget endnu bedre," sagde Williams. Andre eksperter er enige. Med et væld af algoritmer til deres rådighed, kan forskere begynde at dissekere dem for at finde ledetråde til, hvad der fik AlphaTensors løsninger til at tikke, og banede vejen for det næste gennembrud.

Billedkredit: DeepMind