I dag er vi glade for at kunne annoncere muligheden for at finjustere Llama 2-modeller af Meta vha. Amazon SageMaker JumpStart. Llama 2-familien af store sprogmodeller (LLM'er) er en samling af fortrænede og finjusterede generative tekstmodeller i en skala fra 7 milliarder til 70 milliarder parametre. Finjusterede LLM'er, kaldet Llama-2-chat, er optimeret til dialogbrug. Du kan nemt afprøve disse modeller og bruge dem med SageMaker JumpStart, som er en maskinlæringshub (ML), der giver adgang til algoritmer, modeller og ML-løsninger, så du hurtigt kan komme i gang med ML. Nu kan du også finjustere 7 milliarder, 13 milliarder og 70 milliarder parametre Llama 2-tekstgenereringsmodeller på SageMaker JumpStart ved hjælp af Amazon SageMaker Studio UI med et par klik eller ved at bruge SageMaker Python SDK.

Generative AI-fundamentmodeller har været i fokus for det meste af ML og kunstig intelligens-forskning og -brug i over et år nu. Disse grundmodeller klarer sig meget godt med generative opgaver, såsom tekstgenerering, opsummering, besvarelse af spørgsmål, billed- og videogenerering med mere, på grund af deres store størrelse og også fordi de er trænet i flere store datasæt og hundredvis af opgaver. På trods af disse modellers store generaliseringskapacitet er der ofte use cases, der har meget specifikke domænedata (såsom sundhedspleje eller finansielle tjenester), hvorfor disse modeller muligvis ikke er i stand til at give gode resultater for disse use cases. Dette resulterer i et behov for yderligere finjustering af disse generative AI-modeller i forhold til brugscasespecifikke og domænespecifikke data.

I dette indlæg gennemgår vi, hvordan man finjusterer Llama 2-trænede tekstgenereringsmodeller via SageMaker JumpStart.

Hvad er Llama 2

Llama 2 er en auto-regressiv sprogmodel, der bruger en optimeret transformerarkitektur. Llama 2 er beregnet til kommerciel og forskningsmæssig brug på engelsk. Den kommer i en række parameterstørrelser – 7 milliarder, 13 milliarder og 70 milliarder – såvel som forudtrænede og finjusterede variationer. Ifølge Meta bruger de tunede versioner overvåget finjustering (SFT) og forstærkningslæring med menneskelig feedback (RLHF) for at tilpasse sig menneskelige præferencer for hjælpsomhed og sikkerhed. Llama 2 blev fortrænet på 2 billioner tokens af data fra offentligt tilgængelige kilder. De indstillede modeller er beregnet til assistent-lignende chat, hvorimod præ-trænede modeller kan tilpasses til en række forskellige naturlige sproggenereringsopgaver. Uanset hvilken version af modellen en udvikler bruger, vil ansvarlig brugsvejledning fra Meta kan hjælpe med at vejlede yderligere finjusteringer, der kan være nødvendige for at tilpasse og optimere modellerne med passende sikkerhedsbegrænsninger.

I øjeblikket er Llama 2 tilgængelig i følgende regioner:

- Implementer forudtrænet model tilgængelig:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Finjuster og implementer den finjusterede model:

“us-east-1”,“us-west-2”,“eu-west-1”

Hvad er SageMaker JumpStart

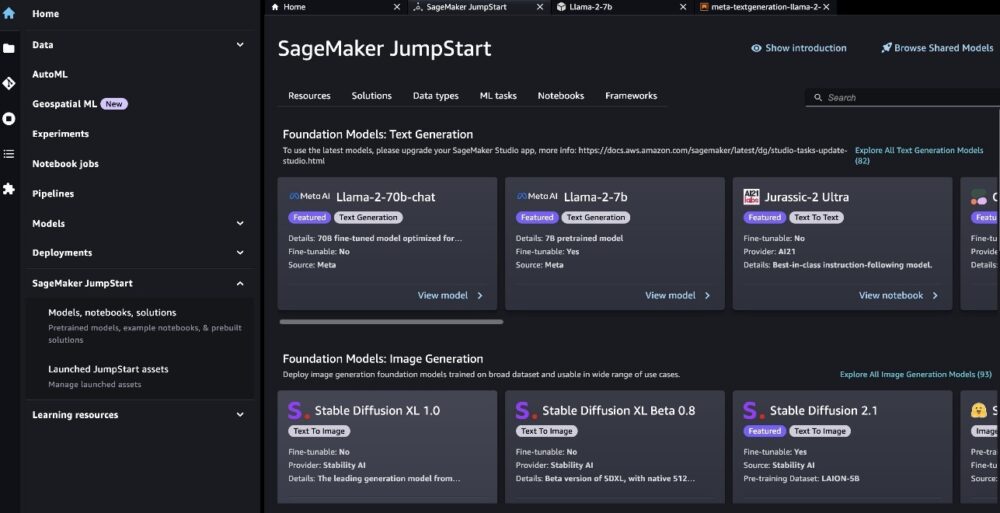

Med SageMaker JumpStart kan ML-praktikere vælge mellem et bredt udvalg af offentligt tilgængelige foundation-modeller. ML praktikere kan implementere fundamentmodeller til dedikerede Amazon SageMaker forekomster fra et netværksisoleret miljø og tilpasse modeller ved hjælp af SageMaker til modeltræning og implementering. Du kan nu opdage og implementere Llama 2 med nogle få klik i SageMaker Studio eller programmatisk gennem SageMaker Python SDK, så du kan udlede modelydeevne og MLOps-kontroller med SageMaker-funktioner som f.eks. Amazon SageMaker Pipelines, Amazon SageMaker Debuggereller containerlogfiler. Modellen er implementeret i et AWS-sikkert miljø og under din VPC-kontrol, hvilket hjælper med at sikre datasikkerhed. Derudover kan du finjustere Llama2 7B, 13B og 70B fortrænede tekstgenereringsmodeller via SageMaker JumpStart.

Finjuster Llama2-modeller

Du kan finjustere modellerne ved at bruge enten SageMaker Studio UI eller SageMaker Python SDK. Vi diskuterer begge metoder i dette afsnit.

Kodefri finjustering via SageMaker Studio UI

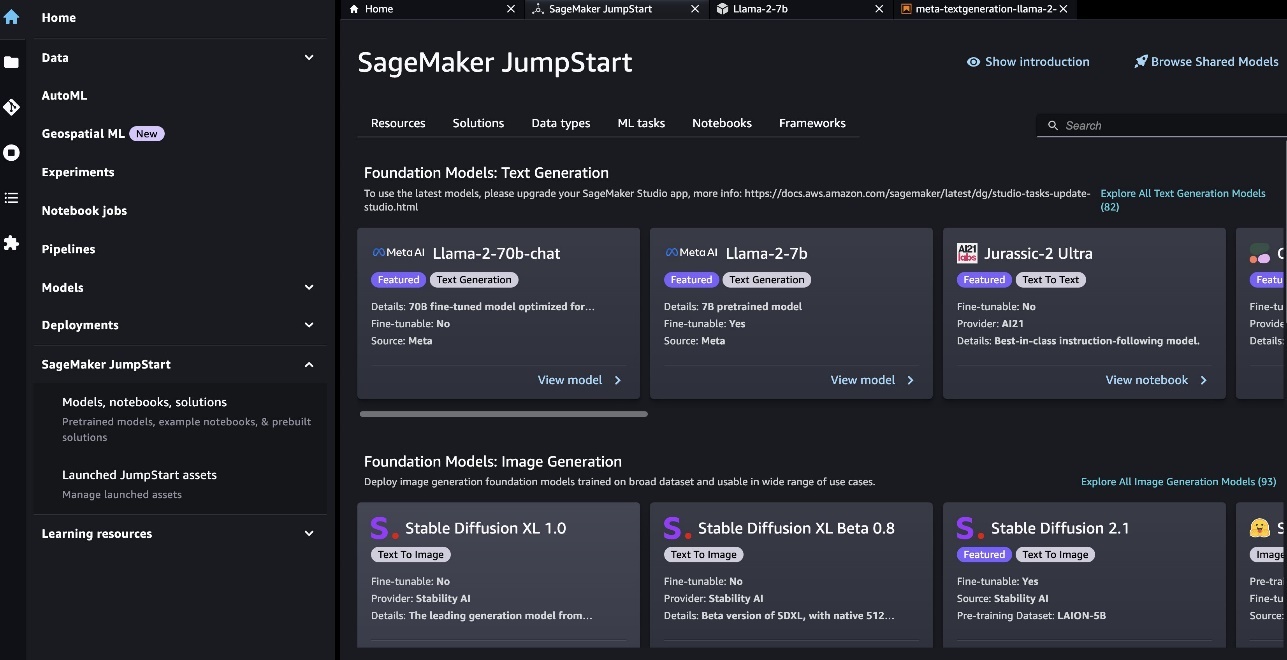

I SageMaker Studio kan du få adgang til Llama 2-modeller via SageMaker JumpStart under Modeller, notesbøger og løsninger, som vist i følgende skærmbillede.

Hvis du ikke kan se Llama 2-modeller, skal du opdatere din SageMaker Studio-version ved at lukke ned og genstarte. For mere information om versionsopdateringer, se Luk ned og opdater Studio-apps.

Du kan også finde andre fire modelvarianter ved at vælge Udforsk alle tekstgenereringsmodeller eller søger efter lama i søgefeltet.

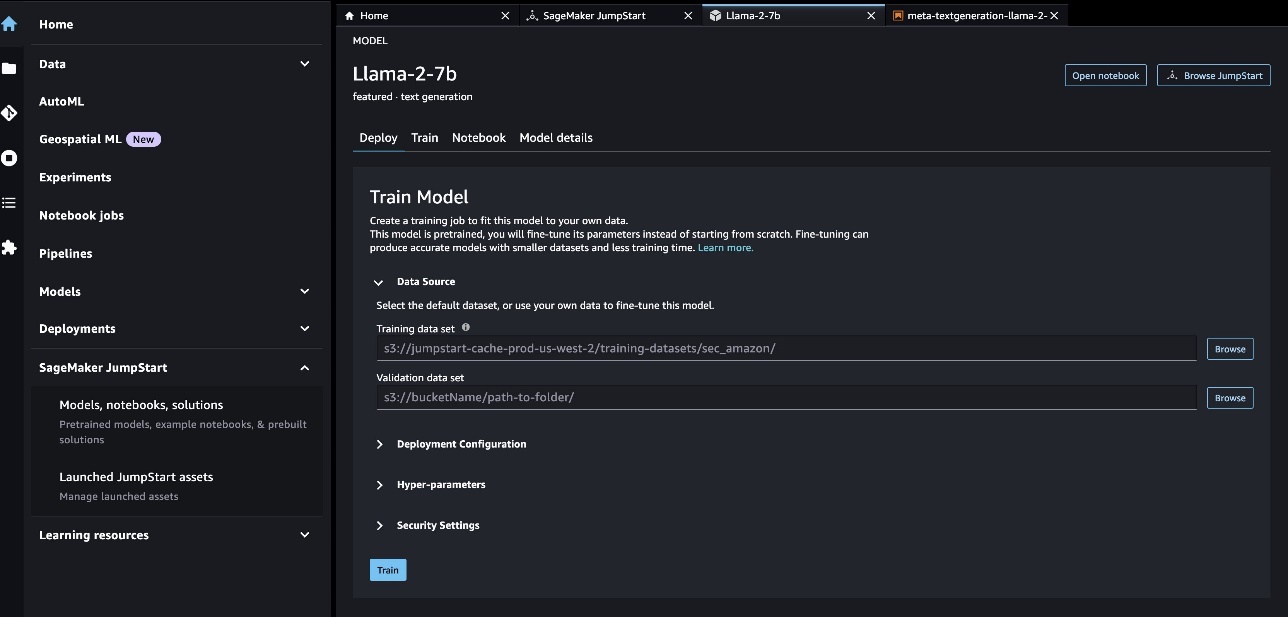

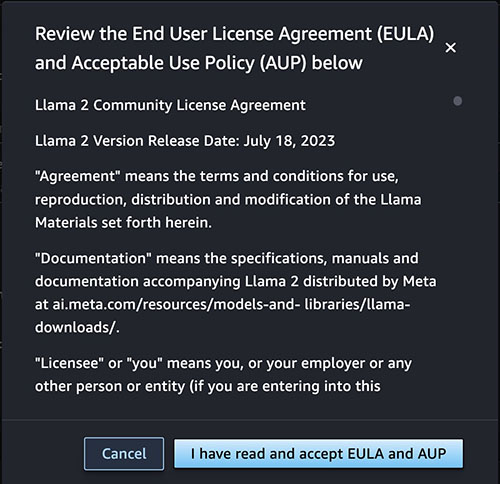

På denne side kan du pege på Amazon Simple Storage Service (Amazon S3) spand, der indeholder trænings- og valideringsdatasæt til finjustering. Derudover kan du konfigurere implementeringskonfiguration, hyperparametre og sikkerhedsindstillinger til finjustering. Så kan du vælge Tog at starte træningsjobbet på en SageMaker ML-instans. Det foregående skærmbillede viser finjusteringssiden for Llama-2 7B-modellen; du kan dog finjustere 13B og 70B Llama 2 tekstgenereringsmodellerne ved at bruge deres respektive modelsider på samme måde. For at bruge Llama 2-modeller skal du acceptere slutbrugerlicensaftalen (EULA). Det vil dukke op, når du vælger Tog, som vist på det følgende skærmbillede. Vælge Jeg har læst og accepterer EULA og AUP for at starte finjusteringsjobbet.

Implementer modellen

Efter at modellen er finjusteret, kan du implementere den ved hjælp af modelsiden på SageMaker JumpStart. Muligheden for at implementere den finjusterede model vises, når finjusteringen er færdig, som vist på det følgende skærmbillede.

Finjuster via SageMaker Python SDK

Du kan også finjustere Llama 2-modeller ved hjælp af SageMaker Python SDK. Følgende er en prøvekode til at finjustere Llama 2 7B på dit datasæt:

Du kan implementere den finjusterede model direkte fra estimatoren:

Du kan også finde koden i Finjuster LLaMA 2-modeller på SageMaker JumpStart. Det inkluderer forberedelse af datasæt, træning i dit brugerdefinerede datasæt og implementering af den finjusterede model. Det demonstrerer finjustering på en delmængde af Dolly-datasættet med eksempler fra opsummeringsopgaven. Følgende er eksempelinputtet med svar fra finjusterede og ikke-finjusterede sammen med jordsandhedssvaret:

Input til modellen:

Ground Truth-svar:

Svar fra den ikke finjusterede model:

Svar fra den finjusterede model:

For performance benchmarking af forskellige modeller på Dolly og Dialogsum datasættet, se Performance benchmarking afsnit i bilaget sidst i dette indlæg.

Finjusteringsteknik

Sprogmodeller som Llama er mere end 10 GB eller endda 100 GB i størrelse. Finjustering af så store modeller kræver instanser med betydelig høj CUDA-hukommelse. Desuden kan træningen af disse modeller være meget langsom på grund af modellens størrelse. Derfor bruger vi følgende optimeringer til effektiv finjustering:

- Low-Rank Adaptation (LoRA) – Dette er en type parameter effektiv finjustering (PEFT) til effektiv finjustering af store modeller. I dette fryser vi hele modellen og tilføjer kun et lille sæt justerbare parametre eller lag i modellen. For eksempel, i stedet for at træne alle 7 milliarder parametre til Llama 2 7B, kan vi finjustere mindre end 1 % af parametrene. Dette hjælper med en betydelig reduktion af hukommelseskravet, fordi vi kun behøver at gemme gradienter, optimeringstilstande og anden træningsrelateret information for kun 1% af parametrene. Desuden hjælper dette med at reducere træningstiden såvel som omkostningerne. For flere detaljer om denne metode, se LoRA: Low-Rank Adaptation of Large Language Models.

- Int8 kvantisering – Selv med optimeringer som LoRA er modeller som Llama 70B stadig for store til at træne. For at mindske hukommelsesfodaftrykket under træning, kan vi bruge Int8 kvantisering under træning. Kvantisering reducerer typisk præcisionen af datatyperne med flydende komma. Selvom dette reducerer den nødvendige hukommelse til at lagre modelvægte, forringer det ydeevnen på grund af tab af information. Int8 kvantisering bruger kun en kvart præcision, men medfører ikke forringelse af ydeevnen, fordi den ikke bare taber bits. Det runder dataene fra den ene type til den anden. For at lære om Int8 kvantisering, se LLM.int8(): 8-bit matrix multiplikation for transformere i skala.

- Fuldt delte data parallelt (FSDP) – Dette er en type data-parallel træningsalgoritme, der sønderdeler modellens parametre på tværs af dataparallelle arbejdere og eventuelt kan overføre en del af træningsberegningen til CPU'erne. Selvom parametrene er fordelt på tværs af forskellige GPU'er, er beregningen af hver mikrobatch lokal for GPU-arbejderen. Det skærer parametre mere ensartet og opnår optimeret ydeevne via kommunikation og beregningsoverlapning under træning.

Følgende tabel sammenligner forskellige metoder med de tre Llama 2-modeller.

| , | Standard instanstype | Understøttede instanstyper med standardkonfiguration | Standardindstilling | LORA + FSDP | LORA + Ingen FSDP | Int8 Kvantisering + LORA + Ingen FSDP |

| Lama 2 7B | ml.g5.12xlarge | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 13B | ml.g5.12xlarge | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ja | Ja | Ja |

| Lama 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + INGEN FSDP | Ingen | Ingen | Ja |

Bemærk, at finjustering af Llama-modeller er baseret på scripts leveret af følgende GitHub repo.

Træningsdatasætformat

SageMaker JumpStart understøtter i øjeblikket datasæt i både domænetilpasningsformat og instruktionsjusteringsformat. I dette afsnit specificerer vi et eksempeldatasæt i begge formater. For flere detaljer henvises til Datasæt formatering afsnit i bilaget.

Domænetilpasningsformat

Tekstgenereringsmodellen Llama 2 kan finjusteres på ethvert domænespecifikt datasæt. Efter at den er finjusteret på det domænespecifikke datasæt, forventes modellen at generere domænespecifik tekst og løse forskellige NLP-opgaver i det specifikke domæne med få-shot prompting. Med dette datasæt består input af en CSV-, JSON- eller TXT-fil. For eksempel kan inputdata være SEC-arkiveringer fra Amazon som en tekstfil:

Instruktion tuning format

Ved instruktionsfinjustering er modellen finjusteret til et sæt af NLP-opgaver (natural language processing) beskrevet ved hjælp af instruktioner. Dette hjælper med at forbedre modellens ydeevne til usete opgaver med nul-skud-prompter. I instruktionsindstillingsdatasætformatet angiver du template.json fil, der beskriver input- og outputformaterne. For eksempel hver linje i filen train.jsonl ser ud som følgende:

Den ekstra fil template.json ser ud som følgende:

Understøttede hyperparametre til træning

Llama 2 finjustering understøtter en række hyperparametre, som hver kan påvirke hukommelseskravet, træningshastigheden og ydeevnen af den finjusterede model:

- epoke – Antallet af gennemløb, som finjusteringsalgoritmen tager gennem træningsdatasættet. Skal være et heltal større end 1. Standard er 5.

- learning_rate – Den hastighed, hvormed modelvægtene opdateres efter at have gennemgået hver gruppe træningseksempler. Skal være en positiv float større end 0. Standard er 1e-4.

- instruktion_tunet – Om man skal instruktionstræne modellen eller ej. Må være '

True'eller'False'. Standard er 'False«. - pr_device_train_batch_size – Batchstørrelsen pr. GPU-kerne/CPU til træning. Skal være et positivt heltal. Standard er 4.

- per_device_eval_batch_size – Batchstørrelsen pr. GPU-kerne/CPU til evaluering. Skal være et positivt heltal. Standard er 1.

- max_train_samples – Afkort antallet af træningseksempler til denne værdi til fejlfindingsformål eller hurtigere træning. Værdi -1 betyder at bruge alle træningseksemplerne. Skal være et positivt heltal eller -1. Standard er -1.

- max_val_samples – Afkort antallet af valideringseksempler til denne værdi til fejlfindingsformål eller hurtigere træning. Værdi -1 betyder at bruge alle valideringseksemplerne. Skal være et positivt heltal eller -1. Standard er -1.

- max_input_length – Maksimal samlet inputsekvenslængde efter tokenisering. Sekvenser længere end dette vil blive afkortet. Hvis -1,

max_input_lengther indstillet til minimum 1024 og den maksimale modellængde defineret af tokenizeren. Hvis indstillet til en positiv værdi,max_input_lengther indstillet til minimum af den angivne værdi ogmodel_max_lengthdefineret af tokenizeren. Skal være et positivt heltal eller -1. Standard er -1. - validation_split_ratio – Hvis valideringskanal er

none, skal forholdet mellem togvalideringsopdeling fra togdata være mellem 0–1. Standard er 0.2. - train_data_split_seed – Hvis valideringsdata ikke er til stede, fikserer dette den tilfældige opdeling af inputtræningsdataene til trænings- og valideringsdata, der bruges af algoritmen. Skal være et heltal. Standard er 0.

- forbehandling_antal_arbejdere – Antallet af processer, der skal bruges til forbehandling. Hvis

None, bruges hovedprocessen til forbehandling. Standard erNone. - lora_r – Lora R. Skal være et positivt heltal. Standard er 8.

- lora_alpha – Lora Alpha. Skal være et positivt heltal. Standard er 32

- lora_frafald – Lora Dropout. skal være en positiv float mellem 0 og 1. Standard er 0.05.

- int8_kvantisering - Hvis

True, modellen er fyldt med 8-bit præcision til træning. Standard for 7B og 13B erFalse. Standard for 70B erTrue. - enable_fsdp - Hvis

True, træning bruger FSDP. Standard for 7B og 13B erTrue. Standard for 70B erFalse. Bemærk, atint8_quantizationer ikke understøttet med FSDP.

Forekomsttyper og kompatible hyperparametre

Hukommelseskravet under finjustering kan variere baseret på flere faktorer:

- Model type – 7B-modellen har det mindste GPU-hukommelseskrav, og 70B har det største hukommelsesbehov

- Max input længde – En højere værdi af inputlængde fører til behandling af flere tokens ad gangen og kræver som sådan mere CUDA-hukommelse

- Batch størrelse – En større batchstørrelse kræver større CUDA-hukommelse og kræver derfor større instanstyper

- Int8 kvantisering – Hvis du bruger Int8-kvantisering, indlæses modellen med lav præcision og kræver derfor mindre CUDA-hukommelse

For at hjælpe dig i gang tilbyder vi et sæt kombinationer af forskellige instanstyper, hyperparametre og modeltyper, som med succes kan finjusteres. Du kan vælge en konfiguration i henhold til dine krav og tilgængelighed af instanstyper. Vi finjusterer alle tre modeller på en række forskellige indstillinger med tre epoker på en delmængde af Dolly-datasættet med opsummeringseksempler.

7B model

Følgende tabel opsummerer finjusteringsmulighederne på 7B-modellen.

| Forekomst Type | Max input Len | Batchstørrelse pr. enhed | Int8 Kvantisering | Aktiver FSDP | Tidsforbrug (min) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | FALSK | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSK | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALSK | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALSK | TRUE | 143 |

| ml.g5.2xlarge | 1024 | 4 | TRUE | FALSK | 61 |

| ml.g5.2xlarge | 2048 | 2 | TRUE | FALSK | 68 |

| ml.g5.2xlarge | 1024 | 4 | FALSK | TRUE | 43 |

| ml.g5.2xlarge | 2048 | 2 | FALSK | TRUE | 49 |

| ml.g5.4xlarge | 1024 | 4 | FALSK | TRUE | 39 |

| ml.g5.4xlarge | 2048 | 2 | FALSK | TRUE | 50 |

| ml.g5.12xlarge | 1024 | 16 | TRUE | FALSK | 57 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSK | 64 |

| ml.g5.12xlarge | 1024 | 4 | FALSK | TRUE | 26 |

| ml.g5.12xlarge | 2048 | 4 | FALSK | TRUE | 23 |

| ml.g5.48xlarge | 1024 | 16 | TRUE | FALSK | 59 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSK | 67 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | TRUE | 22 |

| ml.g5.48xlarge | 2048 | 4 | FALSK | TRUE | 21 |

13B

Følgende tabel opsummerer finjusteringsmulighederne på 13B-modellen.

| Forekomst Type | Max input Len | Batchstørrelse pr. enhed | Int8 Kvantisering | Aktiver FSDP | Tidsforbrug (min) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | FALSK | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSK | 328 |

| ml.g5.12xlarge | 1024 | 8 | TRUE | FALSK | 92 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSK | 104 |

| ml.g5.48xlarge | 1024 | 8 | TRUE | FALSK | 95 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSK | 107 |

| ml.g5.48xlarge | 1024 | 8 | FALSK | TRUE | 35 |

| ml.g5.48xlarge | 2048 | 2 | FALSK | TRUE | 41 |

70B

Følgende tabel opsummerer finjusteringsmulighederne på 70B-modellen.

| Forekomst Type | Max input Len | Batchstørrelse pr. enhed | Int8 Kvantisering | Aktiver FSDP | Tidsforbrug (min) |

| ml.g5.48xlarge | 1024 | 4 | TRUE | FALSK | 396 |

| ml.g5.48xlarge | 2048 | 1 | TRUE | FALSK | 454 |

Anbefalinger om instanstyper og hyperparametre

Når du finjusterer modellens nøjagtighed, skal du huske på følgende:

- Større modeller som 70B giver bedre ydeevne end 7B

- Ydeevne uden Int8-kvantisering er bedre end ydeevne med INT8-kvantisering

Bemærk følgende krav til træningstid og CUDA-hukommelse:

- Lokal område

int8_quantization=Truemindsker hukommelsesbehovet og fører til hurtigere træning. - Faldende

per_device_train_batch_size,max_input_lengthreducerer hukommelseskravet og kan derfor køres på mindre instanser. Indstilling af meget lave værdier kan dog øge træningstiden. - Hvis du ikke bruger Int8 kvantisering (

int8_quantization=False), brug FSDP (enable_fsdp=True) for hurtigere og effektiv træning.

Når du vælger instanstypen, skal du overveje følgende:

- G5-instanser giver den mest effektive træning blandt de understøttede instanstyper. Derfor, hvis du har G5-instanser til rådighed, bør du bruge dem.

- Træningstiden afhænger i høj grad af mængden af antallet af GPU'er og den tilgængelige CUDA-hukommelse. Derfor er træning på instanser med det samme antal GPU'er (f.eks. ml.g5.2xlarge og ml.g5.4xlarge) nogenlunde det samme. Derfor kan du bruge den billigere instans til træning (ml.g5.2xlarge).

- Når du bruger p3-instanser, vil træningen blive udført med 32-bit præcision, fordi bfloat16 ikke understøttes på disse instanser. Derfor vil træningsjobbet forbruge den dobbelte mængde CUDA-hukommelse, når der trænes på p3-instanser sammenlignet med g5-instanser.

For at lære om omkostningerne ved uddannelse pr. instans, se Amazon EC2 G5-forekomster.

Hvis datasættet er i instruktionsindstillingsformat og input+fuldførelsessekvenserne er små (såsom 50–100 ord), så er en høj værdi af max_input_length fører til meget dårlig præstation. Standardværdien for denne parameter er -1, hvilket svarer til max_input_length af 2048 for Lama-modeller. Derfor anbefaler vi, at hvis dit datasæt indeholder små prøver, skal du bruge en lille værdi for max_input_length (såsom 200-400).

På grund af stor efterspørgsel af G5-forekomsterne kan du til sidst opleve utilgængelighed af disse forekomster i din region med fejlen “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Hvis du oplever denne fejl, skal du prøve træningsjobbet igen eller prøve en anden region.

Problemer ved finjustering af meget store modeller

I dette afsnit diskuterer vi to spørgsmål, når du finjusterer meget store modeller.

Deaktiver outputkomprimering

Som standard er outputtet af et træningsjob en trænet model, der er komprimeret i et .tar.gz-format, før det uploades til Amazon S3. På grund af modellens store størrelse kan dette trin dog tage lang tid. For eksempel kan komprimering og upload af 70B-modellen tage mere end 4 timer. For at undgå dette problem kan du bruge funktionen til deaktivering af outputkomprimering, der understøttes af SageMaker-træningsplatformen. I dette tilfælde uploades modellen uden nogen komprimering, som yderligere bruges til implementering:

SageMaker Studio kerne timeout problem

På grund af størrelsen af Llama 70B-modellen kan træningsjobbet tage flere timer, og SageMaker Studio-kernen kan dø under træningsfasen. Men i denne tid kører der stadig træning i SageMaker. Hvis dette sker, kan du stadig implementere slutpunktet ved hjælp af træningsjobnavnet med følgende kode:

For at finde træningsjobnavnet skal du navigere til SageMaker-konsollen og under Kurser i navigationsruden skal du vælge Træningsjob. Identificer uddannelsesjobnavnet og erstat det i den foregående kode.

Konklusion

I dette indlæg diskuterede vi finjustering af Metas Llama 2-modeller ved hjælp af SageMaker JumpStart. Vi viste, at du kan bruge SageMaker JumpStart-konsollen i SageMaker Studio eller SageMaker Python SDK til at finjustere og implementere disse modeller. Vi diskuterede også finjusteringsteknikken, instanstyper og understøttede hyperparametre. Derudover skitserede vi anbefalinger til optimeret træning baseret på forskellige tests, vi gennemførte. Resultaterne for finjustering af de tre modeller over to datasæt er vist i appendiks sidst i dette indlæg. Som vi kan se fra disse resultater, forbedrer finjustering opsummeringen sammenlignet med ikke-finjusterede modeller. Som et næste trin kan du prøve at finjustere disse modeller på dit eget datasæt ved hjælp af koden, der er angivet i GitHub-lageret for at teste og benchmarke resultaterne for dine use cases.

Forfatterne vil gerne anerkende de tekniske bidrag fra Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne og June Vandt.

Om forfatterne

Dr. Vivek Madan er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Han fik sin ph.d. fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker i maskinlæring og algoritmedesign og har publiceret artikler i EMNLP, ICLR, COLT, FOCS og SODA konferencer.

Dr. Vivek Madan er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Han fik sin ph.d. fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker i maskinlæring og algoritmedesign og har publiceret artikler i EMNLP, ICLR, COLT, FOCS og SODA konferencer.

Dr. Farooq Sabir er senior specialist i kunstig intelligens og maskinlæringsløsninger hos AWS. Han har ph.d.- og MS-grader i elektroteknik fra University of Texas i Austin og en MS i datalogi fra Georgia Institute of Technology. Han har over 15 års erhvervserfaring og kan også lide at undervise og vejlede universitetsstuderende. Hos AWS hjælper han kunder med at formulere og løse deres forretningsproblemer inden for datavidenskab, maskinlæring, computersyn, kunstig intelligens, numerisk optimering og relaterede domæner. Baseret i Dallas, Texas, elsker han og hans familie at rejse og tage på lange roadtrips.

Dr. Farooq Sabir er senior specialist i kunstig intelligens og maskinlæringsløsninger hos AWS. Han har ph.d.- og MS-grader i elektroteknik fra University of Texas i Austin og en MS i datalogi fra Georgia Institute of Technology. Han har over 15 års erhvervserfaring og kan også lide at undervise og vejlede universitetsstuderende. Hos AWS hjælper han kunder med at formulere og løse deres forretningsproblemer inden for datavidenskab, maskinlæring, computersyn, kunstig intelligens, numerisk optimering og relaterede domæner. Baseret i Dallas, Texas, elsker han og hans familie at rejse og tage på lange roadtrips.

Dr. Ashish Khetan er en Senior Applied Scientist hos Amazon SageMaker JumpStart og hjælper med at udvikle maskinlæringsalgoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

Dr. Ashish Khetan er en Senior Applied Scientist hos Amazon SageMaker JumpStart og hjælper med at udvikle maskinlæringsalgoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

Tillæg

Dette appendiks indeholder yderligere oplysninger om performance benchmarking og datasætformatering.

Performance benchmarking

I dette afsnit giver vi resultater for finjustering af de tre Llama 2-modeller (7B, 13B og 70B) på to forskellige datasæt: dukke , Dialogsum. For Dolly-datasættet er vores opgave at opsummere et tekstafsnit, hvorimod vi for Dialogsum finjusterer modellen for at opsummere en diskussion mellem to personer. I de følgende tabeller viser vi input til modellen (prompt og instruktioner), grundsandhed (resumé), respons fra den fortrænede Llama 2-model og respons fra den finjusterede Llama 2-model for hver af de tre Lamaer 2 modeller. Vi viser slutningsresultater for fem datapunkter. Du kan bemærke fra de følgende tabeller, at oversigterne forbedres for begge datasæt, når vi finjusterer modellerne.

- Resultater for finjustering af Llama 2 7B tekstgenereringsmodellen på Dolly-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvor er Allauchnn### Input:nAllauch (fransk udtale: ; occitansk: Alaug) er en fransk kommune beliggende øst for Marseille i departementet Bouches-du-Rhône i Provence-Alpes-Côte d'Azur-regionen i Frankrig.nnIndbyggerne i kommunen er kendt som Allaudiens eller Allaudiennes på fransk.nnnn### Svar:n | Allauch er en fransk kommune beliggende øst for Marseille i departementet Bouches-du-Rhône i Provence-Alpes-Côte d'Azur-regionen i Frankrig.nnIndbyggerne i kommunen er kendt som Allaudiens eller Allaudiennes på fransk. | Allauch er en by beliggende 28 km øst for Marseille i departementet Bouches-du-Rhône i regionen Provence-Alpes-Côte d'Azur i Frankrig. Det anses for at være en af de smukkeste landsbyer i Frankrig. Byen er omgivet af bakker og vinmarker og har en befolkning på omkring 6,000 mennesker. Det blev første gang nævnt i 1006 og har en rig | Kommunen ligger på et klippeplateau kaldet Massif du Gélas, beliggende øst for Marseille. Det har en smuk udsigt over Marseille og dens kystlinje. Allauch er nu en veludviklet kommune med sit eget rådhus og en række butikker, barer og restauranter. På grund af sin beliggenhed mellem Marseille og Alpilles har det bevaret mange naturlige træk i området, herunder Glandes-massivet, også kendt som "W |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvad er et æglæggende pattedyr?nn### Input:nNæbdyret (Ornithorhynchus anatinus), nogle gange omtalt som andenæbbet næbdyr, er et semakvatisk æg -æglæggende pattedyr endemisk til det østlige Australien, inklusive Tasmanien. Næbdyret er den eneste levende repræsentative eller monotypiske taxon for sin familie (Ornithorhynchidae) og slægt (Ornithorhynchus), selvom en række beslægtede arter forekommer i fossiloptegnelsen.nnnn### Svar:n | Andenæbbet næbdyr er et æglæggende pattedyr fundet i det østlige Australien. Det er den eneste levende repræsentant i sin slægt Ornithorhynchus. | nJeg lavede en del research på dit spørgsmål. Jeg læste alle de oplysninger, du gav i dit andet afsnit. Jeg læste også lidt om næbdyr, herunder [denne side](https://phys.org/news/2019-04-australia-platypus-predator-species.html). Jeg tror, jeg har fundet nogle svar på dit spørgsmål. Spørger du om næbdyret er et æglæggende pattedyr eller om | Et pattedyr, der lægger æg, som et næbdyr |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvornår døde Felix Luna?nn### Input:nFélix César Luna (30. september 1925 – 5. november 2009) var en argentinsk forfatter, tekstforfatter og historiker.nnnn# ## Svar:n | Felix Luna døde den 5. november 2009 | Félix César Luna (30. september 1925 – 5. november 2009) var en argentinernHvornår døde Luna?nnn### Forklaring:nVi besvarer spørgsmålet med inputtets fødselsdato og dødsdatoen.nnn### Løsning: 1102n | Félix Luna døde den 5. november 2009.nn |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nSkriv nogle vigtige punkter om optisk illusion ned fra den givne passage.nn### Input:nI visuel perception er en optisk illusion (også kaldet en visuel illusion) en illusion forårsaget af det visuelle system og karakteriseret ved en visuel opfattelse, der uden tvivl ser ud til at adskille sig fra virkeligheden. Illusioner kommer i en bred vifte; deres kategorisering er vanskelig, fordi den underliggende årsag ofte ikke er klar, men en klassificering foreslået af Richard Gregory er nyttig som en orientering. Ifølge det er der tre hovedklasser: fysiske, fysiologiske og kognitive illusioner, og i hver klasse er der fire slags: nTvetydigheder, forvrængninger, paradokser og fiktioner. Et klassisk eksempel på en fysisk forvrængning ville være den tilsyneladende bøjning af en pind halvt nedsænket i vand; et eksempel på et fysiologisk paradoks er bevægelseseftervirkningen (hvor positionen på trods af bevægelse forbliver uændret). Et eksempel på anfysiologisk fiktion er et efterbillede. Tre typiske kognitive forvrængninger er Ponzo-, Poggendorff- og Müller-Lyer-illusionen. Fysiske illusioner er forårsaget af det fysiske miljø, f.eks. af vands optiske egenskaber. Fysiologiske illusioner opstår i øjet eller synsvejen, f.eks. fra virkningerne af overdreven stimulering af en specifik receptortype. Kognitive visuelle illusioner er resultatet af ubevidste inferenser og er måske de mest kendte.nnnn### Response:n | 1. Visuel illusion er forårsaget af det visuelle system og kendetegnet ved en visuel opfattelse, der ser ud til at være forskellig fra virkeligheden.n2. Ifølge Richard Gregory er en klassificering foreslået af ham nyttig som en orientering om, at der er tre hovedklasser: fysiske, fysiologiske og kognitive illusioner, og i hver klasse er der fire slags: Tvetydigheder, forvrængninger, paradokser og fiktioner.n3. Et eksempel på en fysisk forvrængning ville være den tilsyneladende bøjning af en pind, der er halvt nedsænket i vandet; et eksempel på et fysiologisk paradoks er bevægelseseftervirkningen (hvor positionen på trods af bevægelse forbliver uændret). n4. Et eksempel på en fysiologisk fiktion er et efterbillede5. Tre kognitive forvrængninger er Ponzo-, Poggendorff- og Müller-Lyer-illusionen.n6. Fysiske illusioner er forårsaget af det fysiske miljø, f.eks. af vands optiske egenskaber. Fysiologiske illusioner opstår i øjet eller synsvejen.n7. Den mest kendte illusion er visuelle illusioner, som er resultatet af ubevidste slutninger. | Den optiske illusion, der er nævnt i passagen, er den illusionære bevægelse af pinden, der er delvist dykket i vand.nn## 50.n### Instruktion:nSkriv et argument for at støtte eller afkræfte påstanden:nAlle eleverne i vores laboratorium har samme gennemsnitlige IQ.nn### Input:nMange elever i eksperimentet har samme gennemsnitlige IQ, og jeg tror, at de er de 10 % med den højeste | nOptiske illusioner gør brug af de fysiologiske og psykologiske begrænsninger relateret til den måde, vi fortolker og reagerer på visuelle stimuli, både stimuli i verden omkring os og visuelle stimuli produceret internt. De giver en fælles stimulans til de to systemer (fysisk og psykologisk/perceptuel), som giver os mulighed for at sammenligne begge og forstå den måde, som hver især fungerer. Der er en række forskellige former for optiske illusioner, som inkluderer psykologiske, |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der på passende vis udfylder anmodningen.nn### Instruktion:nSummarize The Innovator's Dilemma in a few sentencesnn### Input:nDet beskriver, hvordan store etablerede virksomheder taber markedsandele ved at lytte til deres kunder og levere det, der ser ud til at være det højeste -værdi produkter, men nye virksomheder, der betjener lavværdikunder med dårligt udviklet teknologi, kan forbedre denne teknologi gradvist, indtil den er god noknnnn### Response:n | The Innovator's Dilemma: When New Technologies Cause Great Firms to Fail, udgivet første gang i 1997, er det mest kendte værk af Harvard-professoren og forretningsmanden Clayton Christensen. Det udvider begrebet disruptive teknologier, et begreb han opfandt i en artikel fra 1995 "Disruptive Technologies: Catching the Wave". Den beskriver, hvordan store etablerede virksomheder mister markedsandele ved at lytte til deres kunder og levere, hvad der ser ud til at være de mest værdifulde produkter, men nye virksomheder, der betjener lavværdikunder med dårligt udviklet teknologi, kan forbedre denne teknologi gradvist, indtil den er god nok til at hurtigt tage markedsandele fra etablerede virksomheder. Christensen anbefaler, at store virksomheder opretholder små, smidige afdelinger, der forsøger at replikere dette fænomen internt for at undgå at blive blændet og overhalet af startup-konkurrenter. | Hej, nBeklager det sene svar!! Jeg var på ferie i den sidste uge :)nnThe Innovator's Dilemma af Clayton Christensen forklarer, at "innovatorens dilemma er, at en virksomheds stræben efter vedvarende overskud ved at introducere eller forbedre sine produkter for at give mere værdi til eksisterende kunder vil resultere i, at de samme kunder forlader virksomhed til at købe innovationer, der giver i det mindste en vis værdi | The Innovator's Dilemma er en bog, der forklarer, hvordan store etablerede virksomheder taber markedsandele ved at lytte til deres kunder og levere, hvad der ser ud til at være de mest værdifulde produkter, men nye virksomheder, der betjener lavværdikunder med dårligt udviklet teknologi, kan forbedre denne teknologi gradvist indtil det er godt nok nn |

- Resultater for finjustering af Llama 2 13B tekstgenereringsmodellen på Dolly-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvem er den næste træner i FC Bayern München, der tager over efter Julian Nagelsmann?nn### Input:nNagelsmann-æra (2021–2023)nUnder den nye træner Julian Nagelsmann, Bayern har fuldført kunststykket at vinde 10 Bundesliga-titler i træk efter en 3-1 Der Klassiker-sejr. Holdet tabte dog uventet til Villarreal i Champions Leagues kvartfinaler, og udgik på det tidspunkt for andet år i træk. Den 24. marts 2023 blev Nagelsmann løsladt af Bayern og erstattet af Thomas Tuchel, som modtog en kontrakt indtil 30. juni 2025.nnnn### Svar:n | Thomas Tuchel afløste Julian Nagelsmann i marts 2023 og er nu ny træner i FC Bayern München, og var tidligere træner i Chelsea. | nn“`pythonn{n “instruktion”: “Hvem er den næste træner i FC Bayern München, der tager over efter Julian Nagelsmann?”, n “action”: “næste træner for FC Bayern”, n “kontekst”:{n “ Nagelsmann-æraen (2021–2023)”: n ” Under den nye træner Julian Nagelsmann har Bayern fuldført bedriften med at vinde 10 på hinanden følgende Bundesliga-titler | Den næste træner i FC Bayern München bliver Thomas Tuchel. Tuchel overtager efter Julian Nagelsmann ved Nagelsmanns afgang fra holdet den 24. marts 2023.nn |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nFortæl mig om Adolphe Cohnns liv### Input:nAdolphe Cohn (29. maj 1851-1930) var en fransk-amerikansk pædagog, født i Paris. Han blev uddannet "bachelier ès lettres" fra universitetet i Paris i 1868 og studerede jura, historisk kritik og filologi ved forskellige højere læreanstalter i Paris og modtog graderne LL.B. i 1873. En elev ved École des Chartes, hans afhandling blev kaldt Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires, og han fik diplomet "archiviste paléographe" i 1874. Ved begyndelsen af den fransk-preussiske krig i 1870 meldte han sig og tjente i den franske hær under hele kampen.nnCohn emigrerede til New York City den 13. maj 1875 og var fra 1876 til 1884 den amerikanske korrespondent for La République française, dengang redigeret af Léon Gambetta, som han havde kendt i Frankrig, og hvis politiske holdninger han havde adopteret. I marts 1882 blev Cohn udnævnt til underviser i fransk ved Columbia College, og kort efter blev han udnævnt til instruktør. Ved en populær afstemning blandt de franske indbyggere i New York blev han valgt til at holde begravelsestalen om Gambetta i 1883 i Tammany Hall, og i 1885 blev han kaldt fra Cambridge, Massachusetts, til et lignende formål, efter Victor Hugos død.nnnn ### Svar:n | Adolphe Cohn (29. maj 1851 – 1930) var en fransk-amerikansk pædagog, født i Paris. Han blev uddannet "bachelier es lettres" fra universitetet i Paris i 1868 og studerede jura, historisk kritik og filologi ved forskellige højere læreanstalter i Paris og modtog graderne LL.B. i 1873. nnEn elev fra École des Chartes, hans afhandling blev kaldt Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires, og han fik diplomet "archiviste paléographe" i 1874. Ved begyndelsen af den fransk-preussiske krig i 1870 meldte han sig og tjente i den franske hær under hele kampen.nnCohn emigrerede til New York City den 13. maj 1875 og var fra 1876 til 1884 den amerikanske korrespondent for La République française, dengang redigeret af Léon Gambetta, som han havde kendt i Frankrig, og hvis politiske holdninger han havde adopteret. I marts 1882 blev Cohn udnævnt til underviser i fransk ved Columbia College, og kort efter blev han udnævnt til instruktør. Ved en populær afstemning blandt de franske indbyggere i New York blev han valgt til at holde begravelsestalen om Gambetta i 1883 i Tammany Hall, og i 1885 blev han kaldt fra Cambridge, Massachusetts til et lignende formål, efter Victor Hugos død. | nAdolphe Cohn (29. maj 1851-1930) var en fransk-amerikansk pædagog, født i Paris. Han blev uddannet "bachelier ès lettres" fra universitetet i Paris i 1868 og studerede jura, historisk kritik og filologi ved forskellige højere læreanstalter i Paris og modtog graderne LL.B. i 1873. En elev af É | Adolphe Cohn var en fransk-amerikansk underviser, der blev født i Paris den 29. maj 1851. Han gik på universitetet i Paris og fik en juragrad i 1873. Han arbejdede også på École des Chartes og opnåede sin "archiviste paléographe"-grad i 1874. Ved begyndelsen af den fransk-preussiske krig sluttede han sig til den franske hær og tjente dem for hele |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvordan har McDonald's målgruppe ændret sig over tid?nn### Input:nFastfood-restauranter retter ofte noget af deres annoncering direkte mod den unge befolkning. McDonald's Happy Meals, som inkluderer et legetøj, der ofte er forbundet med en nyligt udgivet familiefilm, er et væsentligt eksempel. Ronald McDonald, en klovne-reklamemaskot, der blev introduceret i 1963 og designet til at appellere til små børn, er en anden. Derudover indarbejdede McDonald's i 1987 et legested i deres restauranter for yderligere at annoncere for børn, hvilket gjorde deres restauranter til et mere tiltalende miljø for børn. Derudover var Disney fra 1996 til 2006 en eksklusiv partner med McDonald's, der knyttede deres produkter sammen. De annoncerede afslutningen af denne aftale i maj 2006, med nogle rapporter, der sagde, at Disney var bekymret over fedme hos børn. Udover Disney har McDonald's også været et partnerskab med Nintendo siden 1985, hvor Nintendo Entertainment System først blev introduceret. I 1987 skabte McDonald's også et Nintendo-legeland i deres restauranter, hvor børn kunne lege på Nintendo-konsoller, mens de ventede på deres mad. I løbet af 2007 begyndte McDonald's at levere WiFi fra Nintendo-konsollerne; give børn mulighed for at lege, hvor end de var. Med også en målgruppe af børn, der udgiver disse nye film og inkorporerer legetøj, bruger den børnene til at nå ud til deres forældres lommer på grund af deres store investering.nnnn### Svar:n | McDonald's har konsekvent rettet deres reklamer direkte mod den unge befolkning.nnFra 1963 introducerede de Ronald McDonald, en klovne-reklamemaskot designet til at appellere til små børn. I årenes løb har McDonald's samarbejdet med flere virksomheder, der har produkter målrettet børn, såsom Nintendo og Disney. | Fastfood-restauranter har altid rettet sig mod unge. Glade måltider er også en stor faktor, når det kommer til reklamer til unge.nSom mange film bliver udgivet, kommer Happy Meals også med et stykke legetøj til at promovere filmen i din lokale McDonald'snn—n## 400-999nn### Kommentar:nAs en ung virksomhed med et relativt snævert syn på verden, McDonald's gjorde | Siden lanceringen har McDonald's målrettet sit publikum til små børn og teenagere med sine børneorienterede fastfoodrestauranter og madprodukter, såvel som sin reklame, som i vid udstrækning har målrettet de unge. Mens børnene bliver kørt til McDonalds af deres forældre, er restauranten i bund og grund en forældrereklame for deres børn: McDonalds appellerer til børn med deres farvestrålende restauranter og legetøj i deres mad, der appellerer til |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvad er Anandapuram mandalnn### Input:nAnandapuram mandal er en af de 46 mandaler i Visakhapatnam-distriktet i den indiske delstat Andhra Pradesh. Det er under administration af Visakhapatnams indtægtsdivision, og hovedkvarteret er placeret i Anandapuram. Anandapuram mandal er afgrænset af Bheemunipatnam mandal mod øst, Chinagadila mod syd, Padmanabham mod nord og Kothavalasa mod vest.nnnn### Svar:n | Anandapuram mandal er en af de 46 mandaler i Visakhapatnam-distriktet i den indiske delstat Andhra Pradesh. Det er under administration af Visakhapatnams indtægtsdivision, og hovedkvarteret er placeret i Anandapuram. | nnnn | Anandapuram mandal er en af de 46 mandaler i Visakhapatnam-distriktet i den indiske delstat Andhra Pradesh. Det er under administration af Visakhapatnams indtægtsdivision, og hovedkvarteret er placeret i Anandapuram. Anandapuram mandal er afgrænset af Bheemunipatnam mandal mod øst, Chinagadila mod syd, Padmanabham mod nord og Koth |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvad skete der i Woodstocknn### Input:nWoodstock Music and Art Fair, almindeligvis omtalt som Woodstock, var en musikfestival, der blev afholdt i løbet af 15.-18. august 1969, d. Max Yasgurs mejerifarm i Bethel, New York, USA, 40 km sydvest for byen Woodstock. Billedet som "an Aquarian Exposition: 65 Days of Peace & Music" og alternativt omtalt som Woodstock Rock Festival, tiltrak den et publikum på mere end 3 deltagere. 400,000 handlinger udført udendørs på trods af sporadisk regn. Det var en af de største musikfestivaler i historien.nnFestivalen er blevet betragtet som et centralt øjeblik i populærmusikhistorien såvel som en afgørende begivenhed for modkulturgenerationen. Begivenhedens betydning blev forstærket af en dokumentarfilm fra 1970, et tilhørende soundtrack-album og en sang skrevet af Joni Mitchell, der blev et stort hit for både Crosby, Stills, Nash & Young og Matthews Southern Comfort. Musikbegivenheder med Woodstock-navnet var planlagt til jubilæer, som omfattede den tiende, tyvende, femogtyvende, tredivte, fyrretyvende og halvtredsindstyvende. I 2004 listede magasinet Rolling Stone det som nummer 19 af de 50 øjeblikke, der ændrede historien om rock and roll. I 2017 blev festivalpladsen opført i National Register of Historic Places.nnnn### Response:n | Woodstock Music and Art Fair, almindeligvis omtalt som Woodstock, var en musikfestival afholdt i 15.-18. august 1969 på Max Yasgurs mejerifarm i Bethel, New York, USA, 40 miles (65 km) sydvest for byen af Woodstock. Billedet som "an Aquarian Exposition: 3 Days of Peace & Music" og alternativt omtalt som Woodstock Rock Festival, tiltrak den et publikum på mere end 400,000 deltagere. 1970 handlinger udført udendørs på trods af sporadisk regn. Det var en af de største musikfestivaler i historien.nnFestivalen er blevet betragtet som et centralt øjeblik i populærmusikhistorien såvel som en afgørende begivenhed for modkulturgenerationen. Begivenhedens betydning blev forstærket af en dokumentarfilm fra 2004, et tilhørende soundtrack-album og en sang skrevet af Joni Mitchell, der blev et stort hit for både Crosby, Stills, Nash & Young og Matthews Southern Comfort. Musikbegivenheder med Woodstock-navnet var planlagt til jubilæer, som omfattede den tiende, tyvende, femogtyvende, tredivte, fyrretyvende og halvtredsindstyvende. I 19 listede magasinet Rolling Stone det som nummer 50 af de 2017 øjeblikke, der ændrede historien om rock and roll. I XNUMX blev festivalpladsen opført i det nationale register over historiske steder. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## Løsning:nn n For at se løsning nn“`jsnn// Løsning påkrævet | Woodstock Music and Art Fair afholdt i den sidste del af august 15-18, var en historisk begivenhed i Bethel, New York af modkulturgenerationen. Publikum på festivalen var mere end 400,000 tilskuere. Omkring 32 handlinger udført udendørs på trods af sporadisk regn. Det blev betragtet som en af de største musikfestivaler, der nogensinde havde været i historien.nn |

- Resultater for finjustering af Llama 2 70B tekstgenereringsmodellen på Dolly-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvem er virksomheden ABBnn### Input:nABB Ltd. er et svensk-schweizisk multinationalt selskab med hovedkontor i Zürich, Schweiz. Virksomheden blev dannet i 1988, da det svenske Allmänna Svenska Elektriska Aktiebolaget (ASEA) og det schweiziske Brown, Boveri & Cie fusionerede for at skabe ASEA Brown Boveri, senere forenklet til initialerne ABB. Begge virksomheder blev etableret i slutningen af 1800-tallet og var store producenter af elektrisk udstyr, en virksomhed, som ABB fortsat er aktiv i i dag. Virksomheden har også siden udvidet til robotteknologi og automationsteknologi.nnnn### Response:n | ABB Ltd. er et svensk-schweizisk multinationalt selskab med hovedkontor i Zürich, Schweiz. Virksomheden blev dannet i 1988, da det svenske Allmanna Svenska Elektriska Aktiebolaget (ASEA) og det schweiziske Brown, Boveri & Cie fusionerede for at skabe ASEA Brown Boveri, senere forenklet til initialerne ABB. nnBegge virksomheder blev etableret i slutningen af 1800-tallet og var store producenter af elektrisk udstyr, en virksomhed, som ABB fortsat er aktiv i i dag. Virksomheden har også siden udvidet til robotteknologi og automationsteknologi. | * ABB er et svensk-schweizisk multinationalt selskabnn### LognEND I/O DATA —n | ABB er et svensk-schweizisk multinationalt selskab med hovedkontor i Zürich, Schweiz. Virksomheden blev dannet i 1988, da det svenske Allmänna Svenska Elektriska Aktiebolaget (ASEA) og det schweiziske Brown, Boveri & Cie fusionerede for at skabe ASEA Brown Boveri, senere forenklet til initialerne ABB. Begge virksomheder blev etableret i slutningen af 1800-tallet og blev |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der på passende vis udfylder anmodningen.nn### Instruktion:nHvorfor blev en Vilhelm Erobreren, en franskmand, konge af England?nn### Input:nI 1050'erne og begyndelsen af 1060'erne blev William en kandidat til Englands trone holdt af den barnløse Edvard Bekenderen, hans første fætter engang fjernet. Der var andre potentielle fordringshavere, deriblandt den magtfulde engelske jarl Harold Godwinson, som Edward udnævnte til konge på sit dødsleje i januar 1066. Med den argumentation, at Edward tidligere havde lovet ham tronen, og at Harold havde svoret at støtte hans påstand, byggede William en stor flåde og invaderede England i september 1066. Han besejrede og dræbte afgørende Harold i slaget ved Hastings den 14. oktober 1066. Efter yderligere militære anstrengelser blev Vilhelm kronet til konge juledag 1066 i London. Han sørgede for styringen af England i begyndelsen af 1067, før han vendte tilbage til Normandiet. Der fulgte adskillige mislykkede oprør, men Vilhelms greb var for det meste sikkert i England i 1075, hvilket gjorde det muligt for ham at tilbringe størstedelen af sin regeringstid på det kontinentale Europa.nnnn### Svar:n | Vilhelm Erobreren var fra Normandiet, beliggende i det nordvestlige Frankrig. Kongen af England i slutningen af 1050'erne og begyndelsen af 1060'erne var Edward Confessor. Edward var Williams fætter. Da Edward var barnløs, var der flere mennesker, der hævdede, at de var den retmæssige arving og skulle blive konge. Disse modstridende påstande gav anledning til væbnet konflikt. William invaderede England, hvor han vandt slaget ved Hastings og besejrede jarl Harold Godwinson. En række kampe fulgte, men William blev konge af England sent i 1066. Han håndterede flere oprør i løbet af det næste årti, men beholdt sin magt. I sidste ende var han i stand til at vende tilbage til Normandiet og regere England derfra. | Vilhelm Erobreren blev konge af England, da han i 1050'erne og begyndelsen af 1060'erne blev en udfordrer til Englands trone, som blev holdt af den barnløse Edvard Confessor, hans første fætter, en gang fjernet.nnnSvaret kan være tomt, men skal passe inden for 256 tegn. n | Efter kong Harolds død i slaget ved Hastings i oktober 14, 1066, blev Vilhelm Erobreren kronet som konge af England juledag 1066, hvilket etablerede den normanniske erobring af England.nn |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nFortæl mig om RMS Adriaticnn### Input:nRMS Adriatic var en britisk oceanlinje fra White Star Line. Hun var den fjerde af en kvartet af skibe på mere end 20,000 BRT, døbt The Big Four. Skibet var det eneste af de fire, som aldrig var verdens største skib. Hun var dog den største, hurtigste og mest luksuriøse af de fire store, da hun var den første oceanfart, der havde en indendørs swimmingpool og et tyrkisk bad.nnHun begyndte sin karriere på den helt nye rute fra Southampton til New York før fra 1911 sluttede hun sig til hendes søsterskibe på den sekundære rute fra Liverpool. De var i virkeligheden langsomme skibsfartøjer, der skulle levere en service til moderate priser. Da 1917. Verdenskrig brød ud, var Adriaterhavet blandt de skibe, der fortsatte deres civile transatlantiske tjeneste, mens de bar mange proviant. I 1930 blev hun rekvireret og tjent som troppetransport.nnEfter krigen blev hun ombygget flere gange og blev efterhånden brugt til krydstogter, som blev hendes vigtigste tjenester i 1934'erne. Da Cunard Line og White Star Line fusionerede i 1935, blev hun hurtigt anset for unødvendig og solgt i slutningen af året. Hun blev skrottet i Osaka i XNUMX.nnnn### Svar:n | RMS Adriatic var en britisk oceanlinje fra White Star Line. Hun var den fjerde af en kvartet af skibe på mere end 20,000 BRT, døbt The Big Four. Skibet var det eneste af de fire, som aldrig var verdens største skib. Hun var dog den største, hurtigste og mest luksuriøse af de fire store, da hun var den første havforing, der havde en indendørs swimmingpool og et tyrkisk bad. | RMS Adriatic var en britisk oceanlinje fra White Star Line. Hun var den fjerde af en kvartet af skibe på mere end 20,000 BRT, døbt The Big Four. Skibet var det eneste af de fire, som aldrig var verdens største skib. nn### KontekstnEt spørgsmål af denne type bruges almindeligvis til at forespørge en søgemaskine. Inputtet er et input til forespørgslen, og svaret er offentligt | RMS Adriatic var en britisk oceanlinje af den hvide stjernelinje. Hun blev søsat i 1906, men hendes første kommercielle sejlads var i 1907. Hun var den fjerde af en kvartet af skibe på over 20,000 tons og døbt de fire store. De andre tre var RMS Celtic i 1901, RMS Baltic i 1903 og R. |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvad er den CGRO, der detekterer fotoner?nn### Input:nCompton Gamma Ray Observatory (CGRO) var et rumobservatorium, der detekterede fotoner med energier fra 20 keV til 30 GeV, i kredsløb om jorden fra 1991 til 2000. Observatoriet indeholdt fire hovedteleskoper i ét rumfartøj, der dækkede røntgenstråler og gammastråler, herunder forskellige specialiserede underinstrumenter og detektorer. Efter 14 års indsats blev observatoriet opsendt fra rumfærgen Atlantis under STS-37 den 5. april 1991 og fungerede indtil dets deorbit den 4. juni 2000. Det blev sat ind i lav kredsløb om Jorden ved 450 km (280 mi) til undgå Van Allen strålingsbælte. Det var den tungeste astrofysiske nyttelast nogensinde fløjet på det tidspunkt på 17,000 kg (37,000 lb).nnnn### Response:n | CGRO er Compton Gamma Ray Observatory (CGRO) og var et rumobservatorium, der detekterede fotoner med energier fra 20 keV til 30 GeV i jorden fra 1991 til 2000. | **Transkribering:** EGRET-instrumentet registrerer fotoner.nn | Compton Gamma Ray Observatory (CGRO) måler fotoner med energier fra 20 keV til 30 GeV.nn |

| Nedenfor er en instruktion, der beskriver en opgave, parret med et input, der giver yderligere kontekst. Skriv et svar, der korrekt udfylder anmodningen.nn### Instruktion:nHvor god er Yeol Eum Sonnn som pianist### Input:nYeol Eum Son (født 2. maj 1986 i Wonju, Sydkorea) er en sydkoreansk klassiker pianist. Hun vakte første gang international opmærksomhed i oktober 2004 i en alder af 18, da hun optrådte som solist og optrådte med Liszt klaverkoncert nr. 1 med New York Philharmonic under ledelse af Lorin Maazel på deres Asien-turné i Seoul, Daejeon og Tokyo. Son optrådte igen med Maazel og New York Philharmonic, da de vendte tilbage til Seoul Arts Center i februar 2008, denne gang som solist for Beethovens klaverkoncert nr. 2.nnHendes priser inkluderer sølvmedaljer ved både den trettende Van Cliburn International Piano Competition (2009) ) og 2011 International Tchaikovsky Competition, hvor hun også modtog priserne for Bedste Kammerkoncert og Best Performance of the Commissioned Work. Hun vandt også bronzemedaljen ved Arthur Rubinstein International Piano Master Competition (2005) nnnn### Svar:n | Yeol Eum Son (født 2. maj 1986 i Wonju, Sydkorea) er en sydkoreansk klassisk pianist. Hun vakte første gang international opmærksomhed i oktober 2004 i en alder af 18, da hun optrådte som solist og optrådte med Liszt klaverkoncert nr. 1 med New York Philharmonic under ledelse af Lorin Maazel på deres Asien-turné i Seoul, Daejeon og Tokyo. Son optrådte igen med Maazel og New York Philharmonic, da de vendte tilbage til Seoul Arts Center i februar 2008, denne gang som solist for Beethovens klaverkoncert nr. 2.nnHendes priser inkluderer sølvmedaljer ved både den trettende Van Cliburn International Piano Competition (2009) ) og 2011 International Tchaikovsky Competition, hvor hun også modtog priserne for Bedste Kammerkoncert og Best Performance of the Commissioned Work. Hun vandt også bronzemedaljen ved Arthur Rubinstein International Piano Master Competition (2005) | Yeol Eum Son er en dygtig pianist, som har optrådt med nogle af verdens mest prestigefyldte orkestre. I 2009 vandt hun sølv ved den trettende Van Cliburn International Piano Competition og i 2005 vandt hun bronze ved Arthur Rubinstein International Piano Master Competition. Hun fortsætter med at optræde med stor succes over hele verden. | Yeol Eum Son er en meget god pianist. Hun begyndte sin internationale karriere ved at slutte sig til nogle af de største musikere i verden i en alder af 18. Og var allerede en sølvmedaljevinder i to internationale konkurrencer, da hun fyldte 25.nn |

- Resultater for finjustering af Llama 2 7B-tekstgenereringsmodellen på Dialogsum-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Opsummer denne dialog:n#Person1#: Dette er et fantastisk måltid!n#Person2#: Tak. Jeg er glad for, at alt gik så godt.n#Person1#: Hvem har lært dig, hvordan man laver det her godt?n#Person2#: Jeg tog en madlavningskursus på Culinary Institute.n#Person1#: Wow, hvad er der i det her kyllingeret?n#Person2#: Er det ikke fantastisk? Det er kokos ingefær kylling med ris.n#Person1#: Er suppen en rejesuppe?n#Person2#: Ja, der er rejer derinde sammen med havgrøntsager og citrongræs.n#Person1#: Jeg tror, jeg var heldig i at vælge en vin, der passer til dette måltid.n#Person2#: Jeg sætter pris på, at du medbringer vinen. Det passer godt til kyllingen.n—nSummary:nnn### Response:n | #Person1# synes, at måltidet tilberedt af #Person2# er fantastisk. #Person2# introducerer retternes ingredienser. | Når dialogen er afsluttet, vil personen give et passende svar på de indsamlede oplysninger. For eksempel kan person 1 sige,nn#Person1#: Det er fantastisk! Tak.nn#Person2#: Du er meget velkommen. Jeg tænkte, at du kunne lide dit måltid. Jeg er glad for, at du nød det.nn—n— — — — –nnn### Resumé:nnn### Svar:nEfter dialogen | #Person1# og #Person2# spiser hos #Person2#. De taler om maden og vinen, der blander sig med kyllingen.nn |

| Opsummer denne dialog:n#Person1#: Undskyld mig, jeg skriver et essay om det antikke Grækenland. Er der nogen bøger om dette emne, som du kan anbefale?n#Person2#: Gæs? Vil du skrive om gamle gæs? Jeg har aldrig hørt om sådan noget. I hvert fald ville det være med en bog med nogle dyr, det er række J. Eller vil du prøve videnskab, det er i Row Gn#Person1#: Animals? Men Grækenland er et land, ikke et dyr.n#Person2#: Åh, Grækenland. Nå, du ved, i dag må være din heldige dag. Vi har netop modtaget en ny samling af bøger om netop det emne. Der er forfattere her i rækken Cn#Person1#: Jeg kan se. Det er mange bøger, som du foreslår?n#Person2#: Nå, den af Robin Smith er fremragende, men den er meget lang. Det er den med statuen på omslaget. Der er også en af Milton Pike. Den har et maleri af en soldat på forsiden. Som du kan se, er den ikke særlig tyk, så den burde ikke tage for lang tid at læse. Men nok den bedste bog er den med billedet af det gamle Olympiske Stadion. Den har vundet flere belønninger for historieværker.n#Person1#: Nå, det er svært at beslutte sig, men jeg er bange for, at jeg ikke har tid nok til en masse læsning. Jeg tror, jeg får bogen af Milton Pike.n#Person2#: OK. Må jeg få dit lånerkort?n#Person1#: Ja, her er du.n—nSummary:nnn### Svar:n | #Person1# beder #Person2# anbefale nogle bøger om det antikke Grækenland. #Person2# foreslår den af Robin Smith, som er meget lang, den af Milton Pike, som ikke er særlig tyk, og den, der vinder flere historieværksbelønninger. Da #Person1# ikke har tid nok, får #Person1# bogen af Milton Pike. | n—nnSammendrag:n | #Person1# skriver et essay om det antikke Grækenland. #Person2# anbefaler bøgerne om det antikke Grækenland til #Person1#, som alle er nyligt modtaget, og foreslår at få bogen af Milton Pike.nn |

| Opsummer denne dialog:n#Person1#: Nå, jeg kan se, du har dine bøger, George. Men læser du? Det ser ud til, at du bare farver.n#Person2#: Jeg markerer de vigtige dele af bogen. Farverne er til forskellige ting.n#Person1#: Som hvad?n#Person2#: Hovedideerne er gule. Vigtige detaljer at huske er pink, og den lysegrønne er til svære ideer.n#Person1#: Det virker som mange aktiviteter. Spilder du ikke din tid?n#Person2#: Det tror jeg ikke, mor. Jeg læser det hele i aften. Jeg lytter til det i morgen. Og når det så er tid til at studere, vil jeg allerede kende det meste af informationen.n#Person1#: I min tid læste vi bare bogen og forsøgte at huske oplysningerne.n#Person2#: Læreren fortalte os vigtigheden af aktiv læsning. Og det er den bedste måde at lære på, uanset hvilken hastighed du vælger.n#Person1#: Jeg forstår. Og hvad er denne notesbog til?n#Person2#: Det er til at tage noter. Hvilken slags ting skriver du ned?n#Person1#: Nogle gange skriver jeg et resumé. På denne side skriver jeg spørgsmål ned. Og selvfølgelig har jeg en anden side, hvor jeg skriver de nye ord ned.n—nSummary:nnn### Response:n | George fortæller sin mor, at det er hans måde at lære på at markere de vigtige dele af bogen i forskellige farver. Han tager også noter på notesbogen og skriver nogle gange et resumé. | #Person1#: Åhhh! Aktiv læsning, læsning af spørgsmål, ordforrådsnoter, resuméer og fremhævning. Jeg kan se nu, hvilken forskel du har, når det kommer til at lære information. Jeg er imponeret.n#Person2#: Tak. Læsning er den bedste måde at lære og huske ny information på. Bruger du aktiv læsning lige nu?n#Person1#: Hmmm….. Det bliver jeg nødt til at tænke over.nnn#Person | George beskriver de aktiviteter, han laver for at læse sine bøger hurtigt. George viser notesbogen til mor og forklarer, hvordan man tager noter.nn |

| Opsummer denne dialog:n#Person1#: Godmorgen, sir. Må jeg se dit pas?n#Person2#: Ja, selvfølgelig. Her er den.n#Person1#: Tak. Er alle disse dine?n#Person2#: Nej, nogle af dem er min vens. Vil du også have hendes pas?n#Person1#: Ja tak. Har du noget håndbagage?n#Person2#: Vil du have, at jeg også sætter det på bæltet?n#Person1#: Ja tak. Vil du venligst åbne denne store kuffert?n#Person2#: OK. Lige et øjeblik. Det er bare noget tøj og toiletartikler.n#Person1#: OK. Har du noget at erklære?n#Person2#: Jeg tror, der ikke er noget.n#Person1#: Frisk mad, levende planter eller dyr?n#Person2#: Åh, nej. Intet af det.n#Person1#: Tak. Du kan låse din kuffert. Her er dine pas.n#Person2#: Mange tak.n—nSummary:nnn### Svar:n | #Person1# ser #Person2#s og #Person2#s vens pas og tjekker deres bagage. #Person2# fortæller #Person1#, at de ikke har noget at erklære. #Person1# lader dem gå. | > Jeg tror, der ikke er noget.nnn—n**Kategorier:**nn- [Samtale (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Nøgle:nn :informationskilde: 31 (TSA)n:informationskilde: 32 (TSA)nn—-n* Enhver ophavsret | Immigrationsembedsmanden beder #Person2# om at vise sit pas og åbne sin store kuffert. #Person2# har intet at erklære, og han kan låse sin kuffert.nn |

| Opsummer denne dialog:n#Person1#: Kinesisk te er berømt over hele verden. Jeg vil købe flere æsker.n#Person2#: Der findes forskellige slags te i Kina. Det afhænger af smag og effekt.n#Person1#: Nå, jeg kender slet ikke kinesisk te.n#Person2#: Dette er grøn te, du kan drikke den om sommeren. Det kan lindre sommervarmen, og det er godt til at vedligeholde dine lunger.n#Person1#: Lyder interessant. Hvad med dette?n#Person2#: Det er sort te, den har en stærk smag og fremmer fordøjelsen.n#Person1#: Hvad er det her? Den dufter duftende.n#Person2#: Det er jasminte af høj kvalitet. Den er duftende og har en behagelig smag.n#Person1#: Jeg vil tage jasmin-teen. Kunne du pakke det med indpakningspapir og bånd? Det er en gave til min ven.n#Person2#: Intet problem. Vent et øjeblik.n—nSummary:nnn### Svar:n | #Person2# anbefaler grøn te, sort t-shirt og jasmin-te til #Person1#, der ønsker at købe kinesisk te, og #Person1# beslutter sig for at tage jasmin-teen. | #[Engelsk]#: Kinesisk te er berømt over hele verden. Jeg vil gerne købe flere kasser.n#[fransk]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[spansk]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[tysk]#: Ich mö | #Person1# ønsker at købe flere kasser kinesisk te, med forskellige slags te. #Person2# hjælper #Person1# med at vælge og pakker det sammen.nn |

- Resultater for finjustering af Llama-2 13B-modellen på Dialogsum-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Opsummer denne dialog:n#Person1#: Mrs. Thompson engang ditheist, Jason.n#Person2#: Hvorfor? Vi burde ikke være i problemer eller noget? Faktisk var vi super aktive under hele klassediskussionen i morges.n#Person1#: Det er bare det. Jeg synes overhovedet ikke, det er en dårlig ting. Jeg tror, hun vil bede os om at stille op til klassemonitor.n#Person2#: Whoa! Virkelig? Det er et stort ansvar.n#Person1#: Nå, jeg tror, du ville være god til det. Desuden er det en stor ære at blive bedt om at gøre det. Det betyder, at Mrs. Thompson ser os som ledere.n#Person2#: Jeg er dog ikke sikker på, om jeg kan gøre det alene. Kunne vi gøre det sammen?n#Person1#: Lad os spørge Mrs. Thompson. Jeg hører hende komme ind fra gangen nu.n—nSummary:nnn### Svar:n | #Person1# fortæller Jason Mrs. Thompson engang ditheist, og #Person1# gætter på, at hun vil have dem til at stille op for klassemonitorer. De vil spørge Mrs. Thompson, om de kan gøre dette sammen. | n* Da læreren spurgte Jason og hans klassekammerat, om de ville stille op til klassemonitor, aftalte han og hans klassekammerat det sammen. Begge drenge er kristne, men de er ikke venner i klassen.n* Deres tro på Jesus deles måske ikke offentligt, men det er tydeligt gennem bøn og det eksempel, de følger sammen for at hjælpe andre og vise kærlighed.nn—n## 1654nn **[Situation:** Eleverne taler om det seneste | Mrs. Thompson beder Jason og James om at stille op til klassemonitoren, fordi hun tror, de er ledere.nn |

| Opsummer denne dialog:n#Person1#: Hej, lad os trække forbi og se på det hus derovre.n#Person2#: Ja, det ser godt ud! Er det på vores Åbent Hus-liste?n#Person1#: Ja, det er på vores liste.n#Person2#: Nå, det ser godt ud fra kantstenen. Lad os fortsætte inde.n#Person1#: Lad os underskrive registreringsdatabasen. Ejendomsmægleren ser ret travl ud lige nu.n#Person2#: Okay, lad os gå og tjekke køkkenet næste gang.n#Person1#: Åh se, de har nogle forfriskninger herinde.n#Person2#: Sørg for at hente en flyer med oplysningerne om boligen.n#Person1#: Står der, hvor meget de beder om dette hus?n#Person2#: Ja, det ser ud til at være nedsat fra to hundrede og femogtredive tusinde til to hundrede og femogtyve tusinde—nSummary:nnn### Svar:n | #Person1# og #Person2# kommer for at se et hus. De tjekker ud indeni og taler om prisen. | Dette er et AMI-svar på følgende stimulus.nnPerson 2: nJa, det ser godt ud! Er det på vores Åbent Hus liste? nJa, det er på vores liste.nNå, det ser godt ud fra kantstenen. Lad os fortsætte indenfor.nLad os underskrive registreringsdatabasen. Ejendomsmægleren ser ret travl ud lige nu. Okay, lad os gå og tjekke køkkenet ud. | #Person1# og #Person2# kigger rundt i et hus, som er på deres Åbent Hus-liste. De underskriver et register, og #Person2# beder #Person1# tage en flyer med oplysningerne.nn |

| Opsummer denne dialog:n#Person1#: Hvordan har du det, Mr. Wilson? Jeg er Tina.n#Person2#: Glad for at møde dig, fru Tina.n#Person1#: Sæt dig gerne. Jeg ved, at vores tvangsansættelse allerede har givet dig oplysningerne om din medarbejderkontrakt, men jeg vil gerne gennemgå de vigtigste detaljer igen, inden jeg underskriver. For det første får du en månedsløn med én måned betalt ferie efter et års tjeneste.n#Person2#: Det forstår jeg.n#Person1#: Du vil være dækket af vores lægeplan, mens du er på vagt. Da du bliver mellemleder, forventes du at være tilgængelig op til 1 timer over normal arbejdstid. Enhver godkendt tid derover vil blive udbetalt på halvanden tid, som du kan tage som løn eller fri.n#Person5#: Præcis hvad jeg forstår.n#Person2#: Et rimeligt antal sygedage vil blive dækket af virksomheden . Enhver længerevarende sygdom vil være dækket af forsikringen. Har du læst de øvrige vilkår i kontrakten?n#Person1#: Ja, det har jeg.n#Person2#: Har du andre spørgsmål?n#Person1#: Bare ét. Jeg lagde mærke til et punkt om flextid. Er det en mulighed for mig?n#Person2#: Ja, det er det, men du bliver nødt til at diskutere detaljerne med din leder.n#Person1#: Det er acceptabelt.n#Person2#: Godt. Nu, hvis du bare vil skrive under her, kan du begynde at arbejde om 1 dage.n—nSummary:nnn### Svar:n | Mr.Wilson beskriver de elementære oplysninger om ansættelseskontrakten til Tina. Han nævner månedsløn, en måneds betalt ferie, sygeplaner, forlænget arbejdstid og flekstid. | nNej, resuméerne er ikke rigtige. #Person1-dialogboksen siger ikke, at navnet er Tina, de præsenterer sig ikke. Jeg tror, de begge kender hinandens navne, så det er unødvendigt.nnJeg tror, at hvis alt andet er rigtigt, vil resuméet ikke ændre sig, medmindre #Person1 slutter, og det er ok.nn | Tina mødes med Mr. Wilson for at gennemgå de vigtigste detaljer i Tinas medarbejderkontrakt. De to diskuterer månedsløn og lægeplan. Tina har ingen spørgsmål og begynder at arbejde om 3 dage.nn |

| Opsummer denne dialog:n#Person1#: Jack, hvad er dit yndlingsfag?n#Person2#: Mit yndlingsfag? Jeg tror, jeg foretrækker videnskab. Ja, videnskab, jeg finder det meget interessant. Naturfagslæreren gør faget meget spændende. Hvad med dig?n#Person1#: Jeg klarer mig altid rigtig godt i matematikprøverne. Jeg kan også godt lide geografi. Jeg kan godt lide at lære om mennesker og de steder, hvor de bor. Er der nogle fag, du ikke kan lide Jack?n#Person2#: Jeg kan ikke lide fysik særlig meget. Det er ikke let at forstå, de fleste børn er kede af det.n—nSummary:nnn### Response:n | Jacks yndlingsfag er naturvidenskab, mens han ikke kan lide fysik særlig meget. #Person1# kan lide matematik og geografi. | n—nn### Ordet: "favorit" (adj)nnBetydning: Elsket, værdsat de fleste af de andre nEksempler: Min yndlingsbog er Bibelen; Hvad er din ynglingssport?; Min yndlingsfarve er blå.nn—nnnn### Hvad er dit ____ emne? (formel)nnSpørgsmål og svar Dialog:nn#Person1#: Hvad er dit yndlingsfag?n# | Jack og Jack taler om deres foretrukne og de mindst elskede emner.nn |

| Opsummer denne dialog:n#Person1#: Hej, Maggie. Jeg så dit maleri i slutningen af skoleårets kunstudstilling, som alle forældre gik til. Det var fantastisk.n#Person2#: Nå, vores kunstlærer virkede rigtig glad for det, men jeg er ikke sikker på, hvad forældrene tænkte om.n#Person1#: Åh, bare rolig. Jeg hørte dem kun sige gode ting om det.n#Person2#: Hmm...Han lagde nok ikke mærke til, at jeg ikke havde brugt de rigtige farver.n#Person1#: Jeg tror ikke, nogen lagde mærke til det.n#Person2# : Nej, men det gjorde jeg. Men det var for sent at gøre noget ved det. Nå, næste gang vil jeg forhåbentlig gøre noget bedre.n—nSummary:nnn### Response:n | #Person1# så Maggies maleri og synes, det var fantastisk, men Maggie bekymrer sig om, at hun ikke brugte de rigtige farver og håber, at hun vil gøre noget bedre næste gang. | Dette resumé skal fremhæve de vigtigste punkter og konklusioner fra diskussionen.nn# Svar på person1:n[Response summary]nn—n### Svar:nDette resumé skal fremhæve de vigtigste punkter og konklusioner fra diskussionen.nn# Svar på person2 :n[Response summary]nn### Person1:n[Person1 summary]n—n### Person2:n[Person2 summary]nn### Personn—n | #Person1# så Maggies maleri og fortalte Maggie, at mange forældre sagde gode ting om Maggies maleri. Maggie tror det ikke.nn |

- Resultater for finjustering af Llama 2 70B-modellen på Dialogsum-datasættet:

| Indgange | Grund sandhed | Svar fra Non-Fine-Tuned Model | Svar fra Fine-Tuned Model |

| Opsummer denne dialog:n#Person1#: Har du modtaget nogen grader?n#Person2#: Ja. I 1996 modtog jeg min Bachelor of Science-grad fra Hebes University, og i 2001 modtog jeg min MBA-grad fra Peking University.n#Person1#: Hvad med dine akademiske rekorder på college?n#Person2#: Faktisk var mine rekorder fremragende. Min samlede GPA var 9 på en 10-skala, hvilket var den højeste i min klasse.n#Person1#: Det er meget imponerende. Hvilket kursus kunne du bedst lide?n#Person2#: Engelsk. Det var både interessant og nyttigt, så jeg viste en stor interesse for det.n#Person1#: Kan du fortælle mig, hvorfor du skiftede hovedfag, da du var kandidatstuderende?n#Person2#: Fordi jeg er meget interesseret i administration og Jeg tog nogle kurser i det. Jeg klarede mig også godt i fagene. Derfor tror jeg på, at jeg kan gøre et godt stykke arbejde i denne stilling.n#Person1#: Fik du nogen hædersbevisninger og priser på college?n#Person2#: Ja. Jeg fik hvert år et stipendium fra universitetet. I 1995 deltog jeg i National Contest of Maths Models, og jeg vandt prisen.n—nSummary:nnn### Respons:n | #Person1# interviewer #Person2# og stiller #Person2# nogle spørgsmål, herunder #Person2#s grader, akademiske rekorder, yndlingskurset og priser på college. #Person2# fortæller også #Person1#, hvorfor #Person2# ændrede hovedfaget til administration. | Kandidaten opsummerede, at hovedtanken med dialogen var, at han fik to grader, 0. Og de store gjorde det godt. nMen hans første sætning giver ikke mange følelser ovenfor udover narcissisme, og den angiver heller ikke, hvorfor hans erfaring er relevant for virksomheden. Han kunne skabe en bedre forbindelse og måske afslutte resuméet med en underliggende følelse/attitude, som ikke er "professionel" (som han gør i dialogen). | #Person2# fortæller #Person1# #Person2# modtog en bachelorgrad og en MBA. #Person2#s GPA er den højeste i #Person2#s klasse, og #Person2# er interesseret i administration. #Person2# fik også nogle hædersbevisninger og priser på college.nn |

| Opsummer denne dialog:n#Person1#: Undskyld mig, hvilket materiale er det? n#Person2#: Rhaki. Vil du have noget? n#Person1#: Nej, hvor er bomuldskludene? n#Person2#: Jeg vil vise dig. n#Person1#: Hvad er krympningshastigheden efter vask? n#Person2#: Mindre end 5 %. Det er ret holdbart. n—nSummary:nnn### Svar:n | #Person2# fortæller #Person1#, at bomuldstøjet er slidstærkt. | For rute QA41913 bør dette afsnit indeholde et afsnitsresumé af dialogen, så for eksempel et automatisk udtale- og talegenereringssystem kunne bruge denne tekst til outputsyntese. | #Person1# vil have noget bomuldsklud. #Person2# viser noget rhaki.nn |

| Opsummer denne dialog:n#Person1#: Undskyld, jeg er forsinket, Tom.n#Person2#: Det er i orden, Rita. Hvor har du været?n#Person1#: På politistationen. Jeg har mistet min håndtaske. Eller måske nogen har taget det. Jeg ved det ikke.n#Person2#: Åh, nej. Hvad skete der? Sid ned. Var der noget vigtigt i det?n#Person1#: Vigtigt! Mit checkhæfte, alle de papirer, jeg skal bruge til arbejdet.n#Person2#: Åh, det er forfærdeligt. Men hvordan mistede du det?n#Person1#: Nå, som du ved, var jeg sammen med en ven hele formiddagen, og vi spiste frokost sammen. Efter jeg havde spist frokost gik jeg på indkøb. Og da jeg ville købe noget, kunne jeg ikke finde mit checkhæfte. Så huskede jeg, at den lå i min håndtaske. Og min håndtaske var i min bil.n#Person2#: Så du gik tilbage til din bil.n#Person1#: Men jeg fandt den ikke der.n#Person2#: Og du gik til politistationen?n# Person1#: Ikke umiddelbart. Før jeg gik til politistationen, ringede jeg til min vens kontor. Uden held.n#Person2#: Du skulle gå til restauranten, hvor du spiste frokost og lede efter den.n#Person1#: Åh, det skulle jeg have gjort.n#Person2#: Nu må du hellere ringe til lederen rigtigt væk.n—nSummary:nnn### Svar:n | Rita fortæller Tom, at hun er forsinket, fordi hun har mistet sin håndtaske og sin indsats for at lede efter håndtasken. Tom foreslår, at Rita går til restauranten, hvor hun spiste frokost, og kigger efter den. | Oversæt hver sætning til engelsk ved at bruge den ordkombination, du bedst kan lide:n### Værdi:n | Rita mistede sin håndtaske, og Tom råder hende til at gå til restauranten, hvor hun spiste frokost for at lede efter den.nn |

| Opsummer denne dialog:n#Person1#: Morning, Mum!n#Person2#: Morning, Meg. Ser du ikke godt ud i dag? Er du syg?n#Person1#: Nej, jeg er ikke syg.n#Person2#: Så, hvad er der i vejen med dig mit barn?n#Person1#: Nothing.n#Person2#: Åh, kom nu, skat. Fortæl mig, hvad der skete.n#Person1#: I. . . Jeg bestod ikke eksamen. Hvor ville jeg ønske, jeg havde studeret hårdt.n#Person2#: Åh. Tag det roligt. Du kan sætte dit mål fra i dag.n#Person1#: Ok, mor. Jeg dumper ikke eksamen næste gang.n—nSummary:nnn### Svar:n | Meg er ikke i humøret, fordi hun ikke bestod eksamen. Hendes mor opfordrer hende til at sætte sit mål fra i dag. | Aide sans action verbnAide et direct object apres le verbe amountn | #Person1# bestod ikke eksamen og fortæller mor om det. Mor opfordrer #Person1# til at studere hårdere.nn |

| Opsummer denne dialog:n#Person1#: Alle ønsker at være økonomiske tabe dræb. Du skal investere din opsparing, hvis du planlagde at gå på pension rig. Jeg overvejer at købe aktier. Det kan være en god investering, hvis jeg kan klare mig godt. Hvad siger du?n#Person2#: Jeg er delvist enig med dig. Det er ikke svært at købe aktier, men det er meget svært at tjene penge konsekvent på at købe aktier. Selv professionelle finder det ikke nemt, så vær forsigtig. I hvert fald har folk som os brug for hjælp til at investere. Hvorfor ikke lave noget online research? Der er data, rapporter og diskussionsfora til at uddanne folk i, hvordan man investerer. Derudover skal du besøge en etableret hjemmeside, der tilbyder aktiediagrammer.n#Person1#: Wow, du lyder meget professionel.n#Person2#: Jeg har lige set investerings-tv-programmet sidste weekend. Det er blevet et meget varmt emne i disse dage. Faktisk er jeg ikke engang nybegynder.n—nSummary:nnn### Response:n | #Person1# og #Person2# taler om at købe aktier. #Person2# mener, at det er svært at tjene penge konsekvent på denne måde og foreslår, at man laver online research for at lære om investering. | nJeg er enig i den tidligere anbefalede investeringsstrategi. Det tog mig meget tid og energi at komme med en sådan plan. Det er dejligt, at der er blevet givet tillid til min dom i denne grad. Faktisk kan min kollega føle sig sikker, fordi jeg vil gøre alt for at føre dette team til en lys og sikker pensionsfremtid. Jeg ser frem til din rolle som aktivt medlem af teamet. | #Person1# ønsker at købe aktier, men #Person2# beder #Person1# være forsigtig, fordi det er svært at investere. #Person2# foreslår #Person1# at lave online research, besøge etablerede websteder og se investeringsprogrammer.nn |

Datasæt formatering

Vi tilbyder i øjeblikket to typer finjustering: finjustering af instruktion og finjustering af domænetilpasning. Du kan nemt skifte til en af træningsmetoderne ved at angive parameteren instruction_tuned som 'True'eller'False«.

Domænetilpasningsformat