Whisper er en Automatic Speech Recognition (ASR) model, der er blevet trænet ved hjælp af 680,000 timers overvågede data fra nettet, der omfatter en række sprog og opgaver. En af dens begrænsninger er den lave ydeevne på sprog med lav ressource, såsom marathisprog og dravidiske sprog, som kan afhjælpes med finjustering. Det er dog blevet en betydelig udfordring at finjustere en Whisper-model, både med hensyn til beregningsressourcer og lagerkrav. Fem til ti kørsler af fuld finjustering for Whisper-modeller kræver cirka 100 timers A100 GPU (40 GB SXM4) (varierer baseret på modelstørrelser og modelparametre), og hvert finjusteret kontrolpunkt kræver omkring 7 GB lagerplads. Denne kombination af høje beregnings- og lagerkrav kan udgøre betydelige forhindringer, især i miljøer med begrænsede ressourcer, hvilket ofte gør det usædvanligt vanskeligt at opnå meningsfulde resultater.

Low-Rank Adaptation, også kendt som LoRA, tager en unik tilgang til model finjustering. Det fastholder de forudtrænede modelvægte i en statisk tilstand og introducerer trenerbare rangnedbrydningsmatricer i hvert lag af transformatorstrukturen. Denne metode kan reducere antallet af oplærbare parametre, der er nødvendige for downstream-opgaver, med 10,000 gange og reducere GPU-hukommelseskravet med 3 gange. Med hensyn til modelkvalitet har LoRA vist sig at matche eller endda overgå ydeevnen af traditionelle finjusteringsmetoder, på trods af at der arbejdes med færre parametre, der kan trænes (se resultaterne fra originalen LoRA papir). Det giver også fordelen ved øget træningsgennemstrømning. I modsætning til adapter metoder, introducerer LoRA ikke yderligere latens under inferens, og bibeholder derved modellens effektivitet under implementeringsfasen. Finjustering af Whisper ved hjælp af LoRA har vist lovende resultater. Tag Whisper-Large-v2, for eksempel: at køre 3-epoker med et 12-timers fælles stemmedatasæt på 8 GB hukommelse GPU tager 6-8 timer, hvilket er 5 gange hurtigere end fuld finjustering med sammenlignelig ydeevne.

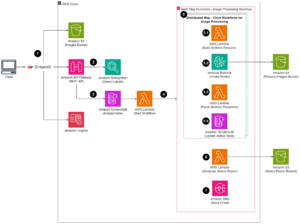

Amazon SageMaker er en ideel platform til at implementere LoRA finjustering af Whisper. Amazon SageMaker giver dig mulighed for at bygge, træne og implementere maskinlæringsmodeller til enhver brug med fuldt administreret infrastruktur, værktøjer og arbejdsgange. Yderligere modeltræningsfordele kan omfatte lavere træningsomkostninger med Managed Spot Training, distribuerede træningsbiblioteker til opdeling af modeller og træningsdatasæt på tværs af AWS GPU-instanser og mere. De trænede SageMaker-modeller kan nemt implementeres til slutning direkte på SageMaker. I dette indlæg præsenterer vi en trin-for-trin guide til implementering af LoRA finjustering i SageMaker. Kildekoden forbundet med denne implementering kan findes på GitHub.

Forbered datasættet til finjustering

Vi bruger det ressourcesvage sprog marathi til finjusteringsopgaven. Bruger Knusende ansigt-datasæt bibliotek, kan du downloade og opdele Common Voice-datasættet i trænings- og testdatasæt. Se følgende kode:

Whisper-talegenkendelsesmodellen kræver lydindgange 16kHz mono 16-bit signerede heltal WAV-filer. Da Common Voice-datasættet er 48K samplinghastighed, skal du først downsample lydfilerne. Derefter skal du anvende Whispers feature extractor til lyden for at udtrække log-mel spektrogram funktioner, og anvende Whispers tokenizer til de indrammede funktioner for at konvertere hver sætning i transskriptionen til et token ID. Se følgende kode:

Når du har behandlet alle træningseksemplerne, skal du uploade de behandlede data til Amazon S3, så når du bruger de behandlede træningsdata i finjusteringsfasen, kan du bruge FastFile for at montere S3-filen direkte i stedet for at kopiere den til lokal disk:

Træn modellen

Til demonstration bruger vi whisper-large-v2 som den fortrænede model (whisper v3 er nu tilgængelig), som kan importeres gennem Hugging Face transformers bibliotek. Du kan bruge 8-bit kvantisering for yderligere at forbedre træningseffektiviteten. 8-bit kvantisering tilbyder hukommelsesoptimering ved at afrunde fra flydende komma til 8-bit heltal. Det er en almindeligt anvendt modelkomprimeringsteknik til at opnå besparelser ved reduceret hukommelse uden at ofre præcision under inferens for meget.

For at indlæse den præ-trænede model i 8-bit kvantiseret format, tilføjer vi blot argumentet load_in_8bit=True, når modellen instansieres, som vist i følgende kode. Dette vil indlæse modelvægtene kvantificeret til 8 bit, hvilket reducerer hukommelsesfodaftrykket.

Vi bruger LoRA-implementeringen fra Hugging Face's peft pakke. Der er fire trin til at finjustere en model ved hjælp af LoRA:

- Instantiér en basismodel (som vi gjorde i sidste trin).

- Opret en konfiguration (

LoraConfig) hvor LoRA-specifikke parametre er defineret. - Pak basismodellen ind med

get_peft_model()at få en træningsbarPeftModel. - Træn

PeftModelsom basismodel.

Se følgende kode:

At køre en SageMaker uddannelse job, vi medbringer vores egen Docker container. Du kan downloade Docker-billedet fra GitHub, hvor ffmpeg4 og git-lfs er pakket sammen med andre Python-krav. For at lære mere om, hvordan du tilpasser din egen Docker-container til at arbejde med SageMaker, se Tilpasning af din egen træningscontainer. Så kan du bruge Hugging Face Estimator og starte et SageMaker træningsjob:

Implementeringen af LoRA gjorde det muligt for os at køre Whisper store finjusteringsopgave på en enkelt GPU-instans (for eksempel ml.g5.2xlarge). Til sammenligning kræver Whisper store fuld finjusteringsopgave flere GPU'er (for eksempel ml.p4d.24xlarge) og en meget længere træningstid. Mere specifikt viste vores eksperiment, at den fulde finjusteringsopgave kræver 24 gange flere GPU-timer sammenlignet med LoRA-tilgangen.

Evaluer modellens ydeevne

For at evaluere ydeevnen af den finjusterede Whisper-model beregner vi ordfejlfrekvensen (WER) på et udholdt testsæt. WER måler forskellen mellem den forudsagte transkription og grundsandhedens transkription. En lavere WER indikerer bedre ydeevne. Du kan køre følgende script mod den forudtrænede model og finjusterede model og sammenligne deres WER-forskel:

Konklusion

I dette indlæg demonstrerede vi finjustering af Whisper, en state-of-the-art talegenkendelsesmodel. Vi brugte især Hugging Faces PEFT LoRA og aktiverede 8-bit kvantisering for effektiv træning. Vi demonstrerede også, hvordan man kører træningsjobbet på SageMaker.

Selvom dette er et vigtigt første skridt, er der flere måder, du kan bygge videre på dette arbejde for yderligere at forbedre hviskemodellen. Fremover kan du overveje at bruge SageMaker distribueret træning til at skalere træning på et meget større datasæt. Dette vil give modellen mulighed for at træne på mere varierede og omfattende data, hvilket forbedrer nøjagtigheden. Du kan også optimere latens, når du betjener Whisper-modellen, for at aktivere talegenkendelse i realtid. Derudover kan du udvide arbejdet til at håndtere længere lydtransskriptioner, hvilket kræver ændringer af modelarkitektur og træningsskemaer.

Anerkendelse

Forfatterne takker Paras Mehra, John Sol og Evandro Franco for deres indsigtsfulde feedback og gennemgang af indlægget.

Om forfatterne

Jun Shi er Senior Solutions Architect hos Amazon Web Services (AWS). Hans nuværende fokusområder er AI/ML infrastruktur og applikationer. Han har over ti års erfaring i FinTech-industrien som softwareingeniør.

Jun Shi er Senior Solutions Architect hos Amazon Web Services (AWS). Hans nuværende fokusområder er AI/ML infrastruktur og applikationer. Han har over ti års erfaring i FinTech-industrien som softwareingeniør.

Dr. Changsha Ma er AI/ML Specialist hos AWS. Hun er teknolog med en ph.d. i datalogi, en kandidatgrad i pædagogisk psykologi og mange års erfaring inden for datavidenskab og selvstændig rådgivning inden for AI/ML. Hun brænder for at forske i metodiske tilgange til maskinel og menneskelig intelligens. Uden for arbejdet elsker hun at vandre, lave mad, jage mad og tilbringe tid med venner og familie.

Dr. Changsha Ma er AI/ML Specialist hos AWS. Hun er teknolog med en ph.d. i datalogi, en kandidatgrad i pædagogisk psykologi og mange års erfaring inden for datavidenskab og selvstændig rådgivning inden for AI/ML. Hun brænder for at forske i metodiske tilgange til maskinel og menneskelig intelligens. Uden for arbejdet elsker hun at vandre, lave mad, jage mad og tilbringe tid med venner og familie.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- :har

- :er

- :hvor

- 000

- 1

- 10

- 100

- 13

- 15 %

- 17

- 24

- 25

- 26 %

- 40

- 7

- 8

- 97

- a

- Om

- nøjagtighed

- opnå

- tværs

- tilpasse

- tilpasning

- tilføje

- Yderligere

- Derudover

- mod

- AI / ML

- Alle

- tillade

- også

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon Web Services (AWS)

- amp

- an

- ,

- enhver

- applikationer

- Indløs

- tilgang

- tilgange

- cirka

- arkitektur

- ER

- områder

- argument

- Array

- AS

- forbundet

- At

- lyd

- forfattere

- auto

- Automatisk Ur

- til rådighed

- AWS

- bund

- baseret

- BE

- fordi

- bliver

- været

- gavner det dig

- fordele

- Bedre

- mellem

- både

- bringe

- bygge

- by

- beregne

- CAN

- tilfælde

- udfordre

- Ændringer

- kode

- kombination

- Fælles

- almindeligt

- sammenlignelig

- sammenligne

- sammenlignet

- sammenligning

- omfattende

- beregningsmæssige

- Compute

- computer

- Datalogi

- Konfiguration

- Overvej

- betydelig

- rådgivning

- Container

- konvertere

- kopiering

- Omkostninger

- kunne

- Nuværende

- data

- Dataforberedelse

- datalogi

- datasæt

- årti

- falde

- definerede

- Degree

- den

- krav

- demonstreret

- indsætte

- indsat

- implementering

- Trods

- DID

- forskel

- svært

- direkte

- distribueret

- distribueret træning

- Docker

- Er ikke

- downloade

- i løbet af

- hver

- nemt

- Uddannelse

- effektivitet

- effektiv

- muliggøre

- aktiveret

- muliggør

- omfatter

- ingeniør

- miljøer

- epoke

- fejl

- især

- evaluere

- Endog

- eksempel

- overstige

- undtagelsesvis

- Udvid

- erfaring

- eksperiment

- udvide

- ekstrakt

- Ansigtet

- familier

- hurtigere

- Feature

- Funktionalitet

- tilbagemeldinger

- færre

- File (Felt)

- Filer

- fintech

- Fornavn

- fem

- flydende

- Fokus

- efter

- mad

- Fodspor

- Til

- format

- Videresend

- fundet

- fire

- venner

- fra

- fuld

- fuldt ud

- funktion

- yderligere

- få

- gå

- GPU

- GPU'er

- taknemmelighed

- Ground

- vejlede

- håndtere

- Have

- he

- Høj

- hans

- HOURS

- Hvordan

- How To

- Men

- HTML

- HTTPS

- menneskelig

- menneskelig intelligens

- Jagt

- Hurdles

- ID

- ideal

- id'er

- billede

- gennemføre

- implementering

- importere

- vigtigt

- Forbedre

- forbedring

- in

- omfatter

- øget

- uafhængig

- angiver

- industrien

- Infrastruktur

- indgang

- indgange

- indsigtsfuld

- instans

- i stedet

- Intelligens

- ind

- indføre

- Introducerer

- IT

- ITS

- Job

- John

- jpg

- kendt

- etiket

- Etiketter

- Sprog

- Sprog

- stor

- større

- Efternavn

- Latency

- lag

- LÆR

- læring

- biblioteker

- Bibliotek

- begrænsninger

- Limited

- belastning

- lokale

- længere

- elsker

- lavere

- maskine

- machine learning

- Vedligeholdelse

- fastholder

- Making

- lykkedes

- kort

- herres

- Match

- meningsfuld

- foranstaltninger

- Hukommelse

- metode

- metoder

- metrisk

- ML

- model

- modeller

- mere

- MONTERING

- mr

- meget

- flere

- nødvendiggør

- Behov

- behov

- Ingen

- nu

- nummer

- Nvidia

- of

- Tilbud

- tit

- on

- ONE

- drift

- optimering

- Optimer

- Indstillinger

- or

- original

- Andet

- vores

- uden for

- i løbet af

- egen

- pakke

- emballeret

- parametre

- særlig

- lidenskabelige

- ydeevne

- fase

- phd

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- udgør

- Indlæg

- Precision

- forudsagde

- forberedelse

- præsentere

- Behandlet

- lovende

- Psykologi

- Python

- kvalitet

- rækkevidde

- rangerer

- Sats

- realtid

- anerkendelse

- reducere

- Reduceret

- reducere

- henvise

- krav

- Krav

- Kræver

- Ressourcer

- Resultater

- afkast

- gennemgå

- afrunding

- Kør

- løber

- s

- at ofre

- sagemaker

- Besparelser

- Scale

- ordninger

- Videnskab

- script

- se

- senior

- dømme

- Tjenester

- servering

- sæt

- flere

- hun

- vist

- underskrevet

- signifikant

- ganske enkelt

- enkelt

- størrelser

- So

- Software

- Software Engineer

- SOL

- Løsninger

- Kilde

- kildekode

- Space

- specialist

- specifikt

- tale

- Talegenkendelse

- udgifterne

- delt

- Spot

- Stage

- starte

- Tilstand

- state-of-the-art

- statisk

- Trin

- Steps

- opbevaring

- struktur

- sådan

- Tag

- tager

- mål

- Opgaver

- opgaver

- teknik

- teknolog

- ti

- vilkår

- prøve

- Test

- tekst

- end

- at

- The Source

- deres

- derefter

- Der.

- derved

- denne

- Gennem

- kapacitet

- tid

- gange

- til

- sammen

- token

- også

- værktøjer

- fakkel

- traditionelle

- Tog

- uddannet

- Kurser

- Transcript

- transformer

- transformers

- Sandheden

- enestående

- I modsætning til

- us

- brug

- brug tilfælde

- anvendte

- ved brug af

- varieret

- Voice

- måder

- we

- web

- webservices

- hvornår

- som

- Hviske

- vilje

- med

- uden

- ord

- Arbejde

- arbejdsgange

- år

- Du

- Din

- zephyrnet