Dette er et gæsteindlæg medforfattet af Nafi Ahmet Turgut, Hasan Burak Yel og Damla Şentürk fra Getir.

Etableret i 2015, bragt har positioneret sig som banebrydende inden for ultrahurtig dagligvarelevering. Denne innovative teknologivirksomhed har revolutioneret sidste mile leveringssegmentet med sit overbevisende udbud af "dagligvarer på få minutter." Med en tilstedeværelse på tværs af Tyrkiet, Storbritannien, Holland, Tyskland og USA er Getir blevet en multinational styrke at regne med. I dag repræsenterer Getir-mærket et diversificeret konglomerat, der omfatter ni forskellige vertikaler, der alle arbejder synergistisk under en enestående paraply.

I dette indlæg forklarer vi, hvordan vi byggede en end-to-end produktkategori forudsigelse pipeline for at hjælpe kommercielle teams ved at bruge Amazon SageMaker , AWS batch, hvilket reducerer modeltræningens varighed med 90 %.

At forstå vores eksisterende produktsortiment på en detaljeret måde er en afgørende udfordring, som vi sammen med mange virksomheder står over for på nutidens hurtige og konkurrenceprægede marked. En effektiv løsning på dette problem er forudsigelsen af produktkategorier. En model, der genererer et omfattende kategoritræ, giver vores kommercielle teams mulighed for at benchmarke vores eksisterende produktportefølje i forhold til vores konkurrenters, hvilket giver en strategisk fordel. Derfor er vores centrale udfordring skabelsen og implementeringen af en nøjagtig produktkategoriforudsigelsesmodel.

Vi udnyttede de kraftfulde værktøjer fra AWS til at tackle denne udfordring og effektivt navigere i det komplekse felt af maskinlæring (ML) og forudsigende analyse. Vores indsats førte til den succesfulde oprettelse af en end-to-end produktkategori forudsigelse pipeline, som kombinerer styrkerne fra SageMaker og AWS Batch.

Denne evne til forudsigende analyse, især den nøjagtige prognose for produktkategorier, har vist sig at være uvurderlig. Det gav vores teams kritisk datadrevet indsigt, der optimerede lagerstyring, forbedrede kundeinteraktioner og styrkede vores markedstilstedeværelse.

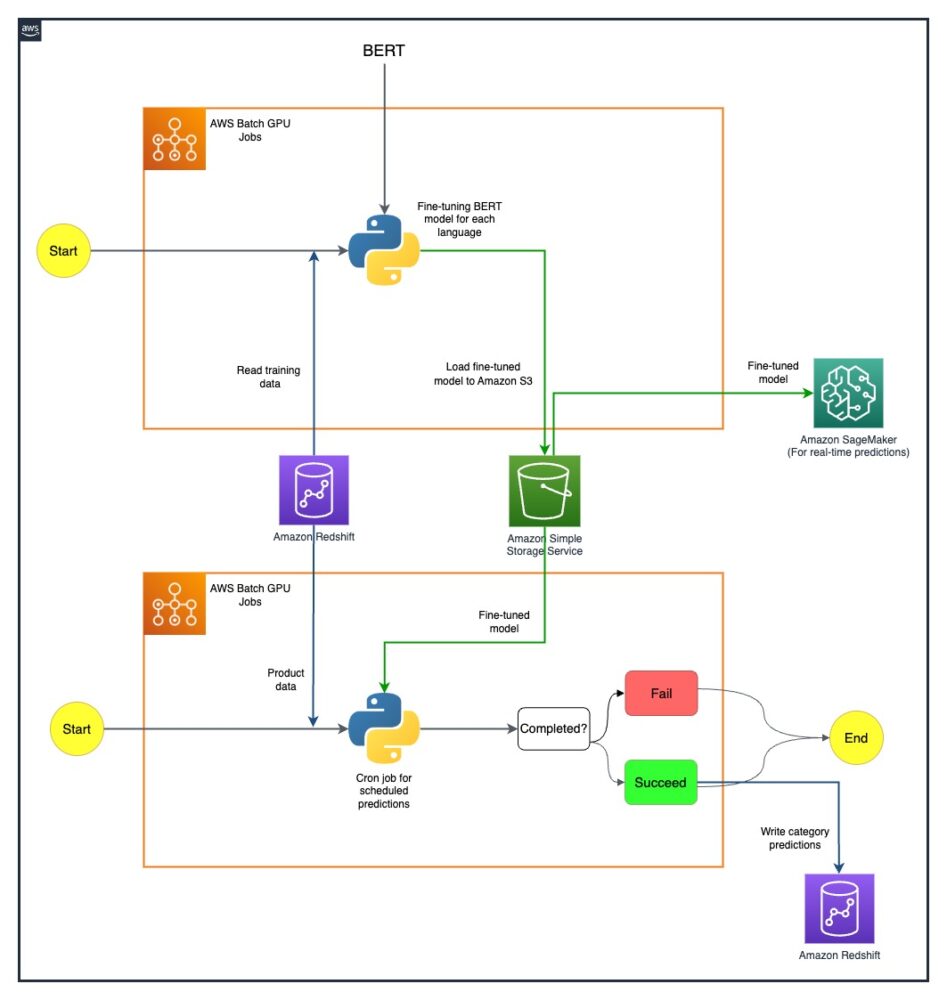

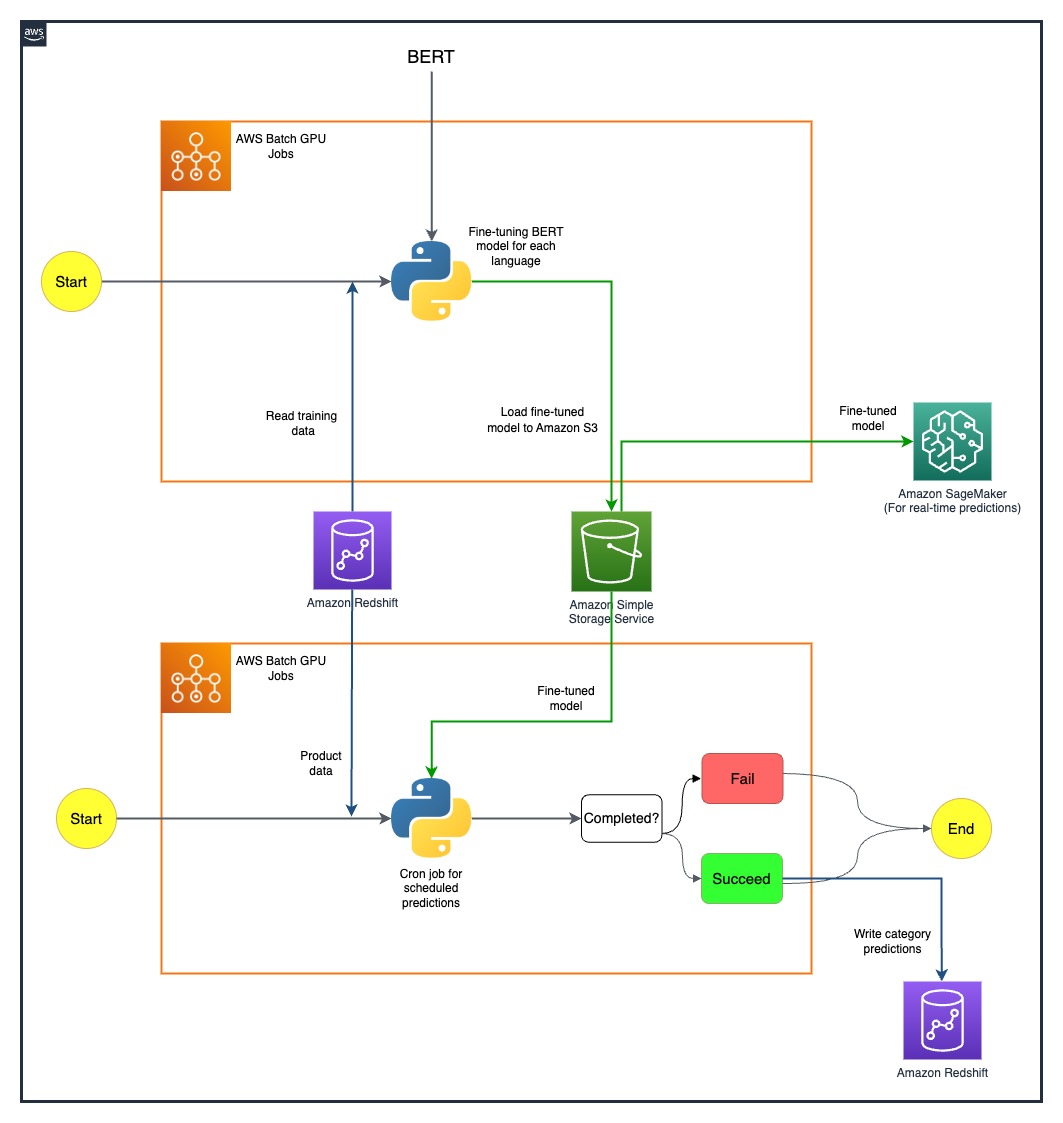

Metoden, vi forklarer i dette indlæg, spænder fra den indledende fase af indsamling af funktioner til den endelige implementering af forudsigelsespipelinen. Et vigtigt aspekt af vores strategi har været brugen af SageMaker og AWS Batch til at forfine præ-trænede BERT-modeller til syv forskellige sprog. Derudover vores problemfri integration med AWS's objektlagringstjeneste Amazon Simple Storage Service (Amazon S3) har været nøglen til effektivt at opbevare og få adgang til disse raffinerede modeller.

SageMaker er en fuldt administreret ML-tjeneste. Med SageMaker kan dataforskere og udviklere hurtigt og ubesværet bygge og træne ML-modeller og derefter implementere dem direkte i et produktionsklart hostet miljø.

Som en fuldt administreret service hjælper AWS Batch dig med at køre batch computing-arbejdsbelastninger af enhver skala. AWS Batch klargør automatisk computerressourcer og optimerer fordelingen af arbejdsbelastningen baseret på mængden og omfanget af arbejdsbelastningerne. Med AWS Batch er der ingen grund til at installere eller administrere batch-computersoftware, så du kan fokusere din tid på at analysere resultater og løse problemer. Vi brugte GPU-job, der hjælper os med at køre job, der bruger en forekomsts GPU'er.

Oversigt over løsning

Fem personer fra Getirs datavidenskabsteam og infrastrukturteam arbejdede sammen om dette projekt. Projektet blev afsluttet på en måned og sat i produktion efter en uges test.

Følgende diagram viser løsningens arkitektur.

Modelpipelinen køres separat for hvert land. Arkitekturen inkluderer to AWS Batch GPU cron-job for hvert land, der kører efter definerede tidsplaner.

Vi overvandt nogle udfordringer ved strategisk at implementere SageMaker og AWS Batch GPU-ressourcer. Den proces, der bruges til at løse hver vanskelighed, er beskrevet i de følgende afsnit.

Finjustering af flersprogede BERT-modeller med AWS Batch GPU-job

Vi søgte en løsning til at understøtte flere sprog til vores forskellige brugerbase. BERT-modeller var et oplagt valg på grund af deres etablerede evne til at håndtere komplekse naturlige sprogopgaver effektivt. For at skræddersy disse modeller til vores behov, udnyttede vi kraften i AWS ved at bruge single-node GPU-instansjob. Dette gjorde det muligt for os at finjustere fortrænede BERT-modeller til hvert af de syv sprog, vi havde brug for support til. Gennem denne metode sikrede vi høj præcision i forudsigelse af produktkategorier og overvinde eventuelle potentielle sprogbarrierer.

Effektiv modelopbevaring ved hjælp af Amazon S3

Vores næste skridt var at adressere modelopbevaring og -styring. Til dette valgte vi Amazon S3, kendt for sin skalerbarhed og sikkerhed. Lagring af vores finjusterede BERT-modeller på Amazon S3 gjorde det muligt for os at give nem adgang til forskellige teams i vores organisation, og dermed strømline vores implementeringsproces betydeligt. Dette var et afgørende aspekt for at opnå smidighed i vores operationer og en problemfri integration af vores ML-indsats.

Oprettelse af en ende-til-ende forudsigelsespipeline

En effektiv pipeline var påkrævet for at udnytte vores fortrænede modeller bedst muligt. Vi implementerede først disse modeller på SageMaker, en handling, der muliggjorde forudsigelser i realtid med lav latenstid, og derved forbedrede vores brugeroplevelse. Til større batch-forudsigelser, som var lige så vigtige for vores drift, brugte vi AWS Batch GPU-job. Dette sikrede den optimale udnyttelse af vores ressourcer, hvilket gav os en perfekt balance mellem ydeevne og effektivitet.

Udforskning af fremtidige muligheder med SageMaker MME'er

Mens vi fortsætter med at udvikle os og søger effektivitet i vores ML-pipeline, er en vej, vi er ivrige efter at udforske, at bruge SageMaker multi-model endpoints (MME'er) til at implementere vores finjusterede modeller. Med MME'er kan vi potentielt strømline implementeringen af forskellige finjusterede modeller og sikre effektiv modelstyring, samtidig med at vi drager fordel af SageMakers indbyggede muligheder som skyggevarianter, automatisk skalering og amazoncloudwatch integration. Denne udforskning stemmer overens med vores kontinuerlige stræben efter at forbedre vores forudsigelige analysekapaciteter og levere overlegne oplevelser til vores kunder.

Konklusion

Vores succesfulde integration af SageMaker og AWS Batch har ikke kun adresseret vores specifikke udfordringer, men har også øget vores operationelle effektivitet markant. Gennem implementeringen af en sofistikeret produktkategori-forudsigelsespipeline er vi i stand til at styrke vores kommercielle teams med datadrevet indsigt og derved lette mere effektiv beslutningstagning.

Vores resultater taler meget om vores tilgangs effektivitet. Vi har opnået en forudsigelsesnøjagtighed på 80 % på tværs af alle fire niveauer af kategorigranularitet, hvilket spiller en vigtig rolle i udformningen af produktsortimentet for hvert land, vi betjener. Dette præcisionsniveau udvider vores rækkevidde ud over sprogbarrierer og sikrer, at vi tilgodeser vores forskelligartede brugerbase med den største nøjagtighed.

Desuden har vi ved strategisk at bruge planlagte AWS Batch GPU-job været i stand til at reducere vores modeluddannelsesvarighed med 90 %. Denne effektivitet har yderligere strømlinet vores processer og styrket vores operationelle smidighed. Effektiv modellagring ved hjælp af Amazon S3 har spillet en afgørende rolle i denne præstation, idet den balancerer både realtids- og batchforudsigelser.

For mere information om, hvordan du kommer i gang med at bygge dine egne ML-pipelines med SageMaker, se Amazon SageMaker-ressourcer. AWS Batch er en glimrende mulighed, hvis du er på udkig efter en billig, skalerbar løsning til at køre batchjob med lavt driftsoverhead. For at komme i gang, se Kom godt i gang med AWS Batch.

Om forfatterne

Nafi Ahmet Turgut afsluttede sin kandidatgrad i Electrical & Electronics Engineering og arbejdede som færdiguddannet forsker. Hans fokus var at bygge maskinlæringsalgoritmer til at simulere nervøse netværksanomalier. Han kom til Getir i 2019 og arbejder i øjeblikket som Senior Data Science & Analytics Manager. Hans team er ansvarligt for at designe, implementere og vedligeholde end-to-end maskinlæringsalgoritmer og datadrevne løsninger til Getir.

Nafi Ahmet Turgut afsluttede sin kandidatgrad i Electrical & Electronics Engineering og arbejdede som færdiguddannet forsker. Hans fokus var at bygge maskinlæringsalgoritmer til at simulere nervøse netværksanomalier. Han kom til Getir i 2019 og arbejder i øjeblikket som Senior Data Science & Analytics Manager. Hans team er ansvarligt for at designe, implementere og vedligeholde end-to-end maskinlæringsalgoritmer og datadrevne løsninger til Getir.

Hasan Burak Yel modtog sin bachelorgrad i Electrical & Electronics Engineering ved Boğaziçi University. Han arbejdede hos Turkcell, hovedsageligt fokuseret på tidsserieprognoser, datavisualisering og netværksautomatisering. Han kom til Getir i 2021 og arbejder i øjeblikket som Data Science & Analytics Manager med ansvar for søge-, anbefalings- og vækstdomæner.

Hasan Burak Yel modtog sin bachelorgrad i Electrical & Electronics Engineering ved Boğaziçi University. Han arbejdede hos Turkcell, hovedsageligt fokuseret på tidsserieprognoser, datavisualisering og netværksautomatisering. Han kom til Getir i 2021 og arbejder i øjeblikket som Data Science & Analytics Manager med ansvar for søge-, anbefalings- og vækstdomæner.

Damla Şentürk modtog sin bachelorgrad i computeringeniør ved Galatasaray University. Hun fortsætter sin kandidatgrad i computeringeniør ved Boğaziçi Universitet. Hun kom til Getir i 2022 og har arbejdet som Data Scientist. Hun har arbejdet på kommercielle, forsyningskæde- og opdagelsesrelaterede projekter.

Damla Şentürk modtog sin bachelorgrad i computeringeniør ved Galatasaray University. Hun fortsætter sin kandidatgrad i computeringeniør ved Boğaziçi Universitet. Hun kom til Getir i 2022 og har arbejdet som Data Scientist. Hun har arbejdet på kommercielle, forsyningskæde- og opdagelsesrelaterede projekter.

Esra Kayabalı er en Senior Solutions Architect hos AWS, specialiseret i analysedomænet, herunder data warehousing, data lakes, big data analytics, batch- og realtidsdatastreaming og dataintegration. Hun har 12 års erfaring med softwareudvikling og arkitektur. Hun brænder for at lære og undervise i cloud-teknologier.

Esra Kayabalı er en Senior Solutions Architect hos AWS, specialiseret i analysedomænet, herunder data warehousing, data lakes, big data analytics, batch- og realtidsdatastreaming og dataintegration. Hun har 12 års erfaring med softwareudvikling og arkitektur. Hun brænder for at lære og undervise i cloud-teknologier.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :har

- :er

- :ikke

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- evne

- I stand

- Om

- adgang

- Adgang

- nøjagtighed

- præcis

- opnået

- præstation

- opnå

- tværs

- Handling

- Derudover

- adresse

- rettet

- Fordel

- Efter

- mod

- algoritmer

- Justerer

- Alle

- tilladt

- tillader

- sammen

- også

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- analytics

- analysere

- ,

- og infrastruktur

- abnormaliteter

- enhver

- arkitektur

- ER

- AS

- udseende

- sortiment

- At

- auto

- automatisk

- Automation

- Avenue

- AWS

- Balance

- afbalancering

- barrierer

- bund

- baseret

- BE

- bliver

- været

- benchmark

- gavn

- BEDSTE

- Beyond

- Big

- Big data

- Hjulpet

- både

- brand

- bygge

- Bygning

- bygget

- virksomheder

- men

- by

- CAN

- kapaciteter

- kapacitet

- kapitaliserede

- kategorier

- Boligtype

- imødekomme

- central

- kæde

- udfordre

- udfordringer

- valg

- Cloud

- kombinerer

- kommerciel

- selskab

- overbevisende

- konkurrencedygtig

- konkurrenter

- Afsluttet

- komplekse

- omfattende

- Compute

- computer

- Computer Engineering

- computing

- konglomerat

- fortsæt

- fortsætter

- kontinuerlig

- land

- skabelse

- kritisk

- afgørende

- For øjeblikket

- kunde

- Kunder

- data

- Dataanalyse

- datalogi

- dataforsker

- datavisualisering

- datastyret

- Beslutningstagning

- definerede

- Degree

- levering

- indsætte

- indsat

- implementering

- implementering

- designe

- detaljeret

- udviklere

- Udvikling

- forskellige

- Vanskelighed

- direkte

- fordeling

- forskelligartede

- diversificeret

- domæne

- Domæner

- grund

- varighed

- hver

- let

- Effektiv

- effektivt

- effektivitet

- effektivitet

- effektivitet

- effektiv

- effektivt

- ubesværet

- indsats

- Elektronik

- bemyndige

- aktiveret

- omfatter

- ende til ende

- Engineering

- forbedret

- styrke

- sikret

- sikrer

- sikring

- Miljø

- lige

- etableret

- udvikle sig

- fremragende

- eksisterende

- erfaring

- Oplevelser

- Forklar

- udforskning

- udforske

- udvider

- Ansigtet

- faciliterende

- hurtig

- Feature

- felt

- endelige

- Fornavn

- Fokus

- fokuserede

- efter

- Til

- Tving

- Forecast

- fire

- fra

- fuldt ud

- yderligere

- fremtiden

- indsamling

- genererer

- Tyskland

- få

- GPU

- GPU'er

- eksamen

- Vækst

- Gæst

- gæst Indlæg

- håndtere

- Have

- he

- hjælpe

- hjælper

- hende

- Høj

- hans

- hostede

- Hvordan

- How To

- HTML

- http

- HTTPS

- if

- implementering

- gennemføre

- vigtigt

- vigtigt aspekt

- in

- omfatter

- Herunder

- oplysninger

- Infrastruktur

- initial

- innovativ

- indsigt

- installere

- instans

- integration

- interaktioner

- ind

- uvurderlig

- opgørelse

- Lagerstyring

- IT

- ITS

- selv

- Karriere

- sluttede

- jpg

- Keen

- Nøgle

- kendt

- søer

- Sprog

- Sprog

- Latency

- læring

- Led

- Niveau

- niveauer

- ligesom

- leder

- Lav

- lave omkostninger

- maskine

- machine learning

- hovedsageligt

- Vedligeholdelse

- lave

- administrere

- lykkedes

- ledelse

- leder

- måde

- mange

- Marked

- herres

- metode

- Metode

- minutter

- ML

- model

- modeller

- Måned

- mere

- multinationale

- flere

- indfødte

- Natural

- Naviger

- Behov

- behov

- Holland

- netværk

- næste

- ni

- ingen

- objekt

- Obvious

- of

- tilbyde

- on

- ONE

- kun

- operationelle

- Produktion

- optimal

- optimeret

- Optimerer

- Option

- or

- ordrer

- organisation

- vores

- overvinde

- egen

- især

- lidenskabelige

- Mennesker

- perfekt

- ydeevne

- fase

- pipeline

- plato

- Platon Data Intelligence

- PlatoData

- spillet

- spiller

- portefølje

- positionerede

- muligheder

- Indlæg

- potentiale

- potentielt

- magt

- vigtigste

- Precision

- forudsige

- forudsigelse

- Forudsigelser

- Prediktiv Analytics

- tilstedeværelse

- Problem

- problemer

- behandle

- Processer

- Produkt

- produktion

- projekt

- projekter

- gennemprøvet

- give

- forudsat

- leverer

- udøvelse

- mængde

- hurtigt

- intervaller

- nå

- realtid

- data i realtid

- modtaget

- Anbefaling

- reducere

- Reduceret

- reducere

- raffinere

- raffinerede

- repræsenterer

- påkrævet

- forskning

- Ressourcer

- ansvar

- ansvarlige

- Resultater

- revolutioneret

- roller

- Kør

- kører

- sagemaker

- Skalerbarhed

- skalerbar

- Scale

- skalering

- planlagt

- Videnskab

- Videnskabsmand

- forskere

- sømløs

- Søg

- sektioner

- sikkerhed

- se

- Søg

- segment

- valgt

- senior

- Series

- tjener

- tjeneste

- Tjenester

- sæt

- syv

- Shadow

- forme

- hun

- Shows

- betydeligt

- Simpelt

- ental

- So

- Software

- softwareudvikling

- løsninger

- Løsninger

- Løsning

- nogle

- sofistikeret

- søgte

- tale

- specialiserede

- specifikke

- påbegyndt

- Stater

- Trin

- opbevaring

- lagring

- Strategisk

- Strategisk

- Strategi

- streaming

- strømline

- strømlinet

- strømlining

- styrket

- styrker

- vellykket

- overlegen

- forsyne

- forsyningskæde

- support

- tackle

- skrædder

- opgaver

- Undervisning

- hold

- hold

- tech

- Tech Company

- Teknologier

- Test

- at

- Holland

- UK

- deres

- Them

- derefter

- derved

- derfor

- Disse

- denne

- Gennem

- tid

- Tidsserier

- til

- i dag

- nutidens

- sammen

- værktøjer

- pioner

- Tog

- Kurser

- træ

- Tyrkiet

- to

- Uk

- paraply

- under

- Forenet

- Forenede Stater

- universitet

- us

- brug

- anvendte

- Bruger

- Brugererfaring

- ved brug af

- udnyttet

- yderste

- forskellige

- vertikaler

- visualisering

- afgørende

- mængder

- var

- we

- web

- webservices

- uge

- var

- som

- mens

- med

- inden for

- arbejdede

- arbejder

- virker

- år

- Du

- Din

- zephyrnet