Introduktion

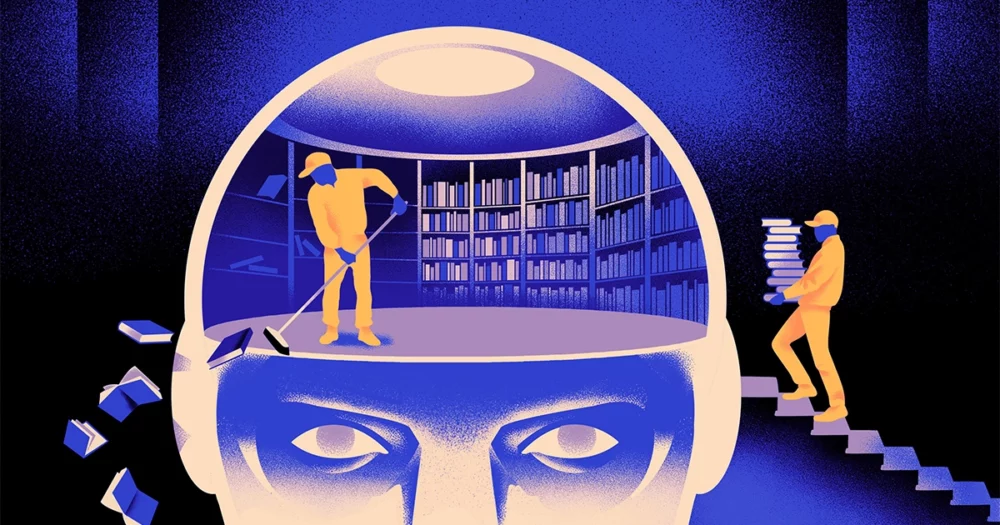

Et team af dataloger har skabt en smidigere, mere fleksibel type af maskinlæringsmodellen. Tricket: Den skal med jævne mellemrum glemme, hvad den ved. Og selvom denne nye tilgang ikke vil fortrænge de enorme modeller, der ligger til grund for de største apps, kan den afsløre mere om, hvordan disse programmer forstår sprog.

Den nye forskning markerer "et betydeligt fremskridt på området," sagde Jea Kwon, en AI-ingeniør ved Institute for Basic Science i Sydkorea.

AI-sprogmotorerne, der bruges i dag, er for det meste drevet af kunstige neurale netværk. Hvert "neuron" i netværket er en matematisk funktion, der modtager signaler fra andre sådanne neuroner, udfører nogle beregninger og sender signaler videre gennem flere lag af neuroner. Til at begynde med er informationsstrømmen mere eller mindre tilfældig, men gennem træning forbedres informationsstrømmen mellem neuroner, efterhånden som netværket tilpasser sig træningsdataene. Hvis en AI-forsker for eksempel ønsker at skabe en tosproget model, vil hun træne modellen med en stor bunke tekst fra begge sprog, som vil justere forbindelserne mellem neuroner på en sådan måde, at teksten relaterer teksten på ét sprog med tilsvarende ord i den anden.

Men denne træningsproces kræver meget computerkraft. Hvis modellen ikke fungerer særlig godt, eller hvis brugerens behov ændrer sig senere, er det svært at tilpasse den. "Sig, at du har en model, der har 100 sprog, men forestil dig, at et sprog, du ønsker, ikke er dækket," sagde Mikel Artetxe, en medforfatter af den nye forskning og grundlægger af AI-startup Reka. "Du kan starte forfra, men det er ikke ideelt."

Artetxe og hans kolleger har forsøgt at omgå disse begrænsninger. Et par år siden, Artetxe og andre trænede et neuralt netværk i ét sprog og slettede derefter, hvad det vidste om ords byggesten, kaldet tokens. Disse er lagret i det første lag af det neurale netværk, kaldet indlejringslaget. De lod alle de andre lag af modellen være i fred. Efter at have slettet tokens på det første sprog, genoplærte de modellen på det andet sprog, som fyldte indlejringslaget med nye tokens fra det sprog.

Selvom modellen indeholdt uoverensstemmende informationer, virkede omskolingen: Modellen kunne lære og bearbejde det nye sprog. Forskerne formodede, at mens indlejringslaget lagrede information specifik for de ord, der blev brugt i sproget, lagrede de dybere niveauer af netværket mere abstrakt information om begreberne bag menneskelige sprog, som så hjalp modellen med at lære det andet sprog.

"Vi lever i den samme verden. Vi konceptualiserer de samme ting med forskellige ord" på forskellige sprog, sagde Yihong Chen, hovedforfatteren af det nylige papir. ”Det er derfor, du har det samme ræsonnement på højt niveau i modellen. Et æble er noget sødt og saftigt i stedet for bare et ord.”

Introduktion

Selvom denne glemmetilgang var en effektiv måde at tilføje et nyt sprog til en allerede trænet model, var omskolingen stadig krævende - det krævede en masse sproglige data og processorkraft. Chen foreslog en tweak: I stedet for at træne, slette indlejringslaget og derefter genoptræne, skulle de periodisk nulstille indlejringslaget under den indledende runde af træningen. "Ved at gøre dette, bliver hele modellen vant til at nulstille," sagde Artetxe. "Det betyder, at når du vil udvide modellen til et andet sprog, er det nemmere, for det er det, du har gjort."

Forskerne tog en almindeligt brugt sprogmodel kaldet Roberta, trænede den ved at bruge deres periodiske glemmeteknik og sammenlignede den med den samme models ydeevne, da den blev trænet med standardmetoden, der ikke glemmes. Glemmemodellen klarede sig lidt dårligere end den konventionelle og fik en score på 85.1 sammenlignet med 86.1 på et fælles mål for sprognøjagtighed. Derefter genoplærte de modellerne på andre sprog ved at bruge meget mindre datasæt på kun 5 millioner tokens, frem for de 70 milliarder de brugte under den første træning. Nøjagtigheden af standardmodellen faldt til 53.3 i gennemsnit, men glemmemodellen faldt kun til 62.7.

Glemmemodellen klarede sig også meget bedre, hvis holdet pålagde beregningsmæssige grænser under genoptræning. Da forskerne reducerede træningslængden fra 125,000 skridt til kun 5,000, faldt nøjagtigheden af glemmemodellen til 57.8 i gennemsnit, mens standardmodellen faldt til 37.2, hvilket ikke er bedre end tilfældige gæt.

Introduktion

Holdet konkluderede, at periodisk glemsel ser ud til at gøre modellen bedre til at lære sprog generelt. "Fordi [de] bliver ved med at glemme og genlære under træning, bliver det lettere at lære netværket noget nyt senere," sagde Evgenii Nikishin, en forsker ved Mila, et forskningscenter for dyb læring i Quebec. Det tyder på, at når sprogmodeller forstår et sprog, gør de det på et dybere plan end blot betydningen af de enkelte ord.

Fremgangsmåden ligner, hvordan vores egen hjerne fungerer. ”Hukommelsen er generelt ikke særlig god til at gemme store mængder detaljeret information nøjagtigt. I stedet har mennesker en tendens til at huske kernen af vores oplevelser, abstrahere og ekstrapolere," sagde Benjamin Levy, en neurovidenskabsmand ved University of San Francisco. "At aktivere AI med mere menneskelignende processer, såsom adaptiv glemsel, er en måde at få dem til at opnå mere fleksibel ydeevne."

Ud over hvad det kan sige om, hvordan forståelse fungerer, håber Artetxe, at mere fleksible glemmesprogmodeller også kan hjælpe med at bringe de seneste AI-gennembrud til flere sprog. Selvom AI-modeller er gode til at håndtere spansk og engelsk, to sprog med rigeligt træningsmateriale, er modellerne ikke så gode med hans modersmål baskisk, det lokale sprog, der er specifikt for det nordøstlige Spanien. "De fleste modeller fra store teknologivirksomheder gør det ikke godt," sagde han. "At tilpasse eksisterende modeller til baskisk er vejen at gå."

Chen ser også frem til en verden, hvor flere AI-blomster blomstrer. ”Jeg tænker på en situation, hvor verden ikke har brug for én stor sprogmodel. Vi har så mange,” sagde hun. "Hvis der er en fabrik, der laver sprogmodeller, har du brug for denne form for teknologi. Den har én basismodel, der hurtigt kan tilpasse sig nye domæner."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :har

- :er

- :ikke

- :hvor

- ][s

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Om

- ABSTRACT

- nøjagtighed

- præcist

- tilpasse

- adaptive

- tilpasser

- tilføje

- Desuden

- fremme

- Efter

- AI

- AI modeller

- Alle

- alene

- allerede

- også

- beløb

- an

- ,

- En anden

- Apple

- tilgang

- apps

- ER

- AS

- At

- forfatter

- gennemsnit

- bund

- grundlæggende

- fordi

- bliver

- været

- bag

- Bedre

- mellem

- Big

- big tech

- Største

- Billion

- Blocks

- Bloom

- både

- gennembrud

- bringe

- Bygning

- men

- by

- beregninger

- kaldet

- CAN

- center

- lave om

- chen

- omgå

- Medforfatter

- kolleger

- Fælles

- almindeligt

- Virksomheder

- sammenlignet

- beregningsmæssige

- computer

- computing

- computerkraft

- begreber

- indgået

- Tilslutninger

- indeholdt

- konventionelle

- kunne

- dækket

- skabe

- oprettet

- Klip

- data

- datasæt

- er faldet

- dyb

- dyb læring

- dybere

- krævende

- detaljeret

- DID

- forskellige

- do

- Er ikke

- gør

- Domæner

- Dont

- droppet

- i løbet af

- hver

- lettere

- Effektiv

- indlejring

- ingeniør

- Motorer

- Engelsk

- Hele

- Ækvivalent

- eksempel

- eksisterende

- Oplevelser

- udvide

- fabrik

- få

- felt

- fyldt

- Fornavn

- fleksibel

- flow

- Til

- Videresend

- grundlægger

- Francisco

- fra

- funktion

- Generelt

- generelt

- få

- GitHub

- Go

- godt

- Håndtering

- Hård Ost

- Have

- he

- hjælpe

- hjulpet

- højt niveau

- hans

- håber

- Hvordan

- HTTPS

- kæmpe

- menneskelig

- menneskelignende

- Mennesker

- ideal

- if

- billede

- pålagt

- forbedrer

- in

- individuel

- oplysninger

- initial

- i første omgang

- i stedet

- Institut

- IT

- lige

- Holde

- Venlig

- kender

- korea

- Sprog

- Sprog

- stor

- senere

- seneste

- lag

- lag

- føre

- LÆR

- læring

- til venstre

- Længde

- mindre

- Niveau

- niveauer

- ligesom

- begrænsninger

- grænser

- leve

- lokale

- UDSEENDE

- Lot

- maskine

- machine learning

- magasin

- lave

- Making

- mange

- materialer

- matematiske

- betydninger

- midler

- måle

- Hukommelse

- måske

- million

- model

- modeller

- mere

- for det meste

- meget

- flere

- skal

- indfødte

- Behov

- behov

- netværk

- neurale

- neurale netværk

- Neuroner

- Ny

- ingen

- of

- on

- ONE

- kun

- or

- Andet

- Andre

- vores

- i løbet af

- egen

- Papir

- ydeevne

- periodisk

- plato

- Platon Data Intelligence

- PlatoData

- kastet

- magt

- strøm

- behandle

- Processer

- forarbejdning

- Processing Power

- Programmer

- Quantamagazin

- Quebec

- hurtigt

- tilfældig

- hellere

- modtager

- modtagende

- nylige

- huske

- påkrævet

- forskning

- forsker

- forskere

- afsløre

- rundt

- løber

- Said

- samme

- San

- San Francisco

- siger

- Videnskab

- forskere

- score

- ridse

- Anden

- synes

- selektiv

- sender

- sæt

- hun

- bør

- signaler

- signifikant

- lignende

- Situationen

- mindre

- So

- nogle

- noget

- Syd

- Sydkorea

- Spanien

- Spansk

- specifikke

- standard

- starte

- opstart

- Steps

- Stadig

- opbevaret

- lagring

- sådan

- foreslår

- sød

- tager

- Undervisning

- hold

- tech

- tech virksomheder

- teknik

- Teknologier

- tendens

- tekst

- end

- at

- oplysninger

- verdenen

- deres

- Them

- derefter

- Disse

- de

- ting

- Tænker

- denne

- selvom?

- Gennem

- til

- i dag

- Tokens

- tog

- Tog

- uddannet

- Kurser

- trick

- forsøgte

- tweak

- to

- forstå

- forståelse

- universitet

- brug

- anvendte

- ved brug af

- meget

- ønsker

- ønsker

- var

- Vej..

- we

- WebP

- GODT

- Hvad

- hvornår

- som

- mens

- hvorfor

- med

- ord

- ord

- Arbejde

- arbejdede

- virker

- world

- værre

- ville

- år

- Du

- zephyrnet