At udtrække tekst fra et billede kan være en besværlig proces. De fleste indtaster manuelt teksten/dataene fra billedet; men det er både tidskrævende og ineffektivt, når du har mange billeder at håndtere.

Billed til tekst konvertere tilbyde en smart måde at udtrække tekst fra billeder.

Selvom sådanne værktøjer gør et godt stykke arbejde, præsenteres den udtrukne tekst/data ofte på en ustruktureret måde, hvilket resulterer i en masse efterbehandling.

An AI-drevet OCR som Nanonets kan trække tekst fra billeder og præsentere de udtrukne data på en pæn, organiseret og struktureret måde.

Nanonets udtrækker data fra billeder nøjagtigt, i skala og på flere sprog. Nanonets er den eneste tekstgenkendelse OCR, der præsenterer udtrukket tekst i pænt strukturerede formater, der er helt tilpasselige. Opsamlede data kan præsenteres som tabeller, linjeposter eller et hvilket som helst andet format.

- Klik for at uploade dit billede nedenfor

- Nanonets' OCR genkender automatisk indholdet i din fil og konverterer det til tekst

- Download den udpakkede tekst som en rå tekstfil eller integrer via API

Indholdsfortegnelse

Her er tre avancerede metoder, hvor du kan bruge Nanonets OCR til at opdage og udtrække tekst fra billeder, Uddrag tekst fra PDFs, udtrække data fra PDFs eller parse PDF'er og andre dokumenttyper:

Har du brug for en gratis online OCR til billede til tekst, PDF til tabellen, PDF til tekst eller PDF-dataudtræk? Tjek Nanonets online OCR API i aktion og begynd at bygge brugerdefinerede OCR-modeller gratis!

Nanonets har præ-trænede OCR-modeller til de specifikke billedtyper, der er anført nedenfor. Hver præ-trænede OCR-model er trænet til nøjagtigt at relatere tekst i billedtypen til et passende felt som navn, adresse, dato, udløb osv. og præsentere den udtrukne tekst på en pæn og organiseret måde.

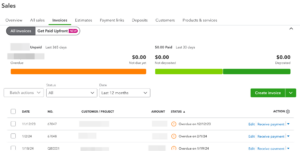

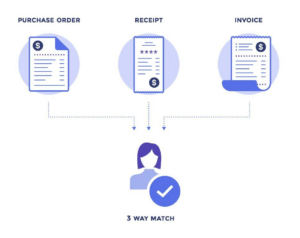

- Fakturaer

- Kvitteringer

- Kørekort (USA)

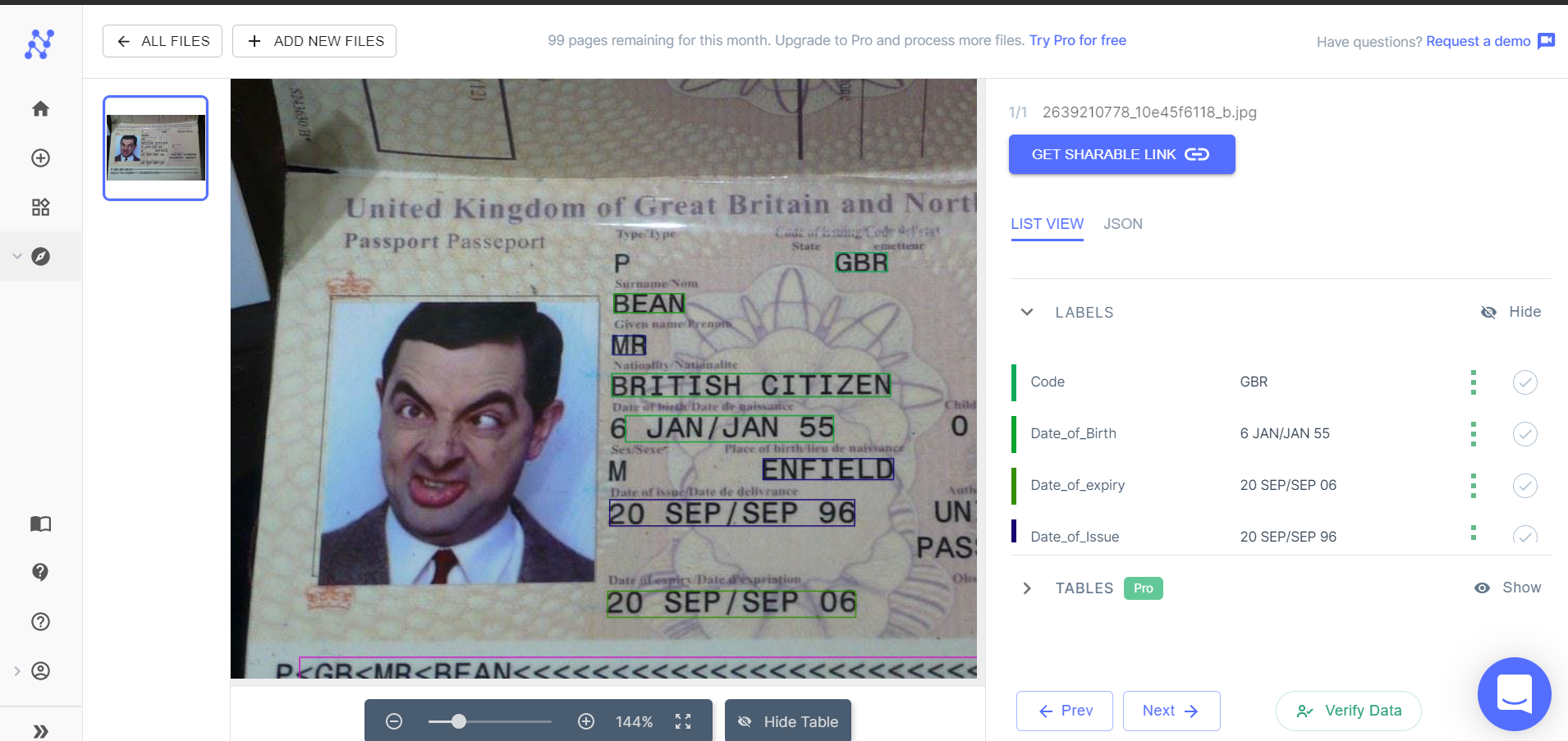

- Pas

Nanonetter online OCR & OCR API har mange interessante brug sager.

Trin 1: Vælg en passende OCR-model

Login til Nanonets og vælg en OCR-model, der passer til det billede, du vil udtrække tekst og data fra. Hvis ingen af de fortrænede OCR-modeller passer til dine krav, kan du springe videre for at finde ud af, hvordan du opretter en tilpasset OCR-model.

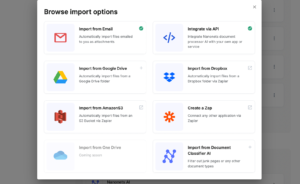

Trin 2: Tilføj filer

Tilføj de filer/billeder, som du vil udtrække tekst fra. Du kan tilføje så mange billeder, som du vil.

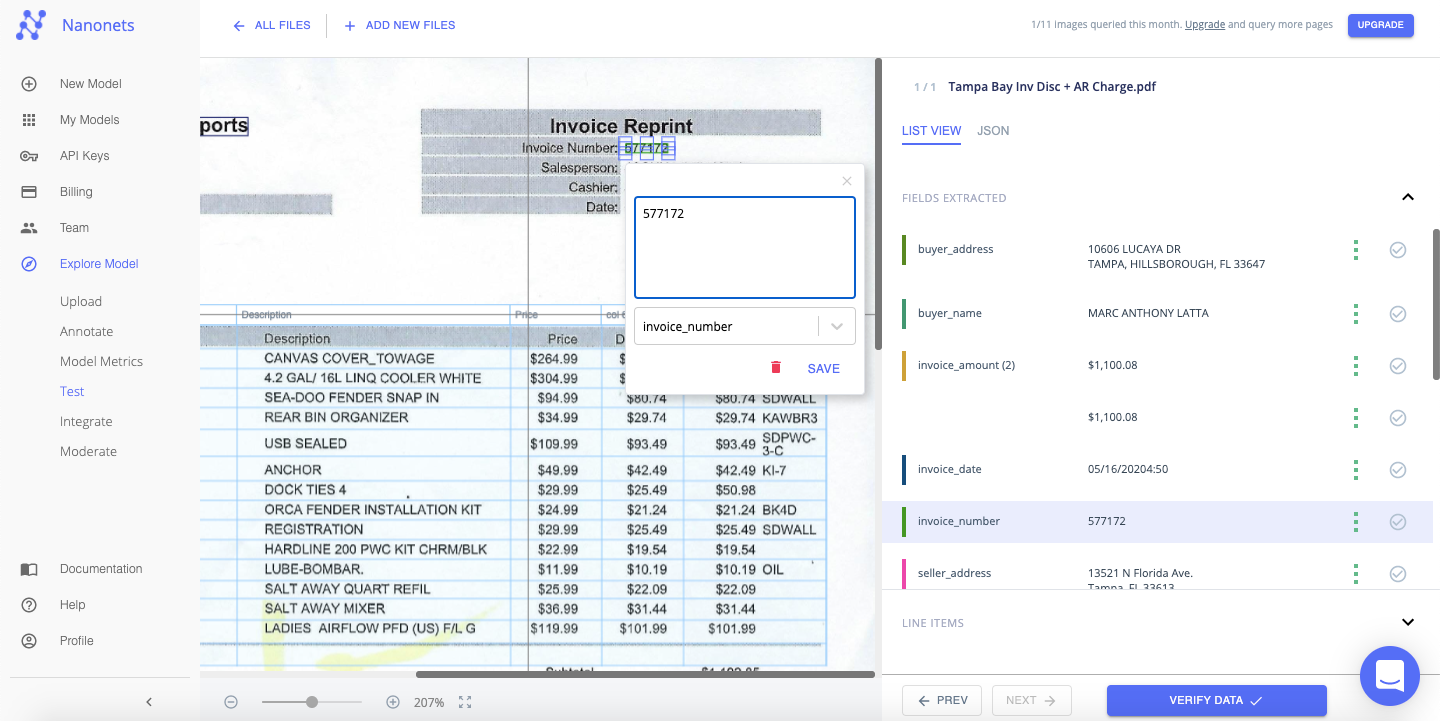

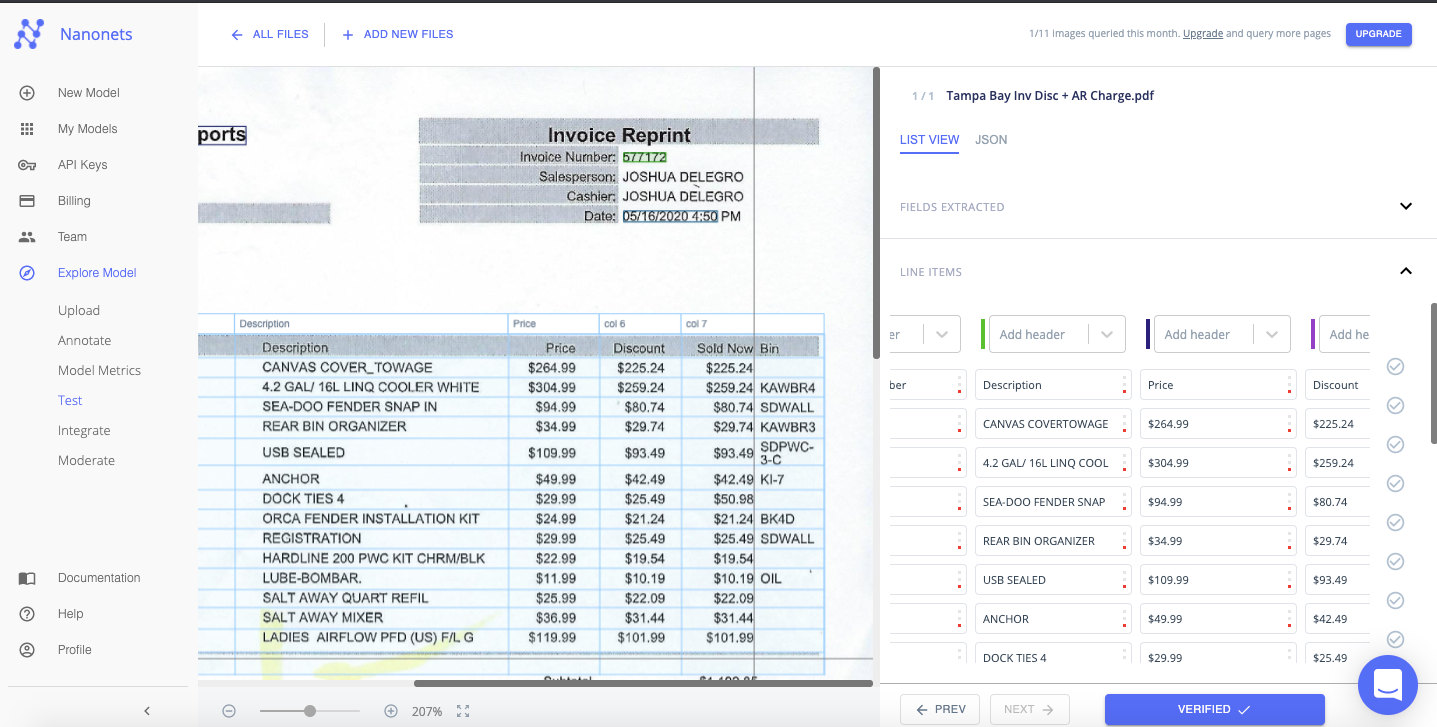

Trin 3: Test

Tillad et par sekunder for modellen at køre og udtrække tekst fra billedet.

Trin 4: Bekræft

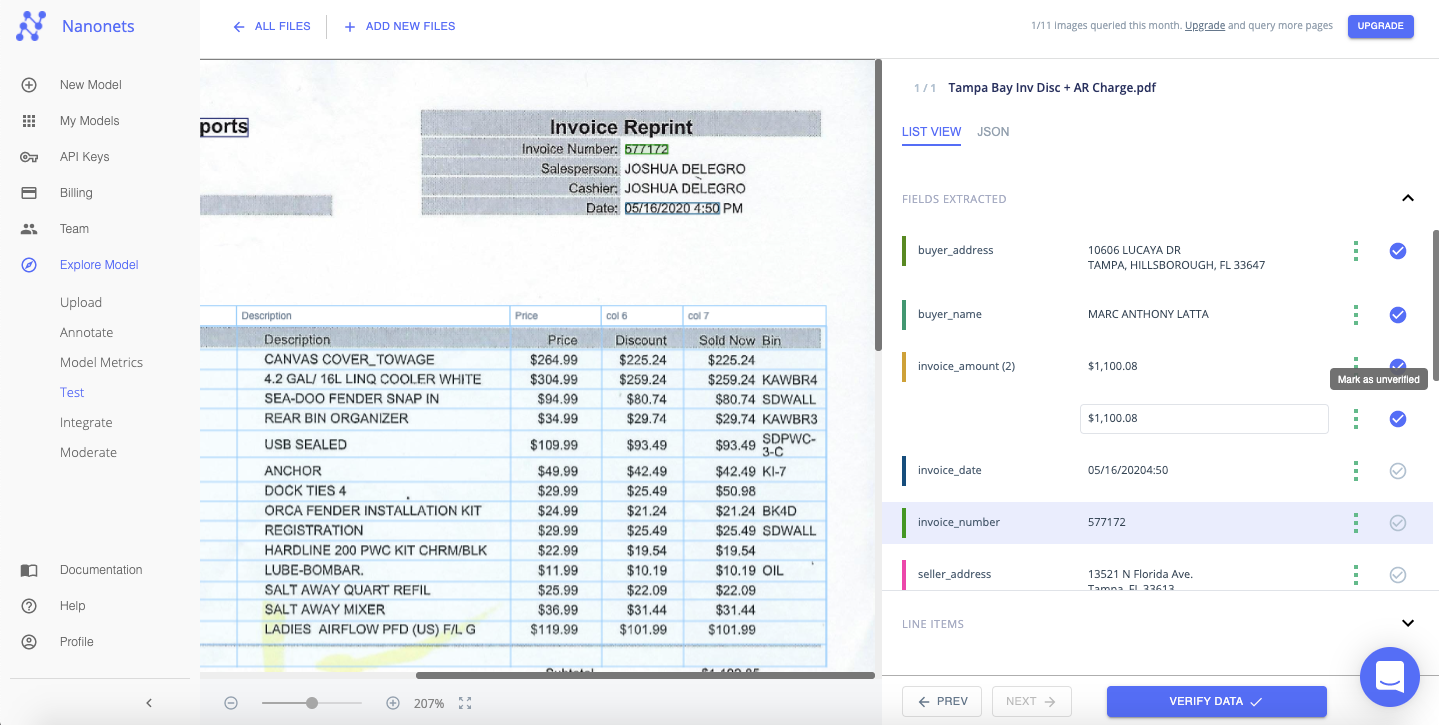

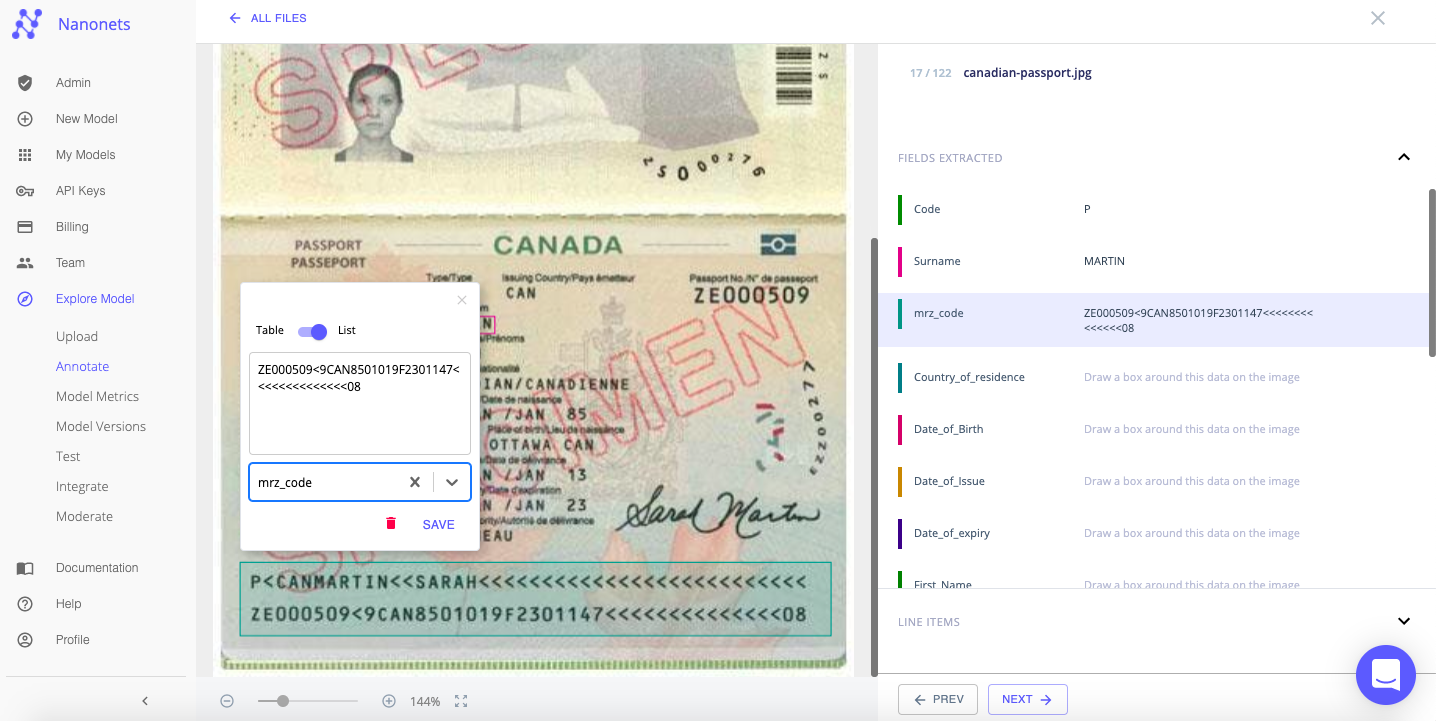

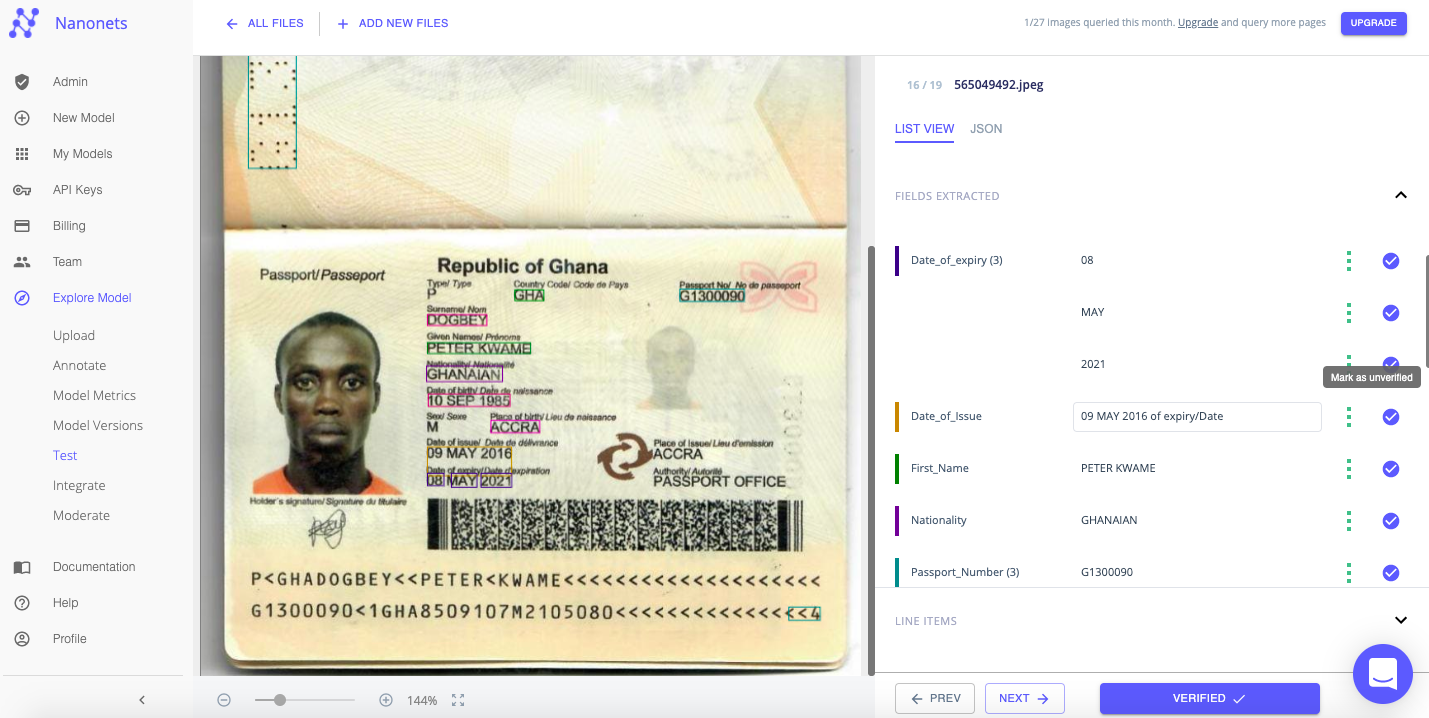

Bekræft hurtigt teksten udtrukket fra hver fil ved at kontrollere tabelvisningen til højre. Du kan nemt dobbelttjekke, om teksten er blevet korrekt genkendt og matchet med et passende felt eller tag.

Du kan endda vælge at redigere/korrigere feltværdierne og etiketterne på dette tidspunkt. Nanonetter er ikke bundet af billedets skabelon.

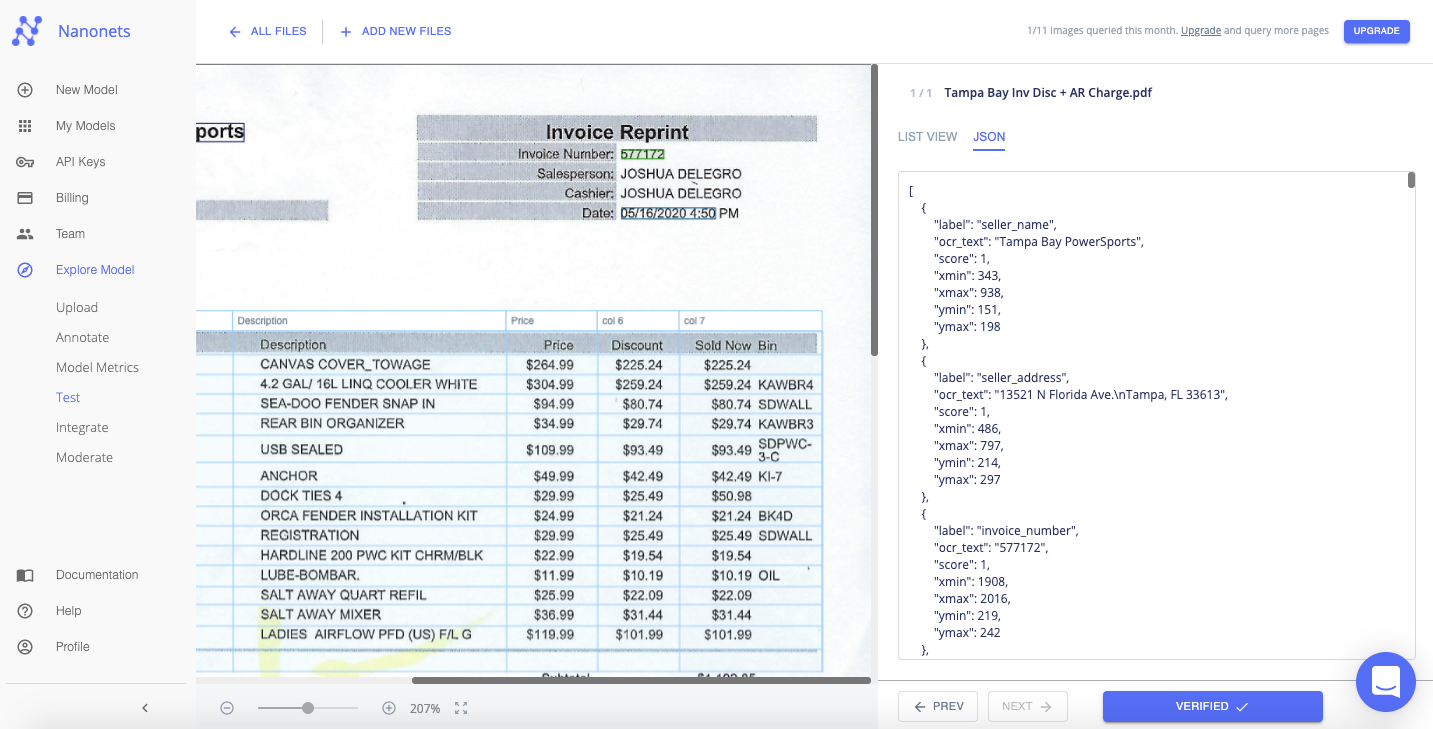

De udtrukne data kan vises i et "List View"- eller "JSON"-format.

Du kan markere afkrydsningsfeltet ud for hver værdi eller felt, du verificerer, eller klikke på "Bekræft data" for at fortsætte med det samme.

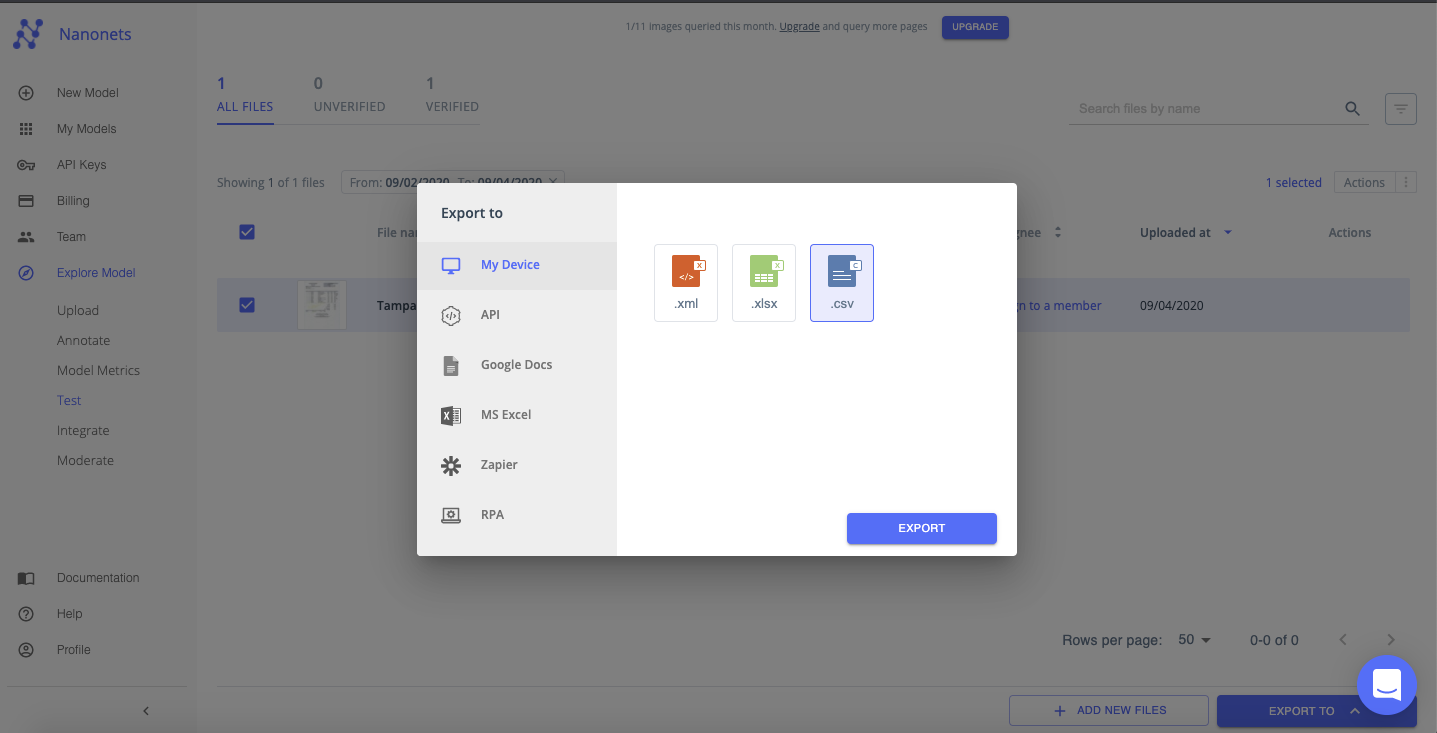

Trin 5: Eksporter

Når alle filerne er blevet bekræftet. Du kan eksportere de pænt organiserede data som en xml-, xlsx- eller csv-fil.

Nanonetter har interessant brug sager og unikke kunde succeshistorier. Find ud af, hvordan Nanonets kan styrke din virksomhed til at blive mere produktiv.

Det er nemt at bygge en tilpasset OCR-model med Nanonets. Du kan typisk bygge, træne og implementere en model for enhver billed- eller dokumenttype, på ethvert sprog, alt sammen på under 25 minutter (afhængigt af antallet af filer, der bruges til at træne modellen).

Se videoen nedenfor for at følge de første 4 trin i denne metode:

Trin 1: Opret din egen OCR-model

Login til Nanonets og klik på "Opret din egen OCR-model".

Trin 2: Upload træningsfiler/billeder

Upload eksempelfiler, der vil blive brugt til at træne OCR-modellerne. Nøjagtigheden af den OCR-model, du bygger, vil i høj grad afhænge af kvaliteten og mængden af de filer/billeder, der uploades på dette stadium

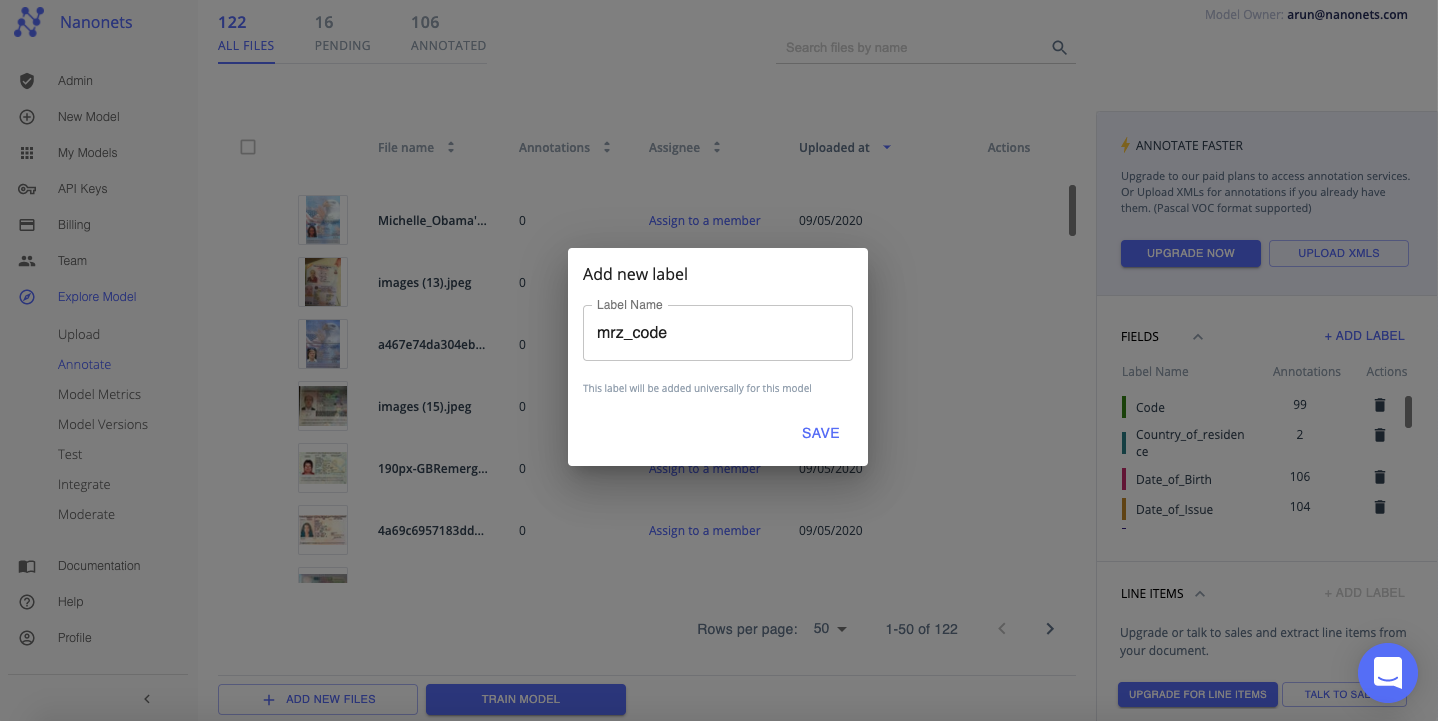

Trin 3: Anmærk tekst på filerne/billederne

Anmærk nu hvert stykke tekst eller data med et passende felt eller etiket. Dette afgørende trin vil lære din OCR-model at udtrække den passende tekst fra billeder og forbinde den med tilpassede felter, der er relevante for dine behov.

Du kan også tilføje en ny etiket for at kommentere teksten eller dataene. Husk, at Nanonets ikke er bundet af billedets skabelon!

Trin 4: Træn den tilpassede OCR-model

Når annoteringen er fuldført for alle træningsfilerne/billederne, skal du klikke på "Train Model". Træning tager normalt mellem 20 minutter-2 timer afhængigt af antallet af filer og modeller i kø til træning. Du kan opgradering til en betalt plan for at få hurtigere resultater på dette stadium (typisk under 20 minutter).

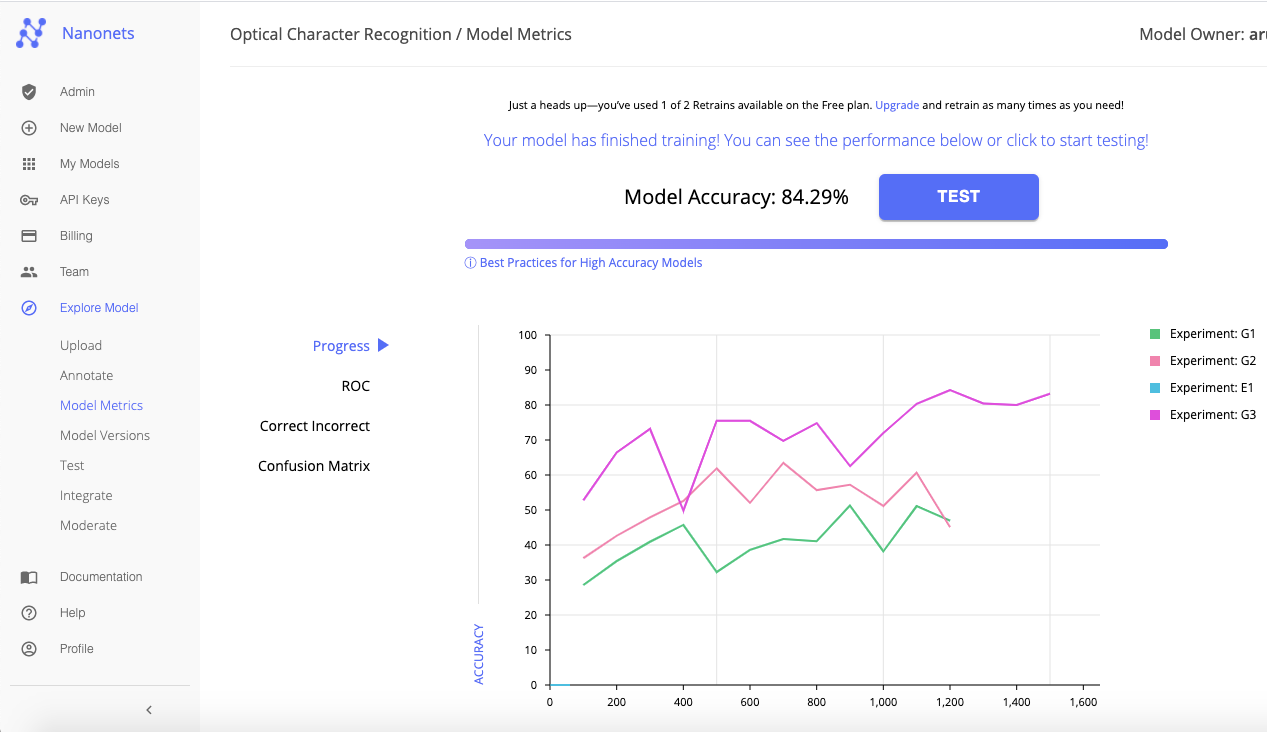

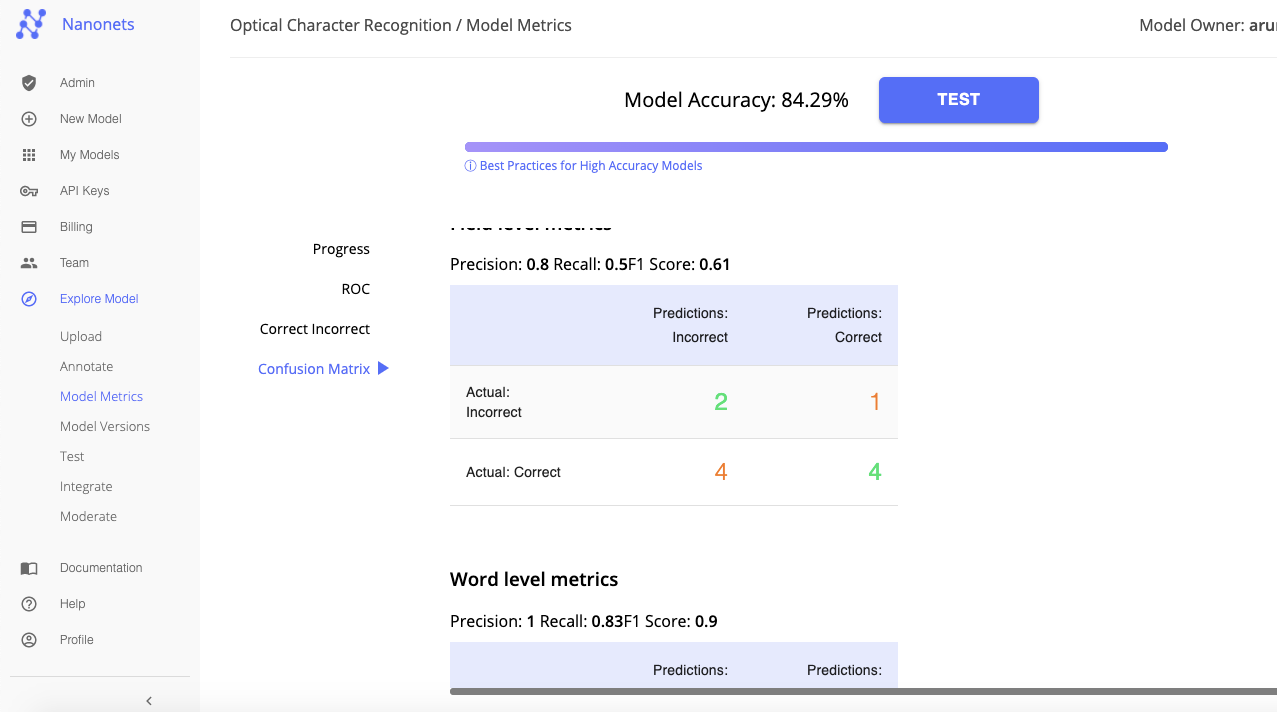

Nanonets udnytter dyb læring til at bygge forskellige OCR-modeller og tester dem mod hinanden for nøjagtighed. Nanonets udvælger derefter den bedste OCR-model (baseret på dine input og nøjagtighedsniveauer).

Fanen "Model Metrics" viser de forskellige målinger og sammenlignende analyser, der gjorde det muligt for Nanonets at vælge den bedste OCR-model blandt alle, der blev bygget. Du kan genoptræne modellen (ved at give et bredere udvalg af træningsbilleder og bedre annoteringer) for at opnå højere niveauer af nøjagtighed.

Eller, hvis du er tilfreds med nøjagtigheden, skal du klikke på "Test" for at teste og kontrollere, om denne brugerdefinerede OCR-model fungerer som forventet på en prøve af billeder eller filer, hvorfra tekst/data skal udtrækkes.

Trin 5: Test og bekræft data

Tilføj et par eksempelbilleder for at teste og verificere den brugerdefinerede OCR-model.

Hvis teksten er blevet genkendt, udtrukket og præsenteret korrekt, så eksporter filen. Som du kan se nedenfor, er de udtrukne data blevet organiseret og præsenteret i et pænt format.

Tillykke, du har nu bygget og trænet en tilpasset OCR-model til at udtrække tekst fra bestemte typer billeder!

Beskæftiger din virksomhed sig med tekstgenkendelse i digitale dokumenter, billeder eller PDF'er? Har du spekuleret på, hvordan man udtrækker tekst fra billeder nøjagtigt?

Træn dine egne OCR-modeller med NanoNets API

Her er en detaljeret vejledning til at træne dine egne OCR-modeller ved hjælp af Nanonets API. I dokumentation, finder du klar til at affyre kodeeksempler i Python, Shell, Ruby, Golang, Java og C#, samt detaljerede API-specifikationer for forskellige endepunkter.

Her er en trin-for-trin guide til træning af din egen model ved hjælp af Nanonets API:

Trin 1: Klon Repo

git clone https://github.com/NanoNets/nanonets-ocr-sample-python

cd nanonets-ocr-sample-python

sudo pip install requests

sudo pip install tqdmTrin 2: Få din gratis API-nøgle

Få din gratis API-nøgle fra https://app.nanonets.com/#/keys

Trin 3: Indstil API-nøglen som en miljøvariabel

export NANONETS_API_KEY=YOUR_API_KEY_GOES_HERE

Trin 4: Opret en ny model

python ./code/create-model.py

Bemærk: Dette genererer et MODEL_ID, som du skal bruge til det næste trin

Trin 5: Tilføj model-id som miljøvariabel

export NANONETS_MODEL_ID=YOUR_MODEL_ID

Trin 6: Upload træningsdataene

Saml billederne af objektet, du vil opdage. Når du har datasæt klar i mappen images (billedfiler), begynd at uploade datasættet.

python ./code/upload-training.py

Trin 7: Togmodel

Når billederne er blevet uploadet, skal du begynde at træne modellen

python ./code/train-model.py

Trin 8: Få modeltilstand

Modellen tager ~30 minutter at træne. Du får en e-mail, når modellen er uddannet. I mellemtiden tjekker du modellens tilstand

watch -n 100 python ./code/model-state.py

Trin 9: Lav forudsigelse

Når modellen er trænet. Du kan lave forudsigelser ved hjælp af modellen

python ./code/prediction.py PATH_TO_YOUR_IMAGE.jpgFordelene ved at bruge Nanonets frem for andre OCR API'er går ud over blot bedre nøjagtighed med hensyn til at udtrække tekst fra billeder. Her er 7 grunde til, hvorfor du bør overveje at bruge Nanonets OCR til tekstgenkendelse i stedet:

1. Arbejde med brugerdefinerede data

De fleste OCR-software er ret stive med hensyn til den type data, de kan arbejde med. Træning af en OCR-model til en use case kræver en stor grad af fleksibilitet med hensyn til dens krav og specifikationer; en OCR til fakturabehandling vil adskille sig meget fra en OCR til pas! Nanonetter er ikke bundet af sådanne stive begrænsninger. Nanonets bruger dine egne data til at træne OCR-modeller, der er bedst egnede til at imødekomme din virksomheds særlige behov.

2. Arbejde med ikke-engelsk eller flere sprog

Da Nanonets fokuserer på træning med brugerdefinerede data, er det unikt placeret til at bygge en enkelt OCR-model, der kunne udtrække tekst fra billeder på ethvert sprog eller flere sprog på samme tid.

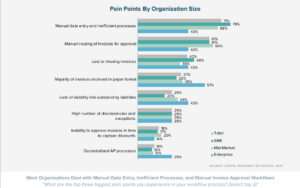

3. Kræver ingen efterbehandling

Tekst udtrukket ved hjælp af OCR-modeller skal være intelligent struktureret og præsenteret i et forståeligt format; ellers går der betydelig tid og ressourcer til at omorganisere dataene til meningsfuld information. Mens de fleste OCR-værktøjer blot fanger og dumper data fra billeder, udtrækker Nanonets kun de relevante data og sorterer dem automatisk i intelligent strukturerede felter, hvilket gør det nemmere at se og forstå.

4. Lærer løbende

Virksomheder står ofte over for dynamisk skiftende krav og behov. For at overvinde potentielle vejspærringer giver Nanonets dig mulighed for nemt at genoptræne dine modeller med nye data. Dette gør det muligt for din OCR-model at tilpasse sig uforudsete ændringer.

5. Håndterer almindelige databegrænsninger med lethed

Nanonets udnytter AI-, ML- og Deep Learning-teknikker til at overvinde almindelige databegrænsninger, der i høj grad påvirker tekstgenkendelse og udtræk. Nanonets OCR kan genkende og håndtere håndskrevet tekst, billeder af tekst på flere sprog på én gang, billeder med lav opløsning, billeder med nye eller kursive skrifttyper og varierende størrelser, billeder med skyggetekst, skrå tekst, tilfældig ustruktureret tekst, billedstøj, slørede billeder og mere. Traditionelle OCR API'er er bare ikke udstyret til at fungere under sådanne begrænsninger; de kræver data på et meget højt niveau af troskab, hvilket ikke er normen i virkelige scenarier.

6. Kræver ingen in-house team af udviklere

Ingen grund til at bekymre dig om at ansætte udviklere og anskaffe talent for at tilpasse Nanonets API til dine forretningskrav. Nanonets blev bygget til problemfri integration. Du kan også nemt integrere Nanonets med de fleste CRM-, ERP- eller RPA-software.

7. Tilpas, tilpasse, tilpasse

Du kan fange så mange felter med tekst/data, som du vil med Nanonets OCR. Du kan endda opbygge tilpassede valideringsregler, der fungerer til dine specifikke krav til tekstgenkendelse og tekstudtrækning. Nanonets er slet ikke bundet af skabelonen for dit dokument. Du kan fange data i tabeller eller linjeposter eller et hvilket som helst andet format!

Nanonets har mange use cases, der kan optimere din virksomheds ydeevne, spare omkostninger og øge væksten. Finde ud af hvordan Nanonets' use cases kan gælde for dit produkt.

Eller tjek ud Nanonetter OCR API i aktion og begynde at bygge skik OCR modeller gratis!

Opdatering juli 2022: dette indlæg blev oprindeligt offentliggjort i Oktober 2020 og er siden blevet opdateret regelmæssigt.

Her er en dias opsummerer resultaterne i denne artikel. Her er en alternativ version af dette indlæg.

- AI

- AI og maskinindlæring

- ai kunst

- ai kunst generator

- en robot

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- OCR

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- Tekstgenkendelse

- zephyrnet