Kinas Institut for Højenergifysik (IHEP) i Beijing er banebrydende med innovative tilgange inden for kvanteberegning og kvantemaskinelæring for at åbne op for nye forskningsveje inden for sit partikelfysikprogram, som Hideki Okawa, Weidong Li , Jun Cao forklare

Instituttet for højenergifysik (IHEP), som er en del af det kinesiske videnskabsakademi, er det største grundlæggende videnskabelige laboratorium i Kina. Det er vært for et tværfagligt forskningsprogram, der spænder over elementær partikelfysik, astrofysik samt planlægning, design og konstruktion af storskala acceleratorprojekter - herunder China Spallation Neutron Source, som blev lanceret i 2018, og High Energy Photon Source, der skal komme online i 2025.

Mens investeringer i IHEPs eksperimentelle infrastruktur er steget dramatisk i løbet af de sidste 20 år, er udviklingen og anvendelsen af kvantemaskinelæring og kvantecomputerteknologier nu klar til at give tilsvarende vidtrækkende resultater inden for IHEP-forskningsprogrammet.

Stor videnskab, kvanteløsninger

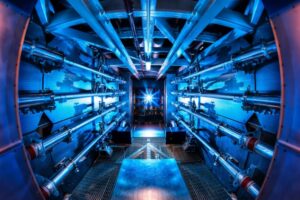

Højenergifysik er hvor "big science" møder "big data". At opdage nye partikler og undersøge de grundlæggende naturlove er bestræbelser, der producerer utrolige mængder af data. Large Hadron Collider (LHC) ved CERN genererer petabytes (1015 bytes) af data under dets eksperimentelle kørsler – som alle skal behandles og analyseres ved hjælp af grid computing, en distribueret infrastruktur, der netværker computerressourcer over hele verden.

På denne måde giver Worldwide LHC Computing Grid et fællesskab af tusindvis af fysikere næsten-realtidsadgang til LHC-data. Det sofistikerede computernet var grundlæggende for den skelsættende opdagelse af Higgs-bosonen ved CERN i 2012 såvel som utallige andre fremskridt for yderligere at undersøge standardmodellen for partikelfysik.

Et andet omdrejningspunkt truer dog, når det kommer til lagring, analyse og mining af big data i højenergifysik. High-Luminosity Large Hadron Collider (HL-LHC), som forventes at træde i drift i 2029, vil skabe et "computing crunch" som maskinens integrerede lysstyrke, proportionalt med antallet af partikelkollisioner, der forekommer i en given tidsperiode , vil stige med en faktor 10 i forhold til LHC's designværdi – og det samme vil de datastrømme, der genereres af HL-LHC-eksperimenterne.

CERN QTI: udnytter stor videnskab til at accelerere kvanteinnovation

På kort sigt vil der være behov for en ny "computing baseline" for at klare HL-LHC's skyhøje datakrav - en baseline, der vil kræve udnyttelse af grafikbehandlingsenheder i stor skala til massiv parallel simulering, dataregistrering og genbehandling. , samt klassiske anvendelser af maskinlæring. CERN har på sin side også etableret en mellem- og langsigtet køreplan, der samler højenergifysik- og kvanteteknologisamfundene via CERN Quantum Technology Initiative (QTI) – en erkendelse af, at endnu et spring i computerydelse er ved at komme til syne med anvendelse af kvantecomputere og kvantenetværksteknologier.

Tilbage til quantum basics

Kvantecomputere, som navnet antyder, udnytter kvantemekanikkens grundlæggende principper. I lighed med klassiske computere, som er afhængige af de binære bit, der tager værdien af enten 0 eller 1, udnytter kvantecomputere binære kvantebit, men som en superposition af 0- og 1-tilstande. Denne superposition, kombineret med kvantesammenfiltring (korrelationer mellem kvantebits), gør i princippet kvantecomputere i stand til at udføre nogle typer beregninger væsentligt hurtigere end klassiske maskiner - for eksempel kvantesimuleringer anvendt inden for forskellige områder af kvantekemi og molekylær reaktionskinetik.

Mens mulighederne for videnskab og den bredere økonomi synes overbevisende, er en af de store ingeniørmæssige hovedpine forbundet med tidlige stadier af kvantecomputere deres sårbarhed over for miljøstøj. Qubits forstyrres alt for let, for eksempel af deres interaktioner med Jordens magnetfelt eller omstrejfende elektromagnetiske felter fra mobiltelefoner og WiFi-netværk. Interaktioner med kosmiske stråler kan også være problematiske, ligesom interferens mellem tilstødende qubits kan.

Den ideelle løsning - en strategi kaldet fejlkorrektion - involverer lagring af den samme information på tværs af flere qubits, således at fejl vil blive opdaget og rettet, når en eller flere af qubits påvirkes af støj. Problemet med disse såkaldte fejltolerante kvantecomputere er deres behov for et stort antal qubits (i størrelsesordenen millioner) – noget, der er umuligt at implementere i den nuværende generations småskala kvantearkitekturer.

I stedet kan designerne af nutidens Noisy Intermediate-Scale Quantum (NISQ) computere enten acceptere støjeffekterne, som de er, eller delvist gendanne fejlene algoritmisk – altså uden at øge antallet af qubits – i en proces kendt som fejlreduktion. Adskillige algoritmer er kendt for at give modstandsdygtighed mod støj i små kvantecomputere, således at "kvantefordele" kan observeres i specifikke højenergifysikapplikationer på trods af de iboende begrænsninger af nuværende generations kvantecomputere.

En sådan undersøgelseslinje hos IHEP fokuserer på kvantesimulering og anvender ideer, der oprindeligt blev fremsat af Richard Feynman omkring brugen af kvanteanordninger til at simulere tidsudviklingen af kvantesystemer - for eksempel i gitterkvantekromodynamik (QCD). Standardmodellen beskriver i sammenhæng alle de grundlæggende vekselvirkninger mellem elementarpartiklerne bortset fra tyngdekraften – dvs. at binde de elektromagnetiske, svage og stærke kræfter sammen. På denne måde omfatter modellen to sæt såkaldte kvantemålefeltteorier: Glashow-Weinberg-Salam-modellen (der giver en samlet beskrivelse af de elektromagnetiske og svage kræfter) og QCD (for de stærke kræfter).

Det er generelt sådan, at kvantemålefeltteorierne ikke kan løses analytisk, med de fleste forudsigelser for eksperimenter, der er afledt af tilnærmelsesmetoder til kontinuerlig forbedring (også kendt som perturbation). Lige nu arbejder IHEP-medarbejdere på direkte at simulere målefelter med kvantekredsløb under forenklede forhold (for eksempel i reducerede rum-tidsdimensioner eller ved at bruge endelige grupper eller andre algebraiske metoder). Sådanne tilgange er kompatible med nuværende iterationer af NISQ-computere og repræsenterer grundlæggende arbejde for en mere komplet implementering af gitter-QCD i den nærmeste fremtid.

QuIHEP kvantesimulatoren

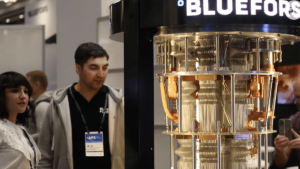

Som en forlængelse af sit ambitiøse kvante-F&U-program har IHEP etableret QuIHEP, en kvantecomputersimulatorplatform, der gør det muligt for forskere og studerende at udvikle og optimere kvantealgoritmer til forskningsstudier i højenergifysik.

For klarhedens skyld er kvantesimulatorer klassiske computerrammer, der forsøger at efterligne eller "simulere" kvantecomputeres opførsel. Kvantesimulering, på den anden side, anvender faktisk kvantecomputerhardware til at simulere tidsudviklingen af et kvantesystem – f.eks. gitter QCD-studierne på IHEP (se hovedteksten).

Som sådan tilbyder QuIHEP et brugervenligt og interaktivt udviklingsmiljø, der udnytter eksisterende højtydende computerklynger til at simulere op til omkring 40 qubits. Platformen giver en komponistgrænseflade til uddannelse og introduktion (der demonstrerer for eksempel, hvordan kvantekredsløb er opbygget visuelt). Udviklingsmiljøet er baseret på Jupyter open source-software og kombineret med et IHEP-brugergodkendelsessystem.

På kort sigt vil QuIHEP koble sig op med distribuerede kvantecomputerressourcer på tværs af Kina for at etablere en harmoniseret forskningsinfrastruktur. Målet: at støtte industri-akademisk samarbejde og uddannelse og træning i kvantevidenskab og ingeniørvidenskab.

Maskinlæring: kvantevejen

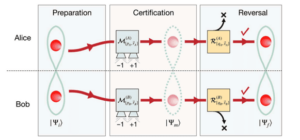

Et andet kvanteforskningstema på IHEP involverer kvantemaskinelæring, som kan grupperes i fire forskellige tilgange: CC, CQ, QC, QQ (med C - klassisk; Q - kvante). I hvert tilfælde svarer det første bogstav til datatypen og det sidste til typen af computeren, der kører algoritmen. CC-skemaet udnytter for eksempel fuldt ud klassiske data og klassiske computere, selvom det kører kvanteinspirerede algoritmer.

Den mest lovende use-case, der forfølges på IHEP, involverer imidlertid CQ-kategorien maskinlæring, hvor den klassiske datatype kortlægges og trænes i kvantecomputere. Motivationen her er, at ved at udnytte kvantemekanikkens grundlæggende principper – det store Hilbert-rum, superposition og sammenfiltring – vil kvantecomputere være i stand til at lære mere effektivt fra store datasæt for at optimere de resulterende maskinlæringsmetoder.

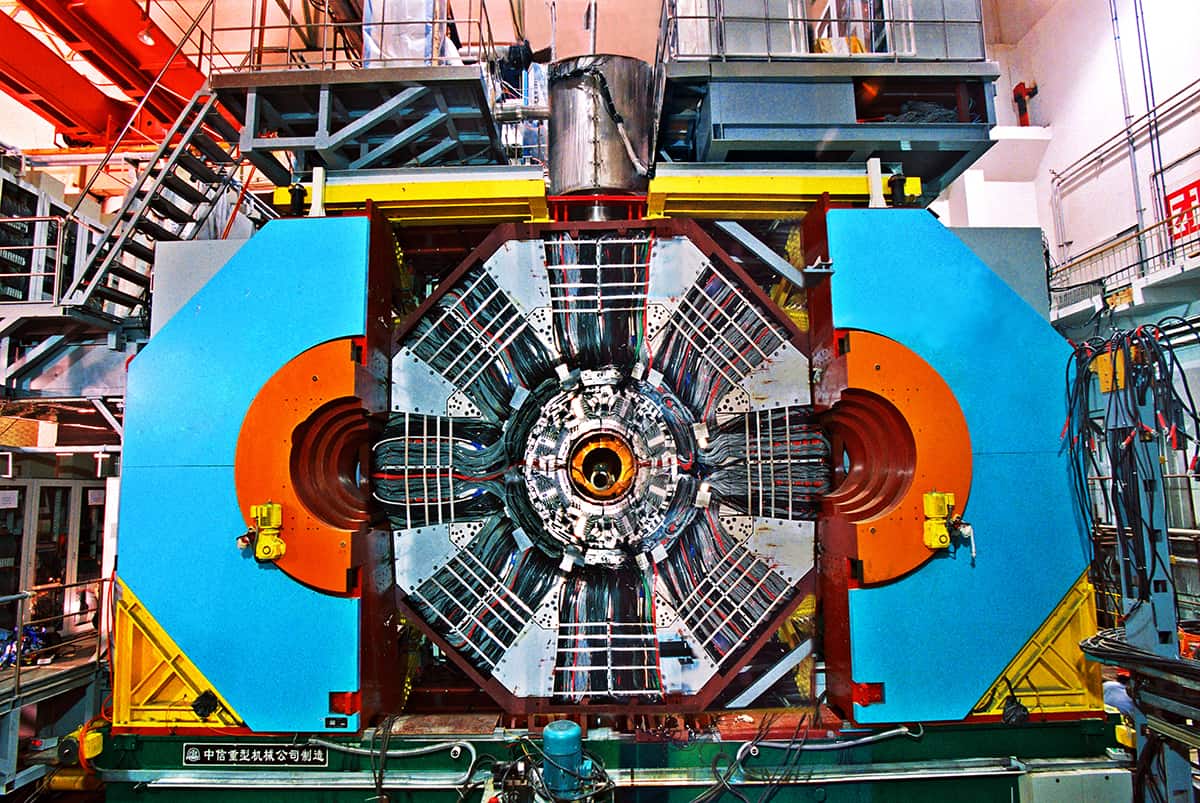

For at forstå potentialet for kvantefordele arbejder IHEP-forskere i øjeblikket på at "genopdage" den eksotiske partikel Zc(3900) ved hjælp af kvantemaskinelæring. Med hensyn til baghistorien: Zc(3900) er en eksotisk subatomær partikel, der består af kvarker (byggestenene i protoner og neutroner) og menes at være den første tetraquark-tilstand, der er observeret eksperimentelt - en observation, der i processen uddybede vores forståelse af QCD. Partiklen blev opdaget i 2013 af Beijing Spectrometer (BESIII) detektor ved Beijing Electron-Positron Collider (BEPCII), med uafhængig observation af Belle-eksperimentet ved Japans KEK partikelfysiklaboratorium.

QUANT-NETs testbed-innovationer: genskabelse af kvantenetværket

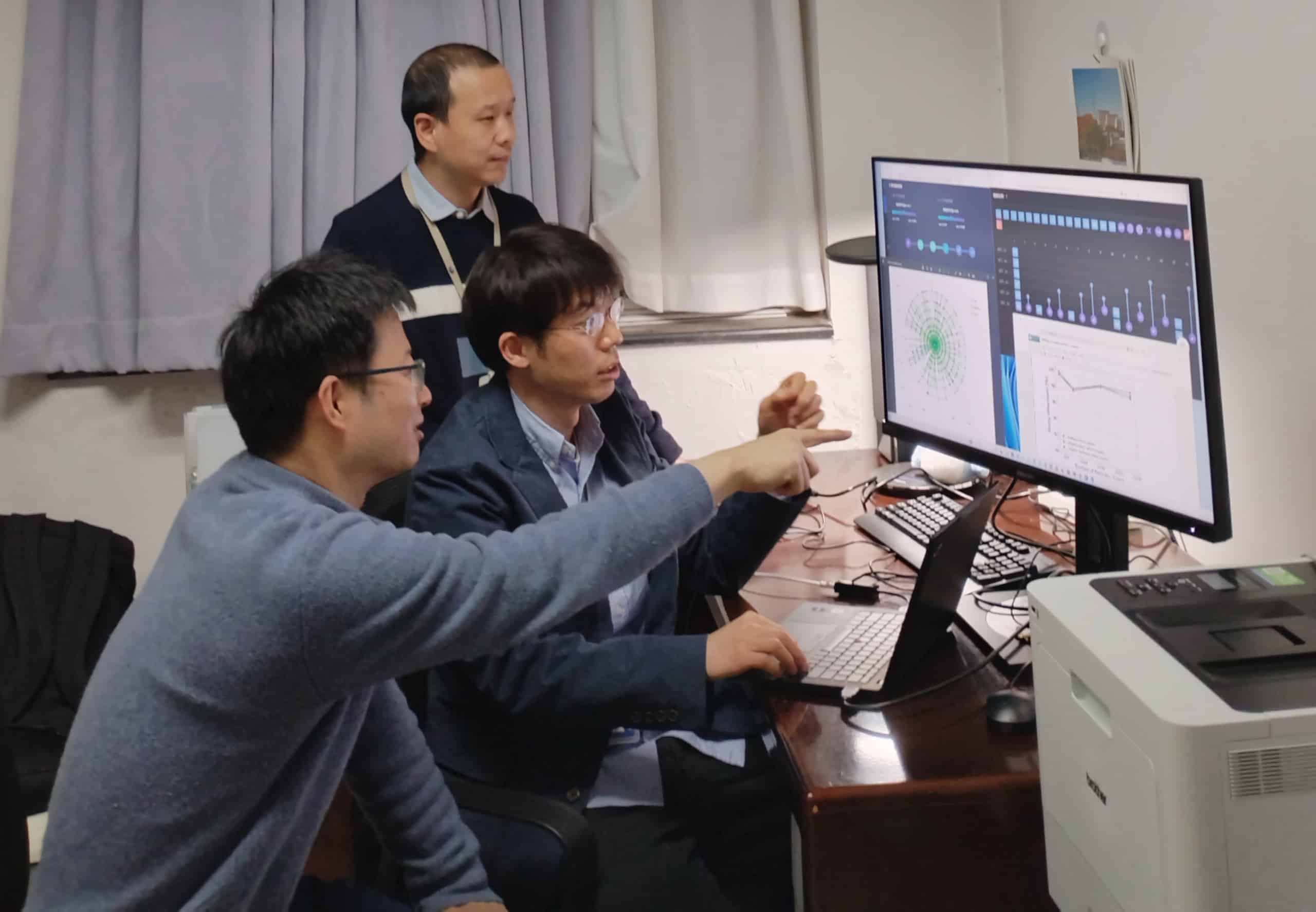

Som en del af denne R&D-undersøgelse implementerede et team ledet af IHEP's Jiaheng Zou, og inklusive kolleger fra Shandong University og University of Jinan, den såkaldte Quantum Support Vector Machine-algoritme (en kvantevariant af en klassisk algoritme) til træningen med simulerede signaler af Zc(3900) og tilfældigt udvalgte hændelser fra de rigtige BESIII-data som baggrunde.

Ved at bruge kvantemaskinelæringstilgangen er ydeevnen konkurrencedygtig i forhold til klassiske maskinlæringssystemer – dog afgørende med et mindre træningsdatasæt og færre datafunktioner. Undersøgelser er i gang for at demonstrere øget signalfølsomhed med kvanteberegning, arbejde, der i sidste ende kan pege på opdagelsen af nye eksotiske partikler i fremtidige eksperimenter.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://physicsworld.com/a/ihep-seeks-quantum-opportunities-to-fast-track-fundamental-science/

- :har

- :er

- :hvor

- $OP

- 1

- 10

- 120

- 20

- 20 år

- 2012

- 2013

- 2018

- 2025

- 40

- 7

- a

- I stand

- Om

- over

- Academy

- fremskynde

- accelerator

- acceleratorer

- Acceptere

- adgang

- tværs

- faktiske

- fremskridt

- Fordel

- mod

- algoritme

- algoritmisk

- algoritmer

- Alle

- sammen

- også

- ambitiøst

- blandt

- beløb

- an

- analyse

- ,

- En anden

- Forventet

- fra hinanden

- vises

- Anvendelse

- applikationer

- anvendt

- Anvendelse

- tilgang

- tilgange

- arkitekturer

- ER

- områder

- omkring

- AS

- forbundet

- At

- Godkendelse

- baggrunde

- baseret

- Baseline

- grundlæggende

- BE

- adfærd

- Beijing

- være

- Tro

- troede

- mellem

- Big

- Big data

- bits

- Blocks

- bosonen

- Bringer

- Bygning

- men

- by

- beregning

- kaldet

- CAN

- kan ikke

- tilfælde

- Boligtype

- kemi

- Kina

- kinesisk

- klarhed

- klik

- Cluster

- samarbejde

- kolleger

- kombineret

- Kom

- kommer

- kommer

- Fællesskaber

- samfund

- kompakt

- kompatibel

- overbevisende

- konkurrencedygtig

- fuldføre

- Komponere

- omfatter

- computer

- computere

- computing

- betingelser

- konstrueret

- opbygge

- sammenhæng

- korrigeret

- korrelationer

- svarer

- Kosmiske stråler

- kunne

- koblede

- skabe

- afgørende

- Nuværende

- For øjeblikket

- data

- datasæt

- krav

- demonstrere

- demonstrerer

- indsat

- Afledt

- beskriver

- beskrivelse

- Design

- designere

- Trods

- opdaget

- udvikle

- Udvikling

- Enheder

- størrelse

- direkte

- opdaget

- opdage

- opdagelse

- distinkt

- distribueret

- dramatisk

- grund

- i løbet af

- e

- hver

- tidlig stadie

- økonomi

- Uddannelse

- effektivt

- effekter

- enten

- muliggør

- bestræbelser

- energi

- Engineering

- forbedret

- sammenfiltring

- Indtast

- Miljø

- miljømæssige

- fejl

- fejl

- etablere

- etableret

- evaluere

- begivenheder

- evolution

- eksempel

- eksisterende

- Exotic

- eksperiment

- eksperimenterende

- eksperimenter

- Exploit

- udnyttelse

- udnytte

- exploits

- udvidelse

- faktor

- vidtrækkende

- hurtigere

- Funktionalitet

- færre

- felt

- Fields

- Fornavn

- fokuserer

- Til

- Tving

- Forces

- Videresend

- grundlæggende

- fire

- rammer

- fra

- fuldt ud

- fundamental

- Fundamentals

- yderligere

- fremtiden

- Målestok

- generelle formål

- generelt

- genereret

- genererer

- given

- giver

- mål

- grafik

- gravitationel

- Grid

- Gruppens

- hånd

- Hardware

- udnyttelse

- hovedpine

- hjælpe

- link.

- Høj

- Høj ydeevne

- værter

- Hvordan

- Men

- HTTPS

- Huang

- i

- ideal

- ideer

- billede

- påvirket

- gennemføre

- implementering

- umuligt

- in

- Herunder

- Forøg

- stigende

- utrolige

- uafhængig

- bøjning

- Bøjningspunkt

- oplysninger

- Infrastruktur

- iboende

- initiativ

- innovationer

- innovativ

- Institut

- integreret

- interaktioner

- interaktiv

- grænseflade

- Interferens

- ind

- Introduktion

- undersøge

- Undersøgelser

- investering

- involverer

- spørgsmål

- IT

- iterationer

- ITS

- Japans

- jpg

- kendt

- laboratorium

- vartegn

- stor

- storstilet

- største

- lanceret

- Love

- Leap

- LÆR

- læring

- Led

- til venstre

- brev

- ligesom

- begrænsninger

- Line (linje)

- LINK

- langsigtet

- truende

- maskine

- machine learning

- Maskiner

- lavet

- Magnetfelt

- Main

- massivt

- max-bredde

- Kan..

- mekanik

- opfylder

- metoder

- metoder

- millioner

- Mining

- afbødning

- Mobil

- mobiltelefoner

- model

- molekylær

- mere

- mest

- Motivation

- tværfaglig

- flere

- skal

- navn

- Natur

- I nærheden af

- behov

- netværk

- net

- neutroner

- Ny

- næste generation

- Støj

- nu

- nummer

- observation

- forekomme

- of

- Tilbud

- on

- ONE

- igangværende

- online

- åbent

- open source

- Open source software

- drift

- Muligheder

- Optimer

- or

- oprindelse

- oprindeligt

- Andet

- vores

- udfald

- i løbet af

- Parallel

- del

- forbi

- pathways

- Udfør

- ydeevne

- telefoner

- Fysik

- Fysik verden

- Banebrydende

- planlægning

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- klar

- potentiale

- Praktisk

- Forudsigelser

- princippet

- principper

- Problem

- problematisk

- behandle

- Behandlet

- forarbejdning

- producere

- program

- projekter

- lovende

- protoner

- giver

- leverer

- sætte

- Quantum

- kvantefordel

- kvantealgoritmer

- kvantecomputere

- quantum computing

- kvanteforvikling

- kvantemaskineindlæring

- Kvantemekanik

- kvante netværk

- kvanteforskning

- kvantesystemer

- kvante teknologi

- kvarker

- qubits

- F & U

- reaktion

- ægte

- anerkendelse

- optagelse

- Recover

- region

- forestille sig igen

- stole

- repræsentere

- kræver

- krav

- forskning

- forskere

- modstandskraft

- Ressourcer

- resulterende

- Richard

- højre

- køreplan

- løber

- s

- samme

- Ordningen

- Videnskab

- VIDENSKABER

- forskere

- se

- søger

- valgt

- Følsomhed

- sæt

- flere

- vist

- Signal

- signaler

- betydeligt

- lignende

- Tilsvarende

- forenklet

- simulere

- simulation

- simuleringer

- simulator

- mindre

- skyhøje

- Software

- løsninger

- nogle

- noget

- sofistikeret

- Kilde

- Space

- spænding

- specifikke

- Personale

- standard

- stående

- Tilstand

- Stater

- opbevaring

- lagring

- Strategi

- strømline

- vandløb

- stærk

- Studerende

- undersøgelser

- Studere

- sådan

- superposition

- support

- Støtte

- systemet

- Systemer

- Tag

- hold

- Teknologier

- Teknologier

- semester

- vilkår

- tekst

- end

- at

- deres

- tema

- Disse

- de

- denne

- selvom?

- tusinder

- thumbnail

- tid

- til

- nutidens

- sammen

- spor

- spor

- uddannet

- Kurser

- sand

- prøv

- to

- typen

- typer

- Ultimativt

- under

- forstå

- forståelse

- forenet

- enheder

- universitet

- brug

- Bruger

- brugervenlig

- ved brug af

- udnytter

- Ved hjælp af

- værdi

- Variant

- forskellige

- versus

- via

- Specifikation

- visuelt

- mængder

- sårbarhed

- var

- Vej..

- svag

- GODT

- hvornår

- som

- bredere

- wifi

- vilje

- med

- inden for

- uden

- Arbejde

- arbejder

- world

- verdensplan

- år

- Udbytte

- zephyrnet