Amazon SageMaker JumpStart er Machine Learning (ML)-hubben i SageMaker, der leverer forudtrænede, offentligt tilgængelige modeller til en lang række problemtyper for at hjælpe dig med at komme i gang med maskinlæring.

JumpStart tilbyder også eksempler på notesbøger, der bruger Amazon SageMaker funktioner som spot-instanstræning og eksperimenter over en lang række modeltyper og use cases. Disse eksempler på notesbøger indeholder kode, der viser, hvordan man anvender ML-løsninger ved at bruge SageMaker og JumpStart. De kan tilpasses til dine egne behov og kan dermed fremskynde applikationsudviklingen.

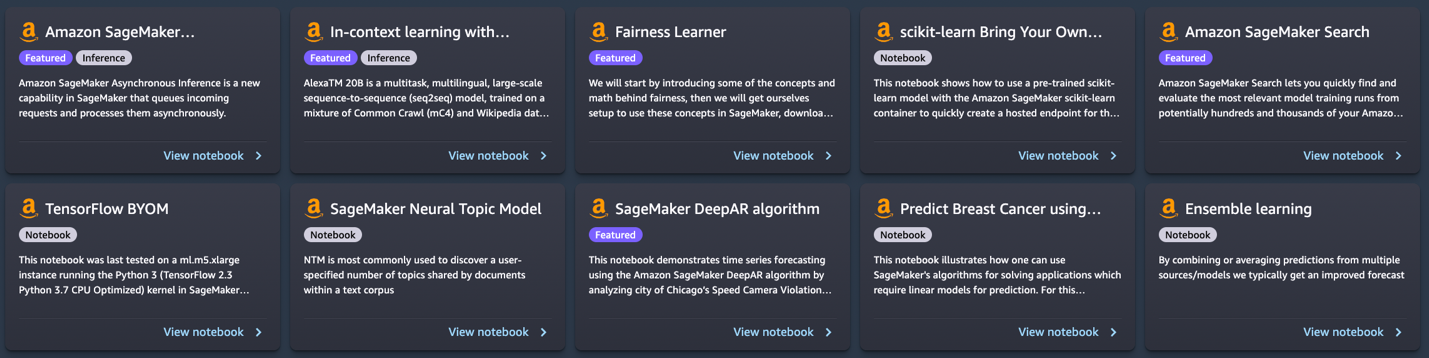

For nylig har vi tilføjet 10 nye notesbøger til JumpStart in Amazon SageMaker Studio. Dette indlæg fokuserer på disse nye notesbøger. Mens dette skrives, tilbyder JumpStart 56 notesbøger, lige fra at bruge state-of-the-art NLP-modeller (natural language processing) til at fikse skævheder i datasæt, når man træner modeller.

De 10 nye notesbøger kan hjælpe dig på følgende måder:

- De tilbyder eksempelkode, som du kan køre som den er fra JumpStart UI i Studio og se, hvordan koden fungerer

- De viser brugen af forskellige SageMaker og JumpStart API'er

- De tilbyder en teknisk løsning, som du kan tilpasse yderligere ud fra dine egne behov

Antallet af notebooks, der tilbydes gennem JumpStart, stiger med jævne mellemrum, efterhånden som flere notebooks tilføjes. Disse notesbøger er også tilgængelige på github.

Notebooks oversigt

De 10 nye notesbøger er som følger:

- Indlæring i kontekst med AlexaTM 20B – Demonstrerer, hvordan man bruger AlexaTM 20B til kontekstindlæring med nul-skuds- og få-skuds-læring på fem eksempelopgaver: tekstresumé, generering af naturligt sprog, maskinoversættelse, ekstraktiv besvarelse af spørgsmål og naturlig sprogslutning og klassificering.

- Fairness lineær elev i SageMaker – Der har for nylig været bekymringer om bias i ML-algoritmer som følge af efterligning af eksisterende menneskelige fordomme. Denne notesbog anvender fairness-koncepter for at justere modelforudsigelser på passende vis.

- Administrer ML-eksperimenter ved hjælp af SageMaker Search – Amazon SageMaker Search lader dig hurtigt finde og evaluere de mest relevante modeluddannelsesforløb fra potentielt hundreder og tusinder af SageMaker modeloplæringsjob.

- SageMaker neural emnemodel – SageMaker Neural Topic Model (NTM) er en uovervåget læringsalgoritme, der forsøger at beskrive et sæt observationer som en blanding af forskellige kategorier.

- Forudsig overtrædelser af kørehastigheden – SageMaker DeepAR-algoritmen kan bruges til at træne en model til flere gader samtidigt og forudsige overtrædelser for flere gadekameraer.

- Forudsigelse af brystkræft – Denne notesbog bruger UCI's diagnostiske datasæt for brystkræft til at bygge en forudsigelig model af, om et brystmassebillede indikerer en godartet eller ondartet tumor.

- Ensemble forudsigelser fra flere modeller – Ved at kombinere eller tage et gennemsnit af forudsigelser fra flere kilder og modeller får vi typisk en forbedret prognose. Denne notesbog illustrerer dette koncept.

- SageMaker asynkron inferens – Asynkron inferens er en ny inferensmulighed til inferensbehov næsten i realtid. Forespørgsler kan tage op til 15 minutter at behandle og har en nyttelaststørrelse på op til 1 GB.

- TensorFlow medbring din egen model – Lær, hvordan du træner en TensorFlow-model lokalt og implementerer på SageMaker ved hjælp af denne notesbog.

- Scikit-learn medbring din egen model - Denne notesbog viser, hvordan man bruger en forudtrænet Scikit-learn-model med SageMaker Scikit-learn-beholderen til hurtigt at oprette et hostet slutpunkt for den model.

Forudsætninger

For at bruge disse notesbøger skal du sørge for, at du har adgang til Studio med en udførelsesrolle, der giver dig mulighed for at køre SageMaker-funktionalitet. Den korte video nedenfor hjælper dig med at navigere til JumpStart-notesbøger.

I de følgende afsnit gennemgår vi hver af de 10 nye løsninger og diskuterer nogle af deres interessante detaljer.

Indlæring i kontekst med AlexaTM 20B

AlexaTM 20B er en multitask, flersproget, storstilet sekvens-til-sekvens (seq2seq) model, trænet på en blanding af Common Crawl (mC4) og Wikipedia-data på tværs af 12 sprog, ved hjælp af denoising og Causal Language Modeling (CLM) opgaver. Den opnår avanceret ydeevne på almindelige sprogopgaver i kontekst, såsom one-shot opsummering og one-shot maskinoversættelse, og overgår dekodermodeller, såsom Open AI's GPT3 og Googles PaLM, som er over otte gange større.

In-context learning, også kendt som hvilket fik, henviser til en metode, hvor man bruger en NLP-model på en ny opgave uden at skulle finjustere den. Nogle få opgaveeksempler er kun givet til modellen som en del af inferensinputtet, et paradigme kendt som få skud i kontekst læring. I nogle tilfælde kan modellen fungere godt uden træningsdata overhovedet, kun givet en forklaring på, hvad der bør forudsiges. Dette kaldes Zero-shot in-context learning.

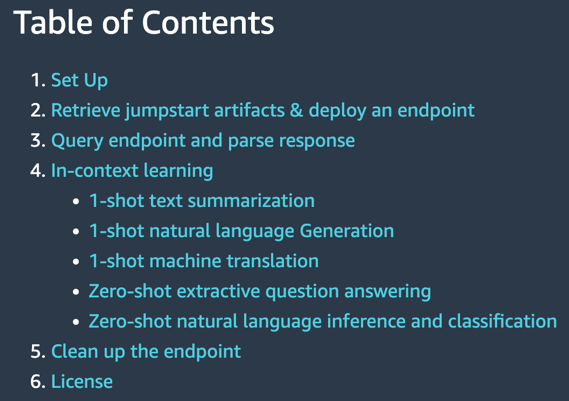

Denne notesbog demonstrerer, hvordan man implementerer AlexaTM 20B gennem JumpStart API og kører inferens. Den demonstrerer også, hvordan AlexaTM 20B kan bruges til kontekstindlæring med fem eksempelopgaver: tekstresumé, generering af naturligt sprog, maskinoversættelse, ekstraktiv besvarelse af spørgsmål og naturlig sproginferens og klassificering.

|

|

Notesbogen demonstrerer følgende:

- One-shot tekstresumé, generering af naturligt sprog og maskinoversættelse ved hjælp af et enkelt træningseksempel for hver af disse opgaver

- Zero-shot spørgsmål besvarelse og naturligt sprog inferens plus klassificering ved brug af modellen, som den er, uden behov for at give nogen træningseksempler.

Prøv at køre din egen tekst mod denne model, og se, hvordan den opsummerer tekst, uddrager spørgsmål og svar eller oversætter fra et sprog til et andet.

Fairness lineær elev i SageMaker

Der har for nylig været bekymringer om bias i ML-algoritmer som følge af efterligning af eksisterende menneskelige fordomme. I dag har flere ML-metoder stærke sociale implikationer, for eksempel bruges de til at forudsige banklån, forsikringsrenter eller annoncer. Desværre vil en algoritme, der lærer af historiske data, naturligt arve tidligere skævheder. Denne notesbog præsenterer, hvordan man overvinder dette problem ved at bruge SageMaker og fair algoritmer i sammenhæng med lineære elever.

Den starter med at introducere nogle af begreberne og matematikken bag retfærdighed, derefter downloader den data, træner en model og til sidst anvender den retfærdighedskoncepter for at justere modelforudsigelser korrekt.

|

|

Notesbogen demonstrerer følgende:

- Kørsel af en standard lineær model på UCI's voksendatasæt.

- Viser uretfærdighed i modelforudsigelser

- Retter data for at fjerne bias

- Omskoling af modellen

Prøv at køre dine egne data ved hjælp af denne eksempelkode og find ud af, om der er skævhed. Prøv derefter at fjerne bias, hvis nogen, i dit datasæt ved hjælp af de medfølgende funktioner i dette eksempel på notesbog.

Administrer ML-eksperimentering ved hjælp af SageMaker Search

SageMaker Search giver dig mulighed for hurtigt at finde og evaluere de mest relevante modeltræningsforløb fra potentielt hundreder og tusinder af SageMaker modeltræningsjob. Udvikling af en ML-model kræver kontinuerlig eksperimentering, afprøvning af nye indlæringsalgoritmer og justering af hyperparametre, alt imens man observerer virkningen af sådanne ændringer på modellens ydeevne og nøjagtighed. Denne iterative øvelse fører ofte til en eksplosion af hundredvis af modeltræningseksperimenter og modelversioner, hvilket bremser konvergensen og opdagelsen af en vindende model. Derudover gør informationseksplosionen det meget svært at spore en modelversions afstamning tilbage – den unikke kombination af datasæt, algoritmer og parametre, der bryggede denne model i første omgang.

Denne notesbog viser, hvordan du bruger SageMaker Search til hurtigt og nemt at organisere, spore og evaluere dine modeloplæringsjob på SageMaker. Du kan søge på alle de definerende attributter fra den anvendte læringsalgoritme, hyperparameterindstillinger, brugte træningsdatasæt og endda de tags, du har tilføjet på modeltræningsopgaverne. Du kan også hurtigt sammenligne og rangere dine træningsløb baseret på deres præstationsmålinger, såsom træningstab og valideringsnøjagtighed, og derved skabe leaderboards til at identificere de vindende modeller, der kan implementeres i produktionsmiljøer. SageMaker Search kan hurtigt spore hele slægten tilbage af en modelversion, der er implementeret i et live-miljø, lige indtil de datasæt, der bruges til træning og validering af modellen.

|

|

Notesbogen demonstrerer følgende:

- Træning af en lineær model tre gange

- Brug af SageMaker Search til at organisere og evaluere disse eksperimenter

- Visualisering af resultaterne på en rangliste

- Implementering af en model til et slutpunkt

- Sporing af modellens afstamning startende fra endepunktet

I din egen udvikling af prædiktive modeller kører du muligvis flere eksperimenter. Prøv at bruge SageMaker Search i sådanne eksperimenter og oplev, hvordan det kan hjælpe dig på flere måder.

SageMaker neural emnemodel

SageMaker Neural Topic Model (NTM) er en uovervåget læringsalgoritme, der forsøger at beskrive et sæt observationer som en blanding af forskellige kategorier. NTM bruges mest til at opdage et brugerspecificeret antal emner, der deles af dokumenter i et tekstkorpus. Her er hver observation et dokument, funktionerne er tilstedeværelsen (eller antallet af forekomster) af hvert ord, og kategorierne er emnerne. Fordi metoden er uden opsyn, er emnerne ikke specificeret på forhånd, og det er ikke garanteret, at de stemmer overens med, hvordan et menneske naturligt kan kategorisere dokumenter. Emnerne læres som en sandsynlighedsfordeling over de ord, der forekommer i hvert dokument. Hvert dokument er på sin side beskrevet som en blanding af emner.

Denne notesbog bruger SageMaker NTM-algoritmen til at træne en model på 20NewsGroups-datasættet. Dette datasæt er blevet brugt i vid udstrækning som benchmark for emnemodellering.

|

|

Notesbogen demonstrerer følgende:

- Oprettelse af et SageMaker træningsjob på et datasæt for at producere en NTM-model

- Brug af modellen til at udføre inferens med et SageMaker-slutpunkt

- Udforske den trænede model og visualisere lærte emner

Du kan nemt ændre denne notesbog, så den kører på dine tekstdokumenter og opdele dem i forskellige emner.

Forudsige overtrædelser af kørehastigheden

Denne notesbog demonstrerer prognoser for tidsserier ved hjælp af SageMaker DeepAR-algoritmen ved at analysere byen Chicagos Speed Camera Violation-datasæt. Datasættet hostes af Data.gov og administreres af US General Services Administration, Technology Transformation Service.

Disse overtrædelser fanges af kamerasystemer og er tilgængelige for at forbedre offentlighedens liv gennem Chicagos dataportal. Datasættet for overtrædelse af fotofælder kan bruges til at skelne mønstre i dataene og få meningsfuld indsigt.

Datasættet indeholder flere kameraplaceringer og daglige overtrædelser. Hvert dagligt antal overtrædelser for et kamera kan betragtes som en separat tidsserie. Du kan bruge SageMaker DeepAR-algoritmen til at træne en model til flere gader samtidigt og forudsige overtrædelser for flere gadekameraer.

|

|

Notesbogen demonstrerer følgende:

- Træning af SageMaker DeepAR-algoritmen på tidsseriedatasættet ved hjælp af spotforekomster

- At lave slutninger om den trænede model til at lave forudsigelser om trafikovertrædelser

Med denne notesbog kan du lære, hvordan tidsserieproblemer kan løses ved hjælp af DeepAR-algoritmen i SageMaker og prøve at anvende den på dine egne tidsseriedatasæt.

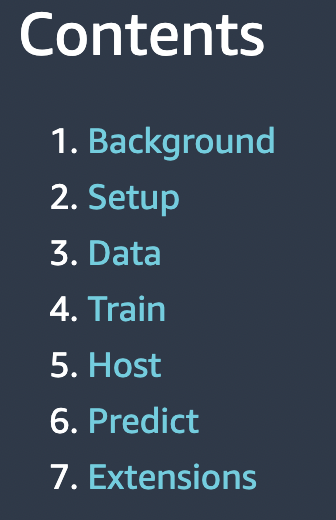

Forudsigelse af brystkræft

Denne notesbog tager et eksempel på forudsigelse af brystkræft ved hjælp af UCI's diagnostiske datasæt for brystkræft. Det bruger dette datasæt til at bygge en forudsigelig model af, om et brystmassebillede indikerer en godartet eller ondartet tumor.

|

|

Notesbogen demonstrerer følgende:

- Grundlæggende opsætning til brug af SageMaker

- Konvertering af datasæt til Protobuf-format brugt af SageMaker-algoritmerne og upload til Amazon Simple Storage Service (Amazon S3)

- Træning af en SageMaker lineær elevmodel på datasættet

- Vært for den trænede model

- Scoring ved hjælp af den trænede model

Du kan gennemgå denne notesbog for at lære, hvordan du løser et forretningsproblem ved hjælp af SageMaker, og forstå de involverede trin til træning og hosting af en model.

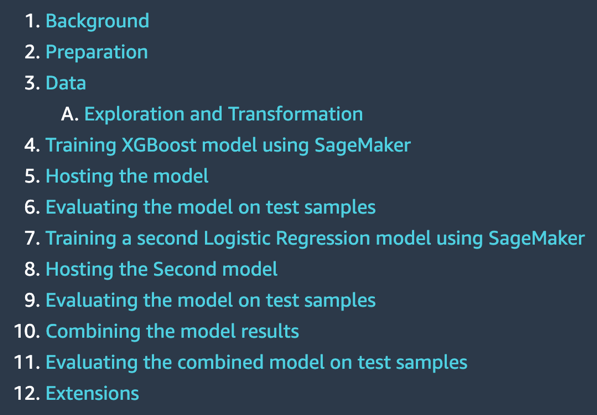

Ensemble forudsigelser fra flere modeller

I praktiske anvendelser af ML på prædiktive opgaver er én model ofte ikke tilstrækkelig. De fleste forudsigelseskonkurrencer kræver typisk at kombinere prognoser fra flere kilder for at få en forbedret prognose. Ved at kombinere eller tage et gennemsnit af forudsigelser fra flere kilder eller modeller får vi typisk en forbedret prognose. Dette sker, fordi der er betydelig usikkerhed i valget af model, og der ikke er én rigtig model i mange praktiske anvendelser. Derfor er det en fordel at kombinere forudsigelser fra forskellige modeller. I den Bayesianske litteratur omtales denne idé som Bayesiansk modelgennemsnit og har vist sig at fungere meget bedre end blot at vælge én model.

Denne notesbog præsenterer et illustrativt eksempel til at forudsige, om en person tjener over $50,000 om året baseret på oplysninger om deres uddannelse, erhvervserfaring, køn og mere.

|

|

Notesbogen demonstrerer følgende:

- Klargøring af din SageMaker notesbog

- Indlæsning af et datasæt fra Amazon S3 ved hjælp af SageMaker

- Undersøgelse og transformation af data, så de kan føres til SageMaker-algoritmer

- Estimering af en model ved hjælp af SageMaker XGBoost (Extreme Gradient Boosting) algoritmen

- Hosting af modellen på SageMaker for at lave løbende forudsigelser

- Estimering af en anden model ved hjælp af SageMaker lineære læremetode

- Kombination af forudsigelserne fra begge modeller og evaluering af den kombinerede forudsigelse

- Generering af endelige forudsigelser på testdatasættet

Prøv at køre denne notesbog på dit datasæt og brug flere algoritmer. Prøv at eksperimentere med forskellige kombinationer af modeller, der tilbydes af SageMaker og JumpStart, og se, hvilken kombination af modelsammensætning, der giver de bedste resultater på dine egne data.

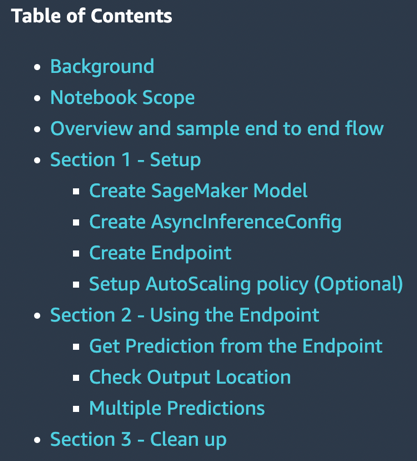

SageMaker asynkron inferens

SageMaker asynkron inferens er en ny funktion i SageMaker, der sætter indgående anmodninger i kø og behandler dem asynkront. SageMaker tilbyder i øjeblikket to slutningsmuligheder for kunder til at implementere ML-modeller: en realtidsmulighed for arbejdsbelastninger med lav latens og batchtransformation, en offline mulighed for at behandle slutningsanmodninger på batches af data, der er tilgængelige på forhånd. Realtidsinferens er velegnet til arbejdsbelastninger med nyttelaststørrelser på mindre end 6 MB og kræver, at inferensanmodninger behandles inden for 60 sekunder. Batchtransformation er velegnet til offline konklusioner om batches af data.

Asynkron inferens er en ny inferensmulighed til inferensbehov næsten i realtid. Forespørgsler kan tage op til 15 minutter at behandle og har en nyttelaststørrelse på op til 1 GB. Asynkron inferens er velegnet til arbejdsbelastninger, der ikke har krav til sekundær latency og har lempede latenskrav. For eksempel skal du muligvis behandle en slutning om et stort billede på flere MB inden for 5 minutter. Derudover giver asynkrone slutningsendepunkter dig mulighed for at kontrollere omkostningerne ved at nedskalere antallet af slutpunktforekomster til nul, når de er inaktive, så du kun betaler, når dine endepunkter behandler anmodninger.

|

|

Notesbogen demonstrerer følgende:

- Oprettelse af en SageMaker-model

- Oprettelse af et slutpunkt ved hjælp af denne model og asynkron inferenskonfiguration

- At lave forudsigelser mod dette asynkrone endepunkt

Denne notesbog viser dig et fungerende eksempel på at sammensætte et asynkront slutpunkt til en SageMaker-model.

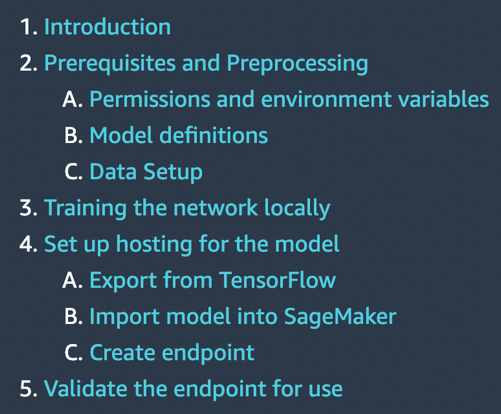

TensorFlow medbring din egen model

En TensorFlow-model trænes lokalt i en klassifikationsopgave, hvor denne notebook køres. Derefter implementeres det på et SageMaker-slutpunkt.

|

|

Notesbogen demonstrerer følgende:

- Træning af en TensorFlow-model lokalt på IRIS-datasættet

- Importerer denne model til SageMaker

- Hoster det på et slutpunkt

Hvis du har TensorFlow-modeller, som du selv har udviklet, kan dette eksempel på notesbog hjælpe dig med at hoste din model på et SageMaker-administreret slutpunkt.

Scikit-learn medbring din egen model

SageMaker inkluderer funktionalitet til at understøtte et hostet notebookmiljø, distribueret, serverløs træning og realtidshosting. Det fungerer bedst, når alle disse tre tjenester bruges sammen, men de kan også bruges uafhængigt af hinanden. Nogle brugstilfælde kræver muligvis kun hosting. Måske blev modellen trænet før SageMaker eksisterede, i en anden tjeneste.

Notesbogen demonstrerer følgende:

- Brug af en forudtrænet Scikit-learn-model med SageMaker Scikit-learn-beholderen til hurtigt at oprette et hostet slutpunkt for den model

Hvis du har Scikit-learn-modeller, som du selv har udviklet, kan denne eksempelnotesbog hjælpe dig med at hoste din model på et SageMaker-administreret slutpunkt.

Ryd op i ressourcer

Når du er færdig med at køre en notesbog i JumpStart, skal du sørge for at Slet alle ressourcer så alle de ressourcer, som du har oprettet i processen, slettes, og din fakturering stoppes. Den sidste celle i disse notesbøger sletter normalt endepunkter, der er oprettet.

Resumé

Dette indlæg ledte dig gennem 10 nye eksempelnotesbøger, der for nylig blev tilføjet til JumpStart. Selvom dette indlæg fokuserede på disse 10 nye notesbøger, er der i alt 56 tilgængelige notesbøger, når dette skrives. Vi opfordrer dig til selv at logge ind på Studio og udforske JumpStart-notesbøgerne og begynde at få øjeblikkelig værdi ud af dem. For mere information, se Amazon SageMaker Studio , SageMaker JumpStart.

Om forfatteren

Dr. Raju Penmatcha er AI/ML Specialist Solutions Architect i AI-platforme hos AWS. Han modtog sin ph.d. fra Stanford University. Han arbejder tæt sammen om lav/ingen kode suite-tjenester i SageMaker, der hjælper kunder med nemt at bygge og implementere maskinlæringsmodeller og -løsninger.

Dr. Raju Penmatcha er AI/ML Specialist Solutions Architect i AI-platforme hos AWS. Han modtog sin ph.d. fra Stanford University. Han arbejder tæt sammen om lav/ingen kode suite-tjenester i SageMaker, der hjælper kunder med nemt at bygge og implementere maskinlæringsmodeller og -løsninger.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- Amazon SageMaker JumpStart

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet