Mens organisationer implementerer modeller til produktion, leder de konstant efter måder at optimere ydeevnen af deres fundamentmodeller (FM'er), der kører på de nyeste acceleratorer, som f.eks. AWS-inferens og GPU'er, så de kan reducere deres omkostninger og reducere responsforsinkelse for at give slutbrugerne den bedste oplevelse. Nogle FM'er udnytter dog ikke fuldt ud de tilgængelige acceleratorer med de instanser, de er installeret på, hvilket fører til en ineffektiv brug af hardwareressourcer. Nogle organisationer implementerer flere FM'er til den samme instans for bedre at udnytte alle de tilgængelige acceleratorer, men dette kræver kompleks infrastrukturorkestrering, der er tidskrævende og vanskelig at administrere. Når flere FM'er deler den samme instans, har hver FM sine egne skaleringsbehov og brugsmønstre, hvilket gør det udfordrende at forudsige, hvornår du skal tilføje eller fjerne instanser. For eksempel kan én model bruges til at drive en brugerapplikation, hvor brugen kan stige i bestemte timer, hvorimod en anden model kan have et mere ensartet brugsmønster. Ud over at optimere omkostningerne ønsker kunderne at give den bedste slutbrugeroplevelse ved at reducere latens. For at gøre dette implementerer de ofte flere kopier af en FM til feltanmodninger fra brugere parallelt. Fordi FM-output kan variere fra en enkelt sætning til flere afsnit, varierer den tid, det tager at fuldføre slutningsanmodningen, betydeligt, hvilket fører til uforudsigelige stigninger i latens, hvis anmodningerne dirigeres tilfældigt mellem instanser. Amazon SageMaker understøtter nu nye inferensfunktioner, der hjælper dig med at reducere implementeringsomkostninger og ventetid.

Du kan nu oprette inferenskomponentbaserede slutpunkter og implementere maskinlæringsmodeller (ML) til et SageMaker-slutpunkt. En inferenskomponent (IC) abstraherer din ML-model og giver dig mulighed for at tildele CPU'er, GPU eller AWS Neuron acceleratorer og skaleringspolitikker pr. model. Inferenskomponenter giver følgende fordele:

- SageMaker vil optimalt placere og pakke modeller på ML-instanser for at maksimere udnyttelsen, hvilket fører til omkostningsbesparelser.

- SageMaker skalerer hver model op og ned baseret på din konfiguration for at opfylde dine ML-applikationskrav.

- SageMaker vil skalere for at tilføje og fjerne forekomster dynamisk for at sikre, at kapaciteten er tilgængelig, mens inaktiv beregning holdes på et minimum.

- Du kan skalere ned til nul kopier af en model for at frigøre ressourcer til andre modeller. Du kan også angive, at vigtige modeller altid skal være indlæst og klar til at betjene trafik.

Med disse funktioner kan du reducere omkostningerne til modelimplementering med 50 % i gennemsnit. Omkostningsbesparelserne vil variere afhængigt af din arbejdsbyrde og trafikmønstre. Lad os tage et simpelt eksempel for at illustrere, hvordan pakning af flere modeller på et enkelt slutpunkt kan maksimere udnyttelsen og spare omkostninger. Lad os sige, at du har en chatapplikation, der hjælper turister med at forstå lokale skikke og bedste praksis bygget ved hjælp af to varianter af Llama 2: den ene finjusteret til europæiske besøgende og den anden finjusteret til amerikanske besøgende. Vi forventer trafik for den europæiske model mellem 00:01–11:59 UTC og den amerikanske model mellem 12:00–23:59 UTC. I stedet for at implementere disse modeller på deres egne dedikerede forekomster, hvor de vil sidde inaktive halvdelen af tiden, kan du nu implementere dem på et enkelt slutpunkt for at spare omkostninger. Du kan nedskalere den amerikanske model til nul, når det ikke er nødvendigt for at frigøre kapacitet til den europæiske model og omvendt. Dette giver dig mulighed for at udnytte din hardware effektivt og undgå spild. Dette er et simpelt eksempel med to modeller, men du kan nemt udvide denne idé til at pakke hundredvis af modeller på et enkelt slutpunkt, der automatisk skaleres op og ned med din arbejdsbyrde.

I dette indlæg viser vi dig de nye muligheder for IC-baserede SageMaker-endepunkter. Vi guider dig også gennem implementering af flere modeller ved hjælp af inferenskomponenter og API'er. Til sidst beskriver vi nogle af de nye observerbarhedsfunktioner, og hvordan du opsætter politikker for automatisk skalering for dine modeller og administrerer instansskalering for dine slutpunkter. Du kan også implementere modeller gennem vores nye forenklede, interaktive brugeroplevelse. Vi understøtter også avancerede routing-funktioner for at optimere latensen og ydeevnen af dine inferensarbejdsbelastninger.

Byggesten

Lad os tage et dybere kig og forstå, hvordan disse nye funktioner fungerer. Følgende er noget ny terminologi for SageMaker-hosting:

- Inferens komponent – Et SageMaker-hostingobjekt, som du kan bruge til at implementere en model til et slutpunkt. Du kan oprette en slutningskomponent ved at angive følgende:

- SageMaker-modellen eller specifikationen af et SageMaker-kompatibelt billede og modelartefakter.

- Beregn ressourcekrav, som specificerer behovene for hver kopi af din model, herunder CPU-kerner, værtshukommelse og antallet af acceleratorer.

- Model kopi – En runtime-kopi af en inferenskomponent, der er i stand til at betjene anmodninger.

- Administreret instans automatisk skalering – En SageMaker-hosting-funktion til at skalere op eller ned for antallet af computerforekomster, der bruges til et slutpunkt. Forekomstskalering reagerer på skalering af inferenskomponenter.

For at oprette en ny inferenskomponent kan du angive et containerbillede og en modelartefakt, eller du kan bruge SageMaker-modeller, som du måske allerede har oprettet. Du skal også specificere krav til computerressourcer, såsom antallet af værts-CPU-kerner, værtshukommelse eller antallet af acceleratorer, som din model skal køre.

Når du implementerer en inferenskomponent, kan du angive MinCopies for at sikre, at modellen allerede er indlæst i den mængde, du har brug for, klar til at betjene anmodninger.

Du har også mulighed for at indstille dine politikker, så inferenskomponent kopierer til nul. For eksempel, hvis du ikke har nogen belastning, der kører mod en IC, vil modelkopien blive fjernet. Dette kan frigøre ressourcer, der kan erstattes af aktive arbejdsbelastninger for at optimere udnyttelsen og effektiviteten af dit slutpunkt.

Efterhånden som slutningsanmodninger stiger eller falder, kan antallet af kopier af dine IC'er også skaleres op eller ned baseret på dine automatiske skaleringspolitikker. SageMaker vil håndtere placeringen for at optimere pakningen af dine modeller for tilgængelighed og pris.

Derudover, hvis du aktiverer automatisk skalering af administrerede forekomster, vil SageMaker skalere beregningsforekomster i henhold til antallet af inferenskomponenter, der skal indlæses på et givet tidspunkt for at betjene trafik. SageMaker vil opskalere forekomsterne og pakke dine forekomster og inferenskomponenter for at optimere for omkostningerne, samtidig med at modellens ydeevne bevares. Selvom vi anbefaler brugen af skalering af administreret forekomst, har du også mulighed for selv at styre skaleringen, hvis du vælger det, gennem applikationens automatiske skalering.

SageMaker vil rebalancere inferenskomponenter og nedskalere forekomsterne, hvis de ikke længere er nødvendige for inferenskomponenter og spare dine omkostninger.

Gennemgang af API'er

SageMaker har introduceret en ny enhed kaldet InferenceComponent. Dette afkobler detaljerne om hosting af ML-modellen fra selve slutpunktet. Det InferenceComponent giver dig mulighed for at specificere nøgleegenskaber til hosting af modellen, såsom den SageMaker-model, du vil bruge, eller containerdetaljerne og modelartefakter. Du angiver også antallet af kopier af selve komponenterne, der skal implementeres, og antallet af acceleratorer (GPU'er, Inf eller Trn-acceleratorer) eller CPU (vCPU'er) påkrævet. Dette giver dig mere fleksibilitet til at bruge et enkelt slutpunkt til et hvilket som helst antal modeller, du planlægger at implementere til det i fremtiden.

Lad os se på Boto3 API-kaldene for at oprette et slutpunkt med en inferenskomponent. Bemærk, at der er nogle parametre, som vi behandler senere i dette indlæg.

Følgende er eksempelkode for CreateEndpointConfig:

Følgende er eksempelkode for CreateEndpoint:

Følgende er eksempelkode for CreateInferenceComponent:

Denne afkobling af InferenceComponent til et slutpunkt giver fleksibilitet. Du kan hoste flere modeller på den samme infrastruktur, tilføje eller fjerne dem, efterhånden som dine krav ændrer sig. Hver model kan opdateres uafhængigt efter behov. Derudover kan du skalere modeller efter dine forretningsbehov. InferenceComponent giver dig også mulighed for at styre kapaciteten pr. model. Du kan med andre ord bestemme, hvor mange kopier af hver model, der skal hostes. Denne forudsigelige skalering hjælper dig med at opfylde de specifikke latenskrav for hver model. Samlet set, InferenceComponent giver dig meget mere kontrol over dine hostede modeller.

I den følgende tabel viser vi en side-om-side-sammenligning af tilgangen på højt niveau til at oprette og påberåbe et slutpunkt uden InferenceComponent og med InferenceComponent. Bemærk, at CreateModel() nu er valgfri for IC-baserede slutpunkter.

| Trin | Modelbaserede endepunkter | Inferenskomponentbaserede endepunkter |

| 1 | Opret model(...) | CreateEndpointConfig(...) |

| 2 | CreateEndpointConfig(...) | Opret slutpunkt(...) |

| 3 | Opret slutpunkt(...) | CreateInferenceComponent(...) |

| 4 | InvokeEndpoint(...) | InvokeEndpoint(InferneceComponentName='value'...) |

Indførelsen af InferenceComponent allows you to scale at a model level. See Delve into instance and IC auto scaling for more details on how InferenceComponent works with auto scaling.

Når du kalder SageMaker-slutpunktet, kan du nu angive den nye parameter InferenceComponentName at ramme det ønskede InferenceComponentName. SageMaker vil håndtere routing af anmodningen til den instans, der er vært for den anmodede InferenceComponentName. Se følgende kode:

Som standard bruger SageMaker tilfældig routing af anmodningerne til de instanser, der understøtter dit slutpunkt. Hvis du vil aktivere routing af mindst udestående anmodninger, kan du indstille routingstrategien i slutpunktskonfigurationens RoutingConfig:

Mindst udestående anmodninger dirigerer ruter til de specifikke forekomster, der har mere kapacitet til at behandle anmodninger. Dette vil give mere ensartet belastningsbalancering og ressourceudnyttelse.

Foruden CreateInferenceComponent, er følgende API'er nu tilgængelige:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent logs og metrics

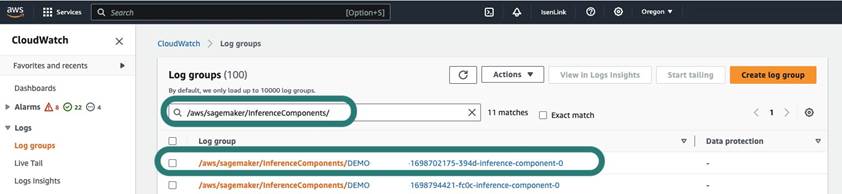

InferenceComponent logs er placeret i /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Alle logfiler sendt til stderr og stdout i containeren sendes til disse logs ind amazoncloudwatch.

Med introduktionen af IC-baserede slutpunkter har du nu mulighed for at se yderligere instansmetrikker, inferenskomponentmetrikker og invokationsmetrikker.

For SageMaker-forekomster kan du nu spore GPUReservation , CPUReservation metrics for at se de ressourcer, der er reserveret til et slutpunkt baseret på de inferenskomponenter, du har implementeret. Disse metrics kan hjælpe dig med at dimensionere dine slutpunkter og politikker for automatisk skalering. Du kan også se de samlede metrics, der er knyttet til alle modeller, der er implementeret til et slutpunkt.

SageMaker afslører også metrics på et inferenskomponentniveau, som kan vise et mere detaljeret overblik over udnyttelsen af ressourcer for de inferenskomponenter, du har implementeret. Dette giver dig mulighed for at få et overblik over, hvor meget samlet ressourceudnyttelse som f.eks GPUUtilizationNormalized , GPUMemoryUtilizationNormalized for hver inferenskomponent, du har implementeret, og som kan have nul eller mange kopier.

Endelig leverer SageMaker invokationsmetrikker, som nu sporer invokationer for inferenskomponenter samlet (Invocations) eller pr. kopi instansieret (InvocationsPerCopy)

For en omfattende liste over målinger, se SageMaker Endpoint Invocation Metrics.

Autoskalering på modelniveau

For at implementere den automatiske skaleringsadfærd, vi beskrev, definerer du, når du opretter SageMaker-slutpunktskonfigurationen og inferenskomponenten, henholdsvis det oprindelige antal forekomster og det indledende antal kopi-modeller. Når du har oprettet slutpunktet og de tilsvarende IC'er, skal du for at anvende automatisk skalering på IC-niveau først registrere skaleringsmålet og derefter knytte skaleringspolitikken til IC'en.

Ved implementering af skaleringspolitikken bruger vi SageMakerInferenceComponentInvocationsPerCopy, som er en ny metrik introduceret af SageMaker. Den fanger det gennemsnitlige antal opkald pr. modelkopi pr. minut.

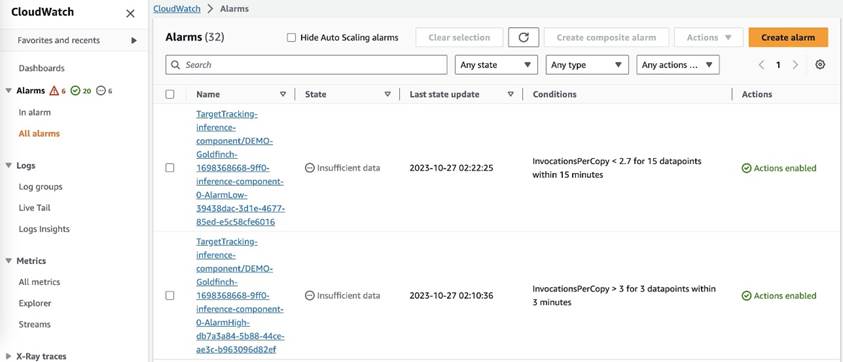

Når du har indstillet skaleringspolitikken, opretter SageMaker to CloudWatch-alarmer for hvert autoskaleringsmål: en til at udløse skalering, hvis den er i alarm i 3 minutter (tre 1-minuts datapunkter) og en til at udløse skalering, hvis den er i alarm i 15 minutter (15 1-minutters datapunkter), som vist på det følgende skærmbillede. Tiden til at udløse skaleringshandlingen er normalt 1-2 minutter længere end disse minutter, fordi det tager tid for slutpunktet at offentliggøre metrics til CloudWatch, og det tager også tid for AutoScaling at reagere. Nedkølingsperioden er den tid, i sekunder, efter en ind- eller udskaleringsaktivitet er afsluttet, før en anden udskaleringsaktivitet kan starte. Hvis udskaleringsafkølingen er kortere end endpoint-opdateringstiden, har det ingen effekt, fordi det ikke er muligt at opdatere et SageMaker-slutpunkt, når det er i Opdatering status.

Bemærk, at når du opsætter automatisk skalering på IC-niveau, skal du sørge for at MaxInstanceCount parameter er lig med eller mindre end det maksimale antal IC'er, som dette endepunkt kan håndtere. Hvis dit slutpunkt f.eks. kun er konfigureret til at have én instans i endepunktskonfigurationen, og denne instans kun kan være vært for maksimalt fire kopier af modellen, så MaxInstanceCount skal være lig med eller mindre end 4. Du kan dog også bruge den administrerede automatiske skaleringsfunktion, der leveres af SageMaker, til automatisk at skalere forekomstantallet baseret på det nødvendige modelkopinummer for at opfylde behovet for flere computerressourcer. Følgende kodestykke viser, hvordan man opsætter skalering af administreret forekomst under oprettelsen af slutpunktskonfigurationen. På denne måde, når den automatiske skalering på IC-niveau kræver mere instanstælling for at være vært for modelkopierne, skalerer SageMaker automatisk instansnummeret ud for at tillade, at IC-niveauskaleringen kan lykkes.

Du kan anvende flere automatiske skaleringspolitikker mod det samme endepunkt, hvilket betyder, at du vil være i stand til at anvende den traditionelle automatiske skaleringspolitik på de endepunkter, der er oprettet med IC'er, og skalere op og ned baseret på de andre endepunktsmålinger. For mere information, se Optimer dine maskinlæringsimplementeringer med automatisk skalering på Amazon SageMaker. Men selvom dette er muligt, anbefaler vi stadig at bruge administreret instansskalering frem for selv at administrere skaleringen.

Konklusion

I dette indlæg introducerede vi en ny funktion i SageMaker inference, der vil hjælpe dig med at maksimere udnyttelsen af computerforekomster, skalere til hundredvis af modeller og optimere omkostningerne, samtidig med at du giver forudsigelig ydeevne. Desuden gav vi en gennemgang af API'erne og viste dig, hvordan du konfigurerer og implementerer inferenskomponenter til dine arbejdsbelastninger.

Vi støtter også avancerede routing-funktioner for at optimere latensen og ydeevnen af dine inferensarbejdsbelastninger. SageMaker kan hjælpe dig med at optimere dine inferensarbejdsbelastninger for omkostninger og ydeevne og give dig granularitet på modelniveau til administration. Vi har skabt en sæt notesbøger der vil vise dig, hvordan du implementerer tre forskellige modeller ved at bruge forskellige containere og anvende automatisk skaleringspolitikker i GitHub. Vi opfordrer dig til at starte med notebook 1 og komme i gang med de nye SageMaker-hostingfunktioner i dag!

Om forfatterne

James Park er Solutions Architect hos Amazon Web Services. Han arbejder sammen med Amazon.com om at designe, bygge og implementere teknologiløsninger på AWS og har en særlig interesse for kunstig intelligens og maskinlæring. I fritiden nyder han at opsøge nye kulturer, nye oplevelser og holde sig ajour med de nyeste teknologitrends. Du kan finde ham på LinkedIn.

James Park er Solutions Architect hos Amazon Web Services. Han arbejder sammen med Amazon.com om at designe, bygge og implementere teknologiløsninger på AWS og har en særlig interesse for kunstig intelligens og maskinlæring. I fritiden nyder han at opsøge nye kulturer, nye oplevelser og holde sig ajour med de nyeste teknologitrends. Du kan finde ham på LinkedIn.

Melanie Li, PhD, er en Senior AI/ML Specialist TAM hos AWS med base i Sydney, Australien. Hun hjælper virksomhedskunder med at bygge løsninger ved hjælp af state-of-the-art AI/ML-værktøjer på AWS og giver vejledning om arkitektur og implementering af ML-løsninger med bedste praksis. I sin fritid elsker hun at udforske naturen og tilbringe tid med familie og venner.

Melanie Li, PhD, er en Senior AI/ML Specialist TAM hos AWS med base i Sydney, Australien. Hun hjælper virksomhedskunder med at bygge løsninger ved hjælp af state-of-the-art AI/ML-værktøjer på AWS og giver vejledning om arkitektur og implementering af ML-løsninger med bedste praksis. I sin fritid elsker hun at udforske naturen og tilbringe tid med familie og venner.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Alan Tan er en Senior Product Manager hos SageMaker, der leder indsatsen inden for store modelslutninger. Han brænder for at anvende maskinlæring til analyseområdet. Uden for arbejdet nyder han udendørslivet.

Alan Tan er en Senior Product Manager hos SageMaker, der leder indsatsen inden for store modelslutninger. Han brænder for at anvende maskinlæring til analyseområdet. Uden for arbejdet nyder han udendørslivet.

Raghu Ramesha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

Raghu Ramesha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

Rupinder Grewal er en Sr Ai/ML Specialist Solutions Architect hos AWS. Han fokuserer i øjeblikket på servering af modeller og MLOps på SageMaker. Før denne rolle har han arbejdet som Machine Learning Engineer ved at bygge og hoste modeller. Uden for arbejdet nyder han at spille tennis og cykle på bjergstier.

Rupinder Grewal er en Sr Ai/ML Specialist Solutions Architect hos AWS. Han fokuserer i øjeblikket på servering af modeller og MLOps på SageMaker. Før denne rolle har han arbejdet som Machine Learning Engineer ved at bygge og hoste modeller. Uden for arbejdet nyder han at spille tennis og cykle på bjergstier.

Dhawal Patel er Principal Machine Learning Architect hos AWS. Han har arbejdet med organisationer lige fra store virksomheder til mellemstore startups om problemer relateret til distribueret computing og kunstig intelligens. Han fokuserer på Deep learning, herunder NLP og Computer Vision domæner. Han hjælper kunder med at opnå højtydende modelslutning på SageMaker.

Dhawal Patel er Principal Machine Learning Architect hos AWS. Han har arbejdet med organisationer lige fra store virksomheder til mellemstore startups om problemer relateret til distribueret computing og kunstig intelligens. Han fokuserer på Deep learning, herunder NLP og Computer Vision domæner. Han hjælper kunder med at opnå højtydende modelslutning på SageMaker.

Saurabh Trikande er Senior Product Manager for Amazon SageMaker Inference. Han brænder for at arbejde med kunder og er motiveret af målet om at demokratisere machine learning. Han fokuserer på kerneudfordringer relateret til implementering af komplekse ML-applikationer, multi-tenant ML-modeller, omkostningsoptimeringer og at gøre implementering af deep learning-modeller mere tilgængelig. I sin fritid nyder Saurabh at vandre, lære om innovative teknologier, følge TechCrunch og tilbringe tid med sin familie.

Saurabh Trikande er Senior Product Manager for Amazon SageMaker Inference. Han brænder for at arbejde med kunder og er motiveret af målet om at demokratisere machine learning. Han fokuserer på kerneudfordringer relateret til implementering af komplekse ML-applikationer, multi-tenant ML-modeller, omkostningsoptimeringer og at gøre implementering af deep learning-modeller mere tilgængelig. I sin fritid nyder Saurabh at vandre, lære om innovative teknologier, følge TechCrunch og tilbringe tid med sin familie.

Lakshmi Ramakrishnan er hovedingeniør hos Amazon SageMaker Machine Learning (ML) platformteam i AWS, der yder teknisk lederskab for produktet. Han har arbejdet i flere ingeniørroller i Amazon i over 9 år. Han har en Bachelor of Engineering-grad i Informationsteknologi fra National Institute of Technology, Karnataka, Indien og en Master of Science-grad i Computer Science fra University of Minnesota Twin Cities.

Lakshmi Ramakrishnan er hovedingeniør hos Amazon SageMaker Machine Learning (ML) platformteam i AWS, der yder teknisk lederskab for produktet. Han har arbejdet i flere ingeniørroller i Amazon i over 9 år. Han har en Bachelor of Engineering-grad i Informationsteknologi fra National Institute of Technology, Karnataka, Indien og en Master of Science-grad i Computer Science fra University of Minnesota Twin Cities.

David Nigenda er en Senior Software Development Engineer på Amazon SageMaker-teamet, der i øjeblikket arbejder på at forbedre produktionsprocesser for maskinlæring samt lancering af nye inferensfunktioner. I sin fritid forsøger han at følge med sine børn.

David Nigenda er en Senior Software Development Engineer på Amazon SageMaker-teamet, der i øjeblikket arbejder på at forbedre produktionsprocesser for maskinlæring samt lancering af nye inferensfunktioner. I sin fritid forsøger han at følge med sine børn.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 100

- 114

- 12

- 13

- 15 %

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- evne

- I stand

- Om

- abstracts

- acceleratorer

- tilgængelig

- Ifølge

- opnå

- Handling

- aktiv

- aktivitet

- tilføje

- tilføje

- Desuden

- Yderligere

- Derudover

- adresse

- fremskreden

- Efter

- mod

- aggregat

- AI

- AI / ML

- Alan

- alarm

- Alle

- tillade

- tillader

- allerede

- også

- Skønt

- altid

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- amerikansk

- beløb

- an

- analytics

- ,

- En anden

- enhver

- api

- API'er

- Anvendelse

- applikationer

- Indløs

- Anvendelse

- tilgang

- ER

- OMRÅDE

- kunstig

- kunstig intelligens

- AS

- Associate

- forbundet

- At

- Australien

- auto

- automatisk

- tilgængelighed

- til rådighed

- gennemsnit

- undgå

- AWS

- opbakning

- baseret

- BE

- fordi

- før

- adfærd

- fordele

- BEDSTE

- bedste praksis

- Bedre

- mellem

- bygge

- Bygning

- bygget

- virksomhed

- men

- by

- kaldet

- Opkald

- CAN

- kapaciteter

- kapacitet

- stand

- Kapacitet

- fanger

- vis

- udfordringer

- udfordrende

- lave om

- Vælg

- byer

- kode

- KOM

- sammenligning

- fuldføre

- Fuldender

- komplekse

- komponent

- komponenter

- omfattende

- Compute

- computer

- Datalogi

- Computer Vision

- computing

- Konfiguration

- konfigureret

- konsekvent

- konstant

- forbrugende

- Container

- Beholdere

- kontrol

- Core

- Tilsvarende

- Koste

- omkostningsbesparelser

- Omkostninger

- kunne

- skabe

- oprettet

- skaber

- Oprettelse af

- skabelse

- For øjeblikket

- Kunder

- told

- Dallas

- data

- datapunkter

- Dato

- falde

- dedikeret

- dyb

- dyb læring

- dybere

- Standard

- definere

- Degree

- dykke

- demokratisering

- demonstrerer

- Afhængigt

- indsætte

- indsat

- implementering

- implementering

- implementeringer

- beskrevet

- Design

- ønskes

- detail

- detaljer

- Bestem

- Udvikling

- forskellige

- svært

- distribueret

- distribueret computing

- do

- Domæner

- Dont

- ned

- i løbet af

- dynamisk

- hver

- nemt

- effekt

- effektivitet

- effektivt

- indsats

- muliggøre

- aktiveret

- muliggør

- tilskynde

- Endpoint

- ingeniør

- Engineering

- sikre

- Enterprise

- virksomheder

- enhed

- lige

- europæisk

- eksempel

- forvente

- erfaring

- Oplevelser

- udforske

- Udforskning

- udvide

- familie

- Feature

- Funktionalitet

- felt

- Finde

- Fornavn

- Fleksibilitet

- fokuserer

- efter

- Til

- Foundation

- fire

- Gratis

- venner

- fra

- fuldt ud

- Endvidere

- fremtiden

- få

- gif

- GitHub

- Giv

- given

- giver

- mål

- GPU

- GPU'er

- kornet

- vejledning

- Halvdelen

- håndtere

- hænder

- Hardware

- Have

- he

- hjælpe

- hjælpe

- hjælper

- hende

- Høj

- højt niveau

- ham

- hans

- Hit

- besidder

- host

- hostede

- Hosting

- HOURS

- Hvordan

- How To

- Men

- http

- HTTPS

- Hundreder

- idé

- tomgang

- if

- illustrere

- billede

- gennemføre

- gennemføre

- vigtigt

- forbedring

- in

- I andre

- Herunder

- Forøg

- uafhængigt

- Indien

- ineffektiv

- oplysninger

- informationsteknologi

- Infrastruktur

- initial

- innovativ

- innovative teknologier

- instans

- i stedet

- Institut

- Intelligens

- interaktiv

- interesse

- ind

- introduceret

- Introduktion

- IT

- ITS

- selv

- jpg

- Holde

- holde

- Nøgle

- børn

- stor

- Store virksomheder

- endelig

- Latency

- senere

- seneste

- lancering

- Leadership" (virkelig menneskelig ledelse)

- førende

- læring

- mindst

- Niveau

- ligesom

- Liste

- Llama

- belastning

- lokale

- placeret

- længere

- Se

- leder

- elsker

- maskine

- machine learning

- lave

- Making

- administrere

- lykkedes

- ledelse

- leder

- styring

- mange

- Master

- herres

- Maksimer

- maksimal

- Kan..

- midler

- Mød

- Hukommelse

- metrisk

- Metrics

- migrere

- minimum

- minut

- minutter

- ML

- MLOps

- model

- modeller

- mere

- motiveret

- Bjerg

- meget

- flere

- national

- Natur

- Behov

- behov

- behov

- Ny

- NLP

- ingen

- Bemærk

- notesbog

- nu

- nummer

- objekt

- of

- tilbyde

- tit

- on

- ONE

- kun

- på

- Optimer

- optimering

- Option

- or

- orkestrering

- organisationer

- Andet

- vores

- ud

- udendørs

- udgange

- uden for

- udestående

- i løbet af

- samlet

- egen

- Pack

- Parallel

- parameter

- parametre

- særlig

- lidenskabelige

- Mønster

- mønstre

- per

- ydeevne

- periode

- phd

- fotografering

- Place

- placering

- Steder

- fly

- perron

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- punkter

- politikker

- politik

- mulig

- Indlæg

- magt

- praksis

- forudsige

- Forudsigelig

- bevare

- Main

- Forud

- problemer

- behandle

- Produkt

- produktchef

- produktion

- egenskaber

- give

- forudsat

- giver

- leverer

- offentliggøre

- mængde

- tilfældig

- rækkevidde

- spænder

- Reagerer

- reagerer

- klar

- rebalancere

- anbefaler

- reducere

- reducere

- henvise

- register

- relaterede

- Fjern

- fjernelse

- udskiftes

- anmode

- anmodninger

- kræver

- påkrævet

- Krav

- Kræver

- forbeholdes

- ressource

- Ressourcer

- henholdsvis

- svar

- roller

- roller

- veje

- routing

- Kør

- kører

- runtime

- sagemaker

- SageMaker Inference

- samme

- Gem

- Besparelser

- siger

- Scale

- skalaer

- skalering

- Videnskab

- sekunder

- se

- søger

- senior

- sendt

- dømme

- tjener

- tjeneste

- Tjenester

- servering

- sæt

- indstilling

- flere

- Del

- hun

- bør

- Vis

- viste

- vist

- betydeligt

- Simpelt

- forenklet

- enkelt

- sidde

- Størrelse

- mindre

- uddrag

- So

- Software

- softwareudvikling

- Løsninger

- nogle

- specialist

- specialiseret

- specifikke

- specifikation

- tilbringe

- udgifterne

- spike

- spikes

- starte

- Nystartede

- state-of-the-art

- Status

- opholder

- Stadig

- Strategi

- vellykket

- sådan

- leverer

- support

- Understøtter

- sikker

- sydney

- bord

- Tag

- tager

- mål

- hold

- TechCrunch

- Teknisk

- Teknologier

- Teknologier

- tennis

- terminologi

- end

- at

- Området

- Fremtiden

- deres

- Them

- derefter

- Der.

- Disse

- de

- denne

- dem

- tre

- Gennem

- tid

- til

- værktøjer

- spor

- traditionelle

- Trafik

- Traveling

- Tendenser

- udløse

- tvilling

- to

- forstå

- universitet

- uforudsigelige

- Opdatering

- opdateret

- Brug

- brug

- anvendte

- Bruger

- Brugererfaring

- brugere

- bruger

- ved brug af

- sædvanligvis

- UTC

- udnytte

- vice

- Specifikation

- vision

- besøgende

- gå

- går igennem

- ønsker

- Affald

- Vej..

- måder

- we

- web

- webservices

- GODT

- hvornår

- ud fra følgende betragtninger

- som

- mens

- vilje

- med

- uden

- ord

- Arbejde

- arbejdede

- arbejdsgange

- arbejder

- virker

- år

- Du

- Din

- dig selv

- zephyrnet

- nul