Mange af vores AWS-kunder leverer research, analyser og business intelligence som en service. Denne type research og business intelligence gør det muligt for deres slutkunder at være på forkant med markeder og konkurrenter, identificere vækstmuligheder og løse problemer proaktivt. For eksempel laver nogle af vores kunder i den finansielle sektor forskning for aktier, hedgefonde og investeringsforvaltningsselskaber for at hjælpe dem med at forstå tendenser og identificere porteføljestrategier. I sundhedsindustrien er en stadig større del af sundhedsforskningen nu informationsbaseret. En stor del af forskningen omfatter analyse af data, der oprindeligt blev indsamlet til diagnostik, behandling eller andre forskningsprojekter, og som nu bliver brugt til nye forskningsformål. Disse former for sundhedsforskning har ført til effektiv primær forebyggelse for at undgå nye tilfælde, sekundær forebyggelse til tidlig opdagelse og forebyggelse for bedre sygdomshåndtering. Forskningsresultaterne forbedrer ikke kun livskvaliteten, men hjælper også med at reducere sundhedsudgifterne.

Kunder har en tendens til at fordøje informationen fra offentlige og private kilder. De anvender derefter etablerede eller brugerdefinerede NLP-modeller (natural language processing) for at opsummere og identificere en tendens og generere indsigt baseret på denne information. NLP-modellerne, der bruges til disse typer af forskningsopgaver, omhandler store modeller og involverer normalt lange artikler, der skal opsummeres i betragtning af korpusets størrelse – og dedikerede endepunkter, som ikke er omkostningsoptimerede i øjeblikket. Disse applikationer modtager en byge af indgående trafik på forskellige tidspunkter af dagen.

Vi mener, at kunderne vil have stor gavn af evnen til at skalere ned til nul og øge deres slutningsevne efter behov. Dette optimerer forskningsomkostningerne og går stadig ikke på kompromis med kvaliteten af slutninger. Dette indlæg diskuterer, hvordan Hugging Face sammen med Amazon SageMaker asynkron inferens kan hjælpe med at opnå dette.

Du kan bygge tekstresumémodeller med flere dybdelæringsrammer som TensorFlow, PyTorch og Apache MXNet. Disse modeller har typisk en stor inputlast af flere tekstdokumenter af varierende størrelse. Avancerede deep learning-modeller kræver computerintensiv forbehandling før modelslutning. Behandlingstiden kan være så lang som et par minutter, hvilket fjerner muligheden for at køre realtidsslutning ved at sende nyttelaster over en HTTP API. I stedet skal du behandle input-nyttelast asynkront fra et objektlager som f.eks Amazon Simple Storage Service (Amazon S3) med automatisk kø og en foruddefineret samtidighedstærskel. Systemet skal kunne modtage statusmeddelelser og reducere unødvendige omkostninger ved at rydde op i ressourcer, når opgaverne er afsluttet.

SageMaker hjælper datavidenskabsfolk og udviklere med at forberede, bygge, træne og implementere højkvalitets maskinlæringsmodeller (ML) hurtigt ved at samle et bredt sæt af funktioner, der er specialbygget til ML. SageMaker leverer de mest avancerede open source-modelserveringscontainere til XGBoost (container, SDK), Scikit-Learn (container, SDK), PyTorch (container, SDK), TensorFlow (container, SDK), og Apache MXNet (container, SDK).

- Realtidsslutning endepunkter er velegnede til arbejdsbelastninger, der skal behandles med lave latenskrav i størrelsesordenen ms til sekunder.

- Batch transformation er ideel til offline forudsigelser på store partier af data.

- Amazon SageMaker Serverless Inference (i preview-tilstand og anbefales ikke til produktionsarbejdsbelastninger, da dette skrives) er en specialbygget inferensindstilling, der gør det nemt for dig at implementere og skalere ML-modeller. Serverløs inferens er ideel til arbejdsbelastninger, der har inaktive perioder mellem trafikken og kan tolerere koldstart.

- Asynkron inferens endepunkter sætter indgående anmodninger i kø. De er ideelle til arbejdsbelastninger, hvor anmodningsstørrelserne er store (op til 1 GB), og behandlingstiden for slutninger er i størrelsesordenen minutter (op til 15 minutter). Asynkron inferens giver dig mulighed for at spare på omkostningerne ved automatisk at skalere instanstællingen til nul, når der ikke er nogen anmodninger at behandle.

Løsningsoversigt

I dette indlæg implementerer vi en PEGASUS model der var på forhånd trænet til at lave tekstresumé fra Knusende ansigt til SageMaker hostingtjenester. Vi bruger modellen som den er fra Hugging Face for enkelhedens skyld. Det kan du dog finjustere modellen baseret på et brugerdefineret datasæt. Du kan også prøve andre modeller tilgængelige i Hugging Face Model Hub. Vi leverer også et asynkront slutpunkt, der er vært for denne model, hvorfra du kan få forudsigelser.

Det asynkrone inferensendepunkts inferenshandler forventer en artikel som inputnyttelast. Artiklens opsummerede tekst er outputtet. Outputtet gemmes i databasen for at analysere tendenserne eller føres nedstrøms til yderligere analyser. Denne downstream-analyse udleder dataindsigt, der hjælper med forskningen.

Vi demonstrerer, hvordan asynkrone inferensendepunkter gør det muligt for dig at have brugerdefinerede samtidigheds- og afslutningsmeddelelser. Vi konfigurerer automatisk skalering af forekomster bag endepunktet til at skalere ned til nul, når trafikken aftager, og skalere op igen, når anmodningskøen fyldes op.

Vi bruger også amazoncloudwatch målinger til at overvåge køstørrelsen, den samlede behandlingstid og behandlede påkaldelser.

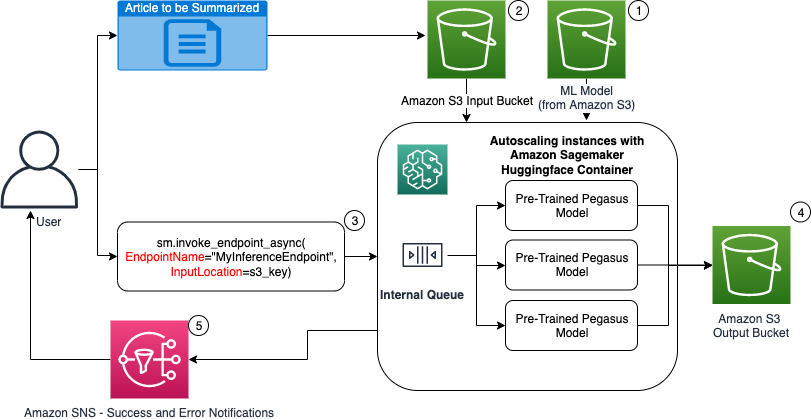

I det følgende diagram viser vi de involverede trin, mens vi udfører inferens ved hjælp af et asynkront inferensslutpunkt.

- Vores fortrænede PEGASUS ML-modellen hostes først på skaleringsendepunktet.

- Brugeren uploader artiklen for at blive opsummeret til en input S3-bøtte.

- Det asynkrone inferensslutpunkt påkaldes ved hjælp af en API.

- Når slutningen er fuldført, gemmes resultatet i output S3-bøtten.

- An Amazon Simple Notification Service (Amazon SNS) meddelelse sendes til brugeren med besked om den afsluttede succes eller fiasko.

Opret et asynkront inferensslutpunkt

Vi opretter det asynkrone inferensslutpunkt svarende til et realtidshostet slutpunkt. Trinene omfatter oprettelse af en SageMaker-model, efterfulgt af konfiguration af slutpunktet og implementering af slutpunktet. Forskellen mellem de to typer endepunkter er, at den asynkrone inferens endepunktskonfiguration indeholder en AsyncInferenceConfig afsnit. Her specificerer vi S3-outputstien for resultaterne fra slutpunktsindkaldelsen og inkluderer eventuelt SNS-emner for meddelelser om succes og fiasko. Vi angiver også det maksimale antal samtidige påkald pr. instans som bestemt af kunden. Se følgende kode:

For detaljer om API'et til at oprette en slutpunktskonfiguration til asynkron inferens, se Opret et asynkront inferensendepunkt.

Kald det asynkrone inferensslutpunkt

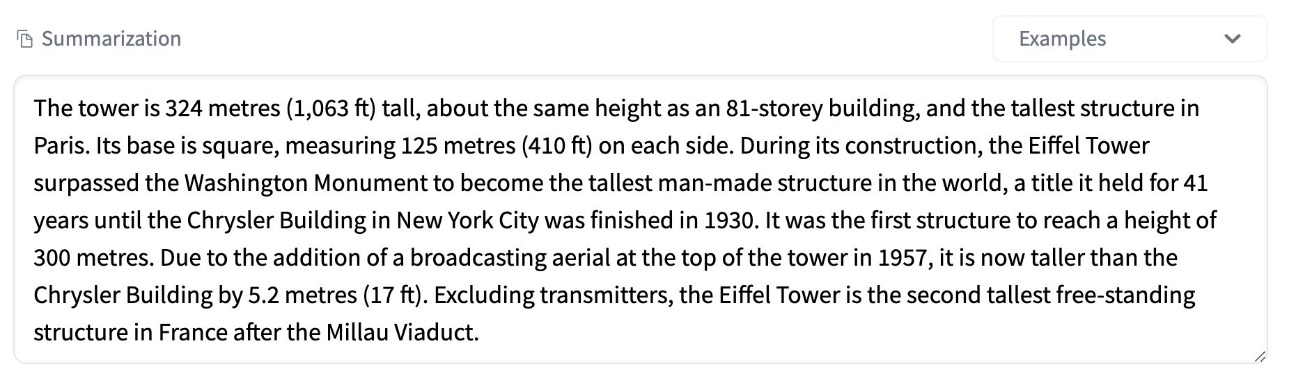

Følgende skærmbillede viser en kort artikel, som vi bruger som vores input-nyttelast:

Følgende kode uploader artiklen som en input.json fil til Amazon S3:

Vi bruger Amazon S3 URI til input-nyttelastfilen for at påkalde slutpunktet. Responsobjektet indeholder outputplaceringen i Amazon S3 for at hente resultaterne efter afslutning:

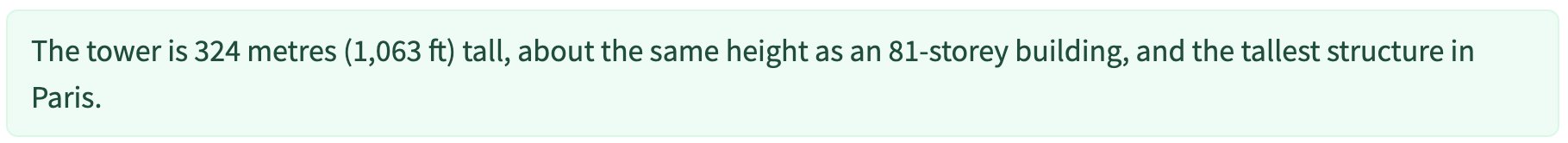

Følgende skærmbillede viser eksempeloutput efter opsummering:

For detaljer om API'et til at fremkalde et asynkront inferensslutpunkt, se Kald et asynkront inferensslutpunkt.

Sæt påkaldelsesanmodningerne i kø med brugerdefineret samtidighed

Det asynkrone inferensslutpunkt sætter automatisk påkaldelsesanmodningerne i kø. Dette er en fuldt administreret kø med forskellige overvågningsmetrikker og kræver ikke yderligere konfiguration. Den bruger MaxConcurrentInvocationsPerInstance parameter i den foregående slutpunktskonfiguration for at behandle nye anmodninger fra køen, efter at tidligere anmodninger er afsluttet. MaxConcurrentInvocationsPerInstance er det maksimale antal samtidige anmodninger sendt af SageMaker-klienten til modelbeholderen. Hvis der ikke er angivet nogen værdi, vælger SageMaker en optimal værdi for dig.

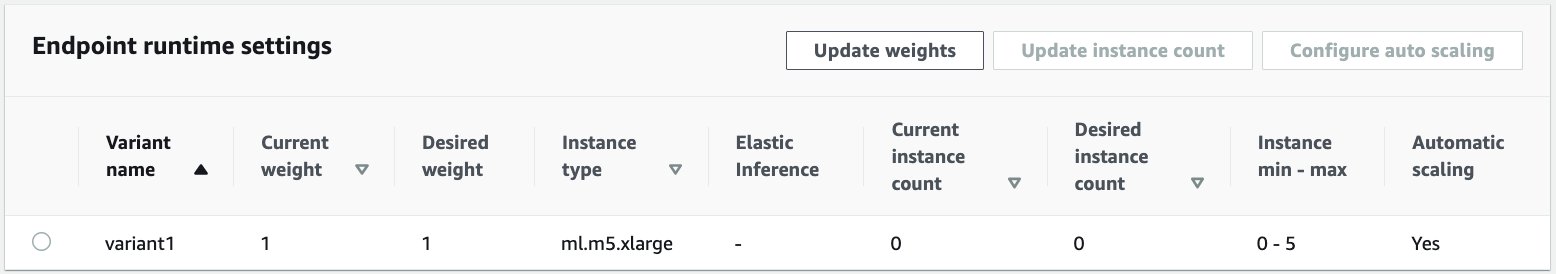

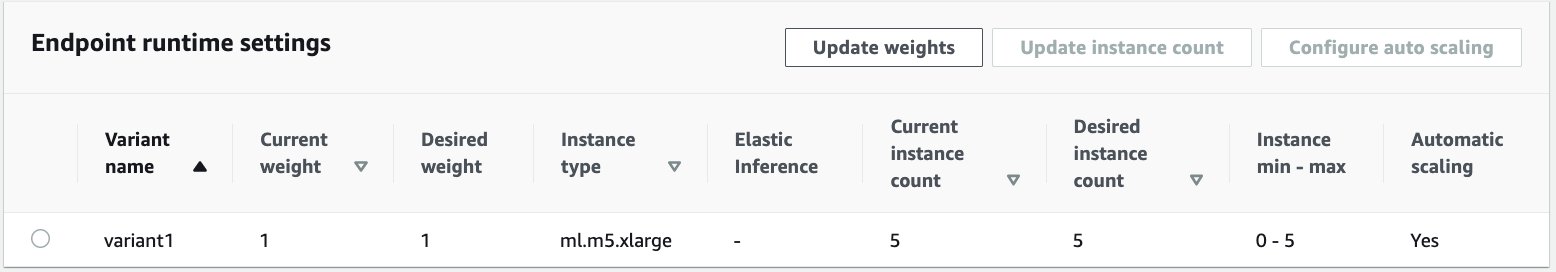

Autoskaleringsforekomster inden for det asynkrone inferensslutpunkt

Vi indstiller politikken for automatisk skalering med en minimumskapacitet på nul og en maksimal kapacitet på fem forekomster. I modsætning til hostede endepunkter i realtid understøtter asynkrone inferensslutpunkter nedskalering af forekomster til nul ved at indstille minimumskapaciteten til nul. Vi bruger ApproximateBacklogSizePerInstance metric for skaleringspolitikkonfigurationen med et målkøefterslæb på fem pr. instans for at skalere yderligere ud. Vi indstiller nedkølingsperioden for ScaleInCooldown til 120 sekunder og ScaleOutCooldown til 120 sekunder. Værdien for ApproximateBacklogSizePerInstance er valgt ud fra trafikken og din følsomhed over for skaleringshastighed. Jo hurtigere du skalerer ind, jo mindre omkostninger påløber du, men jo mere sandsynligt bliver du nødt til at skalere op igen, når der kommer nye anmodninger. Jo langsommere du skalerer ind, jo flere omkostninger påløber du, men det er mindre sandsynligt, at du får en anmodning kommer ind, når du er underskaleret.

For detaljer om API'et til automatisk skalering af et asynkront inferensslutpunkt, se Autoskaler et asynkront inferensendepunkt.

Konfigurer meddelelser fra det asynkrone inferensslutpunkt

Vi opretter to separate SNS-emner for succes og fejlmeddelelser for hvert resultat af slutpunktskald:

Andre muligheder for meddelelser omfatter periodisk kontrol af output fra S3-bøtten eller brug af S3-bøttemeddelelser til at initialisere en AWS Lambda funktion ved filupload. SNS-meddelelser er inkluderet i endepunktskonfigurationssektionen som tidligere beskrevet.

For detaljer om, hvordan du opsætter meddelelser fra et asynkront inferensslutpunkt, se Tjek forudsigelsesresultater.

Overvåg det asynkrone inferensendepunkt

Vi overvåger det asynkrone inferens-endepunkt med indbyggede yderligere CloudWatch-metrikker, der er specifikke for asynkron inferens. For eksempel overvåger vi kølængden i hver instans med ApproximateBacklogSizePerInstance og samlet kølængde med ApproximateBacklogSize.

Se en komplet liste over målinger Overvågning af asynkrone inferensendepunkter.

Vi kan optimere slutpunktskonfigurationen for at få den mest omkostningseffektive instans med høj ydeevne. For eksempel kan vi bruge en instans med Amazon Elastic Inference eller AWS Inferentia. Vi kan også gradvist øge samtidighedsniveauet op til gennemstrømningsspidsen, mens vi justerer andre modelserver- og containerparametre.

CloudWatch-grafer

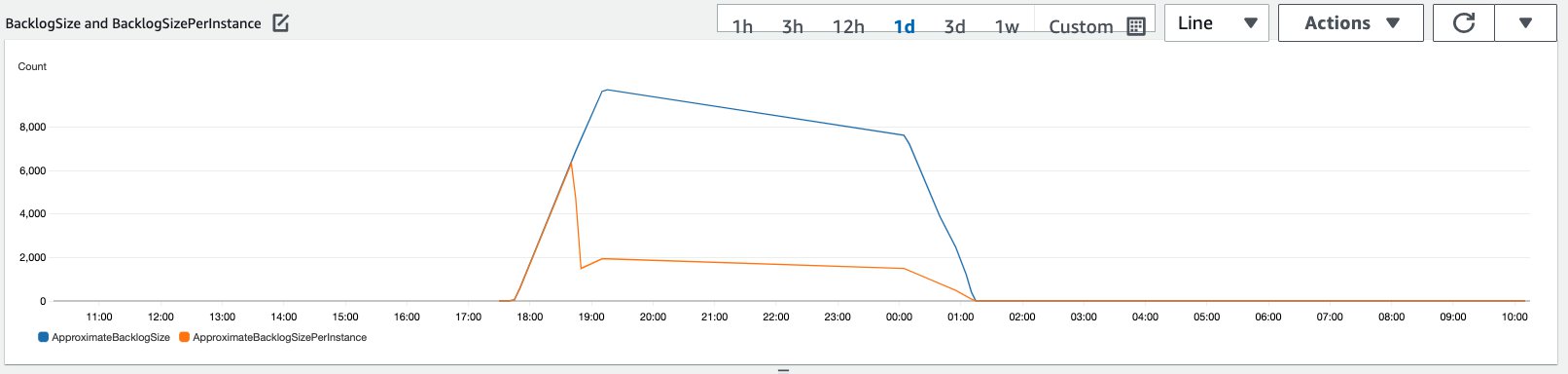

Vi simulerede en trafik på 10,000 slutningsanmodninger, der strømmer ind over en periode til det asynkrone slutningsendepunkt, der er aktiveret med den automatiske skaleringspolitik beskrevet i det foregående afsnit.

Følgende skærmbillede viser forekomstmålinger, før anmodninger begyndte at strømme ind. Vi starter med et live-slutpunkt, hvor nul forekomster kører:

Følgende graf viser, hvordan BacklogSize , BacklogSizePerInstance metrics ændres, efterhånden som den automatiske skalering starter, og belastningen på slutpunktet deles af flere forekomster, der blev klargjort som en del af den automatiske skaleringsprocessen.

Som vist på det følgende skærmbillede steg antallet af tilfælde, efterhånden som slutningsantallet blev skaleret op:

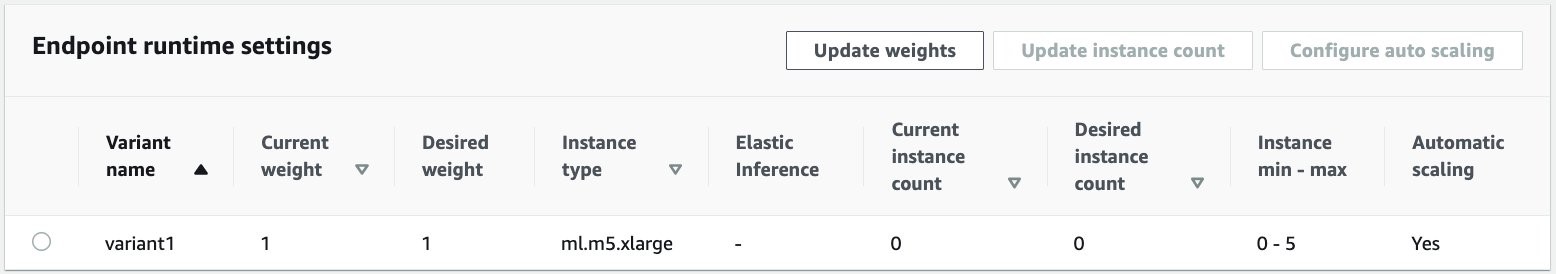

Følgende skærmbillede viser, hvordan indskaleringen bringer slutpunktet tilbage til starttilstanden med nul kørende forekomster:

Ryd op

Når alle anmodninger er afsluttet, kan vi slette slutpunktet svarende til sletning af hostede realtidsslutpunkter. Bemærk, at hvis vi sætter minimumskapaciteten for asynkrone inferensendepunkter til nul, er der ingen instansafgifter, der påløber, efter at den er nedskaleret til nul.

Hvis du aktiverede automatisk skalering for dit endepunkt, skal du sørge for at afregistrere endepunktet som et skalerbart mål, før du sletter endepunktet. For at gøre dette skal du køre følgende kode:

Husk at slette dit slutpunkt efter brug, da du vil blive opkrævet for de tilfælde, der bruges i denne demo.

Du skal også slette S3-objekter og SNS-emner. Hvis du har oprettet andre AWS-ressourcer til at forbruge og handle på SNS-meddelelserne, vil du måske også slette dem.

Konklusion

I dette indlæg demonstrerede vi, hvordan man bruger den nye asynkrone slutningsevne fra SageMaker til at behandle en typisk stor input-nyttelast, der er en del af en opsummeringsopgave. Til inferens brugte vi en model fra Hugging Face og implementerede den på asynkront inferensslutpunkt. Vi forklarede de almindelige udfordringer med burst-trafik, høje modelbehandlingstider og store nyttelaster involveret i forskningsanalyse. Det asynkrone inferensendepunkts iboende evne til at administrere interne køer, foruddefinerede samtidighedsgrænser, konfigurere svarmeddelelser og automatisk skalere ned til nul hjalp os med at løse disse udfordringer. Den komplette kode for dette eksempel er tilgængelig på GitHub.

For at komme i gang med SageMaker asynkron inferens, tjek ud Asynkron inferens.

Om forfatterne

Dinesh Kumar Subramani er Senior Solutions Architect hos UKIR SMB-teamet med base i Edinburgh, Skotland. Han har specialiseret sig i kunstig intelligens og maskinlæring. Dinesh nyder at arbejde med kunder på tværs af brancher for at hjælpe dem med at løse deres problemer med AWS-tjenester. Uden for arbejdet elsker han at tilbringe tid med sin familie, spille skak og nyde musik på tværs af genrer.

Dinesh Kumar Subramani er Senior Solutions Architect hos UKIR SMB-teamet med base i Edinburgh, Skotland. Han har specialiseret sig i kunstig intelligens og maskinlæring. Dinesh nyder at arbejde med kunder på tværs af brancher for at hjælpe dem med at løse deres problemer med AWS-tjenester. Uden for arbejdet elsker han at tilbringe tid med sin familie, spille skak og nyde musik på tværs af genrer.

Raghu Ramesha er en ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

Raghu Ramesha er en ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

- Coinsmart. Europas bedste Bitcoin og Crypto Exchange.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. FRI ADGANG.

- CryptoHawk. Altcoin radar. Gratis prøveversion.

- Kilde: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- tværs

- Handling

- aktivitet

- Yderligere

- adresse

- fremskreden

- AI

- Alle

- Amazon

- beløb

- analyse

- analytics

- En anden

- api

- Anvendelse

- applikationer

- artikel

- artikler

- kunstig

- kunstig intelligens

- Kunstig intelligens og maskinlæring

- auto

- til rådighed

- gennemsnit

- AWS

- grundlag

- være

- grænse

- bygge

- indbygget

- virksomhed

- business intelligence

- Kan få

- kapaciteter

- Kapacitet

- tilfælde

- udfordringer

- lave om

- opladet

- afgifter

- kontrol

- skak

- Rengøring

- kode

- Fælles

- Virksomheder

- konkurrenter

- Datalogi

- Konfiguration

- forbruge

- Container

- Beholdere

- indeholder

- omkostningseffektiv

- Omkostninger

- Oprettelse af

- Kunder

- Dallas

- data

- Database

- dag

- deal

- dedikeret

- indsætte

- implementering

- Detektion

- udviklere

- forskellige

- Sygdom

- dokumenter

- Er ikke

- Domæner

- ned

- Tidligt

- Effektiv

- Endpoint

- etableret

- eksempel

- forventer

- udgifter

- Ansigtet

- Manglende

- familie

- hurtigere

- Fed

- finansielle

- finansielle tjenesteydelser

- Fornavn

- efter

- format

- formularer

- Gratis

- funktion

- fonde

- generere

- stor

- Vækst

- Helse

- sundhedspleje

- Hedgefonde

- hjælpe

- hjælper

- link.

- Høj

- besidder

- Hvordan

- How To

- HTTPS

- identificere

- Forbedre

- omfatter

- medtaget

- Forøg

- øget

- industrier

- industrien

- oplysninger

- indsigt

- Intelligens

- investering

- involverede

- spørgsmål

- IT

- Sprog

- stor

- læring

- Led

- Niveau

- Liste

- belastning

- placering

- Lang

- maskine

- machine learning

- ledelse

- Markeder

- Metrics

- ML

- model

- modeller

- overvågning

- mest

- MS

- Musik

- Natural

- underretning

- bemyndigende

- Muligheder

- Option

- Indstillinger

- ordrer

- Andet

- ydeevne

- perioder

- fotografering

- politik

- portefølje

- forudsigelse

- Forudsigelser

- Forebyggelse

- Eksempel

- primære

- private

- problemer

- behandle

- produktion

- projekter

- give

- giver

- offentlige

- formål

- kvalitet

- hurtigt

- Rampe

- realtid

- modtage

- reducere

- kræver

- Krav

- forskning

- ressource

- Ressourcer

- svar

- Resultater

- Kør

- kører

- skalerbar

- Scale

- skalering

- Videnskab

- forskere

- sekundær

- sektor

- Serverless

- tjeneste

- Tjenester

- sæt

- indstilling

- delt

- lignende

- Simpelt

- Størrelse

- Løsninger

- SOLVE

- specialiseret

- hastighed

- udgifterne

- starte

- påbegyndt

- starter

- Tilstand

- Status

- forblive

- opbevaring

- butik

- strategier

- succes

- support

- Understøtter

- systemet

- mål

- opgaver

- hold

- tid

- sammen

- Emner

- Sporing

- Trafik

- behandling

- Tendenser

- forstå

- us

- brug

- sædvanligvis

- værdi

- vision

- hvorvidt

- inden for

- Arbejde

- arbejder

- skrivning

- nul