Kunstig intelligens (AI) er et felt i hastig udvikling med potentiale til at forbedre og transformere mange aspekter af samfundet. I 2023 er tempoet for vedtagelse af AI-teknologier accelereret yderligere med udviklingen af kraftfulde fundamentmodeller (FM'er) og en deraf følgende fremgang inden for generative AI-kapaciteter.

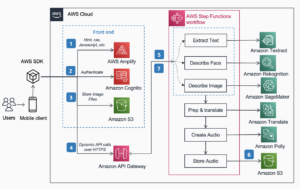

Hos Amazon har vi lanceret flere generative AI-tjenester, som f.eks Amazonas grundfjeld , Amazon Code Whisperer, og har gjort en række yderst dygtige generative modeller tilgængelige gennem Amazon SageMaker JumpStart. Disse tjenester er designet til at støtte vores kunder i at låse op for de nye muligheder inden for generativ AI, herunder forbedret kreativitet, personlig og dynamisk indholdsskabelse og innovativt design. De kan også gøre det muligt for AI-udøvere at få mening i verden som aldrig før – adressering af sprogbarrierer, klimaændringer, accelererende videnskabelige opdagelser og meget mere.

For at realisere det fulde potentiale af generativ AI er det dog vigtigt at reflektere omhyggeligt over eventuelle potentielle risici. Først og fremmest gavner dette AI-systemets interessenter ved at fremme ansvarlig og sikker udvikling og udrulning og ved at tilskynde til vedtagelse af proaktive foranstaltninger for at imødegå potentielle konsekvenser. Derfor er etablering af mekanismer til at vurdere og styre risiko en vigtig proces for AI-udøvere at overveje og er blevet en kernekomponent i mange nye AI-industristandarder (f. ISO 42001, ISO 23894og NIST RMF) og lovgivning (som f.eks EU's AI-lov).

I dette indlæg diskuterer vi, hvordan du vurderer den potentielle risiko ved dit AI-system.

Hvad er de forskellige risikoniveauer?

Selvom det kan være lettere at begynde at se på en individuel maskinlæringsmodel (ML) og de tilhørende risici isoleret, er det vigtigt at overveje detaljerne i den specifikke anvendelse af en sådan model og den tilsvarende brugssag som en del af et komplet AI-system . Faktisk er et typisk AI-system sandsynligvis baseret på flere forskellige ML-modeller, der arbejder sammen, og en organisation søger måske at bygge flere forskellige AI-systemer. Som følge heraf kan risici evalueres for hver use case og på forskellige niveauer, nemlig modelrisiko, AI-systemrisiko og virksomhedsrisiko.

Virksomhedsrisiko omfatter det brede spektrum af risici, som en organisation kan stå over for, herunder finansielle, operationelle og strategiske risici. AI-systemrisiko fokuserer på påvirkningen forbundet med implementering og drift af AI-systemer, hvorimod ML-modelrisiko specifikt vedrører de sårbarheder og usikkerheder, der er iboende i ML-modeller.

I dette indlæg fokuserer vi primært på AI-systemrisiko. Det er dog vigtigt at bemærke, at alle forskellige niveauer af risikostyring i en organisation bør overvejes og tilpasses.

Hvordan defineres AI-systemrisiko?

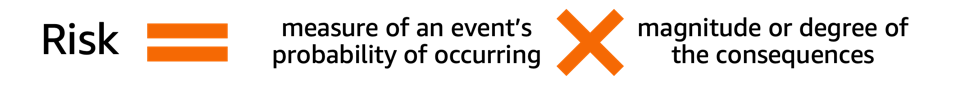

Risikostyring i forbindelse med et AI-system kan være en vej til at minimere effekten af usikkerhed eller potentielle negative påvirkninger, samtidig med at det giver muligheder for at maksimere positive påvirkninger. Risiko i sig selv er ikke en potentiel skade, men effekten af usikkerhed på mål. Ifølge NIST Risk Management Framework (NIST RMF), kan risiko estimeres som et multiplikativt mål for en hændelses sandsynlighed for at indtræffe, timet efter størrelsen af konsekvenserne af den tilsvarende hændelse.

Der er to aspekter af risiko: iboende risiko og resterende risiko. Iboende risiko repræsenterer mængden af risiko, som AI-systemet udviser i fravær af begrænsninger eller kontroller. Restrisiko fanger de resterende risici efter indregning i afbødningsstrategier.

Husk altid på, at risikovurdering er en menneskecentreret aktivitet, der kræver indsats i hele organisationen; disse bestræbelser spænder fra at sikre, at alle relevante interessenter er inkluderet i vurderingsprocessen (såsom produkt-, teknik-, videnskabs-, salgs- og sikkerhedsteams) til at vurdere, hvordan sociale perspektiver og normer påvirker den opfattede sandsynlighed for og konsekvenser af visse begivenheder.

Hvorfor skal din organisation bekymre sig om risikoevaluering?

Etablering af risikostyringsrammer for AI-systemer kan gavne samfundet som helhed ved at fremme sikkert og ansvarligt design, udvikling og drift af AI-systemer. Risikostyringsrammer kan også gavne organisationer gennem følgende:

- Forbedret beslutningstagning – Ved at forstå de risici, der er forbundet med AI-systemer, kan organisationer træffe bedre beslutninger om, hvordan de kan mindske disse risici og bruge AI-systemer på en sikker og ansvarlig måde

- Øget compliance planlægning – En risikovurderingsramme kan hjælpe organisationer med at forberede sig på risikovurderingskrav i relevante love og regler

- Opbygning af tillid – Ved at demonstrere, at de tager skridt til at mindske risiciene ved AI-systemer, kan organisationer vise deres kunder og interessenter, at de er forpligtet til at bruge AI på en sikker og ansvarlig måde

Hvordan vurderer man risiko?

Som et første skridt bør en organisation overveje at beskrive den AI-brugssag, der skal vurderes, og identificere alle relevante interessenter. En use case er et specifikt scenarie eller en situation, der beskriver, hvordan brugere interagerer med et AI-system for at opnå et bestemt mål. Når du opretter en use case-beskrivelse, kan det være nyttigt at specificere det forretningsproblem, der skal løses, liste de involverede interessenter, karakterisere arbejdsgangen og give detaljer vedrørende vigtige input og output af systemet.

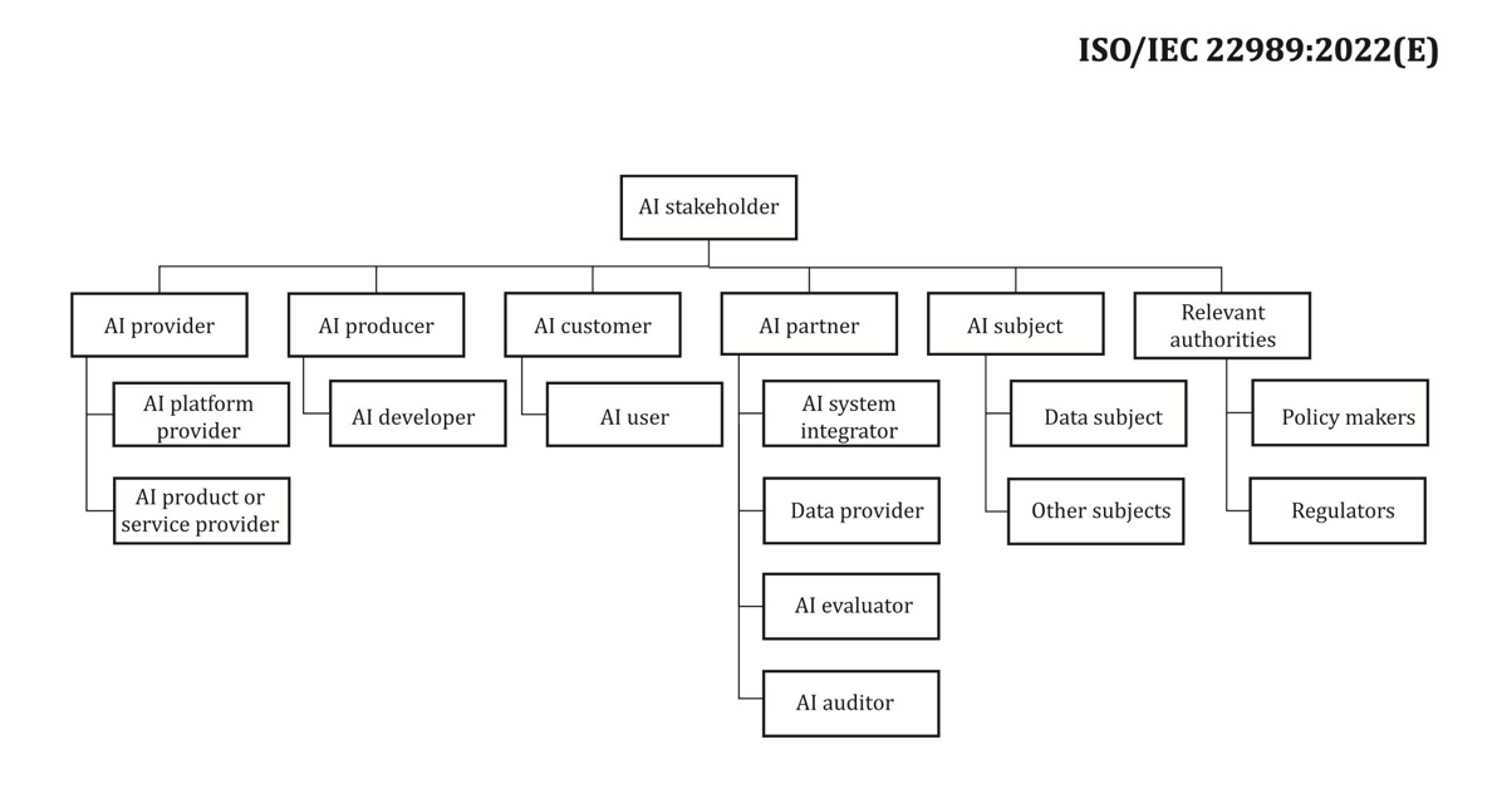

Når det kommer til interessenter, er det nemt at overse nogle. Følgende figur er et godt udgangspunkt for at kortlægge AI-interessenterroller.

Kilde: “Informationsteknologi – Kunstig intelligens – Kunstig intelligens begreber og terminologi”.

Et vigtigt næste trin i AI-systemets risikovurdering er at identificere potentielt skadelige hændelser forbundet med brugssagen. Når man overvejer disse begivenheder, kan det være nyttigt at reflektere over forskellige dimensioner af ansvarlig AI, såsom retfærdighed og robusthed, for eksempel. Forskellige interessenter kan blive påvirket i forskellig grad langs forskellige dimensioner. For eksempel kan en lav robusthedsrisiko for en slutbruger være resultatet af et AI-system, der udviser mindre afbrydelser, hvorimod en lav fairness-risiko kan være forårsaget af et AI-system, der producerer ubetydeligt forskellige output for forskellige demografiske grupper.

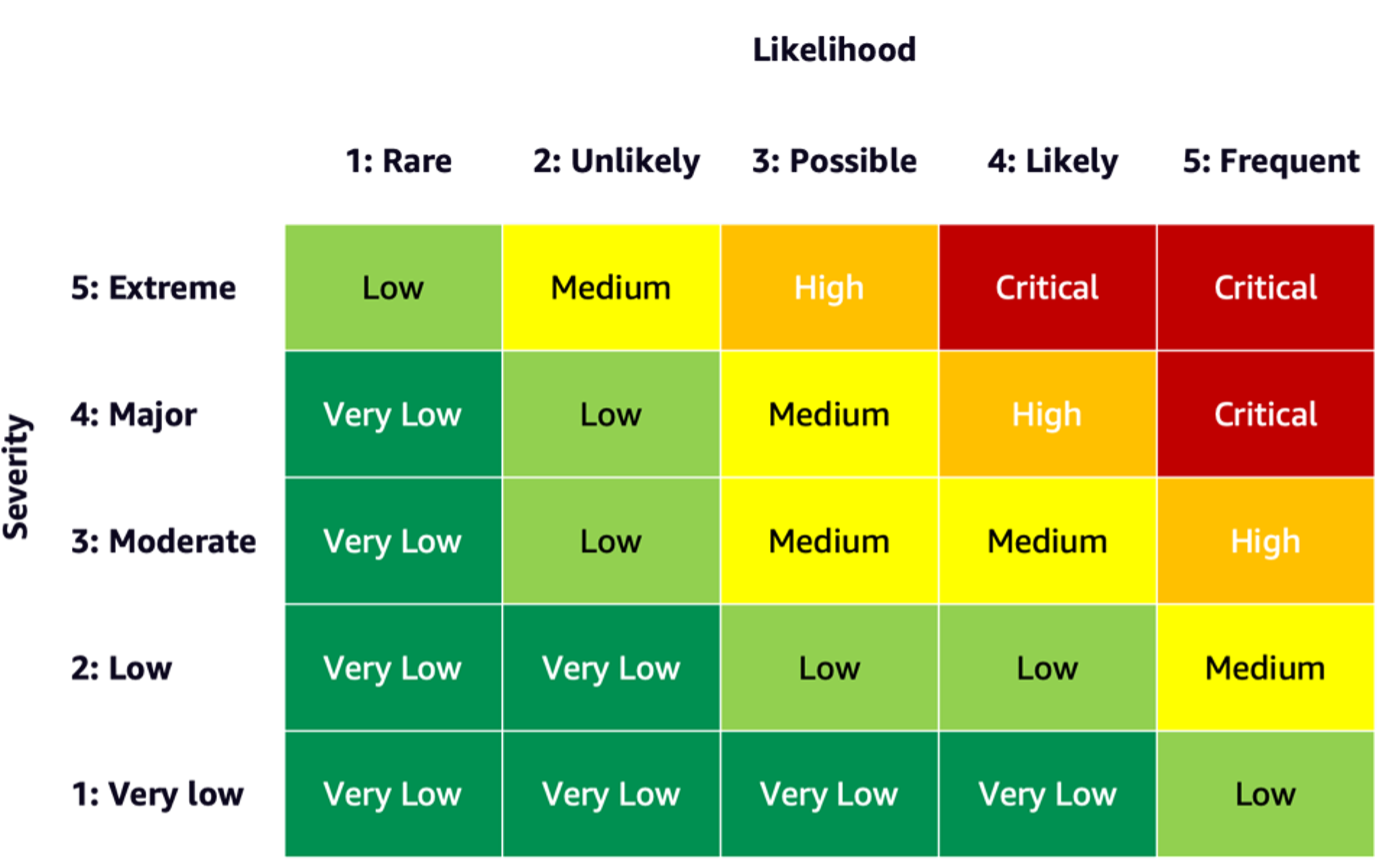

For at estimere risikoen for en hændelse kan du bruge en sandsynlighedsskala i kombination med en alvorlighedsskala til at måle sandsynligheden for hændelsen samt graden af konsekvenser. Et nyttigt udgangspunkt ved udvikling af disse skalaer kan være NIST RMF, som foreslår at bruge kvalitative ikke-numeriske kategorier, der spænder fra meget lav til meget høj risiko eller semi-kvantitative vurderingsprincipper, såsom skalaer (såsom 1-10), skraldespande eller andet repræsentative tal. Når du har defineret sandsynligheds- og alvorlighedsskalaerne for alle relevante dimensioner, kan du bruge et risikomatrixskema til at kvantificere den samlede risiko pr. interessent langs hver relevant dimension. Følgende figur viser et eksempel på en risikomatrix.

Ved at bruge denne risikomatrix kan vi betragte en hændelse med lav sværhedsgrad og sjælden sandsynlighed for at indtræffe som meget lav risiko. Husk, at den indledende vurdering vil være et estimat af iboende risiko, og risikobegrænsende strategier kan hjælpe med at sænke risikoniveauet yderligere. Processen kan derefter gentages for at generere en vurdering for en eventuel resterende risiko pr. hændelse. Hvis der er flere hændelser identificeret langs den samme dimension, kan det være nyttigt at vælge det højeste risikoniveau blandt alle for at skabe et endeligt vurderingsresumé.

Ved at bruge det endelige vurderingsresumé skal organisationer definere, hvilke risikoniveauer der er acceptable for deres AI-systemer, samt overveje relevante regler og politikker.

AWS engagement

Gennem engagementer med Hvide Hus , UNVi er blandt andet forpligtet til at dele vores viden og ekspertise for at fremme ansvarlig og sikker brug af kunstig intelligens. På denne måde repræsenterede Amazons Adam Selipsky for nylig AWS på AI Safety Summit med stats- og industriledere til stede, hvilket yderligere demonstrerer vores dedikation til at samarbejde om ansvarlig fremme af kunstig intelligens.

Konklusion

Efterhånden som AI fortsætter med at udvikle sig, bliver risikovurdering stadig vigtigere og nyttigere for organisationer, der ønsker at bygge og implementere AI på en ansvarlig måde. Ved at etablere en risikovurderingsramme og risikoreduktionsplan kan organisationer reducere risikoen for potentielle AI-relaterede hændelser og opnå tillid hos deres kunder, samt høste fordele såsom forbedret pålidelighed, forbedret retfærdighed for forskellige demografiske forhold og mere.

Gå videre og kom i gang på din rejse med at udvikle en risikovurderingsramme i din organisation, og del dine tanker i kommentarerne.

Se også en oversigt over generative AI-risici offentliggjort på Amazon Science: Ansvarlig AI i den generative æra, og udforsk rækken af AWS-tjenester, der kan støtte dig på din risikovurdering og afbødningsrejse: Amazon SageMaker Clarify, Amazon SageMaker Model Monitor, AWS CloudTrail, Samt modelstyringsramme.

Om forfatterne

Mia C. Mayer er en Applied Scientist og ML-underviser ved AWS Machine Learning University; hvor hun forsker i og underviser i sikkerhed, forklarlighed og retfærdighed af Machine Learning og AI-systemer. Gennem hele sin karriere etablerede Mia adskillige opsøgende universitetsprogrammer, fungerede som gæsteforelæser og hovedtaler og præsenterede på adskillige store læringskonferencer. Hun hjælper også interne teams og AWS-kunder med at komme i gang med deres ansvarlige AI-rejse.

Mia C. Mayer er en Applied Scientist og ML-underviser ved AWS Machine Learning University; hvor hun forsker i og underviser i sikkerhed, forklarlighed og retfærdighed af Machine Learning og AI-systemer. Gennem hele sin karriere etablerede Mia adskillige opsøgende universitetsprogrammer, fungerede som gæsteforelæser og hovedtaler og præsenterede på adskillige store læringskonferencer. Hun hjælper også interne teams og AWS-kunder med at komme i gang med deres ansvarlige AI-rejse.

Denis V. Batalov er en 17-årig Amazon-veteran og en PhD i Machine Learning, arbejdede Denis på så spændende projekter som Search Inside the Book, Amazon Mobile apps og Kindle Direct Publishing. Siden 2013 har han hjulpet AWS-kunder med at adoptere AI/ML-teknologi som Solutions Architect. I øjeblikket er Denis en Worldwide Tech Leader for AI/ML ansvarlig for driften af AWS ML Specialist Solutions Architects globalt. Denis er en hyppig offentlig taler, du kan følge ham på Twitter @dbatalov.

Denis V. Batalov er en 17-årig Amazon-veteran og en PhD i Machine Learning, arbejdede Denis på så spændende projekter som Search Inside the Book, Amazon Mobile apps og Kindle Direct Publishing. Siden 2013 har han hjulpet AWS-kunder med at adoptere AI/ML-teknologi som Solutions Architect. I øjeblikket er Denis en Worldwide Tech Leader for AI/ML ansvarlig for driften af AWS ML Specialist Solutions Architects globalt. Denis er en hyppig offentlig taler, du kan følge ham på Twitter @dbatalov.

Dr. Sara Liu er Senior Technical Program Manager hos AWS Responsible AI-teamet. Hun arbejder med et team af videnskabsmænd, datasætledere, ML-ingeniører, forskere samt andre tværfunktionelle teams for at hæve den ansvarlige AI-bar på tværs af AWS AI-tjenester. Hendes nuværende projekter involverer udvikling af AI-servicekort, udførelse af risikovurderinger for ansvarlig AI, oprettelse af evalueringsdatasæt af høj kvalitet og implementering af kvalitetsprogrammer. Hun hjælper også interne teams og kunder med at opfylde udviklende AI-industristandarder.

Dr. Sara Liu er Senior Technical Program Manager hos AWS Responsible AI-teamet. Hun arbejder med et team af videnskabsmænd, datasætledere, ML-ingeniører, forskere samt andre tværfunktionelle teams for at hæve den ansvarlige AI-bar på tværs af AWS AI-tjenester. Hendes nuværende projekter involverer udvikling af AI-servicekort, udførelse af risikovurderinger for ansvarlig AI, oprettelse af evalueringsdatasæt af høj kvalitet og implementering af kvalitetsprogrammer. Hun hjælper også interne teams og kunder med at opfylde udviklende AI-industristandarder.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- :har

- :er

- :ikke

- :hvor

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- Om

- accelereret

- accelererende

- acceptabel

- Ifølge

- opnå

- tværs

- aktivitet

- Adam

- adresse

- vedtage

- Vedtagelse

- fremme

- fremgang

- påvirket

- Efter

- forude

- AI

- AI-risici

- AI-tjenester

- AI-systemer

- AI / ML

- justeret

- Alle

- sammen

- også

- Amazon

- Amazon Web Services

- blandt

- beløb

- an

- ,

- enhver

- Anvendelse

- anvendt

- apps

- arkitekter

- ER

- kunstig

- kunstig intelligens

- AS

- aspekter

- vurdere

- vurderes

- Vurdering

- vurdering

- vurderinger

- forbundet

- At

- fremmøde

- til rådighed

- AWS

- AWS maskinindlæring

- Bar

- barrierer

- baseret

- BE

- bliver

- blive

- være

- gavner det dig

- fordele

- Bedre

- siloer

- bog

- bred

- bygge

- virksomhed

- men

- by

- CAN

- kapaciteter

- stand

- fanger

- Kort

- hvilken

- Karriere

- omhyggeligt

- tilfælde

- kategorier

- forårsagede

- vis

- lave om

- karakterisere

- kontrollere

- Klima

- Klima forandring

- samarbejde

- kombination

- kommer

- kommentarer

- engageret

- fuldføre

- Compliance

- komponent

- begreber

- udførelse

- konferencer

- Konsekvenser

- følgelig

- Overvej

- betragtes

- Overvejer

- indhold

- indholdsskabelse

- sammenhæng

- fortsætter

- kontrol

- Core

- Tilsvarende

- kunne

- skabe

- Oprettelse af

- skabelse

- kreativitet

- tværgående teams

- Nuværende

- For øjeblikket

- Kunder

- datasæt

- afgørelser

- dedikation

- definere

- definerede

- Degree

- demografiske

- Demografi

- demonstrerer

- indsætte

- implementering

- beskriver

- beskrivelse

- Design

- konstrueret

- detaljer

- udvikling

- Udvikling

- forskellige

- Dimension

- størrelse

- direkte

- diskutere

- forstyrrelser

- dynamisk

- hver

- tjene

- lettere

- let

- effekt

- indsats

- smergel

- muliggøre

- vedrører generelt

- tilskynde

- engagementer

- Engineering

- Ingeniører

- forbedret

- sikring

- Enterprise

- etableret

- oprettelse

- skøn

- anslået

- evalueret

- evaluering

- begivenhed

- begivenheder

- udviklende

- eksempel

- spændende

- Udviser

- udstillinger

- ekspertise

- udforske

- Ansigtet

- Faktisk

- factoring

- fairness

- felt

- Figur

- endelige

- finansielle

- Fornavn

- Fokus

- fokuserer

- følger

- efter

- Til

- fremmest

- Foundation

- Framework

- rammer

- hyppig

- fra

- fuld

- fungerer

- yderligere

- generere

- generative

- Generativ AI

- få

- Globalt

- mål

- godt

- regeringsførelse

- Gruppens

- Gæst

- skade

- skadelig

- Have

- he

- hoveder

- hjælpe

- hjulpet

- hjælpsom

- hjælper

- hende

- Høj

- høj kvalitet

- højeste

- stærkt

- ham

- Hvordan

- How To

- Men

- HTML

- HTTPS

- identificeret

- identificere

- if

- KIMOs Succeshistorier

- Påvirkninger

- implementering

- gennemføre

- vigtigt

- Forbedre

- forbedret

- in

- medtaget

- Herunder

- stigende

- individuel

- industrien

- industristandarder

- indflydelse

- iboende

- initial

- innovativ

- indgange

- indvendig

- Intelligens

- interagere

- interne

- involvere

- involverede

- ISO

- isolation

- IT

- selv

- rejse

- jpg

- Holde

- Nøgle

- Keynote

- Hovedtaler

- viden

- Sprog

- stor

- lanceret

- Love

- leder

- ledere

- Leads

- LÆR

- læring

- Lovgivning

- Niveau

- niveauer

- sandsynlighed

- Sandsynlig

- linjer

- Liste

- leder

- Lav

- lavere

- maskine

- machine learning

- lavet

- lave

- administrere

- ledelse

- leder

- mange

- kort

- Matrix

- Maksimer

- Kan..

- måle

- foranstaltninger

- mekanismer

- Mød

- måske

- tankerne

- mindre

- afbøde

- afbødning

- ML

- Mobil

- mobil-apps

- model

- modeller

- mere

- flere

- nemlig

- behov

- negativ

- aldrig

- næste

- NIST

- normer

- Bemærk

- numre

- talrige

- målsætninger

- Hændelse

- forekommende

- of

- on

- drift

- operationelle

- Muligheder

- or

- organisation

- organisationer

- Andet

- Andre

- Ellers

- vores

- ud

- udgange

- opsøgende

- samlet

- oversigt

- Tempo

- del

- særlig

- sti

- per

- opfattet

- Personlig

- perspektiver

- phd

- pick

- fly

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- politikker

- positiv

- Indlæg

- potentiale

- potentielt

- vigtigste

- Forbered

- forelagt

- primært

- principper

- Proaktiv

- Problem

- behandle

- producerer

- Produkt

- Program

- Programmer

- projekter

- Fremme

- give

- leverer

- offentlige

- offentliggjort

- Publicering

- kvalitative

- kvalitet

- rejse

- rækkevidde

- spænder

- hurtigt

- SJÆLDEN

- bedømmelse

- indse

- høste

- for nylig

- reducere

- afspejler

- om

- regler

- relevant

- pålidelighed

- resterende

- gentaget

- repræsentativt

- repræsenteret

- repræsenterer

- Krav

- Kræver

- forskere

- forsker

- ansvarlige

- ansvarligt

- resultere

- resulterer

- Risiko

- risikovurdering

- risikostyring

- risici

- robusthed

- roller

- sikker

- Sikkerhed

- sagemaker

- salg

- samme

- Scale

- skalaer

- scenarie

- Ordningen

- Videnskab

- videnskabelig

- Videnskabsmand

- forskere

- Søg

- sikker

- sikkerhed

- senior

- forstand

- tjeneste

- Tjenester

- flere

- Del

- deling

- hun

- bør

- Vis

- Shows

- siden

- Situationen

- Social

- Samfund

- Løsninger

- nogle

- Højttaler

- specialist

- specifikke

- specifikt

- Spectrum

- interessent

- interessenter

- standarder

- starte

- påbegyndt

- Starter

- Tilstand

- Trin

- Steps

- Strategisk

- strategier

- sådan

- foreslår

- RESUMÉ

- support

- systemet

- Systemer

- tager

- hold

- hold

- tech

- Teknisk

- Teknologier

- Teknologier

- at

- verdenen

- deres

- derefter

- Der.

- Disse

- de

- denne

- dem

- Gennem

- hele

- Tidsindstillet

- til

- sammen

- Transform

- Stol

- to

- typisk

- usikkerheder

- Usikkerhed

- forståelse

- universitet

- oplåsning

- brug

- brug tilfælde

- brugere

- ved brug af

- meget

- veteran

- Sårbarheder

- we

- web

- webservices

- GODT

- Hvad

- hvornår

- ud fra følgende betragtninger

- som

- mens

- vilje

- med

- inden for

- arbejdede

- workflow

- arbejder

- virker

- world

- verdensplan

- Du

- Din

- zephyrnet