Ja.. Jeg taler om AI-applikationerne - vores utallige AI-applikationer og kommende, der hvisker til mennesker om, hvad de skal gøre... hvordan man gør det...men ikke om de hviskende, der interagerer med AI-chatbots.

Ifølge IDC forudsigelser, kan det globale AI-marked nå op på over 500 milliarder dollars i 2024 – en stigning på mere end 50 % fra 2021. Dette indikerer, at vi gik fra forretningseksperimenter til at acceptere, at det er en integreret del af virksomhedens strategi for alle størrelser. Det er et nødvendigt værktøj til at omdanne data til indsigt for at sætte gang i handling baseret på bedre beslutninger. Ingen diskuterer fordelene ved AI for at mindske forretningsrisici og forstærke ROI med innovation. Men som altid er der et …MEN… den upartiske AI er lettere sagt end gjort.

Disse AI-modeller, der er kritiske for virksomheden, skal fungere pålideligt med synlighed og ansvarlighed. Ellers har fiasko i dette tilfælde alvorlige konsekvenser, der påvirker enhver virksomheds pengestrømme og kan endda resultere i juridiske spørgsmål. Den eneste måde at undgå dette på er automatisering og gennemsigtighed for at besvare ét spørgsmål "Kan du bevise, at denne AI-applikation/arbejdsbelastning er bygget etisk." Aka...hvordan regerer du? Og kan du bevise, at det bliver styret løbende?

Det er her, virksomheder kan lide IBM har investeret i AI-styring for at orkestrere den overordnede proces med at lede, administrere og overvåge organisationens AI-aktiviteter. Den primære opgave er at sikre, at alle forretningsenheder forbliver proaktive og indgyder styringsrammen i initiativerne for at styrke evnen til at leve op til etiske principper og regler. Især regulerede industrier som bank og finansielle tjenesteydelser er juridisk forpligtet til at levere beviser for at tilfredsstille tilsynsmyndigheder.

Indflydelsen fra AI vokser eksponentielt i sektoren for finansielle tjenesteydelser på grund af det enorme pres fra digital transformation. Som sagt er det lettere sagt end gjort, fordi:

1. Driftssikkert operationaliser AI-apps:

I nogle tilfælde bygges modeller uden klarhed og katalogisering; Det er overflødigt at sige, at overvågning glider væk midt i alt for at spore livscyklussen fra ende til ende. Mens banker kæmper med ældre applikationer, blev det sværere at automatisere processerne for at skabe gennemsigtighed og forklarlighed og til gengæld en sort boks. Ingen ved hvorfor/hvordan beslutninger blev truffet. De nye apps, der er sammenfiltret med ældre apps, ser aldrig dagslyset, selvom der er forbundet et enormt ROI med det på grund af kvalitet og uopfattede risici.

Det bringer os til vores andet punkt – styring af omdømmerisikoen

2. Håndter omdømmerisiko sammen med den overordnede risiko

jeg har spurgt #chatGPT , #Bard – hvem er Padma Chukka. #ChatGPT nægtede at svare, selvom jeg ændrede spørgsmålet på flere måder. Alligevel gav Bard mig et detaljeret svar, inklusive min LinkedIn-profil ... men data er fra forskellige websteder, hvor min gamle profil stadig eksisterer som en del af højttalerens bios. Fra det tidspunkt skal jeg endnu ikke åbne Bard. Så hurtigt blev jeg slukket, aka – Omdømmerisiko. Antag, at jeg kan slå en simpel chatbot fra, når jeg indser, at dataene kan være inkonsekvente. Hvordan kunne jeg ikke være sikker, før jeg besluttede mig for at købe en AI-infunderet applikation til at drive kritisk forretning? Omdømmerisiko er en væsentlig faktor, som virksomheder nogle gange glemmer. Hvis du kvantificerer omdømmerisikoen, kan man se den enorme indvirkning på virksomheden, hvis man ikke er proaktiv.

For at øge kompleksiteten er den tredje...

3. Hvordan kan en virksomhed reagere på ændrede AI-regler?

For at undgå risikoen for omdømme bør et succesfuldt og ansvarligt AI-team være opmærksomme på enhver lokal og global regulering og falde som en tick-tock-video med et øjebliks varsel. Og manglende overholdelse kan i sidste ende koste en organisation millioner af dollars i bøder omkring arbejdet som den foreslåede EU AI-lov. Det kan være op til 30 millioner euro eller 6 % af virksomhedens globale omsætning – OUCH.

Nå, ikke alt behøver at være rosenrødt i starten ... så længe vi ved, hvordan man giver en makeover fra en skræmmende til en rosenrød situation.

Uden nogen overraskelse... det er altid mennesker, processer og teknologi. Så opret først et tværfunktionelt styrende organ til at uddanne, lede og overvåge initiativerne baseret på målene. Benchmark derefter den nuværende AI-teknologi og -processer, forstå hullerne, og afhjælp derefter til fremtidig bevis. Fald derefter tilbage på et sæt automatiserede styrings-workflows i overensstemmelse med compliance-kravene. Til sidst skal du oprette et overvågningssystem for at advare ejere, hvis den acceptable tærskel er ved at lukke ind. Fra teknologiens side kræver en veldesignet, veludført og velforbundet AI flere byggeklodser. Og sørg for, at den har nogle eller alle funktioner:

· Dataintegritet på tværs af forskellige implementeringer

· Brug åbne, fleksible eksisterende værktøjer, der overholder AI Governance

· Sørg for at tilbyde selvbetjeningsadgang med privatlivskontrol – en måde at spore på

· Design med automatisering og AI-styring i tankerne

· Kan forbinde og tilpasses til flere interessenter gennem tilpasselig arbejdsgang

Når vi har lavet en makeover af appen fra skræmmende til rosenrød...så er det næste spørgsmål, hvordan du beviser...

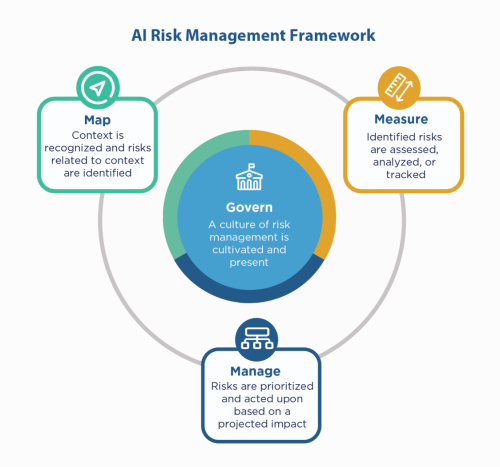

Først skal du falde tilbage på virksomhedens AI-principper – byg med dem, og alligevel skal du stadig "vise", at du er kompatibel, især i regulerede miljøer som Financial Services. Da finansielle tjenester skal klage til NIST 800-53, kunne de se på NIST AI Risk Management Framework (AI RMF). NIST foreslog kontrollerne i fire familier - Styr, Kort, Mål og Administrer. Brug det som en vejledende faktor og stresstest applikationerne for at identificere hullerne, der skal udbedres og overvåges.

IBM kan validere dine modeller, før du sætter dem i produktion, og kan overvåges for retfærdighed, kvalitet og drift. Den kan også levere dokumentation, der forklarer modellens adfærd og forudsigelser for at tilfredsstille regulatorers og revisorers krav. Disse forklaringer kan give synlighed og lette revisionssmerten og øge gennemsigtigheden og evnen til at bestemme mulige risici.

Lyt til disse AI hvisker med selvtillid!

#Finansielle tjenesteydelser #ansvarligai #etisk #NISTAIRMF

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Kilde: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :er

- $OP

- 2021

- 2024

- 7

- a

- evne

- Om

- acceptabel

- adgang

- ansvarlighed

- tværs

- Lov

- Handling

- aktiviteter

- klæbe

- AI

- AI-loven

- AI-styring

- alias

- Alert

- Alle

- altid

- ,

- besvare

- app

- Anvendelse

- applikationer

- apps

- ER

- omkring

- AS

- forbundet

- At

- revision

- revisorer

- Automatiseret

- Automatisering

- Automation

- tilbage

- Bank

- Banker

- baseret

- BE

- fordi

- før

- være

- benchmark

- fordele

- Bedre

- Billion

- Sort

- Blocks

- krop

- Boks

- Bringer

- bygge

- Bygning

- bygget

- virksomhed

- købe

- by

- CAN

- kapaciteter

- tilfælde

- tilfælde

- Kontanter

- pengestrøm

- skiftende

- chatbot

- chatbots

- klarhed

- lukning

- Virksomheder

- selskab

- kompleksitet

- Compliance

- kompatibel

- Adfærd

- trygt

- Tilslut

- Konsekvenser

- kontinuerligt

- kontrol

- Koste

- kunne

- skabe

- kritisk

- Nuværende

- tilpasses

- cyklus

- data

- debattere

- Beslutter

- afgørelser

- falde

- Design

- detaljeret

- Bestem

- digital

- Digital Transformation

- dire

- direkte

- lede

- forskelligartede

- dokumentation

- dollars

- Dropper

- lettere

- uddanne

- ende til ende

- sikre

- Enterprise

- miljøer

- især

- væsentlig

- etisk

- EU

- euro

- Endog

- Hver

- at alt

- bevismateriale

- eksisterende

- eksisterer

- forklarer

- eksponentielt

- Manglende

- fairness

- Fall

- familier

- Endelig

- finansielle

- finansielle tjenesteydelser

- bøder

- Finextra

- Fornavn

- fleksibel

- flow

- Til

- Framework

- fra

- fra 2021

- fremtiden

- Giv

- Global

- regeringsførelse

- Dyrkning

- Have

- Hvordan

- How To

- HTTPS

- kæmpe

- Mennesker

- i

- identificere

- KIMOs Succeshistorier

- in

- Herunder

- Forøg

- angiver

- industrier

- indflydelse

- initiativer

- Innovation

- indsigt

- integral

- integritet

- interagere

- investeret

- IT

- ITS

- Job

- Kend

- Legacy

- Politikker

- juridiske forhold

- Livet

- ligesom

- Line (linje)

- lokale

- Lang

- Se

- lavet

- lave

- administrere

- ledelse

- styring

- kort

- Marked

- Matters

- Kan..

- måle

- Mød

- måske

- million

- millioner

- model

- modeller

- øjeblik

- Overvåg

- overvåges

- overvågning

- mere

- flere

- nødvendig

- Behov

- Unødvendig

- Ny

- næste

- NIST

- målsætninger

- of

- tilbyde

- Gammel

- on

- ONE

- åbent

- betjene

- organisation

- Ellers

- samlet

- ejere

- Smerte

- del

- Mennesker

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- mulig

- Forudsigelser

- tryk

- primære

- principper

- Beskyttelse af personlige oplysninger

- Proaktiv

- behandle

- Processer

- produktion

- Profil

- bevis

- foreslog

- Bevise

- give

- sætte

- kvalitet

- spørgsmål

- hurtigt

- nå

- indse

- reguleret

- regulerede brancher

- Regulering

- regler

- Regulators

- omdømme

- påkrævet

- Krav

- Kræver

- Svar

- ansvarlige

- resultere

- indtægter

- Risiko

- risikostyring

- risici

- ROI

- Rosy

- s

- Said

- Anden

- sektor

- Selvbetjening

- Tjenester

- sæt

- bør

- Vis

- side

- Simpelt

- siden

- Websteder

- Situationen

- størrelser

- So

- nogle

- Spark

- Højttaler

- interessenter

- forblive

- Stadig

- Strategi

- Styrke

- stress

- Kæmper

- vellykket

- systemet

- taler

- hold

- Teknologier

- prøve

- at

- Them

- Disse

- Tredje

- tærskel

- Gennem

- til

- værktøj

- værktøjer

- spor

- Transformation

- Gennemsigtighed

- enorm

- TUR

- Drejede

- Ultimativt

- forstå

- enheder

- kommende

- us

- brug

- VALIDATE

- forskellige

- video

- synlighed

- Vej..

- måder

- Hvad

- mens

- WHO

- med

- uden

- Arbejde

- arbejdsgange

- Du

- Din

- zephyrnet