Har du nogensinde set en babygazelle lære at gå? En fawn, som dybest set er en pattedyrsfar med lange ben, kravler sig op, falder, står og falder igen. Til sidst står den længe nok til at slynge sine tandstikkerlignende ben ind i en række næsten fald ... ahem, skridt. Forbløffende nok, et par minutter efter denne indtagende skærm, hopper fawn rundt som en gammel professionel.

Nå, nu har vi en robotversion af denne klassiske Serengeti-scene.

Fawn i dette tilfælde er en robothund ved University of California, Berkeley. Og det er ligeledes en overraskende hurtig lærende (i forhold til resten af robot-typen). Robotten er også speciel, fordi den i modsætning til andre prangende robotter, du måske har set online, bruger kunstig intelligens til at lære sig selv at gå.

Begyndende på ryggen, med benene vinkende, lærer robotten at vende sig selv om, rejse sig og gå på en time. Yderligere ti minutters chikane med en rulle pap er nok til at lære den at modstå og komme sig efter at blive skubbet rundt af sine handlere.

Det er ikke første gang en robot har brugt kunstig intelligens til at lære at gå. Men mens tidligere robotter lærte færdigheden ved at prøve og fejle over utallige iterationer i simuleringer, lærte Berkeley-botten helt i den virkelige verden.

[Indlejret indhold]

I en papir offentliggjort på arXiv preprint-serveren siger forskerne - Danijar Hafner, Alejandro Escontrela og Philipp Wu - at det ikke er ligetil at overføre algoritmer, som er lært i simulering, til den virkelige verden. Små detaljer og forskelle mellem den virkelige verden og simulering kan snuble nye robotter. På den anden side er træning af algoritmer i den virkelige verden upraktisk: Det ville tage for meget tid og slid.

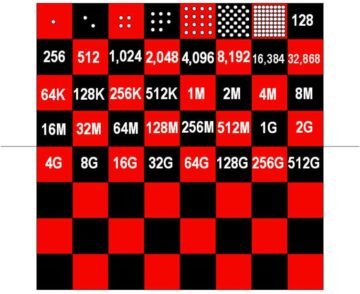

For fire år siden viste OpenAI for eksempel en AI-aktiveret robothånd, der kunne manipulere en terning. Kontrolalgoritmen, Dactyl, havde brug for omkring 100 års erfaring i en simulering drevet af 6,144 CPU'er og 8 Nvidia V100 GPU'er for at udføre denne relativt enkle opgave. Tingene er gået frem siden da, men problemet består stort set. Rene forstærkende læringsalgoritmer har brug for for meget trial and error for at lære færdigheder til, at de kan træne i den virkelige verden. Kort sagt ville læreprocessen knække forskere , robotter, før de gør nogen meningsfulde fremskridt.

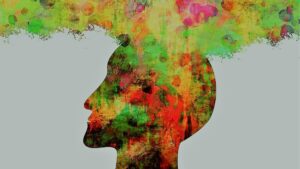

Berkeley-teamet satte sig for at løse dette problem med en algoritme kaldet Dreamer. At konstruere det, der kaldes en "verdensmodel,” Dreamer kan fremskrive sandsynligheden for, at en fremtidig handling vil nå sit mål. Med erfaring forbedres nøjagtigheden af dens fremskrivninger. Ved at frafiltrere mindre vellykkede handlinger på forhånd giver verdensmodellen robotten mulighed for mere effektivt at finde ud af, hvad der virker.

"At lære verdensmodeller fra tidligere erfaringer gør det muligt for robotter at forestille sig de fremtidige resultater af potentielle handlinger, hvilket reducerer mængden af forsøg og fejl i det virkelige miljø, der er nødvendigt for at lære succesfuld adfærd," skriver forskerne. "Ved at forudsige fremtidige resultater tillader verdensmodeller planlægning og adfærdslæring givet kun små mængder af virkelige verdensinteraktion."

Med andre ord kan en verdensmodel reducere, hvad der svarer til års træningstid i en simulering til ikke mere end en akavet time i den virkelige verden.

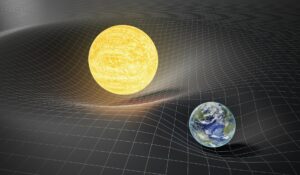

Tilgangen kan også have bredere relevans end robothunde. Holdet anvendte også Dreamer på en pick-and-place robotarm og en robot med hjul. I begge tilfælde fandt de ud af, at Dreamer gav deres robotter mulighed for effektivt at lære relevante færdigheder, ingen sim-tid påkrævet. Mere ambitiøse fremtidige ansøgninger kan omfatte selvkørende biler.

Selvfølgelig er der stadig udfordringer at tage fat på. Selvom forstærkningslæring automatiserer noget af den indviklede håndkodning bag nutidens mest avancerede robotter, kræver det stadig, at ingeniører definerer en robots mål, og hvad der udgør succes – en øvelse, der både er tidskrævende og åben for miljøer i den virkelige verden. Selvom robotten overlevede holdets eksperimenter her, kan længere træning på mere avancerede færdigheder vise sig at være for meget til, at fremtidige bots kan overleve uden skader. Forskerne siger, at det kan være frugtbart at kombinere simulatortræning med hurtig læring i den virkelige verden.

Alligevel fremmer resultaterne AI i robotteknologi endnu et skridt. Dreamer styrker sagen om, at "forstærkende læring vil være et hjørnestensværktøj i fremtiden for robotstyring," Jonathan Hurst, professor i robotteknologi ved Oregon State University fortalt MIT Technology Review.

Billede Credit: Danijar Hafner / YouTube