Data brændstof til maskinlæring (ML); kvaliteten af data har direkte indflydelse på kvaliteten af ML-modeller. Derfor er det afgørende at forbedre datakvaliteten og anvende de rigtige feature engineering-teknikker for at skabe nøjagtige ML-modeller. ML-udøvere gentager ofte kedeligt funktionsteknologi, valg af algoritmer og andre aspekter af ML i jagten på optimale modeller, der generaliserer godt på data fra den virkelige verden og leverer de ønskede resultater. Fordi hastigheden i at drive forretning er uforholdsmæssig vigtig, kan denne ekstremt kedelige og iterative proces føre til projektforsinkelser og mistede forretningsmuligheder.

Amazon SageMaker Data Wrangler reducerer tiden til at aggregere og forberede data til ML fra uger til minutter, og Amazon SageMaker Autopilot bygger, træner og tuner automatisk de bedste ML-modeller baseret på dine data. Med Autopilot bevarer du stadig fuld kontrol og synlighed over dine data og model. Begge tjenester er specialbygget til at gøre ML-udøvere mere produktive og fremskynde tid til værdi.

Data Wrangler giver nu en samlet oplevelse, der giver dig mulighed for at forberede data og problemfrit træne en ML-model i autopilot. Med denne nyligt lancerede funktion kan du nu forberede dine data i Data Wrangler og nemt starte Autopilot-eksperimenter direkte fra Data Wrangler-brugergrænsefladen (UI). Med blot et par klik kan du automatisk bygge, træne og tune ML-modeller, hvilket gør det nemmere at anvende avancerede funktionsteknologier, træne ML-modeller af høj kvalitet og få indsigt fra dine data hurtigere.

I dette indlæg diskuterer vi, hvordan du kan bruge denne nye integrerede oplevelse i Data Wrangler til at analysere datasæt og nemt bygge højkvalitets ML-modeller i Autopilot.

Datasæt oversigt

Pima-indianere er en indfødt gruppe, der bor i Mexico og Arizona, USA. Undersøgelser vise Pima-indianere som en højrisikobefolkningsgruppe for diabetes mellitus. At forudsige sandsynligheden for en persons risiko og modtagelighed for en kronisk sygdom som diabetes er en vigtig opgave i at forbedre sundheden og velværet for denne ofte underrepræsenterede minoritetsgruppe.

Vi bruger Pima Indian Diabetes offentligt datasæt at forudsige et individs modtagelighed for diabetes. Vi fokuserer på den nye integration mellem Data Wrangler og Autopilot for at forberede data og automatisk skabe en ML-model uden at skrive en enkelt linje kode.

Datasættet indeholder oplysninger om Pima indiske kvinder 21 år eller ældre og inkluderer flere medicinske prædiktorvariabler (uafhængige) og en målvariabel (afhængig), Outcome. Følgende diagram beskriver kolonnerne i vores datasæt.

| Kolonne Navn | Beskrivelse |

| graviditeter | Antallet af gange gravid |

| Glucose | Plasmaglukosekoncentration i en oral glucosetolerancetest inden for 2 timer |

| Blodtryk | Diastolisk blodtryk (mm Hg) |

| Hudtykkelse | Triceps hudfoldtykkelse (mm) |

| Insulin | 2-timers seruminsulin (mu U/ml) |

| BMI | Body mass index (vægt i kg/(højde i m)^2) |

| Diabetes Stamtavle | Diabetes stamtavle funktion |

| Alder | Alder i år |

| Resultat | Målvariablen |

Datasættet indeholder 768 poster, med 9 funktioner i alt. Vi gemmer dette datasæt i Amazon Simple Opbevaringsbøtte (Amazon S3) som en CSV-fil og importer derefter CSV'en direkte til et Data Wrangler-flow fra Amazon S3.

Løsningsoversigt

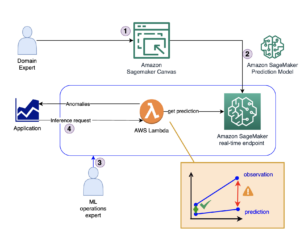

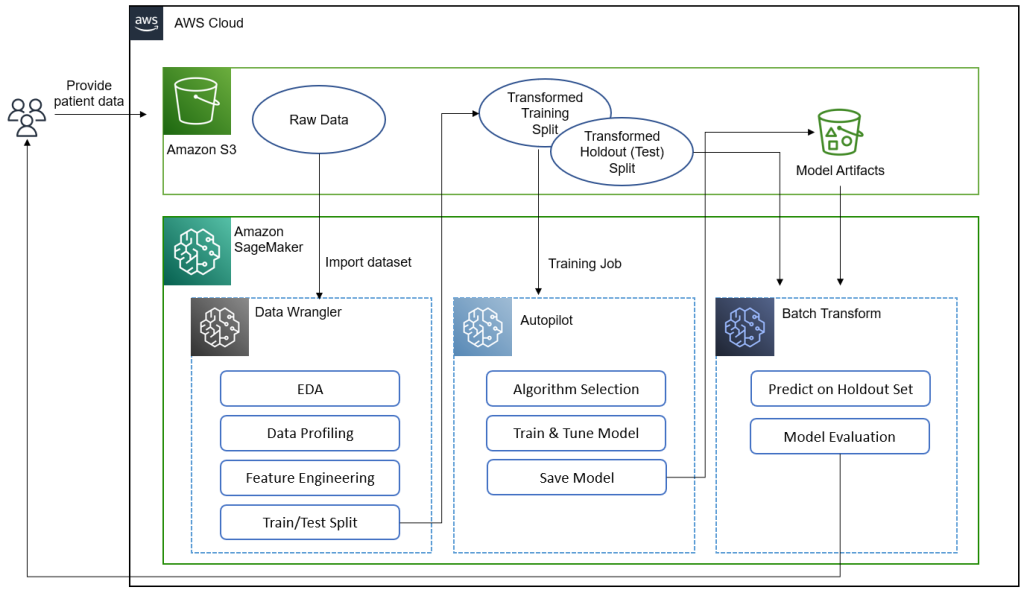

Følgende diagram opsummerer, hvad vi opnår i dette indlæg.[KT1]

Dataforskere, læger og andre medicinske domæneeksperter giver patientdata oplysninger om glukoseniveauer, blodtryk, kropsmasseindeks og andre funktioner, der bruges til at forudsige sandsynligheden for at have diabetes. Med datasættet i Amazon S3 importerer vi datasættet til Data Wrangler for at udføre eksplorativ dataanalyse (EDA), dataprofilering, feature engineering og opdeling af datasættet i tog og test til modelbygning og evaluering.

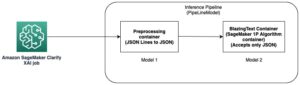

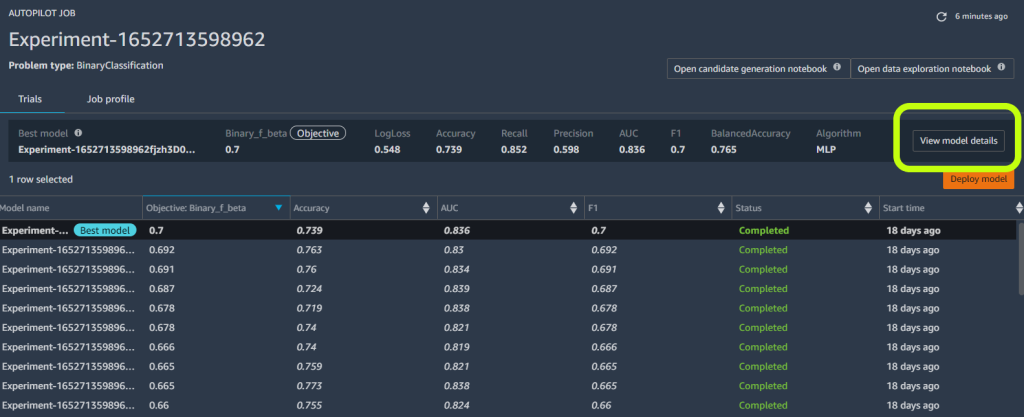

Vi bruger derefter Autopilots nye funktionsintegration til hurtigt at bygge en model direkte fra Data Wrangler-grænsefladen. Vi vælger Autopilots bedste model ud fra modellen med den højeste F-beta score. Efter at autopiloten har fundet den bedste model, kører vi en SageMaker Batch Transform job på testen (holdout) sæt med modelartefakter af den bedste model til evaluering.

Medicinske eksperter kan levere nye data til den validerede model for at opnå en forudsigelse for at se, om en patient sandsynligvis vil have diabetes. Med denne indsigt kan medicinske eksperter starte behandling tidligt for at forbedre udsatte befolkningers sundhed og velvære. Medicinske eksperter kan også forklare en models forudsigelse ved at henvise til modellens detaljer i autopiloten, fordi de har fuld indsigt i modellens forklarlighed, ydeevne og artefakter. Denne synlighed udover validering af modellen fra testsættet giver medicinske eksperter større tillid til modellens forudsigelsesevne.

Vi leder dig gennem følgende trin på højt niveau.

- Importer datasættet fra Amazon S3.

- Udfør EDA og dataprofilering med Data Wrangler.

- Udfør feature engineering for at håndtere outliers og manglende værdier.

- Opdel data i tog- og testsæt.

- Træn og byg en model med Autopilot.

- Test modellen på en holdout prøve med en SageMaker notesbog.

- Analyser validering og testsæts ydeevne.

Forudsætninger

Udfør følgende forudsætningstrin:

- Upload datasættet til en S3-spand efter eget valg.

- Sørg for, at du har de nødvendige tilladelser. For mere information, se Kom godt i gang med Data Wrangler.

- Konfigurer et SageMaker-domæne, der er konfigureret til at bruge Data Wrangler. For instruktioner, se Ombord på Amazon SageMaker Domain.

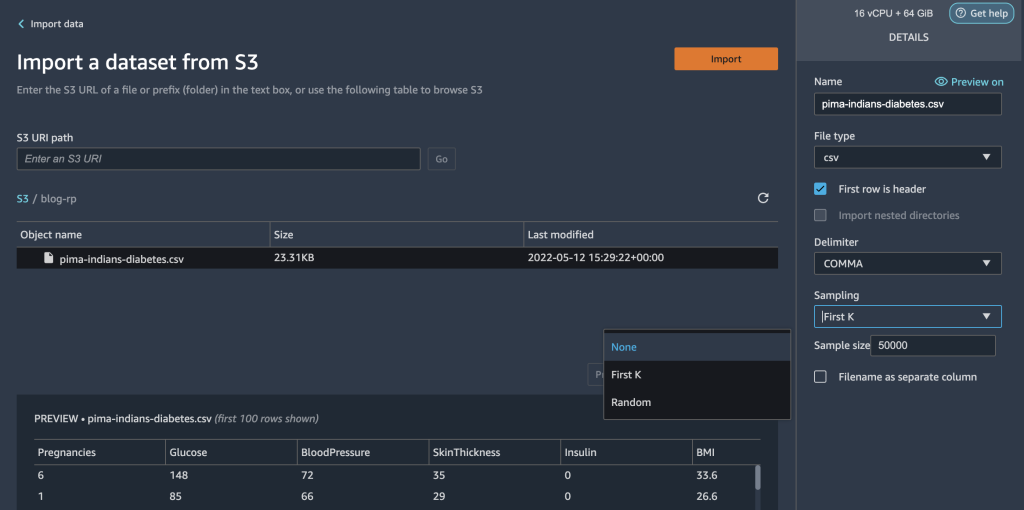

Importer dit datasæt med Data Wrangler

Du kan integrere et Data Wrangler-dataflow i dine ML-arbejdsgange for at forenkle og strømline dataforbehandling og funktionsteknologi ved brug af lidt eller ingen kodning. Udfør følgende trin:

- Opret en ny Data Wrangler flow.

Hvis det er første gang, du åbner Data Wrangler, skal du muligvis vente et par minutter, før den er klar.

- Vælg datasættet, der er gemt i Amazon S3, og importer det til Data Wrangler.

Når du har importeret datasættet, bør du se begyndelsen af et dataflow i Data Wrangler-brugergrænsefladen. Du har nu et flowdiagram.

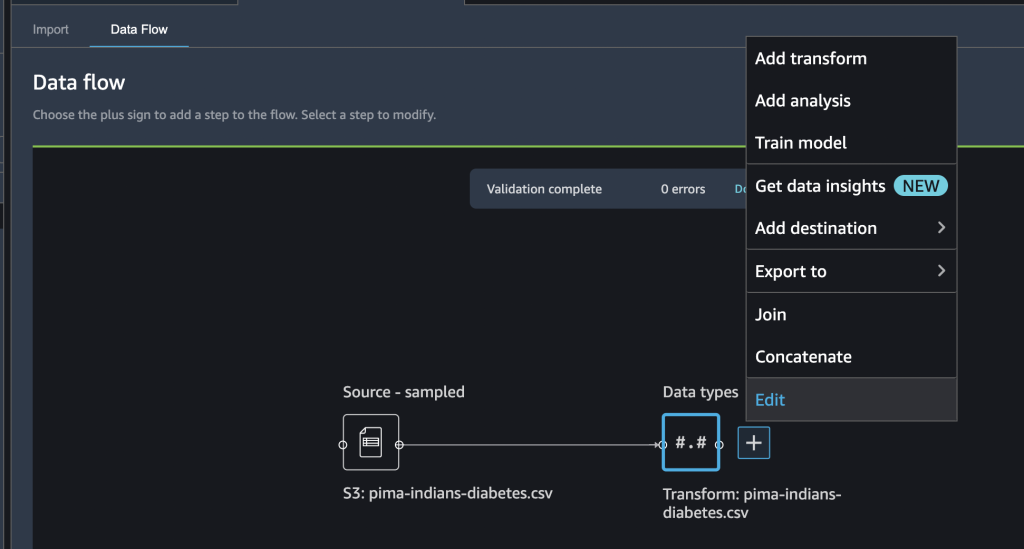

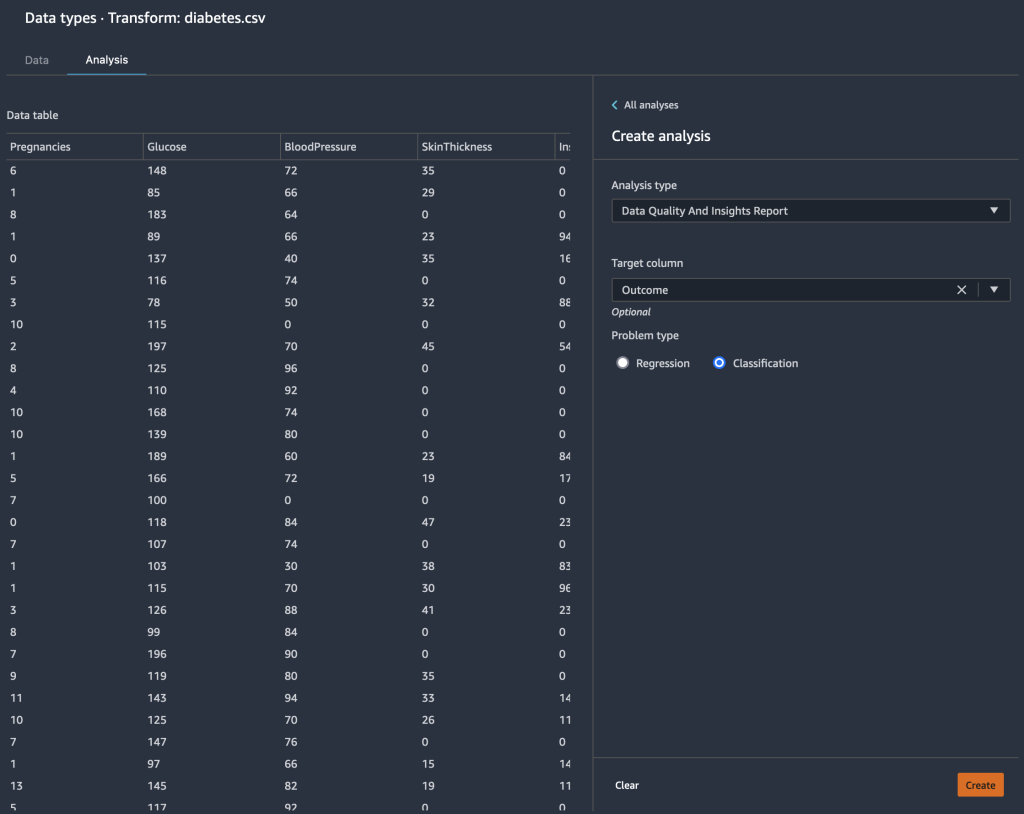

- Vælg plustegnet ved siden af Datatyper Og vælg Redigere for at bekræfte, at Data Wrangler automatisk udledte de korrekte datatyper for dine datakolonner.

Hvis datatyperne ikke er korrekte, kan du nemt ændre dem via brugergrænsefladen. Hvis der er flere datakilder til stede, kan du tilslutte eller sammenkæde dem.

Vi kan nu lave en analyse og tilføje transformationer.

Udfør undersøgende dataanalyse med dataindsigtsrapporten

Udforskende dataanalyse er en kritisk del af ML-arbejdsgangen. Vi kan bruge den nye dataindsigtsrapport fra Data Wrangler til at få en bedre forståelse af profilen og distributionen af vores data. Rapporten indeholder opsummerende statistikker, advarsler om datakvalitet, indsigt i målkolonne, en hurtig model og oplysninger om unormale og duplikerede rækker.

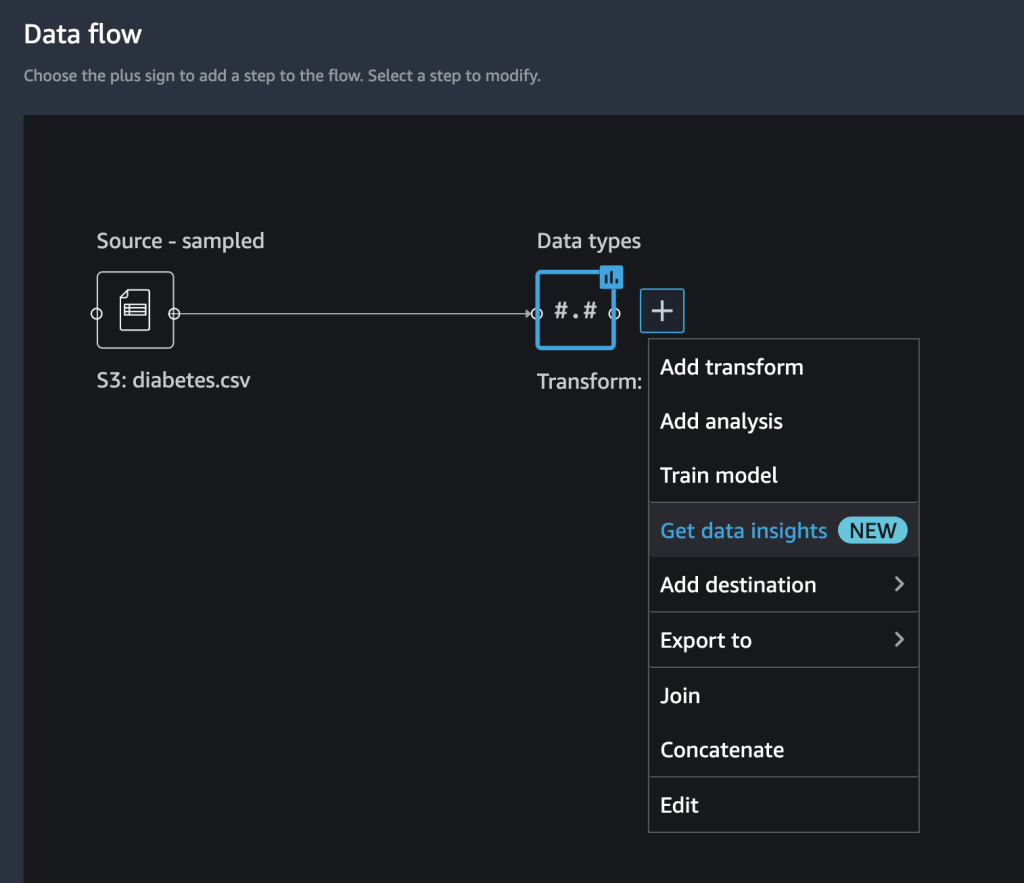

- Vælg plustegnet ved siden af Datatyper Og vælg Få dataindsigt.

- Til mål kolonne, vælg Resultat.

- Til Problektype, og (valgfrit) vælg Klassifikation.

- Vælg Opret.

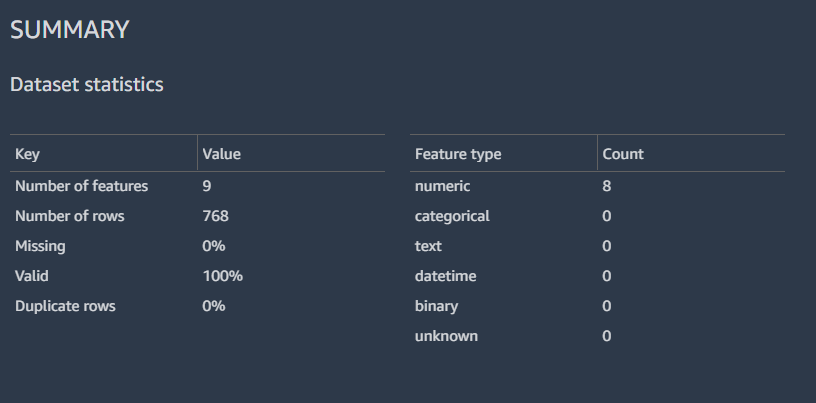

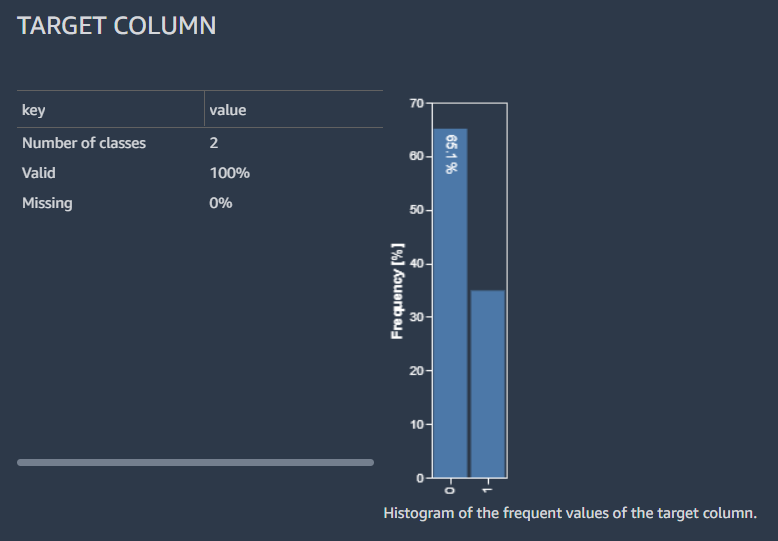

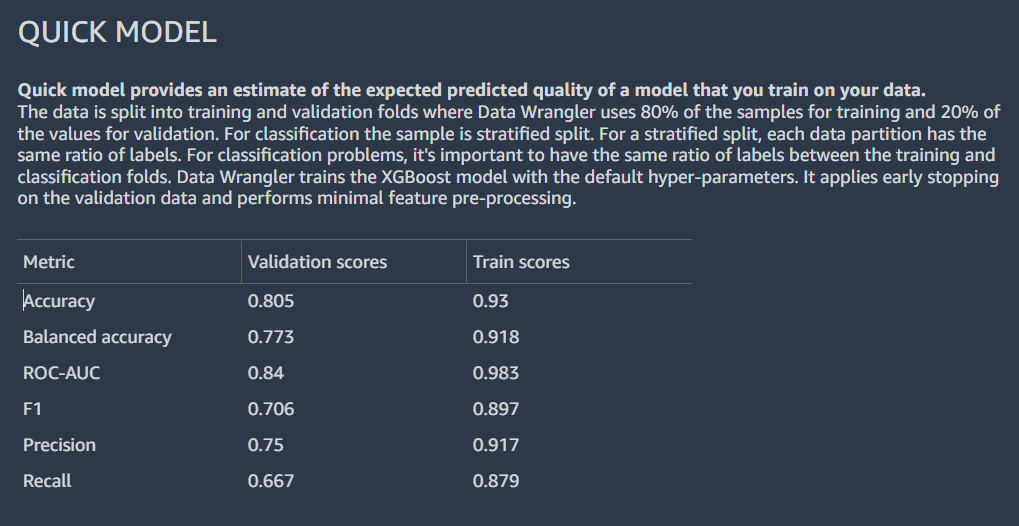

Resultaterne viser et opsummerende data med datasætstatistikken.

Vi kan også se fordelingen af de mærkede rækker med et histogram, et estimat af den forventede forudsagte kvalitet af modellen med den hurtige modelfunktion og en funktionsoversigtstabel.

Vi går ikke i detaljer med at analysere dataindsigtsrapporten; henvise til Fremskynd dataforberedelsen med datakvalitet og indsigt i Amazon SageMaker Data Wrangler for yderligere oplysninger om, hvordan du kan bruge dataindsigtsrapporten til at fremskynde dine dataforberedelsestrin.

Udfør feature engineering

Nu hvor vi har profileret og analyseret fordelingen af vores inputkolonner på et højt niveau, kunne den første overvejelse for at forbedre kvaliteten af vores data være at håndtere manglende værdier.

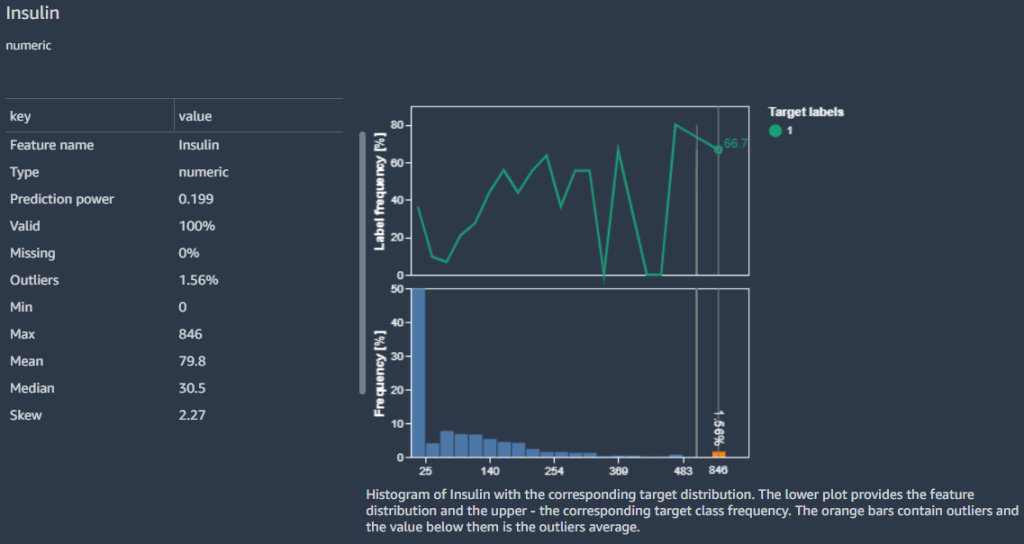

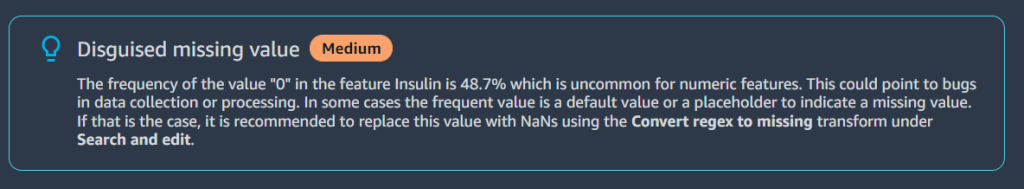

For eksempel ved vi, at nuller (0) for Insulin kolonne repræsenterer manglende værdier. Vi kunne følge anbefalingen om at erstatte nullerne med NaN. Men ved nærmere undersøgelse finder vi, at minimumsværdien er 0 for andre kolonner som f.eks Glucose, BloodPressure, SkinThicknessog BMI. Vi har brug for en måde at håndtere manglende værdier på, men skal være følsomme over for kolonner med nuller som gyldige data. Lad os se, hvordan vi kan løse dette.

I Funktionsdetaljer afsnit rejser rapporten en Forklædt manglende værdi advarsel for funktionen Insulin.

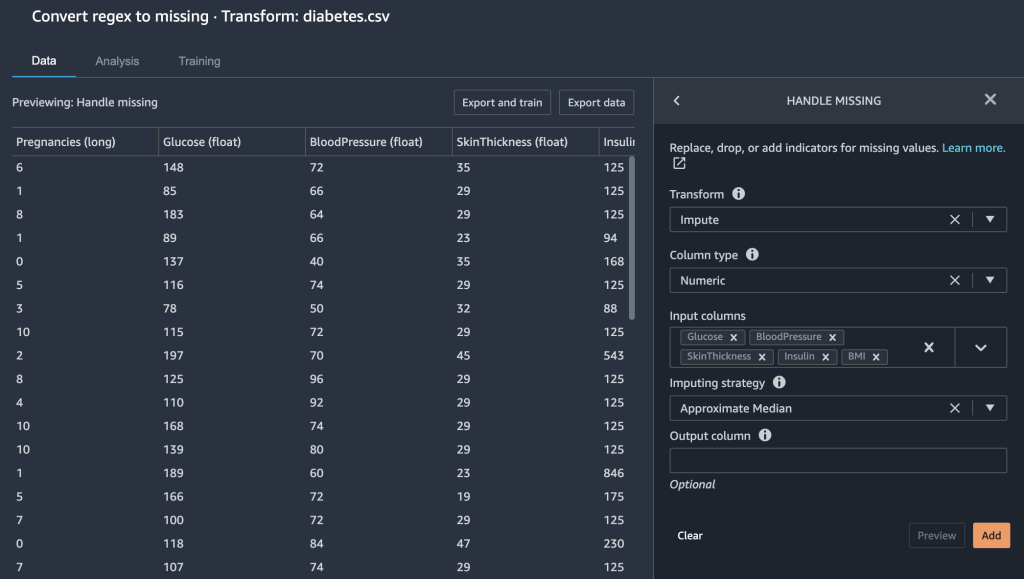

Fordi nuller i Insulin kolonnen i virkeligheden mangler data, bruger vi Konverter regex til manglende transformer for at transformere nulværdier til tomme (manglende værdier).

- Vælg plustegnet ved siden af data typer Og vælg Tilføj omdanne.

- Vælg Søg og rediger.

- Til Transform, vælg Konverter regex til manglende.

- Til Input kolonner, vælg kolonnerne

Insulin,Glucose,BloodPressure,SkinThicknessogBMI. - Til Mønster, gå ind

0. - Vælg Eksempel , Tilføj for at gemme dette trin.

De 0 poster under Insulin, Glucose, BloodPressure, SkinThicknessog BMI mangler nu værdier.

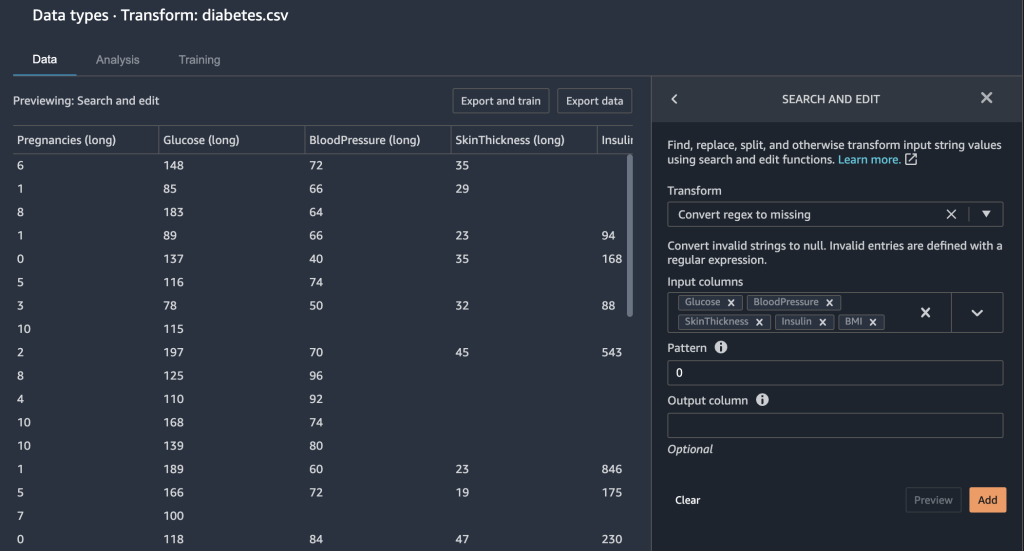

Data Wrangler giver dig et par andre muligheder for at rette manglende værdier.

- Vi håndterer manglende værdier ved at imputere den omtrentlige median for

Glucosekolonne.

Vi ønsker også at sikre, at vores funktioner er i samme skala. Vi ønsker ikke ved et uheld at give mere vægt til en bestemt funktion, bare fordi de indeholder et større numerisk område. Vi normaliserer vores funktioner for at gøre dette.

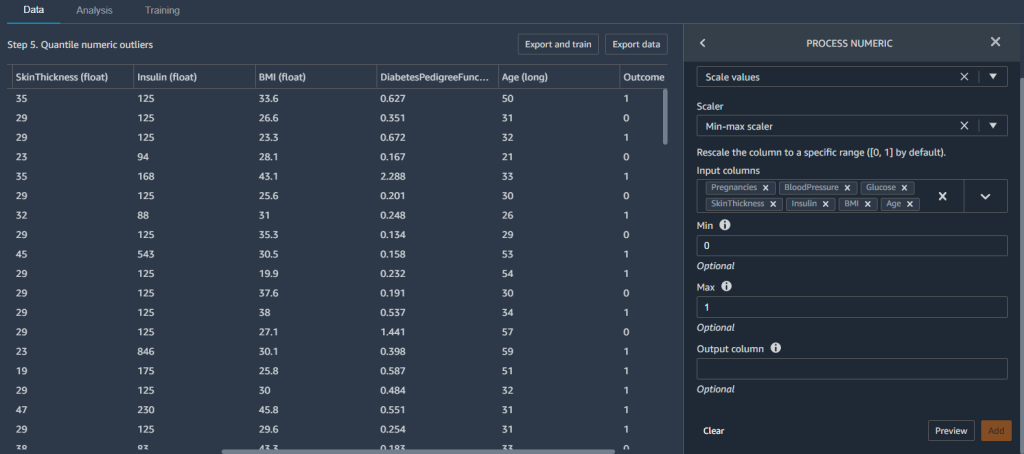

- Tilføj en ny Proces numerisk transformere og vælge Skala værdier.

- Til Scaler, vælg Min-max scaler.

- Til Input kolonner, vælg kolonnerne

Pregnancies,BloodPressure,Glucose,SkinThickness,Insulin,BMIogAge. - sæt Min til

0, max til1.

Dette sikrer, at vores funktioner er mellem værdierne 0 , 1.

Nu hvor vi har oprettet nogle funktioner, opdeler vi vores datasæt i træning og test, før vi bygger en model.

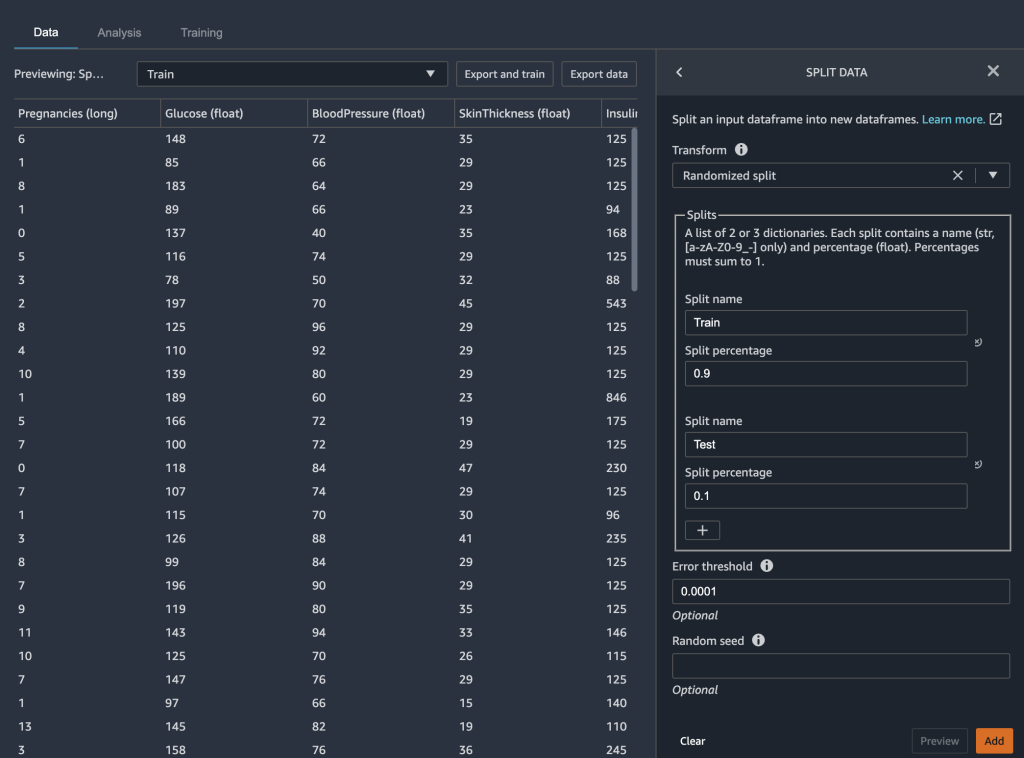

Opdel data i træning og test

I modelbygningsfasen af dit ML-workflow tester du effektiviteten af din model ved at køre batch-forudsigelser. Du kan afsætte et test- eller holdout-datasæt til evaluering for at se, hvordan din model klarer sig ved at sammenligne forudsigelserne med sandheden. Generelt, hvis flere af modellens forudsigelser matcher true etiketter, kan vi fastslå, at modellen klarer sig godt.

Vi bruger Data Wrangler til at opdele vores datasæt til test. Vi beholder 90 % af vores datasæt til træning, fordi vi har et relativt lille datasæt. De resterende 10 % af vores datasæt fungerer som testdatasæt. Vi bruger dette datasæt til at validere autopilotmodellen senere i dette indlæg.

Vi opdeler vores data ved at vælge Opdel data transformere og vælge Randomiseret opdeling som metoden. Vi angiver 0.9 som splitprocent for træning og 0.1 for test.

Med datatransformationen og de tekniske trin fuldført, er vi nu klar til at træne en model.

Træn og valider modellen

Vi kan bruge den nye Data Wrangler-integration med Autopilot til direkte at træne en model fra Data Wranglers dataflow-UI.

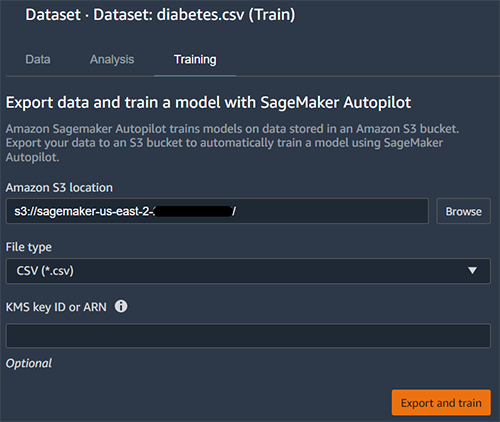

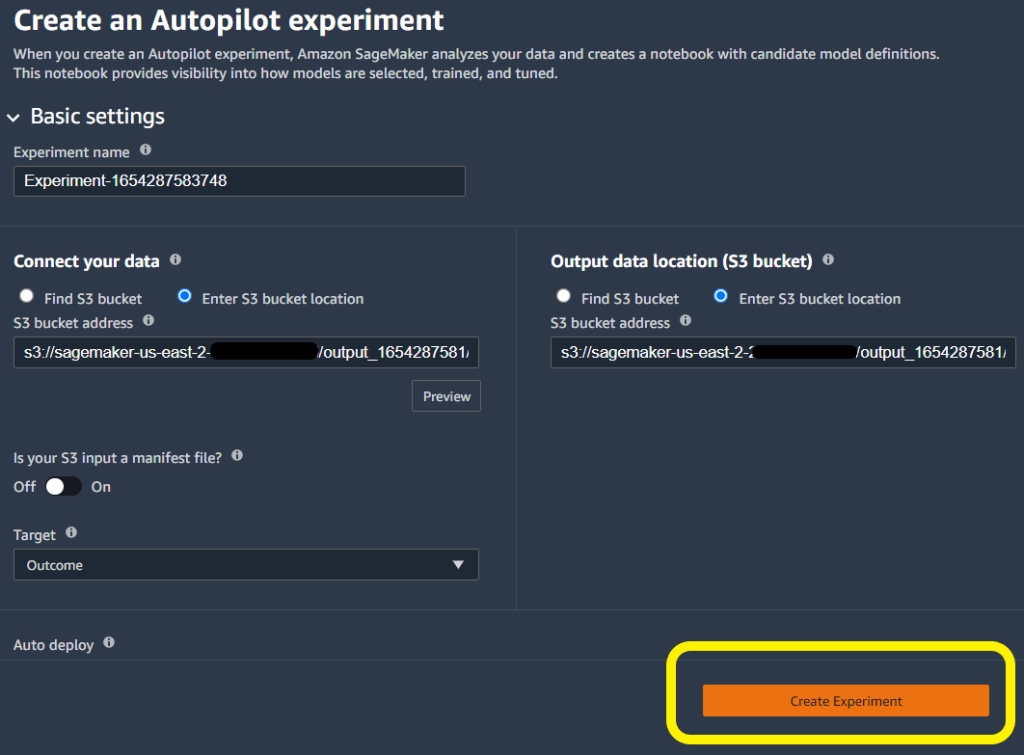

- Vælg plustegnet ved siden af datasæt Og vælg Tog model.

- Til Amazon S3 placering, angiv Amazon S3-lokationen, hvor SageMaker eksporterer dine data.

Autopilot bruger denne placering til automatisk at træne en model, hvilket sparer dig for tid fra at skulle definere outputplaceringen af Data Wrangler-flowet og derefter skulle definere inputplaceringen for autopilotens træningsdata. Dette giver en mere problemfri oplevelse.

- Vælg eksport og træne at igangsætte modelbygning med Autopilot.

Autopiloten vælger automatisk træningsdatainput- og outputplaceringerne. Du behøver kun at angive målkolonnen og klikke Opret eksperiment at træne din model.

Test modellen på en holdout-prøve

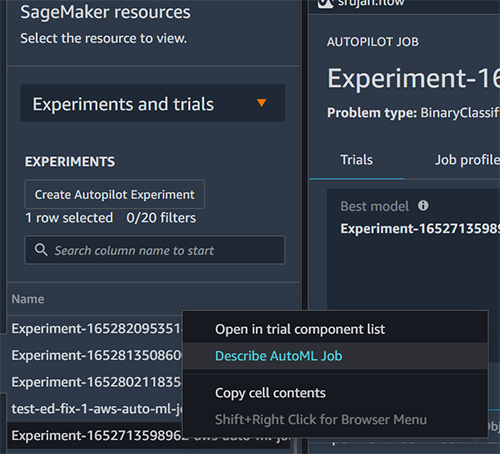

Når autopiloten afslutter eksperimentet, kan vi se træningsresultaterne og udforske den bedste model.

- Vælg Se modeldetaljer for din ønskede model, vælg derefter Performance (Præstation) fanen på siden med modeldetaljer.

Performance (Præstation) fanen viser flere modelmålingstest, inklusive en forvirringsmatrix, området under præcisions-/genkaldelseskurven (AUCPR) og området under modtagerens driftskarakteristikkurve (ROC). Disse illustrerer modellens overordnede valideringsydelse, men de fortæller os ikke, om modellen vil generalisere godt. Vi mangler stadig at køre evalueringer på usete testdata for at se, hvor nøjagtigt modellen forudsiger, om en person vil have diabetes.

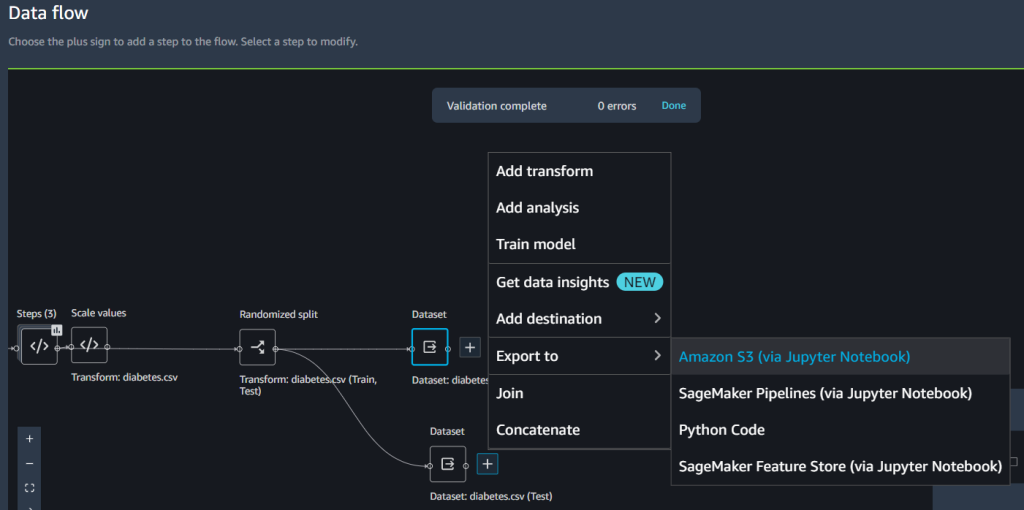

For at sikre, at modellen generaliserer godt nok, sætter vi testprøven til side til uafhængig prøveudtagning. Vi kan gøre det i Data Wrangler flow UI.

- Vælg plustegnet ved siden af datasæt, vælg Eksporter til, og vælg Amazon S3.

- Angiv en Amazon S3-sti.

Vi henviser til denne sti, når vi kører batch-inferens til validering i næste afsnit.

- Opret en ny SageMaker-notesbog for at udføre batch-inferencing på holdout-prøven og vurdere testydelsen. Der henvises til følgende GitHub repo en eksempel notesbog at køre batch-inferens til validering.

Analyser validering og testsæts ydeevne

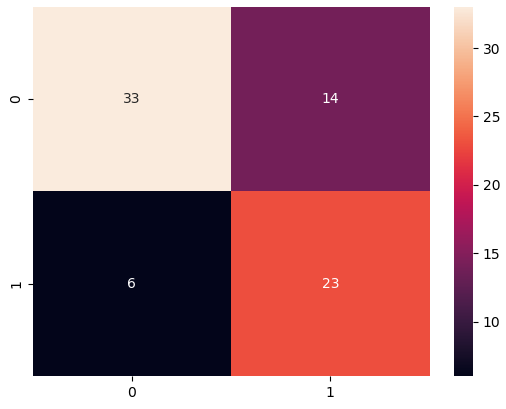

Når batchtransformationen er fuldført, opretter vi en forvirringsmatrix for at sammenligne de faktiske og forudsagte resultater af holdout-datasættet.

Vi ser 23 sande positive og 33 sande negative fra vores resultater. I vores tilfælde refererer sande positive til modellen, der korrekt forudsiger en person som havende diabetes. I modsætning hertil henviser sande negativer til modellen, der korrekt forudsiger et individ som ikke at have diabetes.

I vores tilfælde er præcision og tilbagekaldelse vigtige målinger. Præcision måler i det væsentlige alle individer, der forventes at have diabetes, hvor mange har egentlig diabetes? I modsætning hertil hjælper tilbagekaldelse med at måle alle personer, der faktisk har diabetes, hvor mange blev forudsagt at have diabetes? For eksempel vil du måske bruge en model med høj præcision, fordi du vil behandle så mange individer som muligt, især hvis den første fase af behandlingen ikke har nogen effekt på individer uden diabetes (disse er falske positiver – dem, der er mærket som havende det) når de faktisk ikke gør det).

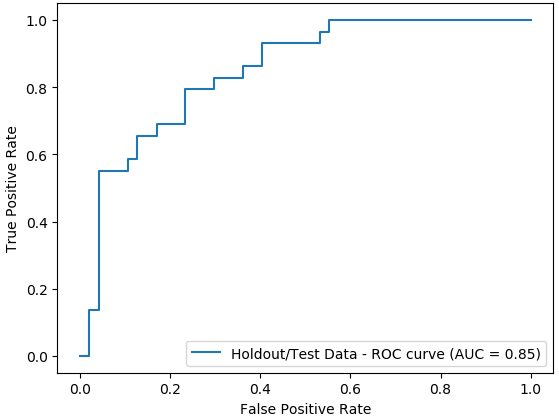

Vi plotter også området under ROC-kurven (AUC) grafen for at evaluere resultaterne. Jo højere AUC, jo bedre er modellen til at skelne mellem klasser, hvilket i vores tilfælde er, hvor godt modellen klarer sig til at skelne patienter med og uden diabetes.

Konklusion

I dette indlæg demonstrerede vi, hvordan du integrerer din databehandling, med ingeniørarbejde og modelbygning ved hjælp af Data Wrangler og Autopilot. Vi fremhævede, hvordan du nemt kan træne og tune en model med Autopilot direkte fra Data Wrangler-brugergrænsefladen. Med denne integrationsfunktion kan vi hurtigt bygge en model efter at have afsluttet feature engineering uden at skrive nogen kode. Derefter refererede vi til Autopilots bedste model til at køre batch-forudsigelser ved hjælp af AutoML-klassen med SageMaker Python SDK.

Lavkode- og AutoML-løsninger som Data Wrangler og Autopilot fjerner behovet for at have dyb kodningsviden for at bygge robuste ML-modeller. Kom godt i gang med at bruge Data Wrangler i dag for at opleve, hvor nemt det er at bygge ML-modeller vha SageMaker Autopilot.

Om forfatterne

Peter Chung er Solutions Architect for AWS, og brænder for at hjælpe kunder med at afdække indsigt fra deres data. Han har bygget løsninger til at hjælpe organisationer med at træffe datadrevne beslutninger i både den offentlige og private sektor. Han har alle AWS-certificeringer samt to GCP-certificeringer. Han nyder kaffe, madlavning, at holde sig aktiv og tilbringe tid med sin familie.

Peter Chung er Solutions Architect for AWS, og brænder for at hjælpe kunder med at afdække indsigt fra deres data. Han har bygget løsninger til at hjælpe organisationer med at træffe datadrevne beslutninger i både den offentlige og private sektor. Han har alle AWS-certificeringer samt to GCP-certificeringer. Han nyder kaffe, madlavning, at holde sig aktiv og tilbringe tid med sin familie.

Pradeep Reddy er en Senior Product Manager i SageMaker Low/No Code ML-teamet, som omfatter SageMaker Autopilot, SageMaker Automatic Model Tuner. Uden for arbejdet nyder Pradeep at læse, løbe og nørde med computere i palmestørrelse som raspberry pi og anden hjemmeautomatiseringsteknologi.

Pradeep Reddy er en Senior Product Manager i SageMaker Low/No Code ML-teamet, som omfatter SageMaker Autopilot, SageMaker Automatic Model Tuner. Uden for arbejdet nyder Pradeep at læse, løbe og nørde med computere i palmestørrelse som raspberry pi og anden hjemmeautomatiseringsteknologi.

Arunprasath Shankar er en specialist i kunstig intelligens og maskinlæring (AI/ML) med AWS, der hjælper globale kunder med at skalere deres AI-løsninger effektivt og effektivt i skyen. I sin fritid nyder Arun at se sci-fi-film og lytte til klassisk musik.

Arunprasath Shankar er en specialist i kunstig intelligens og maskinlæring (AI/ML) med AWS, der hjælper globale kunder med at skalere deres AI-løsninger effektivt og effektivt i skyen. I sin fritid nyder Arun at se sci-fi-film og lytte til klassisk musik.

Srujan Gopu er en Senior Frontend Engineer i SageMaker Low Code/No Code ML, der hjælper kunder med Autopilot og Canvas-produkter. Når han ikke koder, nyder Srujan at løbe en tur med sin hund Max, lytte til lydbøger og VR-spiludvikling.

Srujan Gopu er en Senior Frontend Engineer i SageMaker Low Code/No Code ML, der hjælper kunder med Autopilot og Canvas-produkter. Når han ikke koder, nyder Srujan at løbe en tur med sin hund Max, lytte til lydbøger og VR-spiludvikling.

- Coinsmart. Europas bedste Bitcoin og Crypto Exchange.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. FRI ADGANG.

- CryptoHawk. Altcoin radar. Gratis prøveversion.

- Kilde: https://aws.amazon.com/blogs/machine-learning/unified-data-preparation-and-model-training-with-amazon-sagemaker-data-wrangler-and-amazon-sagemaker-autopilot/

- "

- 100

- 7

- 9

- a

- evne

- Om

- fremskynde

- præcis

- aktiv

- Desuden

- Yderligere

- AI

- algoritmer

- Alle

- Amazon

- analyse

- analysere

- OMRÅDE

- arizona

- kunstig

- kunstig intelligens

- Kunstig intelligens og maskinlæring

- lyd

- Automatisk Ur

- automatisk

- Automation

- AWS

- fordi

- før

- BEDSTE

- mellem

- blod

- krop

- Bøger

- bygge

- Bygning

- bygger

- virksomhed

- canvas

- tilfælde

- vis

- valg

- Vælg

- klasse

- klasser

- tættere

- Cloud

- kode

- Kodning

- Kaffe

- Kolonne

- fuldføre

- færdiggøre

- computere

- koncentration

- tillid

- forvirring

- overvejelse

- indeholder

- kontrol

- kunne

- skabe

- oprettet

- Oprettelse af

- kritisk

- skøger

- Kunder

- data

- dataanalyse

- databehandling

- afgørelser

- dyb

- forsinkelser

- demonstreret

- afhængig

- detail

- detaljer

- Bestem

- Udvikling

- direkte

- direkte

- diskutere

- displays

- fordeling

- Læger

- domæne

- Tidligt

- nemt

- effekt

- effektivt

- effektivt

- muliggør

- ingeniør

- Engineering

- Indtast

- især

- væsentlige

- skøn

- evaluere

- evaluering

- eksempel

- forventet

- erfaring

- eksperiment

- eksperter

- udforske

- familie

- hurtigere

- Feature

- Funktionalitet

- Med

- fund

- Fornavn

- første gang

- Fix

- flow

- Fokus

- følger

- efter

- fra

- fuld

- spil

- generelt

- Global

- gå

- større

- gruppe

- håndtere

- have

- Helse

- højde

- hjælpe

- hjælpe

- hjælper

- Høj

- høj kvalitet

- høj risiko

- højere

- Fremhævet

- besidder

- Home

- Home Automation

- Hvordan

- How To

- HTTPS

- sygdom

- KIMOs Succeshistorier

- vigtigt

- Forbedre

- forbedring

- omfatter

- Herunder

- uafhængig

- indeks

- individuel

- enkeltpersoner

- oplysninger

- indgang

- indsigt

- integrere

- integreret

- integration

- Intelligens

- grænseflade

- IT

- Job

- deltage

- Kend

- viden

- Etiketter

- større

- lancere

- lanceret

- føre

- læring

- Niveau

- niveauer

- Sandsynlig

- Line (linje)

- Lytte

- lidt

- leve

- placering

- placeringer

- maskine

- machine learning

- vedligeholde

- lave

- maerker

- Making

- leder

- Match

- Matrix

- Matters

- måle

- foranstaltninger

- medicinsk

- Metrics

- Mexico

- minimum

- mindretal

- ML

- model

- modeller

- mere

- Film

- flere

- Musik

- nødvendig

- næste

- NIH

- notesbog

- nummer

- åbning

- drift

- Muligheder

- Indstillinger

- organisationer

- Andet

- samlet

- del

- lidenskabelige

- procentdel

- ydeevne

- udfører

- fase

- befolkning

- Pradeep

- forudsige

- forudsigelse

- Forudsigelser

- Forbered

- præsentere

- tryk

- private

- behandle

- forarbejdning

- Produkt

- Produkter

- Profil

- profilering

- projekt

- give

- giver

- offentlige

- kvalitet

- Hurtig

- hurtigt

- rejser

- rækkevidde

- Læsning

- optegnelser

- resterende

- indberette

- repræsentere

- Resultater

- Risiko

- Kør

- kører

- samme

- besparelse

- Scale

- forskere

- SDK

- sømløs

- problemfrit

- Søg

- Sektorer

- Tjenester

- sæt

- flere

- underskrive

- Simpelt

- enkelt

- hud

- lille

- So

- Løsninger

- nogle

- specialist

- hastighed

- udgifterne

- delt

- Stage

- starte

- påbegyndt

- state-of-the-art

- statistik

- Stadig

- opbevaring

- butik

- strømline

- mål

- hold

- tech

- teknikker

- prøve

- Test

- tests

- derfor

- Gennem

- tid

- gange

- i dag

- tolerance

- Kurser

- tog

- Transform

- Transformation

- transformationer

- behandle

- behandling

- typer

- ui

- afdække

- under

- forståelse

- us

- brug

- valideret

- validering

- værdi

- Specifikation

- synlighed

- vr

- Sårbar

- vente

- Hvad

- WHO

- inden for

- uden

- Arbejde

- arbejdsgange

- skrivning

- år

- Din

- nul