Efterhånden som maskinlæringsmodeller (ML) er blevet forbedret, har dataforskere, ML-ingeniører og forskere flyttet mere af deres opmærksomhed til at definere og forbedre datakvaliteten. Dette har ført til fremkomsten af en datacentreret tilgang til ML og forskellige teknikker til at forbedre modellens ydeevne ved at fokusere på datakrav. Anvendelse af disse teknikker giver ML-udøvere mulighed for at reducere mængden af data, der kræves for at træne en ML-model.

Som en del af denne tilgang er avancerede teknikker til udvælgelse af dataundersæt dukket op for at fremskynde træningen ved at reducere mængden af inputdata. Denne proces er baseret på automatisk at vælge et givet antal punkter, der tilnærmer fordelingen af et større datasæt, og bruge det til træning. Anvendelse af denne type teknik reducerer den tid, det tager at træne en ML-model.

I dette indlæg beskriver vi anvendelsen af datacentrerede AI-principper med Amazon SageMaker Ground Truth, hvordan man implementerer teknikker til udvælgelse af dataundersæt ved hjælp af LEDNINGER depot på Amazon SageMaker at reducere mængden af data, der kræves for at træne en indledende model, og hvordan man kører eksperimenter ved hjælp af denne tilgang med Amazon SageMaker-eksperimenter.

En datacentreret tilgang til maskinlæring

Før du dykker ned i mere avancerede datacentrerede teknikker som dataundersætudvælgelse, kan du forbedre dine datasæt på flere måder ved at anvende et sæt underliggende principper til din datamærkningsproces. Til dette understøtter Ground Truth forskellige mekanismer til at forbedre etiketkonsistens og datakvalitet.

Etiketkonsistens er vigtig for at forbedre modellens ydeevne. Uden det kan modeller ikke producere en beslutningsgrænse, der adskiller hvert punkt, der tilhører forskellige klasser. En måde at sikre konsistens på er ved at bruge annotationskonsolidering i Ground Truth, som giver dig mulighed for at vise et givet eksempel til flere etiketter og bruge den aggregerede etiket, der er angivet som grundsandheden for dette eksempel. Divergens i etiketten måles ved den tillidsscore, der genereres af Ground Truth. Når der er divergens i etiketter, bør du se efter, om der er tvetydighed i mærkningsinstruktionerne til dine etiketter, som kan fjernes. Denne tilgang afbøder virkningerne af bias af individuelle etiketter, hvilket er centralt for at gøre etiketter mere konsistente.

En anden måde at forbedre modellens ydeevne ved at fokusere på data involverer udvikling af metoder til at analysere fejl i etiketter, når de kommer op for at identificere den vigtigste delmængde af data, der skal forbedres. du kan gøre dette til dit træningsdatasæt med en kombination af manuel indsats, der involverer dykning i mærkede eksempler og brug af amazoncloudwatch logfiler og metrics genereret af Ground Truth-mærkningsjob. Det er også vigtigt at se på fejl, som modellen laver på slutningstidspunktet for at drive den næste iteration af mærkning for vores datasæt. Ud over disse mekanismer, Amazon SageMaker Clarify giver datavidenskabsfolk og ML-ingeniører mulighed for at køre algoritmer som f.eks KernelSHAP at give dem mulighed for at fortolke forudsigelser lavet af deres model. Som nævnt kan en dybere forklaring af modellens forudsigelser relateres tilbage til den indledende mærkningsproces for at forbedre den.

Til sidst kan du overveje at smide støjende eller alt for overflødige eksempler ud. Ved at gøre dette kan du reducere træningstiden ved at fjerne eksempler, der ikke bidrager til at forbedre modellens ydeevne. Det er imidlertid vanskeligt og tidskrævende at identificere en nyttig delmængde af et givet datasæt manuelt. Ved at anvende teknikkerne til udvælgelse af dataundersæt beskrevet i dette indlæg kan du automatisere denne proces langs etablerede rammer.

Brug sag

Som nævnt fokuserer datacentreret AI på at forbedre modelinput frem for selve modellens arkitektur. Når du har anvendt disse principper under datamærkning eller funktionsudvikling, kan du fortsætte med at fokusere på modelinput ved at anvende dataundersætvalg på træningstidspunktet.

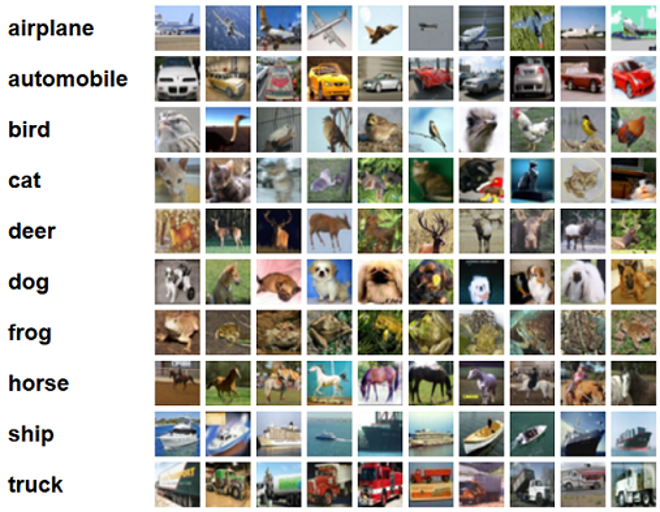

Til dette indlæg anvender vi generaliseringsbaseret dataundersætudvælgelse til effektiv og robust læring (GLISTER), som er en af mange teknikker til udvælgelse af dataundersæt implementeret i CORDS-lageret, til træningsalgoritmen for en ResNet-18 model for at minimere den tid, det tager at træne en model til at klassificere CIFAR-10 billeder. Følgende er nogle eksempelbilleder med deres respektive etiketter hentet fra CIFAR-10-datasættet.

ResNet-18 bruges ofte til klassificeringsopgaver. Det er et 18-lags dybt konvolutionelt neuralt netværk. CIFAR-10-datasættet bruges ofte til at evaluere gyldigheden af forskellige teknikker og tilgange i ML. Det er sammensat af 60,000 32×32 farvebilleder mærket på tværs af 10 klasser.

I de følgende afsnit viser vi, hvordan GLISTER til en vis grad kan hjælpe dig med at besvare følgende spørgsmål:

Hvor stor en procentdel af et givent datasæt kan vi bruge og stadig opnå god modelpræstation under træning?

Anvendelse af GLISTER på din træningsalgoritme vil introducere fraktion som en hyperparameter i din træningsalgoritme. Dette repræsenterer procentdelen af det givne datasæt, du ønsker at bruge. Som med enhver hyperparameter kræver det justering at finde den værdi, der giver det bedste resultat for din model og data. Vi går ikke i dybden med justering af hyperparameter i dette indlæg. For mere information, se Optimer hyperparametre med Amazon SageMaker Automatic Model Tuning.

Vi kører adskillige tests ved hjælp af SageMaker Experiments for at måle effekten af tilgangen. Resultaterne vil variere afhængigt af det indledende datasæt, så det er vigtigt at teste tilgangen i forhold til vores data ved forskellige undersætstørrelser.

Selvom vi diskuterer brugen af GLISTER på billeder, kan du også anvende det til træningsalgoritmer, der arbejder med strukturerede data eller tabeldata.

Valg af dataundersæt

Formålet med udvælgelse af dataundersæt er at accelerere træningsprocessen og samtidig minimere virkningerne på nøjagtigheden og øge modellens robusthed. Mere specifikt vælger GLISTER-ONLINE et undersæt, efterhånden som modellen lærer ved at forsøge at maksimere log-sandsynligheden for det pågældende træningsdataundersæt på det valideringssæt, du angiver. Optimering af dataundersætudvælgelse på denne måde afbøder støjen og klasseubalancen, der ofte findes i datasæt fra den virkelige verden, og gør det muligt for undersætudvælgelsesstrategien at tilpasse sig, efterhånden som modellen lærer.

Den indledende GLISTER papir beskriver en hastigheds-/nøjagtighedsafvejning ved forskellige dataundersætstørrelser som fulgt ved hjælp af en LeNet model:

| Undersætstørrelse | Speedup | Nøjagtighed |

| 10 % | 6x | -3% |

| 30 % | 2.5x | -1.20% |

| 50 % | 1.5x | -0.20% |

For at træne modellen kører vi en SageMaker træningsjob ved hjælp af et tilpasset træningsscript. Vi har også allerede uploadet vores billeddatasæt til Amazon Simple Storage Service (Amazon S3). Som med ethvert SageMaker træningsjob, skal vi definere en Estimator objekt. PyTorch-estimatoren fra sagemaker.pytorch pakke giver os mulighed for at køre vores eget træningsscript i en administreret PyTorch-container. Det inputs variabel overført til estimatorens .fit funktionen indeholder en ordbog over trænings- og valideringsdatasættets S3-placering.

train.py script køres, når et træningsjob startes. I dette script importerer vi ResNet-18-modellen fra CORDS-biblioteket og giver den antallet af klasser i vores datasæt som følger:

Så bruger vi gen_dataset funktion fra CORDS til at skabe trænings-, validerings- og testdatasæt:

Fra hvert datasæt opretter vi en tilsvarende PyTorch dataloader:

Til sidst bruger vi disse dataindlæsere til at skabe en GLISTERDataLoader fra CORDS-biblioteket. Den bruger en implementering af GLISTER-ONLINE udvælgelsesstrategien, som anvender udvælgelse af delmængder, når vi opdaterer modellen under træning, som diskuteret tidligere i dette indlæg.

For at oprette objektet videregiver vi udvælgelsesstrategiens specifikke argumenter som en DotMap objekt sammen med train_loader, validation_loaderog logger:

GLISTERDataLoader kan nu anvendes som en almindelig dataloader til en træningsløkke. Den vil vælge dataundersæt til næste træningsbatch, efterhånden som modellen lærer baseret på den pågældende models tab. Som vist i den foregående tabel giver tilføjelse af en strategi for dataundersætudvælgelse os mulighed for at reducere træningstiden betydeligt, selv med det ekstra trin til udvælgelse af dataundersæt, med ringe afvejning i nøjagtighed.

Datavidenskabsmænd og ML-ingeniører har ofte brug for at vurdere gyldigheden af en tilgang ved at sammenligne den med en baseline. Vi demonstrerer, hvordan du gør dette i næste afsnit.

Eksperimentsporing

Du kan bruge SageMaker Experiments til at måle gyldigheden af tilgangen til valg af dataundersæt. For mere information, se Næste generation af Amazon SageMaker-eksperimenter – Organiser, spor og sammenlign dine maskinlæringstræninger i stor skala.

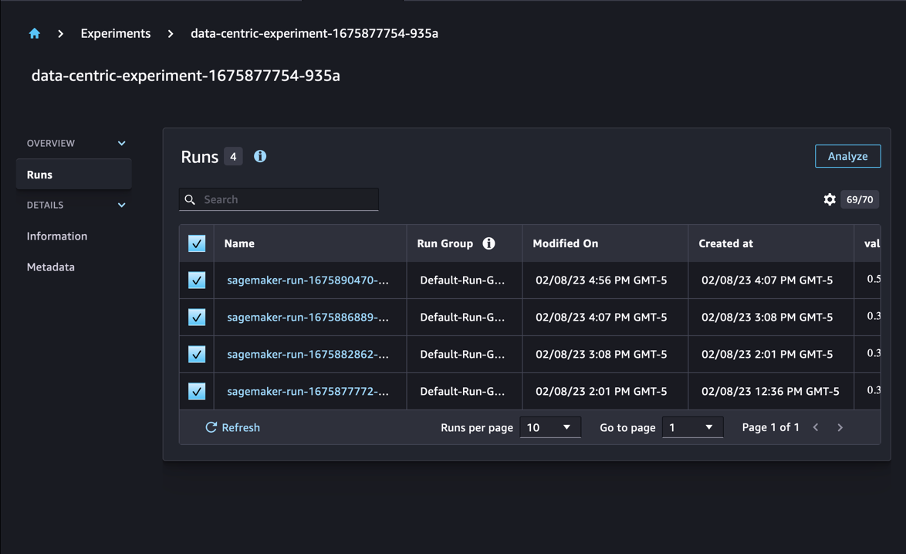

I vores tilfælde udfører vi fire eksperimenter: en baseline uden at anvende dataundersætselektion og tre andre med forskellige fraction parametre, som repræsenterer størrelsen af delmængden i forhold til det samlede datasæt. Naturligvis ved hjælp af en mindre fraction parameter bør resultere i reducerede træningstider, men også lavere modelnøjagtighed.

For denne post er hvert træningsløb repræsenteret som en Run i SageMaker Experiments. Kørslerne relateret til vores eksperiment er alle grupperet under én Experiment objekt. Kørsler kan knyttes til et fælles eksperiment, når du opretter Estimator med SDK. Se følgende kode:

Som en del af dit brugerdefinerede træningsscript kan du indsamle løbsmetrics ved at bruge load_run:

Derefter, ved at bruge kørselsobjektet, der blev returneret af den forrige operation, kan du indsamle datapunkter pr. epoke ved at kalde run.log_metric(name, value, step) og levering af metrisk navn, værdi og nuværende epokenummer.

For at måle gyldigheden af vores tilgang indsamler vi målinger svarende til træningstab, træningsnøjagtighed, valideringstab, valideringsnøjagtighed og tid til at fuldføre en epoke. Så kan vi, efter at have kørt uddannelsesjob gennemgå resultaterne af vores eksperiment in Amazon SageMaker Studio eller gennem SageMaker Experiments SDK.

Vælg for at se valideringsnøjagtighederne i Studio Analyser på forsøget Kører .

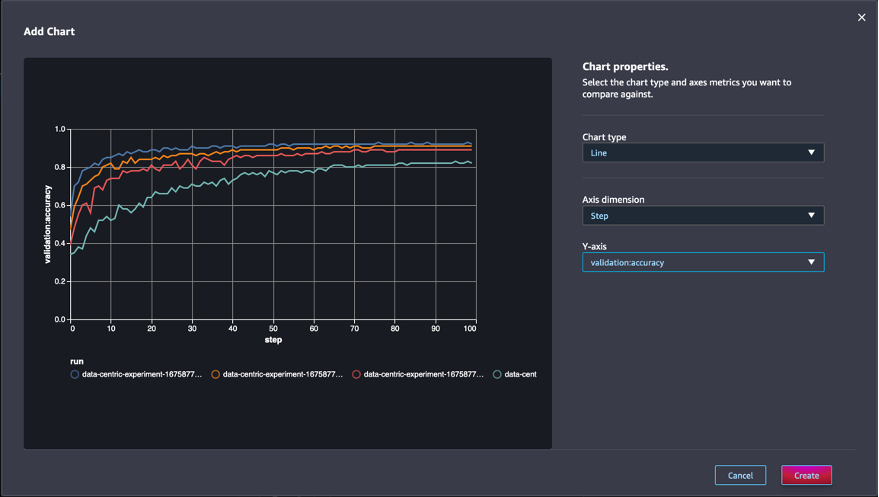

Tilføj et diagram, indstil diagramegenskaberne, og vælg Opret. Som vist i det følgende skærmbillede, vil du se et plot af valideringsnøjagtigheder ved hver epoke for alle kørsler.

SDK'et giver dig også mulighed for at hente eksperimentrelaterede oplysninger som en Pandas-dataramme:

Eventuelt kan uddannelsesjobbene sorteres. For eksempel kunne vi tilføje "metrics.validation:accuracy.max" som værdien af sort_by parameter overført til ExperimentAnalytics at returnere resultatet sorteret efter valideringsnøjagtighed.

Som forventet viser vores eksperimenter, at anvendelse af GLISTER og dataundersætvalg til træningsalgoritmen reducerer træningstiden. Når du kører vores baseline træningsalgoritme, svinger mediantiden til at gennemføre en enkelt epoke omkring 27 sekunder. I modsætning hertil vil anvendelse af GLISTER til at vælge en undergruppe svarende til 50 %, 30 % og 10 % af det samlede datasæt resultere i tider til at fuldføre en epoke på henholdsvis ca. 13, 8.5 og 2.75 sekunder på ml.p3.2xlarge forekomster .

Vi observerer også en forholdsvis minimal indvirkning på valideringsnøjagtigheden, især ved brug af dataundersæt på 50 %. Efter træning i 100 epoker giver basislinjen en valideringsnøjagtighed på 92.72 %. I modsætning hertil resulterer anvendelsen af GLISTER til at vælge et undersæt svarende til 50 %, 30 % og 10 % af det samlede datasæt i valideringsnøjagtigheder på henholdsvis 91.42 %, 89.76 % og 82.82 %.

Konklusion

SageMaker Ground Truth og SageMaker Experiments muliggør en datacentreret tilgang til maskinlæring ved at give datavidenskabsfolk og ML-ingeniører mulighed for at producere mere ensartede datasæt og spore virkningen af mere avancerede teknikker, når de implementerer dem i modelbygningsfasen. Implementering af en datacentreret tilgang til ML giver dig mulighed for at reducere mængden af data, der kræves af din model og forbedre dens robusthed.

Prøv det, og lad os vide, hvad du synes i kommentarerne.

Om forfatterne

Nicolas Bernier er en Solutions Architect, en del af den canadiske offentlige sektor hos AWS. Han er i gang med en mastergrad med et forskningsområde i Deep Learning og har fem AWS-certificeringer, herunder ML Specialty Certification. Nicolas brænder for at hjælpe kunder med at uddybe deres viden om AWS ved at arbejde sammen med dem om at omsætte deres forretningsmæssige udfordringer til tekniske løsninger.

Nicolas Bernier er en Solutions Architect, en del af den canadiske offentlige sektor hos AWS. Han er i gang med en mastergrad med et forskningsområde i Deep Learning og har fem AWS-certificeringer, herunder ML Specialty Certification. Nicolas brænder for at hjælpe kunder med at uddybe deres viden om AWS ved at arbejde sammen med dem om at omsætte deres forretningsmæssige udfordringer til tekniske løsninger.

Givanildo Alves er en Prototyping Architect hos Prototyping and Cloud Engineering teamet hos Amazon Web Services, der hjælper kunder med at innovere og accelerere ved at vise kunsten at mulige på AWS, efter at have implementeret adskillige prototyper omkring kunstig intelligens. Han har en lang karriere inden for software engineering og har tidligere arbejdet som Software Development Engineer hos Amazon.com.br.

Givanildo Alves er en Prototyping Architect hos Prototyping and Cloud Engineering teamet hos Amazon Web Services, der hjælper kunder med at innovere og accelerere ved at vise kunsten at mulige på AWS, efter at have implementeret adskillige prototyper omkring kunstig intelligens. Han har en lang karriere inden for software engineering og har tidligere arbejdet som Software Development Engineer hos Amazon.com.br.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :er

- $OP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- Om

- fremskynde

- nøjagtighed

- opnå

- tværs

- tilpasse

- Desuden

- Yderligere

- fremskreden

- Efter

- mod

- AI

- algoritme

- algoritmer

- Alle

- tillade

- tillader

- allerede

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- tvetydigheden

- beløb

- analytics

- analysere

- ,

- besvare

- anvendt

- Indløs

- Anvendelse

- tilgang

- tilgange

- arkitektur

- ER

- OMRÅDE

- argumenter

- omkring

- Kunst

- kunstig

- kunstig intelligens

- AS

- At

- forsøger

- opmærksomhed

- automatisere

- Automatisk Ur

- automatisk

- AWS

- tilbage

- baseret

- Baseline

- BE

- BEDSTE

- skævhed

- Bygning

- virksomhed

- by

- ringer

- CAN

- Canadian

- Karriere

- tilfælde

- central

- Certificering

- certificeringer

- udfordringer

- Chart

- Vælg

- klasse

- klasser

- klassificering

- Klassificere

- kunder

- Cloud

- kode

- indsamler

- farve

- KOM

- kombination

- Kom

- kommentarer

- Fælles

- forholdsvis

- sammenligne

- sammenligne

- fuldføre

- sammensat

- udførelse

- tillid

- Overvej

- konsekvent

- konsolidering

- Container

- indeholder

- fortsæt

- kontrast

- bidrage

- Tilsvarende

- kunne

- skabe

- Oprettelse af

- Nuværende

- For øjeblikket

- skik

- Kunder

- data

- datapunkter

- datasæt

- beslutning

- dyb

- dyb læring

- uddybe

- dybere

- definere

- Degree

- demonstrere

- demonstreret

- Afhængigt

- dybde

- beskrive

- beskrevet

- udvikling

- Udvikling

- forskellige

- forskellige

- svært

- diskutere

- drøftet

- fordeling

- Divergens

- gør

- Dont

- køre

- i løbet af

- hver

- tidligere

- effekter

- effektiv

- indsats

- fremkomsten

- muliggøre

- ingeniør

- Engineering

- Ingeniører

- sikre

- epoke

- epoker

- Ækvivalent

- fejl

- især

- etableret

- evaluere

- Endog

- Hver

- eksempel

- eksempler

- forventet

- eksperiment

- forklaring

- Feature

- finde

- Fokus

- fokuserer

- fokusering

- efterfulgt

- efter

- følger

- Til

- fundet

- fraktion

- rammer

- fra

- funktion

- genereret

- generation

- given

- Go

- godt

- Ground

- Have

- have

- hjælpe

- hjælpe

- besidder

- Hvordan

- How To

- Men

- HTML

- http

- HTTPS

- Tuning af hyperparameter

- identificere

- identificere

- billede

- billeder

- ubalance

- KIMOs Succeshistorier

- gennemføre

- implementering

- implementeret

- gennemføre

- importere

- vigtigt

- Forbedre

- forbedret

- forbedring

- in

- Herunder

- stigende

- individuel

- oplysninger

- initial

- innovere

- indgang

- instans

- anvisninger

- Intelligens

- indføre

- IT

- iteration

- ITS

- selv

- Job

- Karriere

- Kend

- viden

- etiket

- mærkning

- Etiketter

- større

- lanceret

- læring

- Led

- Bibliotek

- ligesom

- Liste

- lidt

- placering

- Lang

- Se

- off

- maskine

- machine learning

- lavet

- maerker

- Making

- lykkedes

- manuel

- manuelt

- mange

- herres

- max

- Maksimer

- måle

- nævnte

- metoder

- metrisk

- Metrics

- mindste

- minimering

- ML

- model

- modeller

- mere

- mest

- flere

- navn

- Behov

- netværk

- neurale netværk

- næste

- Nicolas

- Støj

- nummer

- objekt

- observere

- of

- on

- ONE

- drift

- optimering

- Andre

- samlet

- egen

- pakke

- side

- pandaer

- parameter

- parametre

- del

- Bestået

- lidenskabelige

- procentdel

- Udfør

- ydeevne

- fase

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- punkter

- mulig

- Indlæg

- Forudsigelser

- tidligere

- tidligere

- principper

- behandle

- producere

- egenskaber

- prototyper

- prototyping

- forudsat

- offentlige

- formål

- pytorch

- kvalitet

- mængde

- spørgsmål

- hellere

- virkelige verden

- reducere

- Reduceret

- reducerer

- reducere

- region

- fast

- relaterede

- fjernet

- fjernelse

- Repository

- repræsenteret

- repræsenterer

- påkrævet

- Krav

- Kræver

- forskning

- forskere

- dem

- resultere

- Resultater

- afkast

- robust

- robusthed

- Kør

- kører

- sagemaker

- forskere

- SDK

- sekunder

- Sektion

- sektioner

- sektor

- udvælgelse

- valg

- tjener

- Tjenester

- Session

- sæt

- flere

- bør

- Vis

- vist

- betydeligt

- Simpelt

- enkelt

- Størrelse

- størrelser

- mindre

- So

- Software

- softwareudvikling

- software Engineering

- Løsninger

- nogle

- Kilde

- Specialty

- specifikke

- specifikt

- hastighed

- Trin

- Stadig

- opbevaring

- Strategi

- struktureret

- Studio

- leverer

- Understøtter

- bord

- tager

- opgaver

- hold

- Teknisk

- teknikker

- prøve

- tests

- at

- deres

- Them

- Disse

- tre

- Gennem

- tid

- gange

- til

- fakkel

- toronto

- spor

- Tog

- Kurser

- træninger

- Oversætte

- under

- underliggende

- Opdatering

- uploadet

- us

- brug

- validering

- værdi

- forskellige

- Specifikation

- Vej..

- måder

- web

- webservices

- GODT

- Hvad

- som

- mens

- vilje

- med

- inden for

- uden

- arbejdede

- arbejder

- Du

- Din

- zephyrnet