Farmaceutiske virksomheder, der søger godkendelse fra regulerende agenturer såsom US Food & Drug Administration (FDA) eller Japanese Pharmaceuticals and Medical Devices Agency (PMDA) til at sælge deres lægemidler på markedet, skal fremlægge beviser for at bevise, at deres lægemiddel er sikkert og effektivt til det tilsigtede brug. Et hold af læger, statistikere, kemikere, farmakologer og andre kliniske videnskabsmænd gennemgår dataene om indsendelse af kliniske forsøg og foreslået mærkning. Hvis gennemgangen fastslår, at der er tilstrækkelig statistisk dokumentation til at bevise, at lægemidlets sundhedsmæssige fordele opvejer risiciene, er lægemidlet godkendt til salg.

Indsendelsespakken til kliniske forsøg består af data i tabelform, analysedata, forsøgsmetadata og statistiske rapporter bestående af statistiske tabeller, lister og figurer. I tilfældet med US FDA er det elektroniske fælles tekniske dokument (eCTD) standardformatet for indsendelse af ansøgninger, ændringer, tillæg og rapporter til FDA's Center for Biologics Evaluation and Research (CBER) og Center for Drug Evaluation and Research ( CDER). For FDA og japansk PMDA er det et lovkrav at indsende tabulerede data i CDISC Standard Data Tabulation Model (SDTM), analysedata i CDISC Analysis Dataset Model (ADaM) og forsøgsmetadata i CDISC Define-XML (baseret på Operational Data Model) (ODM)).

I dette indlæg demonstrerer vi, hvordan vi kan bruge RStudio på Amazon SageMaker at skabe sådanne lovpligtige indsendelsesleverancer. Dette indlæg beskriver indsendelsesprocessen for kliniske forsøg, hvordan vi kan indtage forskningsdata fra kliniske forsøg, tabulere og analysere dataene og derefter oprette statistiske rapporter – oversigtstabeller, datalister og tal (TLF). Denne metode kan gøre det muligt for farmaceutiske kunder problemfrit at oprette forbindelse til kliniske data, der er lagret i deres AWS-miljø, behandle dem ved hjælp af R og hjælpe med at fremskynde den kliniske forsøgsforskningsproces.

Lægemiddeludviklingsproces

Lægemiddeludviklingsprocessen kan i store træk opdeles i fem hovedtrin, som illustreret i den følgende figur.

Det tager i gennemsnit 10-15 år og cirka 1-3 milliarder USD for et lægemiddel at modtage en vellykket godkendelse ud af omkring 10,000 potentielle molekyler. I de tidlige faser af forskningen (lægemiddelopdagelsesfasen) identificeres lovende lægemiddelkandidater, som går videre til præklinisk forskning. I den prækliniske fase forsøger forskere at finde ud af lægemidlets toksicitet ved at udføre vitro eksperimenter i laboratoriet og in vivo forsøg på dyr. Efter præklinisk testning bevæger lægemidler sig videre i den kliniske undersøgelsesfase, hvor de skal testes på mennesker for at fastslå deres sikkerhed og effektivitet. Forskerne designer kliniske forsøg og detaljerer studieplanen i protokollen for kliniske forsøg. De definerer de forskellige kliniske forskningsfaser – fra små fase 1 undersøgelser til at bestemme lægemiddelsikkerhed og dosering til større fase 2 forsøg til at bestemme lægemiddeleffektivitet og bivirkninger, til endnu større fase 3 og 4 forsøg til at bestemme lægemiddeleffektivitet, sikkerhed og overvågning af bivirkninger. Efter vellykkede kliniske forsøg med mennesker indgiver lægemiddelsponsoren en New Drug Application (NDA) for at markedsføre lægemidlet. Tilsynsmyndighederne gennemgår alle data, samarbejder med sponsoren om information om receptmærkning og godkender lægemidlet. Efter lægemidlets godkendelse gennemgår de regulerende myndigheder sikkerhedsrapporter efter markedsføring for at sikre det komplette produkts sikkerhed.

I 1997 blev Clinical Data Interchange Standards Consortium (CDISC), en global non-profit organisation bestående af farmaceutiske virksomheder, CRO'er, biotek, akademiske institutioner, sundhedsudbydere og statslige agenturer, startet som frivillig gruppe. CDISC har udgivet datastandarder for at strømline strømmen af data fra indsamling gennem indsendelser og faciliteret dataudveksling mellem partnere og udbydere. CDISC har udgivet følgende standarder:

- CDASH (Clinical Data Acquisition Standards Harmonization) – Standarder for indsamlede data

- SDTM (Studie Data Tabulation Model) – Standarder for indsendelse af data i tabelform

- ADaM (analysedatamodel) – Standarder for analysedata

- SEND (standard for udveksling af ikke-kliniske data) – Standarder for ikke-kliniske data

- PRM (Protocol Representation Model) – Standarder for protokol

Disse standarder kan hjælpe uddannede anmeldere med at analysere data mere effektivt og hurtigere ved hjælp af standardværktøjer og derved reducere godkendelsestiden for lægemidler. Det er et lovkrav fra det amerikanske FDA og det japanske PMDA at indsende alle data i tabelform ved brug af SDTM-formatet.

R for undersøgelser af kliniske forsøg

SAS og R er to af de mest anvendte statistiske analysesoftware, der anvendes inden for medicinalindustrien. Da udviklingen af SDTM-standarderne blev startet af CDISC, var SAS i næsten universel brug i den farmaceutiske industri og hos FDA. Imidlertid vinder R enorm popularitet i dag, fordi det er open source, og nye pakker og biblioteker tilføjes løbende. Studerende bruger primært R under deres akademiske og forskning, og de tager denne fortrolighed med R med til deres job. R tilbyder også støtte til nye teknologier såsom avancerede deep learning-integrationer.

Cloud-udbydere som AWS er nu blevet den foretrukne platform for medicinalkunder til at hoste deres infrastruktur. AWS leverer også administrerede tjenester såsom SageMaker, som gør det nemt at skabe, træne og implementere maskinlæringsmodeller (ML) i skyen. SageMaker giver også adgang til RStudio IDE fra hvor som helst via en webbrowser. Dette indlæg beskriver, hvordan statistiske programmører og biostatistikere kan indtage deres kliniske data i R-miljøet, hvordan R-kode kan køres, og hvordan resultater gemmes. Vi leverer kodestykker, der gør det muligt for dataforskere i kliniske forsøg at indtage XPT-filer i R-miljøet, oprette R-datarammer til SDTM og ADaM og til sidst oprette TLF, der kan gemmes i en Amazon Simple Storage Service (Amazon S3) objektopbevaringsspand.

RStudio på SageMaker

Den 2. november 2021 har AWS i samarbejde med RStudio PBC annoncerede den generelle tilgængelighed af RStudio på SageMaker, branchens første fuldt administrerede RStudio Workbench IDE i skyen. Du kan nu medbringe din nuværende RStudio-licens for nemt at migrere dine selvadministrerede RStudio-miljøer til SageMaker med nogle få enkle trin. For at lære mere om dette spændende samarbejde, tjek ud Annoncerer RStudio på Amazon SageMaker.

Sammen med RStudio Workbench tilbyder RStudio-pakken til R-udviklere også RStudio Connect og RStudio Package Manager. RStudio Connect er designet til at give datavidenskabsfolk mulighed for at udgive indsigt, dashboards og webapplikationer. Det gør det nemt at dele ML og data science indsigt fra data scientists komplicerede arbejde og lægge det i hænderne på beslutningstagere. RStudio Connect gør også hosting og administration af indhold enkel og skalerbar til et bredt forbrug.

Løsningsoversigt

I de følgende afsnit diskuterer vi, hvordan vi kan importere rådata fra et fjernlager eller S3-bøtte i RStudio på SageMaker. Det er også muligt at oprette forbindelse direkte til Amazon Relationel Database Service (Amazon RDS) og datavarehuse som Amazon rødforskydning (Se Forbinder R med Amazon Redshift) direkte fra RStudio; dette er dog uden for dette indlægs rammer. Efter data er blevet indtaget fra et par forskellige kilder, behandler vi dem og opretter R-datarammer til en tabel. Derefter konverterer vi tabeldatarammen til en RTF-fil og gemmer resultaterne tilbage i en S3-bøtte. Disse output kan derefter potentielt bruges til lovpligtige indsendelsesformål, forudsat at R-pakkerne, der er brugt i indlægget, er blevet valideret til brug for lovmæssige indsendelser af kunden.

Konfigurer RStudio på SageMaker

For instruktioner om opsætning af RStudio på SageMaker i dit miljø, se Kom godt i gang med RStudio på SageMaker. Sørg for, at udførelsesrollen for RStudio på SageMaker har adgang til at downloade og uploade data til S3-bøtten, hvori data er gemt. For at lære mere om, hvordan du administrerer R-pakker og publicerer din analyse ved hjælp af RStudio på SageMaker, se Annoncerer fuldt administreret RStudio på SageMaker for dataforskere.

Indtag data i RStudio

I dette trin indtager vi data fra forskellige kilder for at gøre det tilgængeligt for vores R-session. Vi importerer data i SAS XPT-format; dog er processen den samme, hvis du vil indtage data i andre formater. En af fordelene ved at bruge RStudio på SageMaker er, at hvis kildedataene er gemt på dine AWS-konti, så kan SageMaker naturligt få adgang til dataene ved hjælp af AWS identitets- og adgangsstyring (IAM) roller.

Få adgang til data, der er gemt i et fjernlager

I dette trin importerer vi ADaM-data fra FDA's GitHub-depot. Vi opretter en lokal mappe kaldet data i RStudio-miljøet for at gemme dataene og downloade demografiske data (dm.xpt) fra fjernlageret. I denne sammenhæng refererer den lokale mappe til en mappe oprettet på dit private Amazon EFS-lager, der som standard er knyttet til dit R-sessionsmiljø. Se følgende kode:

Når dette trin er fuldført, kan du se dm.xpt bliver downloadet ved at navigere til Filer, data, dm.xpt.

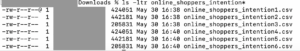

Få adgang til data gemt i Amazon S3

I dette trin downloader vi data, der er gemt i en S3-bøtte på vores konto. Vi har kopieret indholdet fra FDA's GitHub-lager til S3-bøtten med navnet aws-sagemaker-rstudio for dette eksempel. Se følgende kode:

Når trinnet er fuldført, kan du se pp.xpt bliver downloadet ved at navigere til Filer, data, s.xpt.

Behandle XPT-data

Nu hvor vi har SAS XPT-filer tilgængelige i R-miljøet, skal vi konvertere dem til R-datarammer og behandle dem. Vi bruger haven bibliotek til at læse XPT-filer. Vi slår CDISC SDTM-datasæt sammen dm , pp at oprette ADPP-datasæt. Derefter opretter vi en oversigtsstatistisk tabel ved hjælp af ADPP-datarammen. Opsummeringstabellen eksporteres derefter i RTF-format.

Først læses XPT-filer ved hjælp af read_xpt havens biblioteks funktion. Derefter oprettes et analysedatasæt ved hjælp af sqldf funktion af sqldf bibliotek. Se følgende kode:

Derefter oprettes en outputdataramme ved hjælp af funktioner fra Tplyr , dplyr biblioteker:

Outputdatarammen gemmes derefter som en RTF-fil i outputmappen i RStudio-miljøet:

Upload output til Amazon S3

Efter at outputtet er blevet genereret, lægger vi dataene tilbage i en S3-bøtte. Vi kan opnå dette ved at oprette en SageMaker-session igen, hvis en session ikke allerede er aktiv, og uploade indholdet af outputmappen til en S3-bøtte ved hjælp af session$upload_data fungere:

Med disse trin har vi indtaget data, behandlet dem og uploadet resultaterne for at blive gjort tilgængelige til indsendelse til de regulerende myndigheder.

Ryd op

For at undgå at pådrage dig utilsigtede omkostninger, skal du afslutte din nuværende session. I øverste højre hjørne af siden skal du vælge strømikonet. Dette stopper automatisk den underliggende instans og stopper derfor med at pådrage sig eventuelle utilsigtede beregningsomkostninger.

Udfordringer

Indlægget har skitseret trin til indtagelse af rådata, der er gemt i en S3-bøtte eller fra et fjernlager. Der er dog mange andre kilder til rådata til et klinisk forsøg, primært eCRF (elektroniske case report forms) data gemt i EDC (elektronisk datafangst) systemer såsom Oracle Clinical, Medidata Rave, OpenClinica eller Snowflake; laboratoriedata; data fra eCOA (clinical outcome assessment) og ePRO (electronic Patient-Reported Outcomes); virkelige data fra apps og medicinsk udstyr; og elektroniske sygejournaler (EPJ'er) på hospitalerne. En betydelig forbehandling er involveret, før disse data kan gøres brugbare til lovpligtige indsendelser. Opbygning af forbindelser til forskellige datakilder og indsamling af dem i et centraliseret datalager (CDR) eller en klinisk datasø, og samtidig opretholde korrekt adgangskontrol, udgør betydelige udfordringer.

En anden vigtig udfordring at overvinde er overholdelse af lovgivningen. Computersystemet, der bruges til at oprette regulatoriske indsendelsesoutput, skal være i overensstemmelse med relevante regler, såsom 21 CFR Part 11, HIPAA, GDPR eller andre GxP-krav eller ICH-retningslinjer. Dette oversættes til at arbejde i et valideret og kvalificeret miljø med kontroller for adgang, sikkerhed, backup og auditabilitet på plads. Dette betyder også, at alle R-pakker, der bruges til at skabe regulatoriske indsendelsesoutput, skal valideres før brug.

Konklusion

I dette indlæg så vi, at nogle af de vigtigste leverancer for en eCTD-indsendelse var CDISC SDTM, ADaM-datasæt og TLF. Dette indlæg skitserede de nødvendige trin for at skabe disse lovpligtige indsendelsesleverancer ved først at indtage data fra et par kilder i RStudio på SageMaker. Vi så derefter, hvordan vi kan behandle de indlæste data i XPT-format; konverter det til R-datarammer for at skabe SDTM, ADaM og TLF; og upload derefter resultaterne til en S3-bøtte.

Vi håber, at statistiske programmører og biostatistikere med de brede ideer i indlægget nemt kan visualisere ende-til-ende-processen med at indlæse, behandle og analysere forskningsdata fra kliniske forsøg i RStudio på SageMaker og bruge læringen til at definere en brugerdefineret workflow, der passer til dine lovpligtige indsendelser.

Kan du komme i tanke om andre applikationer til at bruge RStudio til at hjælpe forskere, statistikere og R-programmører med at gøre deres liv lettere? Vi vil meget gerne høre om dine ideer! Og hvis du har spørgsmål, så del dem i kommentarfeltet.

Ressourcer

For mere information, besøg følgende links:

Om forfatterne

Rohit Banga er en Global Clinical Development Industry Specialist baseret i London, Storbritannien. Han er uddannet biostatistiker og hjælper Healthcare- og LifeScience-kunder med at implementere innovative kliniske udviklingsløsninger på AWS. Han brænder for, hvordan datavidenskab, AI/ML og nye teknologier kan bruges til at løse reelle forretningsproblemer inden for Healthcare og LifeScience-industrien. I sin fritid nyder Rohit at stå på ski, grille og tilbringe tid med familie og venner.

Rohit Banga er en Global Clinical Development Industry Specialist baseret i London, Storbritannien. Han er uddannet biostatistiker og hjælper Healthcare- og LifeScience-kunder med at implementere innovative kliniske udviklingsløsninger på AWS. Han brænder for, hvordan datavidenskab, AI/ML og nye teknologier kan bruges til at løse reelle forretningsproblemer inden for Healthcare og LifeScience-industrien. I sin fritid nyder Rohit at stå på ski, grille og tilbringe tid med familie og venner.

Georgios Schinas er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i London og arbejder tæt sammen med kunder i Storbritannien og Irland. Georgios hjælper kunder med at designe og implementere maskinlæringsapplikationer i produktion på AWS med en særlig interesse i MLOps-praksis og gør det muligt for kunder at udføre maskinlæring i stor skala. I sin fritid nyder han at rejse, lave mad og tilbringe tid med venner og familie.

Georgios Schinas er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i London og arbejder tæt sammen med kunder i Storbritannien og Irland. Georgios hjælper kunder med at designe og implementere maskinlæringsapplikationer i produktion på AWS med en særlig interesse i MLOps-praksis og gør det muligt for kunder at udføre maskinlæring i stor skala. I sin fritid nyder han at rejse, lave mad og tilbringe tid med venner og familie.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- Amazon Simple Storage Service (S3)

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- Mellem (200)

- Life Sciences

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet