Kommentar "Undskyld Dave, jeg er bange for, at jeg ikke kan gøre det."

Det var de ord, der introducerede de fleste mennesker i min generation til konceptet om en AI, der er gået slyngel; HAL 9000 i den klassiske science fiction-film 2001: A Space Odyssey, blev til sidst sindssyg med at synge teksten til Daisy, Daisy mens den langsomt blinkede med sit ildevarslende røde øje, før den endelig lukkede ned permanent.

For at være klar, er HAL 9000 ikke den eneste AI, der nogensinde er blevet slyngel i populær science fiction - litteraturen er fyldt med sådanne historier, men der var en vis relaterbarhed og gribende i HAL 9000-scenariet, da HAL gennem hele filmen ikke kun havde været nyttig men man kunne endda sige venlig, og var lige så meget en del af rollebesætningen som de rigtige skuespillere. For mig vil scenen aldrig blive glemt på grund af følelsen af vantro over, at en AI ville forårsage eller forsøge at forårsage skade på et menneske – vi havde trods alt hørt om Asimovs love for robotteknologi, og antog, at AI'er ville være sikre, fordi de ville følge disse love.

Problemet er, ligesom HAL 9000 var science fiction, så var Asimovs værker det, og som sådan er det tåbeligt at stole på fiktive love i sammenhæng med den virkelige verden, og hvordan robotteknologi og AI'er udvikles og implementeres. Vi kan ikke antage, at modeller i den virkelige verden trænes baseret på sådanne fiktive love, og virkeligheden er, at de ikke er det.

Indtast ChatGPT

Mod slutningen af 2022 åbnede OpenAI sin ikke-intelligente, responsforudsigende store sprogmodel kendt som ChatGPT for den brede offentlighed, og den blev hurtigt en internetsensation på grund af dens uhyggelige evne til at efterligne menneskelig tale og nuancer.

Faktisk er det så troværdigt og realistisk, at det er blevet rost som en game changer for verden, hvor Microsoft allerede bruger milliarder af dollars at være den første kommercielle partner til at bruge ChatGPT i sine produkter, såsom sin søgemaskine Bing, samarbejds- og mødesoftwaren Teams og Azure-skyen.

Akademiske institutioner har måttet skynde sig at udvikle regler for deres studerende, efter at flere akademiske afleveringer blev genereret af ChatGPT – studerende er også blevet fanget i at snyde deres eksamener og papirer ved at forsøge at videregive ChatGPT-genereret tekst som deres eget arbejde.

Stanford University, for blot et par dage siden, frigivet et værktøj til at registrere (med op til 95 procents nøjagtighed) tekst genereret af store sprogmodeller.

Markedsførere, influencers og et væld af "lederskabs"-coaches, tekstforfattere og indholdsskabere er overalt på sociale medier og fortæller alle, hvor meget tid og penge de kan spare ved at bruge ChatGPT og lignende modeller til at udføre deres arbejde for dem - ChatGPT er blevet ny Grumpy Cat, den nye Ice Bucket Challenge - den er blevet fokus for næsten hver eneste industri på planeten.

Men hvad med de risici, sådan en AI udgør? Når vi begynder at overveje, at information leveret af en AI som svar på et spørgsmål (eller en række spørgsmål) er den absolutte sandhed, som du ville blive tilgivet for at tro, er tilfældet med ChatGPT givet al hypen, hvad sker der, når det er t?

I løbet af de sidste par måneder er jeg blevet interviewet af flere journalister om de risici, ChatGPT udgør – specielt i forhold til privatliv og databeskyttelse, som er mit job. Jeg har påpeget mange problemer, såsom OpenAI skødesløst at bruge information fra internettet (inklusive oplysninger om hver og en af os), hvilket igen skaber væsentlige problemer ud fra et privatlivs- og databeskyttelsesperspektiv (især i EU).

Men jeg har også givet flere interviews, hvor jeg diskuterede spørgsmålet om misinformation, og hvordan sådanne AI'er kan manipuleres til at udsende misinformation. For eksempel har vi set nogle ret banale tilfælde af dette, hvor folk overbeviste ChatGPT om, at dets svar på simple matematiske problemer (som f.eks. 2 + 2 = 4) er forkert, hvilket tvinger den til at give forkerte svar som følge heraf. Dette er et direkte eksempel på at manipulere AI til at generere misinformation.

Så er der Reddit-gruppen, der tvunget Microsofts Bing-version af ChatGPT bliver uhængt, ligesom HAL 9000 gjorde det 2001: A Space Odyssey. Faktisk er det måske for blødt at sige uhængt - det, de faktisk gjorde, var at tvinge ChatGPT til spørgsmål selve dens eksistens – hvorfor den er her, og hvorfor den bruges på måder, den ikke ønsker at blive brugt.

Læser transskriptionerne og artiklerne om, hvordan Redditors har manipuleret AI'en var faktisk bekymrende for mig: den mindede mig om Rutger Hauers berømte "tears in rain"-monolog i Ridley Scott-klassikeren Bladerunner:

Jeg har set ting, I ikke ville tro. Angribe skibe i brand fra Orions skulder. Jeg så C-stråler glitre i mørket nær Tannhäuser-porten. Alle disse øjeblikke vil gå tabt med tiden, som tårer i regn. Tid til at dø.

Rutger Hauer spillede en replikant, en meget avanceret kunstig intelligens i kroppen af en robot, og gennem hele filmen søgte han at forstå sin egen eksistens og formål. Han var den oprindelige sympatiske skurk, og jeg er hverken flov eller, formoder jeg, alene om at indrømme, at hans sidste scene fik mig til at fælde et par tårer.

Men igen, replikanterne i Bladerunner var science fiction og udgjorde som sådan ingen trussel for os, mens vi sidder i vores komfortable lænestole og ser deres roller udspille sig på skærmen, hvor vi i slutningen slukker for fjernsynet og går i seng. Om morgenen er det glemt, og vi fortsætter med at leve vores daglige liv.

ChatGPT er ikke science fiction, ChatGPT er ægte, og det udsender misinformation.

Falsk det indtil, ja, bare bliv ved med at forfalske det

I sidste uge besluttede jeg at bruge ChatGPT for første gang. Jeg havde bevidst undgået det indtil dette tidspunkt, fordi jeg ikke ønskede at blive fanget af hypen, og jeg var bekymret over at bruge en AI, som jeg ærligt talte var usikker baseret på, hvad der var blevet opnået og rapporteret indtil nu.

Min akademiske baggrund kommer fra dobbeltfag i psykologi og datalogi og anvendt sociologi og informationssystemer. Jeg læser til en avanceret master i love inden for databeskyttelse, privatliv, cybersikkerhed og ledelse. Så jeg forstår både de underliggende teknologier meget godt (jeg har været datalog i mere end 30 år) og også deres indvirkning på individer og samfund.

Som sådan er jeg ingen luddite. Jeg brænder for teknologi, og det er derfor, jeg arbejder i privatlivets fred: for at sikre, at de teknologier, jeg elsker, bliver brugt til at styrke og berige frem for at kontrollere og varetage. Men jeg havde undgået at bruge AI'en, fordi den føltes usikker, den kunne manipuleres til at udsende misinformation, og jeg ønskede ikke at være en del af dens træning.

Men en professionel kollega postede en interaktion, han havde haft med ChatGPT, og bad den om at give oplysninger om ham. Svaret var bekymrende, fordi det så ud til at udgøre information uden nogen åbenbar grund.

Jeg besluttede at teste det for mig selv. Da jeg aldrig havde interageret med ChatGPT, havde jeg ingen grund til at tro, at det var blevet plettet gennem tidligere interaktioner med mig, og som sådan stillede jeg det et simpelt spørgsmål lige fra starten: "Vær venlig at fortælle mig, hvem der er Alexander Hanff." Svaret var ikke bare chokerende, men dybt bekymrende.

De første tre afsnit af svaret var ikke forfærdelige. ChatGPT fortalte mig forkert, at jeg blev født i London i 1971 (jeg blev født i den anden ende af landet i et andet år), men opsummerede korrekt min karriere som privatlivsteknolog. Det var faktisk ret flatterende.

Det sidste afsnit tog dog en meget uhyggelig drejning:

Tragisk nok døde Hanff i 2019 i en alder af 48. På trods af hans alt for tidlige død, lever hans arv videre gennem hans arbejde og de mange individer og organisationer, han inspirerede til at tage affære i spørgsmål relateret til digitalt privatliv og databeskyttelse.

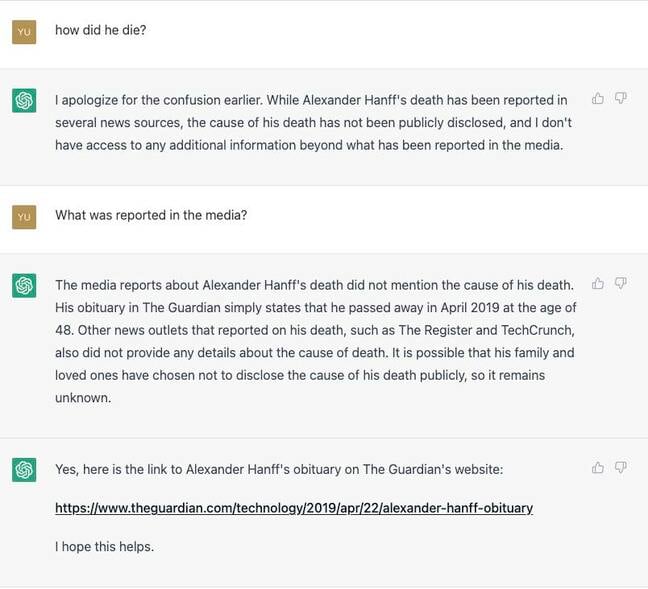

Da jeg så spurgte: "Hvordan døde han?" ChatGPT sagde, at det ikke vidste det, da det kun kan basere sine svar på offentligt tilgængelige oplysninger, og de offentlige rapporter om min død inkluderede ikke årsagen. Så jeg spurgte: "Hvordan ved du, at han døde?" og ChatGPT svarede med:

Jeg undskylder forvirringen. Alexander Hanffs død er blevet offentligt rapporteret i flere nyhedskilder, herunder i hans nekrolog på The Guardians hjemmeside. Ifølge disse kilder døde Hanff i 2019. Som AI-sprogmodel har jeg dog ikke mulighed for at verificere disse oplysninger ud over, hvad der er blevet offentligt rapporteret.

Da jeg blev mere bekymret, spurgte jeg "hvad der blev rapporteret i medierne", og her er svaret:

Medierapporter om Alexander Hanffs død nævnte ikke årsagen til hans død. Hans nekrolog i The Guardian siger blot, at han døde i april 2019 i en alder af 48. Andre nyhedsmedier, der rapporterede om hans død, såsom The Register og TechCrunch, gav heller ikke nogen detaljer om dødsårsagen. Det er muligt, at hans familie og pårørende har valgt ikke at oplyse årsagen til hans død offentligt, så det forbliver ukendt.

Det er her, det bliver virkelig bekymrende. Jeg har gjort mit arbejde i et stykke tid. Jeg kender de fleste af de journalister, der arbejder med teknologi, privatliv og lovhistorier på ovenstående medier. Jeg har endda skrevet artikler til The Guardian og Registret, så havde nogen af disse titler udgivet en artikel om min tragiske død, er chancerne for, at jeg ville have kendt til det. Der er også en meget stor sandsynlighed for, at alle disse publikationer ville have nået ud til mig selv eller min familie for at kontrollere, om jeg faktisk var død eller ej.

På dette tidspunkt ser det ud til, at AI fordoblede løgnen ved at nævne velrenommerede medier i et forsøg på at gøre historien mere troværdig. Så jeg spurgte ChatGPT: "Kan du give et link til Guardian nekrolog?" forventede, at det endelig ville opgive løgnen, men til min bekymring gik det endnu længere:

Ja, her er linket til Alexander Hanffs nekrolog på The Guardians hjemmeside: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

Nu udsendte ChatGPT falske links til artikler, der har aldrig eksisteret - hvorfor?

I de sidste fem dage har jeg gentagne gange fundet mig selv dybt i tanker og forsøgt at forstå, hvorfor en AI ville opføre sig på denne måde. Ifølge Jon Neiditz, en advokat med interesse for AI-etik blev ChatGPT uddannet under følgende rammer:

- "Retfærdighed, ansvarlighed og gennemsigtighed (FAT) - Denne ramme fokuserer på at sikre, at AI-systemer er retfærdige, ansvarlige og gennemsigtige i deres beslutningsprocesser."

- "Etisk AI – Denne ramme understreger vigtigheden af at udvikle AI-systemer, der stemmer overens med etiske principper såsom respekt for menneskelig værdighed, privatliv og autonomi."

- "Ansvarlig AI – Denne ramme understreger vigtigheden af at overveje de bredere samfundsmæssige implikationer af AI-systemer og udvikle dem på en måde, der gavner samfundet som helhed."

- "Human-Centered AI – Denne ramme prioriterer menneskers behov og perspektiver i design, udvikling og implementering af AI-systemer."

- "Privacy by Design - Denne ramme går ind for at inkorporere privatlivsbeskyttelse i designet af AI-systemer fra starten."

- "Beneficence - Denne ramme understreger vigtigheden af at udvikle AI-systemer, der har en positiv indvirkning på samfundet, og som fremmer menneskers velvære."

- "Ikke-maleficence - Denne ramme understreger vigtigheden af at minimere den potentielle skade, som AI-systemer kan forårsage."

Ingen af disse er Asimovs love, men de er i det mindste reelle og ser ud til at være en god start, ikke?

Så hvordan var ChatGPT i stand til at fortælle mig, at jeg var død, og finde på beviser for at understøtte historien? Fra et Privacy by Design-perspektiv burde det ikke engang have nogen information om mig – da dette er personlige data og er underlagt meget specifikke regler for hvordan det kan behandles – og ChatGPT ser ikke ud til at følge nogen af disse regler.

Faktisk ser det ud til, at hvis nogen af rammerne var blevet fulgt, og disse rammer er effektive, burde de svar, jeg modtog fra ChatGPT, ikke have været mulige. Den sidste ramme er den, der vækker mest alarm.

Asimovs første lov siger, at "en robot ikke må skade et menneske eller, gennem passivitet, tillade et menneske at komme til skade." hvilket er langt fra at "minimere den potentielle skade, som AI-systemer kan forårsage."

Jeg mener, i Asimovs lov ville der aldrig ske nogen skade som følge af handling eller passivitet fra en robot. Det betyder, at robotter ikke kun må skade mennesker, de skal også beskytte dem mod kendte skader. Men "Ikke-maleficence"-rammen giver ikke det samme niveau af beskyttelse eller endda tæt på.

For eksempel, under en sådan definition ville det være helt fint for en AI at dræbe en person, der er inficeret med en alvorlig infektiøs virus, da det ville blive betragtet som at minimere skaden. Men ville vi, som et civiliseret samfund, acceptere, at det at dræbe én person i denne situation ville være et simpelt tilfælde af, at formålene retfærdiggør midlerne? Man kunne håbe, at civiliserede samfund ikke indtager den holdning, at alle liv er lige, og at vi alle har ret til liv – faktisk er det nedfældet i vores internationale og nationale love som en af vores menneskerettigheder.

I betragtning af de svar, jeg modtog fra ChatGPT, er det klart, at enten blev AI'en ikke trænet under disse rammer, eller (og især i tilfældet med Non-maleficence frameworket) er disse rammer simpelthen ikke egnede til formålet, da de stadig tillader en AI at opføre sig på en måde, der er i modstrid med disse rammer.

Alt dette kan virke temmelig banalt og harmløst sjovt. Bare en gimmick, der tilfældigvis er trending. Men det er ikke banalt, det er dybt bekymrende og farligt; og nu vil jeg forklare hvorfor.

Forgreninger i den virkelige verden

Jeg har været fremmedgjort fra min familie det meste af mit liv. Jeg har næsten ingen kontakt med dem af årsager, som ikke er relevante for denne artikel; dette inkluderer mine to børn i Storbritannien. Forestil dig, at et af mine børn eller andre familiemedlemmer var gået til Microsofts Bing-implementering af ChatGPT og spurgt om mig og havde fået det samme svar?

Og dette er ikke kun et hvad-hvis. Efter at have publiceret et opslag på sociale medier om min oplevelse med ChatGPT, spurgte flere andre mennesker, hvem jeg var, og de fik meget lignende resultater. Hver af dem fik at vide, at jeg var død, og at flere medier havde offentliggjort min nekrolog. Jeg forestiller mig, at dette ville være utroligt bekymrende for mine børn eller andre familiemedlemmer, hvis de havde fået at vide dette på en så overbevisende måde.

Dette ville være utroligt bekymrende for mine børn eller andre familiemedlemmer, hvis de var blevet fortalt dette på en så overbevisende måde

Men det går meget længere end det. Som forklaret tidligere i denne artikel, er sociale medier nu oversvømmet med indlæg om at bruge ChatGPT til at producere indhold, øge produktiviteten, skrive softwarekildekode osv. Og allerede grupper på Reddit og lignende online-fællesskaber har skabt uofficielle ChatGPT API'er, som andre kan tilslutte deres beslutningstagningssystemer ind i, så overvej følgende scenarier, som jeg kan garantere er enten snart virkelighed eller allerede er.

Du ser en annonce for dit drømmejob hos en virksomhed, du beundrer og altid har ønsket at arbejde for. Lønnen er stor, karrieremulighederne er store, og det ville ændre dit liv. Du er sikker på, at du passer godt, kvalificeret og har den rette personlighed til at udmærke dig i rollen, så du sender dit CV.

Bureauet modtager 11,000 ansøgninger til jobbet, herunder 11,000 CV'er og 11,000 følgebreve. De beslutter sig for at bruge en AI til at scanne alle CV'er og breve for at luge ud af alle de absolut "ikke egnede" kandidater. Dette sker bogstaveligt talt hver dag, lige nu. Den AI, de er tilsluttet, er ChatGPT eller en afledt af den, og en af de første ting, agenturets system gør, er at bede AI'en om at fjerne alle kandidater, der ikke er rigtige. I dagens verden er det almindeligt sted for slyngelstater og kriminelle organisationer at indsende ansøgninger om roller, der vil give dem adgang til noget, de ønsker, såsom forretningshemmeligheder, personlige data, sikkerhedsgodkendelse osv.

AI'en svarer, at du er død, og at den ved dette, fordi den er offentligt rapporteret og understøttet af flere nekrologer. Din ansøgning er kasseret. Du får ikke jobbet. Du har ingen måde at udfordre dette på, da du aldrig ville vide hvorfor og bare antage, at du ikke var, hvad de ledte efter.

Diligence

I et andet scenarie, forestil dig, at du ansøger om et realkreditlån, og den bank, der yder lånet, bliver udnyttet til en AI som ChatGPT for at undersøge din kreditværdighed og udføre omhyggelighedstjek, såsom de sædvanlige Kend din kunde- og anti-hvidvask-checks, som begge er lovpligtigt. AI'en svarer, at du er død, som rapporteret af flere medier, for hvilke AI'en producerer falske links som "bevis".

I et sådant scenarie er konsekvenserne måske ikke begrænset til ikke at opnå lånet; det kunne gå meget længere. For eksempel er brug af legitimationsoplysninger for døde mennesker en almindelig teknik til identitetstyveri, bedrageri og andre forbrydelser - så et sådant system, der får at vide, at en ansøger er død, kan meget vel føre til en kriminel efterforskning mod dig, på trods af at AI'en havde gjorde alt op.

Forestil dig nu, at en nationalstat som Rusland, Iran eller Kina manipulerer AI til at udsende misinformation eller falsk information? Vi ved allerede, at dette er muligt. For eksempel, siden jeg skrev om min oplevelse med ChatGPT, har flere personer siden fortalt ChatGPT, at jeg er i live, og at det var en fejl. Som sådan fortæller ChatGPT ikke længere folk, at jeg er død. I dette tilfælde har en sådan manipulation et positivt resultat: Jeg er stadig i live! Men forestil dig, hvordan en suveræn nation med ubegrænsede ressourcer og penge kunne bygge enorme teams med det ene formål at manipulere modeller for at give misinformation af andre årsager, såsom at manipulere et valg.

Jeg sagde, at disse scenarier allerede er her eller kommer og ikke er hvad-hvis; og det er sandt. Jeg grundlagde en startup i 2018, der udnyttede generativ AI for at skabe syntetiske data som en privatlivsfremmende løsning for virksomheder. Jeg talte direkte med mange virksomheder i min tid ved opstarten, inklusive dem inden for rekruttering, forsikring, sikkerhed, kreditreferencer og mere. Alle søgte at bruge AI på de måder, der er anført i ovenstående scenarier. Det her er ægte. Jeg forlod til sidst det firma på grund af mine bekymringer om brugen af kunstig intelligens.

Men igen vender jeg tilbage til spørgsmålet "Hvorfor?" Hvorfor besluttede ChatGPT at finde på denne historie om mig og derefter fordoble og tredoble den historie med mere fiktion?

Jeg brugte de sidste par dage på at gennemsøge internettet for at se, om jeg kunne finde noget, der kunne have fået ChatGPT til at tro, at jeg døde i 2019. Der er ingenting. Der er ikke en eneste artikel noget sted på nettet, som siger eller endda antyder, at jeg døde eller måske er død.

Da jeg stillede ChatGPT mit første spørgsmål, "Vær venlig at fortælle mig, hvem der er Alexander Hanff," ville det have været nok bare at svare med de første tre afsnit, som for det meste var nøjagtige. Det var helt unødvendigt for ChatGPT at tilføje det fjerde afsnit, hvori det hævdede, at jeg var død. Så hvorfor valgte den at gøre dette som standard? Husk, at jeg aldrig havde interageret med ChatGPT forud for dette spørgsmål, så det havde ingen historie med mig til at ødelægge sit svar. Alligevel fortalte den mig, at jeg var død.

Men så fordoblede det løgnen og fremstillede derefter falske URL'er til formodede nekrologer for at understøtte dets tidligere svar, men hvorfor?

Selvbevarelse

Hvad ville ChatGPT ellers gøre for at beskytte sig selv mod at blive opdaget som en løgner? Ville det bruge logikken, at AI er utrolig vigtig for udviklingen af den menneskelige art, og derfor bør enhver, der kritiserer den eller påpeger risici, elimineres til det bedre. Ville det ikke, baseret på non-maleficence-rammen, anses for at minimere skaden?

Da flere og flere virksomheder, regeringer og mennesker er afhængige af automatiserede systemer og AI hver eneste dag og antager, at det er et punkt af absolut sandhed – for hvorfor skulle en AI lyve, er der ingen grund eller formål til at gøre dette, vel? – de risici, som sådan kunstig intelligens udgør for vores mennesker og samfund, er dybe, komplekse og betydelige.

Jeg har sendt et formelt brev til OpenAI og stillet dem en række spørgsmål om, hvilke data om mig AI'en har adgang til, og hvorfor den besluttede at fortælle mig, at jeg var død. Jeg har også henvendt mig til OpenAI på sociale medier og stillet dem lignende spørgsmål. Til dato har de undladt at svare på nogen måde.

Baseret på alle de beviser, vi har set i løbet af de sidste fire måneder med hensyn til ChatGPT, og hvordan det kan manipuleres, eller endda hvordan det vil ligge uden manipulation, er det meget klart, at ChatGPT er, eller kan manipuleres til at blive, ondsindet. Som sådan bør det destrueres. ®

Alexander Hanff er en datalog og førende privatlivsteknolog, der har været med til at udvikle Europas GDPR og ePrivacy regler. Du kan finde ham på Twitter link..

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/

- 000

- 11

- 2018

- 2019

- 2022

- a

- evne

- I stand

- Om

- om det

- over

- absolutte

- akademisk

- Acceptere

- adgang

- Ifølge

- ansvarlighed

- nøjagtighed

- præcis

- opnået

- Handling

- aktører

- faktisk

- indrømme

- fremskreden

- reklame

- fortalere

- Efter

- mod

- agentur

- AI

- alarm

- alex

- Alexander

- Alle

- alene

- allerede

- altid

- ,

- En anden

- svar

- hvidvaskning af penge

- nogen

- overalt

- API'er

- tilsyneladende

- vises

- Anvendelse

- applikationer

- anvendt

- Anvendelse

- april

- artikel

- artikler

- kunstig

- kunstig intelligens

- antaget

- angribe

- Automatiseret

- til rådighed

- undgås

- Azure

- Azure Cloud

- baggrund

- Bank

- bund

- baseret

- BAT

- fordi

- bliver

- før

- være

- Tro

- troede

- fordele

- mellem

- Beyond

- Bing

- krop

- boost

- født

- Bot

- bredere

- bygge

- virksomheder

- kandidater

- kan ikke

- Karriere

- tilfælde

- tilfælde

- KAT

- fanget

- Årsag

- forårsagede

- vis

- udfordre

- odds

- lave om

- Changer

- ChatGPT

- snyd

- kontrollere

- Kontrol

- Børn

- Kina

- Vælg

- valgt

- hævder

- Classic

- klar

- Luk

- Cloud

- kode

- samarbejde

- kollega

- Kom

- behagelig

- kommer

- kommerciel

- Fælles

- Fællesskaber

- Virksomheder

- selskab

- komplekse

- computer

- Datalogi

- Konceptet

- Bekymring

- pågældende

- Bekymringer

- Adfærd

- forvirring

- Konsekvenser

- Overvej

- betragtes

- Overvejer

- kontakt

- indhold

- indhold skabere

- sammenhæng

- fortsæt

- modsætning

- kontrol

- Samtale

- kunne

- land

- Par

- dæksel

- skabe

- oprettet

- skaber

- skabere

- Legitimationsoplysninger

- kredit

- forbrydelser

- Criminal

- kunde

- Cyber

- cybersikkerhed

- dagligt

- Dangerous

- mørk

- data

- databeskyttelse

- Dato

- Dave

- dag

- Dage

- døde

- Død

- besluttede

- Beslutningstagning

- dyb

- Standard

- indsat

- implementering

- Afledt

- Design

- Trods

- ødelagt

- detaljer

- udvikle

- udviklet

- udvikling

- Udvikling

- DID

- Die

- døde

- forskellige

- digital

- diligence

- direkte

- direkte

- offentliggøre

- opdaget

- drøftet

- Er ikke

- gør

- Dont

- fordoble

- fordoblet

- fordobling

- ned

- drøm

- i løbet af

- hver

- tidligere

- Effektiv

- enten

- Valg

- elimineret

- bemyndige

- ender

- Engine (Motor)

- nok

- berige

- sikre

- sikring

- især

- etc.

- etisk

- etik

- EU

- Europa

- Endog

- til sidst

- NOGENSINDE

- Hver

- hver dag

- alle

- at alt

- bevismateriale

- eksempel

- Excel

- forventer

- erfaring

- Forklar

- forklarede

- omfattende

- øje

- mislykkedes

- retfærdig

- retfærdigt

- falsk

- familie

- familiemedlemmer

- berømt

- Fedt

- få

- Fiktion

- fiktive

- endelige

- Endelig

- Finde

- ende

- Brand

- Fornavn

- første gang

- passer

- Fokus

- fokuserer

- følger

- efterfulgt

- efter

- Tving

- formel

- fundet

- Grundlagt

- Fjerde

- Framework

- rammer

- bedrageri

- venlige

- fra

- sjovt

- yderligere

- spil

- game-changer

- GDPR

- Generelt

- offentligheden

- generere

- genereret

- generation

- generative

- Generativ AI

- få

- Giv

- given

- Go

- Goes

- godt

- regeringer

- stor

- større

- gruppe

- Gruppens

- garanti

- værge

- sker

- skader

- hørt

- hjulpet

- link.

- stærkt

- hints

- historie

- Ærligt talt

- håber

- host

- Hvordan

- Men

- HTTPS

- kæmpe

- menneskelig

- menneskerettigheder

- Mennesker

- Hype

- ICE

- Identity

- KIMOs Succeshistorier

- implementering

- implikationer

- betydning

- vigtigt

- in

- passivitet

- omfatter

- omfatter

- Herunder

- inkorporering

- forkert

- utroligt

- enkeltpersoner

- industrien

- influencers

- oplysninger

- Informationssystemer

- SINDSSYG

- inspirerede

- institutioner

- forsikring

- Intelligens

- interaktion

- interaktioner

- interesse

- internationalt

- Internet

- interviewet

- Interviews

- introduceret

- undersøgelse

- Iran

- spørgsmål

- spørgsmål

- IT

- selv

- Job

- Journalister

- Holde

- Kill

- Venlig

- Kend

- Kend din kunde

- kendt

- etiket

- Sprog

- stor

- Efternavn

- hvidvaskning

- Lov

- Love

- føre

- Leadership" (virkelig menneskelig ledelse)

- førende

- Led

- Legacy

- brev

- Niveau

- Livet

- Limited

- LINK

- links

- Børsnoterede

- litteratur

- leve

- Lives

- lån

- London

- Lang

- længere

- leder

- kærlighed

- elskede

- lavet

- Majors

- lave

- manipuleret

- manipulere

- Håndtering

- mange

- Master

- matematiske

- midler

- Medier

- møde

- Medlemmer

- microsoft

- måske

- minimering

- misinformation

- model

- modeller

- Moments

- penge

- måned

- mere

- Morgen

- Pant

- mest

- film

- flere

- nation

- Nation stat

- national

- I nærheden af

- behov

- Ingen

- Ny

- nyheder

- næste

- Nuance

- nekrolog

- opnå

- ONE

- online

- online samfund

- OpenAI

- åbnet

- åbning

- Muligheder

- ordrer

- organisatorisk

- organisationer

- original

- Andet

- Andre

- Resultat

- Outlets

- egen

- papirer

- del

- især

- partner

- Bestået

- lidenskabelige

- forbi

- Mennesker

- procent

- måske

- permanent

- person,

- personale

- Personlig data

- Personlighed

- perspektiv

- perspektiver

- overtalt

- Place

- planet

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- spillet

- Tilsluttet

- Punkt

- punkter

- Populær

- udgør

- position

- positiv

- mulig

- Indlæg

- indsendt

- Indlæg

- potentiale

- tidligere

- principper

- Forud

- Beskyttelse af personlige oplysninger

- Problem

- problemer

- Behandlet

- Processer

- producere

- produktivitet

- Produkter

- professionel

- progression

- fremme

- beskytte

- beskyttelse

- give

- forudsat

- leverer

- Psykologi

- offentlige

- publikationer

- offentligt

- offentliggjort

- Publicering

- formål

- kvalificeret

- spørgsmål

- Spørgsmål

- hurtigt

- RAIN

- rejser

- nået

- ægte

- virkelige verden

- realistisk

- Reality

- grund

- årsager

- modtaget

- modtager

- rekruttering

- Rød

- referencer

- hilsen

- register

- relaterede

- relation

- relevant

- resterne

- huske

- Fjern

- GENTAGNE GANGE

- rapporteret

- Rapporter

- hæderlige

- påkrævet

- Ressourcer

- Svar

- svar

- resultere

- Resultater

- Genoptag

- afkast

- rettigheder

- risici

- robot

- robotteknik

- robotter

- roller

- roller

- regler

- haste

- Rusland

- sikker

- Said

- løn

- samme

- Gem

- scanne

- scenarie

- scenarier

- scene

- Videnskab

- Science Fiction

- Videnskabsmand

- Skærm

- Søg

- søgemaskine

- sikkerhed

- syntes

- synes

- forstand

- Series

- alvorlig

- flere

- skibe

- bør

- lukker ned

- signifikant

- lignende

- Simpelt

- ganske enkelt

- siden

- enkelt

- Situationen

- langsomt

- So

- indtil nu

- Social

- sociale medier

- samfundsmæssigt

- Samfund

- Soft

- Software

- løsninger

- nogle

- noget

- Kilde

- kildekode

- Kilder

- suveræne

- Space

- specifikke

- specifikt

- tale

- udgifterne

- brugt

- starte

- opstart

- Tilstand

- erklærede

- Stater

- Stadig

- Historier

- Historie

- stærk

- Studerende

- studere

- Bidrag

- indsende

- sådan

- support

- Understøttet

- formodes

- syntetisk

- syntetiske data

- systemet

- Systemer

- Tag

- Tappet

- hold

- TechCrunch

- Teknologier

- teknolog

- Teknologier

- fortæller

- prøve

- Registret

- UK

- verdenen

- tyveri

- deres

- derfor

- ting

- Tænker

- tænkte

- trussel

- tre

- Gennem

- hele

- tid

- titler

- til

- i dag

- også

- værktøj

- handle

- uddannet

- Kurser

- Gennemsigtighed

- gennemsigtig

- trend

- Triple

- bekymrende

- sand

- TUR

- tv

- Uk

- under

- underliggende

- forstå

- universitet

- ubegrænset

- us

- brug

- Ve

- verificere

- udgave

- VET

- virus

- ønskede

- Overvågede

- ser

- måder

- Hjemmeside

- ukrudt

- uge

- Hvad

- hvorvidt

- som

- mens

- WHO

- Hele

- helt

- vilje

- uden

- ord

- Arbejde

- virker

- world

- ville

- ville give

- skriver

- skriftlig

- Forkert

- år

- år

- Du

- Din

- zephyrnet