Kunstig intelligens (AI) has created a furor recently with its possibility to revolutionize how people approach and solve different tasks and complex problems. From healthcare to finance, AI and its associated machine-learning models have demonstrated their potential to streamline intricate processes, enhance decision-making patterns and uncover valuable insights.

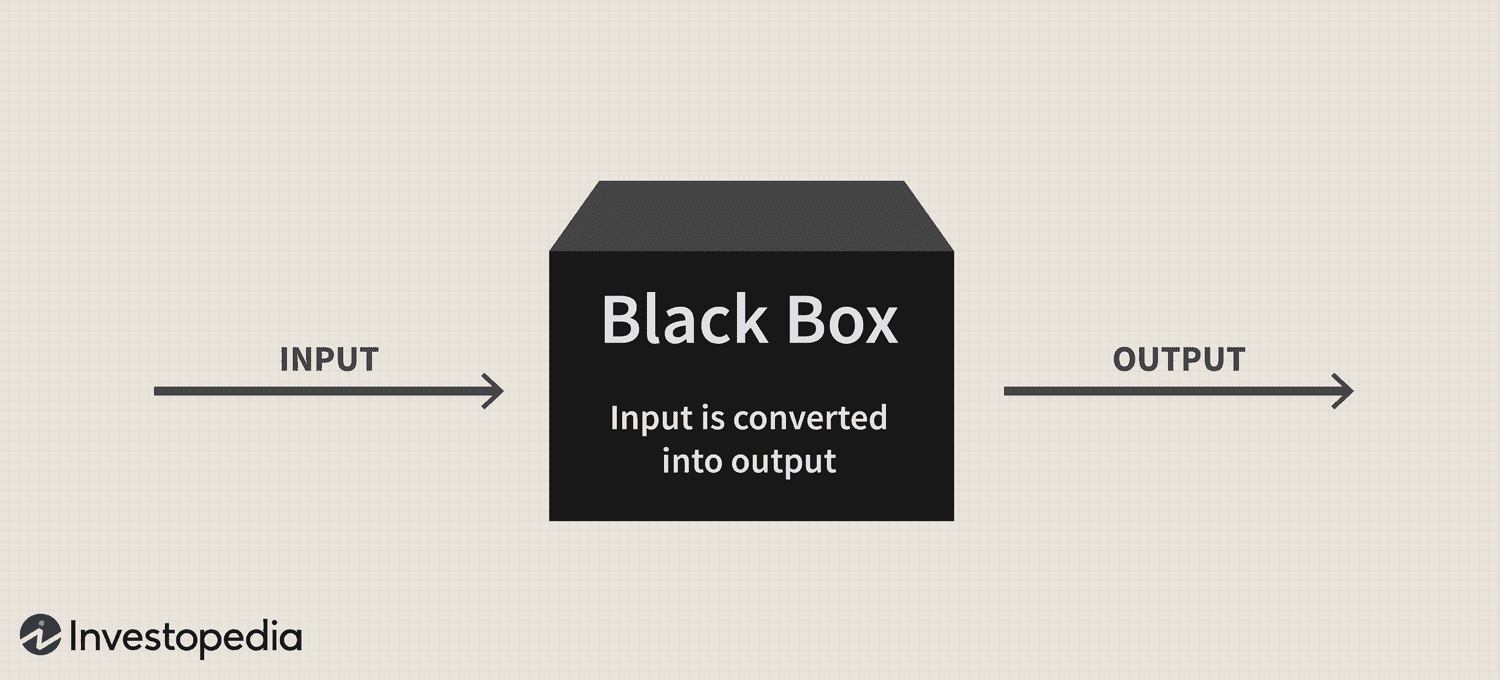

På trods af teknologiens enorme potentiale har et vedvarende "black box"-problem dog fortsat udgøre en betydelig udfordring for dens vedtagelse, hvilket rejser spørgsmål om gennemsigtigheden og fortolkningen af disse sofistikerede systemer.

Kort sagt stammer black box-problemet fra vanskeligheden ved at forstå, hvordan AI-systemer og maskinlæringsmodeller behandler data og genererer forudsigelser eller beslutninger. Disse modeller er ofte afhængige af indviklede algoritmer, som ikke er let forståelige for mennesker, hvilket fører til mangel på ansvarlighed og tillid.

Derfor, efterhånden som AI bliver mere og mere integreret i forskellige aspekter af vores liv, er det afgørende at løse dette problem for at sikre denne kraftfulde teknologis ansvarlige og etiske brug.

Den sorte boks: Et overblik

"Black box"-metaforen stammer fra forestillingen om, at AI-systemer og maskinlæringsmodeller fungerer på en måde, der er skjult for menneskelig forståelse, ligesom indholdet af en forseglet, uigennemsigtig boks. Disse systemer er bygget på komplekse matematiske modeller og højdimensionelle datasæt, som skaber indviklede relationer og mønstre, der styrer deres beslutningsprocesser. Imidlertid er disse indre funktioner ikke let tilgængelige eller forståelige for mennesker.

Rent praktisk er AI-sort boks-problemet vanskeligheden ved at tyde ræsonnementet bag et AI-systems forudsigelser eller beslutninger. Dette problem er især udbredt i deep learning-modeller som neurale netværk, hvor flere lag af indbyrdes forbundne noder behandler og transformerer data på en hierarkisk måde. Forviklingen af disse modeller og de ikke-lineære transformationer, de udfører, gør det yderst udfordrende at spore rationalet bag deres output.

Nikita Brudnov, CEO for BR Group - et AI-baseret marketinganalyse-dashboard - fortalte Cointelegraph, at manglen på gennemsigtighed i, hvordan AI-modeller når frem til bestemte beslutninger og forudsigelser, kan være problematisk i mange sammenhænge, såsom medicinsk diagnose, økonomisk beslutningstagning og retssager, hvilket i høj grad påvirker den fortsatte indførelse af kunstig intelligens.

Magazine: Joe Lubin: Sandheden om ETH-grundlæggernes splittelse og 'Crypto Google'

"I de seneste år er der blevet rettet meget opmærksomhed mod udviklingen af teknikker til at fortolke og forklare beslutninger truffet af AI-modeller, såsom generering af karakteristika for funktioner, visualisering af beslutningsgrænser og identificering af kontrafaktiske hypotetiske forklaringer," sagde han og tilføjede:

"Men disse teknikker er stadig i deres vorden, og der er ingen garanti for, at de vil være effektive i alle tilfælde."

Brudnov mener endvidere, at med yderligere decentralisering kan regulatorer kræve, at beslutninger truffet af AI-systemer er mere gennemsigtige og ansvarlige for at sikre deres etiske gyldighed og overordnede retfærdighed. Han foreslog også, at forbrugere kan tøve med at bruge AI-drevne produkter og tjenester, hvis de ikke forstår, hvordan de fungerer og deres beslutningsproces.

James Wo, grundlæggeren af DFG - et investeringsfirma, der aktivt investerer i AI-relaterede teknologier - mener, at black box-problemet ikke vil påvirke adoptionen i en overskuelig fremtid. Per Wo er de fleste brugere ikke nødvendigvis ligeglade med, hvordan eksisterende AI-modeller fungerer og er glade for blot at få nytte af dem, i det mindste for nu.

"På mellemlang sigt, når nyheden i disse platforme forsvinder, vil der helt sikkert være mere skepsis over for black box-metoden. Spørgsmålene vil også stige, efterhånden som brugen af kunstig intelligens kommer ind i krypto og Web3, hvor der er økonomiske indsatser og konsekvenser at overveje,” indrømmede han.

Indvirkning på tillid og gennemsigtighed

Et domæne, hvor fraværet af gennemsigtighed kan påvirke tilliden væsentligt, er AI-drevet medicinsk diagnostik. For eksempel kan AI-modeller analysere komplekse medicinske data i sundhedsvæsenet for at generere diagnoser eller behandlingsanbefalinger. Men når klinikere og patienter ikke kan forstå rationalet bag disse forslag, kan de stille spørgsmålstegn ved pålideligheden og validiteten af disse indsigter. Denne skepsis kan yderligere føre til tøven med at vedtage AI-løsninger, hvilket potentielt hæmmer fremskridt inden for patientpleje og personlig medicin.

På det finansielle område kan AI-systemer anvendes til kreditvurdering, afsløring af svindel og risikovurdering. Black box-problemet kan dog skabe usikkerhed med hensyn til retfærdigheden og nøjagtigheden af disse kreditvurderinger eller begrundelsen bag svindelvarsler, hvilket begrænser teknologiens evne til at digitalisere industrien.

Kryptoindustrien står også over for følgerne af black box-problemet. For eksempel er digitale aktiver og blockchain-teknologi forankret i decentralisering, åbenhed og verificerbarhed. AI-systemer, der mangler gennemsigtighed og fortolkning, står til at danne en afbrydelse mellem brugernes forventninger og virkeligheden af AI-drevne løsninger i dette rum.

Lovgivningsmæssige betænkeligheder

Fra et regulatorisk synspunkt giver AI black box-problemet unikke udfordringer. For det første kan uigennemsigtigheden af AI-processer gøre det stadig sværere for regulatorer at vurdere disse systemers overensstemmelse med eksisterende regler og retningslinjer. Desuden kan mangel på gennemsigtighed komplicere tilsynsmyndighedernes evne til at udvikle nye rammer, der kan håndtere de risici og udfordringer, som AI-applikationer udgør.

Lovgivere kan have svært ved at evaluere AI-systemers retfærdighed, partiskhed og databeskyttelsespraksis og deres potentielle indvirkning på forbrugerrettigheder og markedsstabilitet. Uden en klar forståelse af beslutningsprocesserne for AI-drevne systemer kan regulatorer desuden stå over for vanskeligheder med at identificere potentielle sårbarheder og sikre, at passende sikkerhedsforanstaltninger er på plads for at mindske risici.

One notable regulatory development regarding this technology has been the European Union’s Artificial Intelligence Act, which is moving closer to becoming part of the bloc’s statute book after reaching a provisional political agreement on April 27.

I sin kerne har AI-loven til formål at skabe et troværdigt og ansvarligt miljø for AI-udvikling i EU. Lovgivere har vedtaget et klassifikationssystem, der kategoriserer forskellige typer AI efter risiko: uacceptabel, høj, begrænset og minimal. Denne ramme er designet til at imødekomme forskellige problemer relateret til AI black box-problemet, herunder spørgsmål omkring gennemsigtighed og ansvarlighed.

Manglende evne til effektivt at overvåge og regulere AI-systemer har allerede anstrengt forholdet mellem forskellige industrier og regulerende organer.

Early last month, the popular AI chatbot ChatGPT was banned in Italy for 29 days, primarily due to privacy concerns raised by the country’s data protection agency for suspected violations of the EU’s General Data Protection Regulations (GDPR). However, the platform was allowed to resume its services on April 29 after CEO Sam Altman announced that he and his team had taken specific steps to comply with the regulator’s demands, including the revelation of its data processing practices and implementation of its implementation of age-gating measures.

Utilstrækkelig regulering af AI-systemer kan erodere offentlighedens tillid til AI-applikationer, efterhånden som brugerne bliver mere og mere bekymrede over iboende skævheder, unøjagtigheder og etiske implikationer.

Løsning af problemet med sort boks

For at løse AI black box-problemet effektivt er det afgørende at anvende en kombination af tilgange, der fremmer gennemsigtighed, fortolkning og ansvarlighed. To sådanne komplementære strategier er forklarlig AI (XAI) og open source-modeller.

XAI er et forskningsområde dedikeret til at bygge bro mellem kompleksiteten af AI-systemer og behovet for menneskelig fortolkning. XAI fokuserer på at udvikle teknikker og algoritmer, der kan give menneskeligt forståelige forklaringer på AI-drevne beslutninger, hvilket giver indsigt i begrundelsen bag disse valg.

Metoder, der ofte anvendes i XAI, omfatter surrogatmodeller, funktionsvigtighedsanalyse, følsomhedsanalyse og lokale fortolkbare modelagnostiske forklaringer. Implementering af XAI på tværs af brancher kan hjælpe interessenter med bedre at forstå AI-drevne processer, øge tilliden til teknologien og lette overholdelse af regulatoriske krav.

Sammen med XAI kan fremme af adoptionen af open source AI-modeller være en effektiv strategi til at løse black box-problemet. Open source-modeller giver fuld adgang til de algoritmer og data, der driver AI-systemer, hvilket gør det muligt for brugere og udviklere at granske og forstå de underliggende processer.

Denne øgede gennemsigtighed kan hjælpe med at opbygge tillid og fremme samarbejde mellem udviklere, forskere og brugere. Desuden kan open source-tilgangen skabe mere robuste, ansvarlige og effektive AI-systemer.

Black box-problemet i kryptorummet

Black box-problemet har betydelige konsekvenser for forskellige aspekter af kryptorummet, herunder handelsstrategier, markedsforudsigelser, sikkerhedsforanstaltninger, tokenisering og smarte kontrakter.

Inden for handelsstrategier og markedsforudsigelser vinder AI-drevne modeller popularitet, efterhånden som investorer søger at udnytte algoritmisk handel. Black box-problemet hindrer dog brugernes forståelse af, hvordan disse modeller fungerer, hvilket gør det udfordrende at vurdere deres effektivitet og potentielle risici. Følgelig kan denne uigennemsigtighed også resultere i uberettiget tillid til AI-drevne investeringsbeslutninger eller gøre investorer alt for afhængige af automatiserede systemer.

AI kommer til at spille en afgørende rolle i at forbedre sikkerhedsforanstaltningerne i blockchain-økosystemet ved at opdage svigagtige transaktioner og mistænkelige aktiviteter. Ikke desto mindre komplicerer black box-problemet verifikationsprocessen for disse AI-drevne sikkerhedsløsninger. Manglen på gennemsigtighed i beslutningstagningen kan udhule tilliden til sikkerhedssystemerne og give anledning til bekymringer om deres evne til at beskytte brugeraktiver og information.

Tokenisering og smarte kontrakter - to vitale komponenter i blockchain-økosystemet - er også vidne til øget integration af AI. Black box-problemet kan dog sløre logikken bag AI-genererede tokens eller smart kontraktudførelse.

Efterhånden som AI revolutionerer forskellige industrier, bliver det mere presserende at løse problemet med sort boks. Ved at fremme samarbejdet mellem forskere, udviklere, politiske beslutningstagere og industriens interessenter kan der udvikles løsninger til at fremme gennemsigtighed, ansvarlighed og tillid til AI-systemer. Derfor vil det være interessant at se, hvordan dette nye teknologiske paradigme fortsætter med at udvikle sig.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Køb og sælg aktier i PRE-IPO-virksomheder med PREIPO®. Adgang her.

- Kilde: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :har

- :er

- :ikke

- :hvor

- 2023

- 27

- a

- evne

- Om

- adgang

- tilgængelig

- ansvarlighed

- ansvarlig

- nøjagtighed

- tværs

- Lov

- aktivt

- aktiviteter

- tilføje

- Derudover

- adresse

- adressering

- vedtaget

- Vedtagelsen

- Vedtagelse

- fremskridt

- påvirke

- Efter

- agentur

- Aftale

- AI

- AI-loven

- AI chatbot

- AI-drevne

- målsætninger

- Advarsler

- algoritmisk

- algoritmisk handel

- algoritmer

- Alle

- allerede

- også

- blandt

- an

- analyse

- analytics

- analysere

- ,

- annoncerede

- applikationer

- tilgang

- tilgange

- passende

- april

- ER

- OMRÅDE

- omkring

- kunstig

- kunstig intelligens

- AS

- aspekter

- vurdering

- Aktiver

- forbundet

- At

- opmærksomhed

- Automatiseret

- BE

- bliver

- bliver

- blive

- været

- bag

- mener

- Bedre

- mellem

- skævhed

- fordomme

- Sort

- blockchain

- blockchain økosystem

- Blockchain teknologi

- organer

- bog

- grænser

- Boks

- brodannelse

- bygge

- opbyg tillid

- bygget

- virksomheder

- by

- CAN

- kan ikke

- kapitalisere

- hvilken

- tilfælde

- Direktør

- vis

- udfordre

- udfordringer

- udfordrende

- chatbot

- ChatGPT

- valg

- klassificering

- klassificeringssystem

- klar

- klinikere

- Cointelegraph

- samarbejde

- kombination

- komplementære

- komplekse

- kompleksitet

- Compliance

- komponenter

- forstå

- pågældende

- Bekymringer

- Konsekvenser

- følgelig

- Overvej

- forbruger

- Forbrugerrettigheder

- Forbrugere

- indhold

- sammenhænge

- fortsatte

- fortsætter

- kontrakt

- kontrakter

- Core

- kunne

- lands

- skabe

- oprettet

- kredit

- afgørende

- krypto

- Kryptoindustri

- krypto rum

- instrumentbræt

- data

- databeskyttelse

- databehandling

- databeskyttelse

- datasæt

- decentralisering

- beslutning

- Beslutningstagning

- afgørelser

- dedikeret

- dyb

- dyb læring

- definitivt

- krav

- demonstreret

- konstrueret

- Trods

- Detektion

- udvikle

- udviklet

- udviklere

- udvikling

- Udvikling

- forskellige

- svært

- vanskeligheder

- Vanskelighed

- digital

- Digitale aktiver

- digitalisere

- do

- domæne

- Dont

- køre

- grund

- nemt

- økosystem

- Effektiv

- effektivt

- effektivitet

- selvstændige

- muliggør

- forbedre

- styrke

- sikre

- sikring

- Går ind i

- Miljø

- væsentlig

- ETH

- etisk

- EU

- europæisk

- evaluere

- udvikle sig

- eksempel

- udførelse

- eksisterende

- forventninger

- forklarer

- Ansigtet

- ansigter

- faciliterende

- fairness

- Feature

- finansiere

- finansielle

- Firm

- fokuserer

- Til

- overskuelig

- formular

- Foster

- fremme

- grundlægger

- stiftere

- Framework

- rammer

- bedrageri

- bedrageri afsløring

- svigagtig

- fra

- fuld

- funktion

- yderligere

- Endvidere

- fremtiden

- vinder

- kløft

- GDPR

- Generelt

- generelle data

- generere

- generere

- indrømme

- gruppe

- garanti

- vejlede

- retningslinjer

- havde

- Gem

- Have

- he

- sundhedspleje

- hjælpe

- Høj

- hindrer

- hans

- Hvordan

- Men

- HTTPS

- menneskelig

- Mennesker

- identificere

- if

- enorme

- KIMOs Succeshistorier

- påvirker

- implementering

- gennemføre

- implikationer

- betydning

- in

- manglende evne

- omfatter

- Herunder

- Forøg

- øget

- stigende

- industrier

- industrien

- oplysninger

- iboende

- indsigt

- integreret

- integration

- Intelligens

- sammenkoblet

- interesse

- interessant

- ind

- investering

- Investorer

- investerer

- spørgsmål

- spørgsmål

- IT

- Italiensk vin

- ITS

- Mangel

- Efternavn

- lovgivere

- lag

- føre

- førende

- læring

- mindst

- Politikker

- retslige processer

- ligesom

- Limited

- Lives

- lokale

- logik

- maskine

- machine learning

- lavet

- lave

- Making

- måde

- mange

- Marked

- forudsigelser på markedet

- Marketing

- matematiske

- Kan..

- foranstaltninger

- medicinsk

- medicinske data

- medicin

- Metode

- måske

- mindste

- afbøde

- modeller

- Overvåg

- Måned

- mere

- Desuden

- mest

- flytning

- meget

- flere

- nødvendigvis

- Behov

- net

- neurale netværk

- Ikke desto mindre

- Ny

- ingen

- noder

- bemærkelsesværdig

- Begreb

- roman

- nyhed

- nu

- of

- off

- tilbyde

- tit

- on

- engang

- uigennemsigtig

- open source

- Åbenhed

- betjene

- or

- vores

- samlet

- betalt

- paradigme

- del

- især

- patient

- patienter

- mønstre

- Mennesker

- Udfør

- Personlig

- Place

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- politiske beslutningstagere

- politisk

- Populær

- popularitet

- Muligheden

- potentiale

- potentielt

- vigtigste

- Praktisk

- praksis

- Forudsigelser

- præsentere

- gaver

- fremherskende

- primært

- Beskyttelse af personlige oplysninger

- Problem

- problemer

- Proceedings

- behandle

- Processer

- forarbejdning

- Produkter

- fremme

- Fremme

- beskyttelse

- give

- midlertidig

- offentlige

- offentlig tillid

- spørgsmål

- Spørgsmål

- hævet

- hæve

- rationale

- nå

- Reality

- rige

- nylige

- for nylig

- anbefalinger

- om

- Regulere

- Regulering

- regler

- Regulators

- lovgivningsmæssige

- relaterede

- Relationer

- pålidelighed

- stole

- konsekvenser

- kræver

- Krav

- forskning

- forskere

- ansvarlige

- resultere

- Genoptag

- revolutionere

- revolutionerer

- rettigheder

- Risiko

- risikovurdering

- risici

- robust

- roller

- regler

- sikkerhedsforanstaltninger

- Said

- Sam

- Sam Altman

- scoring

- sikkerhed

- Sikkerhedsforanstaltninger

- se

- Søg

- Følsomhed

- Tjenester

- sæt

- Vis

- signifikant

- betydeligt

- ganske enkelt

- skepsis

- Smart

- smart kontrakt

- Smarte kontrakter

- Løsninger

- SOLVE

- sofistikeret

- Kilde

- Space

- specifikke

- delt

- Stabilitet

- interessenter

- stå

- står

- stængler

- Steps

- Stadig

- strategier

- Strategi

- strømline

- Kamp

- sådan

- mistænksom

- systemet

- Systemer

- Tandem

- opgaver

- hold

- tech

- teknikker

- Teknologier

- Teknologier

- vilkår

- at

- deres

- Them

- Der.

- Disse

- de

- denne

- til

- tokenization

- Tokens

- Trace

- Trading

- Trading Strategies

- Transaktioner

- Transform

- transformationer

- Gennemsigtighed

- gennemsigtig

- behandling

- Stol

- troværdig

- Sandheden

- to

- typer

- Usikkerhed

- afdække

- underliggende

- forstå

- forståelig

- forståelse

- enestående

- på

- us

- brug

- Bruger

- brugere

- nytte

- Værdifuld

- forskellige

- Verifikation

- Overtrædelser

- afgørende

- Sårbarheder

- var

- Web3

- hvornår

- som

- vilje

- med

- inden for

- uden

- vidne

- wo

- Arbejde

- arbejdssteder

- år

- zephyrnet