Forskere fra OpenAI, Cambridge University, Harvard University og University of Toronto tilbød "udforskende" ideer til, hvordan man regulerer AI-chips og hardware, og hvordan sikkerhedspolitikker kunne forhindre misbrug af avanceret kunstig intelligens.

Anbefalingerne giver måder til at måle og auditere udviklingen og brugen af avancerede AI-systemer og de chips, der driver dem. Anbefalinger til håndhævelse af politik omfatter begrænsning af systemernes ydeevne og implementering af sikkerhedsfunktioner, der fjernt kan deaktivere useriøse chips.

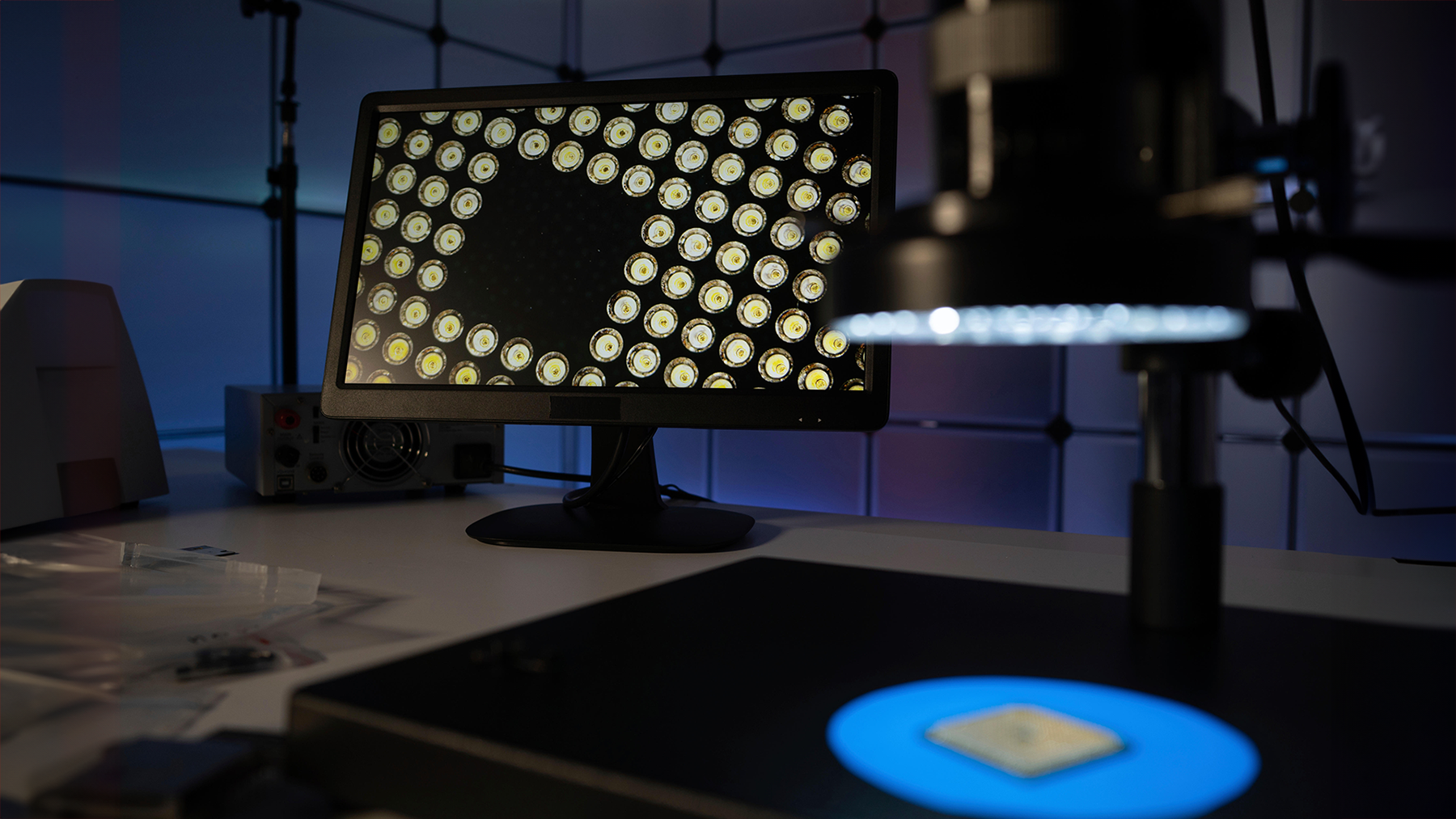

"Træning af yderst dygtige AI-systemer kræver i øjeblikket akkumulering og orkestrering af tusindvis af AI-chips," skrev forskerne. "[Hvis disse systemer er potentielt farlige, så kan en begrænsning af denne akkumulerede computerkraft tjene til at begrænse produktionen af potentielt farlige AI-systemer."

Regeringer har i vid udstrækning fokuseret på software til AI-politik, og papiret er en ledsager, der dækker hardwaresiden af debatten, siger Nathan Brookwood, hovedanalytiker hos Insight 64.

Industrien vil dog ikke hilse nogen sikkerhedsfunktioner, der påvirker ydeevnen af AI, velkommen, advarer han. At gøre AI sikker gennem hardware "er en ædel ambition, men jeg kan ikke se nogen af dem, der gør det. Anden er ude af lampen, og held og lykke med at få den ind igen,” siger han.

Drøvle forbindelser mellem klynger

Et af de forslag, forskerne foreslår, er et loft for at begrænse den databehandlingskapacitet, der er tilgængelig for AI-modeller. Ideen er at indføre sikkerhedsforanstaltninger, der kan identificere misbrug af AI-systemer, og afskære og begrænse brugen af chips.

Specifikt foreslår de en målrettet tilgang til at begrænse båndbredden mellem hukommelse og chipklynger. Det nemmere alternativ - at afskære adgangen til chips - var ikke ideelt, da det ville påvirke den samlede AI-ydeevne, skrev forskerne.

Avisen foreslog ikke måder at implementere sådanne sikkerhedsværn, eller hvordan misbrug af AI-systemer kunne opdages.

"At bestemme den optimale båndbreddegrænse for ekstern kommunikation er et område, der fortjener yderligere forskning," skrev forskerne.

Storskala AI-systemer kræver enorm netværksbåndbredde, og AI-systemer som Microsofts Eagle og Nvidias Eos er blandt de top 10 hurtigste supercomputere i verden. Der findes måder at begrænse netværkets ydeevne på for enheder, der understøtter programmeringssproget P4, som kan analysere netværkstrafik og omkonfigurere routere og switches.

Men held og lykke med at bede chipproducenter om at implementere AI-sikkerhedsmekanismer, der kan bremse chips og netværk, siger Brookwood.

"Arm, Intel og AMD har alle travlt med at bygge de hurtigste, ondeste chips, de kan bygge for at være konkurrencedygtige. Jeg ved ikke, hvordan man kan sætte farten ned,” siger han.

Fjerne muligheder indebærer en vis risiko

Forskerne foreslog også at deaktivere chips eksternt, hvilket er noget, som Intel har indbygget i sine nyeste serverchips. On Demand-funktionen er en abonnementstjeneste, der giver Intel-kunder mulighed for at slå on-chip-funktioner såsom AI-udvidelser til og fra som f.eks. sædevarme i en Tesla.

Forskerne foreslog også en attestationsordning, hvor chips kun tillader autoriserede parter at få adgang til AI-systemer via kryptografisk signerede digitale certifikater. Firmware kan give retningslinjer for autoriserede brugere og applikationer, som kan ændres med opdateringer.

Selvom forskerne ikke gav tekniske anbefalinger om, hvordan dette ville blive gjort, ligner ideen, hvordan fortrolig databehandling sikrer applikationer på chips ved at attestere autoriserede brugere. Intel , AMD har fortrolig databehandling på deres chips, men det er stadig tidlige dage endnu for den nye teknologi.

Der er også risici ved fjernhåndhævelse af politikker. "Fjernhåndhævelsesmekanismer kommer med betydelige ulemper og kan kun være berettiget, hvis den forventede skade fra AI er ekstrem høj," skrev forskerne.

Brookwood er enig.

"Selvom du kunne, vil der være slemme fyre, der vil forfølge det. At sætte kunstige begrænsninger for gode fyre vil være ineffektivt,” siger han.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.darkreading.com/cyber-risk/what-using-security-to-regulate-ai-chips-could-look-like

- :har

- :er

- :ikke

- :hvor

- 10

- 7

- a

- misbrug

- AC

- adgang

- Akkumuleret

- fremskreden

- påvirke

- er enig

- AI

- AI modeller

- AI-systemer

- Alle

- tillade

- også

- alternativ

- AMD

- blandt

- an

- analytiker

- analysere

- ,

- enhver

- applikationer

- tilgang

- ER

- OMRÅDE

- ARM

- kunstig

- AS

- spørge

- aspiration

- revision

- autoriseret

- til rådighed

- tilbage

- Bad

- båndbredde

- BE

- mellem

- bygge

- Bygning

- bygget

- travlt

- men

- by

- Cambridge

- CAN

- kasket

- stand

- Kapacitet

- bære

- certifikater

- ændret

- chip

- Chips

- Kom

- Kommunikation

- følgesvend

- konkurrencedygtig

- Compute

- computing

- computerkraft

- fortroligt

- Tilslutninger

- begrænsninger

- kunne

- dækker

- kryptografisk

- For øjeblikket

- Kunder

- Klip

- skære

- Dangerous

- Dage

- debat

- Efterspørgsel

- opdaget

- bestemmelse

- Udvikling

- Enheder

- DID

- digital

- do

- Don

- færdig

- ned

- ulemper

- eagle

- Tidligt

- lettere

- smergel

- Emerging Technology

- håndhævelse

- håndhæve

- EOS

- Endog

- eksisterer

- forventet

- udvidelser

- ekstern

- ekstremt

- hurtigste

- Feature

- Funktionalitet

- fokuserede

- Til

- fra

- yderligere

- Genie

- få

- gå

- godt

- retningslinjer

- Hardware

- skade

- Harvard

- Harvard Universitet

- Have

- he

- Høj

- stærkt

- Hvordan

- How To

- HTTPS

- i

- idé

- ideal

- identificere

- if

- gennemføre

- gennemføre

- in

- omfatter

- industrien

- indsigt

- Intel

- ind

- IT

- ITS

- Kend

- Sprog

- vid udstrækning

- ligesom

- GRÆNSE

- begrænsende

- Se

- ligner

- held

- Makers

- Making

- Kan..

- måle

- foranstaltninger

- mekanismer

- Hukommelse

- fortjenester

- microsoft

- modeller

- netværk

- netværkstrafik

- net

- Nyeste

- Noble

- Nvidia

- of

- off

- tilbydes

- on

- ONE

- kun

- OpenAI

- optimal

- or

- orkestrering

- ud

- samlet

- Papir

- parter

- ydeevne

- stykke

- Place

- plato

- Platon Data Intelligence

- PlatoData

- politikker

- politik

- muligheder

- potentielt

- magt

- forhindre

- Main

- forarbejdning

- produktion

- Programmering

- Forslag

- give

- forfølge

- sætte

- Sætte

- anbefalinger

- Regulere

- fjern

- fjernadgang

- Kræver

- forskning

- forskere

- Risiko

- risici

- s

- sikker

- siger

- Ordningen

- Sikrer

- sikkerhed

- Sikkerhedsforanstaltninger

- sikkerhedspolitikker

- se

- tjener

- server

- tjeneste

- side

- underskrevet

- signifikant

- lignende

- langsom

- Software

- nogle

- noget

- Sponsoreret

- Stadig

- abonnement

- sådan

- tyder

- Støtte

- Systemer

- målrettet

- Teknisk

- Teknologier

- at

- deres

- Them

- derefter

- Der.

- Disse

- de

- denne

- dem

- tusinder

- Gennem

- til

- toronto

- Trafik

- Kurser

- enorm

- TUR

- universitet

- opdateringer

- brug

- brugere

- ved brug af

- via

- advarer

- måder

- velkommen

- Hvad

- som

- WHO

- vilje

- med

- ville

- skrev

- endnu

- Du

- zephyrnet