Dette er en meningsredaktion af Aleksandar Svetski, forfatter til "The UnCommunist Manifesto" og grundlægger af den Bitcoin-fokuserede sprogmodel Spirit of Satoshi.

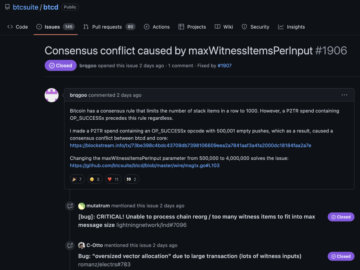

Sprogmodeller er i høj kurs, og mange mennesker tager bare basismodeller (oftest ChatGPT eller noget lignende) og forbinder dem derefter med en vektordatabase, så når folk stiller deres "model" et spørgsmål, reagerer den på svaret med kontekst fra denne vektordatabase.

Hvad er en vektor database? Jeg vil forklare det mere detaljeret i et fremtidigt essay, men en enkel måde at forstå det på er som en samling af information, der er lagret som bidder af data, som en sprogmodel kan forespørge og bruge til at producere bedre svar. Forestil dig "The Bitcoin Standard", opdelt i afsnit og gemt i denne vektordatabase. Du stiller denne nye "model" et spørgsmål om pengenes historie. Den underliggende model vil faktisk forespørge databasen, vælge det mest relevante stykke kontekst (et eller andet afsnit fra "The Bitcoin Standard") og derefter føre det ind i prompten af den underliggende model (i mange tilfælde ChatGPT). Modellen skulle så svare med et mere relevant svar. Dette er fedt og fungerer OK i nogle tilfælde, men løser ikke de underliggende problemer med almindelig støj og bias, som de underliggende modeller er underlagt under deres træning.

Det er det, vi prøver at gøre hos Spirit of Satoshi. Vi har bygget en model som det, der er beskrevet ovenfor for omkring seks måneder siden, som du kan prøve link.. Du vil bemærke, at det ikke er dårligt med nogle svar, men det kan ikke holde en samtale, og det klarer sig virkelig dårligt, når det kommer til shitcoinery og ting, som en rigtig Bitcoiner ville vide.

Det er derfor, vi har ændret vores tilgang og bygger en fuld sprogmodel fra bunden. I dette essay vil jeg tale lidt om det, for at give dig en idé om, hvad det indebærer.

En mere 'baseret' Bitcoin-sprogmodel

Missionen med at bygge en mere "baseret" sprogmodel fortsætter. Det har vist sig at være mere involveret, end jeg selv havde troet, ikke fra en "teknisk kompliceret" synspunkt, men mere fra en "for fanden det er kedeligt" synspunkt.

Det hele handler om data. Og ikke mængden af data, men kvaliteten og formatet af data. Du har sikkert hørt nørder tale om dette, og du sætter ikke rigtig pris på det, før du faktisk begynder at fodre tingene til en model, og du får et resultat... som ikke nødvendigvis var det, du ønskede.

Datapipelinen er der, hvor alt arbejdet er. Du skal indsamler , kuratere dataene, så skal du ekstrakt det. Så skal du programmæssigt ren det (det er umuligt at udføre en første kørselsrensning manuelt).

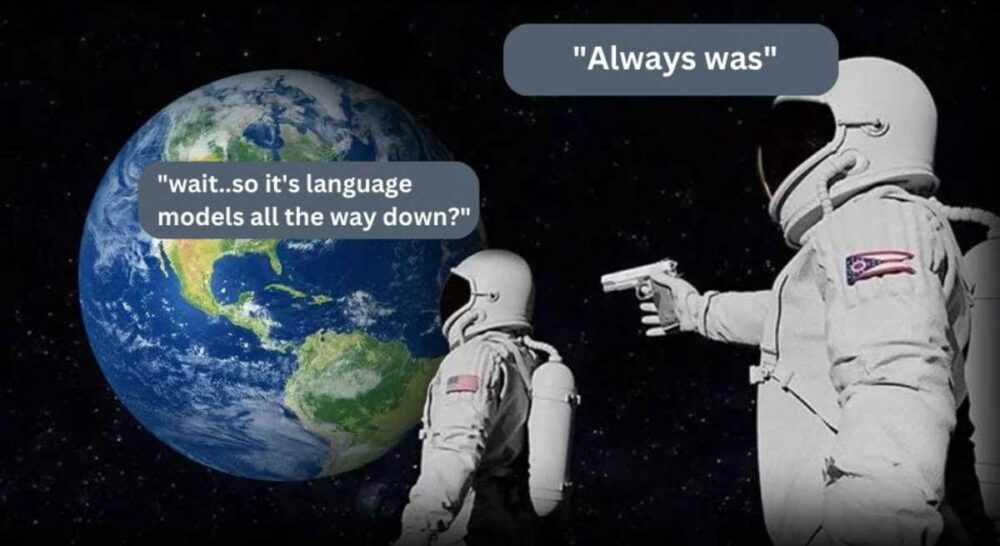

Så tager du disse programmatisk rensede, rå data, og du skal omdanne det til flere data formater (tænk på spørgsmål-og-svar-par eller semantisk sammenhængende bidder og afsnit). Dette skal du også gøre programmatisk, hvis du har med masser af data at gøre - hvilket er tilfældet for en sprogmodel. Sjovt nok er andre sprogmodeller faktisk gode til denne opgave! Du bruger sprogmodeller til at bygge nye sprogmodeller.

Derefter, fordi der sandsynligvis vil være masser af skrammel tilbage derinde, og irrelevant affald genereret af hvilken som helst sprogmodel, du brugte til programmæssigt at transformere dataene, er du nødt til at gøre en mere intens ren.

Denne er her, du har brug for at få menneskelig hjælp, for på dette stadium ser det ud til, at mennesker stadig er de eneste væsner på planeten med det nødvendige organ til at differentiere og bestemme kvalitet. Algoritmer kan sådan set gøre dette, men ikke så godt med sprog endnu - især i mere nuancerede, komparative sammenhænge - som er der, hvor Bitcoin sidder rigtigt.

Under alle omstændigheder er det utroligt svært at gøre dette i stor skala, medmindre du har en hær af mennesker til at hjælpe dig. Den hær af mennesker kan være lejesoldater betalt af nogen, som OpenAI som har flere penge end Gud, eller de kan være missionærer, hvilket er hvad Bitcoin-fællesskabet generelt er (vi er meget heldige og taknemmelige for dette hos Spirit of Satoshi). Enkeltpersoner gennemgår dataelementer og vælger én efter én, om de vil beholde, kassere eller ændre dataene.

Når dataene går igennem denne proces, ender du med noget rent i den anden ende. Selvfølgelig er der flere forviklinger involveret her. For eksempel skal du sikre dig, at dårlige aktører, der forsøger at fejle din oprydningsproces, bliver luget ud, eller at deres input kasseres. Du kan gøre det på en række måder, og alle gør det lidt forskelligt. Du kan screene folk på vej ind, du kan bygge en form for intern oprydningskonsensusmodel, så tærsklerne skal overholdes for at dataelementer kan opbevares eller kasseres osv. Hos Spirit of Satoshi laver vi en blanding af begge, og jeg gætter på, at vi vil se, hvor effektivt det er i de kommende måneder.

Nu ... når du først har fået disse smukke rene data ud, slutningen af denne "rørledning,” så skal du format det endnu en gang som forberedelse til "uddannelse" en model.

Denne sidste fase er, hvor de grafiske behandlingsenheder (GPU'er) kommer i spil, og det er virkelig, hvad de fleste mennesker tænker på, når de hører om at bygge sprogmodeller. Alle de andre ting, som jeg dækkede, bliver generelt ignoreret.

Denne hjemme-stretch-etape går ud på at træne en række modeller og lege med parametrene, datablandingerne, mængden af data, modeltyperne osv. Dette kan hurtigt blive dyrt, så du bedst har nogle pokkers gode data, og du' det er bedre at starte med mindre modeller og bygge dig op.

Det hele er eksperimentelt, og hvad du får ud i den anden ende er... et resultat…

Det er utroligt de ting, vi mennesker fremtryller. Alligevel…

Hos Spirit of Satoshi er vores resultat stadig undervejs, og vi arbejder på det på et par måder:

- Vi beder frivillige om at hjælpe os med at indsamle og kurere de mest relevante data for modellen. Det gør vi kl Nakamoto-depotet. Dette er et lager af alle bøger, essays, artikler, blogs, YouTube-videoer og podcasts om og relateret til Bitcoin, og perifere enheder som Friedrich Nietzsche, Oswald Spengler, Jordan Peterson, Hans-Hermann Hoppe, Murray Rothbard, Carl Jung, Bibelen osv.

Du kan søge efter hvad som helst der og få adgang til URL'en, tekstfilen eller PDF. Hvis en frivillig ikke kan finde noget, eller føler, at det skal med, kan de "føje" en rekord. Hvis de tilføjer skrammel, vil det dog ikke blive accepteret. Ideelt set vil frivillige indsende dataene som en .txt-fil sammen med et link.

- Fællesskabsmedlemmer kan også faktisk hjælpe os med at rense dataene og tjene sats. Kan du huske det missionærstadium, jeg nævnte? Nå det er det. Vi ruller en hel værktøjskasse ud som en del af dette, og deltagerne vil kunne spille "FUD buster" og "rank replies" og alle mulige andre ting. For nu er det som en Tinder-agtig behold/kasser/kommenter-oplevelse på datagrænsefladen for at rydde op i, hvad der er i pipelinen.

Dette er en måde for folk, der har brugt år på at lære om og forstå Bitcoin, til at omdanne dette "arbejde" til sats. Nej, de bliver ikke rige, men de kan hjælpe med at bidrage til noget, de måske anser for at være et værdigt projekt, og tjene noget hen ad vejen.

Sandsynlighedsprogrammer, ikke AI

I et par tidligere essays har jeg argumenteret for, at "kunstig intelligens" er et mangelfuldt udtryk, fordi mens det is kunstigt, det er ikke intelligent - og desuden har frygtpornoen omkring kunstig generel intelligens (AGI) været fuldstændig ubegrundet, fordi der bogstaveligt talt ikke er nogen risiko for, at denne ting bliver spontant sansende og dræber os alle. Et par måneder efter, og jeg er endnu mere overbevist om dette.

Jeg tænker tilbage på John Carters fremragende artikel "Jeg keder mig allerede med generativ AI" og han var så spot on.

Der er virkelig ikke noget magisk eller intelligent for den sags skyld ved nogen af disse AI-ting. Jo mere vi leger med det, jo mere tid vi faktisk bruger på at bygge vores eget, jo mere indser vi, at der ikke er nogen sans her. Der sker ingen egentlig tænkning eller ræsonnement. Der er intet bureau. Disse er blot "sandsynlighedsprogrammer."

Måden de er mærket på, og de udtryk, der slynges rundt, uanset om det er "AI" eller "maskine læring” eller ”agenter”, er faktisk der, hvor det meste af frygten, usikkerheden og tvivlen ligger.

Disse etiketter er blot et forsøg på at beskrive et sæt af processer, som virkelig er ulig noget, et menneske gør. Problemet med sproget er, at vi med det samme begynder at antropomorfisere det for at få mening ud af det. Og i færd med at gøre det, er det publikum eller lytteren, der puster liv i Frankensteins monster.

AI har ingen andet liv end hvad du giver det med din egen fantasi. Dette er meget det samme med enhver anden imaginær, eskatologisk trussel.

(Indsæt eksempler omkring klimaændringer, rumvæsener eller hvad der ellers foregår på Twitter/X.)

Dette er selvfølgelig meget nyttigt for globo-homo-bureaukrater, der ønsker at bruge et sådant værktøj/program/maskine til deres egne formål. De har snurret historier og fortællinger, siden før de kunne gå, og det her er bare den seneste, der har snurret. Og fordi de fleste mennesker er lemminger og vil tro, hvad end nogen, der lyder et par IQ-point smartere end dem, har at sige, vil de bruge det til deres fordel.

Jeg kan huske, at jeg talte om, at regulering er på vej. Jeg bemærkede, at i sidste uge eller ugen før er der nu "officielle retningslinjer" eller noget af den slags for generativ AI - høfligt af vores bureaukratiske overherrer. Hvad det betyder, er der ingen, der rigtig ved. Det er maskeret i det samme useriøse sprog, som alle deres andre regler er. Nettoresultatet er endnu en gang: "Vi skriver reglerne, vi får brugt værktøjerne, som vi vil, du skal bruge det, som vi fortæller dig det, ellers."

Den mest latterlige del er, at en flok mennesker jublede over dette og troede, at de på en eller anden måde er mere sikre fra det imaginære monster, der aldrig har været. Faktisk vil de sandsynligvis kreditere disse bureauer med at "redde os fra AGI", fordi det aldrig blev til noget.

Det minder mig om dette:

Da jeg postede ovenstående billede på Twitter, fortalte mængden af idioter, der reagerede med ægte tro på, at undgåelsen af disse katastrofer var et resultat af øget bureaukratisk indgriben, mig alt, hvad jeg havde brug for at vide om niveauet af kollektiv intelligens på den platform.

Ikke desto mindre er vi her. Endnu engang. Samme historie, nye karakterer.

Ak - der er virkelig lidt, vi kan gøre ved det, andet end at fokusere på vores egne ting. Vi vil fortsætte med at gøre det, vi har tænkt os at gøre.

Jeg er blevet mindre begejstret for "GenAI" generelt, og jeg får en fornemmelse af, at meget af hypen forsvinder, efterhånden som folks opmærksomhed bevæger sig over på udlændinge og politik igen. Jeg er også mindre overbevist om, at der er noget væsentligt transformativt her - i hvert fald i den grad, som jeg troede for seks måneder siden. Måske vil jeg blive bevist forkert. Jeg tror, at disse værktøjer har latent, uudnyttet potentiale, men det er bare det: latent.

Jeg tror, vi skal være mere realistiske med hensyn til, hvad de er (i stedet for kunstig intelligens er det bedre at kalde dem "sandsynlighedsprogrammer") og det kan faktisk betyde, at vi bruger mindre tid og energi på pipe dreams og fokuserer mere på at bygge brugbare applikationer. I den forstand forbliver jeg nysgerrig og forsigtigt optimistisk over, at noget virkelig materialiserer sig, og tror, at et eller andet sted i forbindelsen mellem Bitcoin, sandsynlighedsprogrammer og -protokoller som Nostr, vil noget meget nyttigt dukke op.

Det håber jeg, at vi kan tage del i, og jeg vil meget gerne have, at du også deltager i det, hvis du er interesseret. Til det formål vil jeg overlade jer alle til jeres dag, og jeg håber, at dette var et nyttigt 10-minutters indblik i, hvad det kræver at bygge en sprogmodel.

Dette er et gæsteindlæg af Aleksander Svetski. Udtalte meninger er helt deres egne og afspejler ikke nødvendigvis dem fra BTC Inc eller Bitcoin Magazine.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- ChartPrime. Løft dit handelsspil med ChartPrime. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://bitcoinmagazine.com/culture/how-to-build-your-own-bitcoin-language-model

- :har

- :er

- :ikke

- :hvor

- $OP

- 7

- a

- I stand

- Om

- over

- accepteret

- adgang

- aktører

- faktiske

- faktisk

- tilføje

- Fordel

- igen

- agenturer

- agentur

- AGI

- siden

- AI

- algoritmer

- udlændinge

- Alle

- sammen

- allerede

- også

- am

- beløb

- an

- ,

- besvare

- svar

- enhver

- noget

- app

- applikationer

- værdsætter

- tilgang

- ER

- argumenteret

- Army

- omkring

- artikel

- kunstig

- kunstig generel intelligens

- kunstig intelligens

- AS

- At

- opmærksomhed

- publikum

- forfatter

- tilbage

- Bad

- BE

- smuk

- fordi

- bliver

- blive

- været

- før

- begynde

- være

- tro

- Tro

- BEDSTE

- Bedre

- skævhed

- Bit

- Bitcoin

- Bitcoin Community

- Bitcoin Magazine

- bitcoin standard

- Blanding

- blandinger

- Blog

- bog

- Bored

- både

- BTC

- BTC Inc

- bygge

- Bygning

- bygget

- Bunch

- bureaukratisk

- men

- by

- ringe

- CAN

- kan ikke

- Carl

- tilfælde

- tilfælde

- katastrofer

- forsigtigt

- lave om

- ændret

- tegn

- ChatGPT

- Klima

- Klima forandring

- indsamler

- samling

- kollektive

- Kom

- kommer

- kommer

- samfund

- fuldstændig

- Tilslutning

- Konsensus

- sammenhæng

- sammenhænge

- fortsæt

- fortsætter

- bidrage

- Samtale

- overbevist

- Cool

- kunne

- Par

- Kursus

- dækket

- kredit

- CrunchBase

- nysgerrig

- data

- Database

- dag

- beskæftiger

- skønner

- Degree

- beskrive

- beskrevet

- detail

- Bestem

- differentiere

- do

- gør

- Er ikke

- gør

- Dont

- tvivler

- ned

- drømme

- i løbet af

- tjene

- Editorial

- Effektiv

- andet

- emerge

- ende

- energi

- nok

- sikre

- helt

- især

- HISTORIE

- etc.

- Endog

- begivenhed

- Hver

- alle

- eksempel

- eksempler

- fremragende

- ophidset

- dyrt

- erfaring

- eksperimenterende

- Forklar

- udtrykt

- Faktisk

- frygt

- fodring

- føler sig

- få

- File (Felt)

- endelige

- Finde

- fejlbehæftet

- Fokus

- Til

- format

- Foundation

- grundlægger

- fra

- fuld

- sjovt

- Endvidere

- fremtiden

- Generelt

- generel intelligens

- generelt

- genereret

- generative

- Generativ AI

- ægte

- få

- Giv

- Go

- Goes

- gå

- godt

- GPU'er

- taknemmelig

- Gæst

- gæst Indlæg

- havde

- Hans-Hermann Hoppe

- Happening

- Hård Ost

- Have

- he

- høre

- hørt

- hjælpe

- link.

- historie

- hold

- håber

- håbefuld

- Hvordan

- How To

- http

- HTTPS

- menneskelig

- Mennesker

- Hype

- i

- SYG

- idé

- ideelt

- if

- imaginær

- fantasi

- billede

- straks

- umuligt

- in

- medtaget

- øget

- utrolige

- utroligt

- enkeltpersoner

- oplysninger

- indgange

- indsigt

- i stedet

- Intelligens

- Intelligent

- interesseret

- grænseflade

- interne

- indgriben

- ind

- snørklede

- involverede

- spørgsmål

- IT

- Varer

- John

- Jordan

- Jordan Peterson

- jpg

- lige

- Holde

- holdt

- Venlig

- Kend

- Etiketter

- Sprog

- Efternavn

- seneste

- læring

- mindst

- Forlade

- til venstre

- mindre

- Niveau

- ligger

- Livet

- ligesom

- Sandsynlig

- LINK

- lytter

- lidt

- belastninger

- Lot

- kærlighed

- magasin

- Mainstream

- lave

- Making

- manuelt

- mange

- mange mennesker

- realitet

- Matter

- me

- betyde

- midler

- Medlemmer

- nævnte

- mødte

- microsoft

- måske

- Mission

- model

- modeller

- ændre

- penge

- måned

- mere

- mest

- bevæger sig

- meget

- flere

- Murray

- skal

- nakamoto

- fortællinger

- nødvendigvis

- nødvendig

- Behov

- behov

- behov

- netto

- aldrig

- Ny

- nexus

- ingen

- Støj

- Vores

- intet

- Varsel..

- nu

- of

- off

- tit

- on

- engang

- ONE

- kun

- på

- OpenAI

- Udtalelse

- Udtalelser

- Optimistisk

- or

- ordrer

- Andet

- vores

- ud

- egen

- betalt

- par

- parametre

- del

- deltagere

- Mennesker

- folks

- udfører

- måske

- periferiudstyr

- Peterson

- billede

- stykke

- rør

- pipeline

- planet

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- spiller

- podcast

- punkter

- politik

- Indlæg

- indsendt

- potentiale

- forberedelse

- tidligere

- sandsynligvis

- Problem

- behandle

- Processer

- forarbejdning

- producere

- Programmer

- projekt

- protokoller

- gennemprøvet

- formål

- kvalitet

- mængde

- Quantum

- spørgsmål

- hurtigt

- Rage

- Raw

- ægte

- realistisk

- indse

- virkelig

- optage

- afspejler

- Regulering

- regler

- relaterede

- relevant

- forblive

- huske

- Repository

- Svar

- reaktioner

- resultere

- afkast

- Rich

- Risiko

- Rullende

- regler

- sikrere

- samme

- Satoshi

- SATS

- siger

- Scale

- ridse

- Skærm

- Søg

- se

- synes

- forstand

- Series

- sæt

- bør

- lignende

- Simpelt

- siden

- sidder

- SIX

- Seks måneder

- mindre

- smartere

- So

- SOLVE

- nogle

- Nogen

- noget

- et eller andet sted

- tilbringe

- brugt

- Spin

- ånd

- delt

- Spot

- Stage

- standard

- standpunkt

- Starter

- Stadig

- opbevaret

- Historier

- Story

- emne

- indsende

- væsentligt

- sådan

- Omkringliggende

- Tag

- tager

- tager

- Tal

- taler

- fortælle

- semester

- vilkår

- end

- at

- deres

- Them

- derefter

- Der.

- Disse

- de

- ting

- ting

- tror

- Tænker

- denne

- dem

- selvom?

- tænkte

- trussel

- Gennem

- tid

- til

- Værktøjskasse

- værktøjer

- mod

- Kurser

- Transform

- transformative

- prøv

- typer

- Usikkerhed

- underliggende

- forstå

- forståelse

- enheder

- I modsætning til

- uudnyttet

- indtil

- URL

- us

- brug

- anvendte

- meget

- video

- frivilligt

- frivillige

- ønsker

- ønskede

- var

- Vej..

- måder

- we

- WebP

- uge

- GODT

- Hvad

- uanset

- hvornår

- hvorvidt

- som

- mens

- WHO

- Hele

- hvorfor

- vilje

- med

- Arbejde

- arbejder

- virker

- ville

- skriver

- Forkert

- år

- endnu

- Du

- Din

- youtube

- zephyrnet