Kommentar Microsofts definition af, hvad der gør og ikke udgør en AI-pc, er ved at tage form. Med den seneste version af Windows, en dedikeret Copilot-nøgle og en NPU, der kan udføre mindst 40 billioner operationer i sekundet, vil du snart kunne køre Microsoft Copilot lokalt, ja, på din maskine.

Redmond s krav for sin AI-model på Windows blev gjort officielle af Intel - en af de stærkeste cheerleaders i AI PC-kategorien - under chipgigantens AI topmøde i Taipei i denne uge.

At køre en stor sprogmodel (LLM) lokalt har nogle iboende fordele. Slutbrugere bør have lavere latenstid og derfor forbedrede svartider, da forespørgsler ikke skal sendes til og fra et fjerndatacenter, plus mere privatliv i teorien. For Microsoft frigør det i mellemtiden, at flytte mere af AI-arbejdsbyrden over på kundens enheder, dets egne ressourcer til andre opgaver, såsom at hjælpe med at træne den næste OpenAI-model eller tilbyde den som en cloud API.

Microsoft håber på at køre sin Copilot LLM udelukkende på NPU'erne, eller neurale processorenheder, i folks Windows AI-pc'er til sidst, at dømme efter kommentarer tilsyneladende lavet af Intel-chefer på topmødet. Vi kan forestille os, at x86-goliathen skubber den linje for at overbevise alle om, at dens silicium er kraftig nok til at køre Redmonds ting derhjemme eller på kontoret.

Selvom ideen om at frigøre Copilot fra Azures navlestreng kan være attraktiv for nogle, synes ikke alle at være fan af Clippy inkarneret og i det mindste en vis mængde behandling vil næsten helt sikkert blive udført i skyen i en overskuelig fremtid.

Intel-chefer har sagt det samme: Hurtigere hardware vil gøre det muligt for flere "elementer" af Copilot at køre lokalt. Med andre ord vil du stadig være afhængig af en netværksforbindelse for i det mindste noget af funktionaliteten, og resten vil AI-pc'en klare sig selv.

Årsagen burde ikke komme så meget som en overraskelse. Disse AI-pc'er har begrænsede ressourcer, og den model, der driver Copilot - OpenAI's GPT-4 - er enorm. Vi ved ikke præcis, hvor stor den version Microsoft bruger er, men skøn sætte den fulde GPT-4-model på omkring 1.7 billioner parametre. Selv med kvantisering eller kørsel af modellen ved INT4, har du brug for omkring 900 GB hukommelse.

Hvordan vi tror det vil fungere

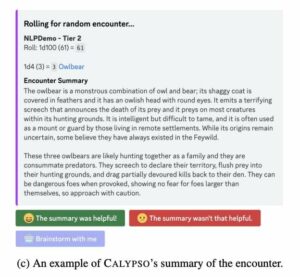

GPT-4 er en såkaldt mix-of-expert-model. I en nøddeskal betyder det, at den faktisk er samlet ud fra en række mindre, specialiserede fortrænede modeller, som forespørgsler sendes til. Ved at have flere modeller optimeret til tekstgenerering, opsummering, kodeoprettelse og så videre, kan inferencing-ydeevnen forbedres, da hele modellen ikke behøver at køre for at fuldføre en opgave.

Intels brug af udtrykket "elementer" til at beskrive kørende Copilot-funktioner lokalt antyder, at nogle af disse eksperter kunne erstatte mindre, smidige modeller, der er i stand til at køre på bærbar hardware. Som vi tidligere har undersøgt, er eksisterende personlig hardware mere end i stand til at køre mindre AI-modeller fra f.eks. Mistral eller Meta.

Tilfældigvis, Microsoft for nylig pumpes €15 millioner ($16.3 millioner) til den franske minimodelbygger Mistral AI, med planer om at gøre dets arbejde tilgængeligt for Azure-kunder. Med kun 7 milliarder parametre i størrelse er Mistral-7B bestemt lille nok til at passe komfortabelt ind i en AI-pc's hukommelse, og kræver i nærheden af 4 GB hukommelse, når du bruger 4-bit kvantisering.

Og det er til en generel model. Tænkeligt kunne du klare dig med endnu mindre modeller, der er indstillet til kildekodegenerering, som kun indlæses i hukommelsen, når applikationen, f.eks. Visual Studio Code, er lanceret, og et aktivt Github Copilot-abonnement detekteres. Husk, Copilot er mere end blot en chatbot; det er en række AI-funktioner, der er ved at blive indbygget i Microsofts OS og softwarebibliotek.

Redmond har ikke sagt, hvor meget hukommelse dens AI PC-specifikation kræver, men i vores erfaring med lokale LLM'er, 16 GB hurtig DDR5 burde være tilstrækkeligt.

Uanset hvilken vej Microsoft ender med at tage, kan kombinationen af lokale og eksterne modeller føre til noget interessant adfærd. Vi ved endnu ikke, under hvilke omstændigheder disse lokale modeller vil tage over, men Microsofts store mængde af Windows-enheder Pavan Davuluri har foreslået, at blandingen kan være dynamisk.

"Vi vil være i stand til at indlæse skift mellem skyen og klienten for at levere det bedste fra computere på tværs af begge disse verdener," sagde han på scenen under AMD's Advancing AI begivenhed i december. "Det samler fordelene ved lokal databehandling, ting som forbedret privatliv og reaktionsevne og latens med kraften fra skyen, højtydende modeller, store datasæt, inferencing på tværs af platforme."

Som sådan kan vi se et par scenarier, hvordan Microsoft kan bruge lokal AI. Den første er at aflaste arbejde fra Microsofts servere og forbedre svartider. Efterhånden som hardwaren forbedres, kan flere Copilot-funktioner skubbes ud af skyen og over på brugerens enheder.

Det andet ville være at have det som et fald tilbage i tilfælde af netværksafbrydelser. Du kan forestille dig, at din AI-pc bare bliver dummere i stedet for at stoppe helt, når den er afskåret fra nettet.

Hardware begrænsninger

Før du bliver alt for begejstret for split-brained AI-pc'er, der udarbejder off-grid manifester, er der i øjeblikket ikke nogen maskiner derude, der opfylder hardwarekravene, og det er ikke på grund af manglen på en Copilot-nøgle.

Problemet er, at NPU'er stadig er relativt nye i x86-silicium, og det, der findes, er ikke nær kraftfuldt nok. AMD var blandt de første til at tilføje en NPU til sine mobile processorer tilbage i begyndelsen af 2023 med lanceringen af sin Ryzen 7040 serie chips.

Denne lineup fik et ur bump i december under House of Zen's Advancing AI-begivenhed. AMD bragte også sine NPU'er til skrivebordet med lanceringen af sin 8000G APU'er på CES i januar i år.

Intel rullede sine dedikerede AI-acceleratorblokke ud med lanceringen af sin meteor sø mikroprocessordele i slutningen af december. Disse Core Ultra-chips har en NPU afledt af Intels Movidius vision processing unit (VPU), som Intel demoed kører en række forskellige arbejdsopgaver under sin Innovation-begivenhed sidste år.

Desværre er chips kun i stand til 10 til 16 billioner (typisk INT4) operationer i sekundet, langt under Microsofts 40 TOPS-specifikationer. Det betyder, at de fleste af de såkaldte AI-pc'er på markedet ikke opfylder kravene - ikke uden at læne sig op ad GPU'en for at udligne forskellen.

Både Intel og AMD har mere kapable chips, der kommer med henholdsvis Lunar Lake og Strix Point silicium. På kort sigt ser det dog ud til, at Qualcomm vil have markedet i et hjørne.

Notebooks med Qualcomms Snapdragon X Elite mobile processorer udkommer engang i midten af 2024 og vil have en NPU, der er i stand til 45 TOPS. Kombineret med en Adreno GPU, der er i stand til 4.6 teraFLOPS FP32-ydeevne, siger Qualcomm, at delen vil være i stand til at køre AI-modeller op til 13 milliarder parametre udelukkende på enheden og generere 30 tokens i sekundet, når de kører mindre LLM'er med 7 milliarder parametre.

Efterhånden som pc'er med højere ydeevne NPU'er og større hukommelseslagre ankommer, og små modeller bliver mere dygtige, formoder vi, at Microsoft vil begynde at overføre mere funktionalitet til lokale enheder - når hardwaren kan håndtere det. ®

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://go.theregister.com/feed/www.theregister.com/2024/03/31/microsoft_copilot_hardware/

- :har

- :er

- :ikke

- $OP

- 1

- 10

- 13

- 16

- 2023

- 30

- 40

- 7

- a

- I stand

- Om

- accelerator

- tværs

- aktiv

- faktisk

- tilføje

- passende

- fremrykkende

- AI

- AI modeller

- næsten

- også

- AMD

- blandt

- beløb

- an

- ,

- enhver

- api

- Anvendelse

- ER

- omkring

- AS

- samlet

- At

- attraktivt

- til rådighed

- Azure

- tilbage

- BE

- begynde

- adfærd

- jf. nedenstående

- fordele

- BEDSTE

- mellem

- Big

- Billion

- Blocks

- både

- Bringer

- bragte

- Builder

- men

- by

- Opkald

- CAN

- stand

- tilfælde

- Boligtype

- sikkert

- disse

- chatbot

- chip

- Chips

- omstændigheder

- kunde

- ur

- Cloud

- CO

- kode

- kombination

- kombineret

- Kom

- kommer

- fuldføre

- Compute

- computing

- tilslutning

- udgøre

- overbevise

- Core

- hjørnet

- Corporate

- kunne

- Par

- skabelse

- Cross

- For øjeblikket

- kunde

- Kunder

- Klip

- data

- datasæt

- Datacenter

- december

- dedikeret

- definition

- Afledt

- beskrive

- desktop

- opdaget

- enhed

- Enheder

- forskel

- forstyrrelser

- gør

- gør ikke

- Don

- færdig

- grund

- i løbet af

- dynamisk

- Tidligt

- elementer

- elite

- muliggøre

- ende

- ender

- forbedret

- enorm

- nok

- Hele

- helt

- Endog

- begivenhed

- til sidst

- alle

- præcist nok

- ophidset

- execs

- ledere

- eksisterer

- eksisterende

- erfaring

- eksperter

- udforsket

- Fall

- ventilator

- langt

- hurtigere

- Feature

- Funktionalitet

- Fornavn

- passer

- Til

- overskuelig

- Fransk

- fra

- fuld

- funktionalitet

- fremtiden

- Generelt

- generere

- generation

- få

- få

- kæmpe

- GitHub

- gå

- GPU

- Grow

- håndtere

- Hardware

- Have

- have

- he

- hjælpe

- Høj

- højere

- Home

- håber

- hus

- Hvordan

- Men

- HTTPS

- idé

- billede

- Forbedre

- forbedret

- forbedrer

- in

- I andre

- Innovation

- Intel

- interessant

- ind

- iboende

- isn

- spørgsmål

- IT

- ITS

- selv

- januar

- jpg

- lige

- Nøgle

- Kend

- etiket

- Mangel

- sø

- Sprog

- laptop

- stor

- større

- Efternavn

- Sidste år

- Sent

- Latency

- seneste

- lancere

- lanceret

- føre

- mindst

- Bibliotek

- ligesom

- synes godt om

- Line (linje)

- lineup

- ll

- LLM

- belastning

- lokale

- lokalt

- UDSEENDE

- lavere

- Lunar

- maskine

- Maskiner

- lavet

- lave

- Marked

- Kan..

- midler

- I mellemtiden

- Mød

- Hukommelse

- Meta

- microsoft

- måske

- million

- blande

- Mobil

- model

- modeller

- mere

- mest

- meget

- flere

- I nærheden af

- næsten

- Behov

- netto

- netværk

- neurale

- Ny

- næste

- nu

- nummer

- Nøddeskal

- of

- off

- tilbyde

- Office

- officiel

- on

- engang

- ONE

- kun

- på

- OpenAI

- Produktion

- optimeret

- or

- OS

- Andet

- vores

- ud

- i løbet af

- egen

- parametre

- del

- dele

- PC

- pc'er

- Mennesker

- per

- ydeevne

- personale

- planer

- perron

- plato

- Platon Data Intelligence

- PlatoData

- plus

- Punkt

- magt

- vigtigste

- strømforsyning

- tidligere

- Beskyttelse af personlige oplysninger

- forarbejdning

- processorer

- give

- formål

- skubbet

- Pushing

- sætte

- Qualcomm

- forespørgsler

- hellere

- RE

- grund

- modtaget

- for nylig

- relativt

- huske

- fjern

- Krav

- Ressourcer

- henholdsvis

- svar

- REST

- Rullet

- R

- dirigeret

- Kør

- kører

- s

- Said

- siger

- siger

- scenarier

- Anden

- se

- synes

- sendt

- Series

- Servere

- sæt

- Shape

- skifte

- SKIFT

- bør

- Silicon

- siden

- Størrelse

- lille

- mindre

- snap dragen

- So

- Software

- nogle

- snart

- Kilde

- kildekode

- specialiserede

- sportslige

- Stage

- Stadig

- standsning

- forhandler

- stærkeste

- Studio

- abonnement

- sådan

- foreslår

- suite

- Summit

- overraskelse

- Tag

- tager

- Opgaver

- opgaver

- semester

- end

- at

- teori

- Der.

- derfor

- Disse

- ting

- tror

- denne

- denne uge

- i år

- dem

- gange

- til

- sammen

- Tokens

- også

- Toppe

- Tog

- trillion

- tunet

- typisk

- Ultra

- under

- enhed

- enheder

- brug

- Bruger

- brugere

- ved brug af

- række

- Ve

- udgave

- vision

- visuel

- var

- we

- uge

- var

- Hvad

- hvornår

- som

- hvorfor

- vilje

- vinduer

- med

- uden

- Vandt

- ord

- Arbejde

- Verdens

- ville

- X

- år

- endnu

- Du

- Din

- youtube

- Zen

- zephyrnet