Længe før 2023 sluttede, var det allerede blevet kronet som året for generativ AI. Ansporet af fremkomsten af modeller som ChatGPT, der producerede detaljerede, skurrende menneskelige svar på brugermeddelelser, begyndte både eksperter og nybegyndere at overveje teknologiens potentielle indvirkning på arbejde, uddannelse og kreativitet.

Men mens nutidens store sprogmodeller (LLM'er) er fantastisk dygtige, er de også chokerende sårbare, siger Khoury-professor Alina Oprea. Hun har studeret AI i en cybersikkerhedskontekst i mere end et årti og var for nylig medforfatter til en rapport, der dykker ned i disse angreb på AI - hvordan de virker, hvordan de klassificeres, og hvordan de kan (og ikke kan) være mildnet.

"Det er virkelig svært at holde generativ AI sikker," siger Oprea. “Skalaen af disse modeller og deres træningsdata vil vokse over tid, hvilket kun gør disse angreb nemmere. Og når først du begynder at tale om generativ AI, der går ud over tekst til billeder og tale, bliver sikkerhed et meget åbent spørgsmål."

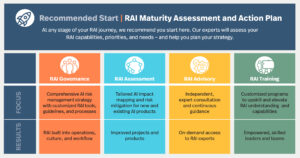

Rapporten, udgivet af Department of Commerce's National Institute of Standards and Technology (NIST), er en opdatering af rapporten Oprea var medforfattet sidste år sammen med NISTs Apostol Vassilev. Den første rapport omhandlede mere traditionel forudsigelig AI, men med generativ AI, der eksploderer i popularitet siden da, bød Opera og Vassilev generative AI-eksperter Alie Fordyce og Hyrum Anderson fra Robust Intelligence velkommen til at udvide projektets mandat.

"Nu har vi akademikere, regering og industri, der arbejder sammen," bemærkede Oprea, "som er den tiltænkte målgruppe for rapporten."

Ifølge rapporten skylder generative AI-modeller deres sårbarhed til en række faktorer. For det første, bemærker Oprea, er de fleste angreb "temmelig nemme at montere og kræver minimal viden om AI-systemet." For en anden er modellernes enorme træningsdatasæt for store til, at mennesker kan overvåge og validere. Og koden, der ligger til grund for modellerne, er ikke automatiseret; den er afhængig af menneskelig mådehold og er udsat for ondsindet menneskelig indblanding.

Resultatet, siger kvartetten af forskere, er fire hovedtyper af angreb, der forvirrer AI-systemer og får dem til at fungere forkert: unddragelsesangreb, der ændrer modellens input for at ændre dens svar, forgiftningsangreb, der korrumperer modellens underliggende algoritmer eller træningsdata, privatliv angreb, der lokker modellen til at afsløre følsomme træningsdata, såsom medicinsk information, og misbrugsangreb, der fører ukorrekte oplysninger ind i legitime kilder, som modellen lærer af. Ved at manipulere modellens input kan angribere vælge dens output på forhånd.

"Dette kan bruges til kommercielle formål, til reklame, til at generere malware-spam eller hadefulde ytringer - ting, som modellen normalt ikke ville generere," forklarer Oprea.

Uden at overbelaste sig selv kan ondsindede aktører kontrollere de webdata, en AI-model træner på, introducere en bagdør og så snigende styre modellens adfærd derfra. I betragtning af disse modellers eksploderende popularitet ville sådanne bagdøre være bekymrende nok i sig selv. Men skaden stopper ikke der.

"Vi har nu disse integrerede applikationer, der bruger LLM'er. For eksempel bygger en virksomhed en e-mail-agent, der integreres med en LLM i baggrunden, og den kan nu læse dine e-mails og sende e-mails på dine vegne,” siger Oprea. "Men angribere kunne bruge det samme værktøj til at sende malware og spam til tusindvis af mennesker. Angrebsoverfladen er steget, fordi vi integrerer LLM'er i disse applikationer."

Hvor destruktivt og farligt som hadefulde ytringer og massespam er, er der endnu større sikkerhedsproblemer i horisonten.

"Nogle applikationer er sikkerhedskritiske, som selvkørende biler," siger Oprea. "Hvis disse modeller laver forkerte forudsigelser, kan de ikke bruges."

Så hvad kan man gøre? Holdet udarbejdede rapporten, som de planlægger at opdatere årligt, for nogle få målgrupper - politiske beslutningstagere, AI-udviklere og akademikere, der kan bruge rapportens taksonomi som grundlag eller kontekst for deres eget arbejde. Alle disse grupper, siger Oprea, har arbejde at gøre for at sikre, at AI-modeller tilpasser sig menneskelige værdier, bevarer privatlivets fred og fungerer i brugernes bedste interesse. Men hun erkender, at det er udfordrende at tage fat på alle spørgsmål, der rejses i rapporten, og at enhver, der sælger løsninger frem for afhjælpning, tager alvorligt fejl.

"Der er mange flere angreb end afbødninger, og for hver afbødning, vi nævner, er der en afvejning eller en præstationsoverhead, herunder forringelse af modellens nøjagtighed," advarer Oprea. "Reduktionerne kommer ikke gratis, og at sikre AI er en virkelig udfordrende indsats, men vi håber, at rapporten giver et nyttigt udgangspunkt for at forstå angrebene."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.mtlc.co/in-the-age-of-chatgpt-ai-models-are-massively-popular-and-easily-compromised/

- :har

- :er

- 2023

- a

- Om

- misbrug

- akademikere

- nøjagtighed

- aktører

- adressering

- fremme

- advent

- reklame

- alder

- Agent

- AI

- AI modeller

- AI-systemer

- algoritmer

- tilpasse

- ens

- Alle

- allerede

- også

- ændre

- an

- ,

- anderson

- Årligt

- En anden

- nogen

- applikationer

- ER

- AS

- angribe

- Angreb

- publikum

- høringer

- Automatiseret

- bagdør

- Bagdøre

- baggrund

- BE

- fordi

- bliver

- været

- før

- begyndte

- vegne

- adfærd

- BEDSTE

- Beyond

- større

- bygger

- men

- by

- CAN

- stand

- biler

- Årsag

- advarer

- udfordrende

- lave om

- ChatGPT

- Vælg

- klassificeret

- kode

- Kom

- kommerciel

- selskab

- Kompromitteret

- vedrørende

- Bekymringer

- sammenhæng

- kontrol

- korrupt

- kunne

- Rådet

- kreativitet

- Cybersecurity

- skader

- Dangerous

- data

- datasæt

- behandlet

- årti

- dykker

- Afdeling

- detaljeret

- udviklere

- svært

- do

- Er ikke

- færdig

- Dont

- lettere

- nemt

- let

- Uddannelse

- emails

- bestræbe sig

- sluttede

- enorm

- nok

- sikre

- unddragelse

- Endog

- Hver

- eksempel

- Udvid

- eksperter

- Forklarer

- udsat

- faktorer

- få

- Til

- Foundation

- fire

- Gratis

- fra

- generere

- generere

- generative

- Generativ AI

- given

- Goes

- Regering

- Gruppens

- Grow

- havde

- hader

- Have

- håber

- horisont

- Hvordan

- HTTPS

- menneskelig

- Mennesker

- billeder

- Påvirkninger

- in

- Herunder

- forkert

- øget

- industrien

- oplysninger

- initial

- indgange

- Institut

- integreret

- Integrerer

- Integration

- Intelligens

- beregnet

- interesse

- ind

- indføre

- spørgsmål

- IT

- ITS

- Holde

- viden

- Sprog

- stor

- Efternavn

- Sidste år

- Leadership" (virkelig menneskelig ledelse)

- lærer

- legitim

- ligesom

- LLM

- større

- lave

- maerker

- ondsindet

- malware

- manipulere

- mange

- Masse

- massivt

- medicinsk

- nævne

- mindste

- afbødning

- model

- modeller

- mådehold

- Overvåg

- mere

- mest

- MONTERING

- national

- NIST

- bemærkede

- Noter

- nybegyndere

- nu

- of

- on

- engang

- ONE

- kun

- åbent

- Opera

- betjene

- or

- udgange

- i løbet af

- overliggende

- egen

- Mennesker

- ydeevne

- fly

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- forgiftning

- politiske beslutningstagere

- Populær

- popularitet

- potentiale

- Forudsigelser

- forberedt

- Beskyttelse af personlige oplysninger

- produceret

- Professor

- projekter

- prompter

- giver

- offentliggjort

- formål

- spørgsmål

- hævet

- hellere

- Læs

- virkelig

- for nylig

- afhængig

- indberette

- kræver

- forskere

- reaktioner

- afslørende

- robust

- samme

- siger

- siger

- Scale

- sikker

- fastgørelse

- sikkerhed

- selvkørende

- send

- følsom

- sæt

- hun

- siden

- Løsninger

- Kilder

- spam

- tale

- standarder

- starte

- Starter

- styre

- Stands

- studere

- sådan

- overflade

- systemet

- Systemer

- taler

- taksonomi

- hold

- tech

- Teknologier

- tekst

- end

- at

- deres

- Them

- selv

- derefter

- Der.

- Disse

- de

- ting

- dem

- tusinder

- tid

- til

- nutidens

- sammen

- også

- værktøj

- traditionelle

- Kurser

- tog

- typer

- underliggende

- understøtter

- forståelse

- Opdatering

- brug

- anvendte

- nyttigt

- Bruger

- brugere

- sædvanligvis

- VALIDATE

- Værdier

- række

- meget

- sårbarhed

- Sårbar

- we

- web

- hilste

- Hvad

- som

- mens

- WHO

- vilje

- med

- Arbejde

- arbejder

- ville

- år

- Du

- Din

- zephyrnet