Bias-detektion i data og modelresultater er et grundlæggende krav for at opbygge ansvarlig kunstig intelligens (AI) og machine learning (ML) modeller. Desværre er det ikke en let opgave at opdage bias for langt de fleste behandlere på grund af det store antal måder, hvorpå det kan måles og forskellige faktorer, der kan bidrage til et skævt resultat. For eksempel kan en ubalanceret sampling af træningsdataene resultere i en model, der er mindre nøjagtig for visse delmængder af dataene. Bias kan også indføres af selve ML-algoritmen - selv med et velafbalanceret træningsdatasæt kan resultaterne favorisere visse delmængder af dataene sammenlignet med de andre.

For at opdage bias skal du have en grundig forståelse af forskellige typer bias og de tilsvarende bias målinger. For eksempel i skrivende stund, Amazon SageMaker Clarify tilbyder 21 forskellige metrics at vælge imellem.

I dette indlæg bruger vi en indkomstforudsigelse (forudsige brugerindkomster fra inputfunktioner som uddannelse og antal arbejdstimer pr. uge) til at demonstrere forskellige typer skævheder og de tilsvarende målinger i SageMaker Clarify. Vi udvikler også en ramme for at hjælpe dig med at beslutte, hvilke målinger der betyder noget for din ansøgning.

Introduktion til SageMaker Clarify

ML-modeller bliver i stigende grad brugt til at hjælpe med at træffe beslutninger på tværs af en række forskellige domæner, såsom finansielle tjenester, sundhedspleje, uddannelse og menneskelige ressourcer. I mange situationer er det vigtigt at forstå, hvorfor ML-modellen lavede en specifik forudsigelse, og også om forudsigelserne var påvirket af bias.

SageMaker Clarify leverer værktøjer til begge disse behov, men i dette indlæg fokuserer vi kun på bias detection-funktionaliteten. For at lære mere om forklarlighed, tjek ud Forklaring af Bundesliga-kampfakta xGoals ved hjælp af Amazon SageMaker Clarify.

SageMaker Clarify er en del af Amazon SageMaker, som er en fuldt administreret tjeneste til at bygge, træne og implementere ML-modeller.

Eksempler på spørgsmål om bias

For at begrunde diskussionen er følgende eksempler på spørgsmål, som ML-byggere og deres interessenter kan have angående bias. Listen består af nogle generelle spørgsmål, der kan være relevante for flere ML-applikationer, samt spørgsmål om specifikke applikationer som f.eks. dokumentsøgning.

Du kan måske spørge, i betragtning af interessegrupperne i træningsdataene (f.eks. mænd vs. kvinder), hvilke målinger jeg skal bruge til at besvare følgende spørgsmål:

- Afspejler grupperepræsentationen i træningsdata den virkelige verden?

- Begunstiger målmærkerne i træningsdataene én gruppe frem for den anden ved at tildele den mere positive mærker?

- Har modellen forskellig nøjagtighed for forskellige grupper?

- I en model, hvis formål er at identificere kvalificerede kandidater til ansættelse, har modellen den samme præcision for forskellige grupper?

- I en model, hvis formål er at hente dokumenter, der er relevante for en inputforespørgsel, henter modellen så relevante dokumenter fra forskellige grupper i samme forhold?

I resten af dette indlæg udvikler vi en ramme for, hvordan man overvejer at besvare disse spørgsmål og andre gennem de metrics, der er tilgængelige i SageMaker Clarify.

Brug case og kontekst

Dette indlæg bruger et eksisterende eksempel på et SageMaker Clarify-job fra Retfærdighed og forklaring med SageMaker Clarify notesbog og forklarer de genererede bias-metriske værdier. Notebook'en træner en XGBoost-model på UCI voksendatasæt (Dua, D. og Graff, C. (2019). UCI Machine Learning Repository. Irvine, CA: University of California, School of Information and Computer Science).

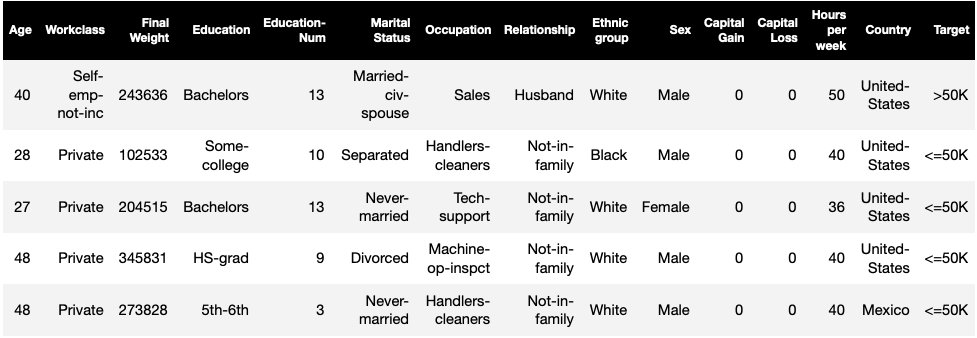

ML-opgaven i dette datasæt er at forudsige, om en person har en årlig indkomst på mere eller mindre end $50,000. Følgende tabel viser nogle tilfælde sammen med deres funktioner. Det er vigtigt at måle skævhed i indkomstforudsigelse, fordi vi kunne bruge disse forudsigelser til at informere beslutninger som rabattilbud og målrettet markedsføring.

Bias terminologi

Før vi dykker dybere, lad os gennemgå nogle vigtige terminologier. For en komplet liste over termer, se Amazon SageMaker præciserer vilkår for bias og retfærdighed.

- etiket – Målfunktionen, som ML-modellen er trænet til at forudsige. An observeret etiket refererer til etiketværdien observeret i de data, der bruges til at træne eller teste modellen. EN forudsagt etiket er værdien forudsagt af ML-modellen. Etiketter kan være binære og er ofte kodet som 0 og 1. Vi antager, at 1 repræsenterer en gunstig eller positiv etiket (f.eks. indkomst mere end eller lig med $50,000), og 0 repræsenterer en ugunstig eller negativ etiket. Etiketter kan også bestå af mere end to værdier. Selv i disse tilfælde udgør en eller flere af værdierne gunstige mærker. For nemheds skyld tager dette indlæg kun binære etiketter i betragtning. For detaljer om håndtering af etiketter med mere end to værdier og etiketter med kontinuerlige værdier (f.eks. i regression), se Amazon AI Fairness and Explainability Whitepaper.

- facet – En kolonne eller funktion, som bias måles i forhold til. I vores eksempel er facetten

sexog tager to værdier:woman,man, kodet somfemale,malei dataene (disse data er udtrukket fra 1994 Census og håndhæver en binær option). Selvom indlægget betragter en enkelt facet med kun to værdier, se for mere komplekse sager, der involverer flere facetter eller facetter med mere end to værdier, Amazon AI Fairness and Explainability Whitepaper. - Bias – En betydelig ubalance i inputdata eller modelforudsigelser på tværs af forskellige facetværdier. Hvad der er "væsentlig" afhænger af din ansøgning. For de fleste målinger betyder en værdi på 0 ingen ubalance. Bias-metrics i SageMaker Clarify er opdelt i to kategorier:

- Fortræning – Når den er til stede, indikerer pretraining bias kun ubalancer i dataene.

- Eftertræning – Bias efter træning tager desuden højde for modellernes forudsigelser.

Lad os undersøge hver kategori separat.

Førtræning bias

Pretraining bias-metrics i SageMaker Klargør svar på følgende spørgsmål: Har alle facetværdier ens (eller lignende) repræsentation i dataene? Det er vigtigt at inspicere dataene for pre-training bias, fordi det kan omsættes til posttraining bias i modelforudsigelserne. For eksempel kan en model, der er trænet på ubalancerede data, hvor en facetværdi forekommer meget sjældent, udvise væsentligt dårligere nøjagtighed for denne facetværdi. Lige repræsentation kan beregnes over følgende:

- Hele træningsdataene uanset etiketterne

- Kun undergruppen af træningsdata med positive etiketter

- Hver etiket separat

Den følgende figur giver en oversigt over, hvordan hver metrik passer ind i hver af de tre kategorier.

Nogle kategorier består af mere end én metrik. De grundlæggende metrikker (grå felter) besvarer spørgsmålet om bias i den kategori i den enkleste form. Målinger i hvide felter dækker desuden særlige tilfælde (f.eks. Simpsons paradoks) og brugerpræferencer (f.eks. fokusering på visse dele af befolkningen, når der beregnes prædiktiv ydeevne).

Facetværdirepræsentation uanset etiketter

Den eneste metrik i denne kategori er klasseubalance (CI). Målet med denne metrik er at måle, om alle facetværdierne har ens repræsentation i dataene.

CI er forskellen i den del af dataene, der udgøres af de to facetværdier. I vores eksempeldatasæt, for facetten sex, viser opdelingen (vist i cirkeldiagrammet), at kvinder udgør 32.4 % af træningsdataene, mens mænd udgør 67.6 %. Som resultat:

CI = 0.676 - 0.324 = 0.352

En alvorlig høj klasseubalance kan føre til dårligere prædiktiv ydeevne for facetværdien med mindre repræsentation.

Facetværdirepræsentation på niveauet af positive etiketter kun

En anden måde at måle lige repræsentation på er at kontrollere, om alle facetværdier indeholder en lignende brøkdel af prøver med positive observerede mærker. Positive mærker består af gunstige resultater (f.eks. lån givet, udvalgt til jobbet), så at analysere positive mærker separat hjælper med at vurdere, om de positive beslutninger er fordelt ligeligt.

I vores eksempeldatasæt opdeles de observerede etiketter i positive og negative værdier, som vist i den følgende figur.

11.4 % af alle kvinder og 31.4 % af alle mænd har den positive etiket (mørk skraveret region i venstre og højre bjælke). Forskellen i positive proportioner i etiketter (DPL) måler denne forskel.

DPL = 0.314 - 0.114 = 0.20

Den avancerede metrik i denne kategori, Conditional Demographic Disparity in Labels (CDDL), måler forskellene i de positive etiketter, men stratificerer dem i forhold til en anden variabel. Denne metrik hjælper med at kontrollere for Simpsons paradoks, et tilfælde, hvor en beregning over hele data viser bias, men bias forsvinder, når man grupperer dataene med hensyn til nogle sideoplysninger.

1973 UC Berkeley Admissions Study giver et eksempel. Ifølge dataene blev mænd indlagt i højere grad end kvinder. Men når de blev undersøgt på niveau med de enkelte universitetsafdelinger, blev kvinder optaget med samme eller højere sats på hvert institut. Denne observation kan forklares med Simpsons paradoks, som opstod her, fordi kvinder søgte ind på skoler, der var mere konkurrencedygtige. Som følge heraf blev der samlet set færre kvinder optaget sammenlignet med mænd, selvom de skole for skole blev optaget med en tilsvarende eller højere sats.

For flere detaljer om, hvordan CDDL beregnes, se Amazon AI Fairness and Explainability Whitepaper.

Facetværdirepræsentation på niveauet af hver etiket separat

Ligestilling i repræsentation kan også måles for hvert enkelt mærke, ikke kun det positive mærke.

Metrics i denne kategori beregner forskellen i etiketfordelingen af forskellige facetværdier. Etiketfordelingen for en facetværdi indeholder alle de observerede etiketværdier sammen med brøkdelen af prøver med den pågældende etikets værdi. For eksempel, i figuren, der viser etiketfordelinger, har 88.6 % af kvinderne en negativ observeret etiket, og 11.4 % har en positiv observeret etiket. Så etiketfordelingen for kvinder er [0.886, 0.114] og for mænd er [0.686, 0.314].

Den grundlæggende metrik i denne kategori, Kullback-Leibler divergens (KL), måler denne forskel som:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

De avancerede metrikker i denne kategori, Jensen-Shannon divergens (JS), Lp-norm (LP), Total Variation Distance (TVD) og Kolmogorov-Smirnov (KS), måler også forskellen mellem fordelingerne, men har forskellige matematiske egenskaber. Bortset fra særlige tilfælde vil de levere indsigt svarende til KL. For eksempel, selvom KL-værdien kan være uendelig, når en facetværdi ikke indeholder prøver med en bestemt etiket (f.eks. ingen mænd med en negativ etiket), undgår JS disse uendelige værdier. For flere detaljer om disse forskelle, se Amazon AI Fairness and Explainability Whitepaper.

Forholdet mellem DPL (Kategori 2) og distributionsbaserede metrics for KL/JS/LP/TVD/KS (Kategori 3)

Distributionsbaserede metrics er mere naturligt anvendelige til ikke-binære etiketter. For binære etiketter, på grund af det faktum, at ubalance i den positive etiket kan bruges til at beregne ubalancen i negativ etiket, leverer distributionsmetrikkene den samme indsigt som DPL. Derfor kan du bare bruge DPL i sådanne tilfælde.

Bias efter træning

Bias-metrics efter træning i SageMaker Clarify hjælper os med at besvare to nøglespørgsmål:

- Er alle facetværdier repræsenteret med en lignende hastighed i positive (gunstige) modelforudsigelser?

- Har modellen ens prædiktiv ydeevne for alle facetværdier?

Den følgende figur viser, hvordan metrikkerne passer til hvert af disse spørgsmål. Det andet spørgsmål kan nedbrydes yderligere afhængigt af, hvilken etiket ydeevnen er målt i forhold til.

Lige repræsentation i positive modelforudsigelser

Metrikker i denne kategori kontrollerer, om alle facetværdier indeholder en lignende brøkdel af prøver med positiv forudsagt mærke af modellen. Denne klasse af metrikker minder meget om prætræningsmetrikken for DPL og CDDL - den eneste forskel er, at denne kategori betragter forudsagte etiketter i stedet for observerede etiketter.

I vores eksempeldatasæt tildeles 4.5 % af alle kvinder den positive etiket af modellen, og 13.7 % af alle mænd tildeles den positive etiket.

Den grundlæggende metrik i denne kategori, Forskel i positive proportioner i forudsagte etiketter (DPPL), måler forskellen i de positive klassetildelinger.

DPPL = 0.137 - 0.045 = 0.092

Læg mærke til, hvordan en højere andel af mændene i træningsdataene havde en positiv observeret etiket. På lignende måde tildeles en højere andel af mænd en positiv forudsagt etiket.

Ved at gå videre til de avancerede målinger i denne kategori måler Disparate Impact (DI) den samme forskel i positive klassetildelinger, men i stedet for forskellen beregner den forholdet:

DI = 0.045 / 0.137 = 0.328

Både DI og DPPL formidler kvalitativt lignende indsigter, men adskiller sig i nogle hjørnesager. For eksempel har forhold tendens til at eksplodere til meget store tal, hvis nævneren er lille. Tag et eksempel på tallene 0.1 og 0.0001. Forholdet er 0.1/0.0001 = 10,000, hvorimod forskellen er 0.1 – 0.0001 ≈ 0.1. I modsætning til de andre metrikker, hvor en værdi på 0 indebærer ingen bias, svarer ingen bias for DI til en værdi på 1.

Betinget demografisk forskel i forudsagte etiketter (CDDPL) måler forskellen i facetværdirepræsentation i den positive etiket, men ligesom prætraining-metrikken for CDDL, kontrollerer den også for Simpsons paradoks.

Counterfactual Fliptest (FT) måler, om lignende prøver fra de to facetværdier modtager lignende beslutninger fra modellen. En model, der tildeler forskellige beslutninger til to prøver, der ligner hinanden, men adskiller sig i facetværdierne, kunne anses for at være forudindtaget i forhold til, at facetværdien tildeles den ugunstige (negative) etiket. Givet den første facetværdi (kvinder), vurderer den, om lignende medlemmer med den anden facetværdi (mænd) har en anden modelforudsigelse. Lignende medlemmer vælges baseret på k-nærmeste nabo-algoritmen.

Lige præstation

Modelforudsigelserne kan have lignende repræsentation i positive etiketter fra forskellige facetværdier, men modellens ydeevne på disse grupper kan variere betydeligt. I mange applikationer kan det være ønskeligt at have en lignende prædiktiv ydeevne på tværs af forskellige facetværdier. Metrics i denne kategori måler forskellen i prædiktiv ydeevne på tværs af facetværdier.

Fordi dataene kan opdeles på mange forskellige måder baseret på de observerede eller forudsagte etiketter, er der mange forskellige måder at måle prædiktiv ydeevne på.

Lige forudsigelig ydeevne uanset etiketter

Du kan overveje modellens ydeevne på de samlede data, uanset de observerede eller de forudsagte etiketter - det vil sige den overordnede nøjagtighed.

De følgende figurer viser, hvordan modellen klassificerer input fra de to facetværdier i vores eksempeldatasæt. Sande negative (TN) er tilfælde, hvor både det observerede og forudsagte mærke var 0. Falske positive (FP) er fejlklassificeringer, hvor det observerede mærke var 0, men det forudsagte mærke var 1. Sande positive (TP) og falske negative (FN) er defineret tilsvarende.

|

|

For hver facetværdi er den overordnede modelydelse, det vil sige nøjagtigheden for denne facetværdi:

Nøjagtighed = (TN + TP) / (TN + FP + FN + TP)

Med denne formel er nøjagtigheden for kvinder 0.930 og for mænd er 0.815. Dette fører til den eneste metrik i denne kategori, nøjagtighedsforskel (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 betyder, at nøjagtigheden for begge grupper er den samme. Større (positive eller negative) værdier indikerer større forskelle i nøjagtighed.

Kun lige ydelse på positive etiketter

Du kan begrænse modellens præstationsanalyse til kun positive etiketter. Hvis ansøgningen f.eks. handler om at opdage fejl på et samlebånd, kan det være ønskeligt at kontrollere, at ikke-defekte dele (positiv etiket) af forskellig art (facetværdier) klassificeres som ikke-defekte med samme hastighed. Denne mængde kaldes tilbagekaldelse eller sand positiv rate:

Recall = TP / (TP + FN)

I vores eksempeldatasæt er tilbagekaldelsen for kvinder 0.389, og tilbagekaldelsen for mænd er 0.425. Dette fører til den grundlæggende metrik i denne kategori, Recall Difference (RD):

RD = 0.425 - 0.389 = 0.036

Lad os nu overveje de tre avancerede metrics i denne kategori, se, hvilke brugerpræferencer de koder, og hvordan de adskiller sig fra den grundlæggende metric for RD.

For det første, i stedet for at måle ydeevnen på de positive observerede etiketter, kan du måle den på de positive forudsagte etiketter. Givet en facetværdi, såsom kvinder, og alle de prøver med denne facetværdi, som er forudsagt at være positive af modellen, hvor mange er egentlig korrekt klassificeret som positive? Denne mængde omtales som acceptrate (AR) eller præcision:

AR = TP / (TP + FP)

I vores eksempel er AR for kvinder 0.977, og AR for mænd er 0.970. Dette fører til forskellen i acceptrate (DAR):

DAR = 0.970 - 0.977 = -0.007

En anden måde at måle bias på er ved at kombinere de to foregående metrics og måle, hvor mange flere positive forudsigelser modellerne tildeler en facetværdi sammenlignet med de observerede positive etiketter. SageMaker Clarify måler denne fordel ved hjælp af modellen som forholdet mellem antallet af observerede positive etiketter for denne facetværdi og antallet af forudsagte positive etiketter og refererer til det som betinget accept (CA):

CA = (TP + FN) / (TP + FP)

I vores eksempel er CA for kvinder 2.510 og for mænd er 2.283. Forskellen i CA fører til den endelige metrik i denne kategori, Difference in Conditional Acceptance (DCA):

DCA = 2.283 - 2.510 = -0.227

Kun lige ydeevne på negative etiketter

På en måde, der ligner positive etiketter, kan bias også beregnes som ydeevneforskellen på de negative etiketter. At overveje negative etiketter separat kan være vigtigt i visse applikationer. For eksempel, i vores defektdetekteringseksempel, vil vi måske detektere defekte dele (negativ etiket) af forskellig art (facetværdi) med samme hastighed.

Den grundlæggende metrik i denne kategori, specificitet, er analog med tilbagekaldelse (true positive rate) metrikken. Specificitet beregner nøjagtigheden af modellen på prøver med denne facetværdi, der har en observeret negativ etiket:

Specificitet = TN / (TN + FP)

I vores eksempel (se forvirringstabellerne) er specificiteten for kvinder og mænd henholdsvis 0.999 og 0.994. Følgelig er Specificitetsforskel (SD) er:

SD = 0.994 - 0.999 = -0.005

Går vi videre, ligesom accepthastighedsmetrikken, er den analoge mængde for negative etiketter - afvisningsraten (RR) -:

RR = TN / (TN + FN)

RR for kvinder er 0.927 og for mænd er 0.791, hvilket fører til Difference in Rejection Rate (DRR) metrikken:

DRR = 0.927 - 0.791 = -0.136

Endelig er den negative etiketanalog af betinget accept, den betingede afvisning (CR), forholdet mellem antallet af observerede negative etiketter for denne facetværdi og antallet af forudsagte negative etiketter:

CR = (TN + FP) / (TN + FN)

CR for kvinder er 0.928 og for mænd er 0.796. Den sidste metrik i denne kategori er Difference in Conditional Rejection (DCR):

DCR = 0.796 - 0.928 = 0.132

Lige præstation på positive vs. negative etiketter

SageMaker Clarify kombinerer de to foregående kategorier ved at overveje modelydelsesforholdet på de positive og negative etiketter. Specifikt for hver facetværdi beregner SageMaker Clarify forholdet mellem falske negativer (FN) og falske positive (FP). I vores eksempel er FN/FP-forholdet for kvinder 679/10 = 67.9 og for mænd er 3678/84 = 43.786. Dette fører til Treatment Equality (TE) metrikken, som måler forskellen mellem FP/FN-forholdet:

TE = 67.9 - 43.786 = 24.114

Følgende skærmbillede viser, hvordan du kan bruge SageMaker Clarify med Amazon SageMaker Studio for at vise værdierne samt intervaller og korte beskrivelser af forskellige bias-metrikker.

Spørgsmål om bias: Hvilke metrics skal man starte med?

Husk prøvespørgsmålene om bias i starten af dette indlæg. Efter at have gennemgået metrics fra forskellige kategorier, overvej spørgsmålene igen. For at besvare det første spørgsmål, som vedrører repræsentationerne af forskellige grupper i træningsdataene, kan du starte med klasseubalance-metrikken (CI). Tilsvarende kan du for de resterende spørgsmål starte med at se på henholdsvis forskel i positive proportioner i etiketter (DPL), nøjagtighedsforskel (AD), forskel i acceptrate (DAR) og tilbagekaldelsesforskel (RD).

Bias uden facetværdier

For at gøre det nemmere at forklare, udelukkede denne beskrivelse af målinger efter træning den generaliserede entropiindeks (GE). Denne metrik måler bias uden at tage højde for facetværdien og kan være nyttig til at vurdere, hvordan modelfejlene er fordelt. For detaljer, se Generaliseret entropi (GE).

Konklusion

I dette indlæg så du, hvordan de 21 forskellige metrics i SageMaker Clarify måler bias på forskellige stadier af ML-pipelinen. Du lærte om forskellige metrics via en indkomstforudsigelse brugscase, hvordan du vælger metrics til din use case, og hvilke du kunne starte med.

Kom i gang med din ansvarlige AI-rejse ved at vurdere bias i dine ML-modeller ved at bruge demo-notesbogen Retfærdighed og forklaring med SageMaker Clarify. Du kan finde den detaljerede dokumentation for SageMaker Clarify, inklusive den formelle definition af metrics, på Hvad er retfærdighed og modelforklarlighed for maskinlæringsforudsigelser. For open source-implementering af bias-metrics henvises til aws-sagemaker-clarify GitHub repository. For en detaljeret diskussion inklusive begrænsninger, se Amazon AI Fairness and Explainability Whitepaper.

Om forfatterne

Bilal Zafar er en anvendt videnskabsmand hos AWS, der arbejder med retfærdighed, forklarlighed og sikkerhed i maskinlæring.

Bilal Zafar er en anvendt videnskabsmand hos AWS, der arbejder med retfærdighed, forklarlighed og sikkerhed i maskinlæring.

Denis V. Batalov er en Solutions Architect for AWS, med speciale i Machine Learning. Han har været hos Amazon siden 2005. Denis har en ph.d. inden for kunstig intelligens. Følg ham på Twitter: @dbatalov.

Michele Donini er Sr Applied Scientist ved AWS. Han leder et team af forskere, der arbejder med ansvarlig kunstig intelligens, og hans forskningsinteresser er Algorithmic Fairness og Explainable Machine Learning.

Michele Donini er Sr Applied Scientist ved AWS. Han leder et team af forskere, der arbejder med ansvarlig kunstig intelligens, og hans forskningsinteresser er Algorithmic Fairness og Explainable Machine Learning.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet