I dag er vi glade for at kunne meddele, at Llama 2-fundamentmodeller udviklet af Meta er tilgængelige for kunder gennem Amazon SageMaker JumpStart. Llama 2-familien af store sprogmodeller (LLM'er) er en samling af fortrænede og finjusterede generative tekstmodeller i en skala fra 7 milliarder til 70 milliarder parametre. Finjusterede LLM'er, kaldet Llama-2-chat, er optimeret til dialogbrug. Du kan nemt afprøve disse modeller og bruge dem med SageMaker JumpStart, som er en maskinlæringshub (ML), der giver adgang til algoritmer, modeller og ML-løsninger, så du hurtigt kan komme i gang med ML.

I dette indlæg gennemgår vi, hvordan du bruger Llama 2-modeller via SageMaker JumpStart.

Hvad er Llama 2

Llama 2 er en auto-regressiv sprogmodel, der bruger en optimeret transformerarkitektur. Llama 2 er beregnet til kommerciel og forskningsmæssig brug på engelsk. Den kommer i en række parameterstørrelser – 7 milliarder, 13 milliarder og 70 milliarder – såvel som forudtrænede og finjusterede variationer. Ifølge Meta bruger de tunede versioner overvåget finjustering (SFT) og forstærkningslæring med menneskelig feedback (RLHF) for at tilpasse sig menneskelige præferencer for hjælpsomhed og sikkerhed. Llama 2 blev fortrænet på 2 billioner tokens af data fra offentligt tilgængelige kilder. De indstillede modeller er beregnet til assistent-lignende chat, hvorimod præ-trænede modeller kan tilpasses til en række forskellige naturlige sproggenereringsopgaver. Uanset hvilken version af modellen en udvikler bruger, vil ansvarlig brugsvejledning fra Meta kan hjælpe med at vejlede yderligere finjusteringer, der kan være nødvendige for at tilpasse og optimere modellerne med passende sikkerhedsbegrænsninger.

Hvad er SageMaker JumpStart

Med SageMaker JumpStart kan ML-udøvere vælge mellem et bredt udvalg af open source-fundamentmodeller. ML praktikere kan implementere fundamentmodeller til dedikerede Amazon SageMaker forekomster fra et netværksisoleret miljø og tilpasse modeller ved hjælp af SageMaker til modeltræning og implementering.

Du kan nu opdage og implementere Llama 2 med et par klik ind Amazon SageMaker Studio eller programmatisk gennem SageMaker Python SDK, så du kan udlede modelydelse og MLOps-kontroller med SageMaker-funktioner som f.eks. Amazon SageMaker Pipelines, Amazon SageMaker Debuggereller containerlogfiler. Modellen er implementeret i et AWS-sikkert miljø og under din VPC-kontrol, hvilket hjælper med at sikre datasikkerhed. Llama 2-modeller er tilgængelige i dag i Amazon SageMaker Studio, oprindeligt i us-east 1 , us-west 2 regioner.

Opdag modeller

Du kan få adgang til fundamentmodellerne gennem SageMaker JumpStart i SageMaker Studio UI og SageMaker Python SDK. I dette afsnit gennemgår vi, hvordan du opdager modellerne i SageMaker Studio.

SageMaker Studio er et integreret udviklingsmiljø (IDE), der giver en enkelt webbaseret visuel grænseflade, hvor du kan få adgang til specialbyggede værktøjer til at udføre alle ML-udviklingstrin, fra forberedelse af data til opbygning, træning og implementering af dine ML-modeller. For flere detaljer om, hvordan du kommer i gang og opsætter SageMaker Studio, se Amazon SageMaker Studio.

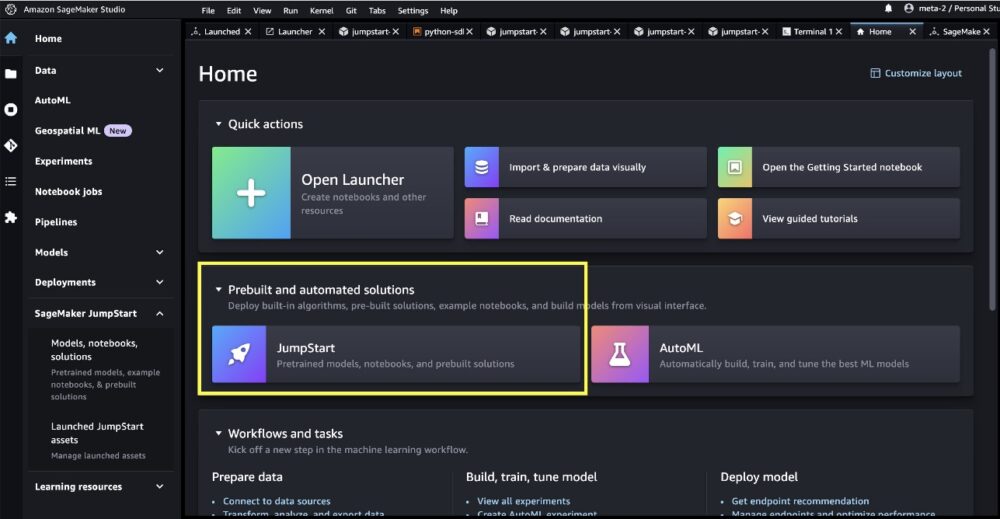

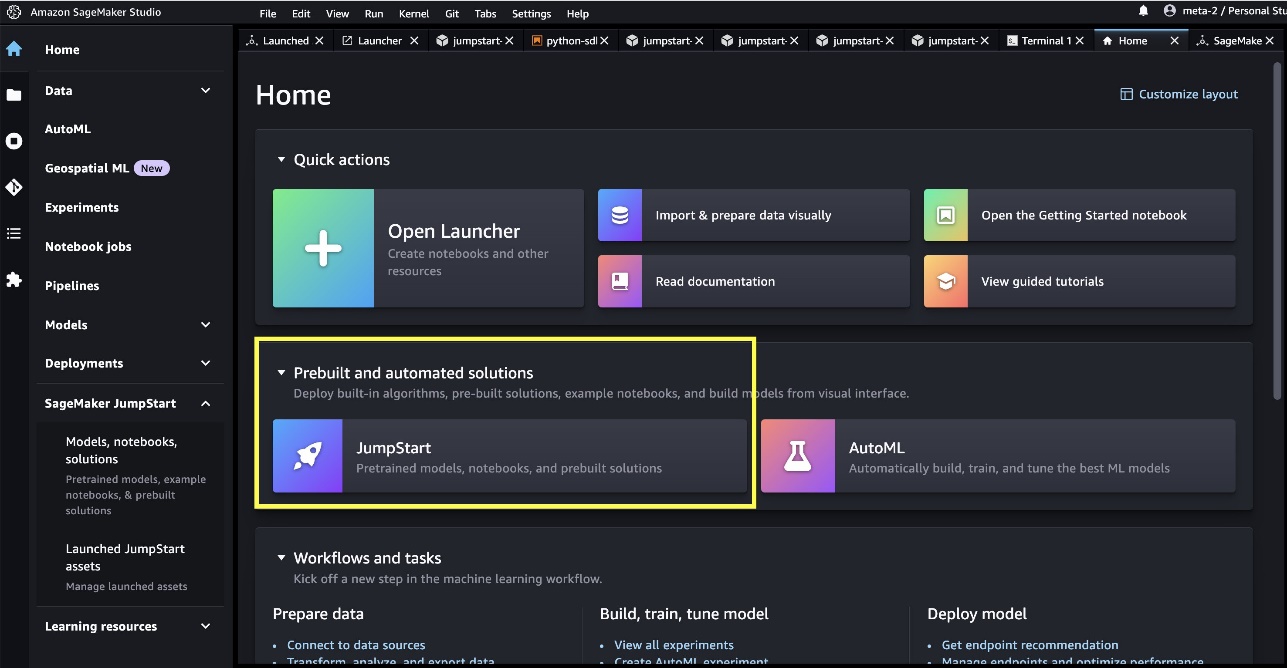

Når du er på SageMaker Studio, kan du få adgang til SageMaker JumpStart, som indeholder forudtrænede modeller, notebooks og præbyggede løsninger under Præbyggede og automatiserede løsninger.

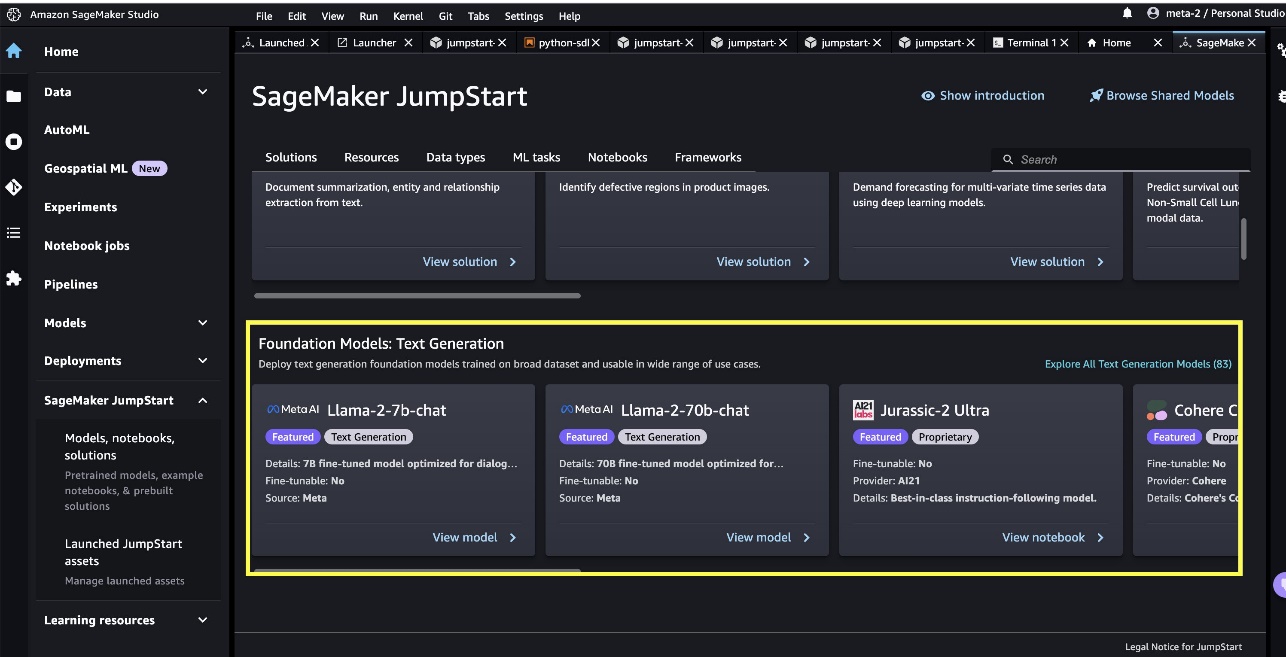

Fra SageMaker JumpStart-destinationssiden kan du søge efter løsninger, modeller, notebooks og andre ressourcer. Du kan finde to flagskibs Llama 2-modeller i Fundamentmodeller: Tekstgenerering karrusel. Hvis du ikke kan se Llama 2-modeller, skal du opdatere din SageMaker Studio-version ved at lukke ned og genstarte. For mere information om versionsopdateringer, se Luk ned og opdater Studio-apps.

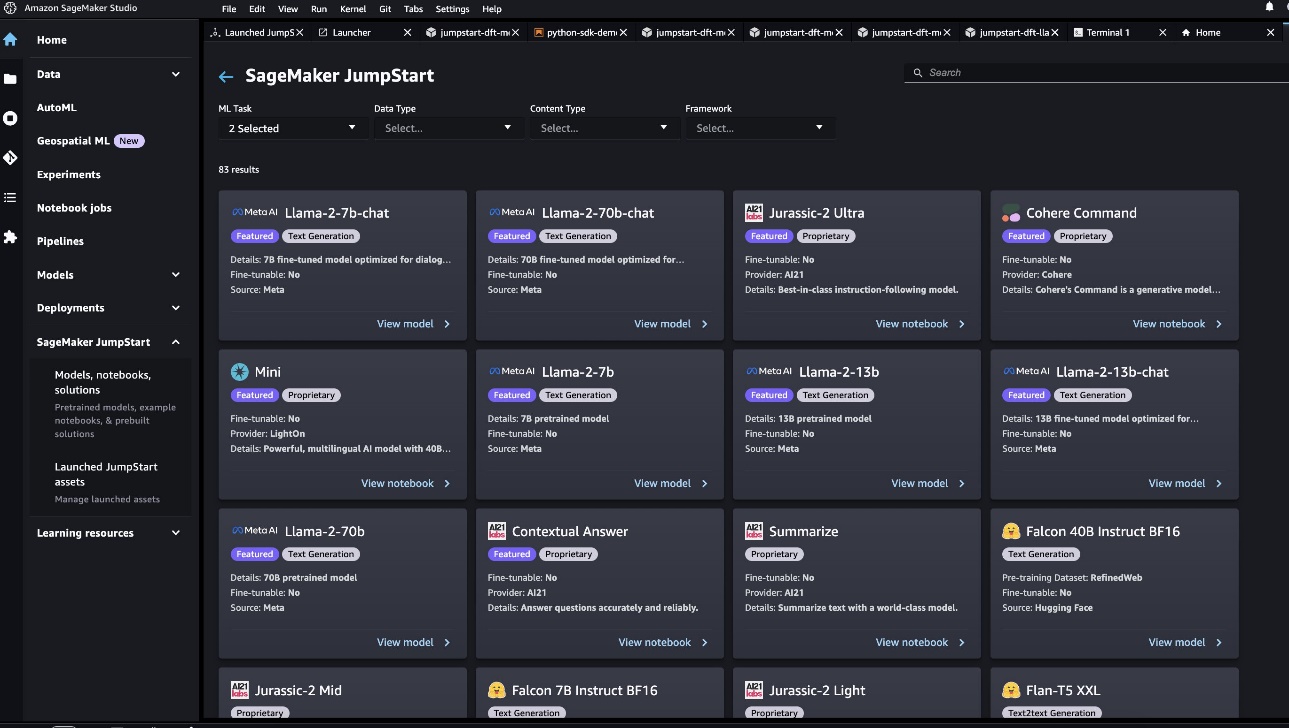

Du kan også finde andre fire modelvarianter ved at vælge Udforsk alle tekstgenereringsmodeller eller søger efter llama i søgefeltet.

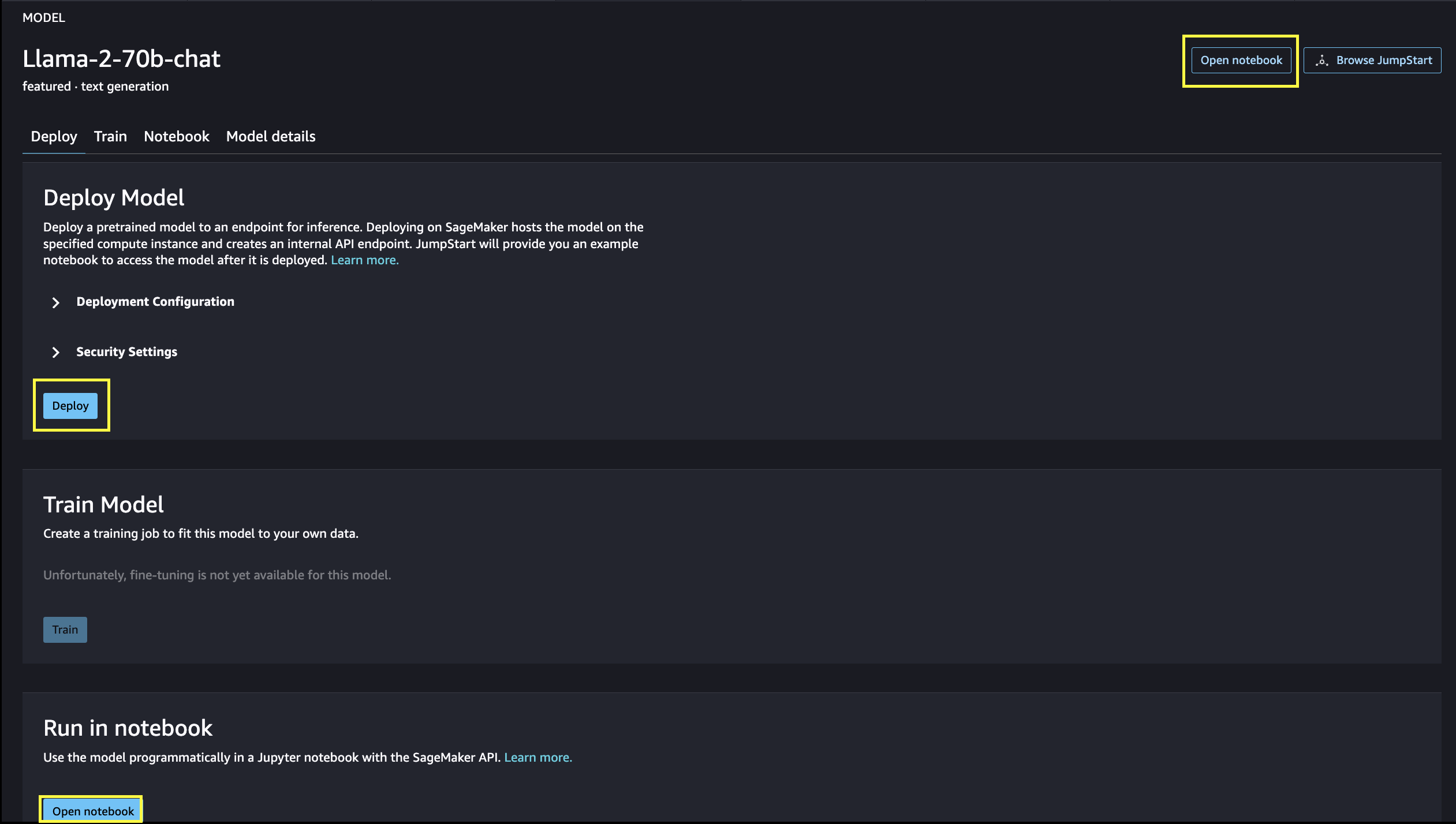

Du kan vælge modelkortet for at se detaljer om modellen, såsom licens, data, der bruges til at træne, og hvordan du bruger den. Du kan også finde to knapper, Implementer , Åbn Notesbog, som hjælper dig med at bruge modellen.

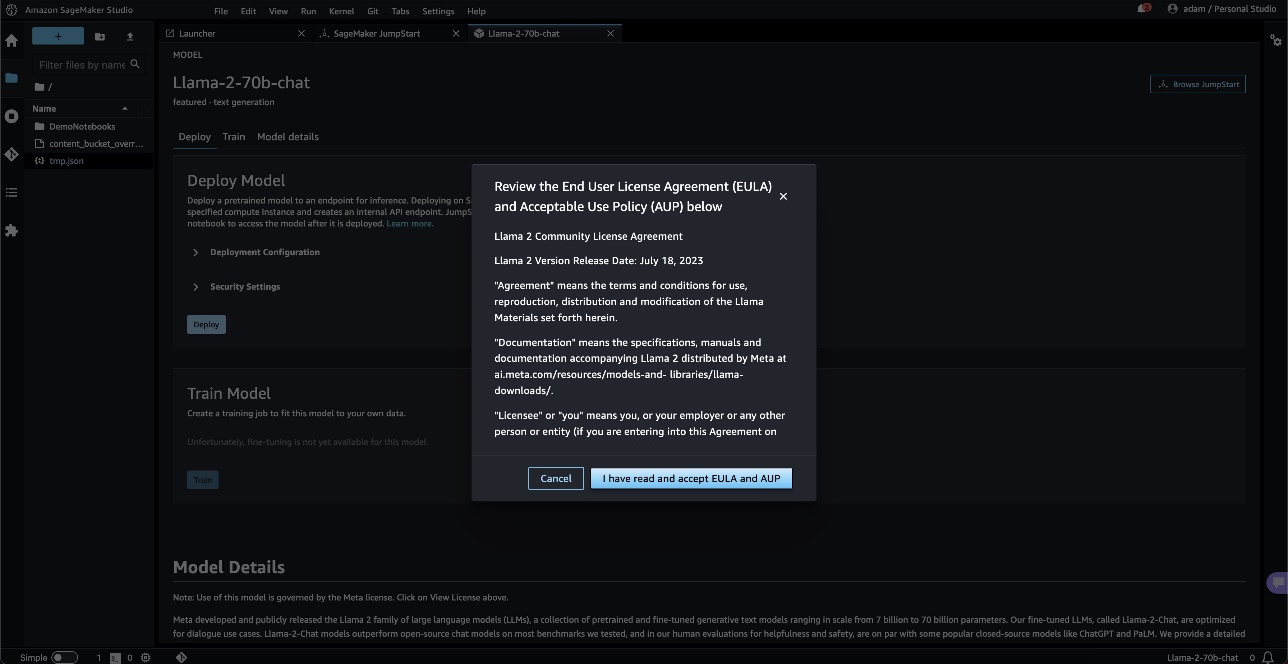

Når du vælger en af knapperne, vil en pop-up vise slutbrugerlicensaftalen og politikken for acceptabel brug, som du kan anerkende.

Når du har bekræftet, vil du fortsætte til næste trin for at bruge modellen.

Implementer en model

Når du vælger Implementer og anerkend vilkårene, vil modelimplementeringen begynde. Alternativt kan du implementere gennem eksemplet på notesbogen, der dukker op ved at vælge Åbn Notesbog. Eksemplet på notesbogen giver ende-til-ende vejledning om, hvordan man implementerer modellen til slutninger og renser ressourcer.

For at implementere ved hjælp af en notesbog starter vi med at vælge en passende model, specificeret af model_id. Du kan implementere enhver af de valgte modeller på SageMaker med følgende kode:

Dette implementerer modellen på SageMaker med standardkonfigurationer, inklusive standardforekomsttype og standard VPC-konfigurationer. Du kan ændre disse konfigurationer ved at angive ikke-standardværdier i JumpStartModel. Efter det er implementeret, kan du køre slutninger mod det implementerede slutpunkt gennem SageMaker-prædiktoren:

Finjusterede chatmodeller (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) accepterer en chathistorik mellem brugeren og chatassistenten og genererer den efterfølgende chat. De fortrænede modeller (Llama-2-7b, Llama-2-13b, Llama-2-70b) kræver en strengprompt og udfører tekstfuldførelse på den angivne prompt. Se følgende kode:

Bemærk, at som standard, accept_eula er indstillet til falsk. Du skal indstille accept_eula=true for at kalde slutpunktet med succes. Ved at gøre det accepterer du brugerlicensaftalen og politikken for acceptabel brug som nævnt tidligere. Du kan også downloade licensaftalen.

Custom_attributes bruges til at bestå EULA er nøgle/værdi-par. Nøglen og værdien er adskilt af = og par er adskilt af ;. Hvis brugeren sender den samme nøgle mere end én gang, beholdes den sidste værdi og videregives til scripthandleren (dvs. i dette tilfælde bruges til betinget logik). For eksempel hvis accept_eula=false; accept_eula=true sendes til serveren, så accept_eula=true opbevares og videregives til scripthandleren.

Inferensparametre styrer tekstgenereringsprocessen ved slutpunktet. Den maksimale kontrol af nye tokens refererer til størrelsen af output genereret af modellen. Bemærk, at dette ikke er det samme som antallet af ord, fordi modellens ordforråd ikke er det samme som det engelsksprogede ordforråd, og hvert token er muligvis ikke et engelsksproget ord. Temperaturen styrer tilfældigheden i outputtet. Højere temperatur resulterer i mere kreative og hallucinerede output. Alle inferensparametre er valgfrie.

Følgende tabel viser alle de Llama-modeller, der er tilgængelige i SageMaker JumpStart sammen med model_ids, standardforekomsttyper og det maksimale antal samlede tokens (summen af antallet af inputtokens og antallet af genererede tokens), der understøttes for hver af disse modeller.

| Modelnavn | Model ID | Max Total Tokens | Standard instanstype |

| Lama-2-7b | meta-tekstgeneration-llama-2-7b | 4096 | ml.g5.2xlarge |

| Lama-2-7b-chat | meta-tekstgeneration-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| Lama-2-13b | meta-tekstgeneration-llama-2-13b | 4096 | ml.g5.12xlarge |

| Lama-2-13b-chat | meta-tekstgeneration-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| Lama-2-70b | meta-tekstgeneration-llama-2-70b | 4096 | ml.g5.48xlarge |

| Lama-2-70b-chat | meta-tekstgeneration-llama-2-70b-f | 4096 | ml.g5.48xlarge |

Bemærk, at SageMaker-slutpunkter har en timeout-grænse på 60s. Selvom modellen muligvis kan generere 4096 tokens, vil anmodningen mislykkes, hvis tekstgenerering tager mere end 60 sekunder. For 7B, 13B og 70B modeller anbefaler vi at indstille max_new_tokens ikke større end henholdsvis 1500, 1000 og 500, mens det samlede antal tokens holdes mindre end 4K.

Inferens og eksempel-prompter for Llama-2-70b

Du kan bruge Lama-modeller til tekstfuldførelse for ethvert stykke tekst. Gennem tekstgenerering kan du udføre en række opgaver, såsom besvarelse af spørgsmål, sprogoversættelse, følelsesanalyse og mange flere. Input nyttelast til slutpunktet ser ud som følgende kode:

Følgende er nogle eksempler på prompter og teksten genereret af modellen. Alle udgange genereres med inferensparametre {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

I det næste eksempel viser vi, hvordan man bruger Llama-modeller med få skud i kontekstindlæring, hvor vi giver træningseksempler til rådighed for modellen. Bemærk, at vi kun drager konklusioner om den installerede model, og under denne proces ændres modelvægtene ikke.

Inferens og eksempel-prompter for Llama-2-70b-chat

Med Llama-2-Chat-modeller, som er optimeret til dialogbrug, er input til chatmodellens slutpunkter den tidligere historie mellem chatassistenten og brugeren. Du kan stille spørgsmål kontekstuelle til den samtale, der er sket indtil nu. Du kan også angive systemkonfigurationen, såsom personas, der definerer chatassistentens adfærd. Input nyttelasten til slutpunktet ser ud som følgende kode:

Følgende er nogle eksempler på prompter og teksten genereret af modellen. Alle output genereres med inferensparametrene {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

I det følgende eksempel har brugeren haft en samtale med assistenten om turiststeder i Paris. Dernæst spørger brugeren om den første mulighed anbefalet af chatassistenten.

I de følgende eksempler indstiller vi systemets konfiguration:

Ryd op

Når du er færdig med at køre notesbogen, skal du sørge for at slette alle ressourcer, så alle de ressourcer, du oprettede i processen, slettes, og din fakturering stoppes:

Konklusion

I dette indlæg viste vi dig, hvordan du kommer i gang med Llama 2-modeller i SageMaker Studio. Med dette har du adgang til seks Llama 2-fundamentmodeller, der indeholder milliarder af parametre. Fordi fundamentmodeller er fortrænede, kan de også hjælpe med at sænke uddannelses- og infrastrukturomkostninger og muliggøre tilpasning til din brugssituation. For at komme i gang med SageMaker JumpStart skal du besøge følgende ressourcer:

Om forfatterne

juni vandt er produktchef hos SageMaker JumpStart. Han fokuserer på at gøre fundamentmodeller let synlige og brugbare for at hjælpe kunder med at bygge generative AI-applikationer. Hans erfaring hos Amazon inkluderer også mobil shopping-applikation og last mile-levering.

juni vandt er produktchef hos SageMaker JumpStart. Han fokuserer på at gøre fundamentmodeller let synlige og brugbare for at hjælpe kunder med at bygge generative AI-applikationer. Hans erfaring hos Amazon inkluderer også mobil shopping-applikation og last mile-levering.

Dr. Vivek Madan er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Han fik sin ph.d. fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker i maskinlæring og algoritmedesign og har publiceret artikler i EMNLP, ICLR, COLT, FOCS og SODA konferencer.

Dr. Vivek Madan er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Han fik sin ph.d. fra University of Illinois i Urbana-Champaign og var postdoktor ved Georgia Tech. Han er en aktiv forsker i maskinlæring og algoritmedesign og har publiceret artikler i EMNLP, ICLR, COLT, FOCS og SODA konferencer.  Dr. Kyle Ulrich er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Hans forskningsinteresser omfatter skalerbare maskinlæringsalgoritmer, computervision, tidsserier, Bayesianske ikke-parametriske og Gaussiske processer. Hans ph.d. er fra Duke University, og han har udgivet artikler i NeurIPS, Cell og Neuron.

Dr. Kyle Ulrich er en anvendt videnskabsmand hos Amazon SageMaker JumpStart-teamet. Hans forskningsinteresser omfatter skalerbare maskinlæringsalgoritmer, computervision, tidsserier, Bayesianske ikke-parametriske og Gaussiske processer. Hans ph.d. er fra Duke University, og han har udgivet artikler i NeurIPS, Cell og Neuron.  Dr. Ashish Khetan er en Senior Applied Scientist hos Amazon SageMaker JumpStart og hjælper med at udvikle maskinlæringsalgoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.

Dr. Ashish Khetan er en Senior Applied Scientist hos Amazon SageMaker JumpStart og hjælper med at udvikle maskinlæringsalgoritmer. Han fik sin ph.d. fra University of Illinois Urbana-Champaign. Han er en aktiv forsker i maskinlæring og statistisk inferens og har publiceret mange artikler i NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP konferencer.  Sundar Ranganathan er Global Head of GenAI/Frameworks GTM Specialists hos AWS. Han fokuserer på at udvikle GTM-strategi for store sprogmodeller, GenAI og storskala ML-arbejdsbelastninger på tværs af AWS-tjenester som Amazon EC2, EKS, EFA, AWS Batch og Amazon SageMaker. Hans erfaring omfatter lederroller inden for produktledelse og produktudvikling hos NetApp, Micron Technology, Qualcomm og Mentor Graphics.

Sundar Ranganathan er Global Head of GenAI/Frameworks GTM Specialists hos AWS. Han fokuserer på at udvikle GTM-strategi for store sprogmodeller, GenAI og storskala ML-arbejdsbelastninger på tværs af AWS-tjenester som Amazon EC2, EKS, EFA, AWS Batch og Amazon SageMaker. Hans erfaring omfatter lederroller inden for produktledelse og produktudvikling hos NetApp, Micron Technology, Qualcomm og Mentor Graphics.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 100

- 11

- 13

- 15 %

- 17

- 19

- 20

- 30

- 31

- 33

- 360-grad

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- I stand

- Om

- Acceptere

- acceptabel

- adgang

- tilgængelighed

- tilgængelig

- Ifølge

- anerkende

- tværs

- aktiv

- tilføje

- tilføje

- Yderligere

- adresse

- Efter

- igen

- mod

- Aftale

- AI

- algoritme

- algoritmer

- tilpasse

- Alle

- tillade

- sammen

- også

- altid

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- amerikansk

- an

- analyse

- ,

- og infrastruktur

- Annoncere

- En anden

- besvare

- enhver

- nogen

- Anvendelse

- applikationer

- anvendt

- værdsætter

- passende

- Arc

- arkitektur

- ER

- Kunst

- AS

- hjælpe

- Assistant

- At

- Atmosfære

- attraktioner

- Automatiseret

- til rådighed

- AWS

- Banan

- grundlæggende

- Battle

- Bayesiansk

- BE

- smuk

- Skønhed

- blev

- fordi

- bliver

- været

- øl

- før

- adfærd

- Beijing

- Tro

- troede

- BEDSTE

- mellem

- fakturerings- og

- Billion

- milliarder

- Sort

- Boks

- Pause

- betagende

- bred

- bygge

- Bygning

- bygget

- men

- .

- by

- kaldet

- CAN

- kapital

- bil

- kort

- karrusel

- tilfælde

- tilfælde

- KAT

- lave om

- Chokolade

- Vælg

- vælge

- By

- Classic

- kode

- samling

- kombineret

- kombinerer

- kommer

- kommer

- kommerciel

- selskab

- færdiggørelse

- computer

- Computer Vision

- konferencer

- sikker

- Konfiguration

- betragtes

- konstant

- opbygge

- indeholder

- Container

- indeholder

- indhold

- kontekstuelle

- fortsæt

- kontinuerligt

- kontrol

- kontrol

- Praktisk

- Samtale

- Omkostninger

- land

- modet

- dæksel

- skabe

- oprettet

- Kreativ

- kulturelle

- Medarbejder kultur

- Kop

- Kunder

- tilpasning

- tilpasse

- data

- datasikkerhed

- dedikeret

- dedikation

- Standard

- definere

- levering

- indsætte

- indsat

- implementering

- implementering

- udruller

- Design

- konstrueret

- ønskes

- destination

- destinationer

- detaljer

- udvikle

- udviklet

- Udvikler

- udvikling

- Udvikling

- Dialog

- forskel

- forskellige

- svært

- opdage

- karakteristisk

- do

- dokumentarfilm

- gør

- færdig

- Dont

- fordoblet

- ned

- Duke

- hertug universitet

- i løbet af

- e

- hver

- tidligere

- nemt

- let

- Edward

- Einstein

- enten

- muliggøre

- muliggør

- ende

- ende til ende

- Endpoint

- Engineering

- Engelsk

- nyde

- nok

- sikre

- Miljø

- udstyr

- Ether

- Endog

- begivenheder

- alle

- eksempel

- eksempler

- ophidset

- erfaring

- eksperiment

- eksperimenter

- Express

- FAIL

- mislykkedes

- retfærdig

- falsk

- familie

- berømt

- langt

- feat

- featured

- Funktionalitet

- tilbagemeldinger

- Feet

- få

- film

- endelige

- Endelig

- Finde

- Fornavn

- flagskib

- Flyde

- strømme

- fokuserer

- efter

- Til

- Videresend

- fundet

- Foundation

- fire

- Fransk vin

- Fransk

- fra

- fuldt ud

- yderligere

- fremtiden

- Generelt

- generere

- genereret

- generation

- generative

- Generativ AI

- Georgien

- få

- Giv

- glas

- Global

- Go

- gå

- grafik

- stor

- større

- banebrydende

- Grow

- vejledning

- vejlede

- havde

- Håndterer

- skete

- Gem

- Hård Ost

- hårdt arbejde

- Have

- have

- he

- hoved

- hjælpe

- hjælpe

- hjælper

- link.

- hi

- Høj

- højere

- hans

- historisk

- historie

- boliger

- Hvordan

- How To

- HTML

- HTTPS

- Hub

- menneskelig

- i

- ikoniske

- idé

- if

- ii

- Illinois

- KIMOs Succeshistorier

- importere

- vigtigt

- imponerende

- in

- omfatter

- omfatter

- Herunder

- Incorporated

- oplysninger

- Infrastruktur

- i første omgang

- indgang

- inspirerede

- inspirerende

- instans

- øjeblikkeligt

- anvisninger

- integreret

- beregnet

- interesser

- grænseflade

- ind

- isolerede

- IT

- ITS

- rejse

- jpg

- lige

- holde

- holdt

- Nøgle

- Venlig

- Kend

- kendt

- landing

- vartegn

- Sprog

- stor

- storstilet

- største

- Efternavn

- Sent

- lancere

- Love

- Leadership" (virkelig menneskelig ledelse)

- LÆR

- Lær og vokse

- læring

- mindst

- mindre

- niveauer

- Licens

- Livet

- lys

- ligesom

- GRÆNSE

- Lister

- litteratur

- ll

- Llama

- logik

- Lang

- lang tid

- leder

- UDSEENDE

- kærlighed

- elskede

- lavere

- maskine

- machine learning

- lavet

- lave

- maerker

- Making

- ledelse

- leder

- mange

- vidunder

- Matter

- maksimal

- Kan..

- betyder

- måle

- Medier

- medium

- nævnte

- besked

- Meta

- micron

- minut

- minutter

- blanding

- ML

- MLOps

- Mobil

- model

- modeller

- øjeblik

- måned

- mere

- mest

- Mest Populære

- bevægelse

- film

- meget

- museum

- Museer

- Musik

- navn

- Natural

- nødvendig

- Behov

- behov

- netværk

- Ny

- New York

- næste

- ingen

- notesbog

- nu

- nummer

- talrige

- NY

- of

- tilbyde

- tilbyde

- Tilbud

- Olie

- on

- engang

- ONE

- kun

- åbent

- open source

- Optimer

- optimeret

- Option

- or

- Andet

- Andre

- Ellers

- vores

- ud

- output

- i løbet af

- samlet

- side

- par

- Papir

- papirer

- parameter

- parametre

- Paris

- del

- passerer

- Bestået

- gennemløb

- forbi

- fred

- Udfør

- ydeevne

- permanent

- telefon

- fotografier

- Fysik

- stykke

- Pizza

- plast

- plato

- Platon Data Intelligence

- PlatoData

- spillet

- politik

- pop-up

- Populær

- Indlæg

- post-

- Predictor

- præferencer

- forberede

- præsentere

- tidligere

- behandle

- Processer

- Produkt

- produktudvikling

- produktstyring

- produktchef

- Forslag

- stolt

- give

- forudsat

- giver

- leverer

- offentlige

- offentlig transport

- offentligt

- offentliggjort

- formål

- sætte

- Python

- Qualcomm

- Spørgsmål

- Hurtig

- hurtigt

- Ramper

- tilfældighed

- rækkevidde

- spænder

- klar

- årsager

- modtage

- opskrift

- anbefaler

- anbefales

- refererer

- Uanset

- regioner

- relative

- relativitetsteori

- gentaget

- repræsentere

- anmode

- Kræver

- forskning

- forsker

- Ressourcer

- henholdsvis

- Svar

- REST

- resultere

- Resultater

- River

- roller

- roller

- Kør

- kører

- s

- Sikkerhed

- sagemaker

- salt

- samme

- skalerbar

- Scale

- Videnskabsmand

- forskere

- SDK

- HAV

- Søg

- søgning

- Sektion

- sikker

- sikkerhed

- se

- se

- syntes

- valgt

- udvælgelse

- valg

- send

- senior

- stemningen

- Series

- Tjenester

- servering

- sæt

- indstilling

- Shape

- Haj

- Shopping

- bør

- Vis

- viste

- Shows

- lukker ned

- betydning

- signifikant

- Simpelt

- ganske enkelt

- enkelt

- websted

- Websteder

- SIX

- Størrelse

- langsomt

- lille

- So

- indtil nu

- Social

- sociale medier

- Løsninger

- nogle

- Kilde

- Kilder

- særligt

- specialister

- specificeret

- hastighed

- står

- starte

- påbegyndt

- Tilstand

- Stater

- statistiske

- Trin

- Steps

- stoppet

- Strategi

- String

- struktur

- Studio

- Bedøvelse

- emne

- efterfølgende

- succes

- Succesfuld

- sådan

- Understøttet

- sikker

- symbol

- systemet

- bord

- Tag

- tager

- opgaver

- smag

- hold

- tech

- Teknologier

- midlertidig

- vilkår

- end

- Tak

- at

- Hovedstaden

- Fremtiden

- The Source

- verdenen

- deres

- Them

- teori

- Der.

- Disse

- de

- ting

- tror

- denne

- selvom?

- Gennem

- Tiger

- tid

- Tidsserier

- gange

- Titel

- til

- i dag

- sammen

- token

- Tokens

- værktøjer

- top

- I alt

- Tårn

- Tog

- Kurser

- transformer

- Oversætte

- Oversættelse

- transport

- trillion

- prøv

- to

- typen

- typer

- ui

- under

- uforglemmelig

- enestående

- universitet

- indtil

- Opdatering

- opdateringer

- brugbar

- brug

- brug tilfælde

- anvendte

- Bruger

- brugere

- bruger

- ved brug af

- værdi

- Værdier

- række

- udgave

- versioner

- meget

- via

- Specifikation

- visninger

- vision

- Besøg

- besøgende

- bind

- ønskede

- krig

- var

- we

- web

- webservices

- web-baseret

- Hjemmeside

- GODT

- Whale

- Hvad

- Hvad er

- hvornår

- ud fra følgende betragtninger

- som

- mens

- hvorfor

- vilje

- vinduer

- med

- ord

- ord

- Arbejde

- virker

- world

- verdenskendte

- wrap

- år

- york

- Du

- Din

- dig selv

- zephyrnet

- Zip