Meta har introduceret Segment Anything Model, som har til formål at sætte en ny bar for computervision-baseret 'objektsegmentering' - computerens evne til at forstå forskellen mellem individuelle objekter i et billede eller en video. Segmentering vil være nøglen til at gøre AR virkelig nyttig ved at muliggøre en omfattende forståelse af verden omkring brugeren.

Objektsegmentering er processen med at identificere og adskille objekter i et billede eller en video. Ved hjælp af AI kan denne proces automatiseres, hvilket gør det muligt at identificere og isolere objekter i realtid. Denne teknologi vil være afgørende for at skabe en mere nyttig AR-oplevelse ved at give systemet en bevidsthed om forskellige objekter i verden omkring brugeren.

Udfordringen

Forestil dig for eksempel, at du har et par AR-briller på, og du gerne vil have to flydende virtuelle skærme til venstre og højre for din rigtige skærm. Medmindre du manuelt vil fortælle systemet, hvor din rigtige skærm er, skal det være i stand til at forstå, hvordan en skærm ser ud, så når den ser din skærm, kan den placere de virtuelle skærme i overensstemmelse hermed.

Men skærme kommer i alle former, størrelser og farver. Nogle gange gør refleksioner eller okkluderede objekter det endnu sværere for et computervisionssystem at genkende.

At have et hurtigt og pålideligt segmenteringssystem, der kan identificere hvert objekt i rummet omkring dig (som din skærm), vil være nøglen til at låse op for tonsvis af AR-brugssager, så teknologien kan være virkelig nyttig.

Computervision-baseret objektsegmentering har været et igangværende forskningsområde i mange år nu, men et af nøglespørgsmålene er, at for at hjælpe computere med at forstå, hvad de ser på, skal du træne en AI-model ved at give den en masse billeder at lære af.

Sådanne modeller kan være ret effektive til at identificere de genstande, de blev trænet på, men hvis de vil kæmpe med genstande, de ikke har set før. Det betyder, at en af de største udfordringer for objektsegmentering simpelthen er at have et stort nok sæt billeder til, at systemerne kan lære af, men at indsamle disse billeder og annotere dem på en måde, der gør dem nyttige til træning, er ikke en lille opgave.

SAM jeg er

Meta offentliggjorde for nylig arbejde på et nyt projekt kaldet Segmentér hvad som helst model (SAM). Det er både en segmenteringsmodel og et massivt sæt træningsbilleder, som virksomheden udgiver, som andre kan bygge videre på.

Projektet har til formål at reducere behovet for opgavespecifik modelleringsekspertise. SAM er en generel segmenteringsmodel, der kan identificere ethvert objekt i ethvert billede eller video, selv for objekter og billedtyper, som den ikke så under træning.

SAM giver mulighed for både automatisk og interaktiv segmentering, hvilket gør det muligt at identificere individuelle objekter i en scene med enkle input fra brugeren. SAM kan "promptes" med klik, bokse og andre prompter, hvilket giver brugerne kontrol over, hvad systemet forsøger at identificere på ethvert givet tidspunkt.

Det er let at se, hvordan denne punktbaserede prompt kunne fungere godt, hvis den kombineres med eye-tracking på et AR-headset. Faktisk er det præcis en af de use-cases, som Meta har demonstreret med systemet:

Her er endnu et eksempel på, at SAM bruges på førstepersonsvideo optaget af Metas Project Aria briller:

Du kan prøv SAM selv i din browser lige nu.

Hvordan SAM ved så meget

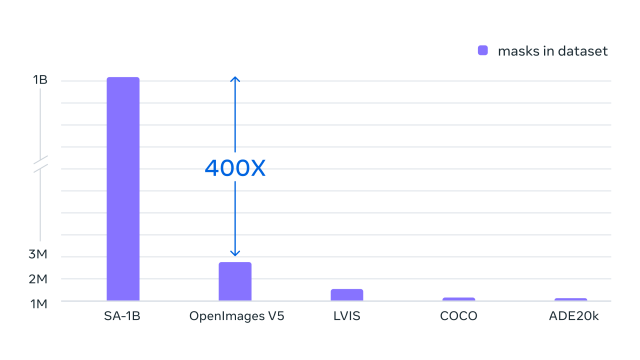

En del af SAMs imponerende evner kommer fra dets træningsdata, som indeholder enorme 10 millioner billeder og 1 milliard identificerede objektformer. Det er langt mere omfattende end nutidige datasæt, ifølge Meta, hvilket giver SAM meget mere erfaring i læreprocessen og gør det muligt at segmentere en bred vifte af objekter.

Meta kalder SAM-datasættet SA-1B, og det er virksomheden frigivelse af hele sættet for andre forskere at bygge videre på.

Meta håber, at dette arbejde med hurtig segmentering og frigivelsen af dette massive træningsdatasæt vil fremskynde forskning i billed- og videoforståelse. Virksomheden forventer, at SAM-modellen kan bruges som en komponent i større systemer, hvilket muliggør alsidige applikationer inden for områder som AR, indholdsskabelse, videnskabelige domæner og generelle AI-systemer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://www.roadtovr.com/meta-shows-progress-ai-segmentation-ar-sam-model-sa-1b/

- :er

- $ 10 millioner

- 1

- 10

- a

- evner

- evne

- I stand

- fremskynde

- Ifølge

- derfor

- AI

- målsætninger

- Alle

- tillade

- tillader

- ,

- En anden

- applikationer

- AR

- ar erfaring

- AR-briller

- AR headset

- OMRÅDE

- områder

- luft

- omkring

- AS

- At

- forsøger

- Automatiseret

- Automatisk Ur

- bevidsthed

- Bar

- baseret

- BE

- før

- være

- mellem

- Største

- Billion

- kasser

- bred

- browser

- bygge

- by

- kaldet

- Opkald

- CAN

- udfordringer

- Indsamling

- Kom

- selskab

- komponent

- omfattende

- computere

- indeholder

- moderne

- indhold

- indholdsskabelse

- kontrol

- kunne

- koblede

- Oprettelse af

- skabelse

- kritisk

- data

- datasæt

- demonstreret

- forskel

- Domæner

- i løbet af

- hver

- Effektiv

- muliggør

- nok

- Hele

- Endog

- præcist nok

- eksempel

- forventer

- erfaring

- ekspertise

- FAST

- flydende

- Til

- fra

- Generelt

- given

- Give

- gå

- stor

- Have

- have

- Headset

- hjælpe

- håber

- Hvordan

- HTTPS

- i

- identificeret

- identificere

- identificere

- billede

- billeder

- imponerende

- in

- individuel

- instans

- interaktiv

- introduceret

- spørgsmål

- IT

- ITS

- Nøgle

- stor

- større

- LÆR

- læring

- ligesom

- leder

- UDSEENDE

- lave

- maerker

- Making

- manuelt

- mange

- massive

- max-bredde

- midler

- Meta

- million

- model

- modeller

- øjeblik

- Overvåg

- skærme

- mere

- Behov

- netto

- Ny

- objekt

- objekter

- of

- on

- ONE

- igangværende

- ordrer

- Andet

- Andre

- Place

- plato

- Platon Data Intelligence

- PlatoData

- mulig

- behandle

- Progress

- projekt

- offentliggjort

- rækkevidde

- ægte

- realtid

- for nylig

- genkende

- reducere

- frigive

- pålidelig

- forskning

- forskere

- Værelse

- Sam

- scene

- videnskabelig

- Sees

- segment

- segmentering

- adskille

- sæt

- former

- Del

- Shows

- ganske enkelt

- størrelser

- lille

- So

- Kamp

- systemet

- Systemer

- Opgaver

- tech

- Teknologier

- at

- verdenen

- Them

- til

- tons

- Tog

- uddannet

- Kurser

- typer

- forstå

- forståelse

- oplåsning

- brugssager

- Bruger

- brugere

- forskellige

- alsidige

- udgave

- video

- Virtual

- Vej..

- Hvad

- som

- vilje

- med

- Arbejde

- world

- år

- Du

- Din

- dig selv

- zephyrnet

![[Industry Direct] Fejrer 8 års Pimax med et særtilbud på vores bedste headset til dato | Vejen til VR [Industry Direct] Fejrer 8 års Pimax med et særtilbud på vores bedste headset til dato | Vejen til VR](https://platoblockchain.com/wp-content/uploads/2023/12/industry-direct-celebrating-8-years-of-pimax-with-a-special-offer-on-our-best-headset-yet-road-to-vr-300x175.png)