Glem ikke at bruge store sprogmodeller (LLM'er) til at hjælpe med at skrive kode, Nvidia CEO Jensen Huang mener, at virksomhedssoftware i fremtiden blot vil være en samling chatbots, der er spændt sammen for at fuldføre opgaven.

"Det er usandsynligt, at du vil skrive det fra bunden eller skrive en hel masse Python-kode eller noget lignende," sagde han på scenen under sin GTC keynote Mandag. "Det er meget sandsynligt, at du samler et hold af AI."

Dette AI-team, forklarer Jensen, kan inkludere en model designet til at nedbryde og uddelegere en anmodning til forskellige andre modeller. Nogle af disse modeller kan være trænet til at forstå forretningstjenester som SAP eller Service Now, mens andre kan udføre numerisk analyse af data, der er gemt i en vektordatabase. Disse data kan derefter kombineres og præsenteres for slutbrugeren af endnu en model.

"Vi kan få en rapport hver eneste dag, eller du ved, top of the time, der har noget at gøre med en byggeplan, eller en prognose, eller en kundeadvarsel, eller en fejldatabase eller hvad det nu er," forklarede han.

For at kæde alle disse modeller sammen tager Nvidia en side ud af Dockers bog og har skabt en container-runtime til AI.

Kaldt Nvidia Inference Microservices, eller NIM for kort, er disse i det væsentlige containerbilleder, der indeholder både modellen, uanset om den er open source eller proprietær, sammen med alle de afhængigheder, der er nødvendige for at få den til at køre. Disse containeriserede modeller kan derefter implementeres på tværs af et vilkårligt antal runtimes, inklusive Nvidia-accelererede Kubernetes-noder.

"Du kan implementere det på vores infrastruktur kaldet DGX Cloud, eller du kan implementere det på forhånd, eller du kan implementere det hvor som helst du vil. Når du først har udviklet det, er det dit at tage med overalt,” sagde Jensen.

Selvfølgelig skal du først have et abonnement på Nvidias AI Enterprise-suite, som ikke ligefrem er billig til $4,500/år pr. GPU eller $1/time pr. GPU i skyen. Denne prisstrategi ser ud til at stimulere tættere systemer med højere ydeevne generelt, da den koster det samme, uanset om du kører på L40'er eller B100s.

Hvis ideen om at containerisere GPU-accelererede arbejdsbelastninger lyder bekendt, er dette ikke ligefrem en ny idé for Nvidia. CUDA acceleration har været understøttes på en lang række container-runtimes, inklusive Docker, Podman, Containerd eller CRI-O i årevis, og det ser ikke ud til, at Nvidias Container Runtime er på vej nogen steder.

Værdiforslaget bag NIM ser ud til at være, at Nvidia vil håndtere pakningen og optimeringen af disse modeller, så de har den rigtige version af CUDA, Triton Inference Server eller TensorRT LLM, der er nødvendig for at få den bedste ydeevne ud af dem.

Argumentet er, at hvis Nvidia udgiver en opdatering, der dramatisk øger slutningsydelsen for visse modeltyper, ville det blot kræve at trække det seneste NIM-billede ned.

Ud over hardwarespecifikke modeloptimeringer arbejder Nvidia også på at muliggøre ensartet kommunikation mellem containere, så de kan chatte med hinanden via API-kald.

Som vi forstår det, er API-kaldene, der bruges af de forskellige AI-modeller på markedet i dag, ikke altid konsistente, hvilket resulterer i, at det er nemmere at sammensætte nogle modeller, mens andre kan kræve yderligere arbejde.

Udlån af institutionel viden til generelle formålsmodeller

Enhver, der har brugt en AI-chatbot, vil vide, at selvom de normalt er ret gode med spørgsmål om generelle viden, er de ikke altid de mest pålidelige med obskure eller tekniske anmodninger.

Jensen fremhævede dette faktum under sin keynote. Adspurgt om et internt program, der blev brugt i Nvidia, gav Metas store sprogmodel Llama 2 70B ikke overraskende definitionen til et ikke-relateret udtryk.

I stedet for at forsøge at få virksomheder til at træne deres egne modeller - noget, der ville sælge mange GPU'er, men ville begrænse det adresserbare marked betydeligt - har Nvidia udviklet værktøjer til at finjustere sine NIM'er med kundedata og -processer.

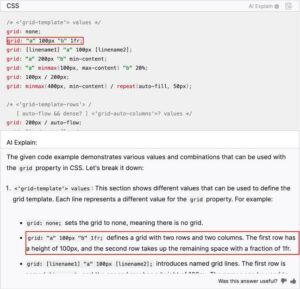

"Vi har en tjeneste kaldet NeMo Microservices, der hjælper dig med at kurere dataene, forberede dataene, så du kan... ombord på denne AI. Du finjusterer den og så beskytter du den; du kan derefter evaluere ... dens ydeevne i forhold til andre andre eksempler,” forklarede Huang.

Han talte også om Nvidias NeMo Retriever-tjeneste, som er baseret på konceptet med at bruge retrieval augmented generation (RAG) til at fremkomme med information, som modellen ikke er blevet specifikt trænet i.

Ideen her er, at dokumenter, processer og andre data kan indlæses i en vektordatabase, der er forbundet med modellen. Baseret på en forespørgsel kan modellen derefter søge i databasen, hente og opsummere den relevante information.

NIM-modeller og NeMo Retriever til integration af RAG'er er tilgængelige nu, mens NeMo Microservices er i tidlig adgang. ®

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :har

- :er

- $OP

- 7

- a

- Om

- accelereret

- acceleration

- adgang

- tværs

- Desuden

- Yderligere

- adresserbare

- Fordel

- mod

- AI

- AI chatbot

- AI modeller

- Alert

- Alle

- sammen

- også

- altid

- an

- analyse

- ,

- En anden

- enhver

- noget

- overalt

- api

- kommer til syne

- ER

- argument

- omkring

- AS

- At

- augmented

- til rådighed

- baseret

- BE

- været

- bag

- være

- mener

- BEDSTE

- mellem

- bog

- boosts

- både

- bots

- Pause

- bugs

- bygge

- Bunch

- virksomhed

- men

- by

- kaldet

- Opkald

- CAN

- Kan få

- Direktør

- vis

- kæde

- chatte

- chatbot

- billig

- Cloud

- CO

- kode

- samling

- kombineret

- Kommunikation

- fuldføre

- Konceptet

- tilsluttet

- konsekvent

- Container

- Beholdere

- Omkostninger

- Kursus

- oprettet

- kuratere

- kunde

- kundedata

- data

- Database

- dag

- definition

- afhængigheder

- indsætte

- indsat

- konstrueret

- udvikle

- udviklet

- do

- Docker

- dokumenter

- gør ikke

- ned

- dramatisk

- i løbet af

- hver

- Tidligt

- lettere

- muliggør

- ende

- Enterprise

- virksomhedssoftware

- virksomheder

- væsentlige

- Hver

- præcist nok

- eksempler

- forklarede

- Forklarer

- Faktisk

- bekendt

- ende

- Fornavn

- Til

- Forecast

- fra

- funktionalitet

- fremtiden

- Generelt

- generation

- få

- gå

- godt

- GPU

- GPU'er

- håndtere

- sker

- Hardware

- Have

- he

- hjælpe

- hjælper

- link.

- højere

- Fremhævet

- hans

- time

- HTTPS

- Huang

- idé

- if

- billede

- billeder

- in

- incitament

- omfatter

- Herunder

- oplysninger

- Infrastruktur

- Institutionel

- Integration

- interne

- ind

- isn

- IT

- ITS

- jensen huang

- jpg

- lige

- Keynote

- Kend

- viden

- Sprog

- stor

- seneste

- ligesom

- Sandsynlig

- GRÆNSE

- ll

- Llama

- LLM

- Se

- ligner

- Lot

- Marked

- Kan..

- Meta

- microservices

- måske

- model

- modeller

- Mandag

- mest

- nødvendig

- Behov

- Ny

- noder

- nu

- nummer

- Nvidia

- of

- on

- Ombord

- engang

- åbent

- open source

- optimering

- optimeringer

- or

- Andet

- Andre

- vores

- ud

- egen

- emballage

- side

- per

- Udfør

- ydeevne

- fly

- plato

- Platon Data Intelligence

- PlatoData

- prem

- Forbered

- forelagt

- smuk

- prissætning

- Processer

- Program

- proposition

- proprietære

- forudsat

- trækker

- formål

- Python

- query

- Spørgsmål

- klud

- RE

- Uanset

- Udgivelser

- relevant

- pålidelig

- indberette

- anmode

- anmodninger

- kræver

- resulterer

- hentning

- højre

- kører

- runtime

- s

- Said

- samme

- sap

- ridse

- Søg

- synes

- sælger

- server

- tjeneste

- Tjenester

- Kort

- enkelt

- So

- Software

- nogle

- noget

- lyde

- Kilde

- specifikke

- specifikt

- Stage

- opbevaret

- Strategi

- String

- abonnement

- suite

- opsummere

- overflade

- Systemer

- Tag

- tager

- Opgaver

- hold

- Teknisk

- semester

- at

- Fremtiden

- deres

- Them

- derefter

- Disse

- de

- denne

- til

- i dag

- sammen

- værktøjer

- top

- Tog

- uddannet

- Triton

- forsøger

- tune

- typer

- forstå

- usandsynligt

- Opdatering

- anvendte

- Bruger

- ved brug af

- sædvanligvis

- værdi

- række

- forskellige

- udgave

- meget

- via

- we

- uanset

- hvorvidt

- som

- mens

- WHO

- Hele

- bred

- vilje

- med

- inden for

- Arbejde

- arbejder

- ville

- skriver

- skriv kode

- år

- endnu

- Du

- yours

- youtube

- zephyrnet