En systematisk tilgang til genoptræning af dyb-lærende kunstig intelligens-algoritmer til at håndtere forskellige situationer er blevet udviklet af klimaforskere i USA. Holdet fandt ud af, at i modsætning til konventionel visdom opnår genoptræning af tidligere niveauer af algoritmen ofte bedre resultater end genoptræning af senere.

Deep learning er en meget avanceret, til tider kontroversiel type maskinlæring, hvor computeralgoritmer lærer sig selv de vigtige funktioner i et system og lærer at lave klassifikationer om dets natur og forudsigelser om dets adfærd, ofte med nøjagtigheder, der overgår menneskers evner. Den måske mest berømte demonstration af dyb læring i aktion var sejren for Googles AlphaGo-program over champion go-spilleren Lee Sedol i 2017. Deep learning har dog flere praktiske anvendelser: den kan forudsige proteinfoldning, screene vævsbiopsier for tidlige tegn på kræft og forudsige vejrmønstre.

Men da deep learning-algoritmer ikke er programmeret af en ekstern operatør, kan de heller ikke blot omprogrammeres. Hvis systemet i stedet ændres, skal algoritmen genoptrænes ved hjælp af data fra det nye system. Dette er vigtigt i klimatologi, hvis deep learning algoritmer, der trænes ved hjælp af nutidens klimatiske forhold, skal lave nyttige forudsigelser om vejrforhold i en verden, der er påvirket af klimaændringer. Denne proces – velkendt for mennesker – med at tilpasse tidligere erfaringer til ukendte situationer er kendt af dataloger som transfer learning.

Dybt mystik

Klimaforsker Pedram Hassanzadeh fra Rice University i Texas forklarer, at deep learning algoritmer behandler information i en sekvens af lag. "Informationen går ind i et lag, som udtrækker noget information, og sender derefter denne information til et andet lag, som udtrækker mere information." Denne proces producerer til sidst outputtet, men som Hassanzadeh forklarer, "Ingen ved præcis, hvad opgaven med hvert lag er, fordi vi ikke designer nogen af dem - de er alle lært." Transfer learning bruger den lille mængde tilgængelige data fra det nye datasæt til at genoptræne et (eller nogle få) af disse niveauer, og Hassanzadeh siger, at det er "vigtigt, hvilket niveau du vælger".

Konventionel visdom, siger han, dikterer, at problemets detaljer er udarbejdet i de dybeste lag af netværket (de lag tættest på outputtet). Derfor, for at udføre overførselslæring, er disse de bedste at genoptræne. "Det, der er blevet gjort tidligere, er, at f.eks. Google træner et tusindlags netværk på Google Images, og så bringer nogen et lille antal røntgenbilleder, så de genoplærer lag 998 og 999," forklarer Hassanzadeh. Nu har han og hans kolleger i stedet taget en systematisk tilgang.

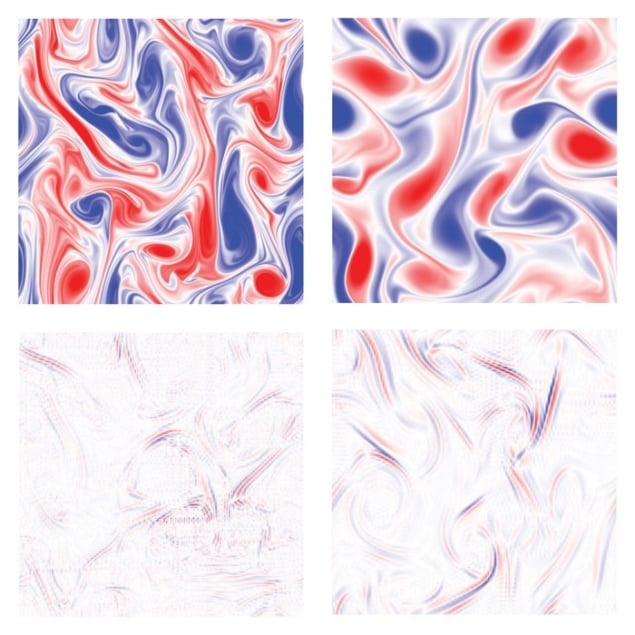

Forskerne udførte højopløsningssimuleringer af væskers adfærd under tre forskellige sæt betingelser. De brugte disse data til at træne tre 10-lags dyb læringsalgoritmer til at forudsige væskers adfærd under hver af disse specifikke parametre. De ændrede nogle parametre såsom Reynolds-tallet (forholdet mellem inertikræfter og viskøse kræfter) eller væskens hvirvelstrøm i hvert tilfælde og udførte et andet sæt højopløsningssimuleringer for at forudsige de nye væskers opførsel. I hvert af de tre tilfælde trænede de de samme algoritmer på de nye data. Til sidst gennemførte de overførselslæring af de gamle algoritmer på en lille delmængde af de nye data, idet de så på effekten af at genoptræne hvert niveau og sammenligne ydeevnen af den omskolede gamle algoritme med den algoritme, der var blevet trænet fra bunden på de nye data.

Genoptræning af lavvandede lag

Resultaterne var overraskende. "I dette papir fandt vi ud af, at de laveste lag var de bedste at genoptræne," siger Hassanzadeh. At have adgang til det forudsagte signal produceret ved at genoptræne hvert lag igen gav dem et vindue til den effekt hvert lag havde på dette endelige signal. Derfor brugte de simpelthen spektralanalyse af hvert signal for at se, hvordan hvert lag ændrede hver tilstedeværende frekvens. Nogle niveauer styrede de lave frekvenser, og det var nyttigt at genoptræne disse, da de fangede algoritmens jævnt varierende, makroskopiske funktioner. Andre niveauer forudsagde i mellemtiden detaljerne, og omskoling af disse alene var næsten ubrugelig. Forskerne har givet en protokol til at bestemme de vigtigste niveauer i et givet tilfælde. "Vi ønskede ikke at sige, at vi har en tommelfingerregel i dette papir," siger Hassanzadeh. "Nu har vi fundet systemer, hvor for eksempel mellemlagene er de bedste [at genoptræne]."

Kunstig intelligens forenkler beregninger af elektroniske egenskaber

Teamet beskriver arbejdet i et papir udgivet i PNAS Nexus.

"Jeg synes, det er et virkelig interessant papir," siger astrofysiker og maskinlæringsekspert Shirley Ho fra Flatiron Institute i New York City. Hun tilføjer: "På den anden side har vi i mange andre videnskabelige discipliner brugt spektralanalyse i lang tid nu, så jeg gætter på, at spørgsmålet er, om det er et væsentligt bidrag at anvende det på de flere lag. Jeg får en fornemmelse af, at det nok er en af de ting, der har været i folks sind, men ingen har skrevet det. Det kan være en af de store aviser, hvor det er indlysende for alle, når man først siger det."

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://physicsworld.com/a/new-approach-retrains-deep-neural-networks-to-deal-with-changes-in-complex-systems/

- 2017

- a

- Om

- adgang

- opnår

- Handling

- Tilføjer

- fremskreden

- algoritme

- algoritmer

- Alle

- alene

- beløb

- analyse

- ,

- En anden

- applikationer

- Anvendelse

- tilgang

- kunstig

- kunstig intelligens

- til rådighed

- fordi

- BEDSTE

- Bedre

- Bund

- Bringer

- beregninger

- Kræft

- kan ikke

- kapaciteter

- tilfælde

- tilfælde

- champion

- lave om

- Ændringer

- By

- Klima

- Klima forandring

- kolleger

- sammenligne

- komplekse

- computer

- betingelser

- modsætning

- bidrag

- styring

- kontroversielle

- konventionelle

- data

- datasæt

- deal

- dyb

- dyb læring

- dybeste

- Design

- detaljer

- bestemmelse

- udviklet

- dikterer

- forskelle

- forskellige

- Dont

- i løbet af

- hver

- tidligere

- Tidligt

- effekt

- enten

- elektronisk

- til sidst

- præcist nok

- eksempel

- erfaring

- ekspert

- Forklarer

- ekstern

- Uddrag

- bekendt

- berømt

- Funktionalitet

- få

- Figur

- endelige

- Endelig

- Forces

- fundet

- Frekvens

- fra

- få

- given

- Go

- Goes

- Googles

- stor

- gruppe

- hånd

- have

- høj opløsning

- stærkt

- Hvordan

- Men

- HTTPS

- Mennesker

- billede

- billeder

- vigtigt

- in

- oplysninger

- i stedet

- Institut

- Intelligens

- interessant

- spørgsmål

- IT

- Job

- kendt

- lag

- lag

- LÆR

- lærte

- læring

- Lee

- Niveau

- niveauer

- Liste

- Lang

- lang tid

- leder

- maskine

- machine learning

- lave

- mange

- max-bredde

- I mellemtiden

- Mellemøsten

- sind

- model

- mere

- mest

- flere

- Natur

- netværk

- net

- neurale netværk

- Ny

- New York

- New York

- nummer

- Obvious

- Gammel

- ONE

- åbent

- operatør

- Andet

- Papir

- papirer

- parametre

- forbi

- mønstre

- folks

- Udfør

- ydeevne

- måske

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- Praktisk

- forudsige

- forudsagde

- Forudsigelser

- præsentere

- Forud

- sandsynligvis

- Problem

- behandle

- produceret

- Program

- programmerede

- Protein

- protokol

- forudsat

- offentliggjort

- spørgsmål

- forholdet

- genkende

- forskere

- Resultater

- Ris

- Herske

- samme

- siger

- Scale

- videnskabelig

- Videnskabsmand

- forskere

- Skærm

- Sequence

- sæt

- sæt

- lavvandet

- vist

- Signal

- signifikant

- Skilte

- ganske enkelt

- situationer

- lille

- glat

- So

- nogle

- specifikke

- Spektral

- væsentlig

- sådan

- overraskende

- systemet

- Systemer

- hold

- Texas

- selv

- derfor

- ting

- tre

- thumbnail

- tid

- til

- nutidens

- top

- Tog

- uddannet

- Kurser

- tog

- overførsel

- sand

- TUR

- under

- ukendt

- universitet

- us

- Vejr

- Hvad

- hvorvidt

- som

- visdom

- Arbejde

- arbejdede

- world

- skriftlig

- Du

- zephyrnet