Idémotor giver dig mulighed for at skabe og dele VR og mixed reality-oplevelser. Opbygning af et sådant generelt værktøj kræver komplekse brugergrænseflader. I denne gæsteartikel deler udvikleren Brett Jackson sine tilgange til interaktion med brugergrænsefladen.

Brett Jackson har udviklet VR-projekter siden 2015 og er direktør for det nye UK-baserede selskab X82 Ltd. Hans tidligere udgivelser inkluderer: Dimensional (PC VR), Breath Tech (PC VR), Jigsaw 360 (PC VR & mobil VR) og 120Hz (SideQuest).

Det er almindeligt at præsentere en brugergrænseflade gennem 2D interaktive paneler i XR. Det er ikke et spændende perspektiv, men det er velkendt og effektivt. Men selvom vi accepterer denne 2D-indtrængen i vores XR-verdener, er der stadig nye overvejelser og muligheder for at bryde fri fra 2D-paradigmer.

Jeg blev hurtigt træt af laserpointere, der overdrev mine håndbevægelser på fjerne paneler, sammen med deres inkonsistente målvektorer og intermitterende pinch-detektion. Min præference er at række ud og interagere med verden. Jeg vil have panelet lige foran mig, så jeg kan placere det komfortabelt og bruge det som en virkelig enhed.

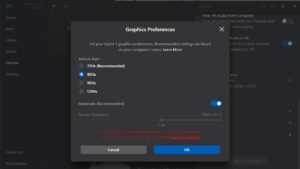

Mit seneste projekt, Idémotor, er udviklet vha Stereokit, et OpenXR-bibliotek med åben kildekode. Det har en hands-first-filosofi og giver out-of-the-box håndsporingssupport såvel som controller-support. Det giver mulighed for effektiv oprettelse af dynamiske vinduer med typiske UI-kontroller. Det er et fremragende værktøj til hurtigt at skabe XR-projekter og har mange andre fordele.

Paneler

Så mit udgangspunkt er et UI-panel, som vi kan gribe til enhver tid (ingen specielle håndtag eller kanter at finde) med en flot aura, der vises, når vi er inden for rækkevidde. Lad os nu tilføje flere XR-overvejelser.

I XR er det nemt for en bruger at ende bag et UI-panel. I stedet for at vise en tom bagside eller omvendt brugergrænseflade, vender jeg brugergrænsefladen til den side, som brugeren ser på – enkelt. Det lyder trivielt, men det er værd at overveje XR-specifikke scenarier. En anden fremgangsmåde er at automatisk rotere panelet, så det hele tiden vender mod afspilleren, men dette fjerner kontrollen fra brugeren. Hvis de vil have panelet i en mærkelig vinkel, så lad dem, de kan have en god grund.

Et individuelt panel bør holdes i en lille størrelse (sidestørrelse / skærmstørrelse), så brugeren nemt kan absorbere indholdet uden at skulle dreje hovedet, men XR giver os en overflod af plads. Jeg kan godt lide at lede efter muligheder for at bryde ud af sidegrænsen. Mine rulbare områder har et håndtag til at gribe og flytte indholdet. Mens du griber, ser du en meget udvidet visning af indholdsområdet, og du kan trække og slippe, mens du er i denne tilstand, hvilket giver et større placeringsområde.

Jeg viser tip til siden af paneler med en linje til den brugergrænsefladekomponent, de beskriver. Dette reducerer mængden af tekst på panelet. Brugere kan bladre gennem tips og skjule dem, de er bekendt med.

I et andet projekt lavede jeg en prototype på et 3D Gantt-diagram, der rullede ud af siden vandret og falmede ud i det fjerne. Brugerens hovedfokus var stadig på centralpanelet i normal størrelse, men de var valgfrit i stand til at tage den bredere kontekst ind.

Selvom paneler er praktiske og velkendte, bør vi ikke føle os begrænset af deres grænser, og det er sjovt at lede efter måder at bryde ud på.

Menuer

StereoKit introducerede mig til den radiale håndmenu, som jeg derefter udvidede. Jeg kan godt lide denne idé, fordi du betjener den med én hånd, så den er praktisk, tilgængelig. Jeg gør det samme menusystem tilgængeligt på både højre og venstre hånd og bruger samme tilgang til popup-menuer på paneler for at opnå konsistens.

Min volumetriske menu tager tingene et skridt videre og var udelukkende drevet af et ønske om at gøre brug af den 3. dimension. Jeg bruger den til at vælge teleportere destinationer (med en pegepind til hver destination) og til at vælge nærliggende noder, der skal redigeres. Jeg bruger det også til tastaturinput, når jeg gennemser metaverse-adresser. Dette er ret eksperimentelt. Det har den fordel, at alle symboler er lige langt fra midten, og du ser dit input uden at skulle kigge væk (et almindeligt problem med virtuelle tastaturer). Ulempen er, at det er ukendt for brugerne, så jeg forventer en vis modstand mod det. Læg mærke til i videoen, at bogstaverne spiraler væk fra forsiden til bagsiden i alfabetisk rækkefølge, så om kort tid burde deres position blive bekendt.

Du vil snart være i stand til at tilføje menuer som disse til dine egne Idea Engine-projekter.

3D-widgets

En farvevælger tilbød en ideel mulighed for at eksperimentere med tre værdier (nuance, mætning og værdi), der kunne kortlægges til 3 dimensioner. I min 3D-farvevælger kan du ændre alle tre værdier på én gang eller individuelt indstille nuance, mætning eller værdi. Jeg føler, det er mere interessant at interagere med end skydere på en 2D-side.

På samme måde med bevægelse vil jeg gerne bevæge mig i 3D, så jeg lavede et 3D-joystick til jævn håndsporet bevægelse. Træk blot kuglen i den retning, du ønsker at rejse, og rul dit håndled for at få snap eller jævn rotation. Den fungerer i gå- eller flyvende tilstand, og rotationen kan deaktiveres, hvis brugeren finder det for meget at tænke på alt i én kontrol. Jeg understøtter stadig traditionel controller-baseret bevægelse, men denne enhåndskontrol duplikerer funktionaliteten af flere joysticks/knapper og er et interessant eksempel på, hvordan 3d håndbevægelse kan opfylde kravene på nye måder.

hænder

I alle mine eksempelvideoer vil du se, at jeg skjuler brugerens hånd, så snart de begynder at interagere med brugergrænsefladen. Mange udviklere investerer kræfter i omhyggeligt at skabe gribestillinger til forskellige formål, og det ser pænt ud, men for mig er en velpositioneret hånd, der ikke afspejler min egen håndposition, mere distraherende end ingen hånd overhovedet. En hånd kan også være en visuel hindring, når interaktionen er startet.

Med hånden væk, er jeg også fri til at dæmpe eller overdrive håndbevægelser uden nogen visuel konflikt. Jeg dæmper håndbevægelser i farvevælgeren for at sænke følsomheden og overdrive håndbevægelser, når der scrolles, når der er meget indhold.

tekst

Mens Idea Engine understøtter Sketchfab til at downloade 3D-modeller, AI til at generere billeder og import af foto/lyd, er det svært at slå letheden og tilgængeligheden af tekst og det talte ord for at formidle komplekse fortællinger. Med dette i tankerne havde jeg brug for anstændig støtte til tekst, så brugere kunne flette alle tilgængelige formater for at fortælle deres historier.

Tekst ser generelt ikke godt ud i VR, så jeg toner den ud, når du går væk for at fjerne grimme artefakter og også lukke tekstpaneler ned. Brugere vil være ivrige efter at udforske miljøet i stedet for at læse tekst, så jeg har mulighed for at lade en fortæller automatisk læse enhver bloktekst, du støder på.

Tekstinput var en udfordring uden en god løsning. Jeg oprettede tekstinput i mobilstil med understøttelse af klip og indsæt og automatisk paginering ved hjælp af et virtuelt tastatur. Da jeg var færdig, tænkte jeg, det er OK, men jeg ville ikke skrive en lang passage i XR. Så tilføjede jeg stemme-til-tekst-understøttelse. Det hjalp, men jeg fandt ud af, at jeg skulle lave en masse redigering efter min diktat, og det var stadig langsommere end at bruge traditionelle midler. Nu giver jeg brugere mulighed for at oprette forbindelse til deres headset fra en browser på alle enheder, de ejer, og importere tekst via en webside. Jeg bruger jævnligt alle tre teknikker, hvor browseren bruges til lang tekstindtastning.

Min lektie her var, at du ikke altid behøver at løse alt i XR. Nogle gange er det at foretrække at bruge mere egnede enheder og derefter importere resultaterne.

Prøve det

Fra pædagogiske mindmaps til interaktive historier og spil kan du udnytte CC-aktiver og importere dine egne billeder, lyde og tekst for at bygge din idé. Så bring det til live ved at tilføje tilstande, begivenheder og scripting på højt niveau, og del det på vores X82-metaverse. Et funktionsspækket slutbrugerværktøj til at udforske mulighederne ved XR.

Fra pædagogiske mindmaps til interaktive historier og spil kan du udnytte CC-aktiver og importere dine egne billeder, lyde og tekst for at bygge din idé. Så bring det til live ved at tilføje tilstande, begivenheder og scripting på højt niveau, og del det på vores X82-metaverse. Et funktionsspækket slutbrugerværktøj til at udforske mulighederne ved XR.

public alpha er nu tilgængelig og gratis at downloade på App Lab, så du kan komme og prøve enhver af de diskuterede funktioner og give mig din feedback.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.roadtovr.com/xr-interface-interactions-idea-engine-brett-jackson/

- :har

- :er

- :ikke

- $OP

- 10

- 180

- 2015

- 2D

- 360

- 3d

- 3.

- 7

- a

- I stand

- Om

- overflod

- Acceptere

- tilgængelighed

- tilgængelig

- tilføje

- tilføjet

- tilføje

- adresser

- Fordel

- Efter

- AI

- Alle

- tillade

- tillader

- sammen

- Alpha

- også

- altid

- beløb

- an

- ,

- En anden

- enhver

- app

- tilgang

- tilgange

- ER

- OMRÅDE

- områder

- artikel

- AS

- Aktiver

- At

- lyd

- Aura

- auto

- automatisk

- til rådighed

- væk

- tilbage

- BE

- slå

- fordi

- bliver

- været

- bag

- fordele

- Bloker

- både

- grænse

- bounds

- Pause

- bryde ud

- Breath

- bringe

- browser

- Browsing

- bygge

- Bygning

- men

- by

- CAN

- omhyggeligt

- central

- center

- udfordre

- lave om

- Chart

- Luk

- Kom

- Fælles

- selskab

- komplekse

- komponent

- konflikt

- Tilslut

- overvejelser

- Overvejer

- konstant

- indhold

- indhold

- sammenhæng

- kontrol

- controller

- kontrol

- Praktisk

- kunne

- skabe

- oprettet

- Oprettelse af

- skabelse

- Klip

- cyklus

- beskrive

- ønske

- destination

- destinationer

- Detektion

- udviklet

- Udvikler

- udviklere

- udvikling

- enhed

- Enheder

- forskellige

- Dimension

- størrelse

- retning

- Direktør

- deaktiveret

- drøftet

- vises

- afstand

- fjernt

- do

- Er ikke

- Dont

- ned

- downloade

- drevet

- Drop

- dubletter

- dynamisk

- hver

- lette

- nemt

- let

- uddannelsesmæssige

- effektiv

- indsats

- ende

- Engine (Motor)

- indrejse

- Miljø

- Endog

- begivenheder

- at alt

- eksempel

- fremragende

- spændende

- udvidet

- forvente

- Oplevelser

- eksperiment

- eksperimenterende

- udforske

- Udforskning

- Ansigtet

- fade

- bekendt

- Funktionalitet

- tilbagemeldinger

- føler sig

- Finde

- fund

- Flip

- flyvende

- Fokus

- Til

- fundet

- Gratis

- fra

- forsiden

- sjovt

- funktionalitet

- yderligere

- Spil

- generelle formål

- generelt

- generere

- Giv

- gået

- godt

- grab

- stor

- større

- stærkt

- voksede

- Gæst

- Gæsteartikel

- hånd

- håndsporing

- håndtere

- Håndterer

- Hård Ost

- Have

- have

- hoved

- Headset

- hjulpet

- link.

- Skjule

- Høj

- hans

- vandret

- Hvordan

- Men

- HTTPS

- i

- idé

- ideal

- if

- billeder

- importere

- importere

- in

- omfatter

- individuel

- Individuelt

- indgang

- interagere

- interaktion

- interaktion

- interaktioner

- interaktiv

- interessant

- grænseflade

- grænseflader

- ind

- introduceret

- Invest

- spørgsmål

- IT

- Jackson

- puslespil

- jpg

- Keen

- holdt

- laser

- seneste

- til venstre

- lektion

- lad

- Niveau

- Leverage

- Bibliotek

- Livet

- ligesom

- Line (linje)

- Lang

- Se

- leder

- UDSEENDE

- Lot

- lavere

- lavet

- Main

- lave

- mange

- Maps

- max-bredde

- Kan..

- me

- midler

- Mød

- Menu

- Flet

- Meta

- metaverse

- tankerne

- blandet

- blandet virkelighed

- Mobil

- tilstand

- modeller

- Overvåg

- mere

- bevæge sig

- bevægelse

- meget

- flere

- my

- fortællinger

- Behov

- behov

- Ny

- rart

- ingen

- noder

- Varsel..

- nu

- Oculus

- of

- off

- tilbydes

- on

- engang

- ONE

- dem

- open source

- betjene

- opererer

- Muligheder

- Opportunity

- Option

- or

- ordrer

- Andet

- vores

- ud

- egen

- side

- Paginering

- panel

- paneler

- paradigmer

- passage

- PC

- vrpc

- filosofi

- foto

- pics

- placering

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- Punkt

- udgør

- position

- muligheder

- foretrækkes

- præsentere

- tidligere

- projekt

- projekter

- udsigten

- giver

- leverer

- rent

- formål

- hurtigt

- helt

- rækkevidde

- hellere

- nå

- Læs

- virkelige verden

- Reality

- grund

- reducerer

- afspejler

- regelmæssigt

- Udgivelser

- Fjern

- fjerner

- Krav

- Kræver

- Modstand

- Resultater

- højre

- Roll

- samme

- scenarier

- rulning

- se

- Vælg

- Følsomhed

- sæt

- Del

- Aktier

- Kort

- bør

- Vis

- side

- sidequest

- ganske enkelt

- siden

- enkelt

- Størrelse

- lille

- udjævne

- Snap

- So

- løsninger

- SOLVE

- nogle

- sommetider

- snart

- lyde

- Space

- særligt

- specifikke

- talt

- starte

- påbegyndt

- Starter

- Stater

- Trin

- Stadig

- Historier

- mærkeligt

- sådan

- egnede

- support

- Understøtter

- systemet

- Tag

- tager

- mål

- tech

- teknikker

- fortælle

- tekst

- end

- at

- verdenen

- deres

- Them

- derefter

- Der.

- Disse

- de

- ting

- tror

- denne

- tænkte

- tre

- Gennem

- tips

- til

- også

- værktøj

- Sporing

- traditionelle

- rejse

- prøv

- TUR

- typen

- typisk

- ui

- ukendt

- us

- brug

- anvendte

- Bruger

- Brugergrænseflade

- brugere

- ved brug af

- værdi

- Værdier

- via

- video

- Videoer

- Specifikation

- Virtual

- visuel

- vr

- gå

- gå

- ønsker

- var

- måder

- we

- web

- GODT

- var

- hvornår

- som

- mens

- bredere

- vilje

- vinduer

- med

- uden

- ord

- world

- Verdens

- værd

- håndled

- XR

- Du

- Din

- zephyrnet