Efterhånden som flere organisationer anvender generative AI-teknologier - til at lave pitches, udfylde ansøgninger om tilskud og skrive kedelkode — sikkerhedsteams indser behovet for at løse et nyt spørgsmål: Hvordan sikrer man AI-værktøjer?

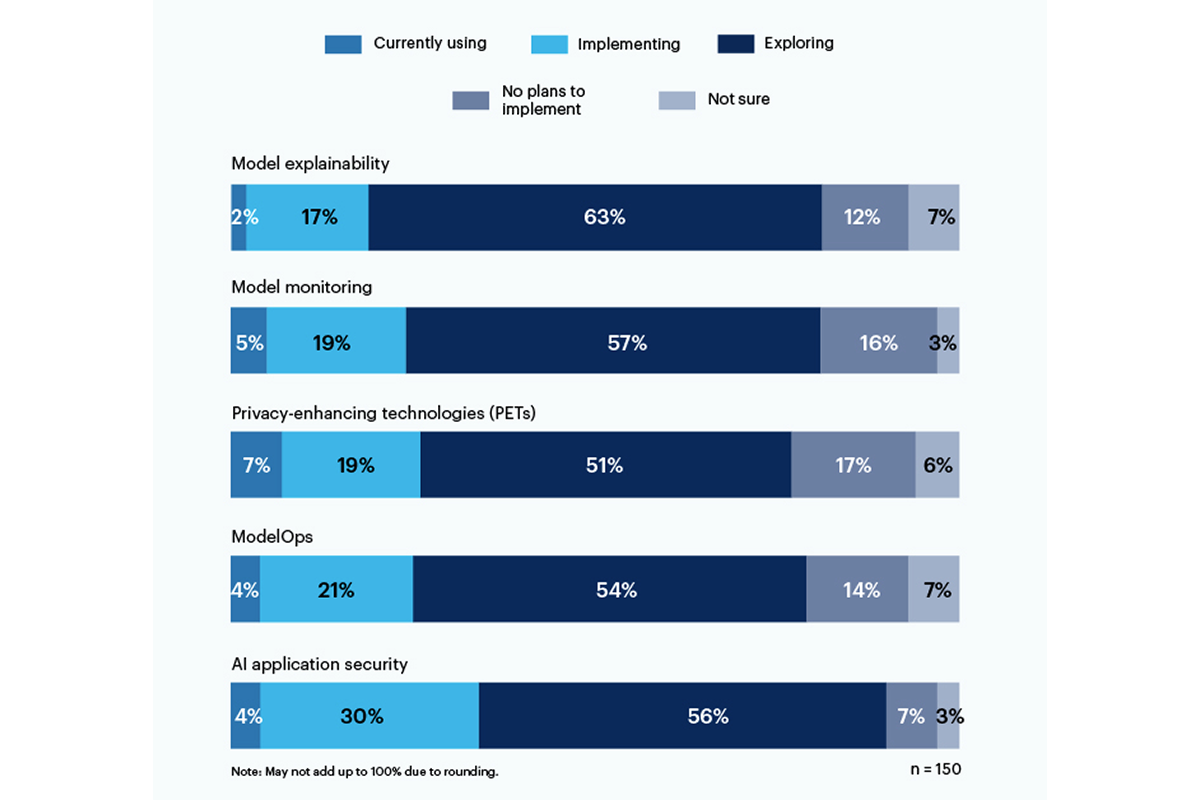

En tredjedel af de adspurgte i en nylig undersøgelse fra Gartner rapporterede enten bruge eller implementere AI-baserede applikationssikkerhedsværktøjer at imødegå de risici, der er forbundet med brugen af generativ kunstig intelligens i deres organisation.

Privatlivsfremmende teknologier (PET'er) udviste den største nuværende brug, med 7 % af de adspurgte, med solide 19 % af virksomhederne, der implementerede det; denne kategori omfatter måder at beskytte personlige data på, som f.eks homomorf kryptering, AI-genererede syntetiske data, sikker flerpartsberegning, fødereret læringog forskelligt privatliv. Men solide 17% har ingen planer om at tilskynde PET'er i deres miljø.

Kun 19 % bruger eller implementerer værktøjer til modelforklarlighed, men der er betydelig interesse (56 %) blandt respondenterne for at udforske og forstå disse værktøjer til at håndtere generativ AI-risiko. Forklarlighed, modelovervågning og AI-applikationssikkerhedsværktøjer kan alle bruges på open source eller proprietære modeller for at opnå pålidelighed og pålidelighed, som virksomhedsbrugere har brug for, ifølge Gartner.

De risici, respondenterne er mest bekymrede over, omfatter ukorrekte eller partiske output (58 %) og sårbarheder eller lækkede hemmeligheder i AI-genereret kode (57 %). Det er bemærkelsesværdigt, at 43 % nævnte potentielle ophavsrets- eller licensproblemer, der stammer fra AI-genereret indhold, som de største risici for deres organisation.

"Der er stadig ingen gennemsigtighed omkring datamodeller, der trænes i, så risikoen forbundet med bias og privatliv er meget svær at forstå og estimere," skrev en C-suite-chef som svar på Gartner-undersøgelsen.

I juni, National Institute of Standards and Technology (NIST) lancerede en offentlig arbejdsgruppe at hjælpe med at løse det spørgsmål, baseret på dets AI Risk Management Framework fra januar. Som Gartner-dataene viser, virksomheder venter ikke for NIST-direktiver.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :er

- :ikke

- 7

- a

- Om

- Ifølge

- opnå

- adresse

- vedtage

- AI

- Alle

- blandt

- ,

- Anvendelse

- applikationssikkerhed

- applikationer

- ER

- AS

- forbundet

- At

- baseret

- BE

- skævhed

- forudindtaget

- men

- by

- C-suite

- CAN

- Boligtype

- citeret

- kode

- Virksomheder

- fuldføre

- pågældende

- indhold

- ophavsret

- håndværk

- Nuværende

- data

- svært

- direktiver

- do

- enten

- Enterprise

- Miljø

- skøn

- udøvende

- Udforskning

- Til

- Framework

- fra

- Gartner

- generative

- Generativ AI

- indrømme

- størst

- Have

- hjælpe

- Hvordan

- Men

- HTTPS

- gennemføre

- in

- omfatter

- omfatter

- Institut

- interesse

- spørgsmål

- IT

- ITS

- januar

- juni

- lanceret

- Licenser

- ledelse

- metoder

- model

- modeller

- overvågning

- mere

- mest

- flere

- national

- Behov

- Ny

- NIST

- ingen

- of

- on

- åbent

- open source

- or

- organisation

- organisationer

- personale

- Personlig data

- Kjæledyr

- pladser

- planer

- plato

- Platon Data Intelligence

- PlatoData

- stillet

- potentiale

- Beskyttelse af personlige oplysninger

- proprietære

- beskytte

- offentlige

- spørgsmål

- realisere

- nylige

- pålidelighed

- stole

- rapporteret

- respondenter

- svar

- Risiko

- risikostyring

- risici

- hemmeligheder

- sikker

- sikkerhed

- viste

- Shows

- signifikant

- betydeligt

- So

- solid

- Kilde

- standarder

- Stadig

- sådan

- Kortlægge

- syntetisk

- hold

- Teknologier

- Teknologier

- at

- deres

- Der.

- Disse

- denne

- til

- værktøjer

- top

- Kurser

- Gennemsigtighed

- troværdighed

- forstå

- forståelse

- brug

- anvendte

- brugere

- ved brug af

- meget

- Sårbarheder

- måder

- med

- arbejder

- skriver

- skrev

- Du

- zephyrnet