Amazon SageMaker Data Wrangler er en evne til Amazon SageMaker der gør det hurtigere for datavidenskabsfolk og ingeniører at forberede højkvalitetsfunktioner til maskinlæringsapplikationer (ML) via en visuel grænseflade. Data Wrangler reducerer den tid, det tager at samle og forberede data til ML fra uger til minutter. Med Data Wrangler kan du forenkle processen med dataforberedelse og funktionsudvikling og fuldføre hvert trin i dataforberedelsesworkflowet, inklusive datavalg, rensning, udforskning og visualisering fra en enkelt visuel grænseflade.

I dette indlæg dykker vi ned i forskellige aspekter af dataforberedelse og de tilhørende funktioner i Data Wrangler for at forstå omkostningskomponenterne ved dataforberedelse, og hvordan Data Wrangler tilbyder en omkostningseffektiv tilgang til dataforberedelse. Vi dækker også best practices for omkostningsoptimering for yderligere at reducere omkostningerne til dataforberedelse i Data Wrangler.

Oversigt over eksplorativ dataanalyse (EDA) og dataforberedelse i Data Wrangler

For at forstå omkostningseffektiviteten af Data Wrangler er det vigtigt at se på forskellige aspekter af EDA og dataforberedelsesfasen af ML. Denne blog vil ikke sammenligne forskellige platforme eller tjenester for EDA, men forstå forskellige trin i EDA, deres omkostningsovervejelser, og hvordan Data Wrangler faciliterer EDA på en omkostningseffektiv måde.

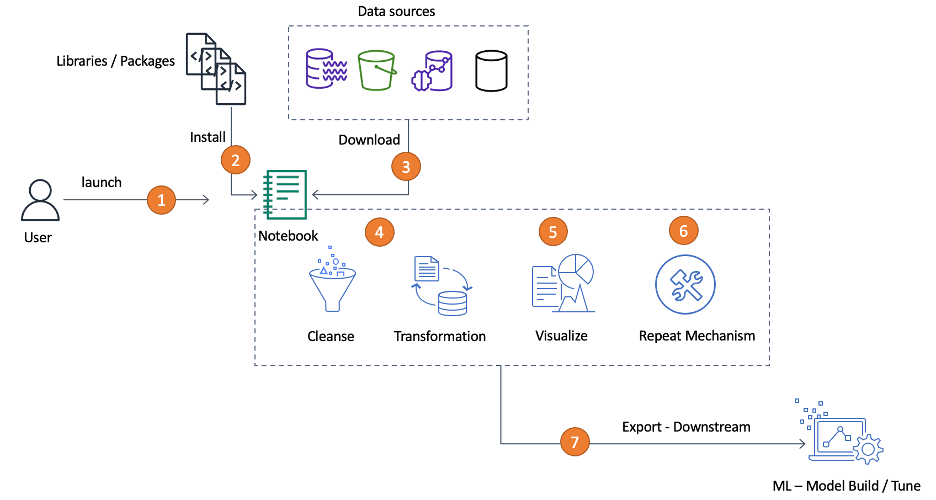

En dataforskers typiske EDA-oplevelse består af følgende trin:

- Start en Jupyter notebook-instans for at udføre EDA.

- Importer nødvendige pakker til dataanalyse og visualisering.

- Importer data fra flere kilder.

- Udfør transformationer såsom håndtering af manglende værdier og afvigelser, one-hot-kodning, balancering af data og mere for at rense dataene og gøre dem klar til modellering.

- Visualiser dataene.

- Opret mekanismer til at gentage trinene.

- Eksporter behandlede data til downstream analytics eller ML.

Disse trin er komplekse og kræver fleksibilitet i beregnings- og hukommelseskrav, så du kan køre hvert trin med passende beregning og hukommelse. Du har også brug for et integreret system, der kan importere data fra flere kilder og mekanismer for at gentage eller genbruge, så du kan anvende de samme EDA-trin, som du allerede har bygget, på større, lignende eller forskellige datasæt som krævet af din downstream ML-pipeline.

EDA omkostningsovervejelser

Følgende er nogle af omkostningsovervejelserne for EDA:

Compute

- Nogle EDA-miljøer kræver data i et bestemt format. I sådanne tilfælde skal du behandle dataene til det format, der accepteres af EDA-miljøet. For eksempel, hvis miljøet kun accepterer CSV-format, men du har data i Parquet eller et andet format, skal du konvertere dit datasæt til CSV-format. Omformatering af data kræver beregning.

- Ikke alle miljøer har fleksibiliteten til at ændre computer- eller hukommelseskonfiguration med et klik på en knap. Du skal muligvis have den højeste beregningskapacitet og hukommelsesfodaftryk, som er relevant for hver transformation, du udfører.

Opbevaring og dataoverførsel

- Data fra flere kilder skal indsamles. Hvis kun udvalgte kilder understøttes af EDA-miljøet, skal du muligvis flytte dine data fra forskellige kilder til den enkelte understøttede kilde, hvilket øger både lager- og dataoverførselsomkostninger.

Arbejdsomkostninger og ekspertise

- Administration af EDA-platformen og den underliggende computerinfrastruktur involverer ekspertise, indsats og omkostninger. Når du administrerer infrastrukturen, har du den operationelle byrde med at administrere operativsystemer og applikationer såsom klargøring, patching og opgradering. Sørg for at identificere problemer hurtigt. Hvis du ikke validerer dataene, før du bygger din model, har du spildt mange ressourcer såvel som ingeniørtid.

- Bemærk, at EDA kræver ekspertise inden for datavidenskab og dataerfaring.

- Derudover tilbyder nogle EDA-miljøer ikke en peg-og-klik-grænseflade og kræver, at du skriver kode for at udforske, visualisere og transformere data, hvilket involverer arbejdsomkostninger.

Driftsomkostninger

- For at flytte dataene fra kilden for at udføre transformationer og derefter til nedstrøms ML-pipelines, skal du muligvis udføre de gentagne EDA-trin igen fra begyndelsen af at hente dataene i hver fase af EDA, hvilket er tidskrævende og har en kumulativ arbejdsomkostninger. Hvis du kan bruge de transformerede data fra det forrige trin, øger det ikke kumulativt omkostningerne.

- At have en nem mekanisme til at gentage det samme sæt EDA-trin på lignende eller trinvise datasæt sparer tid såvel som omkostninger set fra et menneske- og computerressourceperspektiv.

Lad os se, hvordan Data Wrangler letter EDA eller dataforberedelse på en omkostningseffektiv måde i forhold til disse forskellige områder.

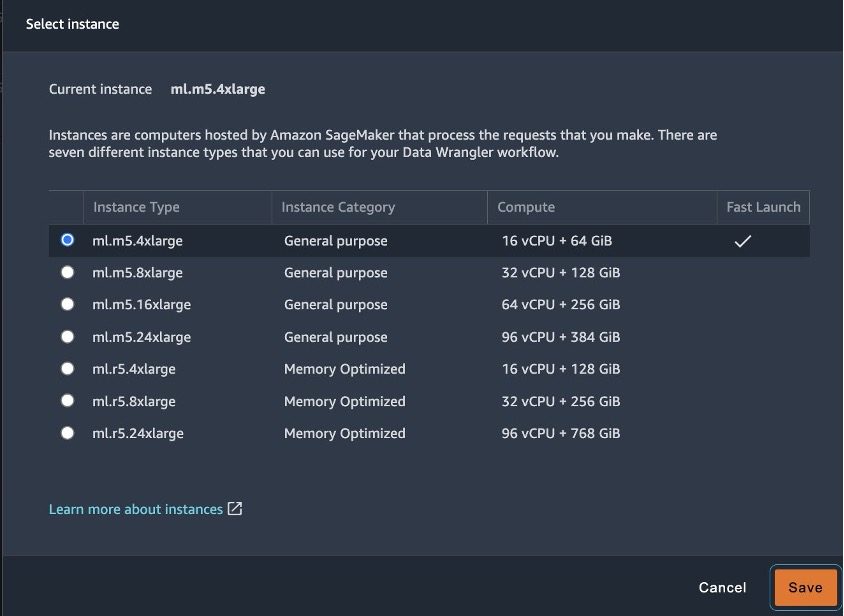

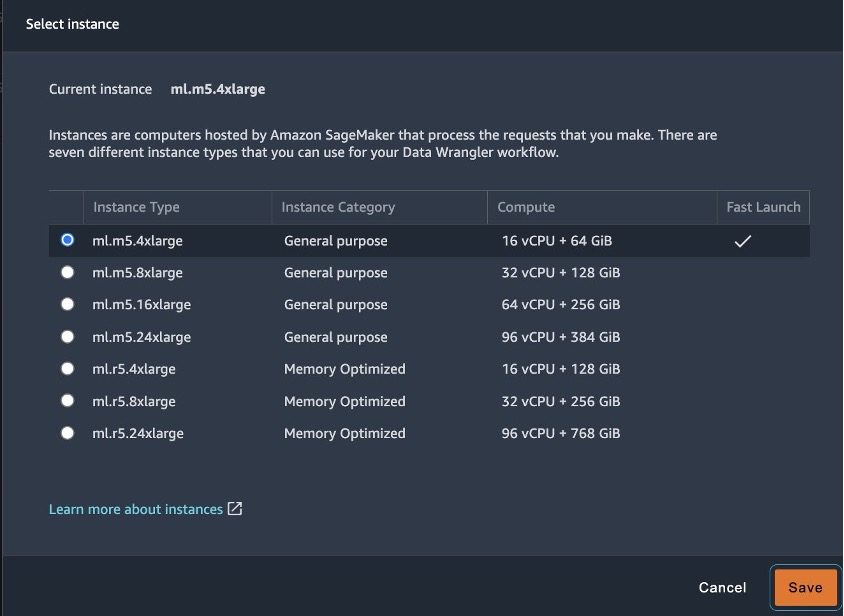

Compute

Når du udfører EDA på en notebook, har du muligvis ikke fleksibiliteten til at skalere computeren eller hukommelsen efter behov, hvilket kan tvinge dig til at køre transformation , visualiseringer i et overdimensioneret miljø. Hvis du har et underdimensioneret miljø, kan du løbe ind i problemer med hukommelsen. I Data Wrangler kan du vælge en mindre instanstype til bestemte transformationer eller analyser og derefter opskalere instansen til en større type og udføre komplekse transformationer. Når den komplekse transformation er fuldført, kan du nedskalere Data Wrangler-forekomsten til en mindre forekomsttype. Dette giver dig fleksibiliteten til at skalere din computer baseret på transformationskravene.

Data Wrangler understøtter en forskellige instanstyper, og du kan vælge den rigtige til din arbejdsbyrde og derved eliminere omkostningerne ved overdimensionerede eller underdimensionerede miljøer.

Opbevaring og dataoverførsel

I dette afsnit diskuterer vi nogle af omkostningsovervejelserne for opbevaring og dataoverførsel.

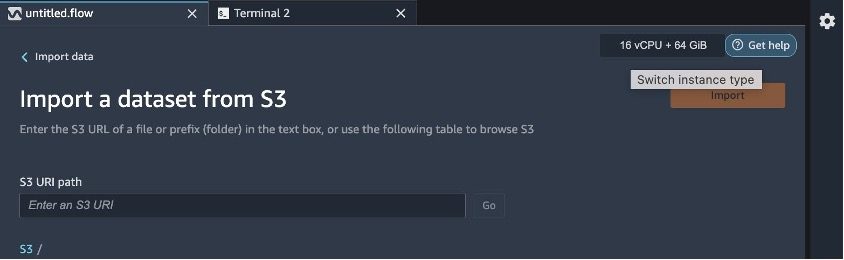

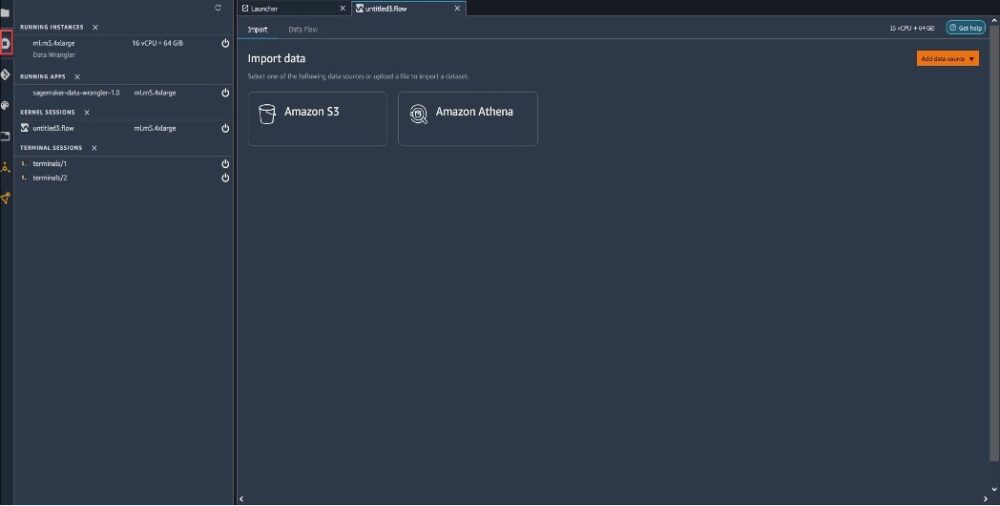

Importere

Data til ML er ofte tilgængelige fra flere kilder og i forskellige formater. Med Data Wrangler kan du importere data fra følgende datakilder: Amazon Simple Storage Service (Amazon S3), Amazonas Athena, Amazon rødforskydning, AWS søformation, Amazon SageMaker Feature Store , Snowflake. Data kan være i et af følgende formater: CSV, Parket, JSON og Optimized Row Columnar (ORC), og flere dataformater vil blive tilføjet baseret på kundernes efterspørgsel. Fordi de vigtige datakilder allerede er understøttet i Data Wrangler, kan data importeres direkte fra de respektive kilder, og du betaler kun for GB-måneden med klargjort lagerplads. For mere information, se Amazon SageMaker-priser.

Al den iterative dataudforskning, datatransformation og visualisering kan udføres i selve Data Wrangler. Dette eliminerer yderligere databevægelse sammenlignet med andre miljøer, hvor du muligvis skal flytte dataene til forskellige steder for indtagelse, transformation og behandling. Fra et omkostningsperspektiv eliminerer dette dobbelt datalagring samt reduceret databevægelse.

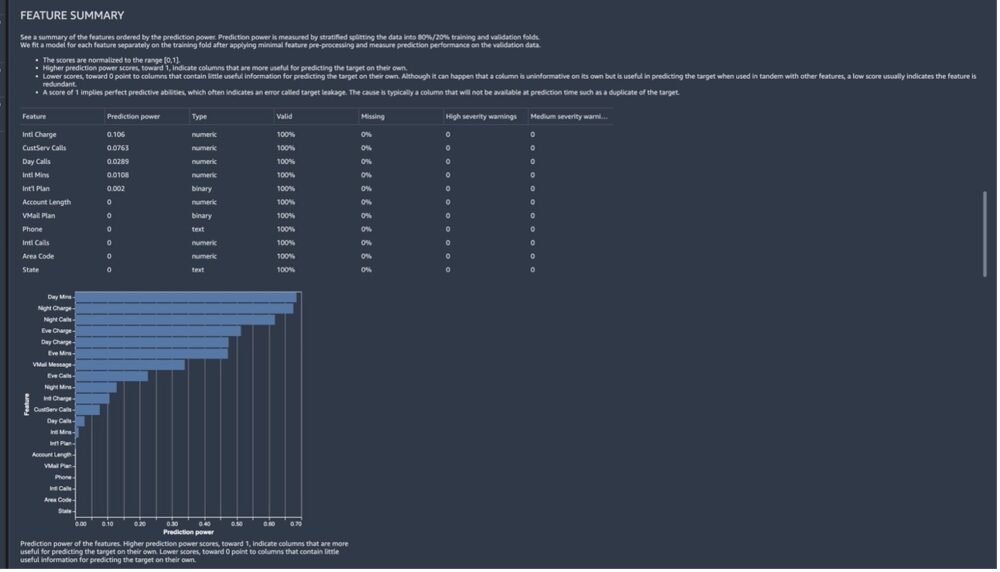

Pris for datakvalitet

Hvis du ikke identificerer dårlige data og retter dem tidligt, bliver det et dyrt problem at løse senere. Det Rapport om datakvalitet og indsigt hjælper dig med at eliminere dette problem. Du kan bruge rapporten Datakvalitet og -indsigt til at udføre en analyse af dine data for at få indsigt i dit datasæt, såsom antallet af manglende værdier og antallet af afvigende værdier. Hvis du har problemer med dine data, såsom mållækage eller ubalance, kan indsigtsrapporten gøre dig opmærksom på disse problemer. Så snart du importerer dine data, kan du køre en indsigtsrapport med et klik på en knap. Dette reducerer indsatsen ved at importere biblioteker og skrive kode for at få den nødvendige indsigt i datasættet, hvilket reducerer arbejdsomkostningerne og den nødvendige ekspertise.

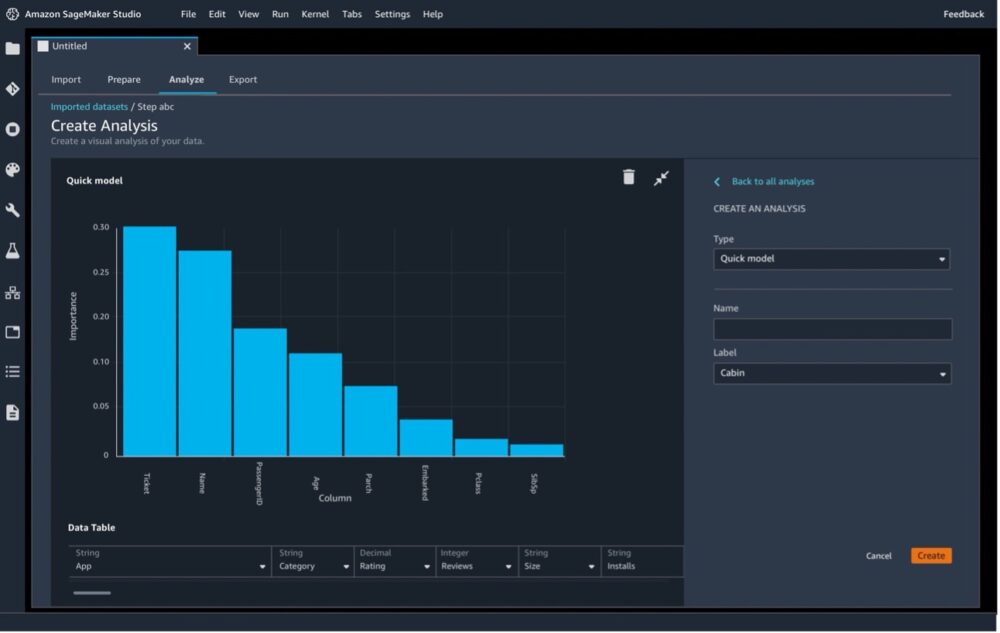

Når du opretter rapporten Datakvalitet og -indsigt, giver Data Wrangler dig mulighed for at vælge en målkolonne (den kolonne, du forsøger at forudsige). Når du vælger en målkolonne, opretter Data Wrangler automatisk en målkolonneanalyse. Den rangerer også funktionerne i rækkefølgen efter deres forudsigelsesevne (se følgende skærmbillede). Dette bidrager til den direkte forretningsmæssige fordel ved funktioner af høj kvalitet til downstream ML-processen.

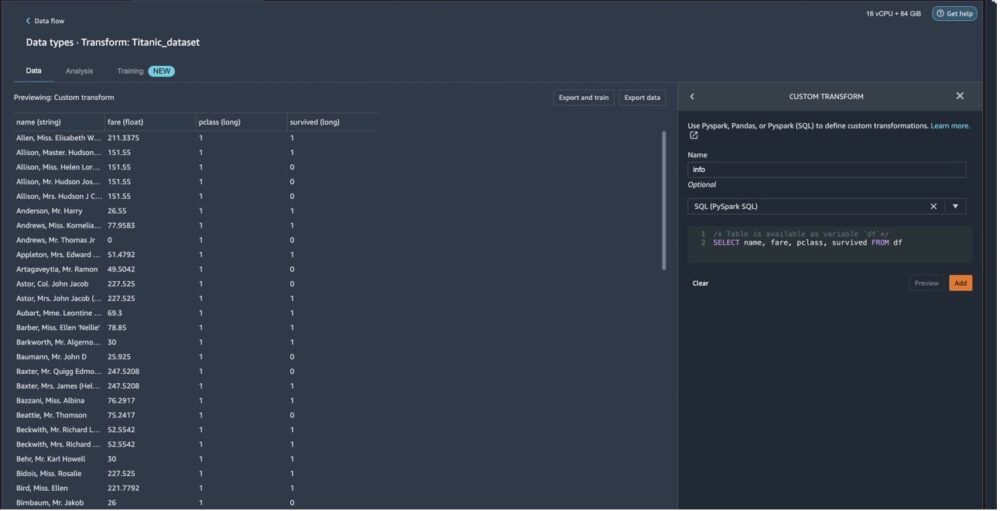

Transformation

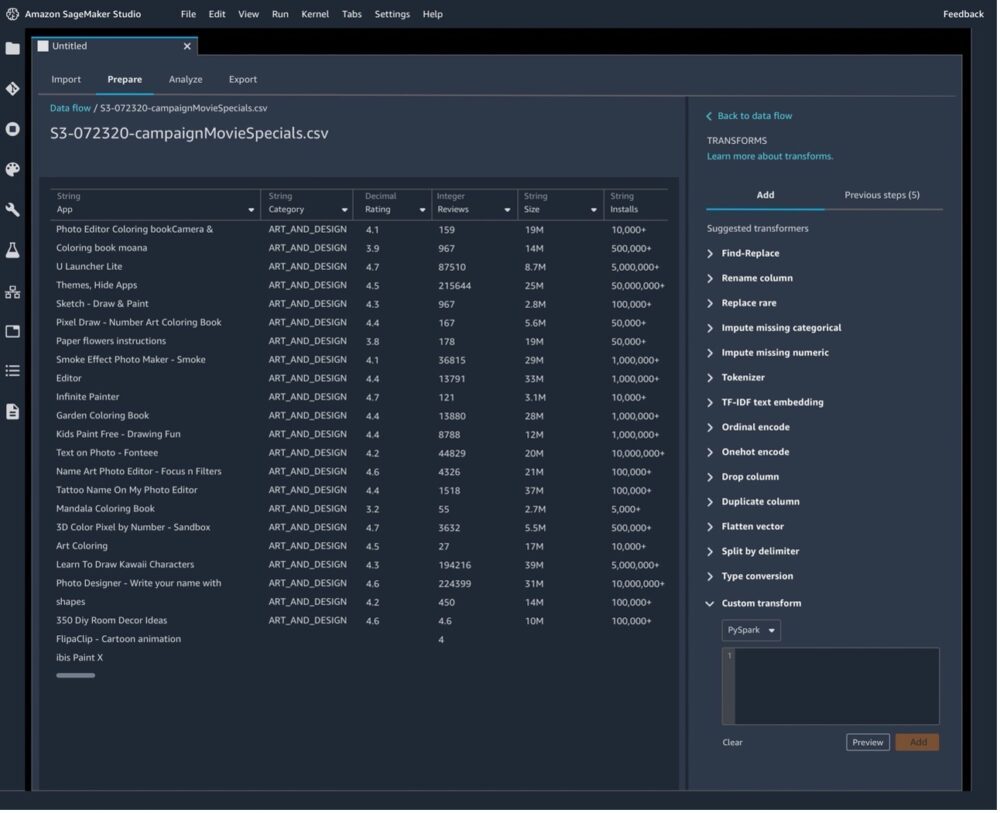

Hvis dit EDA-værktøj kun understøtter visse transformationer, skal du muligvis flytte dataene til et andet miljø for at udføre de tilpassede transformationer, såsom Spark-job. Data Wrangler understøtter tilpassede transformationer, som kan skrives i PySpark, Pandas og SQL (se følgende skærmbillede for et eksempel). De er udviklervenlige og alle sømløst pakket på ét sted, hvilket reducerer databevægelser og sparer omkostninger forbundet med dataoverførsel og lagring.

Du skal muligvis også udføre matematiske operationer på dine datasæt, såsom at tage en absolut værdi af en kolonne. Hvis dit EDA-værktøj ikke understøtter matematiske operationer, skal du muligvis udføre operationerne eksternt, hvilket kræver ekstra indsats og omkostninger. Nogle værktøjer understøtter muligvis matematiske operationer på datasættet, men kræver, at du importerer biblioteker, hvilket kræver en ekstra indsats. I Data Wrangler kan du også bruge en tilpasset formel at definere en ny kolonne ved hjælp af et Spark SQL-udtryk til at forespørge data i den aktuelle dataramme uden at pådrage sig yderligere omkostninger for tilpassede transformationer eller tilpassede forespørgsler.

Arbejdsomkostninger og ekspertise

Administration af EDA-platformen og den underliggende computerinfrastruktur involverer ekspertise, indsats og omkostninger. Data Wrangler tilbyder et udvalg af over 300 prækonfigurerede datatransformationer skrevet i PySpark, så du kan behandle datasæt op til hundredvis af gigabyte effektivt uden at skulle bekymre dig om at skrive kode for at transformere dataene. Du kan bruge transformationer såsom konvertere kolonnetype, én varm kodning, imputere manglende data med middelværdi eller median, reskalere kolonner og data/tidsindlejringer til at transformere dine data til formater, som modellerne kan bruge uden selv at skrive en enkelt linje kode. Dette reducerer tid og kræfter og reducerer derved arbejdsomkostningerne.

Data Wrangler tilbyder en peg-og-klik-grænseflade til at visualisere og validere data (se følgende skærmbillede). Der kræves ingen ekspertise inden for datateknik eller analyse, fordi al dataforberedelse kan udføres med et simpelt peg og klik.

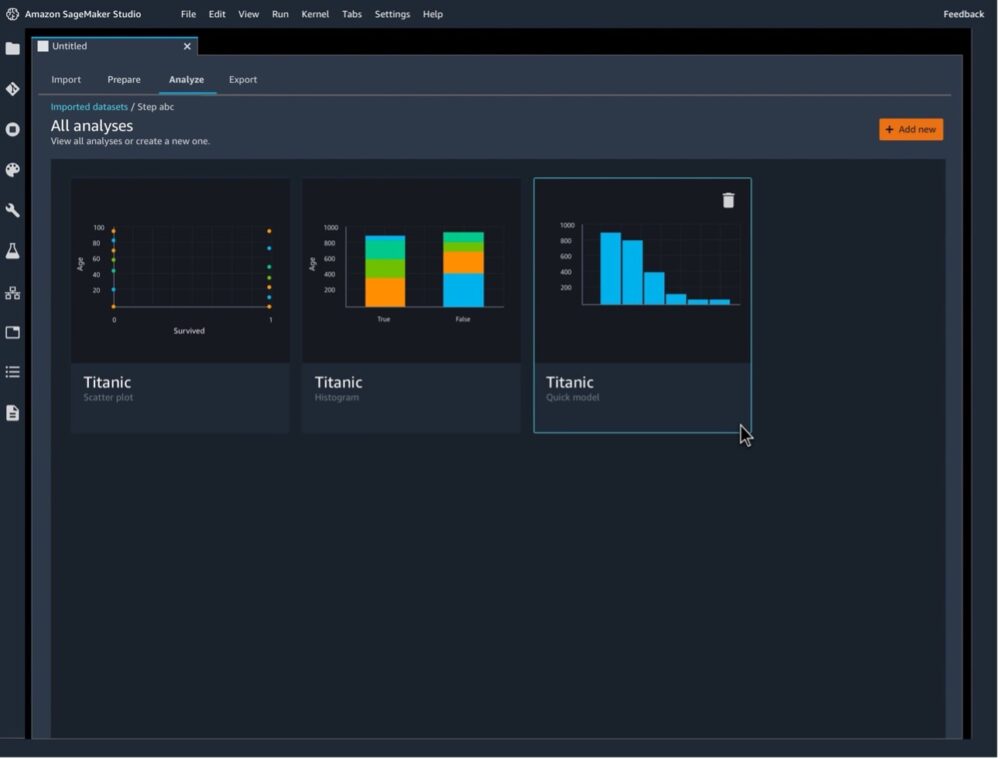

Visualisering

Data Wrangler hjælper dig med at forstå dine data og identificere potentielle fejl og ekstreme værdier med et sæt robuste prækonfigurerede visualiseringsskabeloner. Du behøver ikke at kende eller bruge ekstra tid på at importere eksterne biblioteker eller afhængigheder for at udføre visualiseringerne. Histogrammer, punktplot, boks- og whiskerplot, linjeplot og søjlediagrammer er alle tilgængelige (se de følgende skærmbilleder for nogle eksempler). Skabeloner såsom histogrammer gør det nemt at oprette og redigere dine egne visualiseringer uden at skrive kode.

Validering

Data Wrangler giver dig mulighed for hurtigt at identificere uoverensstemmelser i dit dataforberedelsesworkflow og diagnosticere problemer, før modeller implementeres i produktion (se følgende skærmbillede). Du kan hurtigt identificere, om dine forberedte data vil resultere i en nøjagtig model, så du kan afgøre, om der er behov for yderligere funktionsteknik for at forbedre ydeevnen. Alt dette sker før modelopbygningsfasen, så der er ingen ekstra arbejdsomkostninger for at bygge en model, der ikke yder som forventet (mål for lav ydeevne), hvilket ville resultere i yderligere transformationer efter modelopbygningen. Valideringen resulterer også i den forretningsmæssige fordel ved funktioner af bedre kvalitet.

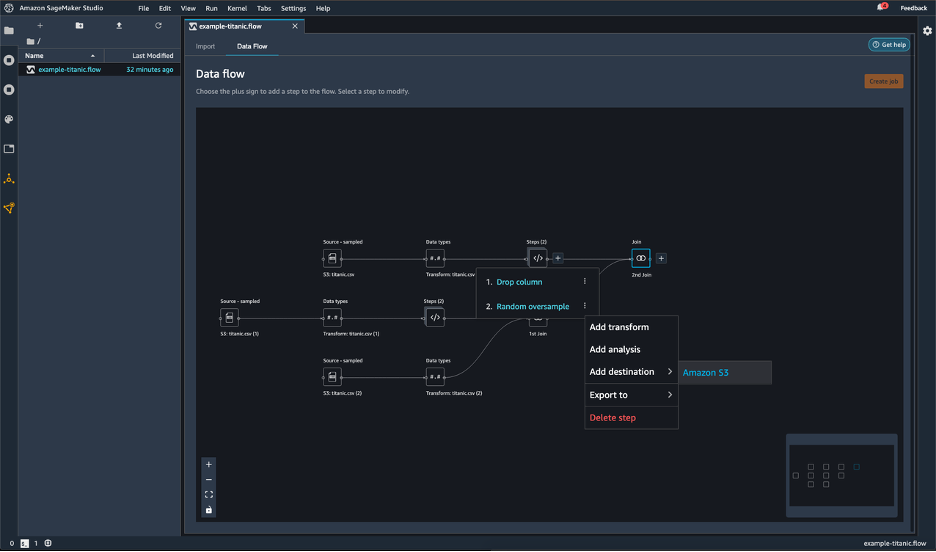

Byg skalerbare dataforberedelsespipelines

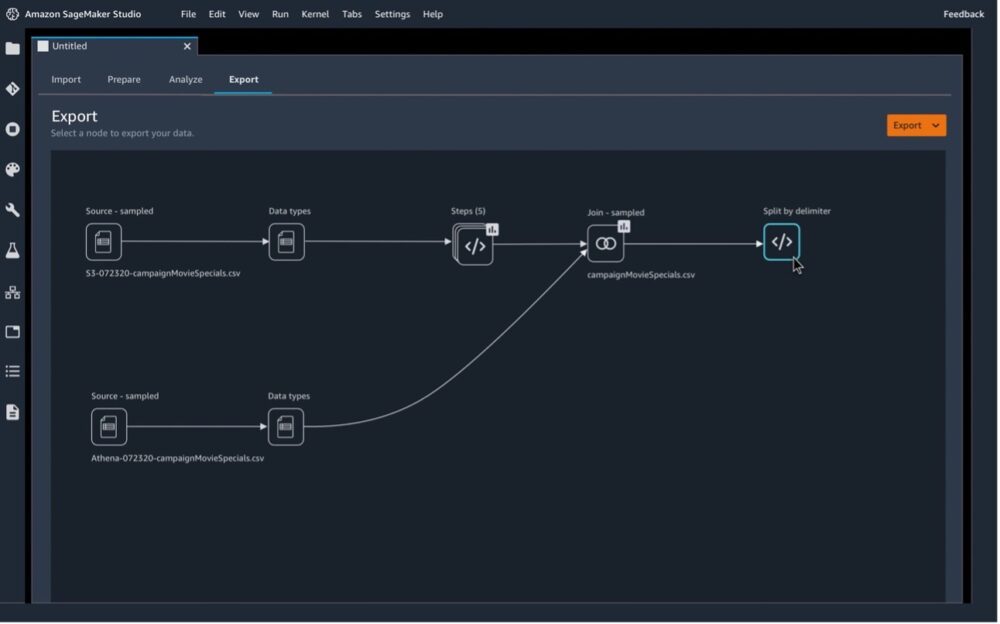

Når du udfører EDA, skal du bygge dataforberedelsespipelines, der kan skaleres med datasæt (se følgende skærmbillede). Dette er vigtigt for gentagelse såvel som downstream ML processer. Typisk bruger kunder Spark på grund af dets distribuerede, skalerbare og in-memory-behandlingsnatur; dette kræver dog en masse ekspertise på Spark. Opsætning af et Spark-miljø er tidskrævende og kræver ekspertise for optimal konfiguration. Med Data Wrangler kan du oprette databehandlingsjob og eksportere til Amazon S3 og Amazon feature store udelukkende via den visuelle grænseflade uden at skulle generere, køre eller administrere Jupyter notebooks, hvilket letter skalerbare dataforberedelsespipelines uden nogen Spark-ekspertise. For mere information, se Start behandlingsjob med nogle få klik ved hjælp af Amazon SageMaker Data Wrangler.

Driftsomkostninger

Integration er muligvis ikke en direkte omkostningsfordel; der er dog indirekte omkostningsfordele, når du arbejder i et integreret miljø som SageMaker. Fordi Data Wrangler er integreret med AWS-tjenester, kan du eksportere dit dataforberedelsesarbejdsgang til en Data Wrangler-jobnotesbog og starte Amazon SageMaker Autopilot træningseksperiment, Amazon SageMaker Pipelines notesbog eller kodescript. Du kan også oprette et Data Wrangler-behandlingsjob med et enkelt klik uden at skulle konfigurere og administrere infrastruktur for at udføre gentagne trin eller automatisering i en ML-arbejdsgang.

I dit Data Wrangler-flow kan du eksport nogle eller alle de transformationer, du har foretaget til dine databehandlingspipelines. Når du eksporterer dit dataflow, bliver du opkrævet for de AWS-ressourcer, du bruger. Fra et omkostningsperspektiv giver eksport af transformationen dig mulighed for at gentage transformationen på yderligere datasæt uden trinvis indsats.

Med Data Wrangler kan du eksportere alle de transformationer, du har lavet til et datasæt, til en destinationsknude med blot et par klik. Dette giver dig mulighed for at oprette databehandlingsjob og eksportere til Amazon S3 rent via den visuelle grænseflade uden at skulle generere, køre eller administrere Jupyter-notebooks, og derved forbedre oplevelsen med lav kode.

Data Wrangler giver dig mulighed for at eksportere dine dataforberedelsestrin eller dataflow til forskellige miljøer. Data Wrangler har problemfri integration med andre AWS-tjenester og funktioner, såsom følgende:

- SageMaker Feature Store – Du kan konstruere dine modelfunktioner ved hjælp af Data Wrangler og derefter indtage i din featurebutik, som er et centraliseret lager for funktioner og deres tilknyttede metadata

- SageMaker Pipelines – Du kan bruge datastrømmen eksporteret fra Data Wrangler i SageMaker-pipelines, som bruges til at bygge og implementere store ML-arbejdsgange

- Amazon S3 – Du kan eksportere dataene til Amazon S3 og bruge dem til at oprette Data Wrangler-job

- Python – Endelig kan du eksportere alle trinene i dit dataflow til en Python-fil, som du manuelt kan integrere i ethvert databehandlings-workflow.

En sådan tæt integration hjælper med at reducere indsats, tid, ekspertise og omkostninger.

Bedste praksis for omkostningsoptimering

I dette afsnit diskuterer vi bedste praksis for yderligere at optimere omkostningerne i Data Wrangler.

Opdater Data Wrangler til den seneste udgivelse

Når du opdater Data Wrangler til den seneste udgivelse får du alle de nyeste funktioner, sikkerhed og overordnede optimeringer til Data Wrangler, hvilket kan forbedre dets omkostningseffektivitet.

Brug indbyggede Data Wrangler-transformere

Brug de indbyggede Data Wrangler-transformere over brugerdefinerede Pandas-transformationer, når du behandler større og bredere datasæt.

Vælg den rigtige instanstype til dit Data Wrangler-flow

Der er to familier af ml-instanstyper, der understøttes af Data Wrangler: m5 og r5. m5-instanser er instanser til generelle formål, der giver en balance mellem computer og hukommelse, hvorimod r5-instanser er designet til at levere hurtig ydeevne til at behandle store datasæt i hukommelsen.

Vi anbefaler, at du vælger en instans, der er bedst optimeret omkring dine arbejdsbelastninger. For eksempel kan r5.8xlarge have en højere pris end m5.4xlarge, men r5.8xlarge kan være bedre optimeret til dine arbejdsbelastninger. Med bedre optimerede forekomster kan du køre dine datastrømme på kortere tid til lavere omkostninger.

Behandle større og bredere datasæt

For datasæt større end snesevis af gigabyte anbefaler vi at bruge indbyggede transformationer eller prøvedata ved import for at køre tilpassede Pandas-transformationer interaktivt. I den indlæg, deler vi vores resultater fra to benchmark-tests for at demonstrere, hvordan man gør dette.

Luk ubrugte forekomster ned

Du debiteres for alle kørende tilfælde. For at undgå at pådrage sig yderligere gebyrer skal du lukke de forekomster, du ikke bruger manuelt. For at lukke en instans, der kører, skal du udføre følgende trin:

- På din dataflowside skal du vælge forekomstikonet i navigationsruden under Kørende forekomster.

- Vælg Luk ned.

Hvis du lukker en instans, der bruges til at køre et flow, ned, kan du ikke få adgang til flowet midlertidigt. Hvis du får en fejl under åbning af flowet, der kører en instans, du tidligere har lukket ned, skal du vente i cirka 5 minutter og prøve at åbne den igen.

Når du ikke bruger Data Wrangler, er det vigtigt at lukke den instans, den kører på, for at undgå at pådrage sig yderligere gebyrer. For mere information, se Sluk Data Wrangler.

For oplysninger om automatisk lukning af Data Wrangler-ressourcer, se Spar omkostninger ved automatisk at lukke ledige ressourcer i Amazon SageMaker Studio.

eksport

Når du eksporterer dit Data Wrangler-flow eller -transformationer, kan du bruge omkostningsfordelingstags til at organisere og administrere omkostningerne ved disse ressourcer. Du opretter disse tags til din brugerprofil, og Data Wrangler anvender dem automatisk på de ressourcer, der bruges til at eksportere datastrømmen. For mere information, se Brug af omkostningsfordelingstags.

Priser

Data Wrangler-priser har tre komponenter: Data Wrangler-forekomster, Data Wrangler-job og ML-lagring. Du kan udføre alle trinene til EDA eller dataforberedelse i Data Wrangler, og du betaler for forekomsten, jobs og lagerpriser baseret på forbrug eller forbrug, uden forudgående gebyrer eller licensgebyrer. For mere information, se On-Demand-priser.

Konklusion

I dette indlæg gennemgik vi forskellige omkostningsaspekter af EDA og dataforberedelse for at opdage, hvordan funktionsrige og integrerede Data Wrangler reducerer den tid, det tager at samle og forberede data til ML-brugssager fra uger til minutter, og derved letter omkostningseffektiv dataforberedelse for ML. Vi inspicerede også prissætningskomponenterne i Data Wrangler og bedste praksis for omkostningsoptimering ved brug af Data Wrangler til dine ML-dataforberedelseskrav.

For mere information, se følgende ressourcer:

Om forfatterne

Rajakumar Sampathkumar er en Principal Technical Account Manager hos AWS, der yder kundevejledning om justering af forretningsteknologi og understøtter genopfindelsen af deres cloud-driftsmodeller og -processer. Han brænder for cloud og machine learning. Raj er også maskinlæringsspecialist og arbejder med AWS-kunder for at designe, implementere og administrere deres AWS-arbejdsbelastninger og -arkitekturer.

Rajakumar Sampathkumar er en Principal Technical Account Manager hos AWS, der yder kundevejledning om justering af forretningsteknologi og understøtter genopfindelsen af deres cloud-driftsmodeller og -processer. Han brænder for cloud og machine learning. Raj er også maskinlæringsspecialist og arbejder med AWS-kunder for at designe, implementere og administrere deres AWS-arbejdsbelastninger og -arkitekturer.

Rahul Nabera er dataanalysekonsulent i AWS Professional Services. Hans nuværende arbejde fokuserer på at gøre det muligt for kunder at opbygge deres data- og maskinlærings-arbejdsbelastninger på AWS. I sin fritid nyder han at spille cricket og volleyball.

Rahul Nabera er dataanalysekonsulent i AWS Professional Services. Hans nuværende arbejde fokuserer på at gøre det muligt for kunder at opbygge deres data- og maskinlærings-arbejdsbelastninger på AWS. I sin fritid nyder han at spille cricket og volleyball.

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- bedste praksis

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- zephyrnet