Store sprogmodeller (LLM'er) har fanget fantasien og opmærksomheden hos udviklere, videnskabsmænd, teknologer, iværksættere og ledere på tværs af flere brancher. Disse modeller kan bruges til besvarelse af spørgsmål, opsummering, oversættelse og mere i applikationer såsom samtaleagenter til kundesupport, indholdsoprettelse til marketing og kodningsassistenter.

For nylig udgav Meta Lama 2 for både forskere og kommercielle enheder, tilføjelse til listen over andre LLM'er, herunder MosaicML MPT , Falcon. I dette indlæg gennemgår vi, hvordan du finjusterer Llama 2 på AWS Trainium, en specialbygget accelerator til LLM-træning, for at reducere træningstider og omkostninger. Vi gennemgår de finjusterende scripts leveret af AWS Neuron SDK (ved hjælp af NeMo Megatron-LM), de forskellige konfigurationer, vi brugte, og de gennemløbsresultater, vi så.

Om Llama 2-modellen

Svarende til den forrige Lama 1 model og andre modeller som GPT, Llama 2 bruger transformatorens dekoder-only-arkitektur. Det kommer i tre størrelser: 7 milliarder, 13 milliarder og 70 milliarder parametre. Sammenlignet med Llama 1 fordobler Llama 2 kontekstlængden fra 2,000 til 4,000 og bruger opmærksomhed på grupperet forespørgsel (kun for 70B). Llama 2 fortrænede modeller er trænet på 2 billioner tokens, og dens finjusterede modeller er blevet trænet på over 1 million menneskelige annotationer.

Distribueret træning af Llama 2

For at imødekomme Llama 2 med 2,000 og 4,000 sekvenslængder implementerede vi scriptet vha. NeMo Megatron til Trainium, der understøtter dataparallelisme (DP), tensorparallelisme (TP) og pipelineparallelisme (PP). For at være specifik, med den nye implementering af nogle funktioner såsom untie word-indlejring, roterende indlejring, RMSNorm og Swiglu-aktivering, bruger vi det generiske script af GPT Neuron Megatron-LM for at understøtte Llama 2-træningsscriptet.

Vores træningsprocedure på højt niveau er som følger: til vores træningsmiljø bruger vi en multi-instans klynge, der administreres af SLURM-systemet til distribueret træning og planlægning under NeMo-rammen.

Først skal du downloade Llama 2-modellen og træningsdatasættene og forbehandle dem ved hjælp af Llama 2-tokenizeren. For at bruge RedPajama-datasættet skal du f.eks. bruge følgende kommando:

For detaljeret vejledning om download af modeller og argumentet for forbehandlingsscriptet henvises til Download LlamaV2-datasæt og tokenizer.

Dernæst kompiler du modellen:

Når modellen er kompileret, skal du starte træningsjobbet med følgende script, der allerede er optimeret med den bedste konfiguration og hyperparametre for Llama 2 (inkluderet i eksempelkoden):

Til sidst overvåger vi TensorBoard for at holde styr på træningsfremskridt:

For den komplette eksempelkode og scripts, vi nævnte, henvises til Llama 7B tutorial , NeMo kode i Neuron SDK for at gennemgå mere detaljerede trin.

Finjustering af eksperimenter

Vi finjusterede 7B-modellen på OSCAR (Open Super-large Crawled ALMAnaCH coRpus) og QNLI (Question-answering NLI) datasæt i et Neuron 2.12-miljø (PyTorch). For hver 2,000 og 4,000 sekvenslængde optimerede vi nogle konfigurationer, som f.eks. batchsize , gradient_accumulation, for træningseffektivitet. Som en finjusteringsstrategi indførte vi fuld finjustering af alle parametre (ca. 500 trin), som kan udvides til fortræning med længere trin og større datasæt (for eksempel 1T RedPajama). Sekvensparallelisme kan også aktiveres for at give NeMo Megatron mulighed for at finjustere modeller med en større sekvenslængde på 4,000. Følgende tabel viser konfigurations- og gennemløbsresultaterne af Llama 7B-finjusteringseksperimentet. Gennemløbet skaleres næsten lineært, når antallet af forekomster stiger op til 4.

| Distribueret bibliotek | datasæt | Sekvenslængde | Antal forekomster | Tensor parallel | Data parallel | Rørledning Parellel | Global batchstørrelse | Gennemløb (sek./s) |

| Neuron NeMo Megatron | OSCAR | 4096 | 1 | 8 | 4 | 1 | 256 | 3.7 |

| . | . | 4096 | 2 | 8 | 4 | 1 | 256 | 7.4 |

| . | . | 4096 | 4 | 8 | 4 | 1 | 256 | 14.6 |

| . | QNLI | 4096 | 4 | 8 | 4 | 1 | 256 | 14.1 |

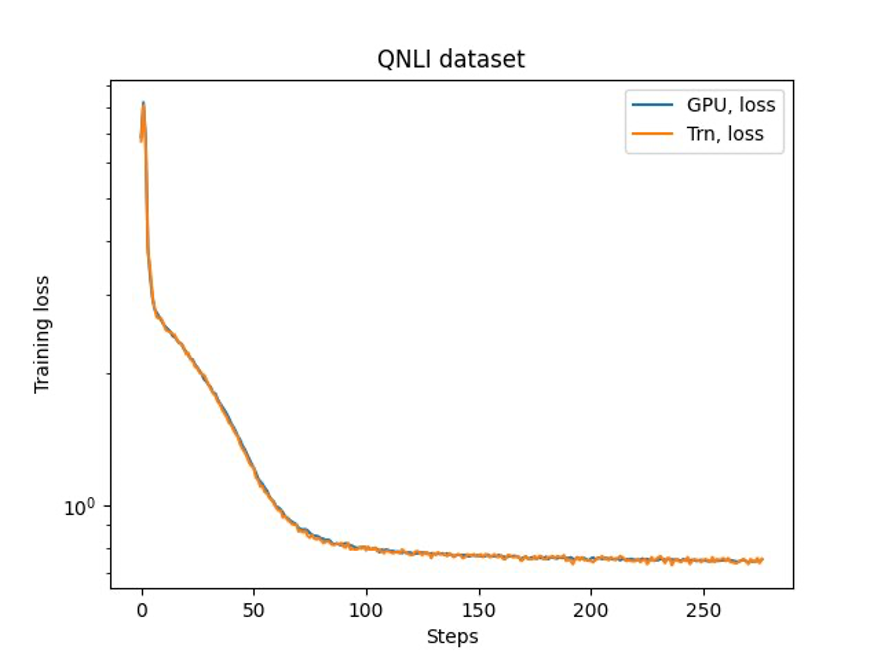

Det sidste trin er at verificere nøjagtigheden med basismodellen. Vi implementerede et referencescript til GPU-eksperimenter og bekræftede, at træningskurverne for GPU og Trainium matchede som vist i den følgende figur. Figuren illustrerer tabskurver over antallet af træningstrin på QNLI-datasættet. Blandet præcision blev vedtaget for GPU (blå) og bf16 med standard stokastisk afrunding for Trainium (orange).

Konklusion

I dette indlæg viste vi, at Trainium leverer høj ydeevne og omkostningseffektiv finjustering af Llama 2. For flere ressourcer til at bruge Trainium til distribueret fortræning og finjustering af dine generative AI-modeller ved hjælp af NeMo Megatron, se AWS Neuron Reference for NeMo Megatron.

Om forfatterne

Hao Zhou er forsker hos Amazon SageMaker. Før det arbejdede han med at udvikle maskinlæringsmetoder til svindeldetektion til Amazon Fraud Detector. Han brænder for at anvende maskinlæring, optimering og generative AI-teknikker på forskellige problemer i den virkelige verden. Han har en PhD i elektroteknik fra Northwestern University.

Hao Zhou er forsker hos Amazon SageMaker. Før det arbejdede han med at udvikle maskinlæringsmetoder til svindeldetektion til Amazon Fraud Detector. Han brænder for at anvende maskinlæring, optimering og generative AI-teknikker på forskellige problemer i den virkelige verden. Han har en PhD i elektroteknik fra Northwestern University.

Karthick Gopalswamy er en anvendt videnskabsmand med AWS. Før AWS arbejdede han som videnskabsmand i Uber og Walmart Labs med stort fokus på optimering af blandet heltal. Hos Uber fokuserede han på at optimere det offentlige transportnetværk med on-demand SaaS-produkter og delte ture. Hos Walmart Labs arbejdede han med prissætning og pakningsoptimeringer. Karthick har en ph.d. i industri- og systemteknik med en bifag i driftsforskning fra North Carolina State University. Hans forskning fokuserer på modeller og metoder, der kombinerer operationsforskning og maskinlæring.

Karthick Gopalswamy er en anvendt videnskabsmand med AWS. Før AWS arbejdede han som videnskabsmand i Uber og Walmart Labs med stort fokus på optimering af blandet heltal. Hos Uber fokuserede han på at optimere det offentlige transportnetværk med on-demand SaaS-produkter og delte ture. Hos Walmart Labs arbejdede han med prissætning og pakningsoptimeringer. Karthick har en ph.d. i industri- og systemteknik med en bifag i driftsforskning fra North Carolina State University. Hans forskning fokuserer på modeller og metoder, der kombinerer operationsforskning og maskinlæring.

Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Xin Huang er en Senior Applied Scientist for Amazon SageMaker JumpStart og Amazon SageMaker indbyggede algoritmer. Han fokuserer på at udvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er inden for området naturlig sprogbehandling, forklarlig dyb læring på tabeldata og robust analyse af ikke-parametrisk rum-tid-klynger. Han har udgivet mange artikler i ACL, ICDM, KDD-konferencer og Royal Statistical Society: Series A.

Youngsuk Park er en Sr. Applied Scientist ved AWS Annapurna Labs, der arbejder på at udvikle og træne fundamentmodeller på AI-acceleratorer. Før det arbejdede Dr. Park på R&D for Amazon Forecast i AWS AI Labs som ledende videnskabsmand. Hans forskning ligger i samspillet mellem maskinlæring, grundlæggende modeller, optimering og forstærkningslæring. Han har udgivet over 20 peer-reviewede artikler på topsteder, herunder ICLR, ICML, AISTATS og KDD, med tjenesten til at organisere workshop og præsentere tutorials inden for tidsserier og LLM-træning. Før han kom til AWS, opnåede han en PhD i elektroteknik fra Stanford University.

Youngsuk Park er en Sr. Applied Scientist ved AWS Annapurna Labs, der arbejder på at udvikle og træne fundamentmodeller på AI-acceleratorer. Før det arbejdede Dr. Park på R&D for Amazon Forecast i AWS AI Labs som ledende videnskabsmand. Hans forskning ligger i samspillet mellem maskinlæring, grundlæggende modeller, optimering og forstærkningslæring. Han har udgivet over 20 peer-reviewede artikler på topsteder, herunder ICLR, ICML, AISTATS og KDD, med tjenesten til at organisere workshop og præsentere tutorials inden for tidsserier og LLM-træning. Før han kom til AWS, opnåede han en PhD i elektroteknik fra Stanford University.

Yida Wang er en ledende videnskabsmand i AWS AI-teamet hos Amazon. Hans forskningsinteresse er i systemer, højtydende computing og big data-analyse. Han arbejder i øjeblikket med deep learning-systemer med fokus på at kompilere og optimere deep learning-modeller til effektiv træning og inferens, især store fundamentmodeller. Missionen er at bygge bro mellem højniveaumodellerne fra forskellige rammer og hardwareplatforme på lavt niveau, herunder CPU'er, GPU'er og AI-acceleratorer, så forskellige modeller kan køre med høj ydeevne på forskellige enheder.

Yida Wang er en ledende videnskabsmand i AWS AI-teamet hos Amazon. Hans forskningsinteresse er i systemer, højtydende computing og big data-analyse. Han arbejder i øjeblikket med deep learning-systemer med fokus på at kompilere og optimere deep learning-modeller til effektiv træning og inferens, især store fundamentmodeller. Missionen er at bygge bro mellem højniveaumodellerne fra forskellige rammer og hardwareplatforme på lavt niveau, herunder CPU'er, GPU'er og AI-acceleratorer, så forskellige modeller kan køre med høj ydeevne på forskellige enheder.

Jun (Luke) Huan er Principal Scientist ved AWS AI Labs. Dr. Huan arbejder med kunstig intelligens og datavidenskab. Han har publiceret mere end 160 peer-reviewede artikler i førende konferencer og tidsskrifter og har dimitteret 11 ph.d.-studerende. Han var modtager af NSF Fakultetets Early Career Development Award i 2009. Før han kom til AWS, arbejdede han hos Baidu Research som en fremtrædende videnskabsmand og leder af Baidu Big Data Laboratory. Han grundlagde StylingAI Inc., en AI-start-up, og arbejdede som administrerende direktør og Chief Scientist i 2019-2021. Før han kom til branchen, var han professor i Charles E. og Mary Jane Spahr i EECS-afdelingen ved University of Kansas. Fra 2015-2018 arbejdede han som programdirektør hos den amerikanske NSF med ansvar for dets big data-program.

Jun (Luke) Huan er Principal Scientist ved AWS AI Labs. Dr. Huan arbejder med kunstig intelligens og datavidenskab. Han har publiceret mere end 160 peer-reviewede artikler i førende konferencer og tidsskrifter og har dimitteret 11 ph.d.-studerende. Han var modtager af NSF Fakultetets Early Career Development Award i 2009. Før han kom til AWS, arbejdede han hos Baidu Research som en fremtrædende videnskabsmand og leder af Baidu Big Data Laboratory. Han grundlagde StylingAI Inc., en AI-start-up, og arbejdede som administrerende direktør og Chief Scientist i 2019-2021. Før han kom til branchen, var han professor i Charles E. og Mary Jane Spahr i EECS-afdelingen ved University of Kansas. Fra 2015-2018 arbejdede han som programdirektør hos den amerikanske NSF med ansvar for dets big data-program.

Shruti Koparkar er Senior Product Marketing Manager hos AWS. Hun hjælper kunder med at udforske, evaluere og anvende Amazon EC2 accelereret computerinfrastruktur til deres maskinlæringsbehov.

Shruti Koparkar er Senior Product Marketing Manager hos AWS. Hun hjælper kunder med at udforske, evaluere og anvende Amazon EC2 accelereret computerinfrastruktur til deres maskinlæringsbehov.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/fast-and-cost-effective-llama-2-fine-tuning-with-aws-trainium/

- :har

- :er

- $OP

- 000

- 1

- 100

- 11

- 12

- 13

- 160

- 20

- 500

- 7

- 70

- 8

- a

- Om

- accelereret

- accelerator

- acceleratorer

- imødekomme

- nøjagtighed

- tværs

- Aktivering

- tilføje

- vedtage

- vedtaget

- midler

- AI

- AI modeller

- algoritmer

- Alle

- tillade

- næsten

- allerede

- også

- Amazon

- Amazon EC2

- Amazon prognose

- Amazon svindeldetektor

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- analyse

- analytics

- ,

- applikationer

- anvendt

- Anvendelse

- arkitektur

- ER

- OMRÅDE

- argument

- AS

- assistenter

- At

- opmærksomhed

- tildeling

- AWS

- Baidu

- bund

- BE

- været

- før

- BEDSTE

- mellem

- Big

- Big data

- Billion

- Blå

- både

- BRIDGE

- indbygget

- by

- CAN

- fanget

- Karriere

- Direktør

- afgift

- Charles

- chef

- Cluster

- klyngedannelse

- kode

- Kodning

- kombinerer

- kommer

- kommerciel

- sammenlignet

- fuldføre

- computing

- konferencer

- Konfiguration

- BEKRÆFTET

- indhold

- indholdsskabelse

- sammenhæng

- konversation

- omkostningseffektiv

- Omkostninger

- skabelse

- For øjeblikket

- skøger

- kunde

- Kunde support

- Kunder

- data

- Dataanalyse

- datalogi

- datasæt

- dyb

- dyb læring

- Standard

- leverer

- Afdeling

- detaljeret

- Detektion

- udviklere

- udvikling

- Udvikling

- Enheder

- forskellige

- Direktør

- Distinguished

- distribueret

- distribueret træning

- Doubles

- downloade

- dr

- e

- hver

- Tidligt

- effektivitet

- effektiv

- indlejring

- aktiveret

- Engineering

- enheder

- iværksættere

- Miljø

- især

- evaluere

- eksempel

- ledere

- eksperiment

- eksperimenter

- udforske

- FAST

- Funktionalitet

- Figur

- Fokus

- fokuserede

- fokuserer

- efter

- følger

- Til

- Forecast

- Foundation

- Grundlagt

- Framework

- rammer

- bedrageri

- bedrageri afsløring

- fra

- fuld

- generative

- Generativ AI

- GPU

- GPU'er

- vejledning

- Hardware

- Have

- he

- hoved

- hjælper

- Høj

- højt niveau

- Høj ydeevne

- hans

- besidder

- Hvordan

- How To

- HTML

- HTTPS

- menneskelig

- illustrerer

- fantasi

- implementering

- implementeret

- in

- Inc.

- medtaget

- Herunder

- Forøg

- industrielle

- industrier

- industrien

- Infrastruktur

- interesse

- interesser

- IT

- ITS

- jane

- Job

- sammenføjning

- jpg

- Kansas

- Holde

- laboratorium

- Labs

- Sprog

- storstilet

- større

- Efternavn

- lancere

- føre

- førende

- læring

- Længde

- ligger

- ligesom

- Liste

- Llama

- LLM

- længere

- off

- maskine

- machine learning

- større

- lykkedes

- leder

- mange

- Marketing

- matchede

- nævnte

- Meta

- metoder

- metoder

- million

- mindre

- Mission

- blandet

- model

- modeller

- Overvåg

- mere

- Natural

- Natural Language Processing

- behov

- netværk

- Ny

- Nord

- nord carolina

- NSF

- nummer

- Nvidia

- opnået

- of

- on

- On-Demand

- kun

- åbent

- Produktion

- optimering

- optimeret

- optimering

- Orange

- organisering

- Andet

- vores

- i løbet af

- papirer

- parametre

- Park

- lidenskabelige

- peer-reviewed

- ydeevne

- phd

- pipeline

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Indlæg

- tidligere

- prissætning

- Main

- Forud

- problemer

- procedure

- forarbejdning

- Produkt

- Produkter

- Professor

- Program

- Progress

- forudsat

- offentlige

- offentlig transit

- offentliggjort

- Python

- pytorch

- spørgsmål

- F & U

- virkelige verden

- reducere

- henvise

- frigivet

- forskning

- forskere

- Ressourcer

- Resultater

- gennemgå

- robust

- afrunding

- Royal

- Kør

- SaaS

- sagemaker

- så

- skalerbar

- skalaer

- planlægning

- Videnskab

- Videnskabsmand

- forskere

- script

- scripts

- SDK

- senior

- Sequence

- Series

- Serie A

- tjeneste

- Tjenester

- flere

- delt

- hun

- viste

- vist

- Shows

- størrelser

- So

- Samfund

- nogle

- specifikke

- Stanford

- Stanford University

- Opstart

- Tilstand

- statistiske

- Trin

- Steps

- Strategi

- Studerende

- Succesfuld

- sådan

- support

- Understøtter

- systemet

- Systemer

- bord

- hold

- teknikker

- teknologer

- end

- at

- Området

- deres

- Them

- Disse

- denne

- tre

- Gennem

- kapacitet

- tid

- Tidsserier

- gange

- til

- sammen

- Tokens

- top

- tp

- spor

- uddannet

- Kurser

- transit

- Oversættelse

- trillion

- tutorials

- Uber

- under

- universitet

- us

- brug

- anvendte

- bruger

- ved brug af

- forskellige

- handelssystemer

- verificere

- gå

- Walmart

- var

- we

- web

- webservices

- som

- med

- ord

- arbejdede

- arbejder

- virker

- værksted

- Din

- zephyrnet