Efterhånden som maskinlæring (ML) bliver mere og mere udbredt i en lang række brancher, oplever organisationer behovet for at træne og betjene et stort antal ML-modeller for at imødekomme deres kunders forskellige behov. Især for software as a service-udbydere (SaaS) er evnen til at træne og betjene tusindvis af modeller effektivt og omkostningseffektivt afgørende for at forblive konkurrencedygtig på et marked i hastig udvikling.

Træning og betjening af tusindvis af modeller kræver en robust og skalerbar infrastruktur, hvilket er hvor Amazon SageMaker kan hjælpe. SageMaker er en fuldt administreret platform, der gør det muligt for udviklere og dataforskere at bygge, træne og implementere ML-modeller hurtigt, samtidig med at det tilbyder de omkostningsbesparende fordele ved at bruge AWS Cloud-infrastrukturen.

I dette indlæg undersøger vi, hvordan du kan bruge SageMaker-funktioner, herunder Amazon SageMaker-behandling, SageMaker træningsjob og SageMaker multi-model endpoints (MME'er), for at træne og betjene tusindvis af modeller på en omkostningseffektiv måde. For at komme i gang med den beskrevne løsning kan du henvise til den medfølgende notesbog på GitHub.

Use case: Energiprognose

Til dette indlæg påtager vi os rollen som en ISV-virksomhed, der hjælper deres kunder med at blive mere bæredygtige ved at spore deres energiforbrug og levere prognoser. Vores virksomhed har 1,000 kunder, som ønsker at forstå deres energiforbrug bedre og træffe informerede beslutninger om, hvordan de kan reducere deres miljøpåvirkning. For at gøre dette bruger vi et syntetisk datasæt og træner en ML-model baseret på Profeten for hver kunde at lave energiforbrugsprognoser. Med SageMaker kan vi effektivt træne og betjene disse 1,000 modeller, hvilket giver vores kunder nøjagtige og handlingsrettede indsigter i deres energiforbrug.

Der er tre funktioner i det genererede datasæt:

- Kunde ID – Dette er et heltals-id for hver kunde, der spænder fra 0-999.

- tidsstempel – Dette er en dato/tidsværdi, der angiver det tidspunkt, hvor energiforbruget blev målt. Tidsstemplerne genereres tilfældigt mellem start- og slutdatoerne angivet i koden.

- forbrug – Dette er en flydende værdi, der angiver energiforbruget, målt i en eller anden vilkårlig enhed. Forbrugsværdierne er tilfældigt genereret mellem 0-1,000 med sinusformet sæsonudsving.

Løsningsoversigt

For effektivt at træne og betjene tusindvis af ML-modeller kan vi bruge følgende SageMaker-funktioner:

- SageMaker-behandling – SageMaker Processing er en fuldt administreret dataforberedelsestjeneste, der sætter dig i stand til at udføre databehandling og modelevalueringsopgaver på dine inputdata. Du kan bruge SageMaker Processing til at transformere rådata til det format, der er nødvendigt til træning og konklusioner, samt til at køre batch- og onlineevalueringer af dine modeller.

- SageMaker uddannelse job – Du kan bruge SageMaker træningsjob til at træne modeller på en række forskellige algoritmer og inputdatatyper og specificere de beregningsressourcer, der er nødvendige for træning.

- SageMaker MME'er – Multi-model endpoints giver dig mulighed for at hoste flere modeller på et enkelt slutpunkt, hvilket gør det nemt at betjene forudsigelser fra flere modeller ved hjælp af en enkelt API. SageMaker MME'er kan spare tid og ressourcer ved at reducere antallet af endepunkter, der er nødvendige for at betjene forudsigelser fra flere modeller. MME'er understøtter hosting af både CPU- og GPU-understøttede modeller. Bemærk, at i vores scenarie bruger vi 1,000 modeller, men dette er ikke en begrænsning af selve tjenesten.

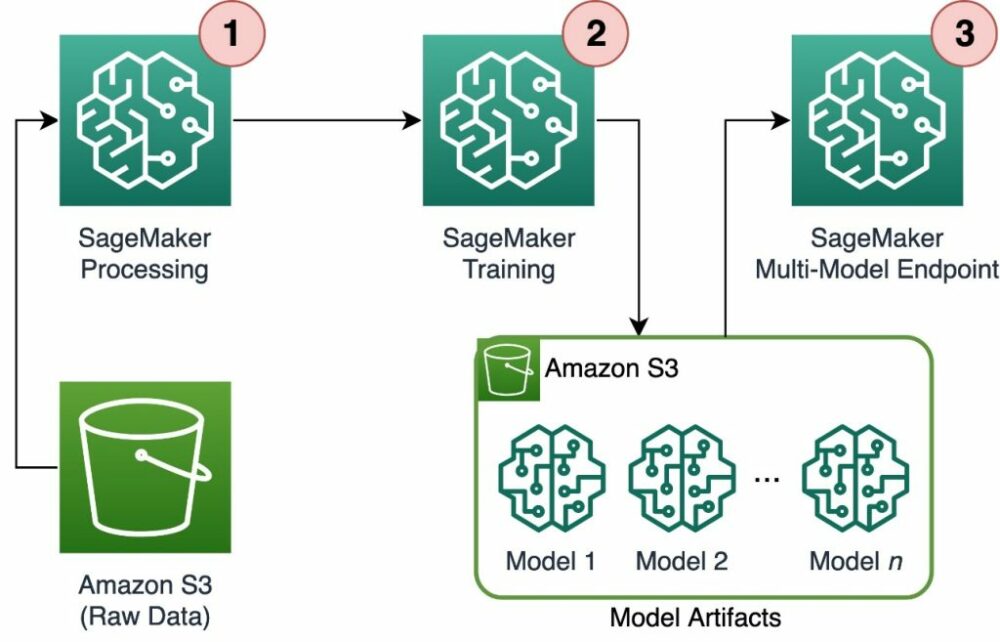

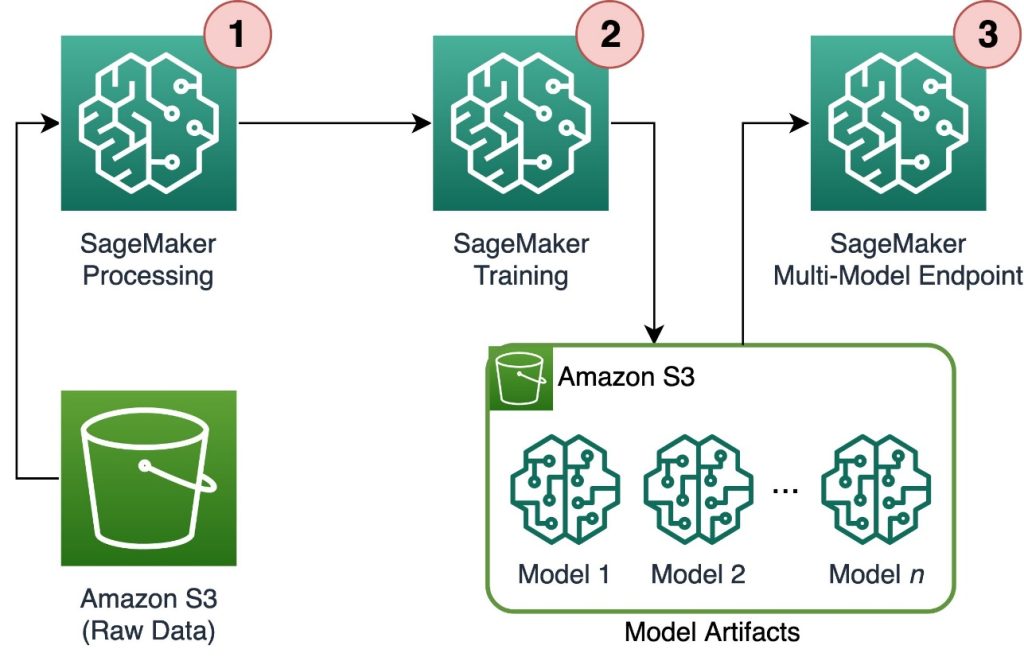

Følgende diagram illustrerer løsningsarkitekturen.

Arbejdsgangen omfatter følgende trin:

- Vi bruger SageMaker Processing til at forbehandle data og oprette en enkelt CSV-fil pr. kunde og gemme den i Amazon Simple Storage Service (Amazon S3).

- SageMaker-træningsjobbet er konfigureret til at læse output fra SageMaker Processing-jobbet og distribuere det på en round-robin-måde til træningsforekomsterne. Bemærk at dette også kan opnås med Amazon SageMaker Pipelines.

- Modelartefakterne gemmes i Amazon S3 af træningsjobbet og serveres direkte fra SageMaker MME.

Skaler træning til tusindvis af modeller

Det er muligt at skalere træningen af tusindvis af modeller via distribution parameter for Træningsinput klasse i SageMaker Python SDK, som giver dig mulighed for at angive, hvordan data fordeles på tværs af flere træningsinstanser for et træningsjob. Der er tre muligheder for distribution parameter: FullyReplicated, ShardedByS3Keyog ShardedByRecord. Det ShardedByS3Key option betyder, at træningsdataene sønderdeles af S3-objektnøgle, hvor hver træningsinstans modtager en unik delmængde af dataene, hvilket undgår duplikering. Efter at dataene er kopieret af SageMaker til træningscontainerne, kan vi læse mappe- og filstrukturen for at træne en unik model pr. kundefil. Følgende er et eksempel på et kodestykke:

Hvert SageMaker træningsjob gemmer den model, der er gemt i /opt/ml/model mappe af træningsbeholderen, før den arkiveres i en model.tar.gz fil, og uploader den derefter til Amazon S3, når træningsjob er afsluttet. Superbrugere kan også automatisere denne proces med SageMaker Pipelines. Når du opbevarer flere modeller via samme træningsjob, opretter SageMaker en enkelt model.tar.gz fil, der indeholder alle de trænede modeller. Det ville så betyde, at vi for at kunne betjene modellen først skulle pakke arkivet ud. For at undgå dette bruger vi checkpoints for at gemme de enkelte modellers tilstand. SageMaker giver funktionaliteten til at kopiere kontrolpunkter, der er oprettet under træningsjobbet, til Amazon S3. Her skal kontrolpunkterne gemmes på en forudbestemt placering, hvor standarden er /opt/ml/checkpoints. Disse kontrolpunkter kan bruges til at genoptage træningen på et senere tidspunkt eller som en model til at implementere på et slutpunkt. For en oversigt på højt niveau af, hvordan SageMaker-træningsplatformen administrerer lagringsstier til træningsdatasæt, modelartefakter, kontrolpunkter og output mellem AWS Cloud-lagring og træningsjob i SageMaker, se Amazon SageMaker Training Storage Mapper til træningsdatasæt, kontrolpunkter, modelartefakter og output.

Følgende kode bruger en fiktiv model.save() funktion inde i train.py script, der indeholder træningslogikken:

Skaler inferens til tusindvis af modeller med SageMaker MME'er

SageMaker MME'er giver dig mulighed for at betjene flere modeller på samme tid ved at oprette en slutpunktskonfiguration, der inkluderer en liste over alle modeller, der skal betjenes, og derefter oprette et slutpunkt ved hjælp af denne slutpunktskonfiguration. Der er ingen grund til at geninstallere endepunktet, hver gang du tilføjer en ny model, fordi endepunktet automatisk vil betjene alle modeller, der er gemt i de angivne S3-stier. Dette opnås med Multi Model Server (MMS), en open source-ramme til at betjene ML-modeller, der kan installeres i containere for at give den frontend, der opfylder kravene til de nye MME container API'er. Derudover kan du bruge andre modelservere, herunder TorchServe , Triton. MMS kan installeres i din brugerdefinerede container via SageMaker Inference Toolkit. For at lære mere om, hvordan du konfigurerer din Dockerfile til at inkludere MMS og bruge den til at betjene dine modeller, se Byg din egen container til SageMaker Multi-Model Endpoints.

Følgende kodestykke viser, hvordan man opretter en MME ved hjælp af SageMaker Python SDK:

Når MME'en er live, kan vi påberåbe den for at generere forudsigelser. Påkald kan udføres i enhver AWS SDK såvel som med SageMaker Python SDK, som vist i følgende kodestykke:

Når man kalder en model, indlæses modellen i første omgang fra Amazon S3 på instansen, hvilket kan resultere i en koldstart, når man kalder en ny model. Hyppigt brugte modeller cachelagres i hukommelsen og på disken for at give slutninger med lav latens.

Konklusion

SageMaker er en kraftfuld og omkostningseffektiv platform til træning og betjening af tusindvis af ML-modeller. Dens funktioner, herunder SageMaker Processing, træningsjob og MME'er, gør det muligt for organisationer effektivt at træne og betjene tusindvis af modeller i stor skala, samtidig med at de drager fordel af de omkostningsbesparende fordele ved at bruge AWS Cloud-infrastrukturen. For at lære mere om, hvordan du bruger SageMaker til træning og servering af tusindvis af modeller, se Behandle data, Træn en model med Amazon SageMaker , Vær vært for flere modeller i én container bag ét slutpunkt.

Om forfatterne

Davide Gallitelli er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i Bruxelles og arbejder tæt sammen med kunder i hele Benelux. Han har været udvikler, siden han var meget ung, og begyndte at kode i en alder af 7. Han begyndte at lære AI/ML på universitetet, og er blevet forelsket i det siden da.

Davide Gallitelli er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i Bruxelles og arbejder tæt sammen med kunder i hele Benelux. Han har været udvikler, siden han var meget ung, og begyndte at kode i en alder af 7. Han begyndte at lære AI/ML på universitetet, og er blevet forelsket i det siden da.

Maurits de Groot er Solutions Architect hos Amazon Web Services, baseret i Amsterdam. Han kan lide at arbejde med maskinlæringsrelaterede emner og har en forkærlighed for startups. I sin fritid holder han af at stå på ski og spille squash.

Maurits de Groot er Solutions Architect hos Amazon Web Services, baseret i Amsterdam. Han kan lide at arbejde med maskinlæringsrelaterede emner og har en forkærlighed for startups. I sin fritid holder han af at stå på ski og spille squash.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Automotive/elbiler, Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- BlockOffsets. Modernisering af miljømæssig offset-ejerskab. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/scale-training-and-inference-of-thousands-of-ml-models-with-amazon-sagemaker/

- :har

- :er

- :ikke

- :hvor

- 000

- 000 kunder

- 1

- 10

- 100

- 12

- 15 %

- 20

- 7

- a

- evne

- Om

- præcis

- opnået

- tværs

- tilføje

- Desuden

- fordele

- Efter

- alder

- AI / ML

- algoritmer

- Alle

- tillade

- tillader

- allerede

- også

- Amazon

- Amazon SageMaker

- Amazon Web Services

- amsterdam

- an

- ,

- enhver

- api

- API'er

- arkitektur

- Arkiv

- ER

- argument

- AS

- antage

- At

- automatisere

- automatisk

- undgå

- undgå

- AWS

- baseret

- BE

- fordi

- bliver

- bliver

- været

- før

- bag

- være

- gavn

- fordele

- Bedre

- mellem

- både

- Bruxelles

- bygge

- men

- by

- ringer

- CAN

- tilfælde

- klasse

- nøje

- Cloud

- sky infrastruktur

- Cloud Storage

- kode

- forkølelse

- selskab

- konkurrencedygtig

- færdiggørelse

- Compute

- Konfiguration

- konfigureret

- forbrug

- Container

- Beholdere

- omkostningseffektiv

- skabe

- oprettet

- skaber

- Oprettelse af

- afgørende

- skik

- kunde

- Kunder

- data

- Dataforberedelse

- databehandling

- datasæt

- Datoer

- afgørelser

- Standard

- definere

- definition

- indsætte

- beskrevet

- Udvikler

- udviklere

- direkte

- displays

- distribuere

- distribueret

- forskelligartede

- do

- færdig

- i løbet af

- hver

- let

- effektivt

- EMEA

- muliggøre

- muliggør

- ende

- Endpoint

- energi

- Energiforbrug

- miljømæssige

- evaluering

- evalueringer

- Hver

- udviklende

- eksempel

- udforske

- Fallen

- Mode

- Funktionalitet

- File (Felt)

- Filer

- finde

- Fornavn

- Flyde

- efter

- Til

- Til opstart

- prognoser

- format

- Framework

- hyppigt

- fra

- forsiden

- forreste ende

- fuldt ud

- funktion

- funktionalitet

- generere

- genereret

- få

- GitHub

- he

- hjælpe

- hjælper

- link.

- højt niveau

- hans

- host

- Hosting

- Hvordan

- How To

- HTML

- http

- HTTPS

- identifikator

- illustrerer

- KIMOs Succeshistorier

- importere

- in

- omfatter

- omfatter

- Herunder

- stigende

- angiver

- individuel

- industrier

- informeret

- Infrastruktur

- i første omgang

- indgang

- indgange

- indvendig

- indsigt

- installeret

- instans

- ind

- IT

- ITS

- selv

- Job

- Karriere

- jpg

- json

- Nøgle

- stor

- senere

- LÆR

- læring

- synes godt om

- begrænsning

- Liste

- leve

- lokalt

- placering

- logik

- kærlighed

- maskine

- machine learning

- lave

- maerker

- lykkedes

- administrerer

- Marked

- betyde

- midler

- Mød

- Hukommelse

- ML

- model

- modeller

- øjeblik

- mere

- flere

- navn

- Behov

- behov

- behov

- Ny

- ingen

- notesbog

- nummer

- numre

- objekt

- of

- tilbyde

- on

- ONE

- online

- open source

- Option

- Indstillinger

- or

- ordrer

- organisationer

- OS

- Andet

- vores

- Vores firma

- ud

- output

- egen

- parameter

- særlig

- passerer

- sti

- per

- Udfør

- periode

- billede

- perron

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- mulig

- Indlæg

- magt

- vigtigste

- Forudsigelser

- Predictor

- forberedelse

- fremherskende

- behandle

- forarbejdning

- give

- udbydere

- giver

- leverer

- Python

- hurtigt

- tilfældigt genereret

- rækkevidde

- spænder

- hurtigt

- Raw

- Læs

- realtid

- modtagende

- reducere

- reducere

- region

- Krav

- Kræver

- Ressourcer

- resultere

- Genoptag

- robust

- roller

- Kør

- SaaS

- sagemaker

- SageMaker Pipelines

- samme

- Gem

- skalerbar

- Scale

- scenarie

- forskere

- SDK

- tjener

- Servere

- tjeneste

- Tjenester

- servering

- sæt

- brudt

- vist

- Shows

- Simpelt

- siden

- enkelt

- uddrag

- Software

- software som en tjeneste

- løsninger

- Løsninger

- nogle

- specialist

- specificeret

- starte

- påbegyndt

- Starter

- Nystartede

- Tilstand

- Steps

- opbevaring

- butik

- opbevaret

- forhandler

- lagring

- struktur

- RESUMÉ

- support

- bæredygtig

- syntetisk

- mål

- opgaver

- at

- Staten

- deres

- derefter

- Der.

- Disse

- denne

- tusinder

- tre

- hele

- tid

- til

- Emner

- Sporing

- Tog

- uddannet

- Kurser

- Transform

- typer

- forstå

- enestående

- enhed

- universitet

- på

- Brug

- brug

- anvendte

- brugere

- bruger

- ved brug af

- værdi

- Værdier

- række

- meget

- via

- W

- ønsker

- var

- Vej..

- we

- web

- webservices

- GODT

- hvornår

- som

- mens

- WHO

- bred

- Bred rækkevidde

- vilje

- med

- inden for

- Arbejde

- workflow

- virker

- ville

- Du

- unge

- Din

- zephyrnet