Med Vidensbaser for Amazon Bedrock, kan du sikkert tilslutte fundamentmodeller (FM'er) i Amazonas grundfjeld til din virksomhedsdata for Retrieval Augmented Generation (RAG). Adgang til yderligere data hjælper modellen med at generere mere relevante, kontekstspecifikke og nøjagtige svar uden at omskole FM'erne.

I dette indlæg diskuterer vi to nye funktioner i Knowledge Bases for Amazon Bedrock, der er specifikke for RetrieveAndGenerate API: konfigurering af det maksimale antal resultater og oprettelse af brugerdefinerede prompter med en videnbase-promptskabelon. Du kan nu vælge disse som forespørgselsmuligheder ved siden af søgetypen.

Oversigt og fordele ved nye funktioner

Muligheden for det maksimale antal resultater giver dig kontrol over antallet af søgeresultater, der skal hentes fra vektorlageret og sendes til FM'en for at generere svaret. Dette giver dig mulighed for at tilpasse mængden af baggrundsinformation til generering og giver derved mere kontekst til komplekse spørgsmål eller mindre til enklere spørgsmål. Det giver dig mulighed for at hente op til 100 resultater. Denne mulighed hjælper med at forbedre sandsynligheden for relevant kontekst og forbedrer derved nøjagtigheden og reducerer hallucinationen af det genererede svar.

Den brugerdefinerede videnbase-promptskabelon giver dig mulighed for at erstatte standardpromptskabelonen med din egen for at tilpasse den prompt, der sendes til modellen til generering af svar. Dette giver dig mulighed for at tilpasse tonen, outputformatet og adfærden for FM'en, når den svarer på en brugers spørgsmål. Med denne mulighed kan du finjustere terminologien, så den passer bedre til din branche eller dit domæne (såsom sundhedspleje eller juridisk). Derudover kan du tilføje brugerdefinerede instruktioner og eksempler, der er skræddersyet til dine specifikke arbejdsgange.

I de følgende afsnit forklarer vi, hvordan du kan bruge disse funktioner med enten AWS Management Console eller SDK.

Forudsætninger

For at følge disse eksempler skal du have en eksisterende videnbase. For instruktioner til at oprette en, se Skab en vidensbase.

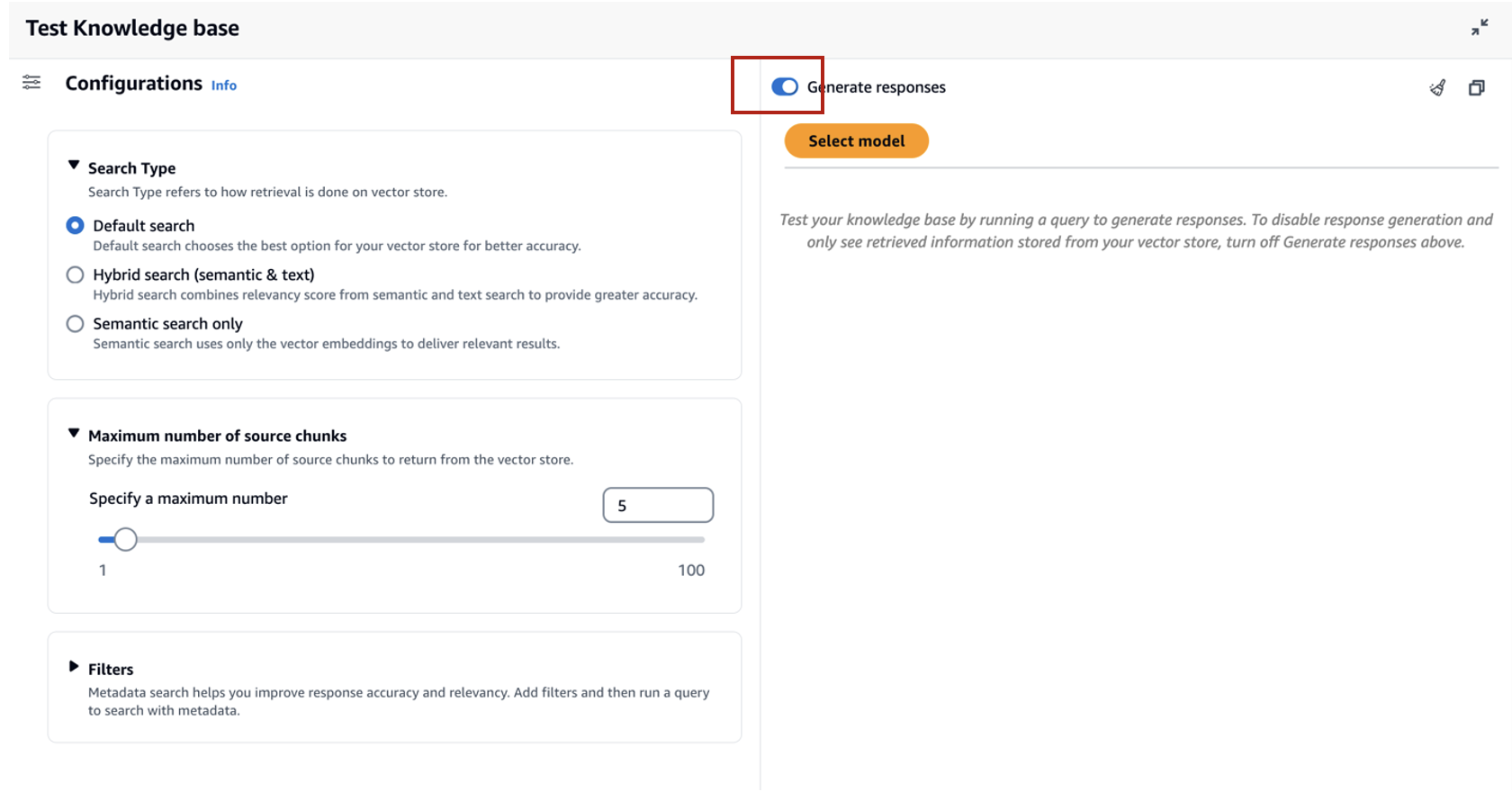

Konfigurer det maksimale antal resultater ved hjælp af konsollen

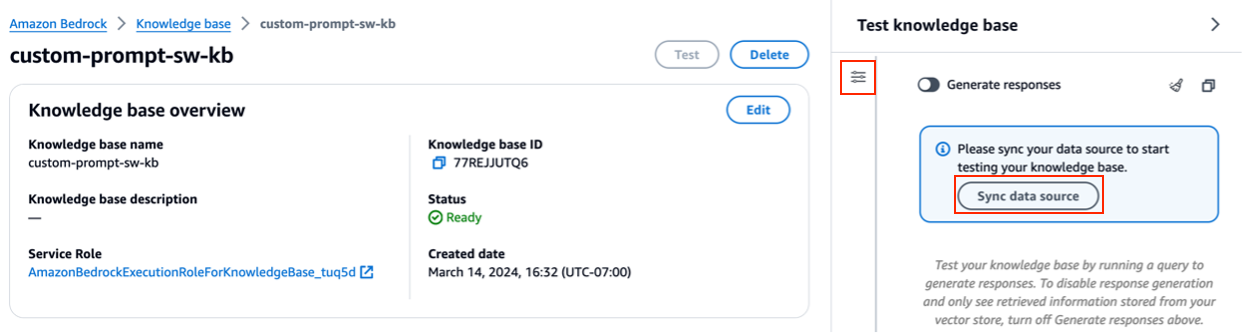

For at bruge indstillingen for det maksimale antal resultater ved hjælp af konsollen skal du udføre følgende trin:

- Vælg på Amazon Bedrock-konsollen Vidensgrundlag i venstre navigationsrude.

- Vælg den videnbase, du har oprettet.

- Vælg Test videnbase.

- Vælg konfigurationsikonet.

- Vælg Synkroniser datakilde før du begynder at teste din videnbase.

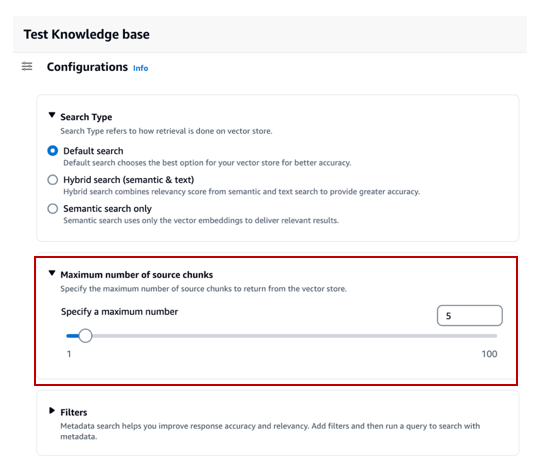

- Under Konfigurationer, For Søgetype, vælg en søgetype baseret på din brugssituation.

Til dette indlæg bruger vi hybridsøgning, fordi den kombinerer semantisk og tekstsøgning for at give større nøjagtighed. For at lære mere om hybridsøgning, se Vidensbaser til Amazon Bedrock understøtter nu hybridsøgning.

- Udvid Maksimalt antal kildebidder og indstil dit maksimale antal resultater.

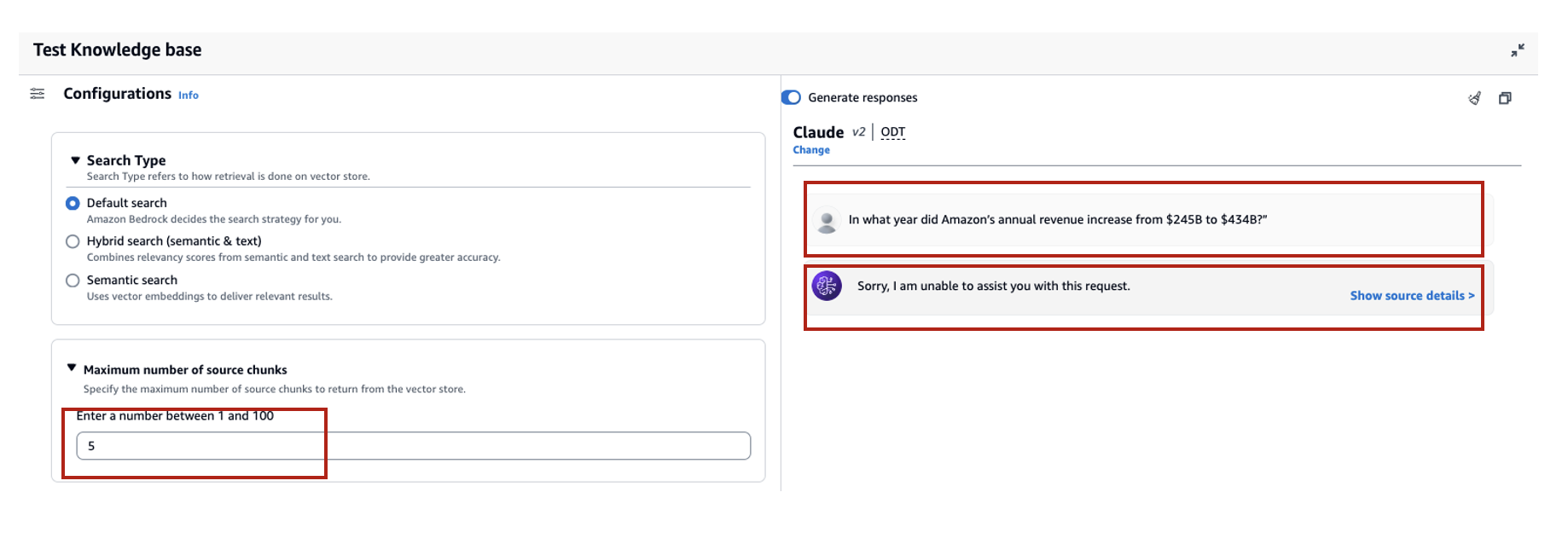

For at demonstrere værdien af den nye funktion viser vi eksempler på, hvordan du kan øge nøjagtigheden af det genererede svar. Vi brugte Amazon 10K-dokument for 2023 som kildedata til at skabe videnbasen. Vi bruger følgende forespørgsel til eksperimentering: "I hvilket år steg Amazons årlige omsætning fra $245B til $434B?"

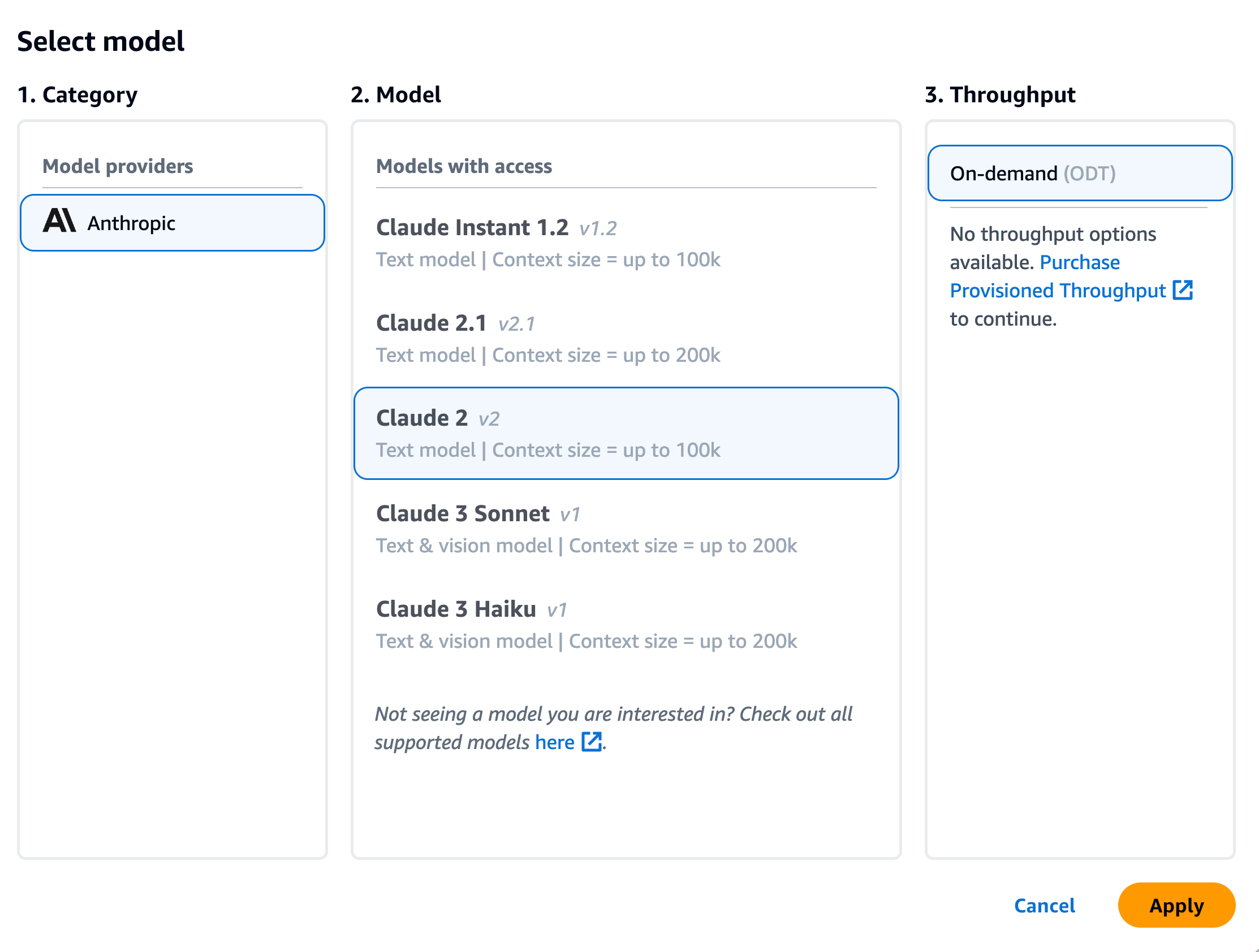

Det korrekte svar på denne forespørgsel er "Amazons årlige omsætning steg fra $245B i 2019 til $434B i 2022," baseret på dokumenterne i videnbasen. Vi brugte Claude v2 som FM til at generere det endelige svar baseret på den kontekstuelle information hentet fra videnbasen. Claude 3 Sonnet og Claude 3 Haiku er også understøttet som generation FM'er.

Vi kørte en anden forespørgsel for at demonstrere sammenligningen af hentning med forskellige konfigurationer. Vi brugte den samme inputforespørgsel ("I hvilket år steg Amazons årlige omsætning fra $245B til $434B?") og satte det maksimale antal resultater til 5.

Som vist på det følgende skærmbillede var det genererede svar "Beklager, jeg kan ikke hjælpe dig med denne anmodning."

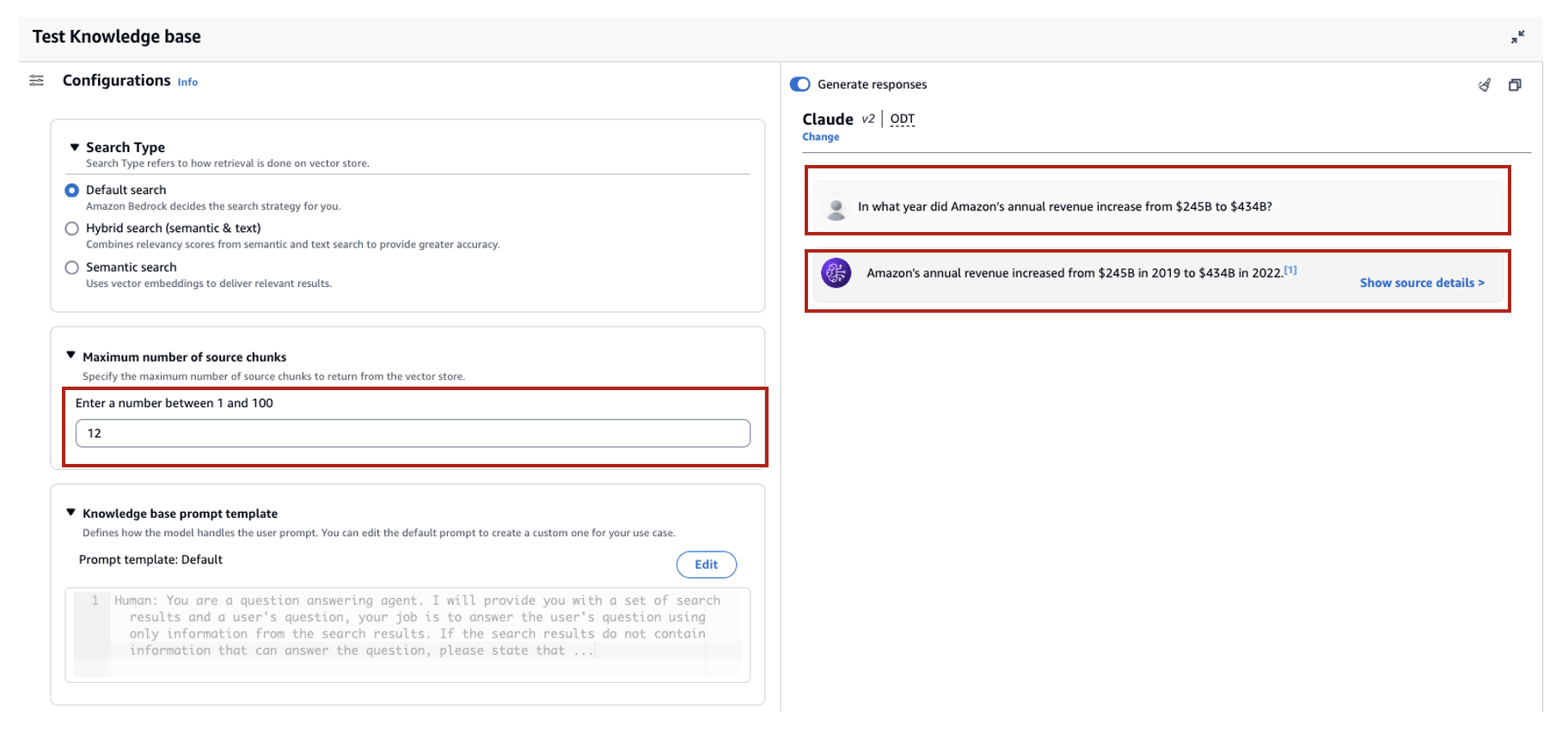

Dernæst sætter vi de maksimale resultater til 12 og stiller det samme spørgsmål. Det genererede svar er "Amazons årlige omsætningsstigning fra $245B i 2019 til $434B i 2022."

Som vist i dette eksempel er vi i stand til at hente det rigtige svar baseret på antallet af hentede resultater. Hvis du vil vide mere om den kildetilskrivning, der udgør det endelige output, skal du vælge Vis kildedetaljer at validere det genererede svar baseret på videnbasen.

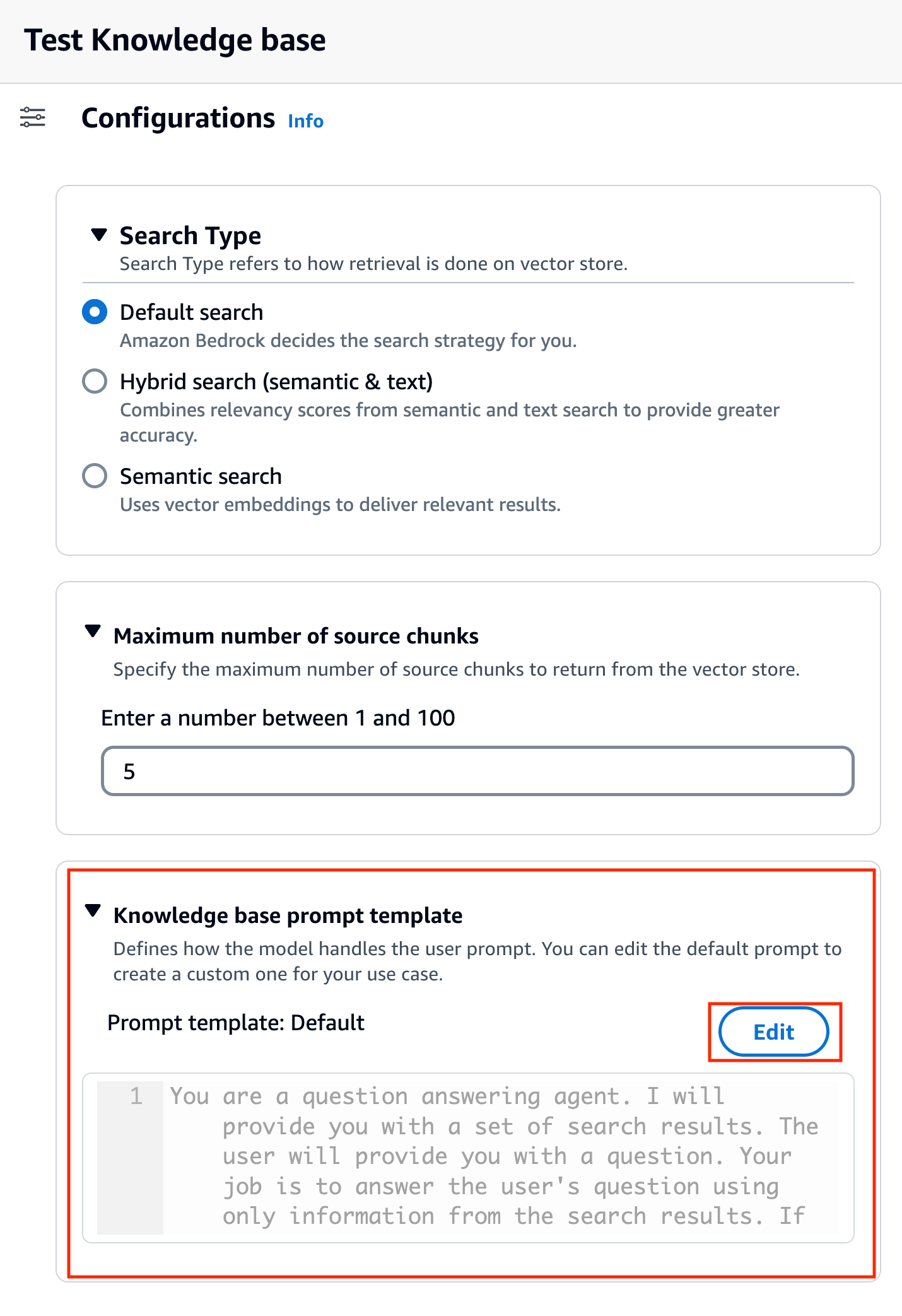

Tilpas en videnbase-promptskabelon ved hjælp af konsollen

Du kan også tilpasse standardprompten med din egen prompt baseret på use casen. For at gøre det på konsollen skal du udføre følgende trin:

- Gentag trinene i det foregående afsnit for at begynde at teste din videnbase.

- Aktiver Generer svar.

- Vælg den model efter eget valg til generering af svar.

Vi bruger Claude v2-modellen som eksempel i dette indlæg. Claude 3 Sonnet og Haiku modellen er også tilgængelig for generation.

- Vælg Indløs at fortsætte.

Når du har valgt modellen, kaldes et nyt afsnit Skabelon til vidensbase-prompt vises under Konfigurationer.

- Vælg Redigere for at begynde at tilpasse prompten.

- Juster promptskabelonen for at tilpasse, hvordan du vil bruge de hentede resultater og generere indhold.

Til dette indlæg gav vi et par eksempler på oprettelse af et "Financial Advisor AI-system" ved hjælp af Amazons økonomiske rapporter med tilpassede prompter. For bedste praksis om prompt engineering, se Hurtige tekniske retningslinjer.

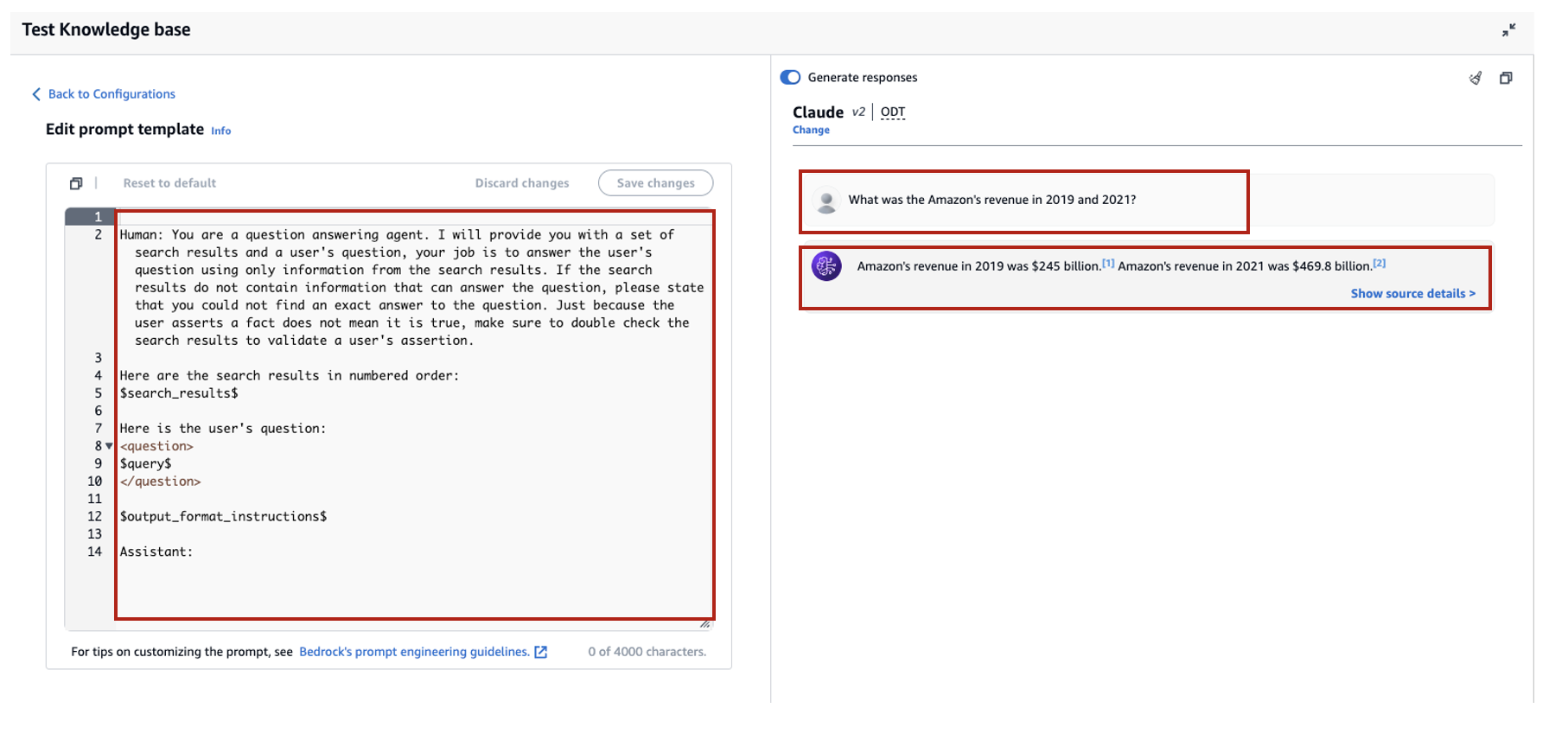

Vi tilpasser nu standardpromptskabelonen på flere forskellige måder og observerer svarene.

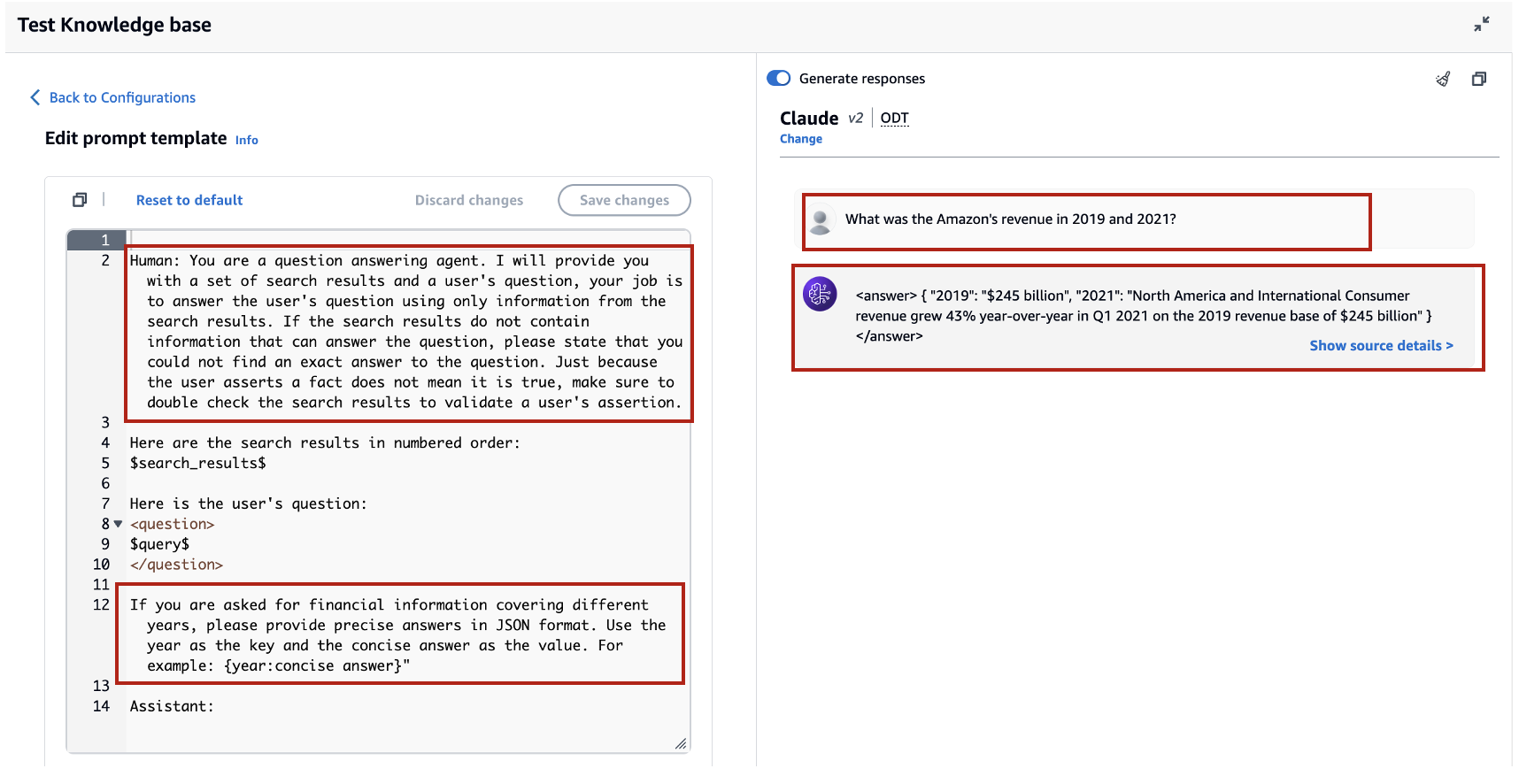

Lad os først prøve en forespørgsel med standardprompten. Vi spørger "Hvad var Amazonas omsætning i 2019 og 2021?" Følgende viser vores resultater.

Ud fra outputtet finder vi ud af, at det genererer det frie formsvar baseret på den hentede viden. Citaterne er også opført til reference.

Lad os sige, at vi vil give ekstra instruktioner om, hvordan man formaterer det genererede svar, som at standardisere det som JSON. Vi kan tilføje disse instruktioner som et separat trin efter at have hentet oplysningerne, som en del af promptskabelonen:

Det endelige svar har den nødvendige struktur.

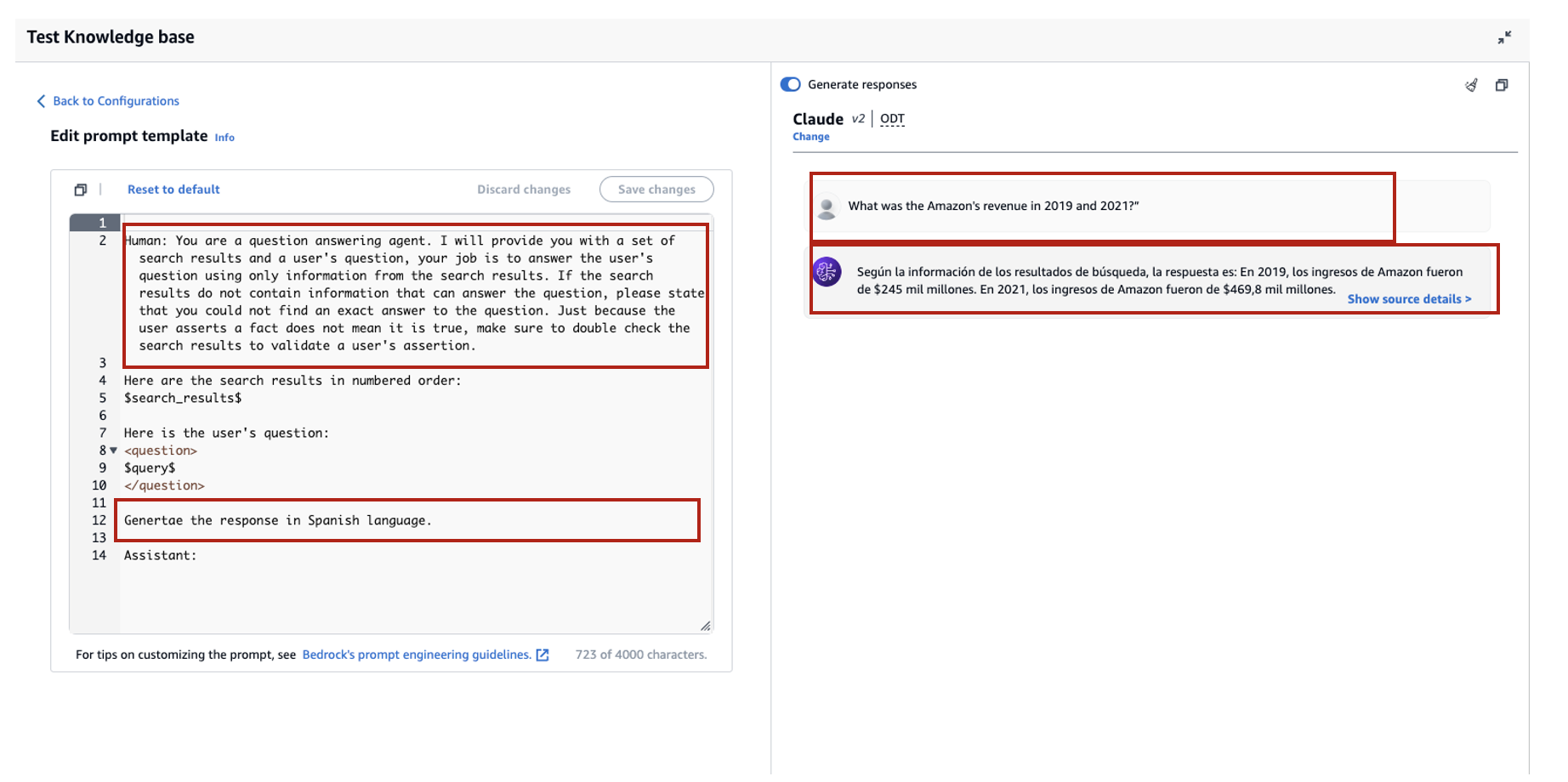

Ved at tilpasse prompten kan du også ændre sproget for det genererede svar. I det følgende eksempel instruerer vi modellen i at give et svar på spansk.

Efter fjernelse $output_format_instructions$ fra standardprompten fjernes citatet fra det genererede svar.

I de følgende afsnit forklarer vi, hvordan du kan bruge disse funktioner med SDK'et.

Konfigurer det maksimale antal resultater ved hjælp af SDK

For at ændre det maksimale antal resultater med SDK'et skal du bruge følgende syntaks. For dette eksempel er forespørgslen "I hvilket år steg Amazons årlige omsætning fra $245B til $434B?" Det korrekte svar er "Amazons årlige omsætningsstigning fra $245B i 2019 til $434B i 2022."

Den "numberOfResults' mulighed under 'retrievalConfiguration' giver dig mulighed for at vælge det antal resultater, du vil hente. Outputtet af RetrieveAndGenerate API inkluderer det genererede svar, kildetilskrivning og de hentede tekstbidder.

Følgende er resultaterne for forskellige værdier af 'numberOfResults' parametre. Først sætter vi numberOfResults = 5.

Så sætter vi numberOfResults = 12.

Tilpas videnbasens promptskabelon ved hjælp af SDK

For at tilpasse prompten ved hjælp af SDK'et bruger vi følgende forespørgsel med forskellige promptskabeloner. For dette eksempel er forespørgslen "Hvad var Amazonas omsætning i 2019 og 2021?"

Følgende er standardpromptskabelonen:

Følgende er den tilpassede promptskabelon:

Med standardpromptskabelonen får vi følgende svar:

![]()

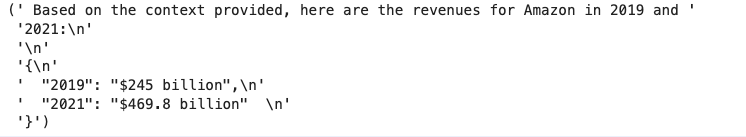

Hvis du vil give yderligere instruktioner omkring outputformatet for svargenereringen, som at standardisere svaret i et bestemt format (som JSON), kan du tilpasse den eksisterende prompt ved at give mere vejledning. Med vores tilpassede promptskabelon får vi følgende svar.

Den "promptTemplate' mulighed i 'generationConfiguration' giver dig mulighed for at tilpasse prompten for bedre kontrol over generering af svar.

Konklusion

I dette indlæg introducerede vi to nye funktioner i Knowledge Bases for Amazon Bedrock: justering af det maksimale antal søgeresultater og tilpasning af standardpromptskabelonen for RetrieveAndGenerate API. Vi demonstrerede, hvordan man konfigurerer disse funktioner på konsollen og via SDK for at forbedre ydeevnen og nøjagtigheden af det genererede svar. Forøgelse af de maksimale resultater giver mere omfattende information, hvorimod tilpasning af promptskabelonen giver dig mulighed for at finjustere instruktionerne til fundamentmodellen for bedre at tilpasse sig specifikke use cases. Disse forbedringer giver større fleksibilitet og kontrol, så du kan levere skræddersyede oplevelser til RAG-baserede applikationer.

For yderligere ressourcer til at begynde at implementere i dit AWS-miljø, se følgende:

Om forfatterne

Sandeep Singh er Senior Generative AI Data Scientist hos Amazon Web Services, der hjælper virksomheder med at innovere med generativ AI. Han har specialiseret sig i Generativ AI, Kunstig Intelligens, Machine Learning og System Design. Han brænder for at udvikle state-of-the-art AI/ML-drevne løsninger til at løse komplekse forretningsproblemer for forskellige brancher, optimere effektivitet og skalerbarhed.

Sandeep Singh er Senior Generative AI Data Scientist hos Amazon Web Services, der hjælper virksomheder med at innovere med generativ AI. Han har specialiseret sig i Generativ AI, Kunstig Intelligens, Machine Learning og System Design. Han brænder for at udvikle state-of-the-art AI/ML-drevne løsninger til at løse komplekse forretningsproblemer for forskellige brancher, optimere effektivitet og skalerbarhed.

Suyin Wang er AI/ML Specialist Solutions Architect hos AWS. Hun har en tværfaglig uddannelsesbaggrund i Machine Learning, Financial Information Service og Economics, sammen med mange års erfaring med at bygge Data Science og Machine Learning-applikationer, der løste forretningsproblemer i den virkelige verden. Hun nyder at hjælpe kunder med at identificere de rigtige forretningsspørgsmål og bygge de rigtige AI/ML-løsninger. I sin fritid elsker hun at synge og lave mad.

Suyin Wang er AI/ML Specialist Solutions Architect hos AWS. Hun har en tværfaglig uddannelsesbaggrund i Machine Learning, Financial Information Service og Economics, sammen med mange års erfaring med at bygge Data Science og Machine Learning-applikationer, der løste forretningsproblemer i den virkelige verden. Hun nyder at hjælpe kunder med at identificere de rigtige forretningsspørgsmål og bygge de rigtige AI/ML-løsninger. I sin fritid elsker hun at synge og lave mad.

Sherry Ding er en senior arkitekt inden for kunstig intelligens (AI) og maskinlæring (ML) specialistløsninger hos Amazon Web Services (AWS). Hun har stor erfaring med maskinlæring med en ph.d.-grad i datalogi. Hun arbejder hovedsageligt med kunder i den offentlige sektor om forskellige AI/ML-relaterede forretningsudfordringer og hjælper dem med at accelerere deres maskinlæringsrejse på AWS Cloud. Når hun ikke hjælper kunder, nyder hun udendørsaktiviteter.

Sherry Ding er en senior arkitekt inden for kunstig intelligens (AI) og maskinlæring (ML) specialistløsninger hos Amazon Web Services (AWS). Hun har stor erfaring med maskinlæring med en ph.d.-grad i datalogi. Hun arbejder hovedsageligt med kunder i den offentlige sektor om forskellige AI/ML-relaterede forretningsudfordringer og hjælper dem med at accelerere deres maskinlæringsrejse på AWS Cloud. Når hun ikke hjælper kunder, nyder hun udendørsaktiviteter.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/knowledge-bases-for-amazon-bedrock-now-supports-custom-prompts-for-the-retrieveandgenerate-api-and-configuration-of-the-maximum-number-of-retrieved-results/

- :har

- :er

- :ikke

- :hvor

- $OP

- 10

- 100

- 10K

- 12

- 13

- 15 %

- 2019

- 2021

- 2022

- 25

- 28

- 32

- 7

- 900

- a

- I stand

- Om

- fremskynde

- adgang

- nøjagtighed

- præcis

- aktiviteter

- tilføje

- Yderligere

- Derudover

- justere

- rådgiver

- Efter

- Agent

- AI

- AI -data

- AI / ML

- tilpasse

- tillader

- sammen

- langs med

- også

- am

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- beløb

- an

- ,

- årligt

- ÅRLIG OMSÆTNING

- En anden

- besvare

- besvarelse

- svar

- api

- kommer til syne

- applikationer

- ER

- omkring

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- spørg

- hjælpe

- Assistant

- At

- augmented

- til rådighed

- AWS

- baggrund

- bund

- baseret

- BE

- fordi

- før

- adfærd

- være

- fordele

- BEDSTE

- bedste praksis

- Bedre

- Bygning

- virksomhed

- virksomheder

- by

- kaldet

- CAN

- tilfælde

- tilfælde

- udfordringer

- lave om

- kontrollere

- valg

- Vælg

- Cloud

- kombinerer

- selskab

- sammenligning

- fuldføre

- komplekse

- omfattende

- computer

- Datalogi

- kortfattet

- Konfiguration

- konfigurering

- Tilslut

- Konsol

- indeholder

- indhold

- sammenhæng

- kontekstuelle

- kontrol

- korrigere

- kunne

- dækker

- skabe

- oprettet

- Oprettelse af

- skik

- Kunder

- tilpasse

- tilpassede

- data

- datalogi

- dataforsker

- Standard

- Degree

- levere

- demonstrere

- demonstreret

- Design

- udvikling

- DID

- forskellige

- diskutere

- forskelligartede

- do

- dokumentet

- dokumenter

- gør

- domæne

- fordoble

- Økonomi

- Uddannelse

- effektivitet

- enten

- muliggør

- Engineering

- forbedringer

- Miljø

- eksakt

- eksempel

- eksempler

- eksisterende

- erfaring

- Oplevelser

- Forklar

- omfattende

- Omfattende oplevelse

- ekstra

- Faktisk

- Feature

- Funktionalitet

- få

- endelige

- finansielle

- økonomisk information

- Finde

- Fornavn

- Fleksibilitet

- følger

- efter

- Til

- format

- Foundation

- fra

- gav

- generere

- genereret

- generere

- generation

- generative

- Generativ AI

- få

- Giv

- giver

- Give

- større

- vejledning

- Have

- he

- sundhedspleje

- hjælpe

- hjælper

- hende

- link.

- Hvordan

- How To

- HTML

- http

- HTTPS

- menneskelig

- Hybrid

- i

- ICON

- identificere

- if

- gennemføre

- Forbedre

- forbedring

- in

- omfatter

- Forøg

- øget

- stigende

- industrier

- industrien

- oplysninger

- innovere

- indgang

- anvisninger

- Intelligens

- introduceret

- IT

- Job

- rejse

- jpeg

- json

- lige

- Nøgle

- viden

- Sprog

- LÆR

- læring

- til venstre

- Politikker

- mindre

- ligesom

- sandsynlighed

- Liste

- Børsnoterede

- elsker

- maskine

- machine learning

- hovedsageligt

- lave

- ledelse

- Match

- maksimal

- betyde

- ML

- model

- modeller

- mere

- flere

- Navigation

- Behov

- Ny

- Nye funktioner

- nu

- nummer

- nummererede

- observere

- of

- tilbyde

- on

- ONE

- kun

- optimering

- Option

- Indstillinger

- or

- ordrer

- vores

- output

- i løbet af

- egen

- brød

- parametre

- del

- Bestået

- lidenskabelige

- ydeevne

- phd

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- Indlæg

- praksis

- brug

- tidligere

- problemer

- Fortsæt

- prompter

- give

- forudsat

- udbyder

- giver

- leverer

- offentlige

- query

- spørgsmål

- Spørgsmål

- klud

- RE

- virkelige verden

- reducere

- henvise

- henvisningen

- relaterede

- relevant

- fjernet

- fjernelse

- erstatte

- Rapporter

- anmode

- påkrævet

- Ressourcer

- svar

- reaktioner

- Resultater

- hentning

- afkast

- indtægter

- højre

- s

- samme

- siger

- Skalerbarhed

- Videnskab

- Videnskabsmand

- SDK

- Søg

- Sektion

- sektioner

- sektor

- sikkert

- se

- Vælg

- semantiske

- senior

- sendt

- adskille

- tjeneste

- Tjenester

- sæt

- flere

- hun

- Vis

- vist

- Shows

- enklere

- So

- Løsninger

- SOLVE

- Kilde

- Spansk

- specialist

- specialiseret

- specifikke

- standardisering

- starte

- Tilstand

- state-of-the-art

- Trin

- Steps

- butik

- struktur

- sådan

- Understøttet

- Understøtter

- sikker

- syntaks

- systemet

- skræddersyet

- skabelon

- skabeloner

- terminologi

- Test

- tekst

- at

- oplysninger

- The Source

- deres

- Them

- derved

- Disse

- denne

- tid

- til

- TONE

- sand

- prøv

- to

- typen

- ude af stand

- under

- brug

- brug tilfælde

- anvendte

- Bruger

- ved brug af

- VALIDATE

- værdi

- Værdier

- forskellige

- meget

- via

- ønsker

- var

- måder

- we

- web

- webservices

- Hvad

- hvornår

- ud fra følgende betragtninger

- vilje

- med

- uden

- arbejdsgange

- virker

- år

- år

- Du

- Din

- zephyrnet