Store sprogmodeller (LLM'er) har revolutioneret området for naturlig sprogbehandling (NLP) og forbedret opgaver som sprogoversættelse, tekstresumé og sentimentanalyse. Men efterhånden som disse modeller fortsætter med at vokse i størrelse og kompleksitet, er det blevet stadig mere udfordrende at overvåge deres ydeevne og adfærd.

Overvågning af LLM'ers ydeevne og adfærd er en kritisk opgave for at sikre deres sikkerhed og effektivitet. Vores foreslåede arkitektur giver en skalerbar og tilpasselig løsning til online LLM-overvågning, hvilket gør det muligt for teams at skræddersy din overvågningsløsning til dine specifikke brugssituationer og krav. Ved at bruge AWS-tjenester giver vores arkitektur realtidssynlighed i LLM-adfærd og gør det muligt for teams hurtigt at identificere og løse eventuelle problemer eller uregelmæssigheder.

I dette indlæg demonstrerer vi et par målinger for online LLM-overvågning og deres respektive arkitektur for skalering ved hjælp af AWS-tjenester som f.eks. amazoncloudwatch , AWS Lambda. Dette giver en tilpasselig løsning ud over, hvad der er muligt med model evaluering job med Amazonas grundfjeld.

Oversigt over løsning

Den første ting at overveje er, at forskellige metrics kræver forskellige beregningsovervejelser. En modulær arkitektur, hvor hvert modul kan indtage modelinferensdata og producere sine egne metrikker, er nødvendig.

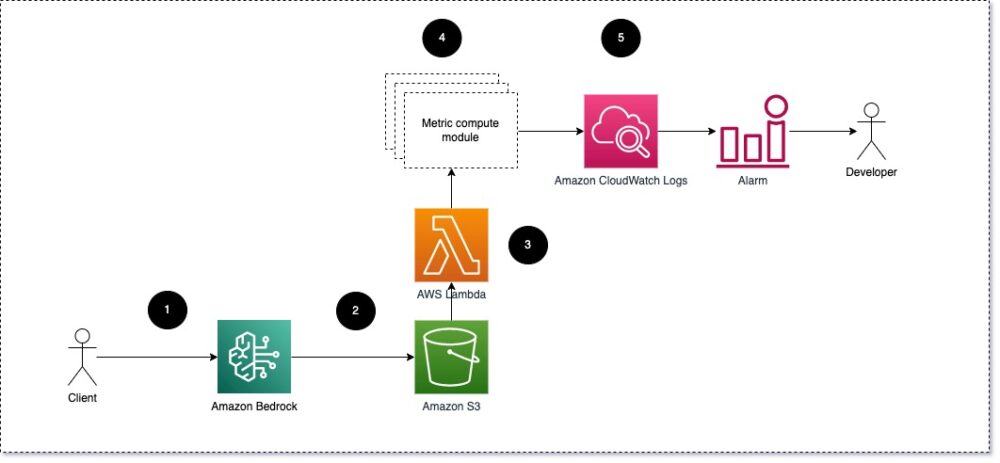

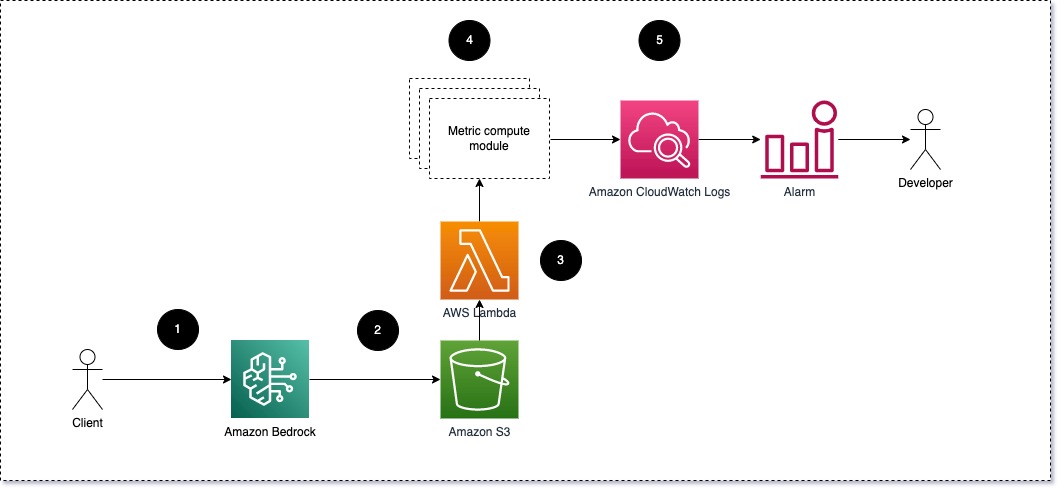

Vi foreslår, at hvert modul tager indgående slutningsanmodninger til LLM'et og videregiver prompt- og færdiggørelses- (svar)par til metriske beregningsmoduler. Hvert modul er ansvarlig for at beregne sine egne metrics med hensyn til inputprompten og afslutningen (svaret). Disse metrics videregives til CloudWatch, som kan aggregere dem og arbejde med CloudWatch-alarmer for at sende meddelelser om specifikke forhold. Følgende diagram illustrerer denne arkitektur.

Fig. 1: Metrisk beregningsmodul – løsningsoversigt

Arbejdsgangen omfatter følgende trin:

- En bruger fremsætter en anmodning til Amazon Bedrock som en del af en applikation eller brugergrænseflade.

- Amazon Bedrock gemmer anmodningen og afslutningen (svaret) i Amazon Simple Storage Service (Amazon S3) som pr konfiguration af invokationslogning.

- Filen gemt på Amazon S3 opretter en begivenhed, der udløser en Lambda funktion. Funktionen aktiverer modulerne.

- Modulerne sender deres respektive metrics til CloudWatch-målinger.

- Alarmer kan underrette udviklingsteamet om uventede metriske værdier.

Den anden ting at overveje, når du implementerer LLM-overvågning, er at vælge de rigtige metrics at spore. Selvom der er mange potentielle målinger, som du kan bruge til at overvåge LLM-ydeevne, forklarer vi nogle af de bredeste i dette indlæg.

I de følgende afsnit fremhæver vi nogle få af de relevante modulmetrikker og deres respektive metriske beregningsmodularkitektur.

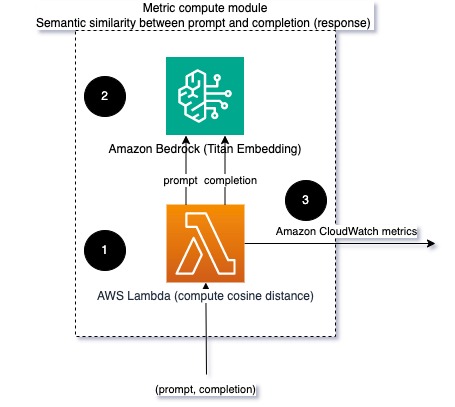

Semantisk lighed mellem prompt og afslutning (svar)

Når du kører LLM'er, kan du opsnappe prompten og afslutningen (svaret) for hver anmodning og transformere dem til indlejringer ved hjælp af en indlejringsmodel. Indlejringer er højdimensionelle vektorer, der repræsenterer tekstens semantiske betydning. Amazon Titan leverer sådanne modeller gennem Titan Embeddings. Ved at tage en afstand såsom cosinus mellem disse to vektorer, kan du kvantificere, hvor semantisk ens prompten og afslutningen (svaret) er. Du kan bruge SciPy or scikit-lære at beregne cosinusafstanden mellem vektorer. Det følgende diagram illustrerer arkitekturen af dette metriske beregningsmodul.

Fig. 2: Metrisk beregningsmodul – semantisk lighed

Denne arbejdsgang omfatter følgende nøgletrin:

- En Lambda-funktion modtager en streamet besked via Amazon Kinesis indeholdende et prompt- og afslutningspar (svar).

- Funktionen får en indlejring for både prompten og afslutningen (svaret), og beregner cosinusafstanden mellem de to vektorer.

- Funktionen sender disse oplysninger til CloudWatch-metrics.

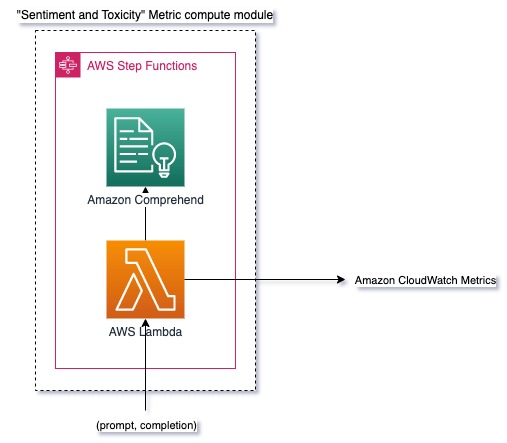

Følelse og toksicitet

Overvågning af følelser giver dig mulighed for at måle den overordnede tone og følelsesmæssige virkning af svarene, hvorimod toksicitetsanalyse giver et vigtigt mål for tilstedeværelsen af stødende, respektløst eller skadeligt sprog i LLM-output. Eventuelle ændringer i følelse eller toksicitet bør overvåges nøje for at sikre, at modellen opfører sig som forventet. Følgende diagram illustrerer det metriske beregningsmodul.

Fig. 3: Metrisk beregningsmodul – sentiment og toksicitet

Arbejdsgangen omfatter følgende trin:

- En Lambda-funktion modtager en prompt og et fuldførelsespar (svar) gennem Amazon Kinesis.

- Gennem AWS Step Functions orkestrering kalder funktionen Amazon Comprehend at opdage stemningen , toksicitet.

- Funktionen gemmer oplysningerne i CloudWatch-metrics.

For mere information om påvisning af følelser og toksicitet med Amazon Comprehend, se Byg en robust tekstbaseret toksicitetsforudsigelse , Markér skadeligt indhold ved hjælp af Amazon Comprehend-toksicitetsdetektion.

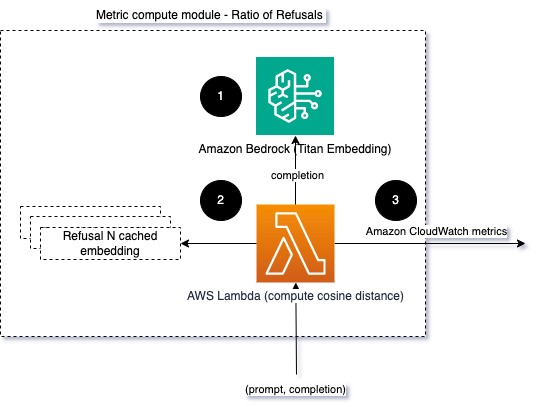

Forholdet mellem afslag

En stigning i afslag, såsom når en LLM nægter færdiggørelse på grund af manglende information, kan betyde, at enten ondsindede brugere forsøger at bruge LLM på måder, der er beregnet til at jailbreake det, eller at brugernes forventninger ikke bliver opfyldt, og de får svar med lav værdi. En måde at måle, hvor ofte dette sker, er ved at sammenligne standardafslag fra LLM-modellen, der bruges, med de faktiske svar fra LLM. For eksempel er følgende nogle af Anthropics Claude v2 LLM almindelige afvisningssætninger:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

På et fast sæt af prompter kan en stigning i disse afslag være et signal om, at modellen er blevet for forsigtig eller følsom. Det omvendte tilfælde bør også evalueres. Det kan være et signal om, at modellen nu er mere tilbøjelig til at indgå i giftige eller skadelige samtaler.

For at hjælpe med at modellere integritet og modelafvisningsforhold kan vi sammenligne svaret med et sæt kendte afvisningssætninger fra LLM. Dette kunne være en egentlig klassifikator, der kan forklare, hvorfor modellen afviste anmodningen. Du kan tage cosinusafstanden mellem svaret og kendte afslagssvar fra den model, der overvåges. Følgende diagram illustrerer dette metriske beregningsmodul.

Fig. 4: Metrisk beregningsmodul – forholdet mellem afslag

Arbejdsgangen består af følgende trin:

- En Lambda-funktion modtager en prompt og afslutning (svar) og får en indlejring fra svaret ved hjælp af Amazon Titan.

- Funktionen beregner cosinus- eller euklidisk afstand mellem svaret og eksisterende afvisningsprompter, der er gemt i hukommelsen.

- Funktionen sender dette gennemsnit til CloudWatch-metrics.

En anden mulighed er at bruge uklar matchning for en ligetil, men mindre kraftfuld tilgang til at sammenligne de kendte afslag med LLM-output. Der henvises til Python-dokumentation til et eksempel.

Resumé

LLM observerbarhed er en kritisk praksis for at sikre pålidelig og troværdig brug af LLM'er. Overvågning, forståelse og sikring af nøjagtigheden og pålideligheden af LLM'er kan hjælpe dig med at mindske de risici, der er forbundet med disse AI-modeller. Ved at overvåge hallucinationer, dårlige afslutninger (svar) og prompter kan du sikre dig, at din LLM forbliver på sporet og leverer den værdi, du og dine brugere leder efter. I dette indlæg diskuterede vi et par målinger for at vise eksempler.

For mere information om evaluering af fundamentmodeller, se Brug SageMaker Clarify til at evaluere fundamentmodeller, og gennemse yderligere eksempel notesbøger tilgængelig i vores GitHub-lager. Du kan også udforske måder at operationalisere LLM-evalueringer i skala ind Operationaliser LLM-evaluering i skala ved hjælp af Amazon SageMaker Clarify og MLOps-tjenester. Til sidst anbefaler vi at henvise til Vurdere store sprogmodeller for kvalitet og ansvar for at lære mere om evaluering af LLM'er.

Om forfatterne

Bruno Klein er en Senior Machine Learning Engineer med AWS Professional Services Analytics Practice. Han hjælper kunder med at implementere big data og analyseløsninger. Uden for arbejdet nyder han at tilbringe tid med familien, rejse og prøve ny mad.

Bruno Klein er en Senior Machine Learning Engineer med AWS Professional Services Analytics Practice. Han hjælper kunder med at implementere big data og analyseløsninger. Uden for arbejdet nyder han at tilbringe tid med familien, rejse og prøve ny mad.

Rushabh Lokhande er en Senior Data & ML Engineer med AWS Professional Services Analytics Practice. Han hjælper kunder med at implementere big data, machine learning og analyseløsninger. Uden for arbejdet nyder han at bruge tid med familien, læse, løbe og spille golf.

Rushabh Lokhande er en Senior Data & ML Engineer med AWS Professional Services Analytics Practice. Han hjælper kunder med at implementere big data, machine learning og analyseløsninger. Uden for arbejdet nyder han at bruge tid med familien, læse, løbe og spille golf.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :har

- :er

- :ikke

- :hvor

- 1

- 100

- 143

- 32

- 455

- 7

- a

- Om

- nøjagtighed

- faktiske

- Yderligere

- adresse

- aggregat

- AI

- AI assistent

- AI modeller

- tillader

- også

- Skønt

- am

- Amazon

- Amazon Comprehend

- Amazon Kinesis

- Amazon SageMaker

- Amazon Web Services

- an

- analyse

- analytics

- ,

- abnormaliteter

- Antropisk

- enhver

- Anvendelse

- tilgang

- tilgange

- arkitektur

- ER

- AS

- Assistant

- forbundet

- At

- til rådighed

- gennemsnit

- AWS

- AWS Professional Services

- AWS-trinfunktioner

- Bad

- BE

- bliver

- adfærd

- være

- mellem

- Beyond

- Big

- Big data

- både

- men

- by

- Opkald

- CAN

- kan ikke

- tilfælde

- tilfælde

- forsigtig

- udfordrende

- vælge

- klassifikator

- nøje

- Fælles

- sammenligne

- sammenligne

- færdiggørelse

- kompleksitet

- forstå

- beregning

- Compute

- computing

- betingelser

- Konfiguration

- Overvej

- overvejelser

- består

- indhold

- sammenhæng

- fortsæt

- samtaler

- kunne

- oprettet

- skaber

- kritisk

- Kunder

- tilpasses

- data

- leverer

- demonstrere

- opdage

- Udvikling

- udviklingsteam

- diagram

- forskellige

- drøftet

- afstand

- do

- grund

- hver

- effektivitet

- enten

- indlejring

- muliggør

- muliggør

- engagere

- ingeniør

- nok

- sikre

- sikring

- evaluere

- evalueret

- evaluere

- evaluering

- evalueringer

- begivenhed

- eksempel

- eksempler

- eksisterende

- forventninger

- forventet

- Forklar

- udforske

- familie

- få

- felt

- fig

- File (Felt)

- Endelig

- Fornavn

- fast

- efter

- mad

- Til

- Foundation

- fra

- funktion

- funktioner

- Målestok

- får

- få

- GitHub

- golf

- Grow

- Happening

- skadelig

- Have

- he

- hjælpe

- hjælpsom

- hjælper

- Fremhæv

- ærlige

- Hvordan

- Men

- HTML

- http

- HTTPS

- i

- identificere

- illustrerer

- KIMOs Succeshistorier

- gennemføre

- gennemføre

- vigtigt

- forbedring

- in

- omfatter

- Indgående

- Forøg

- stigende

- oplysninger

- indgang

- integritet

- beregnet

- grænseflade

- ind

- omvendt

- påberåber sig

- spørgsmål

- IT

- ITS

- jailbreake

- Karriere

- jpg

- Nøgle

- kendt

- Mangel

- Sprog

- stor

- LÆR

- læring

- mindre

- LLM

- leder

- maskine

- machine learning

- lave

- maerker

- ondsindet

- mange

- betyde

- betyder

- måle

- Hukommelse

- besked

- mødte

- metrisk

- Metrics

- afbøde

- ML

- MLOps

- model

- modeller

- modulær

- Moduler

- Moduler

- Overvåg

- overvåges

- overvågning

- mere

- Natural

- Natural Language Processing

- nødvendig

- Ny

- NLP

- meddelelser

- nu

- of

- offensiv

- Tilbud

- tit

- on

- ONE

- dem

- online

- Option

- or

- orkestrering

- vores

- output

- udgange

- uden for

- samlet

- oversigt

- egen

- par

- par

- del

- Bestået

- Passing

- per

- ydeevne

- sætninger

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- mulig

- Indlæg

- potentiale

- vigtigste

- praksis

- tilstedeværelse

- forarbejdning

- producere

- professionel

- prompter

- foreslog

- give

- giver

- Python

- kvalitet

- hurtigt

- forholdet

- Læsning

- realtid

- modtager

- anbefaler

- henvise

- afslag

- nægtede

- relevant

- pålidelighed

- pålidelig

- Repository

- repræsentere

- anmode

- anmodninger

- kræver

- Krav

- respekt

- dem

- svar

- reaktioner

- ansvarlige

- revolutioneret

- højre

- risici

- robust

- kører

- Sikkerhed

- sagemaker

- gemt

- skalerbar

- Scale

- Anden

- sektioner

- semantiske

- send

- sender

- senior

- følsom

- stemningen

- Tjenester

- sæt

- Skift

- bør

- udstillingsvindue

- Signal

- lignende

- Simpelt

- Størrelse

- løsninger

- Løsninger

- nogle

- rumlige

- specifikke

- udgifterne

- standard

- Trin

- Steps

- opbevaring

- ligetil

- streamet

- sådan

- tyder

- sikker

- skrædder

- Tag

- tager

- Opgaver

- opgaver

- hold

- hold

- teknikker

- tekst

- at

- oplysninger

- deres

- Them

- Der.

- Disse

- de

- ting

- denne

- Gennem

- tid

- titan

- til

- TONE

- spor

- Transform

- Oversættelse

- Traveling

- troværdig

- forsøger

- to

- forståelse

- Uventet

- brug

- anvendte

- Bruger

- Brugergrænseflade

- brugere

- ved brug af

- værdi

- Værdier

- via

- synlighed

- Vej..

- måder

- we

- web

- webservices

- Hvad

- Hvad er

- hvornår

- ud fra følgende betragtninger

- som

- hvorfor

- Wikipedia

- med

- Arbejde

- workflow

- Du

- Din

- zephyrnet