Dette indlæg er skrevet sammen med Ilan Geller og Shuyu Yang fra Accenture.

Virksomheder står i dag over for store udfordringer, når det kommer til at bruge deres informations- og videnbaser til både intern og ekstern forretningsdrift. Med konstant udvikling af drift, processer, politikker og overholdelseskrav kan det være ekstremt svært for medarbejdere og kunder at holde sig opdateret. Samtidig gør den ustrukturerede karakter af meget af dette indhold det tidskrævende at finde svar ved hjælp af traditionel søgning.

Internt kan medarbejdere ofte bruge utallige timer på at jage information, de har brug for for at udføre deres arbejde, hvilket fører til frustration og reduceret produktivitet. Og når de ikke kan finde svar, er de nødt til at eskalere problemer eller træffe beslutninger uden fuldstændig kontekst, hvilket kan skabe risiko.

Eksternt kan kunder også finde det frustrerende at finde den information, de søger. Selvom virksomhedens videnbaser over tid har forbedret kundeoplevelsen, kan de stadig være besværlige og svære at bruge. Uanset om du søger svar på et produktrelateret spørgsmål eller har brug for information om åbningstider og lokationer, kan en dårlig oplevelse føre til frustration eller endnu værre, en kundeafvisning.

I begge tilfælde, efterhånden som vidensstyring bliver mere kompleks, giver generativ kunstig intelligens en mulighed for spilskiftende virksomheder til at forbinde mennesker med den information, de har brug for for at udføre og innovere. Med den rigtige strategi kan disse intelligente løsninger transformere, hvordan viden fanges, organiseres og bruges på tværs af en organisation.

For at hjælpe med at tackle denne udfordring samarbejdede Accenture med AWS om at bygge en innovativ generativ AI-løsning kaldet Knowledge Assist. Ved at bruge AWS generative AI-tjenester har teamet udviklet et system, der kan indtage og forstå enorme mængder af ustruktureret virksomhedsindhold.

I stedet for traditionelle søgeordssøgninger kan brugere nu stille spørgsmål og udtrække præcise svar i en ligetil samtalegrænseflade. Generativ AI forstår kontekst og relationer inden for videnbasen for at levere personlige og præcise svar. Efterhånden som det udfylder flere forespørgsler, forbedrer systemet løbende sin sprogbehandling gennem maskinlæringsalgoritmer (ML).

Siden lanceringen af denne AI-assistanceramme har virksomheder set dramatiske forbedringer i fastholdelse af medarbejderviden og produktivitet. Ved at give hurtig og præcis adgang til information og gøre det muligt for medarbejderne at betjene sig selv, reducerer denne løsning uddannelsestiden for nyansatte med over 50 % og reducerer eskaleringer med op til 40 %.

Med kraften fra generativ AI kan virksomheder transformere, hvordan viden fanges, organiseres og deles på tværs af organisationen. Ved at frigøre deres eksisterende vidensbaser kan virksomheder øge medarbejdernes produktivitet og kundetilfredshed. Som Accentures samarbejde med AWS viser, ligger fremtiden for virksomhedsvidenstyring i AI-drevne systemer, der udvikler sig gennem interaktioner mellem mennesker og maskiner.

Accenture arbejder sammen med AWS for at hjælpe kunder med at implementere Amazonas grundfjeld, udnytte de mest avancerede grundmodeller som f.eks Amazon Titan, og implementere brancheførende teknologier som f.eks Amazon SageMaker JumpStart , Amazon Inferentia sammen med andre AWS ML-tjenester.

Dette indlæg giver et overblik over en ende-til-ende generativ AI-løsning udviklet af Accenture til en produktionsbrugssag ved hjælp af Amazon Bedrock og andre AWS-tjenester.

Løsningsoversigt

En stor klient i den offentlige sundhedssektor betjener millioner af borgere hver dag, og de kræver nem adgang til opdateret information i et stadigt foranderligt sundhedslandskab. Accenture har integreret denne generative AI-funktionalitet i en eksisterende FAQ-bot, hvilket giver chatbotten mulighed for at give svar på en bredere vifte af brugerspørgsmål. Ved at øge borgernes mulighed for at få adgang til relevant information på en selvbetjeningsmåde sparer afdelingen tid og penge, hvilket mindsker behovet for interaktion mellem callcentermedarbejdere. Løsningens nøglefunktioner omfatter:

- Hybrid hensigtstilgang – Bruger generative og fortrænede hensigter

- Flersproget support – Samtaler på engelsk og spansk

- Samtaleanalyse – Rapporter om brugerbehov, følelser og bekymringer

- Naturlige samtaler - Vedligeholder kontekst med human-like natural language processing (NLP)

- Gennemsigtige citater – Vejleder brugere til kildeoplysningerne

Accentures generative AI-løsning giver følgende fordele i forhold til eksisterende eller traditionelle chatbot-rammer:

- Genererer præcise, relevante og naturligt klingende svar på brugerforespørgsler hurtigt

- Husker konteksten og besvarer opfølgende spørgsmål

- Håndterer forespørgsler og genererer svar på flere sprog (såsom engelsk og spansk)

- Lærer og forbedrer løbende svar baseret på brugerfeedback

- Kan nemt integreres med din eksisterende webplatform

- Indtager et stort lager af virksomhedens videnbase

- Reagerer på en menneskelignende måde

- Udviklingen af viden er konstant tilgængelig med minimal eller ingen indsats

- Bruger en pay-as-you-use model uden forudgående omkostninger

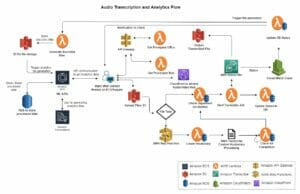

Arbejdsgangen på højt niveau af denne løsning involverer følgende trin:

- Brugere skaber en enkel integration med eksisterende webplatforme

- Data indlæses i platformen som en masseupload på dag 0 og derefter trinvise uploads fra dag 1+.,

- Brugerforespørgsler behandles i realtid med systemets skalering efter behov for at imødekomme brugernes efterspørgsel.

- Samtaler gemmes i applikationsdatabaser (Amazon Dynamo DB) for at understøtte multi-runde samtaler.

- Den antropiske Claude-grundmodel påberåbes via Amazon Bedrock, som bruges til at generere forespørgselssvar baseret på det mest relevante indhold.

- Den antropiske Claude-grundmodel bruges til at oversætte forespørgsler samt svar fra engelsk til andre ønskede sprog for at understøtte flersprogede samtaler.

- Amazon Titan-fundamentmodellen påberåbes via Amazon Bedrock for at generere vektorindlejringer.

- Indholdsrelevans bestemmes gennem ligheden mellem indlejringer af råt indhold og indlejring af brugerforespørgsler ved at bruge Pinecone vektordatabaseindlejringer.

- Konteksten sammen med brugerens spørgsmål er vedhæftet for at skabe en prompt, som er givet som input til den antropiske Claude-model. Det genererede svar leveres tilbage til brugeren via webplatformen.

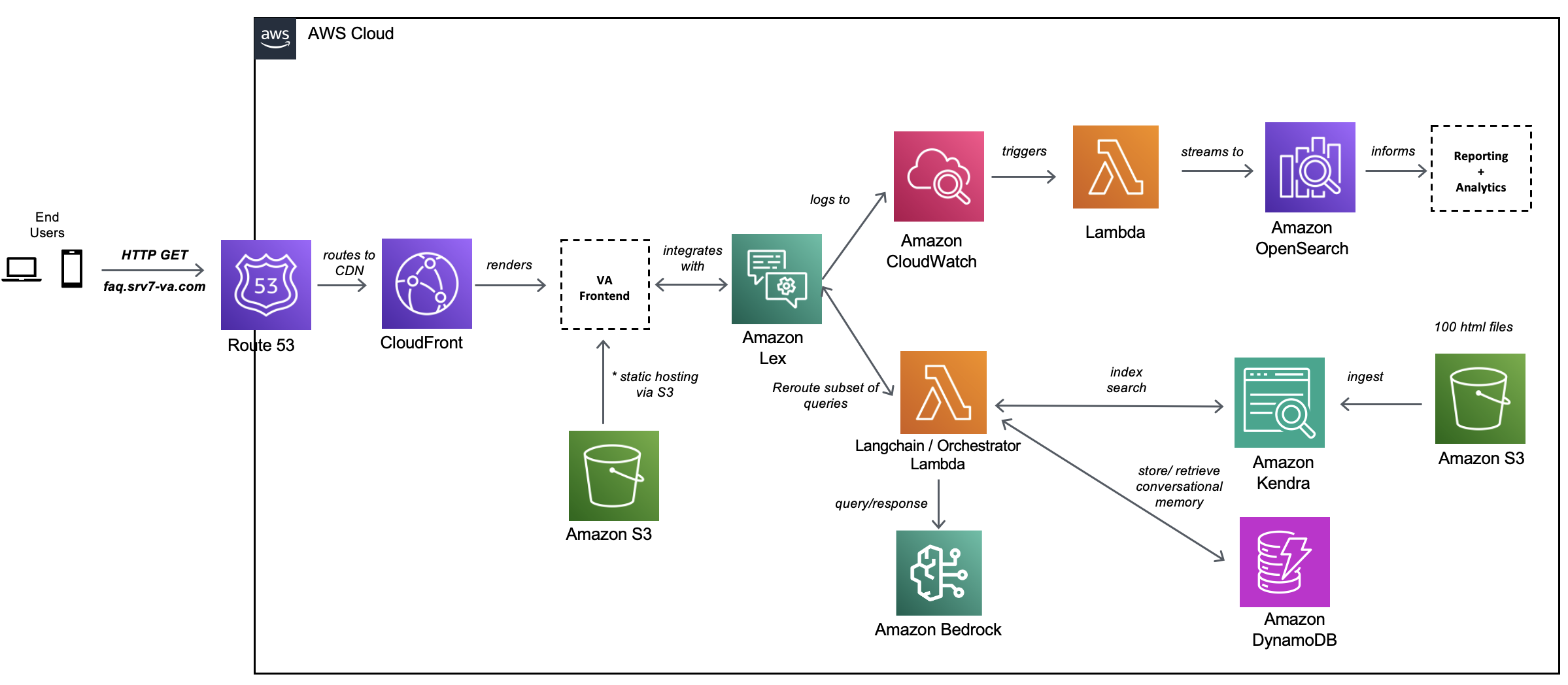

Følgende diagram illustrerer løsningsarkitekturen.

Arkitekturflowet kan forstås i to dele:

I de følgende afsnit diskuterer vi forskellige aspekter af løsningen og dens udvikling mere detaljeret.

Modelvalg

Processen til modelvalg inkluderede regresstest af forskellige modeller tilgængelige i Amazon Bedrock, som inkluderede AI21 Labs, Cohere, Anthropic og Amazon foundation modeller. Vi tjekkede for understøttede use cases, modelattributter, maksimale tokens, omkostninger, nøjagtighed, ydeevne og sprog. Baseret på dette valgte vi Claude-2 som bedst egnet til denne use case.

Datakilde

Vi oprettede et Amazon Kendra-indeks og tilføjede en datakilde ved hjælp af webcrawler-forbindelser med en rodweb-URL og mappedybde på to niveauer. Adskillige websider blev optaget i Amazon Kendra-indekset og brugt som datakilde.

GenAI chatbot anmodning og svar proces

Trin i denne proces består af en ende-til-ende-interaktion med en anmodning fra Amazon Lex og et svar fra en stor sprogmodel (LLM):

- Brugeren sender anmodningen til samtalefrontend-applikationen, der er hostet i en Amazon Simple Storage Service (Amazon S3) spand igennem Amazonrute 53 , Amazon CloudFront.

- Amazon Lex forstår hensigten og sender anmodningen til orkestratoren, der er vært i en AWS Lambda funktion.

- Orchestrator Lambda-funktionen udfører følgende trin:

- Funktionen interagerer med applikationsdatabasen, som er hostet i en DynamoDB-administreret database. Databasen gemmer sessions-id'et og bruger-id'et til samtalehistorik.

- En anden anmodning sendes til Amazon Kendra-indekset for at få de fem bedste relevante søgeresultater til at bygge den relevante kontekst. Ved at bruge denne kontekst konstrueres modificeret prompt påkrævet til LLM-modellen.

- Forbindelsen er etableret mellem Amazon Bedrock og orkestratoren. Der sendes en anmodning til Amazon Bedrock Claude-2-modellen for at få svar fra den valgte LLM-model.

- Dataene efterbehandles fra LLM-svaret, og et svar sendes til brugeren.

Online rapportering

Onlinerapporteringsprocessen består af følgende trin:

- Slutbrugere interagerer med chatbotten via et CloudFront CDN-frontend-lag.

- Hver anmodning/svar-interaktion lettes af AWS SDK og sender netværkstrafik til Amazon Lex (botens NLP-komponent).

- Metadata om anmodning/svar-parringerne logges på amazoncloudwatch.

- CloudWatch-loggruppen er konfigureret med et abonnementsfilter, der sender logs ind Amazon OpenSearch Service.

- Når først de er tilgængelige i OpenSearch Service, kan logfiler bruges til at generere rapporter og dashboards ved hjælp af Kibana.

Konklusion

I dette indlæg viste vi, hvordan Accenture bruger AWS generative AI-tjenester til at implementere en end-to-end-tilgang til digital transformation. Vi identificerede hullerne i traditionelle spørgsmålssvarsplatforme og øgede generativ intelligens inden for dens rammer for hurtigere svartider og løbende forbedring af systemet, mens vi interagerer med brugerne over hele kloden. Tag fat i Accenture Center of Excellence-teamet for at dykke dybere ned i løsningen og implementere denne løsning til dine kunder.

Denne Knowledge Assist-platform kan anvendes til forskellige industrier, herunder, men ikke begrænset til, sundhedsvidenskab, finansielle tjenesteydelser, fremstilling og mere. Denne platform giver naturlige, menneskelignende svar på spørgsmål ved hjælp af viden, der er sikret. Denne platform muliggør effektivitet, produktivitet og mere nøjagtige handlinger, som dens brugere kan foretage.

Den fælles indsats bygger på det 15-årige strategiske forhold mellem virksomhederne og bruger de samme gennemprøvede mekanismer og acceleratorer bygget af Accenture AWS Business Group (AABG).

Forbind med AABG-teamet på accentureaws@amazon.com at drive forretningsresultater ved at transformere til en intelligent datavirksomhed på AWS.

For yderligere information om generativ AI på AWS ved hjælp af Amazon Bedrock eller Amazon SageMaker, anbefaler vi følgende ressourcer:

Du kan også tilmeld dig det AWS generative AI-nyhedsbrev, som omfatter uddannelsesressourcer, blogs og serviceopdateringer.

Om forfatterne

Ilan Geller er administrerende direktør hos Accenture med fokus på kunstig intelligens, der hjælper kunder med at skalere kunstig intelligens-applikationer og Global GenAI COE Partner Lead for AWS.

Ilan Geller er administrerende direktør hos Accenture med fokus på kunstig intelligens, der hjælper kunder med at skalere kunstig intelligens-applikationer og Global GenAI COE Partner Lead for AWS.

Shuyu Yang er Generative AI og Large Language Model Delivery Lead og leder også CoE (Center of Excellence) Accenture AI (AWS DevOps professionelle) teams.

Shuyu Yang er Generative AI og Large Language Model Delivery Lead og leder også CoE (Center of Excellence) Accenture AI (AWS DevOps professionelle) teams.

Shikhar Kwatra er en AI/ML-specialistløsningsarkitekt hos Amazon Web Services, der arbejder med en førende global systemintegrator. Han har opnået titlen som en af de yngste indiske mesteropfindere med over 500 patenter inden for AI/ML og IoT-domænerne. Shikhar hjælper med at arkitekture, bygge og vedligeholde omkostningseffektive, skalerbare cloudmiljøer for organisationen og understøtter GSI-partneren med at bygge strategiske industriløsninger på AWS.

Shikhar Kwatra er en AI/ML-specialistløsningsarkitekt hos Amazon Web Services, der arbejder med en førende global systemintegrator. Han har opnået titlen som en af de yngste indiske mesteropfindere med over 500 patenter inden for AI/ML og IoT-domænerne. Shikhar hjælper med at arkitekture, bygge og vedligeholde omkostningseffektive, skalerbare cloudmiljøer for organisationen og understøtter GSI-partneren med at bygge strategiske industriløsninger på AWS.

Jay Pillai er Principal Solution Architect hos Amazon Web Services. I denne rolle fungerer han som Global Generative AI Lead Architect og også Lead Architect for Supply Chain Solutions hos AABG. Som informationsteknologileder har Jay specialiseret sig i kunstig intelligens, dataintegration, business intelligence og brugergrænsefladedomæner. Han har 23 års omfattende erfaring med at arbejde med adskillige kunder på tværs af forsyningskæden, juridiske teknologier, fast ejendom, finansielle tjenesteydelser, forsikring, betalinger og markedsundersøgelser.

Jay Pillai er Principal Solution Architect hos Amazon Web Services. I denne rolle fungerer han som Global Generative AI Lead Architect og også Lead Architect for Supply Chain Solutions hos AABG. Som informationsteknologileder har Jay specialiseret sig i kunstig intelligens, dataintegration, business intelligence og brugergrænsefladedomæner. Han har 23 års omfattende erfaring med at arbejde med adskillige kunder på tværs af forsyningskæden, juridiske teknologier, fast ejendom, finansielle tjenesteydelser, forsikring, betalinger og markedsundersøgelser.

Karthik Sonti leder et globalt team af Solutions Architects med fokus på at konceptualisere, bygge og lancere horisontale, funktionelle og vertikale løsninger med Accenture for at hjælpe vores fælles kunder med at transformere deres forretning på en differentieret måde på AWS.

Karthik Sonti leder et globalt team af Solutions Architects med fokus på at konceptualisere, bygge og lancere horisontale, funktionelle og vertikale løsninger med Accenture for at hjælpe vores fælles kunder med at transformere deres forretning på en differentieret måde på AWS.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/accenture-creates-a-knowledge-assist-solution-using-generative-ai-services-on-aws/

- :har

- :er

- :ikke

- $OP

- 100

- 23

- 500

- 7

- a

- evne

- Om

- acceleratorer

- Accenture

- adgang

- nøjagtighed

- præcis

- tværs

- aktioner

- tilføjet

- fremskreden

- fordele

- Agent

- AI

- AI-tjenester

- AI / ML

- hjælpemidler

- algoritmer

- tillade

- sammen

- langs med

- også

- Skønt

- Amazon

- Amazon Kendra

- Amazon Lex

- Amazon Web Services

- beløb

- an

- ,

- svar

- Antropisk

- Anvendelse

- applikationer

- anvendt

- tilgang

- arkitekter

- arkitektur

- ER

- Array

- kunstig

- kunstig intelligens

- AS

- spørg

- aspekter

- hjælpe

- Assistance

- At

- attributter

- augmented

- til rådighed

- AWS

- tilbage

- bund

- baseret

- BE

- bliver

- BEDSTE

- mellem

- blogs

- boost

- Bot

- både

- bredere

- bygge

- Bygning

- bygger

- bygget

- virksomhed

- business intelligence

- men

- by

- ringe

- call center

- kaldet

- CAN

- fanget

- tilfælde

- tilfælde

- center

- Center for ekspertise

- kæde

- udfordre

- udfordringer

- chatbot

- afkrydset

- Borgere

- kunde

- kunder

- Cloud

- samarbejdet

- samarbejde

- kommer

- Virksomheder

- fuldføre

- komplekse

- Compliance

- komponent

- forstå

- konfigureret

- Tilslut

- tilslutning

- består

- konstant

- indhold

- sammenhæng

- kontinuerligt

- Samtale

- konversation

- samtaler

- Koste

- crawler

- skabe

- oprettet

- skaber

- besværlig

- kunde

- Kundeoplevelse

- Kundetilfredshed

- Kunder

- nedskæringer

- dashboards

- data

- Database

- databaser

- Dato

- dag

- afgørelser

- dybere

- levere

- levering

- Efterspørgsel

- demonstrerer

- Afdeling

- indsætte

- implementering

- dybde

- ønskes

- detail

- bestemmes

- udviklet

- Udvikling

- forskellige

- differentieret

- svært

- digital

- Digital Transformation

- Direktør

- diskutere

- dyk

- do

- Domæner

- ned

- dramatisk

- køre

- optjent

- nemt

- let

- uddannelsesmæssige

- effektivitet

- indsats

- enten

- indlejring

- Medarbejder

- medarbejdere

- muliggør

- muliggør

- ende til ende

- engagerende

- Engelsk

- Enterprise

- virksomheder

- miljøer

- eskalere

- etableret

- ejendom

- evigt skiftende

- Hver

- hver dag

- evolution

- udvikle sig

- udviklende

- Excellence

- eksisterende

- erfaring

- omfattende

- Omfattende oplevelse

- ekstern

- ekstrakt

- ekstremt

- Ansigtet

- lettes

- FAQ

- hurtigere

- Funktionalitet

- Fields

- filtrere

- finansielle

- finansielle tjenesteydelser

- Finde

- fem

- flow

- Fokus

- fokuserede

- efter

- Til

- Foundation

- Framework

- rammer

- fra

- frustrerende

- frustration

- funktion

- funktionel

- funktionalitet

- funktioner

- yderligere

- fremtiden

- huller

- generere

- genereret

- genererer

- generative

- Generativ AI

- få

- Global

- kloden

- gruppe

- Guides

- Have

- he

- Helse

- hjælpe

- hjælpe

- højt niveau

- ansættelser

- historie

- besidder

- Vandret

- hostede

- HOURS

- Hvordan

- HTML

- http

- HTTPS

- Mennesker

- Jagt

- ID

- identificeret

- illustrerer

- gennemføre

- forbedret

- forbedringer

- forbedrer

- forbedring

- in

- omfatter

- medtaget

- omfatter

- Herunder

- stigende

- indeks

- indiske

- industrier

- industrien

- brancheførende

- oplysninger

- informationsteknologi

- innovere

- innovativ

- indgang

- forsikring

- integreret

- integration

- Intelligens

- Intelligent

- hensigt

- interagere

- interaktion

- interaktioner

- interagerer

- grænseflade

- interne

- ind

- Opfindere

- påberåbes

- tingenes internet

- spørgsmål

- IT

- ITS

- Karriere

- fælles

- jpg

- Nøgle

- viden

- Knowledge Management

- Labs

- landskab

- Sprog

- Sprog

- stor

- lancering

- lag

- føre

- leder

- førende

- Leads

- læring

- Politikker

- niveauer

- ligger

- Limited

- LLM

- placeringer

- log

- logget

- maskine

- machine learning

- Maskiner

- Vedligeholdelse

- fastholder

- større

- lave

- maerker

- ledelse

- styring

- Managing Director

- måde

- Produktion

- Marked

- markedsundersøgelse

- massive

- Master

- maksimal

- mekanismer

- Mød

- millioner

- mindste

- ML

- model

- modeller

- modificeret

- penge

- mere

- mest

- meget

- flere

- Natural

- Natural Language Processing

- Natur

- Behov

- behøve

- behov

- netværk

- netværkstrafik

- Ny

- NLP

- ingen

- nu

- of

- tit

- on

- ONE

- online

- drift

- Produktion

- Opportunity

- or

- organisation

- Organiseret

- Andet

- vores

- ud

- udfald

- i løbet af

- oversigt

- parringer

- partner

- dele

- Patenter

- betalinger

- Mennesker

- Udfør

- ydeevne

- udfører

- Personlig

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- politikker

- fattige

- Indlæg

- indsendt

- magt

- brug

- gaver

- Main

- behandle

- Behandlet

- Processer

- forarbejdning

- produktion

- produktivitet

- professionel

- gennemprøvet

- give

- forudsat

- giver

- leverer

- offentlige

- folkesundheden

- forespørgsler

- spørgsmål

- Spørgsmål

- Hurtig

- Raw

- nå

- ægte

- fast ejendom

- realtid

- anbefaler

- Reduceret

- reducerer

- forhold

- Relationer

- relevans

- relevant

- Rapportering

- Rapporter

- Repository

- anmode

- påkrævet

- Krav

- forskning

- Ressourcer

- svar

- reaktioner

- Resultater

- tilbageholdelse

- højre

- Risiko

- roller

- rod

- R

- sagemaker

- samme

- tilfredshed

- gemt

- skalerbar

- Scale

- skalering

- VIDENSKABER

- SDK

- Søg

- søgninger

- sektioner

- sektor

- Sikret

- søger

- set

- valgt

- valg

- Selvbetjening

- sender

- sendt

- stemningen

- tjener

- tjeneste

- Tjenester

- Session

- flere

- delt

- fremvist

- Simpelt

- løsninger

- Løsninger

- Kilde

- Spansk

- specialist

- specialiseret

- tilbringe

- forblive

- Steps

- Stadig

- opbevaring

- forhandler

- ligetil

- Strategisk

- Strategi

- abonnement

- sådan

- forsyne

- forsyningskæde

- support

- Understøttet

- Understøtter

- systemet

- Systemer

- tackle

- Tag

- hold

- hold

- Teknologier

- Teknologier

- Test

- end

- at

- Fremtiden

- oplysninger

- The Source

- deres

- derefter

- Disse

- de

- denne

- Gennem

- tid

- gange

- titan

- Titel

- til

- i dag

- Tokens

- top

- mod

- traditionelle

- Trafik

- Kurser

- Transform

- Transformation

- omdanne

- Oversætte

- to

- forstår

- forstået

- oplåsning

- up-to-date

- opdateringer

- URL

- brug

- brug tilfælde

- anvendte

- Bruger

- Brugergrænseflade

- brugere

- bruger

- ved brug af

- udnytte

- forskellige

- Vast

- lodret

- via

- we

- web

- webservices

- GODT

- var

- hvornår

- hvorvidt

- som

- mens

- med

- inden for

- uden

- workflow

- arbejder

- værre

- år

- yngste

- Din

- zephyrnet