I dag er vi glade for at kunne meddele, at Meta Llama 3 foundation-modeller er tilgængelige igennem Amazon SageMaker JumpStart at implementere og køre inferens. Llama 3-modellerne er en samling af fortrænede og finjusterede generative tekstmodeller.

I dette indlæg gennemgår vi, hvordan du opdager og implementerer Llama 3-modeller via SageMaker JumpStart.

Hvad er Meta Llama 3

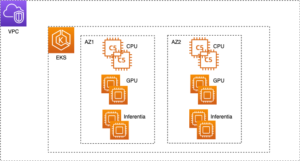

Llama 3 kommer i to parameterstørrelser - 8B og 70B med 8k kontekstlængde - der kan understøtte en bred vifte af use cases med forbedringer i ræsonnement, kodegenerering og instruktionsfølge. Llama 3 bruger en transformerarkitektur, der kun er dekoder, og ny tokenizer, der giver forbedret modelydelse med en størrelse på 128k. Derudover forbedrede Meta procedurer efter træning, som væsentligt reducerede antallet af falske afslag, forbedrede tilpasningen og øgede diversiteten i modelsvar. Du kan nu få de kombinerede fordele ved Llama 3-ydeevne og MLOps-kontroller med Amazon SageMaker-funktioner såsom SageMaker Pipelines, SageMaker Debugger eller containerlogfiler. Derudover vil modellen blive implementeret i et AWS-sikkert miljø under dine VPC-kontroller, hvilket hjælper med at give datasikkerhed.

Hvad er SageMaker JumpStart

Med SageMaker JumpStart kan du vælge mellem et bredt udvalg af offentligt tilgængelige fundamentmodeller. ML-praktikere kan implementere fundamentmodeller til dedikerede SageMaker-instanser fra et netværksisoleret miljø og tilpasse modeller ved hjælp af SageMaker til modeltræning og -implementering. Du kan nu opdage og implementere Llama 3-modeller med nogle få klik Amazon SageMaker Studio eller programmatisk gennem SageMaker Python SDK, så du kan udlede modelydelse og MLOps-kontroller med SageMaker-funktioner som f.eks. SageMaker Pipelines, SageMaker Debuggereller containerlogfiler. Modellen er implementeret i et AWS-sikkert miljø og under din VPC-kontrol, hvilket hjælper med at give datasikkerhed. Llama 3-modeller er tilgængelige i dag til implementering og inferencing i Amazon SageMaker Studio i us-east-1 (N. Virginia), us-east-2 (Ohio), us-west-2 (Oregon), eu-west-1 (Irland) og ap-northeast-1 (Tokyo) AWS-regioner.

Opdag modeller

Du kan få adgang til fundamentmodellerne gennem SageMaker JumpStart i SageMaker Studio UI og SageMaker Python SDK. I dette afsnit gennemgår vi, hvordan du opdager modellerne i SageMaker Studio.

SageMaker Studio er et integreret udviklingsmiljø (IDE), der giver en enkelt webbaseret visuel grænseflade, hvor du kan få adgang til specialbyggede værktøjer til at udføre alle ML-udviklingstrin, fra forberedelse af data til opbygning, træning og implementering af dine ML-modeller. For flere detaljer om, hvordan du kommer i gang og opsætter SageMaker Studio, se Amazon SageMaker Studio.

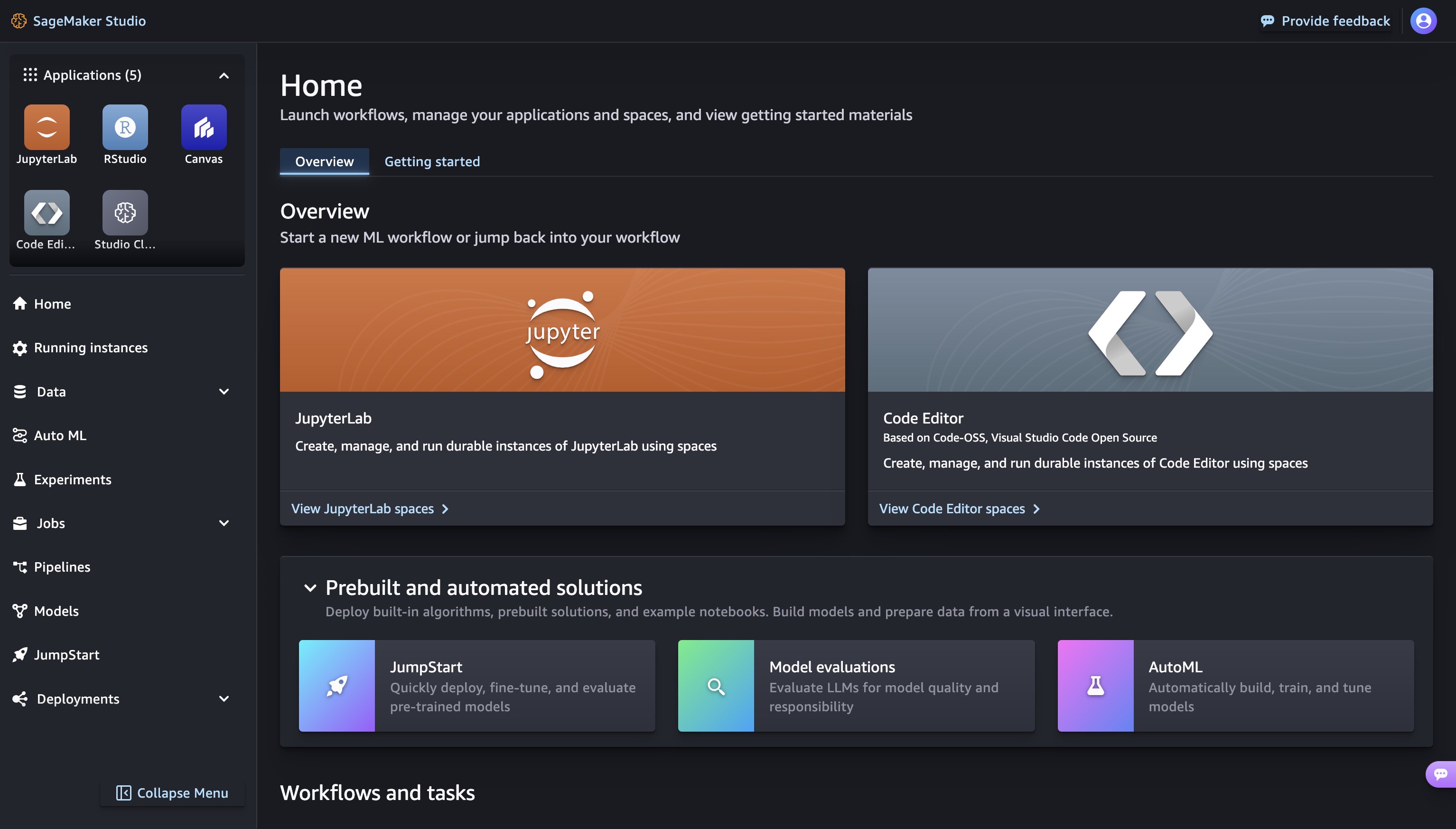

I SageMaker Studio kan du få adgang til SageMaker JumpStart, som indeholder fortrænede modeller, notebooks og præbyggede løsninger, under Præbyggede og automatiserede løsninger.

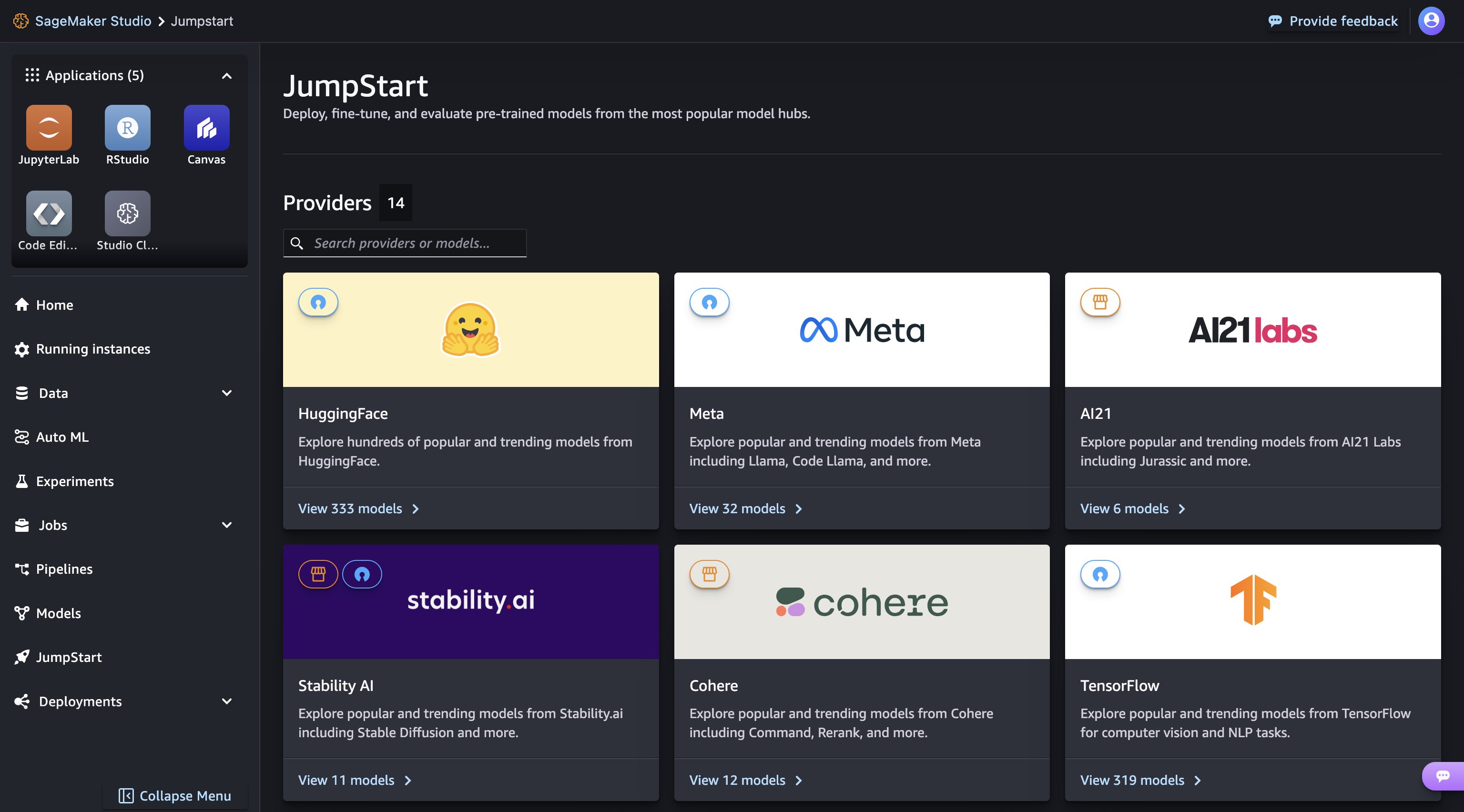

Fra SageMaker JumpStart-landingssiden kan du nemt opdage forskellige modeller ved at browse gennem forskellige hubs, som er opkaldt efter modeludbydere. Du kan finde Llama 3-modeller i Meta-hub. Hvis du ikke kan se Llama 3-modeller, skal du opdatere din SageMaker Studio-version ved at lukke ned og genstarte. For mere information, se Luk ned og opdater Studio Classic Apps.

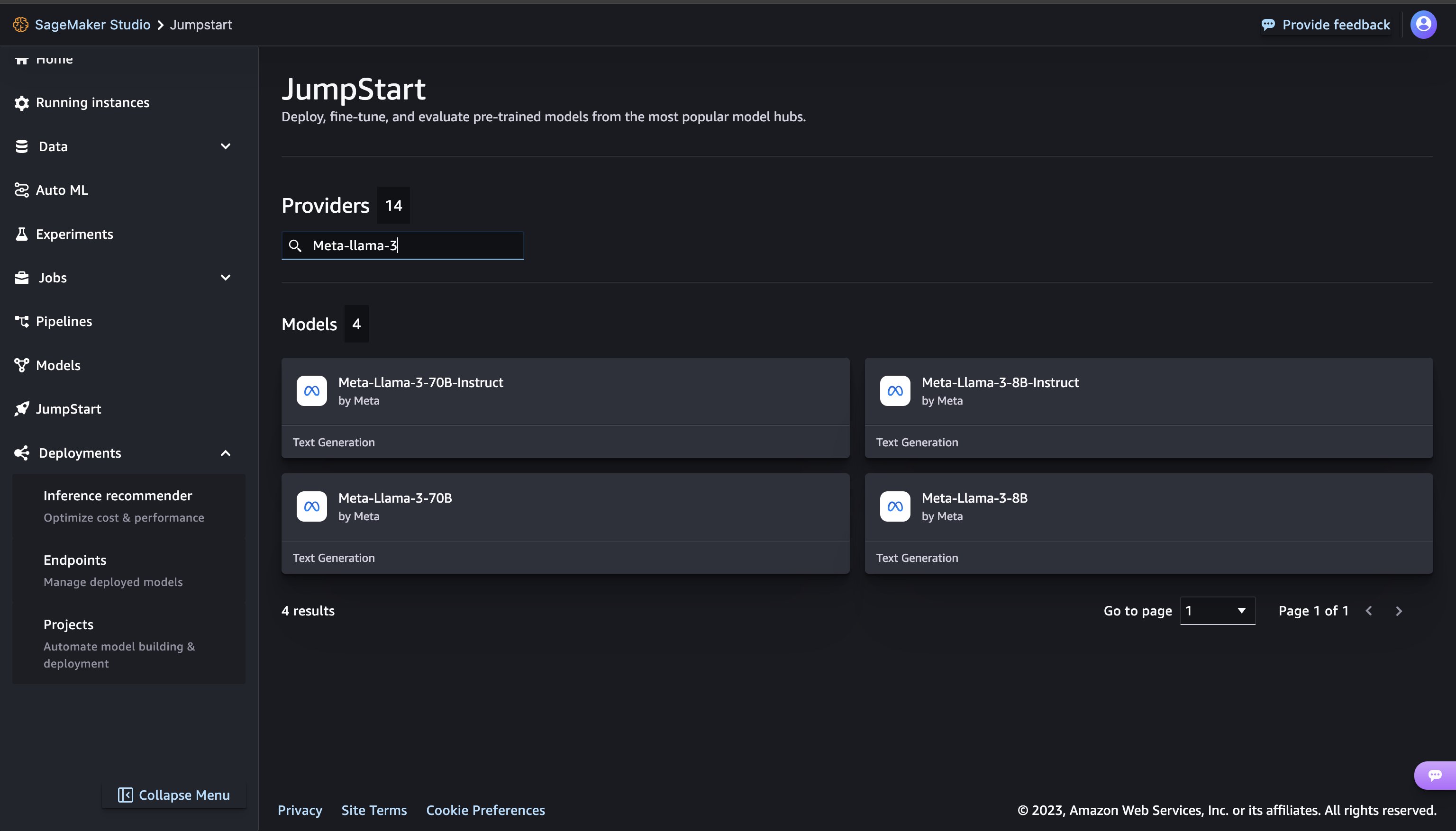

Du kan finde Llama 3-modeller ved at søge efter "Meta-llama-3" fra søgefeltet øverst til venstre.

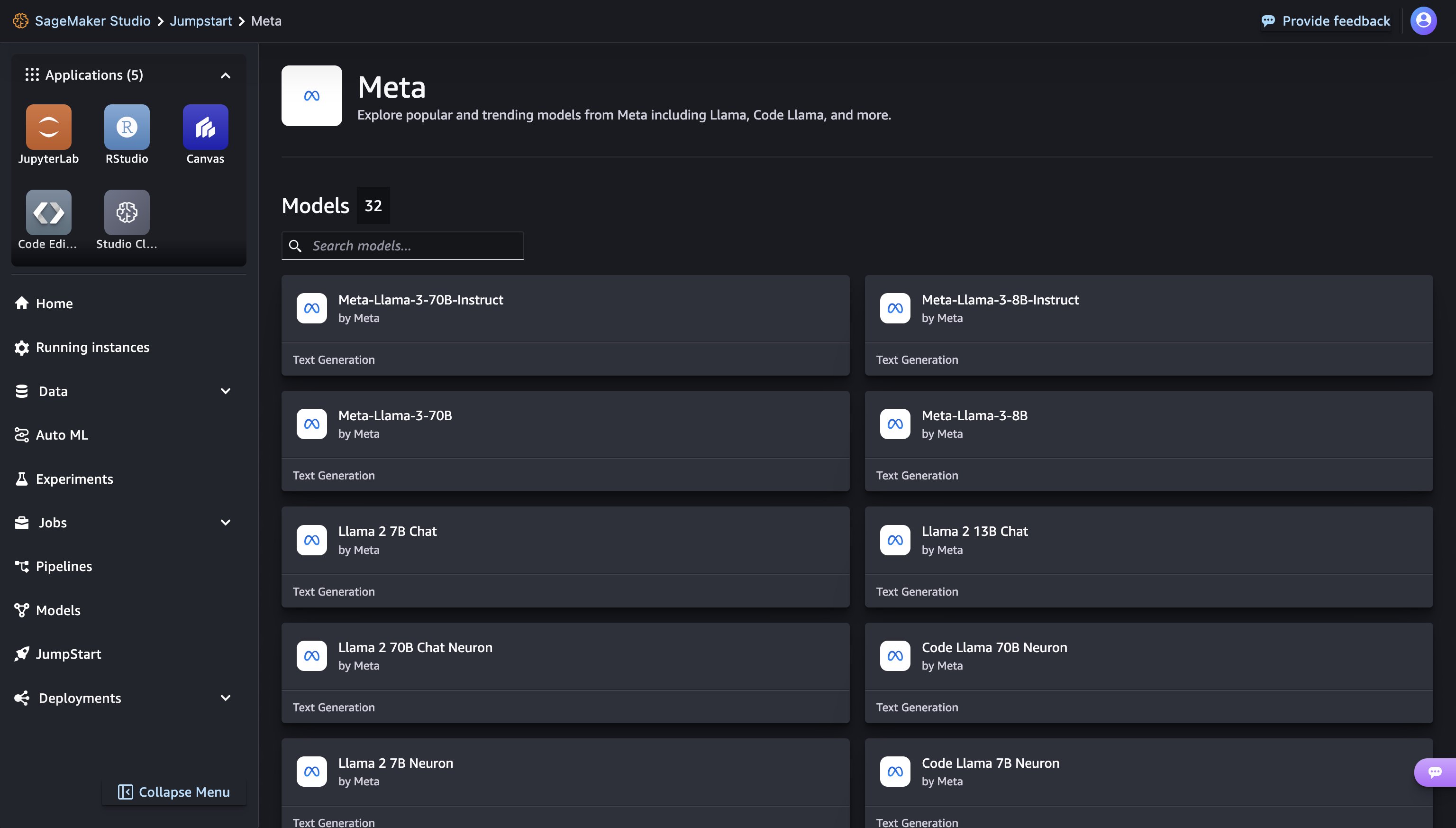

Du kan finde alle Meta-modeller tilgængelige i SageMaker JumpStart ved at klikke på Meta-hub.

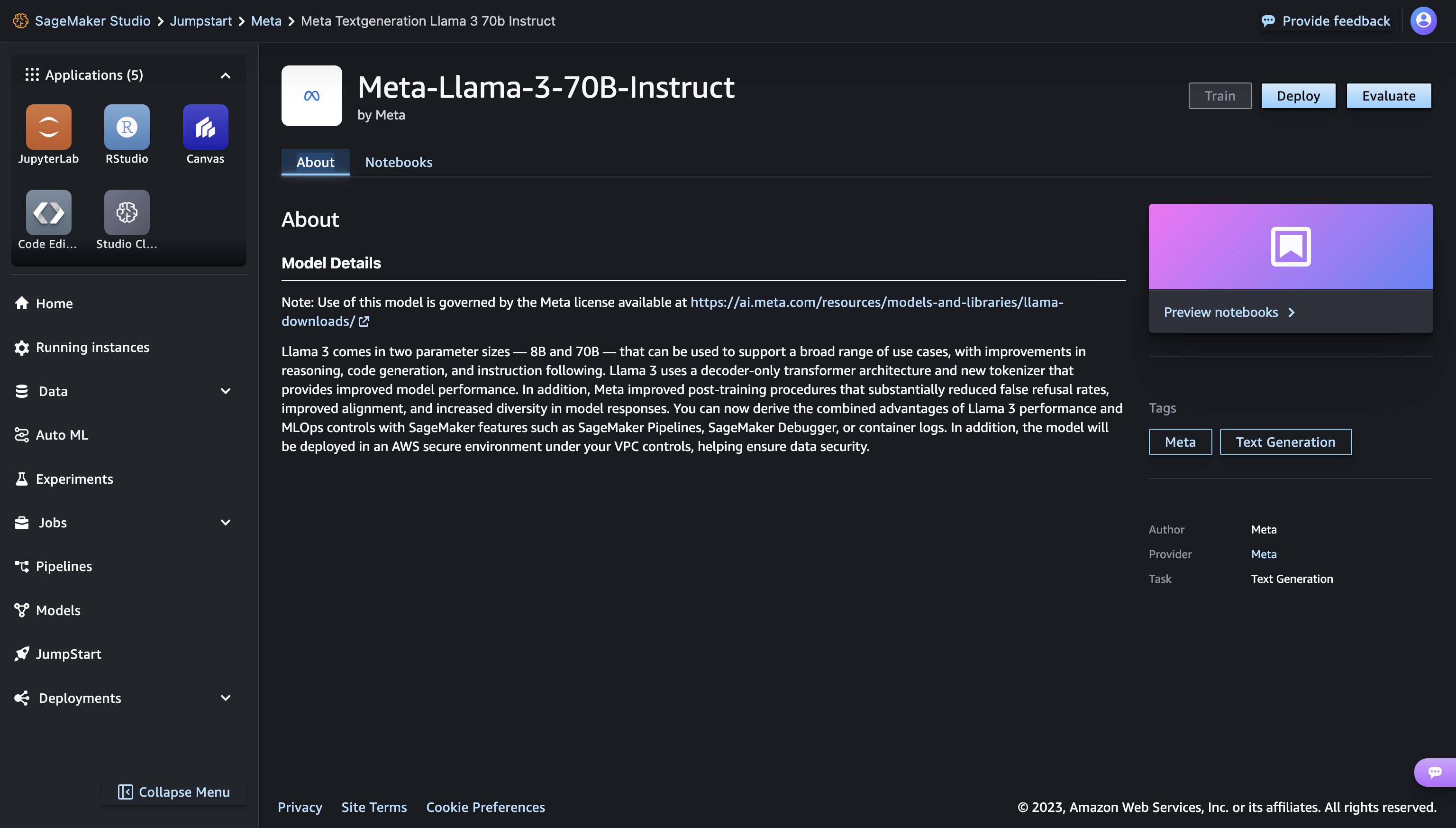

Ved at klikke på et modelkort åbnes den tilsvarende modeldetaljeside, hvorfra du nemt kan implementere modellen.

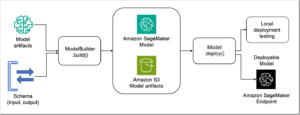

Implementer en model

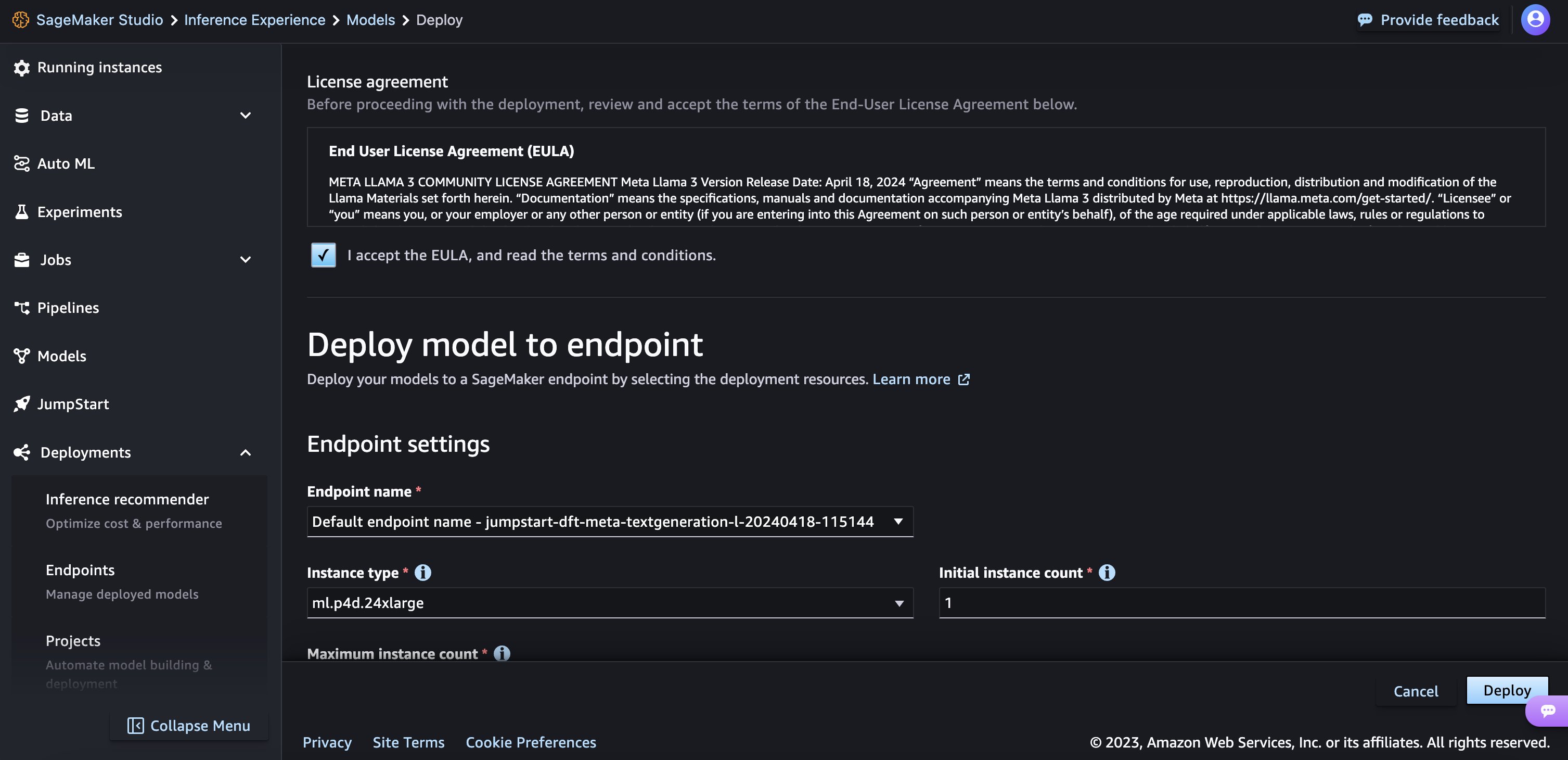

Når du vælger Implementer og anerkender EULA-vilkårene, starter implementeringen.

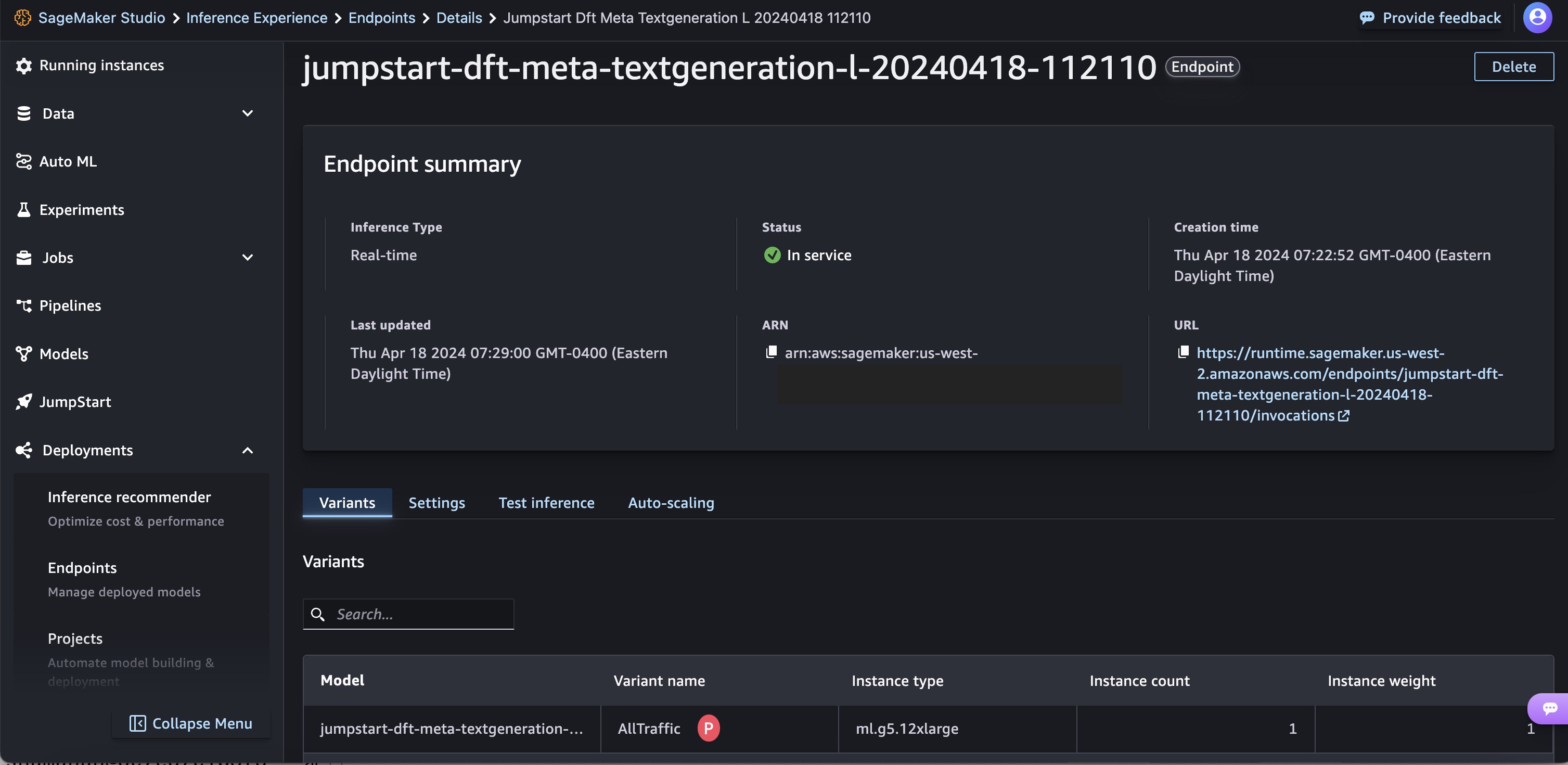

Du kan overvåge implementeringens fremskridt på den side, der vises efter at have klikket på knappen Implementer.

Alternativt kan du vælge Åbn notesbog at implementere gennem eksempelnotesbogen. Eksemplet på notesbogen giver ende-til-ende vejledning om, hvordan man implementerer modellen til slutninger og renser ressourcer.

For at implementere ved hjælp af notesbogen starter du med at vælge en passende model, specificeret af model_id. Du kan implementere enhver af de valgte modeller på SageMaker med følgende kode.

Som standard accept_eula er sat til False. Du skal manuelt acceptere EULA'en for at implementere slutpunktet med succes. Ved at gøre det accepterer du brugerlicensaftalen og politikken for acceptabel brug. Du kan også finde licensaftalen Lama hjemmeside. Dette implementerer modellen på SageMaker med standardkonfigurationer, herunder standardinstanstypen og standard VPC-konfigurationer. Du kan ændre disse konfigurationer ved at angive ikke-standardværdier i JumpStartModel. For at lære mere, se venligst følgende dokumentation.

Følgende tabel viser alle de Llama 3-modeller, der er tilgængelige i SageMaker JumpStart sammen med model_ids, standardforekomsttyper og maksimalt antal samlede tokens (summen af antallet af inputtokens og antallet af genererede tokens) understøttet for hver af disse modeller.

| Modelnavn | Model ID | Max Total Tokens | Standard forekomsttype |

| Meta-Lama-3-8B | meta-tekstgeneration-llama-3-8B | 8192 | ml.g5.12xlarge |

| Meta-Llama-3-8B-instruktion | meta-textgeneration-llama-3-8B-instruct | 8192 | ml.g5.12xlarge |

| Meta-Lama-3-70B | meta-tekstgeneration-llama-3-70b | 8192 | ml.p4d.24xlarge |

| Meta-Llama-3-70B-instruktion | meta-textgeneration-llama-3-70b-instruct | 8192 | ml.p4d.24xlarge |

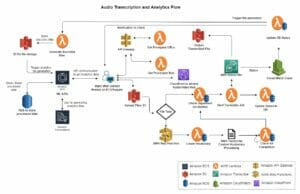

Kør inferens

Når du har implementeret modellen, kan du køre inferens mod det implementerede slutpunkt gennem SageMaker-prædiktoren. Finjusterede instruktionsmodeller (Llama 3: 8B Instruct og 70B Instruct) accepterer en historie med chats mellem brugeren og chatassistenten og genererer den efterfølgende chat. De fortrænede modeller (Llama 3: 8B og 70B) kræver en streng-prompt og udfører tekstfuldførelse på den medfølgende prompt.

Inferensparametre styrer tekstgenereringsprocessen ved slutpunktet. Max nye tokens styrer størrelsen af output genereret af modellen. Dette er ikke det samme som antallet af ord, fordi modellens ordforråd ikke er det samme som det engelsksprogede ordforråd, og hver token er muligvis ikke et engelsksproget ord. Temperaturparameteren styrer tilfældigheden i udgangen. Højere temperatur resulterer i mere kreative og hallucinerede output. Alle inferensparametre er valgfrie.

Eksempelbeskeder for 70B-modellen

Du kan bruge Llama 3-modeller til tekstfuldførelse for ethvert stykke tekst. Gennem tekstgenerering kan du udføre en række forskellige opgaver såsom besvarelse af spørgsmål, sprogoversættelse og følelsesanalyse og meget mere. Input nyttelasten til slutpunktet ser ud som følgende kode:

Følgende er nogle eksempler på prompter og teksten genereret af modellen. Alle udgange genereres med inferensparametre {"max_new_tokens":64, "top_p":0.9, "temperature":0.6}.

I det næste eksempel viser vi, hvordan man bruger Llama 3-modeller med få skud i kontekstindlæring, hvor vi giver træningseksempler til rådighed for modellen. Vi fører kun konklusioner om den installerede model og under denne proces, og modelvægte ændres ikke.

Eksempel på prompter for 70B-Instruct-modellen

Med Llama 3-instruktionsmodeller, som er optimeret til dialogbrug, er input til instruktionsmodellens slutpunkter den tidligere historik mellem chatassistenten og brugeren. Du kan stille spørgsmål kontekstuelle til den samtale, der er sket indtil videre. Du kan også angive systemkonfigurationen, såsom personas, som definerer chatassistentens adfærd. Selvom input-nyttelastformatet er det samme som den forudtrænede basismodel, skal inputteksten formateres på følgende måde:

I denne instruktionsskabelon kan du eventuelt starte med en system rolle og inkludere så mange alternerende roller som ønsket i den turbaserede historie. Den endelige rolle bør altid være assistant og afslut med to nye linjeskift.

Overvej derefter et par eksempler på prompter og svar fra modellen. I det følgende eksempel stiller brugeren et simpelt spørgsmål til assistenten.

I det følgende eksempel har brugeren en samtale med assistenten om turiststeder i Paris. Så forespørger brugeren om den første mulighed anbefalet af chatassistenten.

I de følgende eksempler indstiller vi systemets konfiguration.

Ryd op

Når du er færdig med at køre notesbogen, skal du sørge for at slette alle de ressourcer, du oprettede i processen, så din fakturering stoppes. Brug følgende kode:

Konklusion

I dette indlæg viste vi dig, hvordan du kommer i gang med Llama 3-modeller i SageMaker Studio. Du har nu adgang til fire Llama 3-fundamentmodeller, der indeholder milliarder af parametre. Fordi fundamentmodeller er fortrænede, kan de også hjælpe med at sænke uddannelses- og infrastrukturomkostninger og muliggøre tilpasning til din brugssituation. Tjek ud SageMaker JumpStart i SageMaker Studio nu for at komme i gang.

Om forfattere

Kyle Ulrich er en Applied Scientist II ved AWS

Xin Huang er Senior Applied Scientist hos AWS

Qing Lan er Senior Software Developer Engineer hos AWS

Haotian An er Software Developer Engineer II hos AWS

Christopher Whitten er softwareudviklingsingeniør II hos AWS

Tyler Osterberg er softwareudviklingsingeniør I hos AWS

Manan Shah er Software Development Manager hos AWS

Jonathan Guinegagne er Senior Software Developer Engineer hos AWS

Adriana Simmons er Senior Product Marketing Manager hos AWS

juni vandt er Senior Product Manager hos AWS

Ashish Khetan er Senior Applied Scientist hos AWS

Rachna Chadha er Principal Solution Architect – AI/ML hos AWS

Deepak Rupakula er Principal GTM Specialist hos AWS

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/meta-llama-3-models-are-now-available-in-amazon-sagemaker-jumpstart/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 11

- 120

- 19

- 360-grad

- 43

- 7

- 8

- 8k

- 9

- a

- Om

- Acceptere

- acceptabel

- adgang

- tilgængelig

- anerkende

- tilføje

- tilføjet

- Desuden

- fordele

- Efter

- igen

- mod

- Aftale

- AI / ML

- tilpasning

- Alle

- sammen

- også

- altid

- am

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon SageMaker Studio

- Amazon Web Services

- stemning

- an

- analyse

- ,

- og infrastruktur

- Annoncere

- besvare

- besvarelse

- enhver

- Apple

- anvendt

- passende

- arkitektur

- ER

- Kunst

- AS

- spørg

- spørge

- Assistant

- forbundet

- At

- Atmosfære

- attraktion

- attraktioner

- Automatiseret

- til rådighed

- undgå

- AWS

- bund

- BE

- Husk

- smuk

- fordi

- været

- adfærd

- Beijing

- Tro

- mellem

- fakturerings- og

- milliarder

- Boks

- pauser

- betagende

- bred

- Broken

- Browsing

- Bygning

- bygget

- men

- .

- by

- Opkald

- CAN

- kapital

- kort

- tilfælde

- tilfælde

- lave om

- chatte

- katte

- kontrollere

- Vælg

- By

- Classic

- ren

- kode

- samling

- kombination

- kombineret

- kommer

- Kommunikation

- færdiggørelse

- Konfiguration

- Overvej

- konstant

- indeholder

- Container

- indeholder

- sammenhæng

- kontekstuelle

- kontinuerligt

- kontrol

- kontrol

- Praktisk

- Samtale

- Tilsvarende

- Omkostninger

- skabe

- oprettet

- Kreativ

- afgørende

- Medarbejder kultur

- Kop

- Kunder

- tilpasning

- tilpasse

- data

- datasikkerhed

- de

- dedikeret

- Standard

- definere

- indsætte

- indsat

- implementering

- implementering

- udruller

- udlede

- ønskes

- destinationer

- detail

- detaljer

- Udvikler

- Udvikling

- Dialog

- forskel

- forskellige

- middage

- opdage

- Mangfoldighed

- do

- gør ikke

- gør

- Don

- færdig

- fordoblet

- ned

- i løbet af

- Dusk

- e

- hver

- nemt

- indsats

- muliggøre

- muliggør

- ende

- ende til ende

- Endpoint

- ingeniør

- Engineering

- Engelsk

- nok

- sikring

- Miljø

- Endog

- Hver

- alle

- eksempel

- eksempler

- ophidset

- erfaring

- retfærdig

- falsk

- berømt

- langt

- feat

- featured

- Funktionalitet

- Feet

- få

- film

- endelige

- Finde

- Fornavn

- smag

- Flyde

- flow

- efter

- Fod

- Til

- format

- Foundation

- fire

- Fransk vin

- Fransk

- frisk

- fra

- Generelt

- Generel relativitetsteori

- generere

- genereret

- generation

- generative

- blid

- Tysk

- få

- glas

- Go

- gå

- gradvist

- stor

- banebrydende

- vejledning

- guidet

- ske

- skete

- Hård Ost

- hårdt arbejde

- Have

- sundere

- hjælpe

- hjælpe

- link.

- højere

- historisk

- historie

- hold

- Home

- time

- boliger

- Hvordan

- How To

- HTML

- HTTPS

- Hub

- hubs

- i

- ikoniske

- if

- ii

- importere

- imponerende

- forbedret

- forbedringer

- in

- omfatter

- Herunder

- Forøg

- øget

- stigende

- oplysninger

- Infrastruktur

- indgang

- instans

- øjeblikkeligt

- integreret

- grænseflade

- ind

- irland

- isolerede

- IT

- ITS

- jpg

- lige

- Holde

- Kend

- kendt

- landing

- landmærker

- Sprog

- største

- lancere

- Love

- LÆR

- læring

- til venstre

- Længde

- Licens

- Livet

- Lifted

- lys

- lighter

- ligesom

- Line (linje)

- Lister

- litteratur

- lidt

- leve

- Lives

- Llama

- placeret

- UDSEENDE

- Lot

- lavere

- lavet

- lave

- Making

- leder

- måde

- manuelt

- mange

- Marketing

- max

- maksimal

- Kan..

- betyder

- besked

- Meta

- midnat

- minutter

- at Røreværk Omrøring

- blanding

- ML

- MLOps

- model

- modeller

- Overvåg

- mere

- mest

- Mest Populære

- meget

- museum

- Museer

- Som hedder

- Behov

- behov

- netværk

- Ny

- næste

- nat

- ingen

- notesbog

- nu

- nummer

- NY

- observation

- observatører

- forekomme

- of

- tilbyde

- tilbyde

- Tilbud

- tit

- Ohio

- Olie

- on

- ONE

- kun

- åbner

- optimal

- optimeret

- Option

- or

- ordrer

- Oregon

- Andre

- vores

- bære

- ud

- output

- udgange

- i løbet af

- side

- parameter

- parametre

- Paris

- del

- Udfør

- ydeevne

- Fysik

- stykke

- Place

- plato

- Platon Data Intelligence

- PlatoData

- spillet

- Vær venlig

- politik

- Populær

- Indlæg

- Predictor

- forberede

- tidligere

- Main

- procedurer

- behandle

- Produkt

- produktchef

- Profiler

- Progress

- prompter

- Forslag

- give

- forudsat

- udbydere

- giver

- offentlige

- offentlig transport

- offentligt

- formål

- sætte

- Python

- spørgsmål

- Spørgsmål

- tilfældighed

- rækkevidde

- priser

- RE

- nået

- årsager

- opskrift

- anbefales

- Reduceret

- henvise

- afslag

- hilsen

- regioner

- relativitetsteori

- kræver

- ressource

- Ressourcer

- reaktioner

- Resultater

- River

- roller

- roller

- romantik

- Værelse

- Kør

- kører

- s

- sagemaker

- SageMaker Pipelines

- salt

- samme

- prøve

- siger

- Videnskabsmand

- SDK

- Søg

- søgning

- Anden

- Sektion

- sikker

- sikkerhed

- se

- valgt

- udvælgelse

- valg

- senior

- stemningen

- Tjenester

- servering

- sæt

- flere

- Shape

- shot

- bør

- Vis

- viste

- Shows

- lukker ned

- signifikant

- Simpelt

- ganske enkelt

- enkelt

- Websteder

- Størrelse

- størrelser

- langsom

- langsomt

- udjævne

- So

- indtil nu

- Software

- softwareudvikling

- løsninger

- Løsninger

- nogle

- Sparkle

- særligt

- specialist

- specificeret

- angiver

- hastighed

- Spot

- stå

- stående

- starte

- påbegyndt

- Stater

- steady

- Steps

- Stands

- stoppet

- strøm

- String

- struktur

- Studio

- Bedøvelse

- efterfølgende

- væsentligt

- Succesfuld

- sådan

- support

- Understøttet

- sikker

- symbol

- systemet

- bord

- skrædder

- Tag

- tager

- tager

- opgaver

- smag

- hold

- skabelon

- vilkår

- tekst

- takke

- at

- Hovedstaden

- verdenen

- derefter

- teori

- Der.

- Disse

- de

- tynd

- denne

- tusinder

- Gennem

- tid

- til

- i dag

- sammen

- token

- Tokens

- tokyo

- også

- værktøjer

- top

- I alt

- Tour

- Tårn

- Kurser

- transformer

- Oversætte

- Oversættelse

- transport

- to

- typen

- typer

- ui

- under

- enestående

- indtil

- Opdatering

- brug

- brug tilfælde

- Bruger

- bruger

- ved brug af

- Værdifuld

- Værdier

- variationer

- række

- forskellige

- udgave

- meget

- via

- visninger

- Virginia

- visuel

- bind

- vs

- gå

- ønskede

- krig

- var

- Vand

- måder

- we

- web

- webservices

- web-baseret

- bryllupper

- GODT

- gik

- Hvad

- hvornår

- som

- mens

- hvid

- hvorfor

- vilje

- vinduer

- VIN

- med

- spekulerer

- ord

- ord

- Arbejde

- world

- Du

- Din

- zephyrnet