- 30. Juni 2014

- Vasilis Vryniotis

- . Keine Kommentare

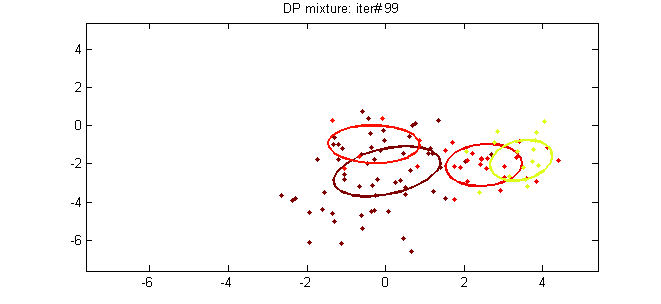

Dieser Artikel ist der fünfte Teil des Tutorials zu Clustering mit DPMM. In den vorherigen Beiträgen haben wir den theoretischen Hintergrund der Methode ausführlich behandelt und ihre mathematischen Darstellungen und Konstruktionsmöglichkeiten beschrieben. In diesem Beitrag werden wir versuchen, die Theorie mit der Praxis zu verknüpfen, indem wir zwei DPMM-Modelle vorstellen: das Dirichlet Multivariate Normal Mixture Model, das zum Clustering von Gaußschen Daten verwendet werden kann, und das Dirichlet Multinomial Mixture Model, das zum Clustering von Dokumenten verwendet wird.

Update: Das Datumbox Machine Learning Framework ist jetzt Open Source und kostenlos für herunterladen. Schauen Sie sich das Paket com.datumbox.framework.machinelearning.clustering an, um die Implementierung von Dirichlet Process Mixture Models in Java zu sehen.

1. Das Dirichlet Multivariate Normal Mixture Model

Das erste Dirichlet-Prozess-Mischungsmodell, das wir untersuchen werden, ist das Dirichlet-Multivariate-Normalmischungsmodell, mit dem Clustering für kontinuierliche Datensätze durchgeführt werden kann. Das Mischungsmodell ist wie folgt definiert:

![]()

![]()

![]()

Gleichung 1: Dirichlet Multivariate Normal Mixture Model

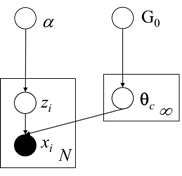

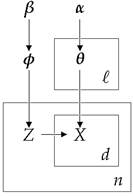

Wie wir oben sehen können, geht das jeweilige Modell davon aus, dass die generative Verteilung die multinomiale Gaußsche Verteilung ist, und verwendet den chinesischen Restaurantprozess wie zuvor für die Clusterzuweisungen. Darüber hinaus für die Basisverteilung G.0 Es wird der Normal-Inverse-Wishart-Prior verwendet vor konjugieren der multivariaten Normalverteilung mit unbekanntem Mittelwert und Kovarianzmatrix. Nachfolgend präsentieren wir das grafische Modell des Mischungsmodells:

Abbildung 1: Grafisches Modell des Dirichlet Multivariate Normal Mixture Model

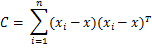

Wie bereits erwähnt, verwenden wir die, um die Clusterzuweisungen abschätzen zu können Eingeklappte Gibbs-Probenahme was erfordert die Auswahl der geeignete konjugierte Prioritäten. Darüber hinaus müssen wir die angegebenen Parameter nachträglich aktualisieren der Prior und die Beweise. Unten sehen wir die MAP-Schätzungen der Parameter für einen der Cluster:

![]()

![]()

![]()

![]()

![]()

Gleichung 2: MAP-Schätzungen für Clusterparameter

Wobei d die Dimensionalität unserer Daten ist und ![]() ist der Stichprobenmittelwert. Darüber hinaus haben wir mehrere Hyperparameter des Normal-Inverse-Wishart wie das μ0 Das ist der anfängliche Mittelwert, κ0 ist der mittlere Bruchteil, der als Glättungsparameter fungiert, ν0 ist der Freiheitsgrad, der auf die Anzahl der Dimensionen und Ψ eingestellt ist0 ist das Produkt der paarweisen Abweichung, das auf die dxd-Identitätsmatrix multipliziert mit einer Konstanten gesetzt wird. Von nun an alle bisherigen Hyperparameter von G.0 wird zur Vereinfachung der Notation mit λ bezeichnet. Schließlich können wir mit all dem oben Gesagten die Wahrscheinlichkeiten abschätzen, die vom Collapsed Gibbs Sampler benötigt werden. Die Wahrscheinlichkeit der Beobachtung i, zu Cluster k zu gehören, ist gegeben, wenn die Clusterzuordnungen, der Datensatz und alle Hyperparameter α und λ von DP und G gegeben sind0 ist unten angegeben:

ist der Stichprobenmittelwert. Darüber hinaus haben wir mehrere Hyperparameter des Normal-Inverse-Wishart wie das μ0 Das ist der anfängliche Mittelwert, κ0 ist der mittlere Bruchteil, der als Glättungsparameter fungiert, ν0 ist der Freiheitsgrad, der auf die Anzahl der Dimensionen und Ψ eingestellt ist0 ist das Produkt der paarweisen Abweichung, das auf die dxd-Identitätsmatrix multipliziert mit einer Konstanten gesetzt wird. Von nun an alle bisherigen Hyperparameter von G.0 wird zur Vereinfachung der Notation mit λ bezeichnet. Schließlich können wir mit all dem oben Gesagten die Wahrscheinlichkeiten abschätzen, die vom Collapsed Gibbs Sampler benötigt werden. Die Wahrscheinlichkeit der Beobachtung i, zu Cluster k zu gehören, ist gegeben, wenn die Clusterzuordnungen, der Datensatz und alle Hyperparameter α und λ von DP und G gegeben sind0 ist unten angegeben:

![]()

![]()

Gleichung 3: Wahrscheinlichkeiten, die von Gibbs Sampler für MNMM verwendet werden

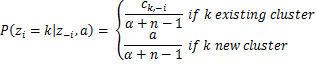

Wo zi ist die Clusterzuordnung der Beobachtung xi, X1: n ist der vollständige Datensatz, z-i ist die Menge der Clusterzuweisungen ohne die der ith Beobachtung, x-i ist der vollständige Datensatz ohne das ith Beobachtung, ck,-ich ist die Gesamtzahl der Beobachtungen, die dem Cluster k ohne i zugeordnet sindth Beobachtung während ![]() und

und ![]() sind der Mittelwert und die Kovarianzmatrix des Clusters k ohne ith Überwachung.

sind der Mittelwert und die Kovarianzmatrix des Clusters k ohne ith Überwachung.

2. Das Dirichlet-Multinomial-Mischungsmodell

Das Dirichlet-Multinomial-Mischungsmodell wird verwendet, um eine Clusteranalyse von Dokumenten durchzuführen. Das jeweilige Modell weist eine etwas kompliziertere Hierarchie auf, da es die Themen / Kategorien der Dokumente, die Wortwahrscheinlichkeiten innerhalb jedes Themas, die Clusterzuweisungen und die generative Verteilung der Dokumente modelliert. Ziel ist es, unbeaufsichtigt zu lernen und eine Liste von Dokumenten zu gruppieren, indem sie Gruppen zugewiesen werden. Das Mischungsmodell ist wie folgt definiert:

![]()

![]()

![]()

![]()

Gleichung 4: Dirichlet-Multinomial-Mischungsmodell

Wobei φ die Themenwahrscheinlichkeiten modelliert, zi ist eine Themenauswahl, θk sind die Wortwahrscheinlichkeiten in jedem Cluster und xich, j repräsentiert die Dokumentwörter. Wir sollten beachten, dass diese Technik die verwendet Bag-of-Words-Framework Dies stellt die Dokumente als ungeordnete Sammlung von Wörtern dar, ohne Berücksichtigung von Grammatik und Wortreihenfolge. Diese vereinfachte Darstellung wird üblicherweise bei der Verarbeitung natürlicher Sprache und beim Abrufen von Informationen verwendet. Nachfolgend präsentieren wir das grafische Modell des Mischungsmodells:

Abbildung 2: Grafisches Modell des Dirichlet-Multinomial-Mischungsmodells

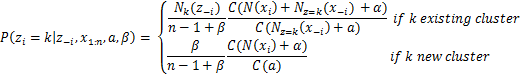

Das jeweilige Modell verwendet Multinomiale diskrete Verteilung für die generative Verteilung und Dirichlet-Verteilungen für die Priors. Das ℓ ist die Größe unserer aktiven Cluster, das n die Gesamtzahl der Dokumente, das β die a priori erwartete Anzahl von Clustern, während das α die Anzahl der jedem Cluster zugewiesenen Wörter steuert. Um die Wahrscheinlichkeiten abzuschätzen, die von der Eingeklappter Gibbs-Sampler wir benutzen das folgende Gleichung:

![]()

Gleichung 5: Wahrscheinlichkeiten, die von Gibbs Sampler für DMMM verwendet werden

Wobei Γ die Gammafunktion ist, zi ist die Clusterzuordnung von Dokument xi, X1: n ist der vollständige Datensatz, z-i ist die Menge der Clusterzuweisungen ohne die der ith Dokument, x-i ist der vollständige Datensatz ohne das ith Dokument, N.k(z-i) ist die Anzahl der Beobachtungen, die dem Cluster k ohne i zugeordnet sindth Dokument, N.z=k(x-i) ist ein Vektor mit den Zählsummen für jedes Wort für alle Dokumente, die dem Cluster k zugeordnet sind, mit Ausnahme von ith Dokument und N (xi) ist der spärliche Vektor mit den Zählungen jedes Wortes in Dokument xi. Schließlich, wie wir oben sehen können, verwenden Sie den θ, indem Sie den Collapsed Gibbs Sampler mit dem chinesischen Restaurant Process verwendenjk Eine Variable, die die Wahrscheinlichkeit des Wortes j in Thema k speichert, kann integriert werden.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- Bezugsbox

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Maschinelles Lernen & Statistik

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet