Ein von einem Vision Pro-Entwickler gepostetes Video scheint das aktuelle Niveau der Handverfolgungs- und Okklusionsleistung zu zeigen, zu der das neue Headset von Apple in der Lage ist.

Apple Vision Pro, voraussichtlich in den nächsten Monaten auf den Markt kommen, wird die Handverfolgung als primäre Eingabemethode verwenden. Während Interaktionen auf Systemebene Hand-Tracking mit Eye-Tracking für eine „Look-and-Tap“-Modalität kombinieren, können Entwickler auch Anwendungen erstellen, die es Benutzern ermöglichen, direkt mit Anwendungen mit ihren Händen zu interagieren.

Die Handverfolgung auf Vision Pro kann in zwei unterschiedliche Funktionen unterteilt werden: „Handverfolgung“ und „Handokklusion“.

Unter Hand-Tracking versteht man das geschätzte 3D-Modell der Hand, ihrer Gelenke und der Position der Fingerspitzen. Dieses Modell wird verwendet, um zu bestimmen, wann Objekte berührt, gegriffen und mit ihnen interagiert werden.

Bei der Handokklusion geht es darum, wie das System Ihre echte Hand mit virtuellen Inhalten überlagert. Anstatt ein 3D-Modell einer virtuellen Hand in die Szene zu zeichnen, schneidet Vision Pro das Bild Ihrer echten Hände aus, um sie stattdessen in der Szene anzuzeigen. Dies verleiht dem virtuellen Inhalt eine weitere Ebene des Realismus, da Sie Ihre eigenen, einzigartigen Hände sehen können.

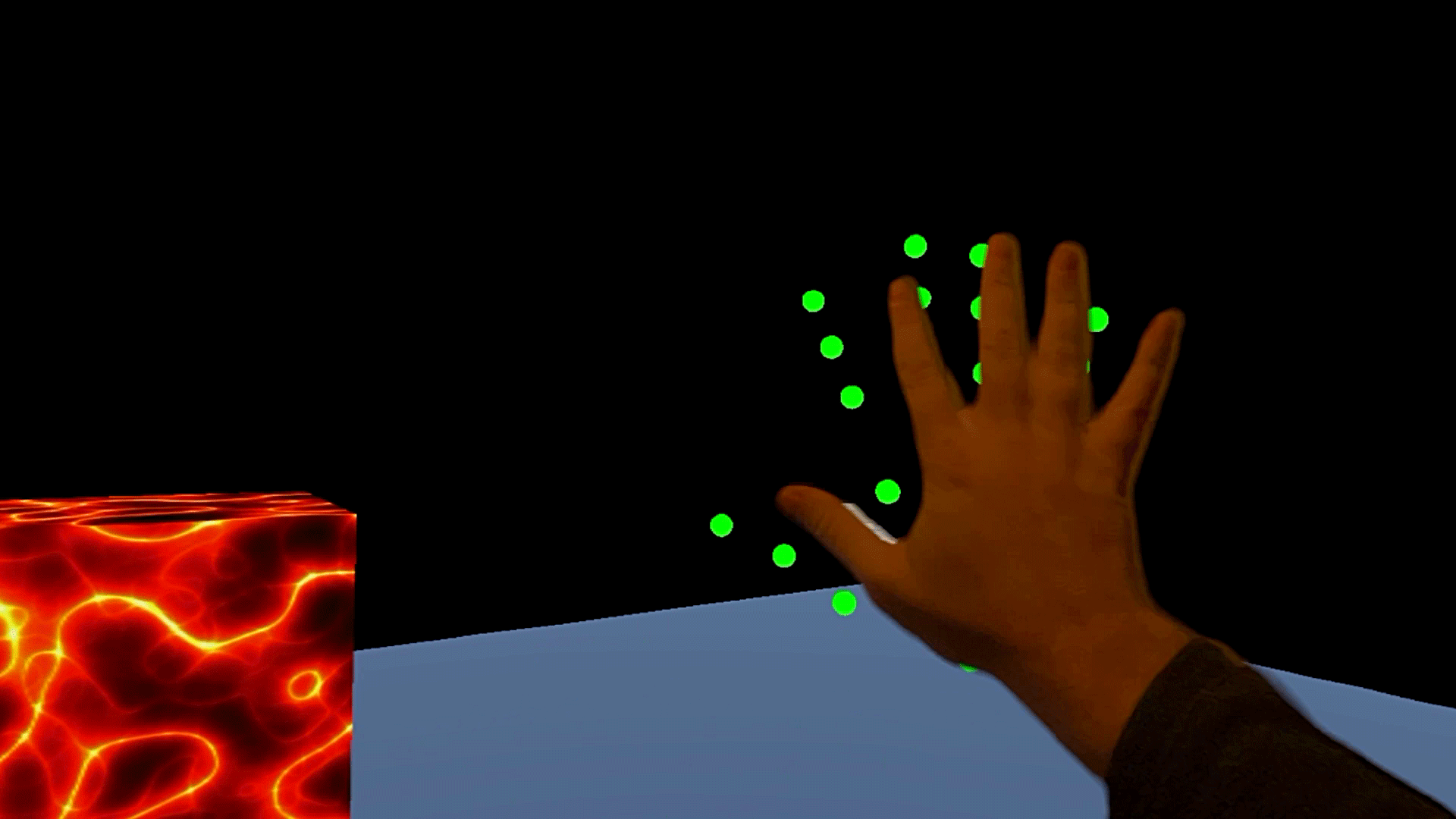

Ein Entwickler, der für Vision Pro mit Unity arbeitet, hat ein Video gepostet, das einen klaren Einblick in die Handverfolgung und Okklusion gibt.

Im Video oben zeigen die echten Hände das Okklusionssystem in Aktion, während die grünen Punkte die geschätzte 3D-Position der Hand zeigen.

Wir können sehen, dass die Handokklusion sehr gut, aber nicht perfekt ist; Wenn Sie vollständig von virtuellen Inhalten umgeben sind und sich schnell bewegen, können Sie einige Ausschnitte an den Handkanten erkennen.

Mittlerweile liegt die tatsächliche Position der Handverfolgung weiter hinter der Handokklusion zurück, etwa 100–200 ms hinterher. Wir können die tatsächliche Latenz der Handverfolgung von Vision Pro jedoch nicht ganz bestimmen, da wir nur eine Ansicht der Hände mit Okklusionsverfolgung haben, mit denen wir sie vergleichen können (die ihrerseits eine gewisse Latenz im Vergleich zu den echten Händen haben).

In diesem Zusammenhang stammt das Video aus einem Unity-Entwicklergespräch, in dem es heißt, dass ihre frühen Experimente mit Vision Pro eine sehr hohe Hand-Tracking-Latenz zeigten, offenbar im Vergleich zu den neuesten Hand-Tracking-Funktionen von Quest. Andere Unity-Entwickler waren sich einig, dass sie auf ihren eigenen Vision Pro-Geräten eine ähnliche Latenz beobachteten.

Bei dem fraglichen Video handelt es sich jedoch um eine Hand-Tracking-Integration innerhalb einer Unity-App, was bedeutet, dass die Hand-Tracking-Leistung und die Latenz möglicherweise zusätzliche Faktoren im Zusammenhang mit Unity haben, die bei Verwendung der Vision Pro-Entwicklungstools von Apples Erstanbietern nicht vorhanden sind. Und wenn man bedenkt, dass das Headset noch nicht auf den Markt gekommen ist und sich diese Tools noch in der Entwicklung befinden, werden wir möglicherweise weitere Verbesserungen sehen, bis das Headset tatsächlich in den Handel kommt.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.roadtovr.com/apple-vision-pro-unity-hand-tracking-occlusion/

- :Ist

- :nicht

- 3d

- a

- oben

- Action

- präsentieren

- berührt das Schneidwerkzeug

- Zusätzliche

- Fügt

- Übereinstimmung

- erlauben

- ebenfalls

- und

- Ein anderer

- App

- erscheint

- Apple

- Anwendungen

- SIND

- um

- AS

- At

- BE

- weil

- hinter

- beide

- Gebrochen

- bauen

- Building

- aber

- by

- CAN

- Fähigkeiten

- fähig

- klar

- kombinieren

- kommt

- vergleichen

- Vergleich

- Berücksichtigung

- Inhalt

- Kontext

- Gespräch

- Strom

- Schnitte

- Angebote

- Bestimmen

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- Entwicklungswerkzeuge

- Geräte

- Direkt

- deutlich

- Dabei

- Zeichnung

- Früh

- vollständig

- geschätzt

- Experimente

- Faktoren

- wenige

- Fingerspitzen

- Aussichten für

- für

- weiter

- gibt

- Blick

- gut

- Grün

- Pflege

- Hände

- Haben

- HEADSET

- GUTE

- Ultraschall

- aber

- HTTPS

- Image

- Verbesserungen

- in

- Varianten des Eingangssignals:

- innerhalb

- beantragen müssen

- Integration

- interagieren

- Interaktionen

- in

- IT

- SEINE

- Latency

- neueste

- starten

- ins Leben gerufen

- Schicht

- Cholesterinspiegel

- aussehen

- Kann..

- Mittel

- Methode

- Modell

- ziehen um

- Neu

- neues Headset

- weiter

- Objekte

- of

- Angebote

- on

- einzige

- auf zu

- Andere

- besitzen

- perfekt

- Leistung

- Plato

- Datenintelligenz von Plato

- PlatoData

- Position

- gepostet

- Gegenwart

- primär

- Pro

- Suche

- Quest Hand-Tracking

- Frage

- schnell

- ganz

- lieber

- Erreicht

- echt

- Realismus

- Betrachten

- sagen

- Szene

- sehen

- Sehen

- erklären

- zeigte

- ähnlich

- So

- einige

- irgendwo

- Immer noch

- Läden

- umgeben

- System

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- sich

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Zeit

- zu

- Werkzeuge

- gerührt

- was immer dies auch sein sollte.

- XNUMX

- einzigartiges

- Einheit

- -

- benutzt

- Nutzer

- Verwendung von

- sehr

- Video

- Anzeigen

- Assistent

- Seh-

- we

- waren

- wann

- welche

- während

- werden wir

- mit

- noch

- Du

- Ihr

- Zephyrnet