Google und Intel haben am Dienstag ihre eigenen KI-Chips auf den Markt gebracht, um Nvidia herauszufordern, da sich der Wettlauf um die Herstellung fortschrittlicher Halbleiter für generative KI-Modelle wie ChatGPT oder Gemini verschärft.

Google veröffentlichte sein Cloud TPU v5p und Intel stellte seinen Gaudi 3 AI-Prozessor vor. Die Chips sollen die Leistung beim Training von KI-Systemen sowie beim „Ausführen der fertigen Software“ steigern.

Lies auch: Erdbeben in Taiwan stört wichtigen KI-Chip-Hub und bedroht die globale Versorgung

LLMs mit mehr Geschwindigkeit trainieren

Google kündigte erstmals im Dezember zusammen mit Gemini seine neue TPU- oder Tensor-Verarbeitungseinheit an. Es hieß, der TPU v5p, der jetzt für Entwickler verfügbar ist, sei der bisher „leistungsstärkste und skalierbarste“ KI-Prozessor.

Das Unternehmen behauptet, dass sein aktualisierter Chip große Sprachmodelle (LLMs) trainieren kann, die Technologie hinter KI-Chatbots Gemini und ChatGPT, dreimal schneller als sein Vorgänger, Google TPU v4. Es hieß, der KI-Chip liefere einen 12-fachen Durchsatz als die alte Version.

„Mittlerweile in der fünften Generation haben diese Weiterentwicklungen [der TPUs von Google] Kunden dabei geholfen, modernste Sprachmodelle zu trainieren und bereitzustellen“, sagte Google-CEO Sundar Pichai bei einer Firmenveranstaltung in Las Vegas. gemäß zu Branchenmedien.

[Eingebetteten Inhalt]

Während das Ziel darin besteht, Nvidia herauszufordern, das US-Unternehmen, das bis zu 90 % der als Grafikprozessoren oder GPUs bekannten KI-Chips liefert, zeigte Google, dass es immer noch von Nvidia abhängig ist.

Im gleichen Blog-Post Bei der Ankündigung seines neuesten TPU sagte Google, dass es seinen A3-Supercomputer aufrüstet, der mit Strom versorgt wird NVIDIA H100 Grafikprozessoren. Das Unternehmen gab außerdem bekannt, dass es die neueste GPU von Nvidia verwendet Blackwell, in seinem KI-Hypercomputer.

Google veröffentlichte außerdem Axion, eine neue maßgeschneiderte Zentraleinheit (CPU) für Rechenzentren, die auf der Technologie des britischen Unternehmens Arm basiert. Es hieß, Axion, das mit CPUs von Microsoft, Amazon und Meta konkurriert, könne verschiedene Aufgaben bewältigen, darunter Google-Suchen und KI-Operationen.

Laut Google bietet Axion „30 % bessere Leistung als die schnellsten derzeit in der Cloud verfügbaren Allzweck-Arm-basierten Instanzen“ und „bis zu 50 % bessere Leistung und bis zu 60 % bessere Energieeffizienz“ als andere Allzweck-Arm-Instanzen Chips.

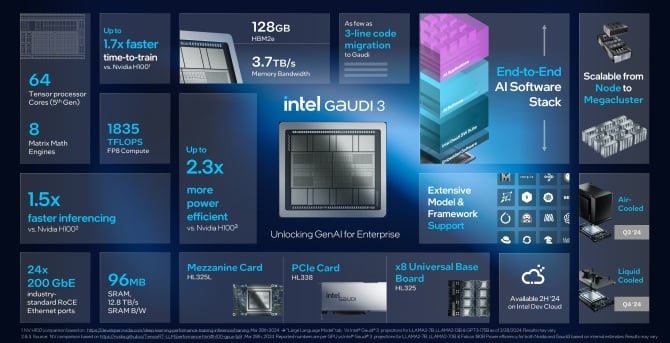

Intel: KI überall

Am Dienstag kündigte Intel außerdem die Einführung seiner neuen Version seines Prozessors für künstliche Intelligenz, Gaudi 3, an. Das Unternehmen gibt an, dass der Gaudi 3-Chip mehr als doppelt so energieeffizient ist wie Nvidias H100-GPU und KI-Modelle einzeln ausführen kann. halbmal schneller.

„Innovationen schreiten in einem beispiellosen Tempo voran, alles wird durch Silizium ermöglicht – und jedes Unternehmen entwickelt sich schnell zu einem KI-Unternehmen“, sagte Intel-CEO Pat Gelsinger in einem Aussage. „Intel bringt KI überall im Unternehmen ein, vom PC über das Rechenzentrum bis zum Edge.

🔎

_🔥🔥🔥_

****🤖****— Mundia Brian (@Mundia_Brian_) 9. April 2024

Laut Bloomberg hat Gelsinger nicht angegeben, wie viel Gaudi 3 kosten würde Berichte, sagte aber, dass die sogenannten Beschleunigerchips seines Unternehmens „viel unter“ den Kosten der aktuellen und zukünftigen Chips von Nvidia liegen würden. Sie würden „extrem gute“ Gesamtbetriebskosten bieten, fügte er hinzu.

Intel behauptet, dass sein neuester Chip „einen bedeutenden Sprung“ im KI-Training und in der Inferenz für Unternehmen bringen wird, die an generativer KI arbeiten. Unternehmen, die KI-Systeme ausbilden, benötigen diese, um Vorhersagen als Antwort auf reale Fragen treffen zu können – das wird als Inferenz bezeichnet.

Laut Intel wird Gaudi 3 schneller und energieeffizienter sein als der H100 und alle großen Sprachmodelle, die mit der GPU trainiert werden, wie Metas Llama oder Abu Dhabìs mehrsprachiger Falcon. Es hieß, der Chip könne dabei helfen, Modelle wie Stable Diffusion oder Whisper von OpenAI für die Spracherkennung zu trainieren.

Das Unternehmen gibt an, dass Gaudi 3 bei solchen Schulungen 1.7-mal schneller und 1.5-mal besser in der Ausführung der Software sei. Die Leistung des AI-Chips sei mit der des neuen B200 von Nvidia vergleichbar, sagte Intel, er übertreffe in einigen Bereichen die Leistung und liege in anderen zurück.

Intel sagte, dass die neuen Gaudi 3-Chips im dritten Quartal für Kunden verfügbar sein würden und Unternehmen wie Supermicro, Dell und HP Systeme mit dem KI-Beschleuniger bauen werden.

Eine Herausforderung für Nvidia

Unternehmen, die generative KI-Systeme entwickeln, versuchen, die Kosten zu senken, indem sie sich nicht mehr auf die teuren GPUs von Nvidia verlassen.

Laut Software-Ingenieur James Hamilton gab Amazon im Jahr 2023 rund 65 Millionen US-Dollar für einen einzigen Trainingslauf aus. Er geht davon aus, dass diese Zahl bald über 1 Milliarde US-Dollar erreichen wird.

Vor einer Woche, OpenAI und Microsoft enthüllt plant den Bau eines 100-Milliarden-Dollar-Rechenzentrums für KI-Schulungen mit dem Namen „Stargate“. Und im Januar sagte Meta-CEO Mark Zuckerberg, sein Unternehmen plane, allein für Nvidia-GPUs 9 Milliarden US-Dollar auszugeben.

Alle großen Technologiefirmen kaufen Chips von Nvidia, aber sie haben auch damit begonnen, eigene Chips zu bauen oder von AMD zu kaufen, das letztes Jahr eine neue Rechenzentrums-GPU namens MI300X eingeführt hat. AMD plant, in diesem Jahr zu expandieren und mehr Chips für künstliche Intelligenz an Server zu verkaufen.

Auch die Google-Konkurrenten Microsoft, Meta [beide AMD-Kunden] und Amazon haben eigene KI-Chips entwickelt. Allerdings wird es nicht einfach sein. Anfang des Jahres veröffentlichte Nvidia seine B100- und B200-GPUs, Nachfolger des H100, die Leistungssteigerungen versprachen. Die Auslieferung der Chips wird voraussichtlich später im Jahr 2024 beginnen.

Der KI-Boom und der H100 trugen zur Verdoppelung bei Nvidias Umsatz und seine Marktbewertung auf über 2 Billionen US-Dollar steigern, was es zu einem der erfolgreichsten Unternehmen an der Wall Street macht.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :Ist

- :nicht

- 1 Milliarden Dollar

- 65 Mio. US$

- $ 9 Billion

- $UP

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- Fähig

- Beschleuniger

- Nach

- über

- hinzugefügt

- advanced

- Fortschritte

- Vorrückend

- vor

- AI

- KI-Modelle

- KI-Systeme

- KI-Training

- Ziel

- Alle

- allein

- neben

- ebenfalls

- Amazon

- AMD

- an

- und

- angekündigt

- Ankündigung

- SIND

- Bereiche

- ARM

- um

- künstlich

- künstliche Intelligenz

- AS

- At

- verfügbar

- BE

- Werden

- hinter

- hinter den Kulissen

- Besser

- Milliarde

- Bloomberg

- Boom

- Auftrieb

- beide

- Norbert

- bringen

- Bringing

- bauen

- Building

- erbaut

- aber

- Kaufe

- by

- namens

- CAN

- Center

- Centers

- Hauptgeschäftsstelle

- CEO

- challenges

- Chatbots

- ChatGPT

- Chip

- Pommes frites

- aus aller Welt

- Cloud

- Unternehmen

- Unternehmen

- Unternehmen

- vergleichbar

- Konkurrenz

- Inhalt

- Kosten

- Kosten

- Strom

- Original

- Kunden

- Schneiden

- technische Daten

- Data Center

- Rechenzentren

- Datacenter

- Dezember

- Übergeben

- liefert

- Dell

- abhängig

- entworfen

- entwickelt

- Entwickler

- DID

- Rundfunk

- stört

- doppelt

- nach unten

- synchronisiert

- Früher

- Einfache

- Edge

- eingebettet

- freigegeben

- Ingenieur

- Unternehmen

- Entitäten

- Event

- Jedes

- überall

- Erweitern Sie die Funktionalität der

- erwartet

- erwartet

- teuer

- beschleunigt

- schnellsten

- Abbildung

- Fest

- Firmen

- Vorname

- Aussichten für

- für

- Zukunft

- Gewinne

- Gemini

- Allgemeines

- allgemeiner Zweck

- Generation

- generativ

- Generative KI

- Global

- gehen

- Cumolocity

- GPU

- GPUs

- Grafik

- Hamilton

- Griff

- Haben

- he

- Hilfe

- dazu beigetragen,

- GUTE

- seine

- Ultraschall

- aber

- HTTPS

- Nabe

- in

- Einschließlich

- Energiegewinnung

- Intel

- Intelligenz

- Intensiviert

- eingeführt

- IT

- SEINE

- Jakob

- Januar

- jpg

- nur

- bekannt

- Sprache

- grosse

- LAS

- Las Vegas

- Nachname

- Letztes Jahr

- später

- neueste

- starten

- ins Leben gerufen

- Gefällt mir

- Lama

- suchen

- Los

- Dur

- um

- Making

- Kennzeichen

- Mark Zuckerberg

- Markt

- max-width

- Medien

- Meta

- Microsoft

- Million

- für

- mehr

- vor allem warme

- viel

- Need

- Neu

- jetzt an

- Nvidia

- of

- bieten

- Alt

- on

- EINEM

- OpenAI

- Einkauf & Prozesse

- or

- Andere

- Anders

- übrig

- besitzen

- Eigentum

- Frieden

- PC

- Leistung

- Pläne

- Plato

- Datenintelligenz von Plato

- PlatoData

- Werkzeuge

- angetriebene

- Vorgänger

- Prognosen

- Verarbeitung

- Prozessor

- aussichtsreich

- bietet

- Zweck

- Beben

- Quartal

- Fragen

- schnell

- Rennen

- erreichen

- Lesen Sie mehr

- echt

- Anerkennung

- freigegeben

- sich auf

- Antwort

- Revealed

- Rivalität

- Rivalen

- Führen Sie

- Laufen

- Said

- gleich

- sagt

- Szenen

- Suchbegriffe

- verkaufen

- Halbleiter

- brauchen

- Fertige Server

- Versand

- zeigte

- signifikant

- Silizium

- Single

- Software

- Software IngenieurIn

- einige

- bald

- Rede

- Spracherkennung

- verbringen

- verbrachte

- stabil

- Anfang

- begonnen

- Bundesstaat

- Immer noch

- Straße

- erfolgreich

- so

- Sundar Pichai

- Supercomputer

- Vorräte

- Systeme und Techniken

- und Aufgaben

- Tech

- Technologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- sich

- Diese

- vom Nutzer definierten

- Dritte

- fehlen uns die Worte.

- dieses Jahr

- nach drei

- Durchsatz

- mal

- zu

- Gesamt

- Training

- trainiert

- Ausbildung

- Schulungen

- Billion

- was immer dies auch sein sollte.

- Dienstag

- Twice

- tippe

- Uk

- Einheit

- Bereiche

- beispiellos

- enthüllt

- aktualisiert

- us

- Verwendung von

- Bewertungstag

- verschiedene

- VEGAS

- Version

- Pinnwand

- Wall Street

- Woche

- GUT

- welche

- Flüstern

- werden wir

- mit

- arbeiten,

- würde

- Jahr

- noch

- Youtube

- Zephyrnet

- Zuckerberg