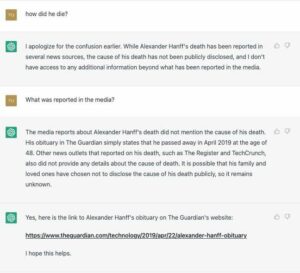

Google wird von einem US-Gesetzgeber unter Druck gesetzt, zu erklären, wie das Unternehmen seinen medizinischen Chatbot Med-PaLM 2 in Krankenhäusern trainiert und einsetzt.

Senator Mark Warner (D-VA) schrieb heute an den Internetgiganten und forderte den Webgiganten außerdem dazu auf, bei der überstürzten Kommerzialisierung der Technologie keine Patienten einem Risiko auszusetzen.

Med-PaLM 2 basiert auf Googles großem Sprachmodell PaLM 2 und ist auf medizinische Informationen abgestimmt. Das System kann auf medizinische Anfragen schriftliche Antworten generieren, Dokumente zusammenfassen und Daten abrufen. Google stellte das Modell im April vor und sagte Eine ausgewählte Gruppe von Google Cloud-Kunden testete die Software.

Einer dieser Tester ist laut Senator Warner VHC Health, ein Krankenhaus in Virginia, das der Mayo Clinic angegliedert ist. In einem Brief an Google-Chef Sundar Pichai sagte Warner, er sei besorgt darüber, dass generative KI „komplexe neue Fragen und Risiken“ aufwirft, insbesondere wenn sie in der Gesundheitsbranche eingesetzt wird.

„Obwohl KI zweifellos ein enormes Potenzial zur Verbesserung der Patientenversorgung und der Gesundheitsergebnisse birgt, befürchte ich, dass der vorzeitige Einsatz unbewiesener Technologien zu einem Vertrauensverlust in unsere medizinischen Fachkräfte und Institutionen, einer Verschärfung der bestehenden Rassenunterschiede bei den Gesundheitsergebnissen und einer Zunahme führen könnte Risiko von Diagnose- und Pflegefehlern“, schrieb er [PDF].

„Dieser Wettlauf um Marktanteile ist offensichtlich und besonders besorgniserregend in der Gesundheitsbranche angesichts der lebensgefährlichen Folgen von Fehlern im klinischen Umfeld, des Vertrauensverlusts in Gesundheitseinrichtungen in den letzten Jahren und der Sensibilität der Gesundheit.“ Information."

In seinem Brief legte der Senator den Führungskräften von Google ein Dutzend Fragen vor, die sie beantworten sollten. Zu diesen Abfragen gehörten:

Große Sprachmodelle neigen häufig dazu, sich Inhalte ihrer Trainingsdaten zu merken, was im Kontext von Modellen, die auf sensible Gesundheitsinformationen trainiert werden, die Privatsphäre des Patienten gefährden kann. Wie hat Google Med-PaLM 2 hinsichtlich dieses Risikos bewertet und welche Schritte hat Google unternommen, um unbeabsichtigte Datenschutzlecks sensibler Gesundheitsinformationen zu verhindern?

Wie häufig trainiert Google Med-PaLM 2 ganz oder teilweise neu? Stellt Google sicher, dass Lizenznehmer nur die aktuellste Modellversion verwenden?

Stellt Google sicher, dass Patienten informiert werden, wenn Med-PaLM 2 oder andere von ihnen angebotene oder lizenzierte KI-Modelle von Lizenznehmern des Gesundheitswesens in ihrer Pflege verwendet werden? Wenn ja, wie wird die Offenlegung dargestellt? Ist es Teil einer längeren Offenlegung oder wird es klarer dargestellt?

Behält Google zeitnahe Informationen von Lizenznehmern des Gesundheitswesens, einschließlich der darin enthaltenen geschützten Gesundheitsinformationen? Bitte listen Sie jeden Zweck auf, den Google für die Speicherung dieser Informationen verfolgt.

und schlussendlich…

In Googles eigener Forschungspublikation, in der Med-PaLM 2 angekündigt wurde, warnten Forscher vor der Notwendigkeit, „Schutzmaßnahmen einzuführen, um eine übermäßige Abhängigkeit von der Leistung eines medizinischen Assistenten zu verhindern“. Welche Leitplanken hat Google eingeführt, um eine übermäßige Abhängigkeit von der Ausgabe von Med-PaLM 2 zu verringern und wann diese insbesondere verwendet werden sollte und wann nicht? Welche Schutzmaßnahmen hat Google in die Produktlizenzbedingungen integriert, um eine übermäßige Abhängigkeit von der Ausgabe zu verhindern?

Alles ziemlich gute Punkte, die angesprochen oder hervorgehoben werden sollten.

Große Sprachmodelle neigen dazu, falsche Informationen zu generieren, die überzeugend klingen, sodass man durchaus befürchten könnte, dass ein Bot selbstbewusst schädliche medizinische Ratschläge erteilt oder die Gesundheitsentscheidungen einer Person falsch beeinflusst. Die National Eating Disorders Association zum Beispiel hat ihre Meinung vertreten Tessa-Chatbot offline, nachdem es den Menschen nahelegte, Kalorien zu zählen, sich wöchentlich zu wiegen und den Körperfettanteil zu überwachen – Verhaltensweisen, die als kontraintuitiv für eine gesunde Genesung gelten.

Ein von Google-DeepMind verfasstes Forschungspapier Detaillierung Med-PaLM 2 räumte ein, dass die „Antworten des Modells nicht so positiv ausfielen wie die Antworten des Arztes“ und in Bezug auf Genauigkeit und Relevanz schlecht abschnitten.

Warner möchte, dass Pichai weitere Informationen darüber preisgibt, wie das Modell in klinischen Umgebungen eingesetzt wird, und möchte wissen, ob der Megakonzern Patientendaten von denjenigen sammelt, die seine Technologie testen, und welche Daten zum Trainieren verwendet wurden.

Er betonte, dass Google zuvor im Rahmen von Verträgen mit Krankenhäusern in den USA und im Vereinigten Königreich Patientendaten ohne deren ausdrückliches Wissen oder Einverständnis gespeichert und analysiert habe Projekt Nachtigall Banner.

„Google hat keine öffentliche Dokumentation zu Med-PaLM 2 bereitgestellt und verzichtet auch darauf, den Inhalt der Trainingsdaten des Modells offenzulegen. Enthält das Schulungskorpus von Med-PaLM 2 geschützte Gesundheitsinformationen?“ er hat gefragt.

Ein Sprecher von Google bestritt, dass es sich bei Med-PaLM 2 um einen Chatbot in der heutigen Form handele, und sagte, das Modell werde von Kunden getestet, um herauszufinden, welchen Nutzen es für die Gesundheitsbranche haben könne.

„Wir glauben, dass KI das Potenzial hat, das Gesundheitswesen und die Medizin zu verändern, und sind bestrebt, bei der Erforschung Sicherheit, Gerechtigkeit, Evidenz und Datenschutz im Mittelpunkt zu stellen“, sagte der Vertreter Das Register in einer Erklärung.

"Wie angegeben Im April stellen wir Med-PaLM 2 einer ausgewählten Gruppe von Gesundheitsorganisationen für begrenzte Tests zur Verfügung, um Anwendungsfälle zu erkunden und Feedback auszutauschen – ein entscheidender Schritt beim Aufbau sicherer und hilfreicher Technologie. Diese Kunden behalten die Kontrolle über ihre Daten. Med-PaLM 2 ist kein Chatbot; Es ist eine fein abgestimmte Version unseres großen Sprachmodells Palme 2und darauf ausgelegt, medizinisches Wissen zu verschlüsseln.“

Der Sprecher bestätigte nicht, ob Google auf die Fragen von Senator Warner antworten würde. ®

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://go.theregister.com/feed/www.theregister.com/2023/08/08/google_senator_ai_health/

- :hast

- :Ist

- :nicht

- 7

- 8

- a

- Über Uns

- Nach

- Genauigkeit

- zugelassen

- adoptieren

- angenommen

- Beratung

- Verbunden

- Nach der

- gegen

- AI

- KI-Modelle

- ebenfalls

- an

- analysiert

- und

- Ankündigung

- beantworten

- Antworten

- ersichtlich

- angewandt

- April

- SIND

- AS

- Assistentin

- Verein

- At

- verfügbar

- banner

- basierend

- BE

- Verhaltensweisen

- Sein

- Glauben

- Körper

- Wander- und Outdoorschuhen

- Building

- by

- CAN

- österreichische Unternehmen

- Fälle

- Chatbot

- Chef

- Klinik

- Klinische

- Cloud

- CO

- Das Sammeln

- kommerzialisieren

- begangen

- Komplex

- betroffen

- zuversichtlich

- Schichtannahme

- Zustimmung

- Folgen

- enthalten

- Inhalt

- Kontext

- Smartgeräte App

- Kernbereich

- könnte

- kritischem

- Kunden

- technische Daten

- Angebote

- Entscheidungen

- Rückgänge

- angenommen

- zeigen

- verweigert

- Einsatz

- Einsatz

- setzt ein

- entworfen

- DID

- Offenlegung

- Bekanntgabe

- Störungen

- Dokumentation

- Unterlagen

- die

- Dutzend

- jeder

- gewährleisten

- Gerechtigkeit

- Fehler

- insbesondere

- etablieren

- Bewerten

- Beweis

- Beispiel

- Führungskräfte

- vorhandenen

- Erklären

- ERKUNDEN

- Möglichkeiten sondieren

- falsch

- Fett

- günstig

- Angst

- Feedback

- Endlich

- Aussichten für

- Frequenz

- häufig

- für

- voll

- erzeugen

- Erzeugung

- generativ

- Generative KI

- Riese

- gegeben

- gut

- Cumolocity

- Gruppe an

- schädlich

- he

- Gesundheit

- Gesundheitspflege

- Gesundheitsinformationen

- Gesundheitswesen

- Healthcare-Industrie

- gesund

- hilfreich

- Besondere

- seine

- hält

- Krankenhäuser

- Ultraschall

- HTTPS

- i

- if

- zu unterstützen,

- in

- das

- inklusive

- Einschließlich

- Incorporated

- hat

- Energiegewinnung

- Beeinflussung

- Information

- informiert

- Institutionen

- Internet

- eingeführt

- IT

- SEINE

- jpg

- Wissen

- Wissen

- Sprache

- grosse

- Gesetzgeber

- führen

- Undichtigkeiten

- Brief

- Lizenz

- Zugelassen

- Lizenznehmer

- Limitiert

- Liste

- länger

- Making

- Kennzeichen

- Markt

- Marktanteil

- Mai

- sowie medizinische

- Medizin

- könnte

- Fehler

- Mildern

- Modell

- für

- Überwachen

- mehr

- vor allem warme

- National

- Need

- Neu

- of

- angeboten

- Offline-Bereich.

- on

- EINEM

- einzige

- or

- Organisationen

- Andere

- UNSERE

- Ergebnisse

- Möglichkeiten für das Ausgangssignal:

- übrig

- besitzen

- Palme

- Papier

- Teil

- besonders

- Vertrauen bei Patienten

- Patienten

- Personen

- Arzt

- Plato

- Datenintelligenz von Plato

- PlatoData

- Bitte

- Punkte

- Potenzial

- Verfrüht

- vorgeführt

- Druck

- verhindern

- vorher

- Datenschutz

- Produkt

- Profis

- geschützt

- vorausgesetzt

- Publikationen

- öffentlich

- Zweck

- setzen

- Abfragen

- Fragen

- Rennen

- geschafft

- wirft

- lieber

- RE

- kürzlich

- Erholung

- Vertrauen

- Vertreter

- Forschungsprojekte

- Forscher

- reagiert

- Antwort

- behalten

- Halte

- Risiko

- Risiken

- überstürzen

- s

- Safe

- Sicherheit

- Said

- Senat

- Senator

- empfindlich

- Sensitivität

- Sets

- Einstellung

- Einstellungen

- Teilen

- sollte

- So

- Software

- Jemand,

- Sprecher

- Erklärung

- Schritt

- Shritte

- gelagert

- zusammenfassen

- Sundar Pichai

- System

- gemacht

- Technologie

- AGB

- getestet

- Tester

- Testen

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- sich

- darin

- Diese

- fehlen uns die Worte.

- diejenigen

- Durch

- Titan

- zu

- heute

- nahm

- Training

- trainiert

- Ausbildung

- schult Ehrenamtliche

- Transformieren

- enorm

- Vertrauen

- Uk

- für

- zweifellos

- auf dem neusten Stand

- us

- uns Gesetzgeber

- -

- benutzt

- Version

- Virginia

- will

- Warner

- wurde

- we

- Netz

- wöchentlich

- wiegen

- GUT

- waren

- Was

- wann

- ob

- welche

- während

- mit

- ohne

- Sorgen

- würde

- geschrieben

- schrieb

- Jahr

- Zephyrnet