Amazon Sage Maker ermöglicht es Ihnen jetzt, die Leistung einer neuen Version eines Model-Serving-Stacks mit der aktuell bereitgestellten Version vor einem vollständigen Produktions-Rollout zu vergleichen, indem Sie eine Bereitstellungssicherheitspraxis verwenden, die als bekannt ist Schattentests. Schattentests können Ihnen helfen, potenzielle Konfigurationsfehler und Leistungsprobleme zu identifizieren, bevor sie sich auf Endbenutzer auswirken. Mit SageMaker müssen Sie nicht in den Aufbau Ihrer Schattentestinfrastruktur investieren, sodass Sie sich auf die Modellentwicklung konzentrieren können. SageMaker kümmert sich um die Bereitstellung der neuen Version neben der aktuellen Version, die Produktionsanforderungen bedient, und leitet einen Teil der Anforderungen an die Schattenversion weiter. Sie können dann die Leistung der beiden Versionen anhand von Metriken wie Latenz und Fehlerrate vergleichen. Dies gibt Ihnen mehr Sicherheit, dass Produktions-Rollouts auf SageMaker-Inferenzendpunkten keine Leistungsregressionen verursachen, und hilft Ihnen, Ausfälle aufgrund versehentlicher Fehlkonfigurationen zu vermeiden.

In diesem Beitrag demonstrieren wir diese neue SageMaker-Funktion. Das entsprechende Beispiel-Notebook ist in diesem GitHub verfügbar Quelle.

Lösungsübersicht

Ihre Modellbereitstellungsinfrastruktur besteht aus dem Modell für maschinelles Lernen (ML), dem Bereitstellungscontainer oder der Compute-Instanz. Betrachten wir die folgenden Szenarien:

- Sie erwägen, ein neues Modell zu fördern, das offline für die Produktion validiert wurde, möchten aber Betriebsleistungsmetriken wie Latenz, Fehlerrate usw. auswerten, bevor Sie diese Entscheidung treffen.

- Sie erwägen Änderungen an Ihrem Bereitstellungsinfrastrukturcontainer, z. B. das Patchen von Schwachstellen oder das Upgrade auf neuere Versionen, und möchten die Auswirkungen dieser Änderungen vor der Heraufstufung in die Produktion bewerten.

- Sie erwägen, Ihre ML-Instanz zu ändern, und möchten auswerten, wie die neue Instanz mit Live-Inferenzanforderungen abschneiden würde.

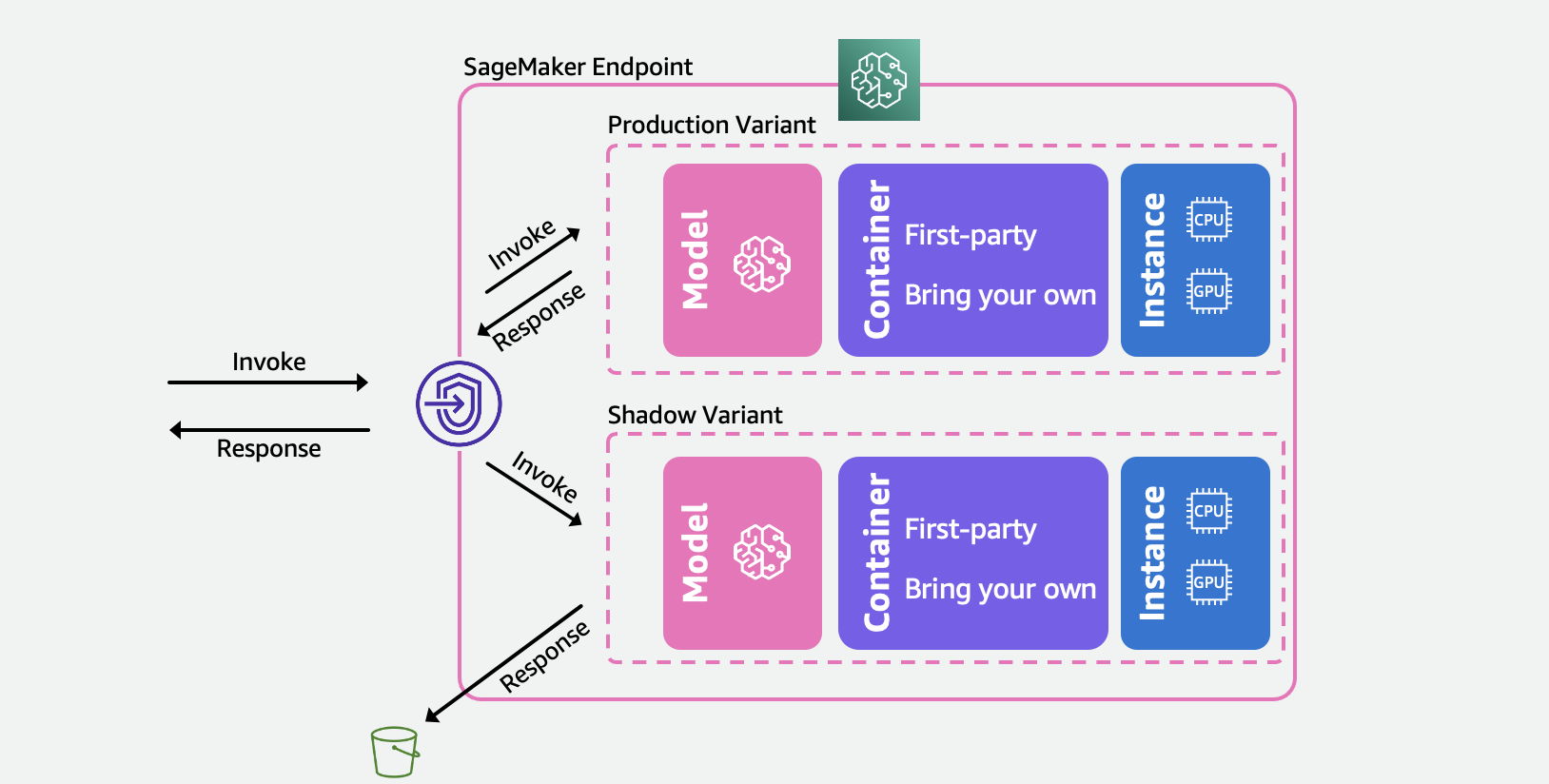

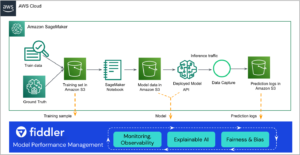

Das folgende Diagramm zeigt unsere Lösungsarchitektur.

Wählen Sie für jedes dieser Szenarien eine Produktionsvariante aus, die Sie testen möchten, und SageMaker stellt die neue Variante automatisch im Shadow-Modus bereit und leitet eine Kopie der Inferenzanforderungen in Echtzeit innerhalb desselben Endpunkts an sie weiter. Nur die Antworten der Produktionsvariante werden an die aufrufende Anwendung zurückgegeben. Sie können die Antworten der Shadow-Variante für den Offline-Vergleich verwerfen oder protokollieren. Optional können Sie die Varianten über ein integriertes Dashboard mit einem direkten Vergleich der Leistungskennzahlen überwachen. Sie können diese Funktion entweder über SageMaker-Inferenzaktualisierungs-Endpunkt-APIs oder über die SageMaker-Konsole verwenden.

Schattenvarianten bauen auf der Produktionsvariantenfunktion in SageMaker-Inferenzendpunkten auf. Um es noch einmal zu wiederholen, a Produktionsvariante besteht aus dem ML-Modell, dem Serving-Container und der ML-Instanz. Da jede Variante unabhängig von anderen ist, können Sie variantenübergreifend unterschiedliche Modelle, Container oder Instance-Typen haben. Mit SageMaker können Sie Auto Scaling-Richtlinien pro Variante festlegen, sodass sie basierend auf der eingehenden Last unabhängig skaliert werden können. SageMaker unterstützt bis zu 10 Produktionsvarianten pro Endpunkt. Sie können entweder eine Variante so konfigurieren, dass sie einen Teil des eingehenden Datenverkehrs empfängt, indem Sie Variantengewichtungen festlegen, oder die Zielvariante in der eingehenden Anfrage angeben. Die Antwort der Produktionsvariante wird zurück an den Aufrufer weitergeleitet.

A Schattenvariante (neu) hat die gleichen Komponenten wie eine Serienvariante. Ein benutzerdefinierter Teil der Anforderungen, bekannt als die Traffic-Sampling-Prozentsatz, wird an die Shadow-Variante weitergeleitet. Sie können die Antwort der Shadow-Variante protokollieren Amazon Simple Storage-Service (Amazon S3) oder verwerfen Sie es.

Beachten Sie, dass SageMaker maximal eine Shadow-Variante pro Endpunkt unterstützt. Für einen Endpunkt mit Schattenvariante kann es maximal eine Produktionsvariante geben.

Nachdem Sie die Produktions- und Schattenvarianten eingerichtet haben, können Sie die überwachen Aufrufmetriken sowohl für Produktions- als auch Schattenvarianten in Amazon CloudWatch unter dem AWS/SageMaker Namensraum. Alle Aktualisierungen am SageMaker-Endpunkt werden mithilfe von orchestriert Blau/Grün-Bereitstellungen und erfolgen ohne Verlust der Verfügbarkeit. Ihre Endpunkte reagieren weiterhin auf Produktionsanforderungen, während Sie Schattenvarianten hinzufügen, ändern oder entfernen.

Sie können diese Funktion auf zwei Arten nutzen:

- Verwaltete Schattentests mit der SageMaker-Konsole – Sie können die Konsole für eine geführte Erfahrung nutzen, um die End-to-End-Reise von Schattentests zu verwalten. Auf diese Weise können Sie Schattentests für einen vordefinierten Zeitraum einrichten, den Fortschritt über ein Live-Dashboard überwachen, nach Abschluss bereinigen und auf die Ergebnisse reagieren.

- Self-Service-Schattentests mit den SageMaker-Inferenz-APIs – Wenn Ihr Bereitstellungsworkflow bereits create/update/delete-endpoint-APIs verwendet, können Sie diese weiterhin verwenden, um Schattenvarianten zu verwalten.

In den folgenden Abschnitten gehen wir durch jedes dieser Szenarien.

Szenario 1 – Verwaltete Schattentests mit der SageMaker-Konsole

Wenn Sie SageMaker auswählen möchten, um den End-to-End-Workflow zum Erstellen, Verwalten und Bearbeiten der Ergebnisse der Shadow-Tests zu verwalten, sollten Sie die Funktion der Shadow-Tests im Abschnitt „Inferenz“ der SageMaker-Konsole verwenden. Wie bereits erwähnt, ermöglicht Ihnen dies, Schattentests für einen vordefinierten Zeitraum einzurichten, den Fortschritt über ein Live-Dashboard zu überwachen, nach Abschluss Bereinigungsoptionen anzuzeigen und auf die Ergebnisse zu reagieren. Um mehr zu erfahren, besuchen Sie bitte die Schattentests Abschnitt unserer Dokumentation für eine Schritt-für-Schritt-Anleitung zu dieser Funktion.

Die Anforderungen:

Die Modelle für Produktion und Schatten müssen auf SageMaker erstellt werden. Bitte wende dich an die CreateModel API hier.

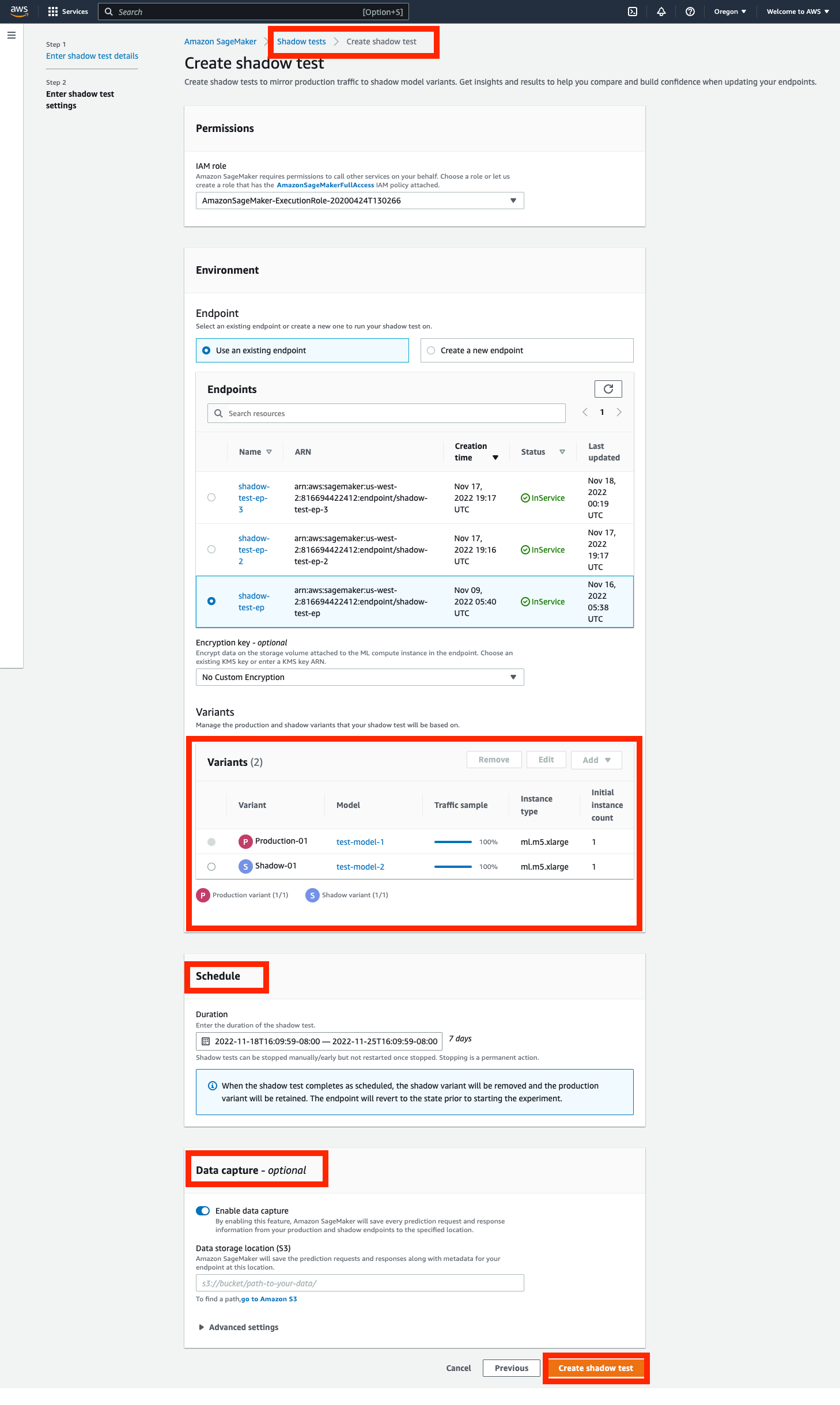

Schritt 1 – Erstellen Sie einen Schattentest

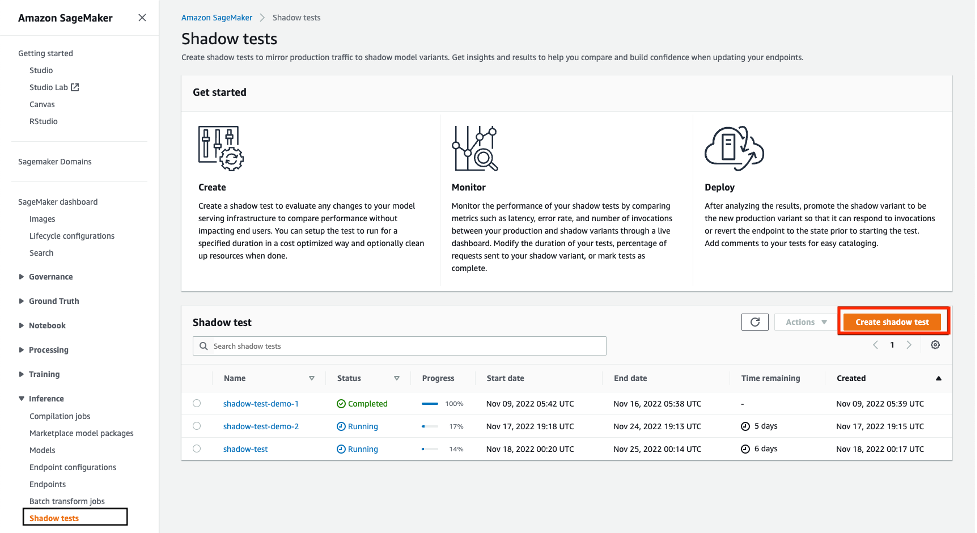

Navigieren Sie zu der Inferenz Abschnitt des linken Navigationsbereichs der SageMaker-Konsole und wählen Sie dann Schattentests. Dadurch gelangen Sie zu einem Dashboard mit allen geplanten, laufenden und abgeschlossenen Schattentests. Klicken 'Schattentest erstellen'. Geben Sie einen Namen für den Test ein und wählen Sie Weiter.

Dadurch gelangen Sie zur Seite mit den Schattentesteinstellungen. Sie können eine vorhandene IAM-Rolle auswählen oder eine erstellen, die die hat AmazonSageMakerFullAccess IAM-Richtlinie beigefügt. Als nächstes wählen Sie 'Neuen Endpunkt erstellen' und geben Sie einen Namen ein (xgb-prod-shadow-1). Sie können eine Produktions- und eine Schattenvariante hinzufügen, die diesem Endpunkt zugeordnet ist, indem Sie auf „Hinzufügen' im Bereich Varianten. Sie können die von Ihnen erstellten Modelle im 'Modell hinzufügen' Dialogbox. Dadurch entsteht eine Produktion oder Variante. Optional können Sie den Instance-Typ und die mit jeder Variante verknüpfte Anzahl ändern.

Der gesamte Datenverkehr geht an die Produktionsvariante und sie antwortet auf Aufrufanforderungen. Sie können einen Teil der Anfragen steuern, die an die Shadow-Variante weitergeleitet werden, indem Sie die ändern Traffic Sampling Percentage.

Sie können die Dauer des Tests von einer Stunde bis zu 30 Tagen steuern. Wenn nicht angegeben, beträgt der Standardwert 7 Tage. Nach diesem Zeitraum wird der Test als abgeschlossen markiert. Wenn Sie einen Test auf einem vorhandenen Endpunkt ausführen, wird dieser nach Abschluss auf den Zustand vor dem Start des Tests zurückgesetzt.

Optional können Sie die Anfragen und Antworten der Shadow-Variante mit erfassen Datenerfassung Optionen. Wenn keine Angabe gemacht wird, werden die Antworten der Schattenvariante verworfen.

Schritt 2 – Überwachen Sie einen Schattentest

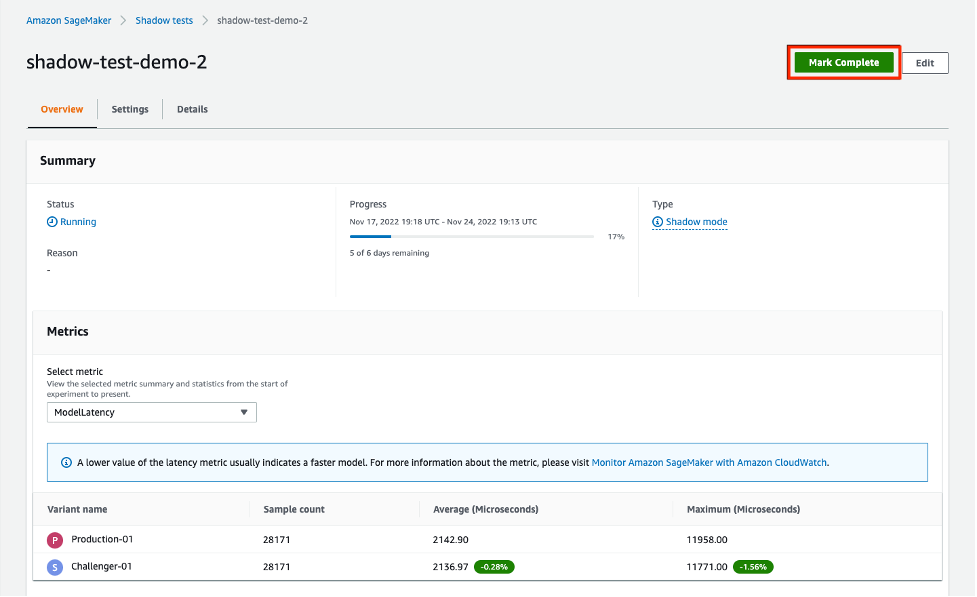

Sie können die Liste der Schattentests anzeigen, indem Sie zu navigieren Shadow Tests Abschnitt unter Inferenz. Klicken Sie auf den im vorherigen Schritt erstellten Shadow-Test, um die Details eines Shadow-Tests anzuzeigen und ihn zu überwachen, während er ausgeführt wird oder nachdem er abgeschlossen wurde.

Der Abschnitt Metriken bietet einen Vergleich der wichtigsten Metriken und überlagerte Diagramme zwischen den Produktions- und Schattenvarianten sowie beschreibende Statistiken. Sie können Aufrufmetriken vergleichen, z ModelLatency und Invocation4xxErrors sowie Instanzmetriken wie z CPUUtilization und DiskUtilization.

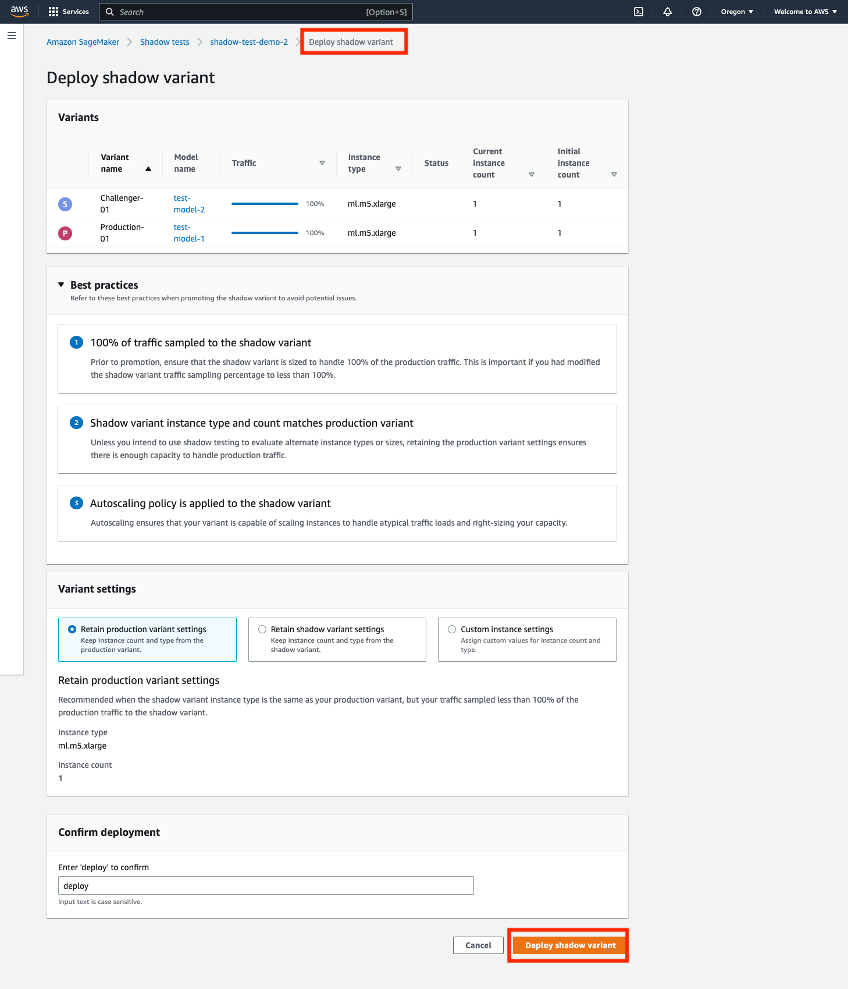

Schritt 3 – Hochstufen der Shadow-Variante auf die neue Produktionsvariante

Beim Vergleich können Sie entweder die Shadow-Variante zur neuen Produktionsvariante heraufstufen oder die Shadow-Variante entfernen. Wählen Sie für diese beiden Optionen 'Als abgeschlossen markieren' oben auf der Seite. Dies bietet Ihnen die Möglichkeit, die Schattenvariante entweder zu fördern oder zu entfernen.

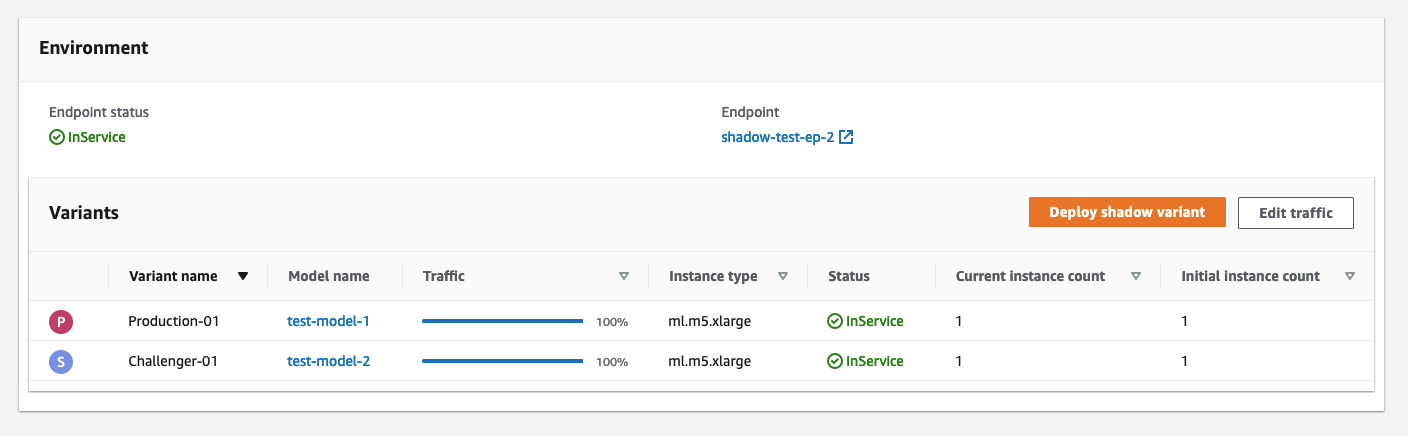

Wenn Sie sich für die Heraufstufung entscheiden, werden Sie zu einer Bereitstellungsseite weitergeleitet, auf der Sie die Varianteneinstellungen vor der Bereitstellung bestätigen können. Vor der Bereitstellung empfehlen wir, Ihre Shadow-Varianten so zu dimensionieren, dass sie 100 % des Aufrufdatenverkehrs verarbeiten können. Wenn Sie keine Schattentests verwenden, um alternative Instance-Typen oder -Größen zu evaluieren, können Sie die Option „Produktionsvarianteneinstellungen beibehalten. Andernfalls können Sie 'Behalten Sie die Schattenvarianteneinstellungen bei. Wenn Sie diese Option wählen, stellen Sie bitte sicher, dass Ihr Traffic-Sampling auf 100 % eingestellt ist. Alternativ können Sie den Instance-Typ und die Anzahl angeben, wenn Sie diese Einstellungen überschreiben möchten.

Nachdem Sie die Bereitstellung bestätigt haben, initiiert SageMaker ein Update an Ihrem Endpunkt, um die Shadow-Variante auf die neue Produktionsvariante hochzustufen. Wie bei allen SageMaker-Updates ist Ihr Endpunkt während des Updates weiterhin betriebsbereit.

Szenario 2: Schattentests mit SageMaker-Inferenz-APIs

In diesem Abschnitt wird beschrieben, wie Sie die vorhandenen SageMaker-APIs create/update/delete-endpoint verwenden, um Schattenvarianten bereitzustellen.

Für dieses Beispiel haben wir zwei XGBoost-Modelle, die zwei verschiedene Versionen der vortrainierten Modelle darstellen. model.tar.gz ist das derzeit in der Produktion eingesetzte Modell. model2 ist das neuere Modell, und wir möchten seine Leistung in Bezug auf Betriebsmetriken wie Latenz testen, bevor wir uns entscheiden, es in der Produktion einzusetzen. Wir setzen ein model2 als Schattenvariante von model.tar.gz. Beide vortrainierten Modelle werden im öffentlichen S3-Bucket gespeichert s3://sagemaker-sample-files. Wir laden zuerst das Modell unserer lokalen Recheninstanz herunter und laden es dann auf S3 hoch.

Die Modelle in diesem Beispiel werden verwendet, um die Wahrscheinlichkeit vorherzusagen, dass ein Mobilfunkkunde seinen aktuellen Mobilfunkbetreiber verlässt. Der von uns verwendete Datensatz ist öffentlich zugänglich und wurde im Buch erwähnt Wissen in Daten entdecken von Daniel T. Larose. Diese Modelle wurden mit dem trainiert Notizbuch zur XGB-Abwanderungsvorhersage im SagMaker. Sie können auch Ihre eigenen vortrainierten Modelle verwenden, in diesem Fall können Sie das Herunterladen von überspringen s3://sagemaker-sample-files und kopieren Sie Ihre eigenen Modelle direkt in den Ordner model/.

Schritt 1 – Erstellen Sie Modelle

Wir laden die Modelldateien in unseren eigenen S3-Bucket hoch und erstellen zwei SageMaker-Modelle. Siehe folgenden Code:

Schritt 2 – Stellen Sie die beiden Modelle als Produktions- und Schattenvarianten an einem Echtzeit-Inferenzendpunkt bereit

Wir erstellen eine Endpunktkonfiguration mit den Produktions- und Shadow-Varianten. Das ProductionVariants und ShadowProductionVariants sind von besonderem Interesse. Beide Varianten haben ml.m5.xlarge-Instanzen mit 4 vCPUs und 16 GiB Arbeitsspeicher, und die anfängliche Instanzanzahl ist auf 1 gesetzt. Siehe den folgenden Code:

Zuletzt erstellen wir die Produktions- und Schattenvariante:

Schritt 3 – Rufen Sie den Endpunkt zum Testen auf

Nachdem der Endpunkt erfolgreich erstellt wurde, können Sie damit beginnen, ihn aufzurufen. Wir versenden ungefähr 3,000 Anfragen nacheinander:

Schritt 4 – Metriken vergleichen

Nachdem wir nun sowohl das Produktions- als auch das Schattenmodell bereitgestellt haben, vergleichen wir die Aufrufmetriken. Eine Liste der zum Vergleich verfügbaren Aufrufmetriken finden Sie unter Überwachen Sie Amazon SageMaker mit Amazon CloudWatch. Beginnen wir mit dem Vergleich der Aufrufe zwischen der Produktions- und der Shadow-Variante.

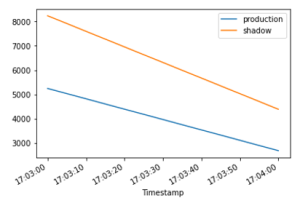

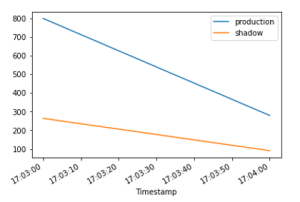

Das InvocationsPerInstance Metrik bezieht sich auf die Anzahl der an die Produktionsvariante gesendeten Aufrufe. Ein Bruchteil dieser Aufrufe, der in der Variantengewichtung angegeben ist, wird an die Schattenvariante gesendet. Der Aufruf pro Instanz wird berechnet, indem die Gesamtzahl der Aufrufe durch die Anzahl der Instanzen in einer Variante dividiert wird. Wie in den folgenden Diagrammen gezeigt, können wir bestätigen, dass sowohl die Produktions- als auch die Schattenvariante Aufrufanforderungen gemäß den in der Endpunktkonfiguration angegebenen Gewichtungen erhalten.

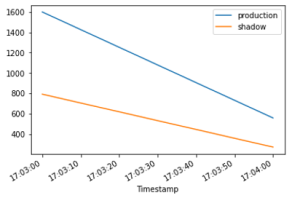

Als nächstes vergleichen wir die Modelllatenz (ModelLatency metrisch) zwischen der Produktions- und der Schattenvariante. Die Modelllatenz ist die Zeit, die ein Modell benötigt, um aus der Sicht von SageMaker zu reagieren. Wir können beobachten, wie die Modelllatenz der Shadow-Variante im Vergleich zur Produktionsvariante abschneidet, ohne Endbenutzer der Shadow-Variante auszusetzen.

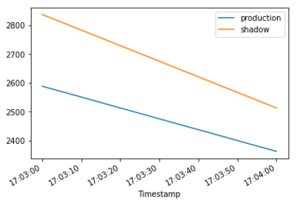

Wir erwarten die Overhead-Latenz (OverheadLatency Metrik), um über Produktions- und Schattenvarianten hinweg vergleichbar zu sein. Overhead-Latenz ist das Intervall, das ab dem Zeitpunkt gemessen wird, an dem SageMaker die Anfrage empfängt, bis es eine Antwort an den Client zurücksendet, abzüglich der Modelllatenz.

Schritt 5 – Werben Sie für Ihre Shadow-Variante

Um das Schattenmodell in die Produktion hochzustufen, erstellen Sie eine neue Endpunktkonfiguration mit current ShadowProductionVariant wie das neue ProductionVariant und entfernen Sie die ShadowProductionVariant. Dadurch wird der Strom entfernt ProductionVariant und die Schattenvariante zur neuen Produktionsvariante zu machen. Wie immer werden alle SageMaker-Updates als Blau/Grün-Bereitstellungen unter der Haube orchestriert, und es gibt keinen Verlust an Verfügbarkeit während der Durchführung des Updates.

Optional können Sie nutzen Bereitstellungsleitlinien wenn Sie während Ihres Updates All-at-on-Traffic-Shifting und automatische Rollbacks verwenden möchten.

Schritt 6 – Aufräumen

Wenn Sie diesen Endpunkt nicht weiter verwenden möchten, sollten Sie den Endpunkt löschen, um zusätzliche Gebühren zu vermeiden und andere in diesem Blog erstellte Ressourcen zu bereinigen.

Zusammenfassung

In diesem Beitrag haben wir eine neue Funktion der SageMaker-Inferenz eingeführt, um die Leistung einer neuen Version eines Model-Serving-Stacks mit der aktuell bereitgestellten Version vor einer vollständigen Produktionseinführung zu vergleichen, wobei eine Bereitstellungssicherheitspraxis verwendet wird, die als Schattentests bekannt ist. Wir haben Sie durch die Vorteile der Verwendung von Shadow-Varianten und Methoden zum Konfigurieren der Varianten mit einem geführt End-to-End-Beispiel. Weitere Informationen zu Schattenvarianten finden Sie unter Schattentests Dokumentation.

Über die Autoren

Raghu Ramesha ist Machine Learning Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Produktions-Workloads in großem Maßstab zu erstellen, bereitzustellen und zu SageMaker zu migrieren. Er ist auf maschinelles Lernen, KI und Computer Vision spezialisiert und hat einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

Raghu Ramesha ist Machine Learning Solutions Architect im Amazon SageMaker Service-Team. Er konzentriert sich darauf, Kunden dabei zu helfen, ML-Produktions-Workloads in großem Maßstab zu erstellen, bereitzustellen und zu SageMaker zu migrieren. Er ist auf maschinelles Lernen, KI und Computer Vision spezialisiert und hat einen Master-Abschluss in Informatik von der UT Dallas. In seiner Freizeit reist und fotografiert er gerne.

Qingwei Li ist Spezialist für maschinelles Lernen bei Amazon Web Services. Er erhielt seinen Ph.D. in Operations Research, nachdem er das Konto seines Beraters für Forschungsstipendien aufgelöst und den versprochenen Nobelpreis nicht geliefert hatte. Derzeit hilft er Kunden in der Finanzdienstleistungs- und Versicherungsbranche beim Aufbau von Lösungen für maschinelles Lernen auf AWS. In seiner Freizeit liest und unterrichtet er gerne.

Qingwei Li ist Spezialist für maschinelles Lernen bei Amazon Web Services. Er erhielt seinen Ph.D. in Operations Research, nachdem er das Konto seines Beraters für Forschungsstipendien aufgelöst und den versprochenen Nobelpreis nicht geliefert hatte. Derzeit hilft er Kunden in der Finanzdienstleistungs- und Versicherungsbranche beim Aufbau von Lösungen für maschinelles Lernen auf AWS. In seiner Freizeit liest und unterrichtet er gerne.

Qiyun Zhao ist Senior Software Development Engineer im Team der Amazon SageMaker Inference Platform. Er ist der leitende Entwickler von Deployment Guardrails und Shadow Deployments und konzentriert sich darauf, Kunden dabei zu helfen, ML-Workloads und -Bereitstellungen in großem Umfang mit hoher Verfügbarkeit zu verwalten. Er arbeitet auch an Plattformarchitekturentwicklungen für die schnelle und sichere Bereitstellung von ML-Jobs und die problemlose Durchführung von ML-Online-Experimenten. In seiner Freizeit liest, spielt und reist er gerne.

Qiyun Zhao ist Senior Software Development Engineer im Team der Amazon SageMaker Inference Platform. Er ist der leitende Entwickler von Deployment Guardrails und Shadow Deployments und konzentriert sich darauf, Kunden dabei zu helfen, ML-Workloads und -Bereitstellungen in großem Umfang mit hoher Verfügbarkeit zu verwalten. Er arbeitet auch an Plattformarchitekturentwicklungen für die schnelle und sichere Bereitstellung von ML-Jobs und die problemlose Durchführung von ML-Online-Experimenten. In seiner Freizeit liest, spielt und reist er gerne.

Tarun Sairam ist Senior Product Manager für Amazon SageMaker Inference. Er ist daran interessiert, die neuesten Trends im maschinellen Lernen kennenzulernen und Kunden dabei zu helfen, diese zu nutzen. In seiner Freizeit fährt er gerne Fahrrad, fährt Ski und spielt Tennis.

Tarun Sairam ist Senior Product Manager für Amazon SageMaker Inference. Er ist daran interessiert, die neuesten Trends im maschinellen Lernen kennenzulernen und Kunden dabei zu helfen, diese zu nutzen. In seiner Freizeit fährt er gerne Fahrrad, fährt Ski und spielt Tennis.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Machine Learning

- Amazon Sage Maker

- Amazon SageMaker-Autopilot

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Schattentests

- Syntax

- Zephyrnet