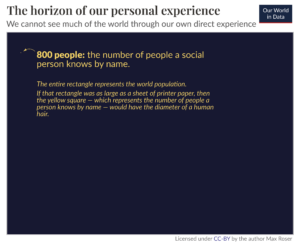

Seit ChatGPT im November letzten Jahres in der Tech-Szene explodierte, hilft es Menschen dabei, alle Arten von Material zu schreiben, Code zu generieren und Informationen zu finden. Es und andere große Sprachmodelle (LLMs) haben Aufgaben von der Annahme von Kundendienstanrufen bis zur Annahme von Fast-Food-Bestellungen erleichtert. Angesichts der Tatsache, wie nützlich LLMs für Menschen in der kurzen Zeit ihres Bestehens waren, wie könnte sich ein ChatGPT für Roboter auf ihre Fähigkeit auswirken, zu lernen und neue Dinge zu tun? Forscher von Google DeepMind beschlossen, dies herauszufinden und veröffentlichten ihre Ergebnisse in einem Blog-Post und Papier, das letzte Woche veröffentlicht wurde.

Sie nennen ihr System RT-2. Es ist die Abkürzung für Robotics Transformer 2 und der Nachfolger von Robotik-Transformator 1, das das Unternehmen Ende letzten Jahres veröffentlichte. RT-1 basierte auf einem kleinen Sprach- und Sehprogramm und war speziell für viele Aufgaben geschult. Die Software wurde in Alphabet X verwendet AlltagsroboterDadurch können sie über 700 verschiedene Aufgaben mit einer Erfolgsquote von 97 Prozent erledigen. Wenn Roboter jedoch aufgefordert wurden, neue Aufgaben zu erledigen, für die sie nicht ausgebildet waren, waren sie mit RT-1 nur in 32 Prozent der Fälle erfolgreich.

RT-2 verdoppelt diese Rate fast und erledigt neue Aufgaben in 62 Prozent der Zeit, die ihm aufgetragen wird. Die Forscher bezeichnen RT-2 als Vision-Language-Action (VLA)-Modell. Es verwendet Text und Bilder, die es online sieht, um neue Fähigkeiten zu erlernen. Das ist nicht so einfach, wie es sich anhört. Es erfordert, dass die Software zunächst ein Konzept „versteht“, dieses Verständnis dann auf einen Befehl oder eine Reihe von Anweisungen anwendet und dann Aktionen ausführt, die diesen Anweisungen entsprechen.

Ein Beispiel nennen die Autoren des Papiers die Müllentsorgung. Bei früheren Modellen musste die Software des Roboters zunächst darauf trainiert werden, Müll zu erkennen. Wenn beispielsweise eine geschälte Banane auf einem Tisch liegt und die Schale daneben liegt, wird dem Bot angezeigt, dass die Schale Müll ist, die Banane jedoch nicht. Anschließend wird ihm beigebracht, wie man die Schale aufnimmt, sie in einen Mülleimer legt und dort ablegt.

RT-2 funktioniert allerdings etwas anders. Da das Modell anhand zahlreicher Informationen und Daten aus dem Internet trainiert wurde, verfügt es über ein allgemeines Verständnis davon, was Müll ist, und obwohl es nicht darauf trainiert ist, Müll wegzuwerfen, kann es die Schritte zur Erledigung dieser Aufgabe zusammensetzen.

Die LLMs, mit denen die Forscher RT-2 trainierten, sind PaLI-X (ein Visions- und Sprachmodell mit 55 Milliarden Parametern) und PaLM-E (was Google ein verkörpertes multimodales Sprachmodell nennt, das speziell für Roboter entwickelt wurde, mit 12 Milliarden Parametern). „Parameter“ bezieht sich auf ein Attribut, das ein maschinelles Lernmodell basierend auf seinen Trainingsdaten definiert. Bei LLMs modellieren sie die Beziehungen zwischen Wörtern in einem Satz und wägen ab, wie wahrscheinlich es ist, dass einem bestimmten Wort ein anderes Wort vorausgeht oder folgt.

Durch das Auffinden der Beziehungen und Muster zwischen Wörtern in einem riesigen Datensatz lernen die Modelle aus ihren eigenen Schlussfolgerungen. Sie können schließlich herausfinden, wie verschiedene Konzepte miteinander in Beziehung stehen, und den Kontext erkennen. Im Fall von RT-2 übersetzt es dieses Wissen in verallgemeinerte Anweisungen für Roboteraktionen.

Diese Aktionen werden für den Roboter als Token dargestellt, die normalerweise zur Darstellung von Text in natürlicher Sprache in Form von Wortfragmenten verwendet werden. In diesem Fall sind die Token Teile einer Aktion und die Software reiht mehrere Token aneinander, um eine Aktion auszuführen. Diese Struktur ermöglicht es der Software auch, Gedankenkettenbegründungen durchzuführen, was bedeutet, dass sie auf Fragen oder Aufforderungen reagieren kann, die ein gewisses Maß an Argumentation erfordern.

Beispiele, die das Team nennt, sind die Auswahl eines Gegenstands, der als Hammer verwendet werden soll, wenn kein Hammer verfügbar ist (der Roboter wählt einen Stein) und die Auswahl des besten Getränks für eine müde Person (der Roboter wählt einen Energy-Drink).

„RT-2 zeigt verbesserte Generalisierungsfähigkeiten und semantisches und visuelles Verständnis über die Roboterdaten hinaus, denen es ausgesetzt war“, schrieben die Forscher in einem Google Blog-Post. „Dazu gehört die Interpretation neuer Befehle und die Reaktion auf Benutzerbefehle durch die Durchführung rudimentärer Überlegungen, beispielsweise Überlegungen zu Objektkategorien oder Beschreibungen auf hoher Ebene.“

Der Traum von Allzweckroboter Das kann Menschen bei allem helfen, was auch immer auf sie zukommt – sei es zu Hause, in einem gewerblichen Umfeld oder in einer industriellen Umgebung –, wird jedoch erst dann möglich sein, wenn Roboter mobil lernen können. Was uns wie der grundlegendste Instinkt erscheint, ist für Roboter eine komplexe Kombination aus dem Verstehen des Kontexts, der Fähigkeit, ihn zu durchdenken, und dem Ergreifen von Maßnahmen zur Lösung von Problemen, mit deren Auftreten man nicht gerechnet hatte. Es ist unmöglich, sie so zu programmieren, dass sie angemessen auf eine Vielzahl ungeplanter Szenarien reagieren. Daher müssen sie in der Lage sein, zu verallgemeinern und aus Erfahrungen zu lernen, genau wie Menschen.

RT-2 ist ein Schritt in diese Richtung. Die Forscher räumen jedoch ein, dass RT-2 zwar semantische und visuelle Konzepte verallgemeinern kann, aber noch nicht in der Lage ist, selbstständig neue Aktionen zu erlernen. Vielmehr wendet es die bereits bekannten Aktionen auf neue Szenarien an. Vielleicht gelingt es RT-3 oder 4, diese Fähigkeiten auf die nächste Stufe zu heben. In der Zwischenzeit, wie das Team abschließend feststellt Blog-Post„Obwohl es noch viel zu tun gibt, um hilfreiche Roboter in menschenzentrierten Umgebungen zu ermöglichen, zeigt uns RT-2 eine spannende Zukunft für die Robotik, die in greifbarer Nähe ist.“

Bild-Kredit: Google DeepMind

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://singularityhub.com/2023/08/02/deepminds-chatgpt-like-brain-for-robots-lets-them-learn-from-the-internet/

- :hast

- :Ist

- :nicht

- $UP

- 12

- 32

- 700

- a

- Fähigkeit

- Fähig

- Über Uns

- anerkennen

- Action

- Aktionen

- Alle

- Alphabet

- bereits

- ebenfalls

- Betrag

- an

- und

- Ein anderer

- Vorweggenommen

- Bewerbung

- passend

- SIND

- um

- AS

- At

- Autoren

- verfügbar

- ein Weg

- Banane

- basierend

- basic

- BE

- war

- Sein

- BESTE

- zwischen

- Beyond

- Milliarde

- Wander- und Outdoorschuhen

- Gehirn

- aber

- by

- rufen Sie uns an!

- Aufrufe

- CAN

- Fähigkeiten

- tragen

- Häuser

- Kategorien

- ChatGPT

- Auswahl

- Code

- Kombination

- wie die

- kommerziell

- Unternehmen

- abschließen

- Komplex

- konzept

- Konzepte

- Kontext

- Kredit

- Kunde

- Kundenservice

- technische Daten

- entschieden

- DeepMind

- Definiert

- Grad

- Einzahlungen

- entwickelt

- anders

- Richtung

- do

- erledigt

- Doppel

- Traum

- Trinken

- jeder

- ermöglichen

- ermöglicht

- ermöglichen

- Ende

- Energie

- Umgebungen

- schließlich

- Beispiel

- unterhaltsame Programmpunkte

- ERFAHRUNGEN

- ausgesetzt

- erleichtert

- FAST

- Abbildung

- Finden Sie

- Suche nach

- Befund

- Vorname

- gefolgt

- Nahrung,

- Aussichten für

- unten stehende Formular

- für

- Zukunft

- Allgemeines

- erzeugen

- Riese

- ABSICHT

- gegeben

- gibt

- Go

- Griff

- Hammer

- Haben

- Hilfe

- hilfreich

- Unternehmen

- High-Level

- Startseite

- Ultraschall

- Hilfe

- HTML

- HTTPS

- Humans

- identifizieren

- if

- Bilder

- Impact der HXNUMXO Observatorien

- unmöglich

- verbessert

- in

- das

- Dazu gehören

- industriell

- Information

- Anleitung

- Internet

- in

- IT

- SEINE

- jpg

- nur

- Wissen

- Sprache

- grosse

- Nachname

- Letztes Jahr

- LERNEN

- lernen

- Lasst uns

- Niveau

- Gefällt mir

- wahrscheinlich

- wenig

- Belastungen

- Maschine

- Maschinelles Lernen

- viele

- Ihres Materials

- max-width

- Kann..

- Bedeutung

- inzwischen

- könnte

- Modell

- für

- vor allem warme

- schlauer bewegen

- mehrere

- Natürliche

- Need

- Neu

- weiter

- nicht

- November

- Objekt

- of

- on

- Online

- einzige

- auf zu

- or

- Bestellungen

- Andere

- übrig

- besitzen

- Papier

- Parameter

- Teile

- Muster

- Personen

- Prozent

- Ausführen

- Durchführung

- vielleicht

- person

- wählen

- Stück

- Plato

- Datenintelligenz von Plato

- PlatoData

- Pop

- früher

- Probleme

- Programm

- Programmierung

- veröffentlicht

- Fragen

- Bewerten

- lieber

- Reagieren

- Grund

- bezieht sich

- Beziehungen

- freigegeben

- vertreten

- vertreten

- erfordern

- erfordert

- Forscher

- Reagieren

- reagiert

- Roboter

- Robotik

- Roboter

- Rock

- s

- Szenarien

- Szene

- scheint

- sieht

- Satz

- kompensieren

- Einstellung

- Short

- gezeigt

- Konzerte

- Einfacher

- da

- Fähigkeiten

- klein

- So

- Software

- LÖSEN

- einige

- speziell

- Schritt

- Shritte

- Immer noch

- Struktur

- Erfolg

- erfolgreich

- Erfolgreich

- so

- System

- Tabelle

- Nehmen

- Einnahme

- Aufgabe

- und Aufgaben

- gelehrt

- Team

- Tech

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- dann

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- obwohl?

- Durch

- Zeit

- müde

- zu

- gemeinsam

- Tokens

- Training

- trainiert

- Ausbildung

- Transformator

- enorm

- Verständnis

- bis

- us

- -

- benutzt

- Mitglied

- verwendet

- Verwendung von

- gewöhnlich

- Vielfalt

- Seh-

- wurde

- Woche

- wiegen

- waren

- Was

- was auch immer

- wann

- welche

- während

- werden wir

- mit

- .

- Word

- Worte

- Arbeiten

- Werk

- würde

- schreiben

- schrieb

- X's

- Jahr

- noch

- Zephyrnet