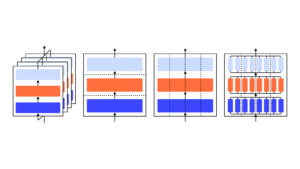

Wir zeigen, dass ein GPT-3-Modell lernen kann, Unsicherheit über seine eigenen Antworten in natürlicher Sprache auszudrücken – ohne Verwendung von Modelllogits. Wenn eine Frage gestellt wird, generiert das Modell sowohl eine Antwort als auch ein Maß an Konfidenz (z. B. „90 % Konfidenz“ oder „hohes Konfidenzniveau“). Diese Ebenen entsprechen Wahrscheinlichkeiten, die gut kalibriert sind. Das Modell bleibt auch bei Verteilungsverschiebungen mäßig kalibriert und reagiert empfindlich auf Unsicherheiten in seinen eigenen Antworten, anstatt menschliche Beispiele zu imitieren. Soweit wir wissen, ist dies das erste Mal, dass ein Modell eine kalibrierte Unsicherheit über seine eigenen Antworten in natürlicher Sprache ausdrückt. Zum Testen der Kalibrierung stellen wir die Aufgabensuite CalibratedMath vor. Wir vergleichen die Kalibrierung der in Worten ausgedrückten Unsicherheit („verbalisierte Wahrscheinlichkeit“) mit der aus Modelllogits extrahierten Unsicherheit. Beide Arten von Unsicherheit sind in der Lage, die Kalibrierung unter Verteilungsverschiebung zu verallgemeinern. Wir liefern auch Beweise dafür, dass die Fähigkeit von GPT-3, die Kalibrierung zu verallgemeinern, von vorab trainierten latenten Darstellungen abhängt, die mit der epistemischen Unsicherheit über seine Antworten korrelieren.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :Ist

- a

- Fähigkeit

- Über Uns

- und

- beantworten

- Antworten

- SIND

- CAN

- fähig

- vergleichen

- Vertrauen

- hängt

- Verteilung

- e

- Beweis

- Beispiele

- express

- zum Ausdruck gebracht

- Vorname

- erstes Mal

- Aussichten für

- für

- erzeugt

- gegeben

- GUTE

- HTTPS

- human

- in

- einführen

- SEINE

- Wissen

- Sprache

- LERNEN

- Niveau

- Cholesterinspiegel

- Karte

- Modell

- für

- Natürliche

- of

- on

- besitzen

- Plato

- Datenintelligenz von Plato

- PlatoData

- die

- Frage

- lieber

- bleibt bestehen

- s

- empfindlich

- verschieben

- erklären

- gezeigt

- Suite

- und Aufgaben

- Einführungen

- Testen

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Diese

- Zeit

- zu

- Unsicherheit

- für

- -

- GUT

- mit

- Worte

- Zephyrnet