-

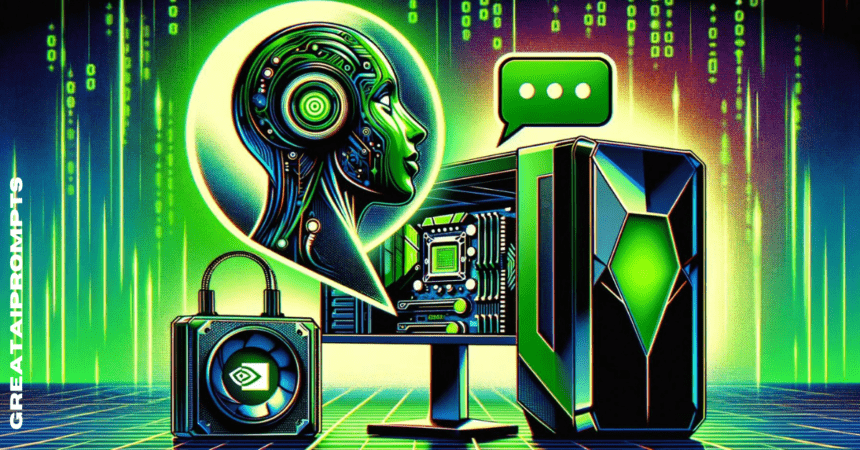

Nvidia Chat mit RTX ist ein großes Sprachmodell auf dem Gerät, das die Informationen auf Ihrem PC nutzt, um Ihre Anfragen zu erfüllen.

-

Es kann auch für Daten im Internet verwendet werden, beispielsweise für Webseiten.

-

Das Modell ist zwar leistungsfähig, es wird jedoch vermutet, dass seine Fähigkeiten stark übertrieben sind.

Nvidia verstärkt sein Engagement in der KI-Revolution, indem es über seine traditionelle Rolle hinausgeht und sich als wichtiger Akteur etabliert. Nach einer Entwicklerkonferenz voller bedeutender Ankündigungen hat Nvidia ein neues Produkt zum Testen vorgestellt: Nvidia Chat mit RTX.

Dieses große Sprachmodell auf dem Gerät läuft vollständig auf Ihrem PC und verwendet lokale Informationen, um auf Anfragen zu reagieren. Ähnlich wie Samsungs Galaxy AI, gestartet mit dem Galaxy S24-SerieNvidia Chat mit RTX, das die meisten KI-Aufgaben auf dem Gerät erledigte, bringt diese Funktion auf PCs und verändert möglicherweise unseren Ansatz für KI, Transformer und große Sprachmodelle (LLMs).

Chatten Sie mit RTX

Chat with RTX ist ein KI-Chatbot auf Ihrem PC. Als Legacy-Software installiert, stellt es einen Chatbot bereit, der alle Daten auf Ihrem PC kennt. Egal, ob Sie sich an etwas aus dem Monatsabschlussbericht Oktober 2022 erinnern möchten oder wo Sie am Abend des 17. Februar 2019 ein Abendessen reserviert haben: Wenn sich die Informationen auf Ihrem PC befinden, kann Chat with RTX sie abrufen hoch.

Vorteile der On-Device-KI

Geschwindigkeit: Einer der größten Vorteile von Chat mit RTX ist die Geschwindigkeit der Verarbeitung. Da die gesamte Verarbeitung auf dem Gerät erfolgt, spielt die Geschwindigkeit Ihrer Internetverbindung keine Rolle. Du brauchst nicht einmal eins! Dies ist ein großer Fortschritt im Vergleich zu bestehenden digitalen oder KI-Assistenten.

Datenschutz: Auch im Hinblick auf den Datenschutz bietet die Verarbeitung aller Geräteinformationen einen großen Vorteil. Alle Informationen werden verarbeitet und auf dem Gerät gespeichert, sodass der Eigentümer die volle Kontrolle und Verwahrung hat. Es gibt keinen Dritten, der Ihre Daten absichtlich oder unabsichtlich durchsehen, sammeln, auswerten, verkaufen oder an Dritte weitergeben kann.

Sicherheit: Die Aufbewahrung der Daten bringt auch Vorteile in der Sicherheit mit sich. Ohne dass Sie sich irgendwo anmelden oder die Informationen senden müssen, erhöhen Sie letztendlich die Sicherheit. Die Informationen müssen niemals reisen oder woanders gespeichert werden, auch nicht vorübergehend.

Anpassung: Ein weiterer klarer Vorteil ist die Individualisierung. Der Chat mit RTX basiert auf den auf Ihrem Computer gespeicherten Informationen und fungiert im Wesentlichen als LLM, der auf Ihre Daten und Informationen geschult ist. Unabhängig davon, ob der Großteil Ihrer Informationen aus Dokumenten, Standbildern oder Videos besteht, ist IT ein Chatbot, der speziell auf Sie und Ihre Daten zugeschnitten ist.

Flexibilität: Der Chat mit RTX ist nicht auf die Daten auf Ihrem Gerät beschränkt; Es kann auch für Daten im Internet verwendet werden, beispielsweise für Webseiten. Sie können Chat with RTX also bitten, auf einer Webseite nach Informationen zu suchen, und es liefert Ergebnisse, ohne Kompromisse bei Sicherheits- oder Datenschutzaspekten einzugehen. Es ist auch erwähnenswert, dass dies erst der Anfang ist.

Teufel im Detail

Die Systemanforderungen für die Ausführung von Chat mit RTX sind auf der Nachfrageseite. Derzeit ist es nur für Windows-PCs verfügbar, sodass MacOS und Linux vorerst im Regen stehen. Es ist nur für PCs mit Windows 11 verfügbar.

Mindestens 16 GB RAM und eine Dateigröße von 35 GB bedeuten, dass Sie für die Nutzung ein recht leistungsfähiges System benötigen. Darüber hinaus erfordert das System auch eine GPU der Nvidia GeForce RTX 30- oder 40-Serie, um auf einem Computer gut zu funktionieren. Die Systemanforderungen sind etwas hoch, aber immer noch im Bereich vieler PCs und Laptops der Mittelklasse.

Gemischte Bewertungen

Der Chat mit RTX wurde erstmals verfügbar gemacht zum Testen am 19. Februar 2024. Die Rezensionen unterscheiden sich etwas von den Demos und Mitteilungen von Nvidia. Das Modell ist zwar leistungsfähig, es wird jedoch vermutet, dass seine Fähigkeiten stark übertrieben sind. Der großen Dateigröße und den hohen Anforderungen wird die Ausgabe nicht gerecht.

Es kann viele Aufgaben erledigen, aber es erledigt sie nicht gut. Dies ist als erster Versuch einer neuen Idee verständlich. Im weiteren Verlauf sollten wir mit Verbesserungen in der Zukunft rechnen. Die enorme Größe und die hohen Systemanforderungen sind zwei Bereiche, an denen sie arbeiten und gleichzeitig Leistungsverbesserungen anstreben sollten.

Während Befürworter begonnen haben, Chat mit RTX als den Anfang vom Ende von Chat GPT und Googles Gemini zu bezeichnen, deuten die Erfahrungen derjenigen, die es verwendet haben, darauf hin, dass dies noch lange nicht der Fall sein wird. LLMs und Transformatoren erfordern eine große Menge an Rechenleistung und entsprechende Schulung.

Zu erwarten, dass eine lokale Installation auf einem PC genauso gute Ergebnisse liefert wie die Rechenzentren hinter Ihrer bevorzugten generativen KI, ist zu schnell zu viel verlangt. Für Unternehmen ist dies jedoch ein Versprechen, das bald umgesetzt werden kann.

Ein Unternehmen angemessener Größe könnte ein eigenes LLM-System für seine Belegschaft betreiben. Dies hätte vielfältige Anwendungsmöglichkeiten, aber die Vorteile für den Arbeitsablauf in informationsintensiven Branchen sind offensichtlich vielfältig.

Die Vorteile der Anpassung, des Datenschutzes und der Sicherheit wären für Unternehmensanwender von großem Nutzen. Während also die Idee eines LLM auf Ihrem PC kurzfristig noch nicht ganz in der Lage ist, mit den Besten seiner Klasse zu konkurrieren, könnten wir kurz- bis mittelfristig personalisierte LLMs für Unternehmensbenutzer sehen.

Das Zeitalter der On-Device-KI

Die Verfügbarkeit von Nvidias Chat mit RTX signalisiert, dass wir uns dem Zeitalter der On-Device-KI nähern. Die Samsung S24-Reihe mit Galaxy AI erledigte den Großteil der Aufgaben auf dem Gerät.

Jetzt bietet uns Nvidia eine vollständige On-Device-Verarbeitung. Das Produkt ist einigen Bewertungen zufolge noch nicht gut genug. Allerdings gibt es nur sehr wenige Erstprodukte. Nvidia hat mit Chat with RTX sicherlich die Katze unter die Tauben geworfen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://web3africa.news/2024/04/12/news/nvidia-chat-with-rtx-on-device-ai/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 11

- 17

- 19

- 2019

- 2022

- 30

- a

- Fähigkeiten

- Fähig

- Über Uns

- Nach

- Schauspielkunst

- Zusatz

- Vorteil

- Vorteilen

- Alter

- AI

- AI Chatbot

- Alle

- ebenfalls

- unter

- Betrag

- an

- und

- Ankündigungen

- Ein anderer

- jemand

- Anwendungen

- Ansatz

- SIND

- Bereiche

- AS

- fragen

- fragen

- Aspekte

- Assistenten

- At

- Verfügbarkeit

- verfügbar

- basierend

- BE

- wird

- Anfang

- hinter

- Sein

- Vorteile

- BESTE

- Beyond

- bringen

- Brings

- aber

- by

- CAN

- capability

- fähig

- Häuser

- CAT

- Zentren

- sicherlich

- Chat

- Chatbot

- Klasse

- klar

- Kälte

- Kommen

- Kommunikation

- Unternehmen

- verglichen

- konkurrieren

- uneingeschränkt

- kompromittierend

- Computer

- Konferenz

- Verbindung

- Smartgeräte App

- könnte

- Zur Zeit

- Sorgerecht

- Anpassung

- technische Daten

- Rechenzentren

- Übergeben

- geliefert

- Demand

- Demos

- Entwickler:in / Unternehmen

- Gerät

- abweichen

- DIG

- digital

- Abendessen

- do

- Unterlagen

- die

- Tut nicht

- Dabei

- Nicht

- sonst

- anderswo

- Ende

- genug

- Unternehmen

- Unternehmen

- vollständig

- im Wesentlichen

- Festlegung

- Sogar

- vorhandenen

- erwarten

- Erfahrungen

- Falling

- zu kurz kommen

- Februar

- wenige

- Reichen Sie das

- gefüllt

- Vorname

- Folgende

- Aussichten für

- vorwärts

- für

- voller

- Zukunft

- Galaxis

- Gemini

- generativ

- Generative KI

- gibt

- Unterstützung

- Go

- gut

- GPU

- groß

- größte

- sehr

- Haben

- mit

- schwer

- kräftig

- hoch

- aber

- HTTPS

- Idee

- if

- Bilder

- unmittelbar

- Verbesserungen

- in

- Erhöhung

- Branchen

- Information

- installieren

- installiert

- absichtlich

- Internet

- Internetverbindung

- eingeführt

- Beteiligung

- IT

- SEINE

- selbst

- nur

- gehalten

- Wesentliche

- kennt

- Sprache

- Laptops

- grosse

- ins Leben gerufen

- Leck

- Verlassen

- Legacy

- Limitiert

- Line

- linux

- wenig

- LLM

- aus einer regionalen

- Log

- aussehen

- Maschine

- MacOS

- gemacht

- Dur

- Mehrheit

- viele

- abgestimmt

- bedeuten

- Mittel

- mittlere

- Minimum

- Modell

- für

- vor allem warme

- ziehen um

- viel

- Need

- hört niemals

- Neu

- neue Produkt

- Nacht-

- nicht

- Bemerkens

- jetzt an

- Nvidia

- Oktober

- of

- on

- EINEM

- einzige

- arbeitet

- or

- Andernfalls

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- besitzen

- Eigentümer

- Seiten

- Party

- PC

- PCs

- Personen

- Leistung

- Personalisiert

- Plato

- Datenintelligenz von Plato

- PlatoData

- Spieler

- möglicherweise

- Werkzeuge

- größte treibende

- Datenschutz

- Datenschutz und Sicherheit

- Verarbeitet

- Verarbeitung

- Verarbeitungsleistung

- Produkt

- Produkte

- Versprechen

- Befürworter

- die

- bietet

- ganz

- RAM

- erreichen

- bereit

- vernünftig

- berichten

- Zugriffe

- erfordern

- Voraussetzungen:

- erfordert

- Umformung

- Reagieren

- Die Ergebnisse

- Bewertungen

- Revolution

- Rollen

- rtx

- Laufen

- s

- Said

- Samsung

- Sicherheitdienst

- sehen

- verkaufen

- senden

- Einstellung

- Short

- Schuss

- sollte

- Seite

- Signale

- signifikant

- ähnlich

- Größe

- So

- Software

- einige

- etwas

- etwas

- irgendwo

- bald

- spezifisch

- Geschwindigkeit

- Stufe

- begonnen

- Schritt

- Schrittmotoren

- Immer noch

- gelagert

- so

- vorschlagen

- System

- sprechen

- Targeting

- und Aufgaben

- Begriff

- AGB

- Testen

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- die Informationen

- Sie

- Dort.

- Diese

- vom Nutzer definierten

- Dritte

- fehlen uns die Worte.

- diejenigen

- Durch

- Zeit

- zu

- auch

- gegenüber

- traditionell

- trainiert

- Ausbildung

- Transformer

- reisen

- was immer dies auch sein sollte.

- Versuch

- XNUMX

- Letztlich

- verständlich

- us

- -

- benutzt

- Nutzer

- verwendet

- Verwendung von

- wertvoll

- riesig

- sehr

- Video

- wurde

- we

- Netz

- webp

- GUT

- ob

- welche

- während

- WHO

- werden wir

- Fenster

- 11 Fenster

- mit

- .

- ohne

- Arbeiten

- Arbeitsablauf.

- Belegschaft

- Werk

- wert

- würde

- noch

- Du

- Ihr

- Zephyrnet