Da immer mehr Organisationen generative KI-Technologien einsetzen – um Pitches zu erstellen, Zuschussanträge auszufüllen und zu schreiben Boilerplate-Code – Sicherheitsteams erkennen die Notwendigkeit, sich mit einer neuen Frage zu befassen: Wie sichert man KI-Tools?

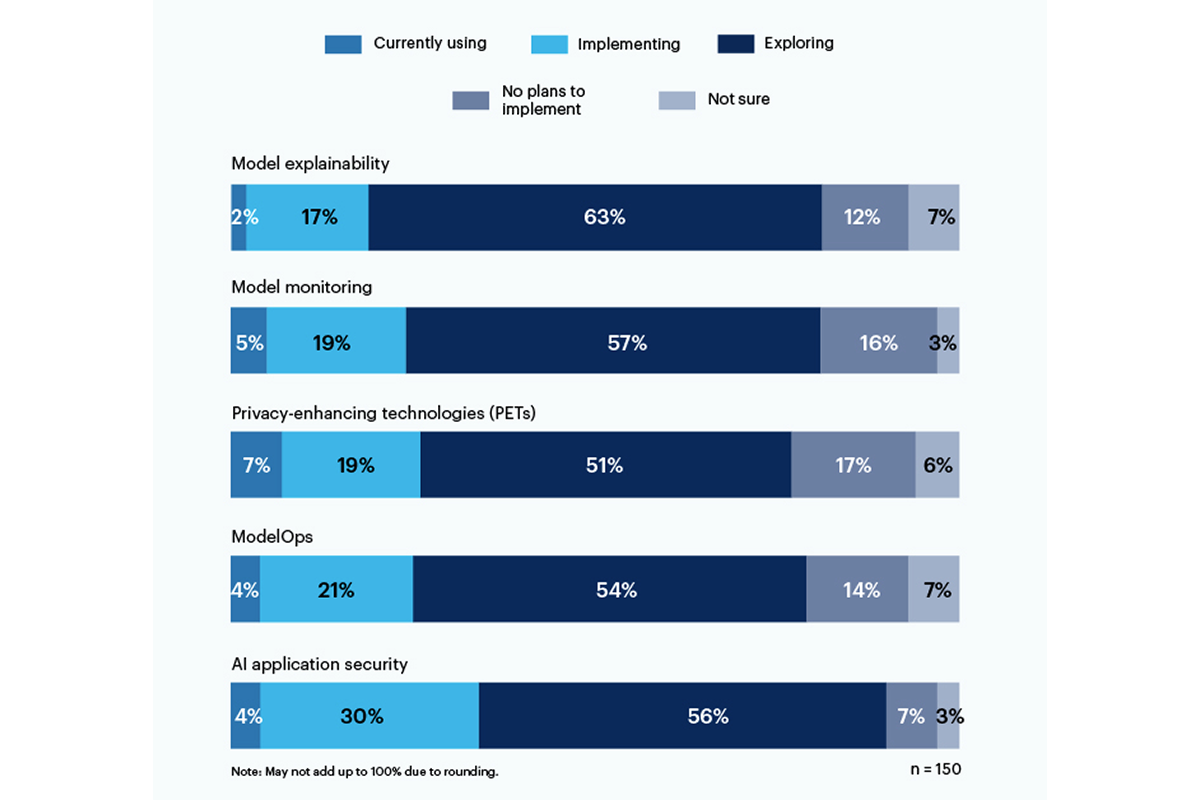

Ein Drittel der Befragten einer aktuellen Umfrage von Gartner gaben beides an Verwendung oder Implementierung KI-basierter Anwendungssicherheitstools um die Risiken anzugehen, die der Einsatz generativer KI in ihrer Organisation mit sich bringt.

Datenschutzverbessernde Technologien (PETs) wurden derzeit am häufigsten von 7 % der Befragten genutzt, wobei ganze 19 % der Unternehmen sie implementieren. Diese Kategorie umfasst Möglichkeiten zum Schutz personenbezogener Daten, wie z homomorphe Verschlüsselung, KI-generierte synthetische Daten, sichere Mehrparteienberechnung, föderiertes Lernen und differenzierte Privatsphäre. Allerdings haben satte 17 % keine Pläne, PETs in ihrer Umgebung einzusetzen.

Nur 19 % verwenden oder implementieren Tools zur Erklärbarkeit von Modellen, aber es besteht ein erhebliches Interesse (56 %) unter den Befragten, diese Tools zu erkunden und zu verstehen, um Risiken durch generative KI zu bewältigen. Laut Gartner können Erklärbarkeits-, Modellüberwachungs- und KI-Anwendungssicherheitstools alle auf Open-Source- oder proprietären Modellen verwendet werden, um die Vertrauenswürdigkeit und Zuverlässigkeit zu erreichen, die Unternehmensbenutzer benötigen.

Zu den Risiken, über die sich die Befragten am meisten Sorgen machen, gehören falsche oder voreingenommene Ausgaben (58 %) sowie Schwachstellen oder durchgesickerte Geheimnisse in KI-generiertem Code (57 %). Bezeichnenderweise nannten 43 % potenzielle Urheberrechts- oder Lizenzprobleme, die sich aus KI-generierten Inhalten ergeben, als größte Risiken für ihr Unternehmen.

„Es gibt immer noch keine Transparenz über die Datenmodelle, auf denen trainiert wird, daher ist das mit Voreingenommenheit und Datenschutz verbundene Risiko sehr schwer zu verstehen und abzuschätzen“, schrieb ein Vorstandsvorsitzender als Antwort auf die Gartner-Umfrage.

Im Juni das National Institute of Standards and Technology (NIST) hat eine öffentliche Arbeitsgruppe ins Leben gerufen um diese Frage zu beantworten, basierend auf seinem AI Risk Management Framework vom Januar. Wie die Gartner-Daten zeigen, Unternehmen warten nicht für NIST-Richtlinien.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :Ist

- :nicht

- 7

- a

- Über Uns

- Nach

- Erreichen

- Adresse

- adoptieren

- AI

- Alle

- unter

- und

- Anwendung

- Anwendungssicherheit

- Anwendungen

- SIND

- AS

- damit verbundenen

- At

- basierend

- BE

- vorspannen

- voreingenommen

- aber

- by

- C-Suite

- CAN

- Kategorie

- zitiert

- Code

- Unternehmen

- abschließen

- betroffen

- Inhalt

- Urheberrecht

- Handwerk

- Strom

- technische Daten

- schwer

- Richtlinien

- do

- entweder

- Unternehmen

- Arbeitsumfeld

- schätzen

- Exekutive

- Möglichkeiten sondieren

- Aussichten für

- Unser Ansatz

- für

- Gartner

- generativ

- Generative KI

- gewähren

- größte

- Haben

- Hilfe

- Ultraschall

- aber

- HTTPS

- Umsetzung

- in

- das

- Dazu gehören

- Institut

- Interesse

- Probleme

- IT

- SEINE

- Januar

- Juni

- ins Leben gerufen

- Lizenzierung

- Management

- Methoden

- Modell

- für

- Überwachung

- mehr

- vor allem warme

- mehrere

- National

- Need

- Neu

- nist

- nicht

- of

- on

- XNUMXh geöffnet

- Open-Source-

- or

- Organisation

- Organisationen

- persönliche

- Daten

- Haustiere

- Stellplätze

- Pläne

- Plato

- Datenintelligenz von Plato

- PlatoData

- gestellt

- Potenzial

- Datenschutz

- Eigentums-

- Risiken zu minimieren

- Öffentlichkeit

- Frage

- Realisierung

- kürzlich

- Zuverlässigkeit

- verlassen

- Berichtet

- Befragte

- Antwort

- Risiko

- Risikomanagement

- Risiken

- Verbindung

- Sicherheitdienst

- zeigte

- Konzerte

- signifikant

- bedeutend

- So

- solide

- Quelle

- Normen

- Immer noch

- so

- Umfrage

- synthetisch

- Teams

- Technologies

- Technologie

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Dort.

- Diese

- fehlen uns die Worte.

- zu

- Werkzeuge

- Top

- Ausbildung

- Transparenz

- Vertrauenswürdigkeit

- verstehen

- Verständnis

- -

- benutzt

- Nutzer

- Verwendung von

- sehr

- Sicherheitslücken

- Wege

- mit

- arbeiten,

- schreiben

- schrieb

- Du

- Zephyrnet