Amazon SageMaker Data Wrangler ist ein UI-basiertes Datenvorbereitungstool, das die Datenanalyse, -vorverarbeitung und -visualisierung mit Funktionen zum schnelleren Bereinigen, Transformieren und Vorbereiten von Daten unterstützt. Die vorgefertigten Flow-Vorlagen von Data Wrangler helfen Datenwissenschaftlern und Praktikern des maschinellen Lernens (ML) dabei, die Datenvorbereitung zu beschleunigen, indem sie Ihnen helfen, Best-Practice-Muster für Datenflüsse mithilfe gemeinsamer Datasets zu beschleunigen und zu verstehen.

Sie können Data Wrangler-Flows verwenden, um die folgenden Aufgaben auszuführen:

- Datenvisualisierung - Untersuchen der statistischen Eigenschaften für jede Spalte im Datensatz, Erstellen von Histogrammen und Untersuchen von Ausreißern

- Datenreinigung - Entfernen von Duplikaten, Löschen oder Füllen von Einträgen mit fehlenden Werten, Entfernen von Ausreißern

- Datenanreicherung und Feature Engineering - Verarbeiten von Spalten, um ausdrucksstärkere Funktionen zu erstellen, Auswählen einer Teilmenge von Funktionen für das Training

Dieser Beitrag hilft Ihnen dabei, Data Wrangler anhand der folgenden vorgefertigten Beispielabläufe zu verstehen GitHub. Das Repository zeigt tabellarische Datentransformationen, Zeitreihendatentransformationen und verbundene Datensatztransformationen. Jede erfordert aufgrund ihrer grundlegenden Natur eine andere Art von Transformationen. Standardmäßige Tabellen- oder Querschnittsdaten werden zu einem bestimmten Zeitpunkt erhoben. Im Gegensatz dazu werden Zeitreihendaten im Laufe der Zeit wiederholt erfasst, wobei jeder aufeinanderfolgende Datenpunkt von seinen vergangenen Werten abhängt.

Sehen wir uns ein Beispiel an, wie wir den Beispieldatenfluss für tabellarische Daten verwenden können.

Voraussetzungen:

DataWrangler ist ein Amazon Sage Maker Funktion innerhalb verfügbar Amazon SageMaker-Studio, daher müssen wir dem Onboarding-Prozess von Studio folgen, um die Studio-Umgebung und -Notebooks hochzufahren. Obwohl Sie aus einigen wenigen Authentifizierungsmethoden auswählen können, ist die einfachste Methode zum Erstellen einer Studio-Domain, die zu befolgen Schnellstart Anweisungen. Der Schnellstart verwendet die gleichen Standardeinstellungen wie der Standard-Studio-Setup. Sie können sich auch für das Onboarding mit entscheiden AWS IAM Identity Center (Nachfolger von AWS Single Sign-On) zur Authentifizierung (vgl Integrieren in die Amazon SageMaker-Domäne mithilfe von IAM Identity Center).

Importieren Sie die Dataset- und Flow-Dateien mit Studio in Data Wrangler

Die folgenden Schritte beschreiben, wie Daten in SageMaker importiert werden, um von Data Wrangler verwendet zu werden:

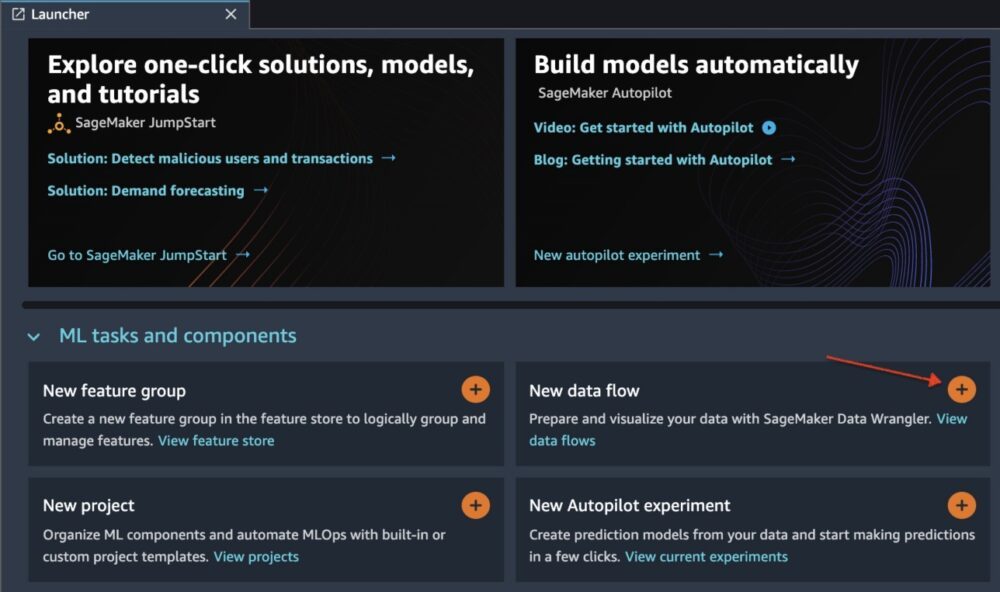

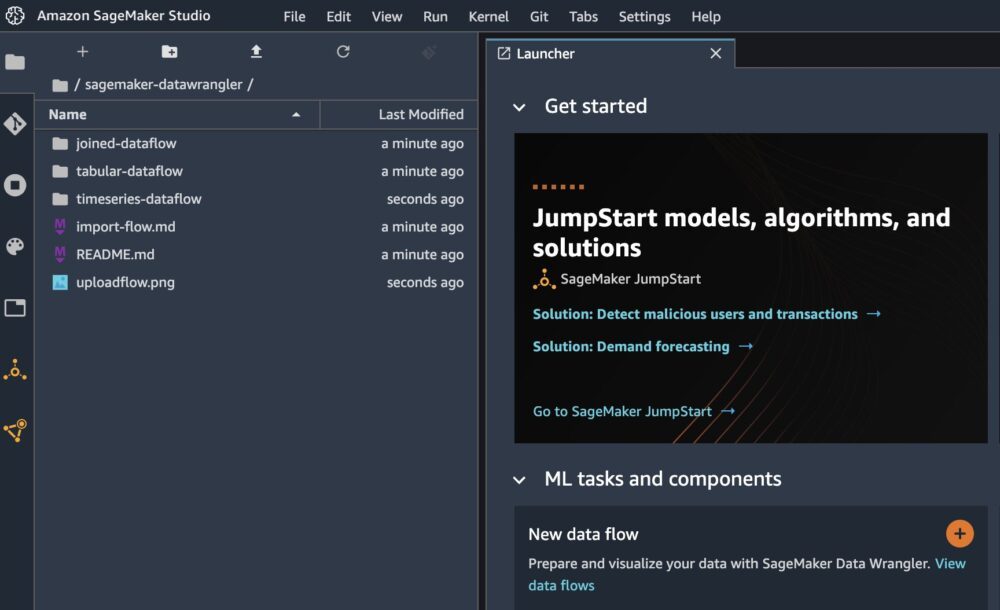

Initialisieren Sie Data Wrangler über die Studio-Benutzeroberfläche, indem Sie auswählen Neuer Datenfluss.

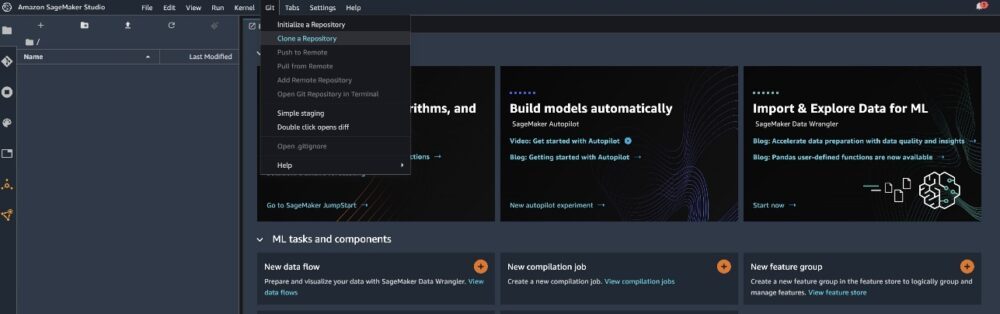

Klonen Sie die GitHub Repo um die Flow-Dateien in Ihre Studio-Umgebung herunterzuladen.

Wenn der Klon abgeschlossen ist, sollten Sie den Inhalt des Repositorys im linken Bereich sehen können.

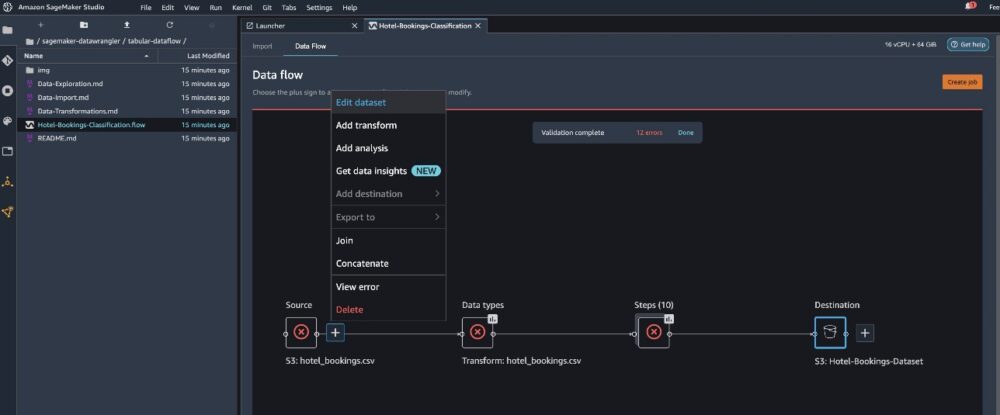

Wählen Sie die Datei aus Hotel-Buchungen-Klassifizierung.flow um die Flow-Datei in Data Wrangler zu importieren.

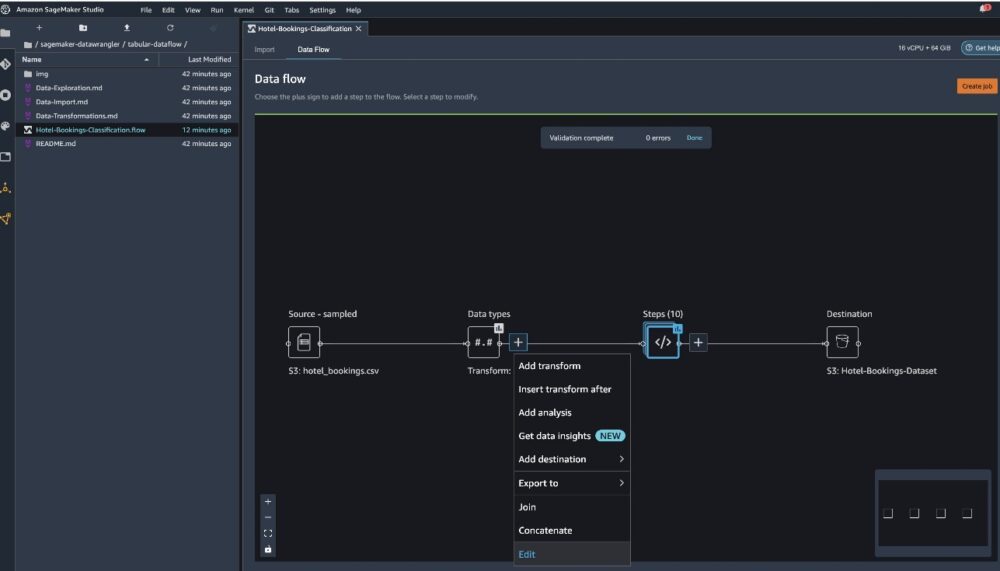

Wenn Sie den Zeitreihen- oder verknüpften Datenfluss verwenden, wird der Fluss unter einem anderen Namen angezeigt. Nachdem der Fluss importiert wurde, sollten Sie den folgenden Screenshot sehen. Dies zeigt uns Fehler, da wir sicherstellen müssen, dass die Flow-Datei auf die richtige Datenquelle verweist Amazon Simple Storage-Service (Amazon S3).

Auswählen

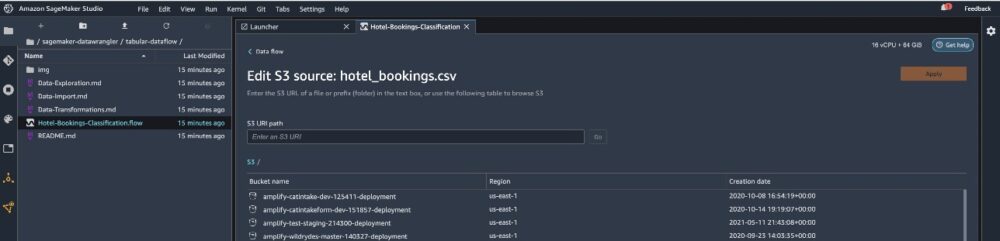

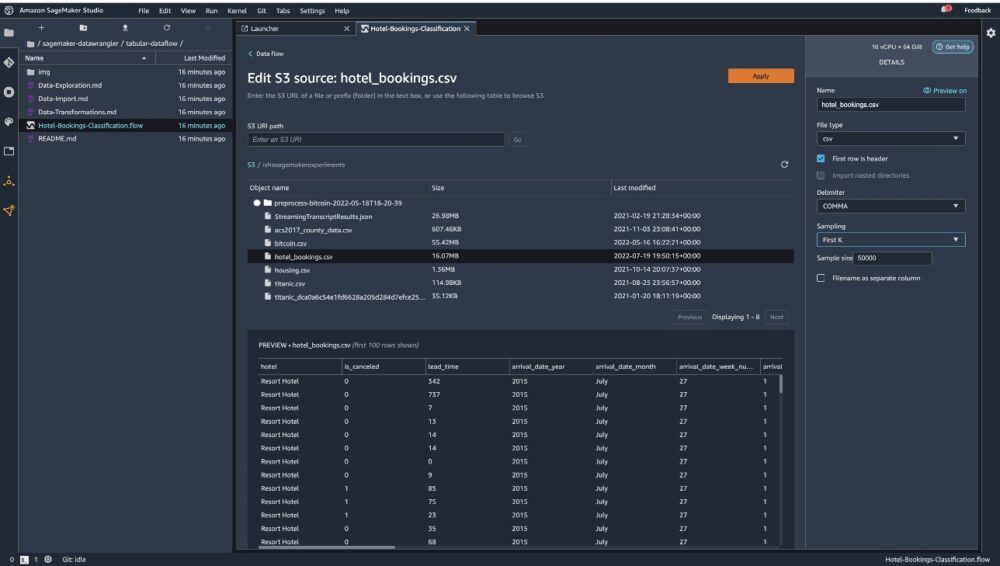

Datensatz bearbeiten um alle Ihre S3-Buckets aufzurufen. Wählen Sie als Nächstes den Datensatz aus hotel_bookings.csv aus Ihrem S3-Bucket zum Durchlaufen der tabellarischer Datenfluss.

Beachten Sie, dass, wenn Sie die verwenden verbundenen Datenfluss, müssen Sie möglicherweise mehrere Datensätze in Data Wrangler importieren

Vergewissern Sie sich im rechten Bereich ABSATZ als Trennzeichen und gewählt wird Probennahme eingestellt ist Erst k. Unser Datensatz ist klein genug, um Data Wrangler-Transformationen für den vollständigen Datensatz auszuführen, aber wir wollten hervorheben, wie Sie den Datensatz importieren können. Wenn Sie über ein großes Dataset verfügen, sollten Sie die Verwendung von Stichproben in Betracht ziehen. Wählen Import um diesen Datensatz in Data Wrangler zu importieren.

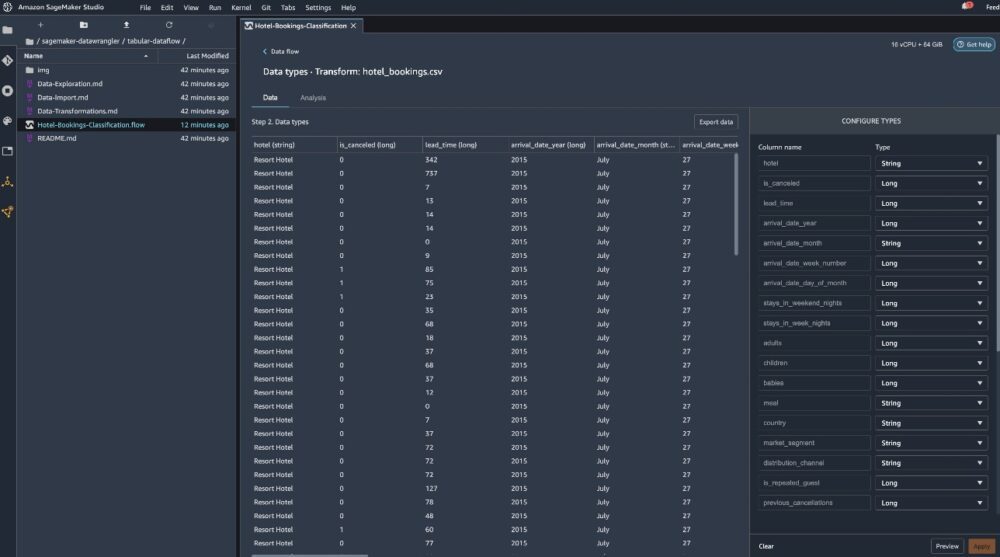

Nachdem das Dataset importiert wurde, validiert Data Wrangler automatisch das Dataset und erkennt die Datentypen. Sie können sehen, dass die Fehler verschwunden sind, da wir auf den richtigen Datensatz verweisen. Der Flow-Editor zeigt jetzt zwei Blöcke an, die zeigen, dass die Daten aus einer Quelle importiert wurden und Datentypen erkannt wurden. Sie können die Datentypen bei Bedarf auch bearbeiten.

Der folgende Screenshot zeigt unsere Datentypen.

Sehen wir uns einige der Transformationen an, die als Teil dieses tabellarischen Ablaufs durchgeführt wurden. Wenn Sie die verwenden Zeitfolgen or beigetreten Datenflüsse finden Sie einige gängige Transformationen auf der GitHub Repo. Wir haben einige grundlegende explorative Datenanalysen unter Verwendung von Data-Insight-Berichten durchgeführt, die das Zielleck und die Kollinearität von Merkmalen im Datensatz, Tabellenzusammenfassungsanalysen und schnelle Modellierungsfunktionen untersuchten. Erkunden Sie die Schritte auf der GitHub Repo.

Jetzt löschen wir Spalten basierend auf den Empfehlungen des Data Insights and Quality Report.

- Für Zielleckage fallen lassen Reservierungsstatus.

- Löschen Sie für redundante Spalten Tage_in_Warteliste, Hotel, reservierter_Zimmer_Typ, Ankunft_Datum_Monat, Reservierungsstatus_Datum, Babys, und ankunftsdatum_tag_des_monats.

- Lassen Sie Spalten basierend auf den Ergebnissen der linearen Korrelation fallen ankunftsdatum_wochennummer und Ankunft_Datum_Jahr da die Korrelationswerte für diese Merkmals-(Spalten-)Paare größer als der empfohlene Schwellenwert von 0.90 sind.

- Basierend auf nichtlinearen Korrelationsergebnissen fallen Reservierungsstatus. Diese Spalte wurde basierend auf der Zielleckageanalyse bereits zum Löschen markiert.

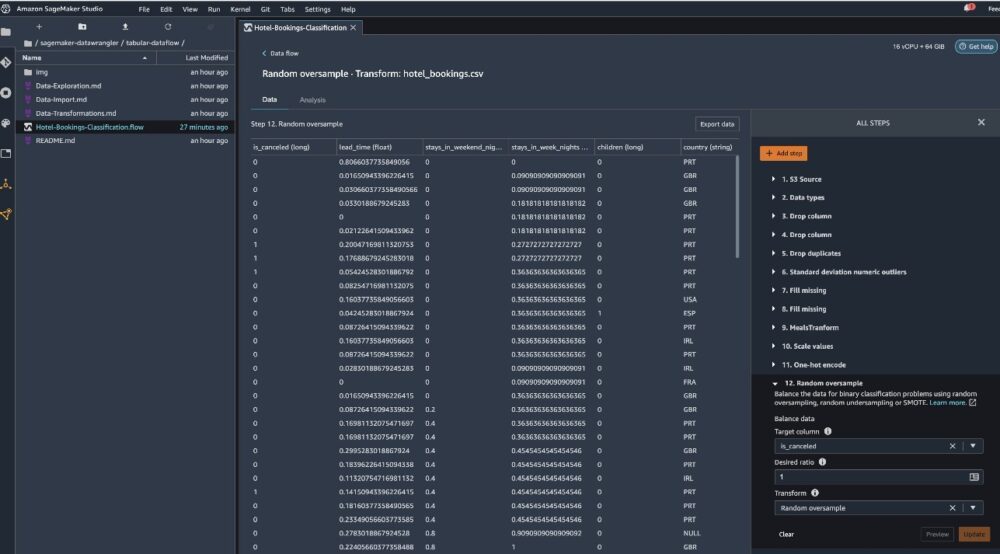

- Zahlenwerte verarbeiten (Min-Max-Skalierung) für Lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, und erforderliche_autoparkplätze.

- One-Hot-Codierung kategorialer Variablen wie Mahlzeit, ist_wiederholter_Gast, Marktsegment, zugewiesener_Zimmertyp, Anzahlungstyp, und Kundentyp.

- Gleichen Sie die Zielvariable aus. Zufällige Überabtastung für Klassenungleichgewicht. Verwenden Sie die schnelle Modellierungsfunktion, um Ausreißer und fehlende Werte zu handhaben.

Exportieren Sie nach Amazon S3

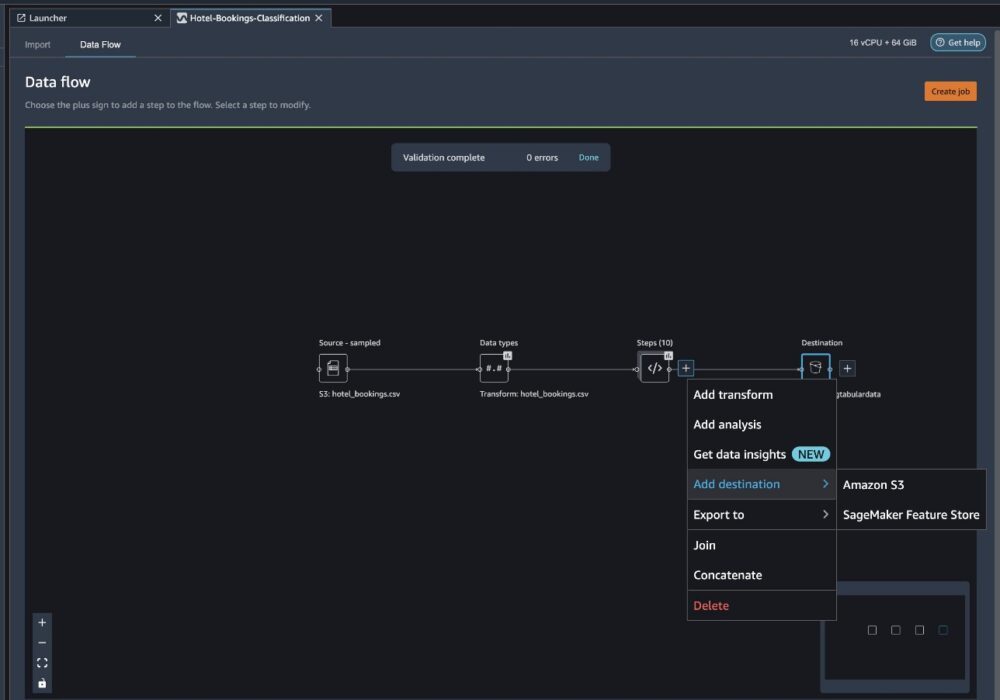

Jetzt haben wir die verschiedenen Transformationen durchlaufen und sind bereit, die Daten nach Amazon S3 zu exportieren. Diese Option erstellt einen SageMaker-Verarbeitungsjob, der den Data Wrangler-Verarbeitungsablauf ausführt und das resultierende Dataset in einem angegebenen S3-Bucket speichert. Befolgen Sie die nächsten Schritte, um den Export nach Amazon S3 einzurichten:

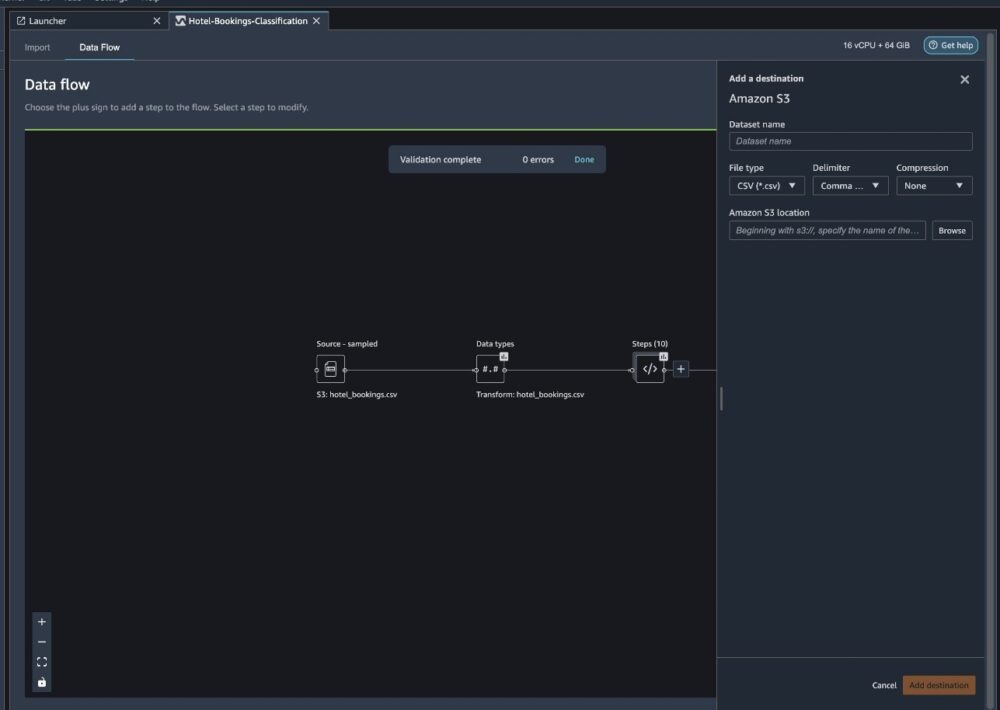

Wählen Sie das Pluszeichen neben einer Sammlung von Transformationselementen und wählen Sie aus Ziel hinzufügen und dann Amazon S3.

- Aussichten für Datensatzname, geben Sie beispielsweise einen Namen für den neuen Datensatz ein

NYC_export. - Aussichten für Dateityp, wählen CSV.

- Aussichten für Trennzeichen, wählen Comma.

- Aussichten für Kompression, wählen Andere.

- Aussichten für Amazon S3-Standortverwenden Sie denselben Bucket-Namen, den wir zuvor erstellt haben.

- Auswählen Ziel hinzufügen.

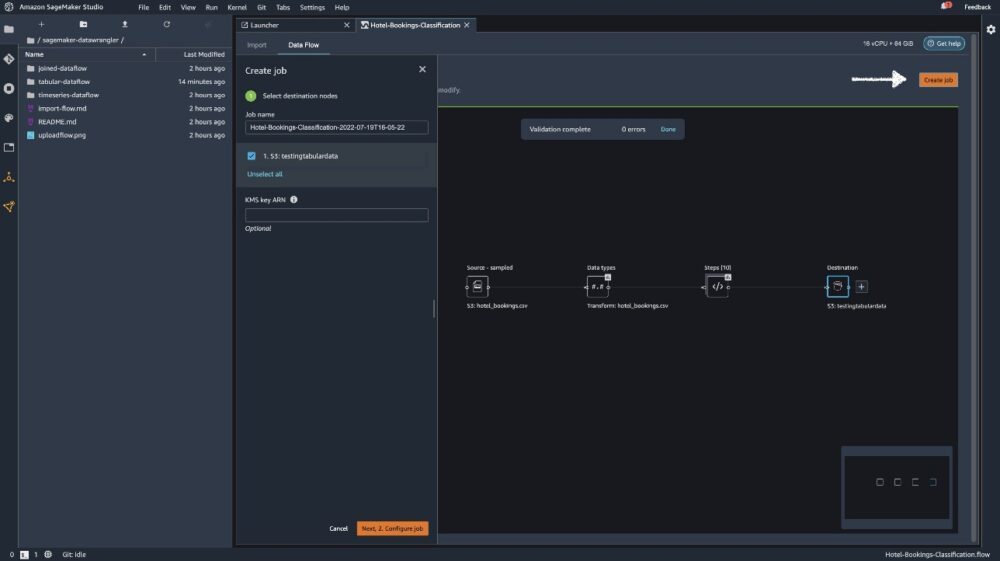

Auswählen Job erstellen.

Aussichten für Berufsbezeichnung, geben Sie einen Namen ein oder behalten Sie die automatisch generierte Option bei und wählen Sie aus Reiseziel. Wir haben nur ein Ziel, S3:testingtabulardata, aber Sie haben möglicherweise mehrere Ziele aus verschiedenen Schritten in Ihrem Workflow. Lassen Sie die KMS-Schlüssel-ARN Feld leer und wählen Weiter.

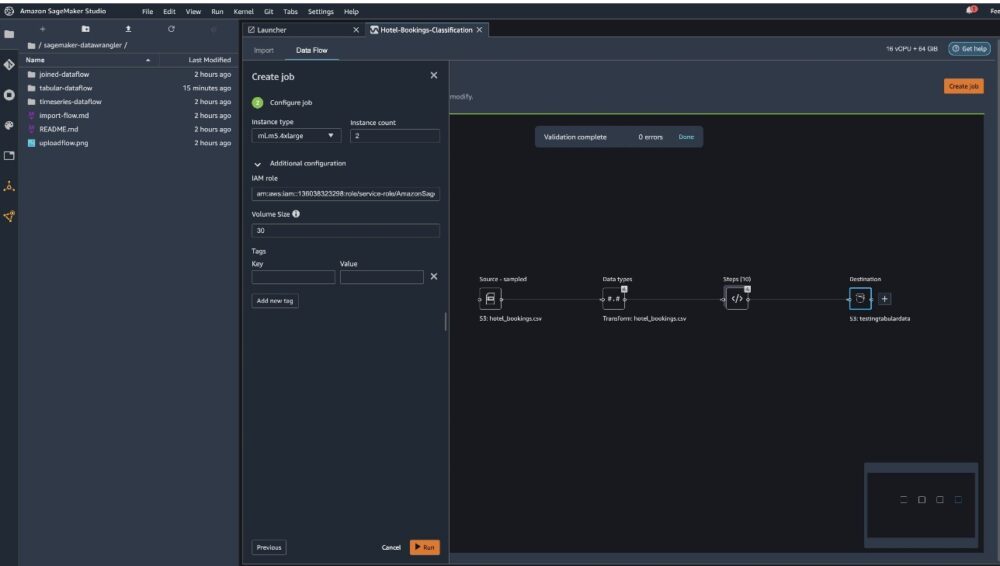

Jetzt müssen Sie die Rechenkapazität für einen Job konfigurieren. Für dieses Beispiel können Sie alle Standardwerte beibehalten.

- Aussichten für Instanztyp, verwenden Sie ml.m5.4xlarge.

- Aussichten für Instanzanzahl, benutze 2.

- Sie können erkunden Zusätzliche Konfiguration, aber behalten Sie die Standardeinstellungen bei.

- Auswählen Führen Sie.

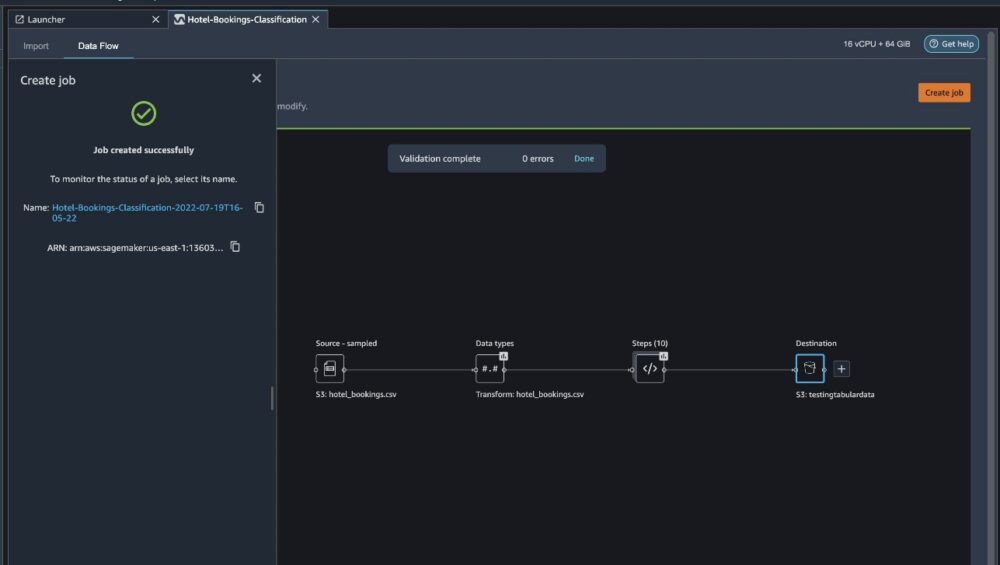

Jetzt hat Ihr Job begonnen und es dauert einige Zeit, 6 GB Daten gemäß unserem Data Wrangler-Verarbeitungsablauf zu verarbeiten. Die Kosten für diesen Job belaufen sich auf etwa 2 USD, da ml.m5.4xlarge 0.922 USD pro Stunde kostet und wir zwei davon verwenden.

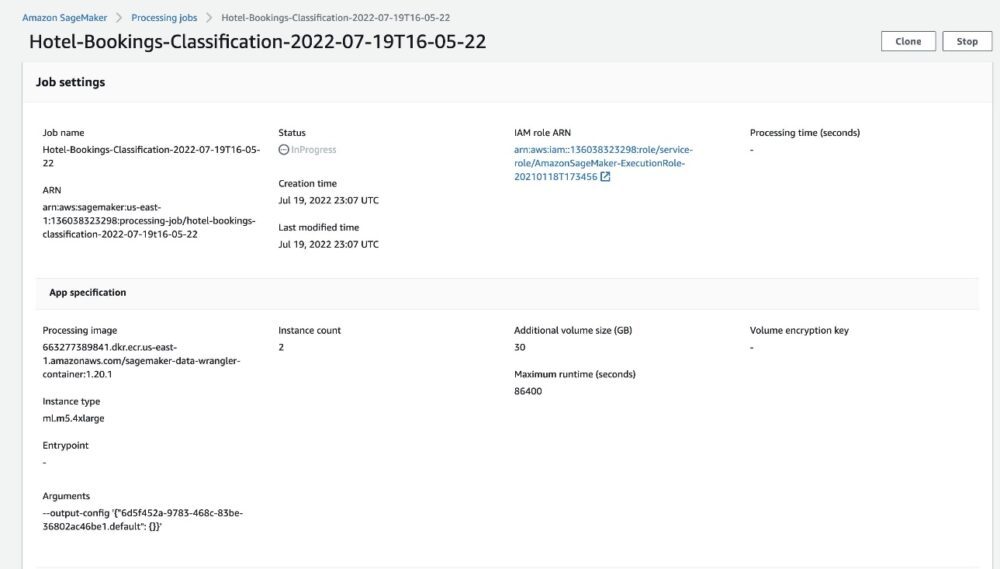

Wenn Sie den Jobnamen auswählen, werden Sie zu einem neuen Fenster mit den Jobdetails weitergeleitet.

Auf der Auftragsdetailseite sehen Sie alle Parameter aus den vorherigen Schritten.

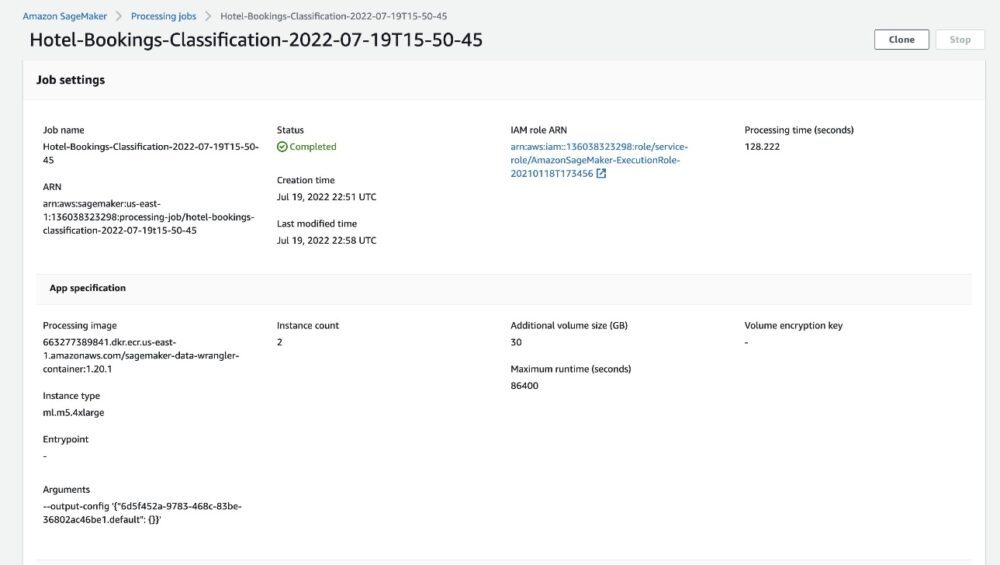

Wenn sich der Auftragsstatus in Abgeschlossen ändert, können Sie auch das überprüfen Verarbeitungszeit (Sekunden) Wert. Dieser Verarbeitungsauftrag dauert etwa 5–10 Minuten.

Wenn der Job abgeschlossen ist, sind die Trainings- und Testausgabedateien in den entsprechenden S3-Ausgabeordnern verfügbar. Den Ausgabeort finden Sie in den Verarbeitungsjobkonfigurationen.

Nachdem der Data Wrangler-Verarbeitungsjob abgeschlossen ist, können wir die in unserem S3-Bucket gespeicherten Ergebnisse überprüfen. Vergessen Sie nicht, die zu aktualisieren job_name Variable mit Ihrem Jobnamen.

Sie können diese exportierten Daten jetzt zum Ausführen von ML-Modellen verwenden.

Aufräumen

Löschen Sie Ihre S3-Buckets und dein Data Wrangler-Fluss um die zugrunde liegenden Ressourcen zu löschen und unerwünschte Kosten zu vermeiden, nachdem Sie das Experiment beendet haben.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie Sie den tabellarischen vorgefertigten Datenfluss in Data Wrangler importieren, mit unserem Datensatz verbinden und die Ergebnisse nach Amazon S3 exportieren können. Wenn Ihre Anwendungsfälle erfordern, dass Sie Zeitreihendaten bearbeiten oder mehrere Datasets zusammenführen, können Sie die anderen vorgefertigten Beispielabläufe in der durchgehen GitHub Repo.

Nachdem Sie einen vorgefertigten Datenvorbereitungs-Workflow importiert haben, können Sie ihn in Amazon SageMaker Processing integrieren, Amazon SageMaker-Pipelines und Amazon SageMaker Feature Store um die Verarbeitung, gemeinsame Nutzung und Speicherung von ML-Trainingsdaten zu vereinfachen. Sie können diesen Beispieldatenfluss auch in ein Python-Skript exportieren und eine benutzerdefinierte ML-Datenvorbereitungspipeline erstellen und so Ihre Veröffentlichungsgeschwindigkeit beschleunigen.

Wir empfehlen Ihnen, sich unsere anzuschauen GitHub-Repository um praktische Übungen zu sammeln und neue Wege zur Verbesserung der Modellgenauigkeit zu finden! Um mehr über SageMaker zu erfahren, besuchen Sie die Amazon SageMaker-Entwicklerhandbuch.

Über die Autoren

Isha Dua ist ein Senior Solutions Architect mit Sitz in der San Francisco Bay Area. Sie hilft AWS Enterprise-Kunden beim Wachstum, indem sie ihre Ziele und Herausforderungen versteht, und leitet sie an, wie sie ihre Anwendungen auf Cloud-native Weise gestalten und gleichzeitig sicherstellen können, dass sie belastbar und skalierbar sind. Sie interessiert sich leidenschaftlich für maschinelle Lerntechnologien und ökologische Nachhaltigkeit.

Isha Dua ist ein Senior Solutions Architect mit Sitz in der San Francisco Bay Area. Sie hilft AWS Enterprise-Kunden beim Wachstum, indem sie ihre Ziele und Herausforderungen versteht, und leitet sie an, wie sie ihre Anwendungen auf Cloud-native Weise gestalten und gleichzeitig sicherstellen können, dass sie belastbar und skalierbar sind. Sie interessiert sich leidenschaftlich für maschinelle Lerntechnologien und ökologische Nachhaltigkeit.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Sage Maker

- Amazon SageMaker Data Wrangler

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet